Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

29.Nov. 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

LETZTE AKTUALISIERUNG: 1.Dez.2018, Anmerkung 1

KONTEXT

Im Rahmen einer öffentlichen Veranstaltung des Fachbereichs 2 ‚Informatik & Ingenieurwissenschaften‘ der Frankfurt University of Applied Sciences am 28.November 2018 mit dem Rahmenthema „Künstliche Intelligenz – Arbeit für Alle?“ hielt Gerd Doeben-Henisch einen kurzen Vortrag zum Thema „Verändert KI die Welt?“ Voraus ging ein Vortrag von Herrn Helmut Geyer „Arbeitsmarkt der Zukunft. (Flyer zur Veranstaltung: FRA-UAS_Fb2_Karte_KI-Arbeit fuer alle_Webversion )

EINSTIEG INS KI-THEMA

Im Kontext der Überlegungen zur Arbeitswelt angesichts des technologischen Wandels gerät die Frage nach der Rolle der Technologie, speziell der digitalen Technologie — und hier noch spezieller der digitalen Technologie mit KI-Anteilen – sehr schnell zwischen die beiden Pole ‚Vernichter von Arbeit‘, ‚Gefährdung der Zukunft‘ einerseits und ‚Neue Potentiale‘, ‚Neue Arbeit‘, ‚Bessere Zukunft‘, wobei es dann auch einen dritten Pol gibt, den von den ‚übermächtigen Maschinen‘, die die Menschen sehr bald überrunden und beherrschen werden.

Solche Positionen, eine Mischungen aus quasi-Fakten, viel Emotionen und vielen unabgeklärten Klischees, im Gespräch sachlich zu begegnen ist schwer bis unmöglich, erst Recht, wenn wenig Zeit zur Verfügung steht.

Doeben-Henisch entschloss sich daher, das Augenmerk zentral auf den Begriff ‚Künstliche Intelligenz‘ zu lenken und die bislang uneinheitliche und technikintrovertierte Begrifflichkeit in einen größeren Kontext zu stellen, der das begrifflich ungeklärte Nebeneinander von Menschen und Maschinen schon im Ansatz zu überwinden sucht.

ANDERE DISZIPLINEN

Viele Probleme im Kontext der Terminologie der KI im technischen Bereich erscheinen hausgemacht, wenn man den Blick auf andere Disziplinen ausweitet. Solche andere Disziplinen sind die Biologe, die Mikrobiologie sowie die Psychologie. In diesen Disziplinen beschäftigt man sich seit z.T. deutlich mehr als 100 Jahren mit komplexen Systemen und deren Verhalten, und natürlich ist die Frage nach der ‚Leistungsfähigkeit‘ solcher Systeme im Bereich Lernen und Intelligenz dort seit langem auf der Tagesordnung.

Die zunehmenden Einsichten in die unfassbare Komplexität biologischer Systeme (siehe dazu Beiträge in diesem Blog, dort auch weitere Links), lassen umso eindrücklicher die Frage laut werden, wie sich solche unfassbar komplexen Systeme überhaupt entwickeln konnten. Für die Beantwortung dieser Frage wies Doeben-Henisch auf zwei spannende Szenarien hin.

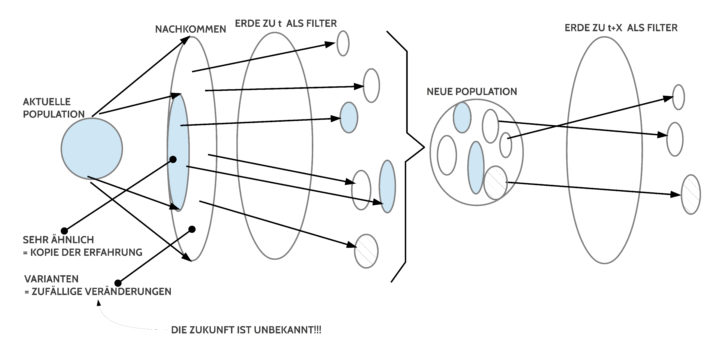

KOMMUNIKATIONSFREIE EVOLUTION

In der Zeit von der ersten Zelle (ca. -3.8 Mrd Jahren) bis zur Verfügbarkeit hinreichend leistungsfähiger Nervensysteme mit Gehirnen (ab ca. -300.000, vielleicht noch etwas früher) wurde die Entwicklung der Lebensformen auf der Erde durch zwei Faktoren gesteuert: (a) die Erde als ‚Filter‘, was letztlich zu einer bestimmten Zeit geht; (b) die Biomasse mit ihrer Reproduktionsfähigkeit, die neben der angenäherten Reproduktion der bislang erfolgreichen Baupläne (DNA-Informationen) in großem Umfang mehr oder weniger starke ‚Varianten‘ erzeugte, die ‚zufallsbedingt‘ waren. Bezogen auf die Erfolge der Vergangenheit konnten die zufälligen Varianten als ’sinnlos‘ erscheinen, als ’nicht zielführend‘, tatsächlich aber waren es sehr oft diese zunächst ’sinnlos erscheinenden‘ Varianten, die bei einsetzenden Änderungen der Lebensverhältnisse ein Überleben ermöglichten. Vereinfachend könnte man also für die Phase die Formel prägen ‚(Auf der dynamischen Erde:) Frühere Erfolge + Zufällige Veränderungen = Leben‘. Da zum Zeitpunkt der Entscheidung die Zukunft niemals hinreichend bekannt ist, ist die Variantenbildung die einzig mögliche Strategie. Die Geschwindigkeit der ‚Veränderung von Lebensformen‘ war in dieser Zeit auf die Generationsfolgen beschränkt.

MIT KOMMUNIKATION ANGEREICHERTE EVOLUTION

Nach einer gewissen ‚Übergangszeit‘ von einer Kommunikationsfreien zu einer mit Kommunikation angereicherte Evolution gab es in der nachfolgenden Zeit die Verfügbarkeit von hinreichend leistungsfähigen Gehirnen (spätestens mit dem Aufkommen des homo sapiens ab ca. -300.000)[1], mittels deren die Lebensformen die Umgebung und sich selbst ‚modellieren‘ und ‚abändern‘ konnten. Es war möglich, gedanklich Alternativen auszuprobieren, sich durch symbolische Kommunikation zu ‚koordinieren‘ und im Laufe der letzten ca. 10.000 Jahren konnten auf diese Weise komplexe kulturelle und technologische Strukturen hervorgebracht werden, die zuvor undenkbar waren. Zu diesen Technologien gehörten dann auch ab ca. 1940 programmierbare Maschinen, bekannt als Computer. Der Vorteil der Beschleunigung in der Veränderung der Umwelt – und zunehmend auch der Veränderung des eigenen Körpers — lies ein neues Problem sichtbar werden, das Problem der Präferenzen (Ziele, Bewertungskriterien…). Während bislang einzig die aktuelle Erde über ‚Lebensfähig‘ ‚oder nicht Lebensfähig‘ entschied, und dies das einzige Kriterium war, konnten die Lebewesen mit den neuen Gehirnen jetzt eine Vielzahl von Aspekten ausbilden, ‚partielle Ziele‘, nach denen sie sich verhielten, von denen oft erst in vielen Jahren oder gar Jahrzehnten oder gar noch länger sichtbar wurde, welche nachhaltigen Effekte sie haben.

Anmerkung 1: Nach Edelman (1992) gab es einfache Formen von Bewusstsein mit den zugehörigen neuronalen Strukturen ab ca. -300 Mio Jahren.(S.123) Danach hätte es also ca. 300 Mio Jahre gedauert, bis Gehirne, ausgehend von einem ersten einfachen Bewusstsein, zu komplexen Denkleistungen und sprachlicher Kommunikation in der Lage waren.

LERNEN und PRÄFERENZEN

Am Beispiel von biologischen Systemen kann man fundamentale Eigenschaften wie z.B. das ‚Lernen‘ und die ‚Intelligenz‘ sehr allgemein definieren.

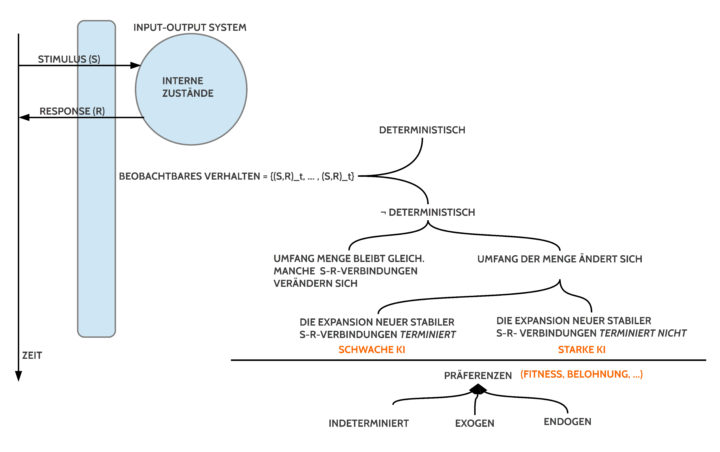

In biologischer Sicht haben wir generell Input-Output-Systeme in einer unfassbar großen Zahl an Varianten bezüglich des Körperbaus und der internen Strukturen und Abläufe. Wie solch ein Input-Output-System intern im Details funktioniert spielt für das konkrete Leben nur insoweit eine Rolle, als die inneren Zustände ein äußerlich beobachtbares Verhalten ermöglichen, das wiederum das Überleben in der verfügbaren Umgebung ermöglicht und bezüglich spezieller ‚Ziele‘ ‚erfolgreich‘ ist. Für das Überleben reicht es also zunächst, einfach dieses beobachtbare Verhalten zu beschreiben.

In idealisierter Form kann man das Verhalten betrachten als Reiz-Reaktions-Paare (S = Stimulus, R = Response, (S,R)) und die Gesamtheit des beobachtbaren Verhaltens damit als eine Sequenz von solchen (S,R)-Paaren, die mathematisch eine endliche Menge bilden.

Ein so beschriebenes Verhalten kann man dann als ‚deterministisch‘ bezeichnen, wenn die beobachtbaren (S,R)-Paare ’stabil‘ bleiben, also auf einen bestimmten Reiz S immer die gleiche Antwort R erfolgt.

Ein dazu komplementäres Verhalten, also ein ’nicht-deterministisches‘ Verhalten, wäre dadurch charakterisiert, dass entweder (i) der Umfang der Menge gleich bleibt, aber manche (S,R)-Paare sich verändern oder (ii) der Umfang der Menge kann sich ändern. Dann gibt es die beiden interessanten Unterfälle (ii.1) es kommen nach und nach neue (S,R)-Paare dazu, die ‚hinreichend lang‘ ’stabil‘ bleiben, aber ab einem bestimmten Zeitpunkt ‚t‘ sich nicht mehr vermehren (die Menge der stabilen Elemente wird ‚eingefroren‘, ‚fixiert‘, ‚gezähmt‘, …), oder (ii.2) die Menge der stabilen (S,R)-Paare expandiert ohne Endpunkt.

Bezeichnet man diese Expansion (zeitlich ‚befristet‘ oder ‚unbefristet‘) als ‚Lernen‘, dann wird sichtbar, dass die ‚Inhalte des Lernens‘ (die korrespondierenden Repräsentationen der (S,R)-Paare in den internen Zuständen des Systems) einmal davon abhängen, was die Umgebung der Systeme ‚erlaubt‘, zum anderen, was die ‚inneren Zustände‘ des Systems an ‚Verarbeitung ermöglichen‘, sowie – sehr indirekt – über welche welche ‚internen Selektionskriterien‘ ein System verfügt.

Die ‚internen Selektionskriterien‘ werden hier kurz ‚Präferenzen‘ genannt, also Strategien, ob eher ein A oder ein B ’selektiert‘ werden soll. Wonach sich solche Kriterien richten, bleibt dabei zunächst offen. Generell kann man sagen, dass solche Kriterien primär ‚endogen‘ begründet sein müssen, dass sie aber nachgeordnet auch von außen (‚exogen‘) übernommen werden können, wenn die inneren Kriterien eine solche Favorisierung des exogenen Inputs ‚befürworten‘ (Beispiel sind die vielen Imitationen im Lernen bzw. die Vielzahl der offiziellen Bildungsprozesse, durch die Menschen auf bestimmte Verhaltens- und Wissensmuster trainiert (programmiert) werden). Offen ist auch, ob die endogenen Präferenzen stabil sind oder sich im Laufe der Zeit ändern können; desgleichen bei den exogenen Präferenzen.

Am Beispiel der menschlichen Kulturen kann man den Eindruck gewinnen, dass das Finden und gemeinsame Befolgen von Präferenzen ein bislang offenes Problem ist. Und auch die neuere Forschung zu Robotern, die ohne Terminierung lernen sollen (‚developmental robotics‘), hat zur Zeit das Problem, dass nicht ersichtlich ist, mit welchen Werten man ein nicht-terminiertes Lernen realisieren soll. (Siehe: Merrick, 2017)) Das Problem mit der Präferenz-Findung ist bislang wenig bekannt, da die sogenannten intelligenten Programme in der Industrie immer nur für klar definierte Verhaltensprofile trainiert werden, die sie dann später beim realen Einsatz unbedingt einhalten müssen. Im technischen Bereich spricht man hier oft von einer ’schwachen KI‘. (Siehe: VDI, 2018) Mit der hier eingeführten Terminologie wären dies nicht-deterministische Systeme, die in ihrem Lernen ‚terminieren‘.

INTELLIGENZ

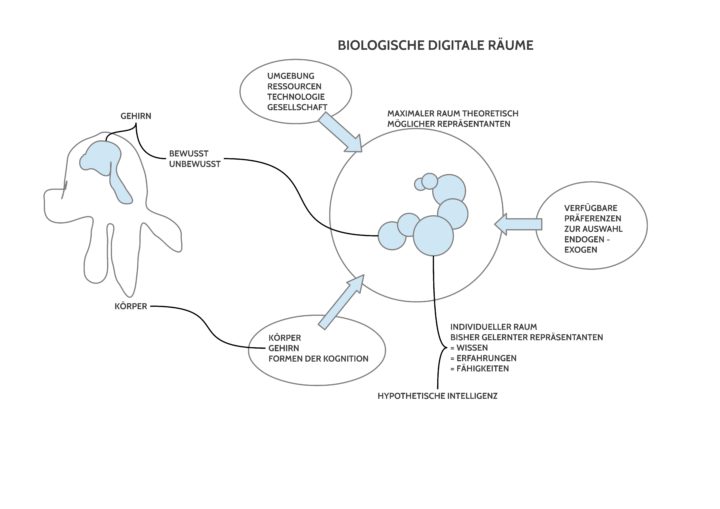

Bei der Analyse des Begriffs ‚Lernen‘ wird sichtbar, dass das, was gelernt wird, bei der Beobachtung des Verhaltens nicht direkt ’sichtbar‘ ist. Vielmehr gibt es eine allgemeine ‚Hypothese‘, dass dem äußerlich beobachtbaren Verhalten ‚interne Zustände‘ korrespondieren, die dafür verantwortlich sind, ob ein ’nicht-lernendes‘ oder ein ‚lernendes‘ Verhalten zu beobachten ist. Im Fall eines ‚lernenden‘ Verhaltens mit dem Auftreten von inkrementell sich mehrenden stabilen (S,R)-Paaren wird angenommen, das den (S,R)-Verhaltensformen ‚intern‘ entsprechende ‚interne Repräsentationen‘ existieren, anhand deren das System ‚entscheiden‘ kann, wann es wie antworten soll. Ob man diese abstrakten Repräsentationen ‚Wissen‘ nennt oder ‚Fähigkeiten‘ oder ‚Erfahrung‘ oder ‚Intelligenz‘ ist für die theoretische Betrachtung unwesentlich.

Die Psychologie hat um die Wende zum 20.Jahrhundert mit der Erfindung des Intelligenztests durch Binet und Simon (1905) sowie in Weiterführung durch W.Stern (1912) einen Ansatz gefunden, die direkt nicht messbaren internen Repräsentanten eines beobachtbaren Lernprozesses indirekt dadurch zu messen, dass sie das beobachtbare Verhalten mit einem zuvor vereinbarten Standard verglichen haben. Der vereinbarte Standard waren solche Verhaltensleistungen, die man Kindern in bestimmten Altersstufen als typisch zuordnete. Ein Standard war als ein Test formuliert, den ein Kind nach möglichst objektiven Kriterien zu durchlaufen hatte. In der Regel gab es eine ganze Liste (Katalog, Batterie) von solchen Tests. Dieses Vorgehensweisen waren sehr flexibel, universell anwendbar, zeigten allerdings schon im Ansatz, dass die Testlisten kulturabhängig stark variieren konnten. Immerhin konnte man ein beobachtbares Verhalten von einem System auf diese Weise relativ zu vorgegebenen Testlisten vergleichen und damit messen. Auf diese Weise konnte man die nicht messbaren hypothetisch unterstellten internen Repräsentationen indirekt qualitativ (Art des Tests) und quantitativ (Anteil an einer Erfüllung des Tests) indizieren.

Im vorliegenden Kontext wird ‚Intelligenz‘ daher als ein Sammelbegriff für die hypothetisch unterstellte Menge der korrespondierenden internen Repräsentanten zu den beobachtbaren (S,R)-Paaren angesehen, und mittels Tests kann man diese unterstellte Intelligenz qualitativ und quantitativ indirekt charakterisieren. Wie unterschiedlich solche Charakterisierung innerhalb der Psychologie modelliert werden können, kann man in der Übersicht von Rost (2013) nachlesen.

Wichtig ist hier zudem, dass in diesem Text die Intelligenz eine Funktion des Lernens ist, das wiederum von der Systemstruktur abhängig ist, von der Beschaffenheit der Umwelt sowie der Verfügbarkeit von Präferenzen.

Aus Sicht einer solchen allgemeinen Lerntheorie kann man statt biologischen Systemen auch programmierbare Maschinen betrachten. Verglichen mit biologischen Systemen kann man den programmierbaren Maschinen ein Äquivalent zum Körper und zur Umwelt spendieren. Grundlagentheoretisch wissen wir ferner schon seit Turing (1936/7), dass programmierbare Maschinen ihr eigenes Programm abändern können und sie prinzipiell lernfähig sind. Was allerdings (siehe zuvor das Thema Präferenz) bislang unklar ist, wo sie jeweils die Präferenzen herbekommen sollen, die sie für eine ’nachhaltige Entwicklung‘ benötigen.

ZUKUNFT VON MENSCH UND MASCHINE

Im Licht der Evolution erscheint die sich beschleunigende Zunahme von Komplexität im Bereich der biologischen Systeme und deren Populationen darauf hinzudeuten, dass mit der Verfügbarkeit von programmierbaren Maschinen diese sicher nicht als ‚Gegensatz‘ zum Projekt des biologischen Lebens zu sehen sind, sondern als eine willkommene Unterstützung in einer Phase, wo die Verfügbarkeit der Gehirne eine rapide Beschleunigung bewirkt hat. Noch bauen die biologischen Systeme ihre eigenen Baupläne nicht selbst um, aber der Umbau in Richtung von Cyborgs hat begonnen und schon heute ist der Einsatz von programmierbaren Maschinen existentiell: die real existierenden biologischen Kapazitätsgrenzen erzwingen den Einsatz von Computern zum Erhalt und für die weitere Entwicklung. Offen ist die Frage, ob die Computer den Menschen ersetzen sollen. Der Autor dieser Zeilen sieht die schwer deutbare Zukunft eher so, dass der Mensch den Weg der Symbiose intensivieren wird und versuchen sollte, den Computer dort zu nutzen, wo er Stärken hat und zugleich sich bewusst sein, dass das Präferenzproblem nicht von der Maschine, sondern von ihm selbst gelöst werden muss. Alles ‚Böse‘ kam in der Vergangenheit und kommt in der Gegenwart vom Menschen selbst, nicht von der Technik. Letztlich ist es der Mensch, der darüber entscheidet, wie er die Technik nutzt. Ingenieure machen sie möglich, die Gesellschaft muss entscheiden, was sie damit machen will.

BEISPIEL EINER NEUEN SYMBIOSE

Der Autor dieser Zeilen hat zusammen mit anderen KollegenInnen in diesem Sommer ein Projekt gestartet, das darauf abzielt, dass alle 11.000 Kommunen in Deutschland ihre Chancen haben sollten, ihre Kommunikation und Planungsfähigkeit untereinander dramatisch zu verbessern, indem sie die modernen programmierbaren Maschinen in neuer ‚intelligenter‘ Weise für ihre Zwecke nutzen.

QUELLEN

- Kathryn Merrick, Value systems for developmental cognitive robotics: A survey, Cognitive Systems Research, 41:38 – 55, 2017

- VDI, Statusreport Künstliche Intelligenz, Oktober 2018, URL: https://www.vdi.de/vdi-statusbericht-kuenstliche-intelligenz/ (zuletzt: 28.November 2018)

- Detlef H.Rost, Handbuch der Intelligenz, 2013: Weinheim – Basel, Beltz Verlag

- Joachim Funke (2006), Kap.2: Alfred Binet (1857 – 1911) und der erste Intelligenztest der Welt, in: Georg Lamberti (Hg.), Intelligenz auf dem Prüfstand. 100 Jahre Psychometrie, Vandenhoek & Ruprecht

- Alfred Binet, Théodore Simon: Methodes nouvelles pour le diagnostiqc du niveau intellectuel des anormaux. In: L’Année Psychologique. Vol. 11, 1904, S. 191–244 (URL: https://www.persee.fr/doc/psy_0003-5033_1904_num_11_1_3675 )

- William Stern, Die psychologischen Methoden der Intelligenzprüfung und deren Anwendung an Schulkinder, 19121: Leipzig, J.A.Barth

- Alan M. Turing, On computable numbers, with an application to the Entscheidungsproblem. Proceedings of the London Mathematical Society, 42(2):230–265, 1936-7

- Gerald M.Edelman, Bright Air, Brilliant Fire. On the Matter of the Mind, New York: 1992, Basic Books

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.