Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

7.Mai 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: doeben@fb2.fra-uas.de

ÜBERSICHT

I Fragmentierung der Welt als Dauerentfremdung

II Philosophie und Wissenschaft (Idealbild)

II-A Alltagserfahrung – Oberflächen .

II-B Jenseits des Alltags – Wissenschaft

II-C Homo Sapiens Heute – Digitale Versklavung beginnt

II-D Selbstvergewisserung – Speziell durch Meditation?

III Erst Reaktionen

III-A Erosion der Wissenschaft ’von innen’

III-B ’Digitalisierung’ als ’hypnotischer Zustand’? .

III-C Meditationserfahrung gegen Reflexion?

Quellen

IDEE

In diesem Text wird aufgezeigt, wie das Phänomen der Meditation im Koordinatensystem der modernen Philosophie und der empirischen Wissenschaften in einer mittlerweile hochtechnisierten Welt verortet werden kann. Ein Deutungsversuch. Er wurde provoziert durch ein Experiment an der Frankfurt University of Applied Sciences, an der seit dem Sommersemester 2017 das Thema ’Meditation’ als offizielles Fach Für alle Bachelor-Studierende der Universität angeboten wird.

I. FRAGMENTIERUNG DER WELT ALS DAUERENTFREMDUNG

In ihren Bachelorstudiengängen erwerben die Studierende grundlegende Kenntnisse über viele verschiedene Einzeldisziplinen. Wieweit diese Disziplinen eher als ’empirische wissenschaftliche Disziplinen’ daherkommen oder doch mehr als ein ’ingenieurmäßiges Anwendungsfeld’ hängt stark vom Charakter der einzelnen Disziplin ab. Sicher ist nur, diese Einzeldisziplinen vermitteln keine ’Gesamtsicht’ der Welt oder des Menschen in der Welt. Ein ’Betriebswirtschaftler’ pflegt einen ganz anderen Zugang zur Welt als ein ’Architekt’, eine ’Case-Managerin’ ist keine ’Elektrotechnikerin’, usw.

Vorab zu allen möglichen Spezialisierungen ist ein Studierender aber primär ein ’Mensch’, ein weltoffenes Wesen, das eine Orientierung im Ganzen sucht, mit einem Körper, der eines der größten Wunderwerke der biologischen Evolution darstellt. Gesellschaftliche Teilhabe, Kommunikation, Verstehen sind wichtige Facetten in einer menschlichen Existenz. Historische Kontexte, Kultur, Werte, eigene Lernprozesse, das eigene Erleben und Lernen, dies alles gehört wesentlich zum Menschsein.

In einer einzelnen Disziplin kommt all dies nicht vor. Wer sich voll in einer bestimmten Disziplin engagiert ist damit nur zu einem kleinen Teil seines Menschseins ’versorgt’. Es klaffen große Lücken. In diesem Kontext ein Modul ’Meditation als kulturelle Praxis’ anzubieten, adressiert ein paar zusätzliche Teilaspekte des studentischen Lebens. Es spricht den persönlichen Umgang mit dem eigenen Körper an, mit spezifischen Körpererfahrungen, die eine feste erlebnismäßige Basis im Strom der Alltagsereignisse bieten können. Damit diese konkrete Praxis nicht ’ir-rational’ daherkommt, werden Teile des kulturellen Kontextes, aus der Geschichte, aus dem heutigen Weltbild, mit erzählt. Wie verstehen Menschen das ’Meditieren’ zu verschiedenen Zeiten, in verschiedenen Kulturen, heute?

II. PHILOSOPHIE UND WISSENSCHAFT (IDEALBILD)

Zwei besonders wichtige Blickweisen in der europäischen Kultur werden durch die modernen empirischen Wissenschaften und durch die moderne Philosophie repräsentiert. Beide entwickelten sich in enger Wechselwirkung seit dem 17.Jahrhundert; sie schufen die Grundlage für moderne Technologien, Gesellschafts- und Wertesysteme. Auch legten sie die Basis für einen Blick auf das Universum, das Leben im Universum, wie auch auf das menschliche Erkennen, wie es in der bisherigen Geschichte des Lebens einmalig ist.

Nun ist der Umfang dieses wissenschaftlichen und philosophischen Wissens zu groß, um es hier auch nur ansatzweise ausbreiten zu können. Es soll aber versucht werden, ausgehend von der Alltagserfahrung und der Praxis der Meditation anzudeuten, wie sich dieses aus Sicht der Philosophie und der empirischen Wissenschaften darstellt.

A. Alltagserfahrung

Oberflächen In seinem Alltag erlebt sich der Mensch mit seinem ’Körper’, der in einem räumlichen Miteinander mit anderen Körpern und Objekten vorkommt. Er erlebt Veränderungen, Verhaltensweisen, asynchron und synchron: Menschen auf einer Straße können wild durcheinander laufen, sie können aber auch gemeinsam diszipliniert in einer Warteschlange stehen, sich im gemeinsamen Tanz bewegen, oder im direkten Gespräch ihr individuelles Verstehen miteinander verschränken.

Zugleich lernt jeder von früh an, dass es ’hinter der Oberfläche’, ’im’ Körper, eine Vielfalt von Ereignissen gibt, subjektive Erlebnisse, die das ’Innere’ eines Menschen charakterisieren. Einiges von diesen Vorgängen ist ’bewusst’, bildet das ’Bewusstsein’ des Menschen. Wir wissen aber heute, dass vieles im Inneren eines Körpers, eigentlich das meiste, ’nicht bewusst’ ist! So sind die ’Inhalte’ unseres ’Gedächtnisses’ normalerweise nicht bewusst; sie können aber bewusst werden, wenn bestimmte Ereignisse uns an etwas erinnern, und herausfordern. Solche Erinnerungen können wie eine Kettenreaktion wirken: eine Erinnerung aktiviert die nächste.

B. Jenseits des Alltags

Wissenschaft Mittlerweile wurde der menschliche Körper, seine Bauweise, viele seiner Funktionen, durch die Biologie, die Physiologie, die Psychologie und durch viele weitere Wissenschaften untersucht und partiell ’erklärt’, dazu auch das Miteinander mit anderen Menschen in seinen vielfältigen Formen.

Wir wissen, dass die ’innere Verarbeitung’ des Menschen die äußeren und die körperinternen Reize nach festen Verfahren zu allgemeinen Strukturen zusammenführt (’Cluster’, ’Kategorien’), diese untereinander vielfach vernetzt, und automatisch in einer Raumstruktur aufbereitet. Zugleich erlaubt das Gedächtnis jede aktuelle Gegenwart mit gespeicherten ’alten Gegenwarten’ zu vergleichen, was ein ’vorher/nachher’ ermöglicht, der Ausgangspunkt für ein Konzept von ’Zeit’. Dazu kommt die besondere Fähigkeit des Menschen, die Ausdrücke einer Sprache mit seinen ’inneren Zuständen’ ’verzahnen’ zu können. Ein Ausdruck wie ’Es ist 7 Uhr auf meiner Uhr’ können wir in Beziehung setzen zu unserer Wahrnehmung eines Gegenstandes am angesprochenen Arm.

Ein wichtiges Charakteristikum biologischer Körper ist auch ihre grundlegende ’Nicht-Determiniertheit’, eine grundlegende Voraussetzung für ’Freiheit’.

Dass diese komplexen inneren Mechanismen des menschlichen Körpers so scheinbar mühelos mit den Gegebenheiten der Körperwelt ’harmonieren’, kommt nicht von ungefähr. Die moderne Biologie mit Spezialgebieten wie z.B. der ’Mikrobiologie’, der ’Evolutionsbiologie’, der ’Paläobiologie’, der ’Astrobiologie’ 1 zusätzlich vereint mit Disziplinen wie der Geologie, Archäologie, der Klimatologie samt vielen Subdisziplinen der Physik und der Chemie; diese alle haben in über 100 Jahren konzertierter Arbeit die Geschichte der Lebensformen auf der Erde samt den parallelen Veränderungen der Erde mit ihrem Klima häppchenweise entschlüsselt, entziffert, dekodiert und immer wieder neu zu einem Gesamtbild zusammen gefügt. Das Bild, das sich daraus bis heute ergeben hat, zeigt eine ungeheure Vielfalt, eine bisweilen große Dramatik, vor allem aber das erstaunliche Phänomen, wie sich ’biologisches Leben’ anschickt, die freien Energiereserven des Universums ’anzuzapfen’, sie für sich ’nutzbar zu machen’, um damit immer komplexere Strukturen zu schaffen, die über einfache erste Zellen von vor ca. 3.8 Mrd. Jahren zu komplexen (’eukaryotischen’) Zellen führten, zu Zellverbänden, zu Pflanzen, zu Tieren und dann, sehr spät, ’erst vor kurzem’, zu einer Lebensform, die wir ’homo sapiens’ nennen, die sich von Ostafrika aus kommend, in ca. 45.000 Jahren über die ganze bekannte Erde ausgebreitet hat. Das sind wir.

Nimmt man die Erkenntnisse der Astrobiologie hinzu, dann wird deutlich, dass unser Planet Erde bisher eine äußerst ’lebensfreundliche’ Position in unserem Sonnensystem inne hatte; unser Sonnensystem wiederum befindet sich in einem sehr lebensfreundlichen Bereich unserer Heimatgalaxie, der Milchstraße mit ihren ca. 200 – 400 Mrd. Sternen; erst in ein paar Mrd. Jahren wird die Milchstraße – nach heutigem Kenntnisstand – mit der Andromeda- Galaxie kollidieren, die ca. 1 Bio. Sterne zählt.

C. Homo Sapiens Heute – Digitale Versklavung beginnt

Verglichen mit den langen Zeiträumen der Entwicklung des bekannten Universums (vor ca. 13.8 Mrd. Jahren), unserer Erde (vor ca. 4.5 Mrd. Jahren), des biologischen Lebens selbst (vor ca. 3.8 Mrd. Jahren) ist das Auftreten des homo sapiens (vor ca. 200.000 Jahre) verschwindend kurz. Betrachtet man nur die Zeit seit der Gründung der ersten Städte (vor ca. 11.000 Jahren), seit dem ersten Computer (vor ca. 88 Jahren), seit dem Internet (vor ca. 48 Jahren), dann muss man sagen, dass wir Menschen uns seit kurzem mitten in einer Revolution befinden, in der digitalen Revolution, die das Zeug dazu hat, die bisherige Lebensweise des homo sapiens so nachhaltig zu verändern, wie vielleicht vergleichbar mit der frühen Seßhaftwerdung des homo sapiens.

Ein Grundzug der Digitalisierung des menschlichen Lebens ist der Aufbau einer parallelen, einer digitalen Welt, in der ungeheure Datenmengen eingelagert werden können, riesige Datenströme schneller als menschliche Gedanken von überall nach überall hin und her strömen können, Daten, die partiell Abbilder, Kopien, Modelle der realen Welt darstellen, in denen Computerprogramme diese Datenberge geräuschlos verwalten, verarbeiten und in Maßnahmen umsetzen können.

Der homo sapiens mit seinem Körper für die Außenwelt und seinen bewussten kognitiven Prozessen in der ’Innenwelt’, wird über Schnittstellen mit der digitalen Welt verkoppelt und lebt immer mehr nur durch das Medium des Digitalen. Sein Körper, die Vorgänge in der Außenwelt, verlieren an Bedeutung. Die wahrgenommene Außenwelt wird zu einem immer kleiner werdenden Segment der subjektiv gedachten und digital aufbereiteten Welt. Falls der homo sapiens die Nutzung der digitalen Welt in der Zukunft nicht grundlegend anders organisiert, wird das einzelne, individuelle Gehirn zu einem bloßen Anhängsel einer neuen digitalen Galaxie, deren Beherrschung und Steuerung sich allen bekannten Kategorien aus der Außenwelt entzieht. Alle bekannten rechtliche, soziale und politische Kategorien werden nicht mehr gelten. Ganze Staaten verlieren ihren Halt, weil ihre Bürger in einer digitalen Welt leben, die von globalen anonymen Kräften beherrscht werden. Bürger mutieren zu ’Realwelt-Zombies’, deren Inneres zum Bestandteil über-individueller globaler Algorithmen geworden ist, die alle individuellen Regungen automatisch beobachten, und nach partiellen ökonomischen Interessen global steuern.

Noch ist diese Vision nicht vollständig wahr, aber doch schon soweit, dass es uns erschrecken sollte. Ist es das, was wir wollen, was wir wollen sollten?

D. Selbstvergewisserung – Speziell durch Meditation?

Eines der wichtigsten Themen der Philosophie war und ist zu allen Zeiten das Thema der ’Selbstvergewisserung’: wer bin ich, der ich wahrnehme, empfinde, denke, und handle? Bin ich das, was ich wahrnehme, empfinde etc. oder bin ich etwas davon ’Verschiedenes’, oder die ’Synthese’ aus all dem, oder etwas noch ganz anderes?

Die Palette der Antworten ist so breit, wie die Zeit lang ist. Jeder Philosoph hat das Thema irgendwie neu moduliert; bis heute gibt es nicht ’die’ Antwort.

Schon mittendrin in der digitalen Revolution, schon jetzt fast mehr im ’digitalen’ Raum als im ’realen Körperraum’, verschärft sich diese philosophische Fragestellung weiter: wenn das, was ich wahrnehme, immer weniger direkt mit der realen Körperwelt korrespondiert, dafür immer mehr mit digital aufbereiteten Objekten, deren Herkunft zu bestimmen immer schwieriger wird, dann kann es passieren, dass sich das individuelle erkennende Subjekt über eine (digitale) Objektwelt definiert, die weitgehend ein Fake ist, einzig dazu da, den Einzelnen zu manipulieren, ihn zu einem ferngesteuerten ’Diener des Systems’ zu machen, besser: zu einem ’digitalen Sklaven’.

Würde man die aktuelle Entwicklungstendenz der digitalen Revolution so fort schreiben, wie sie aktuell formatiert ist, dann würde dies zur totalen Auslöschung eines freien, kreativen Individuums führen. Denn selbst ein Individuum, das vom Ansatz her ein ’freies’ Individuum ist, würde durch eine reale Lebensform der manifesten digitalen Sklaverei jeglichen Ansatzpunkt verlieren, die Freiheit zu ’materialisieren’.

Um eine solche digitale Sklaverei zu verhindern, kann und muss man die aktuelle digitale Revolution ’um- formatieren’. Statt den menschlichen Benutzer zu einem vollständig manipulierten Bestandteil einer Population von wertfreien Algorithmen zu machen, die von einzelnen narzisstischen, macht-hungrigen und menschenverachtenden Menschen global gesteuert werden, sollte man den digitalen Raum neu, von ’unten-nach-oben’ organisieren. Der einzelne Mensch muss wieder zum Taktgeber werden, die individuelle Freiheit, Kreativität und in Freiheit geborenen Werte müssen in einer freien Gesellschaft wieder ins Zentrum gerückt werden, und die diversen Algorithmen und Datengebirge müssen diesen individuellen Freiheiten in einer demokratischen Gesellschaft ’dienen’!

Eine Grundvoraussetzung für solch eine neue ’Selbstvergewisserung’ von ’Freiheit’ ist eine radikale, authentische Selbstwahrnehmung des ganzen individuellen Daseins, weit-möglichst frei von manipulierten und gefakten Fakten. Natürlich kann dies nicht bedeuten, dass der Mensch sich all seiner Erfahrungen, all seines Wissens ’entleert’, das wäre die andere Form von Versklavung in der Dunkelheit eines radikalen ’Nicht-Wissens’. Aber in all seinen Erfahrungen, in all seinem Wissen, braucht es die Erfahrung ’seiner selbst’, wie man ’faktisch ist’, man ’selbst’, mit seinem ’Körper’, in einer Erfahrungswelt, die dem menschlichen Tun ’vorgelagert’ ist als das, was wir ’Natur’ nennen, die ’aus sich heraus gewordene und werdende Wirklichkeit’ der Erde im Universum, des Lebens auf der Erde, von dem wir ein Teil sind.

Natürlich, und das wissen wir mittlerweile, gerade auch durch das philosophische Denken im Einklang mit den empirischen Wissenschaften, haben wir Menschen niemals einen völlig authentischen, einen völlig ’ungefilterten’ Zugang zur ’Natur’. Einmal nicht, weil das menschliche Vermögen des Wahrnehmens und Verstehens aus sich heraus ’konstruktiv’ ist und wir die ’Außenwelt’ grundsätzlich nur im Modus unserer ’Innenwelt’ ’haben’, zum anderen nicht, weil wir selbst Teil dieser Natur sind und durch unsere Aktivitäten diese Natur mit verändern. Die erlebbare Natur ist von daher immer schon eine ’vom Menschen mit-gestaltete Natur’! Je mehr wir dies tun, je mehr wir selbst als Teil der Natur die Natur verändern, umso weniger können wir die Natur ’vor’ oder ’ohne’ den Menschen erleben.

Dennoch, bei aller ’Verwicklung’ des Menschen mit der umgebenden Natur, und heute noch zusätzlich mit der selbst geschaffenen digitalen Wirklichkeit, gibt es keine Alternative zu einer praktizierten Selbstvergewisserung mit vollem Körpereinsatz. Dies können intensive Formen körperlicher Aktivitäten sein – wie z.B. Gehen, Laufen, Fahrrad fahren, Mannschaftssport, Tanzen, Musizieren, … –, dies kann aber auch das ’Meditieren’ sein. Im Meditieren, mit dem Atmen als ’Referenzpunkt’, kann sich der einzelne mit all seinen Befindlichkeiten als ’Ganzes’ erleben, als direkt Gegebenes, mit einem ungefilterten Erleben, mit einer Feinheit des Erlebens, die nicht durch Alltagsrauschen ’überdeckt’, ’maskiert’ wird, und der einzelne kann darin nicht nur ’physiologische Entspannung’ finden, sondern auch – über die Zeit – durch seine erweiterte Wahrnehmung zu neuen, differenzierteren ’Bildern seiner selbst’ kommen, zum ’Entdecken’ von ’Mustern’ des Daseins, die über den aktuellen Moment hinaus auf Wirkzusammenhänge verweisen, die im Alltagsrauschen normalerweise völlig untergehen. Darüber hinaus können sich – meist auf Dauer – Erlebnisse, Erfahrungen einstellen, die sich in spezifischer Weise ’wohltuend’ auf das gesamte Lebensgefühl eines einzelnen auswirken, die einen ’gefühlten Zusammenhang mit Allem’ ermöglichen, der das ’Gefühl für das Ganze’ deutlich verändert. Dieses ’Wohlfühlen’ ist ’mehr’ als physiologische Entspannung, es sind ’Gefühle eines komplexen Existierens’, zu dem nur biologische Systeme fähig sind, deren Körper aufgrund ihrer quanten-physikalischen Offenheit in allen Richtungen Wirklichkeit ’registrieren’ können. Auch das Thema sogenannter ’mystischer’ Erfahrungen gehört in diesen Kontext. Leider gibt es dazu kaum wissenschaftliche Forschungen, aber viele Phänomene, die der Erklärung harren.

III. ERST REAKTIONEN

Obwohl dieser Text erst wenige Tage alt ist, kam es schon zu interessanten Rückmeldungen. Einige davon seien hier ausdrücklich genannt, da sie helfen können, den Kern der Aussage noch weiter zu konturieren.

A. Erosion der Wissenschaft ’von innen’

Wenn im vorausgehenden Text von ’Wissenschaft’ die Rede ist, dann wurde in diesem Text ein Idealbild von Wissenschaft unterstellt, das es so heute ansatzweise gar nicht mehr gibt, und das tendenziell dabei ist, sicher weiter zu verwischen. Für das Projekt einer Zukunft mit dem homo sapiens als aktivem Teilnehmer ist dies brandgefährlich!

Für eine ausführliche Beschreibung dieser beginnenden Erosion von Wissenschaft bräuchte es einen längeren Text. Hier zwei Beispiele, die als erste ’Indikatoren’ dienen mögen.

Vor wenigen Tagen hatte ich Gelegenheit, im Rahmen eines sogenannten ’Graduiertenkollegs’ mit Studierenden von 6 verschiedenen Universitäten mit 7 verschiedenen akademischen Profilen arbeiten zu können; alle waren DoktorandenInnen.

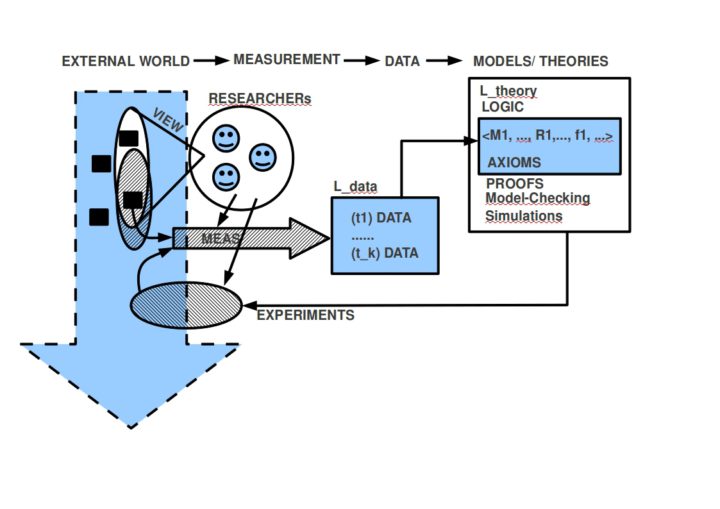

Wir nahmen uns zu Beginn die Zeit, mittels einfacher Zettel, mal zusammen zu stellen, was jedem von ihnen zum Thema ’Wissenschaft’ einfällt. Das Ergebnis war erschreckend. Kein einziger war in der Lage, ein auch nur annähernd ’korrektes’ Bild dessen zu zeichnen, was ’standardmäßig’ unter dem Begriff ’Wissenschaft’ zu verstehen ist; keiner. Nachdem wir dann in Ruhe alle Beiträge gemeinsam diskutiert und in einen Gesamtzusammenhang eingeordnet hatten (mit vielen Ergänzungen), war die einhellige Reaktion, dass sie dieses in ihrem ganzen Studium noch nie gehört hätten, und dass sie ein großes Interesse hätten, dazu mehr zu erfahren.

Also, eine Zufallsauswahl von jungen Menschen, die eine Doktorarbeit schreiben wollen, war nicht in der Lage, ein belastbares Konzept von ’Wissenschaft’ zu kommunizieren, und das nach ca. 5-6 Jahren Studien an 6 verschiedenen Universitäten in 7 verschiedenen Fachprofilen.

Wer diesen Befund jetzt mit dem Hinweis wegwischen möchte, dass dies auf keinen Fall repräsentativ sei, dem möchte ich ein neueres Handbuch der Wissenschaftsphilosophie zu den Philosophien der Einzelwissenschaften zur Lektüre empfehlen (siehe: [LR17]). In diesem Buch von 2017 wird von Experten der Wissenschaftsphilosophie in 22 Kapiteln sehr kenntnisreich, mit umfänglichen Literatursammlungen, dargelegt, was heute die großen Strömungen im Verständnis von Wissenschaft sind. Was man in diesen Texten nicht findet – ich konnte bislang 6 von 22 Kapiteln lesen –, ist ein klares Konzept, was dann heute unter ’Wissenschaft’ verstanden wird oder verstanden werden sollte. Wenn mir beispielsweise für die Disziplinen Mathematik, Philosophie, Ingenieurwissenschaften und Psychologie – ohne Zweifel sehr kenntnisreich – allerlei Strömungen und Problemdiskussionen präsentiert werden, das Fach selbst samt Wissenschaftsbegriff aber nicht zuvor geklärt wird, dann ist die Aufzählung von all den interessanten Aspekten wenig hilfreich. Alles verschwimmt in einem großen Brei. Und die Studierenden (siehe das Beispiel oben) durchlaufen den Wissenschaftsbetrieb und wissen nachher eigentlich nicht, was man unter ’Wissenschaft’ versteht bzw. verstehen sollte.

Das meine ich mit ’innerer Erosion’ von Wissenschaft: der Wissenschaftsbetrieb als ganzer weist heute riesige, komplexe Organisationsformen auf, verschlingt riesige Geldsummen, aber keiner scheint mehr zu wissen, was es eigentlich ist, was man da macht.

B. ’Digitalisierung’ als ’hypnotischer Zustand’?

Ein ähnliches Phänomen kann man im Umfeld des Phänomens der ’Digitalisierung von Gesellschaft’ beobachten. Mittlerweile vergeht nicht ein Tag, an dem nicht in Zeitungen, im Fernsehen, in Fachartikeln, in Romanen das Phänomen der Digitalisierung beschworen wird. Zumeist hält man sich bei einigen Auswirkungen auf, die in der Tat bedrohlich erscheinen oder sogar sind, aber fast nirgends findet man fundierte Analysen von jenen Technologien, die ’hinter’ den Phänomenen tatsächlich am Werk sind. Am schlimmsten ist das Wort ’Künstliche Intelligenz’. Obwohl es bis heute keine wirklich akzeptierte Definition gibt, jeder damit etwas anderes meint (Anmerkung: Eines der am häufigsten zitierten Lehrbücher zur künstlichen Intelligenz enthält über viele hundert Seiten unzählige Beispiele von einzelnen mathematischen Konzepten (und Algorithmen), aber eine klare Definition wird man nicht finden, auch keine klare Einordnung in das Gesamt von Wissenschaft; siehe [RN10] ) wird so getan, als ob klar ist, was es ist, als ob es so einfach wäre, dass künstliche Intelligenz sich verselbständigen könnte und die ’Herrschaft über die Menschen’ übernehmen wird. Zeitgleich fällt das Bild vom Menschen in ein schwarzes Loch des Nichtwissens, aus dem es kein Entrinnen gibt, um der umfassenden gesellschaftlichen ’Hypnose’ der Digitalisierung ein paar vernünftige Gedanken entgegen zu setzen. Eine der wenigen kritische, dekonstruierende Stellungnahme ist für mich ein Artikel von Sarah Spiekermann (siehe [Spi18]), in dem sie die ernüchternde Schwachheit des ganzen Big-Data-Ansatzes klar ausspricht und welche Gefahren gerade dadurch für uns als Gesellschaft davon ausgehen. Nicht die ’Stärke’ dieser Algorithmen bildet eine Gefahr, sondern ihre grandiose Schwäche, durch welche die Komplexität der Gegenwart und die noch größeren Komplexität der noch unbekannten Zukunft vor unserem geistigen Auge verdeckt wird.

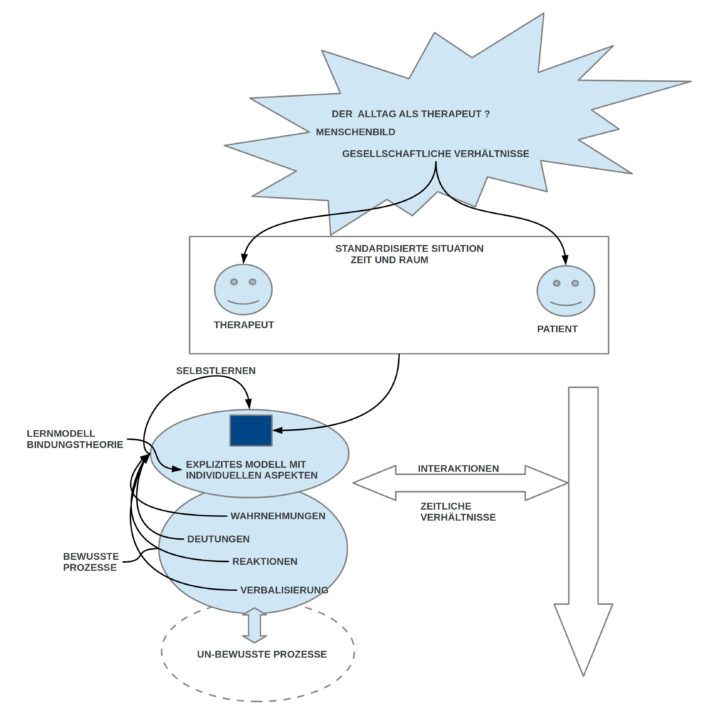

C. Meditationserfahrung gegen Reflexion?

Einen anderen interessanten Reflex durfte ich erfahren (nicht unbedingt erst seit diesem Text): diejenigen, die Meditation schon für ihr Leben entdeckt haben, es bisweilen viele Jahre oder gar schon Jahrzehnte, praktizieren, reagieren spontan mit Abwehr auf die ’Vereinnahmung’ von Meditation durch Reflexion, durch Wissen, was sie als ’Quelle von Störungen’ erfahren, als Hindernis zur tieferen, inneren Erkenntnis und Erfahrung.

Kommunikation in diesem Kontext wird dadurch erschwert, dass das Phänomen ’Meditation’ ja nicht nur über tausende von Jahren in unterschiedlichen kulturellen Kontexten praktiziert und interpretiert wurde (und niemand beherrscht rein wissensmäßig alle diese Traditionen), sondern die Meditationserfahrung selbst spielt sich in jenen inneren Bereichen des Körpers ab, die sich einem direkten ’Zugriff von außen’ entziehen und die von daher schwer bis gar nicht mit ’klaren sprachlichen Ausdrücken’ kommunizierbar sind. Jeder muss immer unterstellen, dass der andere ’das Gleiche’ meint, wie man selbst, ohne es wirklich kontrollieren zu können. Auch die modernen Verfahren der Hirnforschung bieten hier nur sehr abstrakte, äußerliche Kriterien zu irgendwelchen physiologischen Parametern, die keinen direkten Schluss auf die tatsächlichen internen Prozesse zulassen (dazu: Jonas/ Kording (2017) [JK17]).

Zu diesen objektiven Schwierigkeiten kommt aber dann eine verbreitete subjektive Abwehr von Reflexion in meditativen Kontexten, da es sowohl dominante Tendenzen in den verschiedenen Traditionen gibt, die diese ’inneren Prozesse/ Zustände/ Erlebensformen…’ im direkten Gegensatz zu ’diskursiven Tätigkeiten’ sehen, wie auch durch die Tatsache bedingt, dass die ’alten Traditionen’ die modernen (wissenschaftlichen und philosophischen) Sichtweisen in keinster Weise kannten. Obwohl also einerseits die Meditation selbst ’diskursfrei’ gesehen wird, wird ihre ’Einbettung in den gesellschaftlichen Kontext’ mit einem begrifflichen Rahmen ’verpackt’, ’interpretiert’, der von modernen Erkenntnissen ’unberührt’ ist.

Es wäre schon viel gewonnen, wenn man zwischen dem ’inneren meditativen Erfahrungsraum’ und den sekundären begrifflichen Erklärungsmustern klar unterscheiden würde. Egal ob ein Buddhist, eine Jude, ein Christ oder ein Muslim – oder wer auch immer – etwas zu Meditation sagt, das ’Reden über Meditation’ ist nicht gleichzusetzen mit dem Meditieren selbst und den hier stattfindenden Ereignissen. Wie eine Reihe von Untersuchungen nahelegen (z.B. Stace (1960) [Sta60]), kann der gleiche Sachverhalt, je nach kulturellem Vor- Wissen, ganz unterschiedliche interpretiert werden.

Von daher kann es sehr wohl sein – und der Autor dieser Zeilen geht davon aus – dass der ’Innenraum’ des Meditierens im ’Lichte’ der Erkenntnisse der neueren Philosophie(en) und Wissenschaften eine ganz neue Deutung finden kann. Insofern das Meditieren im Grundansatz an den Phänomenen des ’Innenraums’ orientiert ist (die nichts mit den Phänomenen des ’Außenraums’ zu tun haben müssen!), hat Meditation eine an ’Erfahrung’ orientierte Ausrichtung, die von allen, die sich ’in gleicher Weise’ verhalten, ’im Prinzip reproduzierbar’ ist. Bezieht man die aktuellen empirischen Wissenschaften mit ihren reproduzierbaren Messprozessen auf die ’intersubjektiven Phänomene’ des ’Körperraums’, dann weisen die meditativen Erfahrungen hin auf einen ’erweiterten Erfahrungsraum’, der sich bislang nur durch den vollen Körpereinsatz unter Einbeziehung der ’Phänomene des Innenraums’ manifestiert, und der ansatzweise erfahrungsmäßig reproduzierbar ist.

Während der Innenraum der Meditation im Prinzip versucht, reflektierende Prozesse ’raus zu halten’, kann die begleitende Reflexion vorher und nachher sehr wohl versuchen, das Getane und Erlebte mit dem verfügbaren Wissen zu vernetzten und damit in bekannte Zusammenhänge einzuordnen. Genauso wenig aber, wie aus empirischen Messwerten ’rein automatisch’ Modelle oder Theorien folgen, genauso wenig folgen aus meditativen ’Erlebnissen/ Erfahrungen…’ irgendwelche Modelle oder Theorien. Jede Art von übergreifendem Zusammenhang ist die kreative Eigenleistung eines Individuums und muss sich vor dem Gesamtheit der Erfahrung und im Experiment ’bewähren’.

Vor diesem Hintergrund kann keine Zeit für sich einen absoluten Interpretationsanspruch zum Phänomen der Meditation beanspruchen! Im Gegenteil, jede neue Zeit ist herausgefordert, bisherige Interpretationen im Lichte neuer Erfahrungen, neuer Experimente, immer wieder zu überprüfen.

LITERATUR

[JK17] E. Jonas and K.P. Kording. Could a neuroscientist understand a microprocessor? PLoS Comput Biol, 13(1):1–24, January 2017.

[LR17] Simon Lohse and Thomas Reydon. Grundriss Wissenschaftsphilosophie. Die Philosophien der Einzelwissenschaften. Wissenschaftliche Buchgesellschaft, Darmstadt (Germany), 1 edition, 2017.

[RN10] Stuart Russel and Peter Norvig. Artificial Intelligence. A Modern Approach. Universe Books, 3 edition, 2010.

[Spi18] Sarah Spiekermann. Die große big-data-illusion. FAZ, (96):13, 25.April 2018.

[Sta60] W.T. Stace. Mysticism and Philosophy. Jeremy P.Tarcher, Inc., Lo Angeles (CA), 1 edition, 1960.

KONTEXT BLOG

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER