Tweet #TwitterGeschichten

(Unter twitter bei ‚cagentartist‘))

Letzte Änderung: 29.Juli 2013, 00:14h

THEMATISCHER RAHMEN BISHER

1) Dieser Blog widmet sich primär der Frage nach dem neuen Weltbild: wie können, bzw. dann auch, wie sollten wir unsere Welt und das Leben in ihr ‚deuten‘, wenn wir alles Wissen zusammen nehmen, was wir uns bislang erarbeitet haben. Es ist eine grundlegend philosophische Frage insofern im Blog die Philosophie als die allgemeinste und umfassendste Reflexionseinstellung identifiziert wurde, der man sämtliche andere Disziplinen zuordnen auch. Die ‚Kunst‘ gehört zur ‚Art und Weise‘, wie man philosophieren kann. Die ‚Theologie‘ ist eine spezialisierte Fragestellung innerhalb der Philosophie, und sie ist als ‚theologia naturalis‘ nicht beliebig sondern ‚unausweichlich‘ (was nicht impliziert, dass es so etwas wie einen ‚Schöpfergott‘ geben muss).

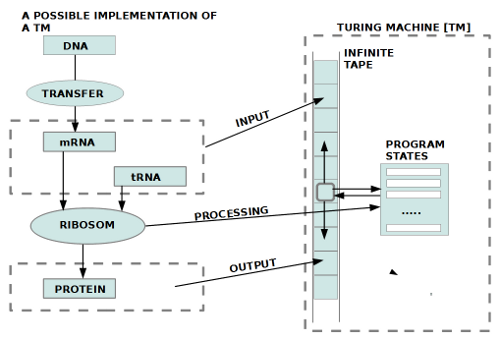

2) Im Laufe der vielen Einzelreflexionen hat sich bislang ein Bild vom Universum und der Welt herausgeschält, in dem der klassische Begriff von ‚Geist‘ und der von ‚Materie‘ immer mehr dahingehend aufgelöst wurden , dass man sie nicht mehr trennen kann. Zwar sind die Alltagsphänomene, die wir mit ‚Geist‘ verknüpfen, grundsätzlich verschieden von den Alltagsphänomenen, die wir mit ‚Materie‘ verknüpfen, aber die wissenschaftlichen Forschungen haben uns geholfen, die Makrophänomene des Alltags mehr und mehr von ihren Grundlagen her zu verstehen und sie in den Zusammenhang einer dynamischen Entwicklung zu setzen. In dieser Perspektive verschwimmen die Abgrenzungen und es wird deutlich, dass das im Alltag über Jahrtausende Getrennte einen inneren Zusammenhang aufweist, und letztlich sich in dem, was wir alltäglich ‚geistig‘ nennen, genau jene Eigenschaften zeigen, die die sogenannte ‚Materie‘ ausmachen. Mehr noch, wir konnten lernen, das Materie und ‚Energie‘ nur zwei verschiedene Zustandsformen ein und derselben Sache sind. Während man also – Einstein vereinfachend – sagen kann Energie ist gleich Materie, müsste man im Fall des Geistes sagen, das uns vom Geist Bekannte zeigt die ‚inneren‘ Eigenschaften der Energie-Materie an, was natürlich die Frage aufwirft, was man sich unter dem ‚Inneren‘ von Materie bzw. Energie vorzustellen hat. Aus der Mathematik – und dann aus der Physik, die die Mathematik als Sprache benutzt – kennen wir den Begriff der ‚Funktion‘ (andere Worte für das Gleiche: ‚Abbildung‘, ‚Operation‘, ‚Prozedur‘, ‚Programm‘, ‚Algorithmus‘,…).

BEGRIFF DER FUNKTION

3) Funktionen definiert man als spezielle Beziehungen zwischen ‚Mengen‘. Während Mengen für irgendwelche ‚Elemente‘ stehen, die man im empirischen Bereich mit irgendetwas Messbarem verknüpfen können muss, sind die Abbildungsbeziehungen, die durch eine Funktion beschrieben werden sollen, selbst keine Objekte, nicht direkt messbar! Eine Funktion ‚zeigt sich‘ nur indirekt ‚anhand ihrer Wirkungen‘. Wenn der berühmte Apfel Newtons zu Boden fällt, kann man ein Objekt beobachten, das seine Position im Raum relativ zum Beobachter verändert. Man bekommt sozusagen eine Folge (Serie, Sequenz, …) von Einzelbeobachtungen. In der Alltagssprache hat man diese Menge von Positionsveränderungen in der Richtung ‚von oben‘ (Sicht des Beobachters) nach ‚Unten‘ mit dem Verb ‚fallen‘ zusammengefasst. Der Apfel selbst mit seiner aktuellen Position fällt nicht, aber relativ zu einem Beobachter mit Gedächtnis, gibt es eine Folge von vielen Einzelpositionen, die es ermöglichen, den Begriff der ‚Veränderung‘ mit einer ‚Richtung‘ zu ‚konstruieren‘ und in diesem nur im Beobachter existierenden ‚Wissen‘ dann das Konzept des ‚Fallens‘ zu bilden und auf die Objekte der Alltagswelt anzuwenden. Ein Beobachter, der den Begriff ‚Fallen‘ gebildet hat, ’sieht‘ ab sofort ‚fallende Objekte‘ – obwohl natürlich kein einziges Objekt tatsächlich ‚fällt‘. Das Fallen ist eine Konstruktion und dann ‚Projektion‘ unserer geistigen Struktur im Umgang mit der Alltagswelt.

4) [Anmerkung: Möglicherweise werden an dieser Stelle viele sagen, dass dies doch ‚Unsinn‘ sei, da wir doch die Veränderung ’sehen‘. Und in der Tat ist es sehr schwer bis unmöglich, diese Analyse zu vollziehen, wenn man den Vorgang nicht rekonstruiert. Eine ideale Möglichkeit, solch eine ‚Analyse durch Synthese‘ vorzunehmen ist heute gegeben durch die Computersimulation von kognitiven Prozessen, allerdings nicht automatisch; man braucht natürlich schon eine passende Theorie. Bei dem Versuch, solche Prozesse nachzubauen sieht man sehr schnell, dass noch so viele Einzelbeobachtungen keinen komplexen Begriff ergeben; würde unser Gehirn die verschiedenen Positionen des Apfels nicht ’speichern‘ und zugleich wieder auch ‚erinnern‘ können, und diese einzelnen Erinnerungen zu einem komplexeren Konzept ‚zusammenbauen‘, und zwar so, dass aktuelle Beobachtungen als ‚zugehörig‘ zu dem neuen komplexen Begriff ‚entschieden werden können‘, wir könnten keine ‚Fallbewegung‘ erkennen. Wir würden immer nur einen Apfel sehen, der eben ‚da‘ ist. Die ‚Aufschlüsselung des ‚Daseins‘ in eine komplexe ‚Bewegung‘ setzt einen komplexen Erkenntnisapparat voraus, der dies ’sichtbar‘ macht. ]

WIRKLICHKEITSSTATUS EINER FUNKTION

5) Welchen Wirklichkeitsstatus sollen wir jetzt der Eigenschaft des Fallens zusprechen? Ist es eine reine ‚Einbildung‘, eine bloße ‚gedankliche Konstruktion des Gehirns‘, zwar gültig ‚im‘ Gehirn aber nicht ‚außerhalb‘ des Gehirns, also ‚gedacht = virtuell‘ und nicht ‚real‘ existierend (allerdings auch als Gedachtes ist es etwas real Existierendes, dessen ‚Begleitwirkungen‘ man als physikalische Prozesse im Gehirn partiell messen kann)? Allerdings, wenn sich im ‚Verhalten‘ eines Objektes der Außenwelt etwas – wenngleich durch durch ‚Zwischenschaltung eines Erkenntnisprozesses‘ – zeigt, so gilt, dass es sich nicht zeigen muss. Das, was wir ‚Empirisch‘ nennen, hat die Eigenschaft, dass es sich zeigen kann, auch wenn wir nicht wollen, und sich nicht zeigen kann, obwohl wir wollen. Das – für uns als Beobachter – Empirische ist das uns gegenüber ‚Widerständige‘, das sich unserer subjektiven Kontrolle entzieht. Die Zwischenschaltung von ‚Messprozessen‘ bzw. ‚Erkenntnisprozessen‘, die in sich ‚unveränderlich‘ sind, d.h. als eine Konstante in den verschiedenen Ereignissen betrachtet werden können, erlaubt damit das Wahrnehmen von ‚Empirischem‘, und dieses Empirische zeigt sich dann auch in ‚Veränderungsprozessen‘, die zwar nur ’sichtbar‘ werden durch komplexe Operationen, die aber unter Beibehaltung der ‚konstanten‘ Erkenntnisprozesse reproduzierbar sind und damit offensichtlich etwas vom ‚Anderen‘ enthüllen, eine implizite Eigenschaft, eine ‚emergente‘ Eigenschaft, die über das Einzelereignis hinausgeht.

6) Bekommt man auf diese Weise eine erste Ahnung davon, was eine ‚Funktion‘ ist und weiß man, dass nahezu alle wichtigen Eigenschaften der Natur mittels Funktionen beschrieben werden (in der Alltagssprache die ‚Verben‘, ‚Tätigkeitswörter‘), dann kann man vielleicht ahnen, was es heißt, dass das, was wir traditionellerweise ‚Geist‘ genannt haben, ausschließlich auf solche Eigenschaften zurückgeht, die wir mittels Funktionen beschreiben: Veränderungen, die stattfinden, die keinen ‚äußeren‘ Grund erkennen lassen, sondern eher den Eindruck erwecken, dass es ‚Faktoren/ Eigenschaften‘ im ‚Innern‘ der beteiligten Elemente gibt, die wir ‚postulieren‘, um zu ‚erklären‘, was wir sehen. Aristoteles nannte solch ein Denken ‚meta-physisch‘; die moderne Physik tut nichts anderes, nur sind ihre Bordmittel ein wenig ausgeweitet worden….

STRUKTURELLE KOMPLEXITÄT WÄCHST EXPONENTIELL

7) Zwar wissen wir mit all diesen Überlegungen immer noch nicht so richtig, was ‚Geist‘ denn nun ‚eigentlich‘ ist, aber wir konnten auch sehen, dass seit dem sogenannten ‚Big Bang‘ vor ca. 13.8 Milliarden Jahren die ’strukturelle Komplexität‘ (siehe die genauere Beschreibung in den vorausgehenden Blogeinträgen) des beobachtbaren Universums – entgegen allen bekannten physikalischen Gesetzen, insbesondere gegen die Thermodynamik – exponentiell zunimmt. Wir leben heute in einer Phase, wo die Beschleunigung der Komplexitätsbildung gegenüber den Zeiten vor uns ein Maximum erreicht hat (was nicht heißt, dass es nicht ’noch schneller‘ gehen könnte). Von den vielen Merkmalen der strukturellen Komplexitätsbildung hatte ich nur einige wenige herausgegriffen. Während der homo sapiens sapiens als solcher einen gewaltigen Sprung markiert, so ist es neben vielen seiner kognitiven Fähigkeiten insbesondere seine Fähigkeit zur Koordination mit den anderen Gehirnen, seine Fähigkeit zum Sprechen, zum Erstellen komplexer Werkzeuge, die Fähigkeit komplexe soziale Rollen und Strukturen einzurichten und zu befolgen, die überindividuelle Wissensspeicherung und der Wissensaustausch, die Erfindung des Computers und der Computernetzwerke, die das lokal-individuelle Denken ins scheinbar Unendliche ausgedehnt und beschleunigt haben.

ENDE DER NATIONALSTAATEN?

8) Fasst man alle diese Veränderungsphänomene zusammen, dann entsteht der Eindruck, als ob die Entwicklung des Lebens in Gestalt des homo sapiens sapiens auf einen neuen Entwicklungssprung hinausläuft, der sowohl eine massive Veränderung seines Körpers (durch Veränderung des Genoms) mit einschließt wie auch eine massive Veränderung in der Art des konkreten Lebens: so wie es ca. 2 Milliarden Jahre gedauert hat, bis aus den einzelnen Zellen organisierte Zellverbände gebildet haben, die hochdifferenzierte ‚Körper‘ als ‚Funktionseinheit‘ ausgebildet haben, so kann man den Eindruck gewinnen, dass wir uns in solch einer Übergangsphase von einzelnen Personen, kleinen Kommunen, Städten zu einem ‚globalen Organismus‘ befinden, in dem zwar jeder einzelne als einzelner noch vorkommt, wo aber die ‚Gesamtfunktion‘ immer größere Teile der Erdpopulation umfassen wird. Die Zeit der ‚Nationalstaaten‘ neigt sich dem Ende entgegen (ein paar tausend Jahre Übergangszeit wären in der Evolution weniger wie eine Sekunde; es spricht aber alles dafür, dass es erheblich schneller gehen wird)) .

FRAGEN DURCH DAS AKTUELL NEUE

9) Dies alles wirft ungeheuer viele Fragen auf, auf die wir bislang wohl kaum die passenden Antworten haben, woher auch. Antworten ergeben sich ja immer nur aus Fragen, und Fragen ergeben sich aus Begegnung mit etwas Neuem. Das neue geschieht ja erst gerade, jetzt.

KONTROLLE ODER KREATIVITÄT?

10) Wie schon in vorausgehenden Blogeinträgen angemerkt, gibt es unterschiedliche Stile, wie einzelne, Firmen und ganze Gesellschaften mit neuen Herausforderungen umgehen. Eine beliebte Form ist die ‚Kontrolle‘ anhand ‚bekannter‘ Parameter. Evolutionstheoretisch und aus Sicht des Lernens ist dies die schlechteste aller Strategien. Es ist der schnellste Weg zum Zusammenbruch des bisherigen Systems, speziell dann wenn es wenigstens ein konkurrierendes System gibt, das statt mit Kontrolle mit gesteigerter Kreativität, Kommunikation, und erneuerter Modellbildung reagieren kann. Die Wahrscheinlichkeit mit der zweiten Strategie neuere und bessere Antworten zu finden, ist um Dimensionen größer, wenngleich nicht ohne Risiko. Die Kontrollstrategie hat aber das größere Gesamtrisiko und führt fast unausweichlich zum Scheitern, während die Kreative Strategie partiell riskant ist, aber insgesamt – sofern es überhaupt eine Lösung gibt – diese finden wird. Die Kontrollstrategie ist emotional gekoppelt an ‚Angst‘, die Kreative Strategie an ‚Vertrauen‘. (In der Tradition der christlichen Spiritualität gibt es eine Grundregel, mittels der man erkennen kann, ob man sich in Übereinstimmung mit ‚Gott‘ befindet oder nicht: das Phänomen des ‚Trostes‘, der ‚Freude‘, der ‚Gelassenheit‘, des ‚Vertrauens‘, der ‚Angstfreiheit‘; d.h. wenn ich etwas tue, was in mir ‚real‘ (!) auf Dauer keinen ‚Trost‘ bewirkt, keine ‚Freude‘, keine ‚Gelassenheit‘, kein ‚Vertrauen‘, keine ‚Angstfreiheit‘, dann bewege ich mich nicht in die Richtung, die Gott von mir erwartet. Auch wenn man nicht an die Existenz eines ‚Gottes‘ glaubt, ist es interessant, dass die Kernelemente christlicher Spiritualität nahezu identisch sind mit den Kernelementen einer modernen mathematischen Lerntheorie, die für alle lernende System gilt, die auf der Erde überleben wollen).

DAS SNOWDON SYNDROM

11) Was hat dies alles mit dem ‚Snowdon Syndrom‘ zu tun? Warum ‚Syndrom‘? Ich verstehe unter ‚Syndrom‘ hier das Zusammenspiel vieler Faktoren, die einerseits einzeln zu wirken scheinen, andererseits aber vielfältig untereinander wechselwirken, sich gegenseitig beeinflussen. Und die Ereignisse ‚um Snowdon herum‘ erscheinen mir so als ein Netzwerk von Ereignissen, Äußerungen, Entscheidungen, die, bei näherer Betrachtung, sehr wohl Zusammenhänge erkennen lassen, die sich mit der Thematik des neuen Weltbildes berühren.

12) Innerhalb der letzten knapp vier Wochen (2.-27.Juli 2013) konnte ich 48 Artikel zum Snowdon Syndrom lesen, zwei Artikel aus dem Frühjahr 2012 habe ich nachgelesen. Dazu kam die eine oder andere Sendung im Radio und Fernsehen. Bedenkt man, wie wenig Zeit man täglich hat, überhaupt Zeitung zu lesen, ist das viel. Gemessen am Thema und seinen sachlichen Verästlungen ist es verschwindend gering. Die folgenden Gedanken sollten daher nur als Denkanstöße verstanden werden.

NETZÜBERWACHUNG REIN TECHNISCH

13) Auslöser für die vielen Artikeln und Beiträgen in den Medien waren die spektakuläre Reise von Snowdon nach Hongkong, seine Weitereise nach Moskau, sein dortiges bislang aufgezwungenes Verweilen, und natürlich seine Mitteilungen über Praktiken amerikanischer Geheimdienste, insbesondere der NSA, der National Security Agency. Viele behaupteten nach den ‚Enthüllungen‘, dass sich das ja eigentlich jeder hätte denken können, dass so etwas passiert, was zumindest für alle Informatikexperten gilt, und hier insbesondere bei jenen, die sich mit Netz- und Computersicherheit beschäftigen; die wissen seit vielen Jahren nicht nur, wie man in Netze und Computer eindringen und sie manipulieren kann, sondern auch, dass dies täglich in tausendfachen Formen geschieht. Akteure sind einmal kriminelle Organisation, die hier ein Eldorado zum Geldverdienen entdeckt haben, Teile davon sind Wirtschaftsspionage, anderes sind geheimdienstliche Aktivitäten für allerlei Zwecke, u.a. einfach zur ‚Absicherung der Macht‘ bestimmter Gruppen. Für diese Experten haben die Meldungen von Snowdon in der Tat nichts wirklich Neues gebracht, höchstens ein paar mehr Details zum Ausmaß der Aktivitäten der amerikanischen Regierung.

14) Ich würde hier auch gerne unterscheiden zwischen den ‚technischen‘ Aspekten von Datenausspähungen, Datenmanipulationen einerseits und den ’sozialen‘, ‚politischen‘, ‚kulturellen‘ und ‚ethischen‘ Aspekten andererseits. Rein technisch haben die Mitteilungen von Snowdon nichts Neues erbracht. Auch die verschiedenen Techniken, die sowohl Geheimdienste wie auch Netzfirmen wie Google, Facebook und Amazon (um die bekanntesten zu nennen) anwenden, aus einer großen Datenmenge (‚big data‘) solche ‚Informationen‘ zu extrahieren, die Hinweise auf spezielle Eigenschaften oder Trends bestimmter Personen und Personengruppen liefern, sind generell bekannt, werden an vielen Universitäten und speziellen Firmen dieser Welt gelehrt und entwickelt (dazu natürlich in vielen speziellen Labors vieler Staaten im Wahn, ein spezielles Labor könnte geheim etwas entwickeln, was die vielen Universitäten nicht könnten. Das ist eine grobe Täuschung. Würde man die Gelder der NSA in alle Universitäten umleiten, wäre der kreativ-produktive Effekt auf die Gesellschaft und Wirtschaft ein Vielfaches von dem, was jetzt stattfindet. Vielleicht sollten die anderen Staaten froh sein, dass die USA auf diese Weise einen Großteil ihres Kapital quasi ‚vernichten‘, da sonst die amerikanische Wirtschaft im Bereich Computer, Software und Netzwerke noch übermächtiger wäre…)).

NETZWERKE: JENSEITS DER TECHNIK

15) Was viele erregt und aufregt, liegt daher weniger im Bereich der verwendeten Technologien, sondern in den sozialen, kulturellen, ethischen und dann auch politischen Dimensionen, die sich mit dem immer mehr publik werden neuen Computer-Netz-Technologien und ihrer Nutzung verknüpfen.

16) Für die meisten wirkten sich die neuen Technologien zunächst darin aus, dass sie im Bereich alltäglicher Kommunikation und alltäglichen Informationsaustausches ganz praktisch neue Möglichkeiten erhielten. Sehr schnell änderten sich flächendeckend alltägliche Verhaltensweisen. Dazu kam, dass nahezu alle Dienste zu Beginn ‚kostenlos‘ waren. Das Geschäftsmodell war einfach: deine Informationen als frei verwertbarer Inhalt für mich, dafür für dich deine Nutzung aller Dienste kostenfrei. Dass die Netzfirmen und die Geheimdienste damit ein Dateneldorado vorfanden, in dem sie sich mit Zustimmung der ‚Lieferanten‘ ungehemmt bewegen konnten, war vielen zunächst nicht so richtig bewusst und erschien vernachlässigbar angesichts der konkreten praktischen Nutzen auf privater Ebene. Mit der massenhaften Nutzung kam natürlich auch der wachsende Missbrauch und in den beginnenden Klagen, Streitigkeiten und Prozessen begann zaghaft ein wachsendes Bewusstsein von der Realität (und den Gefahren) der freien Nutzung zu wachsen. Dass sich die öffentliche Diskussion speziell an den Mitteilungen Snowdons dann mehr als bisher entzündete (Wer konnte bis heute überhaupt Snowdons Miteilungen überprüfen?), erscheint mir eher als ein Zufall. Das Thema war am Aufkochen und auch ohne Snowdon gab es erste alternative Geschäftsmodelle, die sich den wachsenden Unmut der großen Menge zunutze machen wollen, und bezahlte Dienste anbieten, dafür aber ohne Ausspähung und Datenmissbrauch. Der Fall Snowdon hat den ganzen Prozess jetzt womöglich nur beschleunigt. Der Wertzuwachs in der Nutzung von Netzen für viele private und zivile Zwecke ist zu groß, als dass man darauf in der Zukunft wieder verzichten möchte. Wie immer gibt es hier eine ’natürliche‘ evolutionäre Entwicklung, bei der negative Auswüchse recht schnell von der Gesellschaft weder abgestoßen werden. Die Geschäftsmodelle von Google, Facebook und Amazon (und auch andere ‚closed shops‘ wie z.B. Apple, Samsung oder Microsoft) sind schon heute eigentlich tot, was nicht heißt, dass sie es noch ein paar Jahre schaffen.

US-REGIERUNGSFORM – PROBLEMATISCHE ENTWICKLUNG?

17) Ein ernsteres Problem hat nach meinem aktuellen Verständnis allerdings das amerikanische politische System. Die USA hatten immer einen überaus mächtigen Komplex aus Geheimdiensten, Militär und Wirtschaft, deren Interessen nicht unbedingt ‚zum Wohle‘ der übrigen amerikanischen Bevölkerung waren. Dazu kommt das Ethos des ‚weißen Ritters‘, der zumindest im Umfeld des zweiten Weltkrieges die USA lange Zeit weithin als ein großes Vorbild für viele hat erstrahlen lassen. Doch seitdem häufen sich Ereignisse, die eher die schmutzigen Seiten dieses Systems nach außen kehren. In dem Zusammenhang erscheinen die Ereignisse um den 11.September 2001 als sehr verhängnisvoll. Der Kampf gegen den ‚Terrorismus‘ wurde zu einem neuen Leitthema, das so stark war, dass diesem fast alles andere untergeordnet wurde. Nach der Verabschiedung des USA-Patriot Act: Uniting (and) Strengthening America (by) Providing Appropriate Tools Required (to) Intercept (and) Obstruct Terrorism Act 2001 war die Gründung des US Staatsministerium für Sicherheit der Heimat 2002 war nach Ansicht vieler Experten die größte Veränderung in der Architektur der Exekutive seit dem Nationalen Sicherheitsvertrag von 1947. Der Schutz vor Bedrohung, speziell ‚Terrorismus‘ gewann ein Ausmaß, das fast alles andere zu ersticken drohte. Ergänzend dazu gab es seit 1978 die Verordnung zur Überwachung fremder geheimdienstlicher Aktivitäten (Foreign Intelligence Surveillance Act (FISA)), die mehrfach erweitert wurde und dabei die Grenzziehung zum Schutz der Privatsphäre selbst für Amerikaner immer schwächer werden lies (für Nichtamerikaner gibt es sowieso überhaupt keine Rechte; vor dem Gesetz ist ein Nicht-Amerikaner unterschiedslos ein rechtloses Subjekt, mit dem die Exekutive machen kann, was sie will). Das wachsende Unbehagen über die übermächtigen Zugriffsmöglichkeiten der Exekutive in die Privatsphäre des einzelnen, sollte durch Einrichtung des Staatlichen Gerichtshofes zur Überwachung der Überwachung (‚United States Foreign Intelligence Surveillance Court (FIS)) 1978 gewährleistet werden.

18) Wie der tatsächliche Verlauf seitdem mit seinen vielen Änderungen, Diskussionen und Gerichtsprozessen anzeigt, verläuft die Gesamtentwicklung eher in Richtung Ausweitung der Aktivitäten der Geheimdienste weit über die vorgesehenen Grenzwerte hinaus.

19) Es gibt zwar grundsätzlich den vierten Zusatz zur US-Verfassung, zum Schutz der Privatsphäre, auch ein Gesetz für den freien Zugang zu Informationen staatlicher Stellen (‚Freedom of Information Act (FOIA)‘), sowie zeitgleich mit dem Staatsministerium für die Sicherheit der Heimat ein Amt zur Sicherung des Schutzes der Privatsphäre (Privacy Office of the U.S. Department of Homeland Security), aber was nützt ein Verfassungsartikel, wenn die täglicher Praxis ihn beständig unterläuft und die Überwachungsgremien eher den Eindruck erwecken, dass sie alles durchwinken und sich einer öffentlichen politischen Diskussion entziehen. Wichtige kritische Gruppierungen sind hier vielleicht das Zentrum für Zivilrecht (Center for Civil Rights (CCR)) oder auch die der Vereinigung für die Grenzen der Elektronik (Electronic Frontier Foundation (EFF)) , aber der entscheidende Punkt ist, wieweit die staatlichen Stellen und die Regierung dem Bürger noch reale Freiräume einräumen, zuerst mal für die US-Bürger selbst, dann aber auch für Nicht-US-Bürger. Irgendwo gibt es die Idee der ‚Menschenrechte‘ und es wäre nicht schlecht, wenn ein Land wie USA die Menschenrecht innerhalb ihres Rechtssystems einen solchen Platz einräumen würden, der der reinen Willkür von US-Behörden gegenüber Nicht-Amerikaner einen klaren rechtlichen Rahmen geben würden. Ansonsten müßten alle Nichtamerikaner die USA aufgrund ihrer rechtlich fixierten Menschenverachtung als direkten Feind betrachten. Dies kann nicht das Ziel sein.

WHISTLEBLOWER

20) Neben dem vierten Verfassungsartikel, dem Amt zum Schutz der Privatsphäre sowie dem Spezialgericht zur Kontrolle der Geheimdiensttätigkeiten (FISA) gibt es in den USA seit 1983 auch ein eigenes Gesetz, das Beschluss zur Ermöglichung von Hinweisen zum Missbrauch (False Claims Act), das eigentlich solche Menschen schützen soll, die Missbrauch entdecken und aufdecken, es geht um die ‚Whistleblower‘, etwa ‚Zuflüsterer‘. Bekanntgewordene Fälle zeigen aber, dass dieses Gesetz von staatlichen Stellen und der Regierung auf vielfache Weise abgeschwächt und unterdrückt werden kann. Die besten Gesetze nützen nichts, wenn die staatlichen Stellen sie nicht hinreichend anwenden (Eines von mehreren beeindruckenden Negativbeispielen für ein Versagen der staatlichen Stellen ist der Bericht (und das Buch) von Peter van Buren , hier eine Liste von einschlägigen Artikeln Artikel zu Whistleblower und Staatsverhalten). Im Falle von Snowdon sieht Snowdon sich als Whistleblower, da er aus seiner Sicht in den überbordenden Aktivitäten der NSA einen ‚Missbrauch‘ sieht, den man anzeigen muss. Die NSA selbst und die Regierung sieht aber in ihrem Verhalten ein ‚gesetzeskonformes‘ Vorgehen, das den Interessen der USA dient. Aus Sicht der staatlichen Stellen ist Snowdon von daher ein ‚Verräter‘; aus Sicht derjenigen Menschen, die im Verhalten der NSA und der US-Regierung eine Grenzüberschreitung sehen, die elementare Rechtsauffassungen verletzt, ist Snowdon ein ‚Whistleblower‘. Der Ausgang ist offen.

DIE USA HABEN EINE GLOBALE BEDEUTUNG

21) Man könnte versucht sein, diese Problemlage in den USA als ‚Sache der Amerikaner‘ abzutun. Das ist meines Erachtens zu einfach. Die USA sind nicht irgendein Land. Die USA sind eines der wichtigsten Länder dieser Erde und sie werden dies auch noch einige Zeit bleiben. Dort vollzieht sich momentan ein Prozess der Umwälzung der Gesellschaft durch die neuen Computer-Netz-basierten Technologien, bei gleichzeitiger Regredierung des politischen Systems in Richtung ‚Überwachungsstaat‘. Die Beteiligten selbst sehen dies noch nicht so, da sie alles mit der Brille der ‚Bedrohung‘ und des ‚Terrorismus‘ sehen (ich unterstelle mal, dass die entscheidenden Leute tatsächlich ‚Patrioten‘ sind und keine finstren Machtmenschen, die den Staat für sich unter Kontrolle bringen wollen (in den Filmen ist es so)). Und es gibt genügend kompetente Kritikern in den USA selbst, die vielfach aufzeigen, wie ineffizient, zu teuer, und letztlich weitgehend wirkungslos diese ganzen Maßnahmen sind (für jemanden, der einen terroristischen Akt gegen die USA ausüben wollte, sind alle die Maßnahmen geradezu lächerlich; meist werden ahnungslose Bürger aufgegriffen, die aus Versehen die falschen Worte benutzt haben). Doch kann keiner voraussagen, wie dieser Transformationsprozeß ausgehen wird. Wir sollten alle daran interessiert sein, dass er nicht in einem hochtechnologischen Überwachungsstaat endet.

ABSPANN

22) Es gibt einerseits die Visionen für das große Ganze, die weder leicht noch selbstverständlich sind, und dann gibt es die unendlich vielen kleinen Schritte im Alltag, durch die sich das große Ganze realisiert oder nicht.

23) Wenn der Erfolg nur davon abhängen würde, dass wir als einzelne alles perfekt und richtig machen, würde wir beständig grandios scheitern. Der Prozeß folgt aber vielen Logiken gleichzeitig. Die meisten verstehen wir nicht.

24) Vielleicht werden Historiker später einmal sagen, dass es gut war, dass die amerikanische Regierung diese Überwachungsmonströsitäten versucht hat, um alle aufzuwecken und zur ‚Vernunft‘ zu bringen, dass es so nicht geht. Vielleicht…

25) Ob der deutsche Innenminister dabei irgendeine Rolle spielen wird? Die Bundeskanzlerin? Welch Rolle die Presse in Deutschland überhaupt spielt? Vielleicht sollten Deutsche und Amerikaner in der Öffentlichkeit mehr miteinander reden. Anders wird sich kaum etwas ändern.

Eine Übersicht über alle bisherigen Blogeinträge nach Titeln findet sich HIER.