Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 27.August 2017

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

Letzte Altualisierung: 27.Aug.2017 - 17:37h

Es gibt eine Weiterentwicklung dieses Beitrags in einem Folgebeitrag!

PDF

Überblick

Eingeleitet durch wissenschaftsphilosophische

Überlegungen wird versucht, die Entwicklung der

Säugetiere bis hin zum homo sapiens anhand der aktuellen

Forschungsdaten abzubilden. Das Hauptaugenmerk liegt

auf der allgemeinen Struktur. Für die vielen Details sei auf

die Literatur verwiesen, die angegeben wird.

I. KONTEXT

Eine der Leitfragen dieses Blogs ist die Frage nach

dem neuen Menschenbild, speziell auch im Kontext

der Diskussion um die Zukunft von Menschen und

intelligenten Maschine.

Wer nach der Zukunft des Menschen fragt,

braucht ein gutes Bild vom aktuellen Menschen und

seiner Entstehungsgeschichte, um auf dieser Basis

Überlegungen zu einer möglichen Zukunft anstellen zu

können.

Während zur biologischen Evolution allgemein schon

einige Blogbeiträge geschrieben wurden, fehlt es im Blog

an konkreten Daten zur Entwicklung unmittelbar vor dem

Auftreten des homo sapiens, etwa in dem Zeitfenster -10

Mio Jahren bis ca. -30.000 Jahren vor dem Jahr 0. Dies

soll hier in einem ersten Beitrag nachgeholt werden.

II. WISSENSCHAFTLICHE SICHTWEISEN

Bei der Frage nach der Entwicklung des homo

sapiens spielen mehrere wissenschaftliche Disziplinen

ineinander. Einmal ist es die Geologie (Siehe: [WD17g]),

die den Kontext Erde untersucht; dann die Klimatologie

(Siehe: [WD17n]), die sich mit den klimatischen

Verhältnissen im Kontext Erde beschäftigt. Für das

Phänomen des Lebens selbst ist die Biologie zuständig,

speziell die Evolutionsbiologie (Siehe: [SWW13],

[WD17e]). Als Teil der Evolutionsbiologie sind noch

zu nennen die Molekularbiologie (Siehe: [WD17s]) mit

der Genetik (Siehe: [WD17f]). Ferner könnte man als

Teil der Evolutionsbiologie auch noch die Paläontologie

(Siehe: [WD17u], [Par15]) nennen und auch die

Archäologie (Siehe: [WD17a]). Wobei das Wechselspiel

von Evolutionsbiologie und Archäologie nicht ganz

so klar erscheint. Viele weitere wissenschaftliche

Disziplinen tauchen innerhalb der genannten Disziplinen

in unterschiedlichsten Kontexten auf.

Diese Vielfalt spiegelt ein wenig die Komplexität der

Phänomene wieder, um die es hier geht. Der Autor

cagent selbst betrachtet die hier zu verhandelnden

empirischen Phänomene aus Sicht der Philosophie

mit den Schwerpunkten Erkenntnisphilosophie, die

Überschneidungen hat mit Phänomenen wie z.B.

‚Lernen’ und ’Intelligenz’. Dies sind Themen, die

feste Orte auch in der Psychologie haben, heute

oft parallelisiert mit der Gehirnforschung (letztere

methodisch gesehen ein Teil der Biologie).

Angesichts dieser Komplexität ist es praktisch

unmöglich, ein völlig konsistentes, einheitliches Bild der

Phänomene zu zeichnen. An dieser Stelle ist es das

Anliegen von cagent, einen ’hinreichenden’ Überblick

über die ’unmittelbare’ Vorgeschichte des homo sapiens

zu bekommen.

Der homo sapiens ist jene biologische Art (Spezies),

die zur Gattung homo gerechnet wird, die sich aus

dem biologischen Formenstrom über Jahrmillionen

herausgeschält hat. Es zeigt sich, dass die zeitliche

Abgrenzung, wann genau ’das Menschliche’ anfängt,

und wann das ’Tierische’ aufhört, irgendwie beliebig

erscheint. Der homo sapiens ab ca. -30.000 besitzt

natürlich Eigenschaften, die wir beschreiben können

wie Körperbau, genetisch bestimmte Erbanlagen,

typische Verhaltensweisen, aber diese Eigenschaften

tauchen nicht abrupt in der Geschichte auf, sind nicht

irgendwann einfach so da, sondern man findet in

der vorausgehenden Zeit eine große Formenvielfalt

in den Artefakten, mit unterschiedlichen genetischen

Distanzen zum heutigen homo sapiens. Daraus muss

man schließen, dass es einen viele Millionen dauernden

Prozess des Formenwandels gab, innerlich genetisch

und äußerlich durch die jeweiligen geologischen und

klimatologischen Verhältnisse beeinflusst, die sich

zudem noch verknüpfen mit der jeweiligen Pflanzen- und

Tierwelt. Alle diese genannten Faktoren waren selbst

einem kontinuierlichen Wandel unterworfen.

Wenn die Grenzziehung zwischen dem ’Tierischen’

und dem ’Menschlichen’ von daher nicht ganz scharf

gezogen werden kann, ist auch eine Zeitangabe dazu,

wie weit zurück in der Zeit man gehen soll, um die

Vorgeschichte’ zu beschreiben, relativ, d.h. abhängig

von den Kriterien, die man bei der Analyse anlegen

will.

In diesem Beitrag wurde der Startpunkt für die

Beschreibung bei den Lebensformen gewählt, die die

Biologen ’Primaten’ nennen, und zwar spezieller den

Punkt der Aufspaltung in die Strepsirrhini und Haplorhini

(Siehe: [WE17l] und [WD17r]), die sich um etwa -80

Mio Jahren ereignet haben soll. Aus Sicht der heutigen

menschlichen Geschichte, wo 100 Jahre oder gar 1000

Jahre eine lange Zeit sind, wirken diese 80 Millionen

Jahre sehr, sehr lang. Innerhalb der Geschichte des

Lebens mit ca. 3.5 Milliarden Jahre fallen die 0.08 Mrd

Jahre seit dieser Aufspaltung nahezu kaum ins Gewicht,

es sind gerade mal 2.2% der gesamten Entwicklungszeit

des biologischen Lebens. Betrachtet man dagegen nur

die Zeit seit dem Auftreten der Lebensform homo, die

dem heute bekannten Menschlichem schon nahe kommt

(etwa ab -2.5 Mio), dann schrumpft der Zeitanteil auf

0.071 % der Entwicklungszeit des biologischen Lebens

zusammen. Umgerechnet auf das 12-Stunden Ziffernblatt

einer Uhr mit 720 Minuten würde die Entstehung der

Lebensform homo die letzte halbe Minute auf dem

Ziffernblatt ausmachen. Die Lebensform homo sapiens,

zu der wir uns zählen, tauchte frühestens um -190.000 in

Afrika auf. Das wären auf dem Ziffernblatt dann (bei ca.

81.000 Jahren pro Sekunde) die letzten 2.3 Sekunden.

Im Spiel des Lebens erscheint dies nicht viel. Betrachtet

man aber, was sich allein in den letzten ca. 10.000

Jahren ereignet hat, und hier speziell nochmals in den

letzten 100 Jahren, dann legt sich der Schluss nahe,

dass die Lebensform homo sapiens offensichtlich über

Fähigkeiten verfügt, die gegenüber der Vorgeschichte

von ca. 3.5 Mrd Jahren etwas qualitativ ganz Neues

sichtbar macht. Autor cagent ist sich nicht sicher,

ob der homo sapiens selbst bislang wirklich begreift,

was hier passiert, welche Rolle er in diesem Prozess

spielt. Auf der einen Seite zeichnet sich eine immer

größere Zerstörungskraft ab (die auch stattfindet), auf

der anderen Seite deuten sich konstruktive Potentiale

an, die alles übersteigen, was bislang vorstellbar war.

III. DEUTUNGEN: MATERIAL, MUSTER, FUNKTION, KONTEXTE

Die Tätigkeit der eingangs erwähnten Wissenschaft

kann man verstehen als eine Deutung, ausgeführt in

einem Deutungsprozess. Diese Deutung beginnt bei der

Bestimmung der Substanzen/ Materialien, die Forscher

vorfinden. Ist das eine Gesteinsart, sind das Knochen,

sind das pflanzliche Bestandteile …. ? Ein anderer

Aspekt ist die Frage nach ’Formen’ und ’Mustern’:

kann man an dem Material auffällige Formen oder

Muster erkennen, dann auch im Vergleich zu anderen

Materialien? Schließlich auch die Frage nach möglichen funktionalen Zusammenhängen’: wenn es ein Knochen

ist, in welchem Zusammenhang eines Knochengerüsts

kommt er vor? Wenn etwas ein Zahn sein soll, wie sah

das zugehörige Gebiss aus? Oder ist dieser Knochen Teil

eines Werkzeugs, einer zu unterstellenden Handlung,

die das Stück benutzt hat? Schließlich, in welchem

Kontext kommt ein Material vor? Ist es zufälliger Kontext,

ein Kontext durch einen geologischen Prozess, ein

Kontext erzeugt durch Verhalten von Lebewesen?

Schon bei diesen Fragen bieten sich eine Vielzahl von

Deutungsmöglichkeiten, bestehen viele Ungewissheiten.

IV. DEUTUNGEN 2: ZEITLICHE ABFOLGE

Was Forscher zur Evolutionsbiologie besonders

interessiert, ist das Erfassen von zeitlichen Abfolgen:

unter Voraussetzung eines bestimmten Zeitmaßes

möchte die Evolutionsbiologie wissen, ob ein

Gegenstand/ Artefakt A im Sinne des Zeitmaßes ‚vor’ oder ’nach’ einem anderen Gegenstand/ Artefakt B ‚anzuordnen’ ist.

Diese Frage macht nur Sinn, wenn man neben

einem definierten Zeitmaß auch annehmen darf

(muss), dass sich die Erde als Generalumgebung aller

vorfindbaren Materialien/ Artefakte grundsätzlich in

einem Veränderungsmodus befindet, dass also die

Erde zu zwei verschiedenen Zeitpunkten grundsätzlich

verschieden sein kann.

Dass sich am Kontext Erde Veränderungen feststellen

lassen, dies haben Menschen schon sehr früh erleben

können: Temperatur, Regen oder nicht Regen, Tag und

Nacht, Wachstum der Pflanzen, Geboren werden und

Sterben, usw. Es passierte aber erst im 17.Jahrhundert,

dass die Fragestellung nach dem Vorher und Nachher in

der Entwicklung der Gesteine mit Nils Stensen (nicolaus

steno) eine systematische Form fand, aus der sich nach

und nach die moderne Geologie entwickelte (Siehe:

[WD17h]).

Erst durch die wissenschaftliche Geologie wissen

wir zunehmend, dass die Erde selbst ein dynamisches

System ist, das sich beständig verändert, wo sich

ganze Kontinente bilden, verschieben, verformen; wo

Vulkanismus stattfindet, Erosion, Klimaänderungen, und

vieles mehr. Erst durch die geologische Sehweise konnte

man nicht nur verschiedene Zustände der Erde entlang

einem definierten Zeitmaß identifizieren, sondern damit

dann auch Veränderungen in der Zeit’ sichtbar machen.

Dieses geologische Wissen vorausgesetzt, besteht

plötzlich die Möglichkeit, ein Material/ Artefakt einer

erdgeschichtlichen Phase, einem Zeitpunkt in einem

Veränderungsprozess, zuzuordnen. Die Geologie hat – mittlerweile unterstützt durch viele Spezialgebiete, wie z.B. auch die Klimatologie (Siehe:

[WD17n]) – unter anderem eine zeitliche Abfolge von

Vulkanausbrüchen in den verschiedenen Regionen

der Erde identifizieren können und auch das sich

verändernde Klima.

So spricht man in der Klimatologie von sogenannten

Eiszeitaltern’ (Siehe: [WD17d]). In der schwachen

Version einer Definition von Eiszeitalter geht man davon

aus, dass mindestens eine Polkappe vereist ist. Die

letzte Eiszeit dieser Art fand statt um -33.5 Mio Jahren.

In der starken Version geht man davon aus, dass beide

Polkappen vereist sind. Die letzte Eiszeit dieser Art

begann um ca. -2.7 Mio Jahren und hält bis heute

an. In dieser Zeit gab es unterschiedliche Kalt- und

Warm-Phasen. Seit ca. -1 Mio Jahren haben sich 6

mal Kaltzeiten wiederholt: ca. -0.9 Mio, -0.77 Mio, -0.6

Mio, -0.48 Mio, -0.35 Mio, -12.000 (siehe: [WD17o],

[Rot00]:SS.173ff ).

Ein anderer starker Faktor, der das Klima

beeinflussen kann, sind Supervulkanausbrüche

(Siehe: [WD17w]). Hier eine Zusammenstellung

von Eiszeitaltern mit Kaltphasen in Kombination mit

den Supervulkanausbrüchen sofern sie das frühe

Ausbreitungsgebiet von homo und homo sapiens berührt

haben (wobei auch andere große Ausbrüche sich

weltweit auswirken konnten)(man beachte, dass die

Zeitangaben mit großen Unschärfen versehen sind):

- Eiszeit: ab ca. -2.7 Mio Jahren

- Vulkan:-1 Mio Äthiopien

- Vulkan: -788.000 Indonesien

- Kaltzeit: ca. -0.77 Mio Jahren

- Kaltzeit: ca. -0.6 Mio Jahren

- Vulkan: -500.000 (+/- 60.000) Äthiopien

- Kaltzeit: ca. -0.48 Mio Jahren

- Vulkan: -374.000 Italien

- Kaltzeit: ca. -0.35 Mio Jahren

- Vulkan:-161.000 Griechenland

- Vulkan: -74.000 Indonesien

- Vulkan:-50.000 Italien

- Vulkan:-39.000 Italien

- Kaltzeit: ca. -12.000

Bei der Entstehung von Eiszeiten spielen eine Vielzahl

von Faktoren eine Rolle, die ineinandergreifen. Sofern

es sich um periodische Faktoren handelt, kann sich dies

auf den Periodencharakter von Kalt- und Warmzeiten

auswirken (siehe: [WD17o], [Rot00]:SS.173ff ). Die globale Erwärmung, die

aktuell beklagt wird, ist ein Ereignis innerhalb eines noch

existierenden Eiszeitalters. Insofern ist die Erwärmung

eigentlich keine Anomalie, sondern eher die Rückkehr

zum ’Normalzustand’ ohne Eiszeitalter. Wobei sich

natürlich die Frage stellt, welcher Zustand der Erde ist

eigentlich ’normal’? Kosmologisch betrachtet – und darin

eingebettet die Wissenschaften von der Erde – wird

die Erde in einem Zustand enden, der nach heutigem

Wissen absolut lebensfeindlich sein wird (siehe: [WD17p],

[WE17b], [WE17c]). Für die Erde ist dieser Zustand

normal’, weil es dem physikalischen Gang der Dinge

entspricht, aus Sicht der biologischen Lebensformen

ist dies natürlich überhaupt nicht ’normal’, es ist ganz

und gar ’fatal’.

Insofern wird hier schon deutlich, dass

die innere Logik des Phänomens ‚biologisches Leben‘

nicht automatisch kongruent ist mit einem aktuellen

Lebensraum. Das Phänomen des biologischen Lebens

manifestiert einen Anspruch auf Geltung, für den

es im Licht der physikalischen Kosmologie keinen

natürlichen’ Ort gibt. Das biologische Leben erscheint

von daher als eine Art ’Widerspruch’ zum bekannten

physikalischen Universum, obgleich es das physikalische

Universum ist, das das biologische Leben mit ermöglicht.

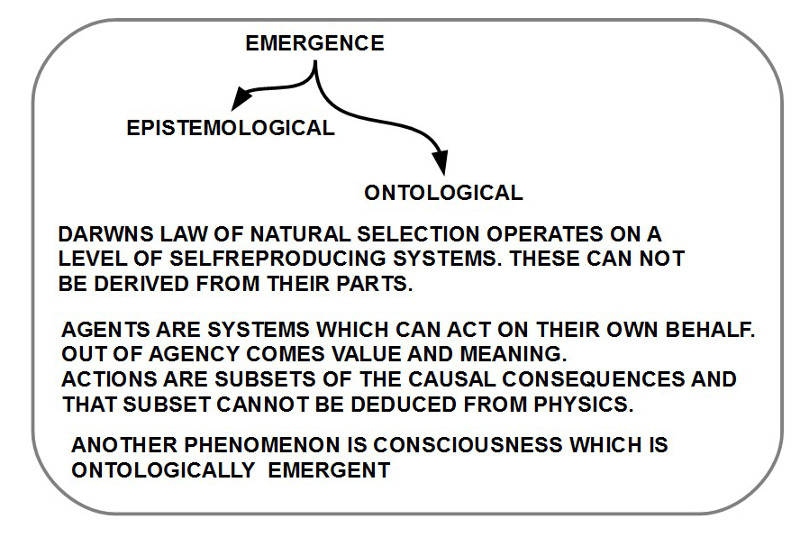

V. DEUTUNGEN 3: ENTWICKLUNG VON KOMPLEXITÄT

Wenn man so weit vorgestoßen ist, dass man

Materialien/ Artefakte auf einer Zeitachse anordnen kann,

dann kann man auch der Frage nachgehen, welche

möglichen Veränderungen sich entlang solch einer

Zeitachse beobachten lassen: Bleibt alles Gleich? Gibt

es Änderungen? Wie lassen sich diese Veränderungen

klassifizieren: werden die beobachtbaren Phänomene

einfacher’ oder ’komplexer’?

Um solche eine Klassifikation in ’einfach’ oder

komplex’ vorzunehmen, braucht man klare Kriterien für

diese Begriffe. Aktuell gibt es aber keine einheitliche, in

allen Disziplinen akzeptierte Definition von ’Komplexität’.

In der Informatik wird ein Phänomen relativ zu

einem vorausgesetzten Begriff eines ’Automaten’ als

komplex’ charakterisiert: je nachdem wie viel Zeit

solch ein Automat zur Berechnung eines Phänomens

benötigt oder wie viel Speicherplatz, wird ein Phänomen

als mehr oder weniger ’komplex’ eingestuft (Siehe

dazu: [GJ79]). Dieser vorausgesetzte Automat ist eine

sogenannte ’Turingmaschine’. Dieses Konzept entstand

in der Grundlagendiskussion der modernen Mathematik

um die Wende vom 19. zum 20.Jahrhundert, als sich

die Mathematiker (und Logiker) darüber stritten, unter

welchen Bedingungen ein mathematischer Beweis

für einen Menschen (!) als ’nachvollziehbar’ gelten

kann. Nach gut 30 Jahren heftigster Diskussionen fand

man mehrere mathematische Konzepte, die sich als

äquivalent erwiesen. Eines davon ist das Konzept der

Turingmaschine, und dieses gilt als das ’einfachste’

Konzept von allen, das sich seit 1936/7 bisher in

allen Widerlegungsversuchen als stabil erwiesen hat.

Dies ist zwar selbst kein unwiderleglicher logischer

Beweis, aber ein empirisches Faktum, was alle Experten

bislang glauben lässt, dass mit diesem Konzept eine

zentrale Eigenschaft des menschlichen Denkens

eine konzeptuelle Entsprechung gefunden hat, die

sich formal und empirische experimentell überprüfen

lässt. So, wie die Physiker zum Messen Standards

entwickelt haben wie das ’Kilogramm’, das ’Meter’

oder die ’Sekunde’, so haben die Informatiker zum

Messen der ’Komplexität’ eines Phänomens relativ zur

(menschlichen) Erkenntnisfähigkeit die ’Turingmaschine’

(samt all ihren äquivalenten Konzepten) gefunden. Der

Vorteil dieser Definition von Komplexität ist, dass man

über das zu klassifizierende Phänomen vorab nahezu

nichts wissen muss. Darüber hinaus macht es Sinn, das

menschliche Erkennen als Bezugspunkt zu wählen, da

die Frage der Komplexität jenseits des menschlichen

Erkennens keinen wirklichen Ort hat.

Zurück zum Ausgangspunkt, ob sich im ’Gang der

Dinge’ auf der Erde Phänomene erkennen lassen,

die ’im Lauf der Zeit’ an Komplexität zunehmen,

deutet sich Folgendes an: es scheint unbestritten,

dass die Beschreibung einer biologischen ’Zelle’

(siehe: [AJL+15]) einen erheblich größeren Aufwand

bedeutet als die Beschreibung eines einzelnen Moleküls.

Zellen bestehen aus Milliarden von Molekülen, die

in vielfältigsten funktionellen Zusammenhängen

miteinander wechselwirken. Der Übergang von einzelnen

Molekülen zu biologischen Zellen erscheint von daher

gewaltig, und es ist sicher kein Zufall, dass es bis heute

kein allgemein akzeptiertes Modell gibt, das diesen

Übergang vollständig und befriedigend beschreiben

kann.

Für den weiteren Verlauf der biologischen Evolution

gibt es zahllose Phänomene, bei denen eine Vielzahl

von Faktoren darauf hindeuten, dass es sich um eine

Zunahme von Komplexität’ im Vergleich zu einer

einzelnen Zelle handelt, wenngleich manche dieser

Komplexitäts-Zunahmen’ Milliarden oder hunderte von

Millionen Jahre gebraucht haben. Im Fall der Entwicklung

zum homo sapiens ab ca. -80 Millionen Jahre gibt es

auch solche Phänomene, die sich aber immer weniger

nur alleine im Substrat selbst, also im Körperbau

und im Gehirnbau, festmachen lassen, sondern wo

das ’Verhalten’ der Lebewesen ein Indikator ist für

immer komplexere Wechselwirkungen zwischen den

Lebewesen und ihrer Umwelt.

Der Körper des homo sapiens selbst umfasst ca.

37 Billionen (10^12) Körperzellen, dazu im Innern des

Körpers geschätzte ca. 100 Billionen Bakterien, und

zusätzlich auf der Körperoberfläche ca. 224 Milliarden

Bakterien (siehe dazu [Keg15]). Diese ca. 137 Billionen

Zellen entsprechen etwa 437 Galaxien im Format

der Milchstraße. Während Menschen beim Anblick

des Sternenhimmels zum Staunen neigen, bis hin

zu einer gewissen Ergriffenheit über die Größe (und

Schönheit) dieses Phänomens, nehmen wir einen

anderen menschlichen Körper kaum noch wahr (falls

er sich nicht irgendwie auffällig ’inszeniert’). Dabei

ist der menschliche Körper nicht nur 437 mal größer in seiner Komplexität

als die Milchstraße, sondern jede einzelne Zelle ist

ein autonomes Individuum, das mit den anderen auf

vielfältigste Weise interagiert und kommuniziert. So kann

eine einzelne Gehirnzelle bis zu 100.000 Verbindungen

zu anderen Zellen haben. Körperzellen können über

elektrische oder chemische Signale mit vielen Milliarden

anderer Zellen kommunizieren und sie beeinflussen.

Bakterien im Darm können über chemische Prozesse

Teile des Gehirns beeinflussen, das wiederum aufgrund dieser Signale Teile des

Körpers beeinflusst. Und vieles mehr. Obgleich

die Erfolge der modernen Wissenschaften in den letzten

20 Jahren geradezu atemberaubend waren, stehen wir

in der Erkenntnis der Komplexität des menschlichen

Körpers noch weitgehend am Anfang. Niemand hat

bislang eine umfassende, zusammenhängende Theorie.

Dazu kommen noch die vielen immer komplexer

werden Muster, die sich aus dem Verhalten von

Menschen (und der Natur) ergeben. Zusätzlich wird das Ganze

stark beeinflusst von modernen Technologi wie z.B. der

Digitalisierung.

VI. DEUTUNGEN4: SELBSTREFERENZ: CHANCE UND

RISIKO

Ist man also zur Erkenntnis einer Zunahme an

Komplexität vorgestoßen, gerät das Erkennen vermehrt

in einen gefährlichen Zustand. Das Erkennen von

Zunahmen an Komplexität setzt – nach heutigem

Wissensstand – symbolisch repräsentierte ’Modelle’

voraus, ’Theorien’, mittels deren das menschliche

(und auch das maschinelle) Denken Eigenschaften

und deren Anordnung samt möglichen Veränderungen

repräsentieren’. Sobald ein solches Modell vorliegt, kann

man damit die beobachteten Phänomene ’klassifizieren’

und in ’Abfolgen’ einordnen. Die ’Übereinstimmung’

von Modell und Phänomen erzeugt psychologisch ein

befriedigendes’ Gefühl. Und praktisch ergibt sich daraus

meist die Möglichkeit, zu ’planen’ und Zustände ’voraus

zu sagen’.

Je komplexer solche Modelle werden, um so größer

ist aber auch die Gefahr, dass man nicht mehr so leicht

erkennen kann, wann diese Modelle ’falsch’ sind. Solche

Modelle stellen Zusammenhänge (im Kopf oder in der

Maschine) her, die dann vom Kopf in die Wirklichkeit

außerhalb des Körpers ’hinein gesehen’ werden, und

mögliche Alternativen oder kleine Abweichungen können

nicht mehr so ohne weiteres wahrgenommen werden.

Dann hat sich in den Köpfen der Menschen ein bestimmtes

Bild der Wirklichkeit ’festgesetzt’, das auf Dauer

fatale Folgen haben kann. In der Geschichte der empirischen

Wissenschaften kann man diese Prozesse mit

zahlreichen Beispielen nachvollziehen (siehe den Klassiker:

[Kuh62]). Dies bedeutet, je umfassender Modelle

des Erkennens werden, um so schwieriger wird es auf

Dauer – zumindest für das aktuelle menschliche Gehirn

das ’Zutreffen’ oder ’Nicht-Zutreffen’ dieser Modelle

zu kontrollieren.

Nachdem mit dem Gödelschen ’Unentscheidbarkeitstheorem’

schon Grenzen des mathematischen Beweisens sichtbar wurden (Siehe: [WD17q]),

was dann mit der Heisenbergschen ’Unschärferelation’

(Siehe: [WD17j]) auf das empirischen Messen erweitert

wurde, kann es sein, dass das aktuelle menschliche

Gehirn eine natürliche Schranke für die Komplexität

möglicher Erklärungsmodelle bereit hält, die unserem

aktuellen Erkennen Grenzen setzt (Grenzen des Erkennens

werden im Alltag in der Regel schon weit vorher

durch psychologische und andere Besonderheiten des

Menschen geschaffen).

VII. PERIODISIERUNGEN: BIS HOMO SAPIENS

Wie schon angedeutet, ist das Vornehmen einer

Periodisierung ein Stück willkürlich. Autor cagent hat

den Zeitpunkt der Aufspaltung der Primaten um etwa

-80 Mio Jahren vor dem Jahr 0 gewählt. Dabei gilt

generell, dass solche Zeitangaben nur Näherungen sind,

da die zugehörigen Wandlungsprozesse sich immer als

Prozess über viele Millionen Jahre erstrecken (später

dann allerdings immer schneller).

Bei der Datierung von Artefakten (primär

Knochenfunden, dazu dann alle weiteren Faktoren,

die helfen können, den zeitlichen Kontext zu fixieren),

gibt es einmal den Ansatzpunkt über die äußere und

materielle Beschaffenheit der Artefakte, dann aber

auch – im Falle biologischer Lebensformen – den

Ansatzpunkt über die genetischen Strukturen und

deren Umformungslogik. Über die Genetik kann man

Ähnlichkeiten (Distanzen in einem Merkmalsraum)

zwischen Erbanlagen feststellen sowie eine ungefähre

Zeit berechnen, wie lange es gebraucht hat, um von

einer Erbanlage über genetische Umformungen zu

einer anderen Erbanlage zu kommen. Diese genetisch

basierten Modellrechnungen zu angenommenen Zeiten

sind noch nicht sehr genau, können aber helfen,

die Materie- und Formen-basierten Zeitangaben zu

ergänzen.

- Ordnung: Primates (Siehe: [SWW13]:Kap.5.2)

(Aufteilung ab ca. -80 Mio) –->Strepsirrhini (Lorisi-,

Chiromyi-, Lemuriformes) und Haplorhini (Tarsier,

Neu- und Altweltaffen (einschließlich Menschen))

(Siehe: [SWW13]:S.428,S.432, S.435 [WE17l],

[WD17r])

- Unterordnung: Haplorrhini (Aufteilung ab ca. -60

Mio) (Siehe: [WE17l]) –->Tarsiiformes und Simiiformes

Nebenordnung: Simiiformes (Aufteilung ab ca. –

42.6 Mio) -–>Platyrrhini (Neuwelt- oder Breitnasenaffen)

und Catarrhini (Altwelt- oder Schmalnasenaffen)

(Siehe: Siehe: [SWW13]:S.428, [WE17l])

- Teilordnung: Catarrhini (Altwelt- oder Schmalnasenaffen)

(Aufteilung ab ca. -29/-25 Mio) -–>Cercopithecoidea

(Geschwänzte Altweltaffen) und Hominoidea

(Menschenartige) (Siehe: Siehe: [WE17l] und

[WD17r])

- Überfamilie: Hominoidea (Menschenartige)

(Aufteilung ab ca. -20 Mio/ -15 Mio) –>Hylobatidae

(Gibbons)und Hominidae (Große Menschenaffen

und Menschen) (Siehe: [WD17r])

- Aufspaltung der Menschenaffen (Hominidae) in die

asiatische und afrikanische Linie (ca. -11 Mio)

(Siehe: [WD17r])

- Familie: Hominidae (Menschenaffen)(Aufteilung ab

ca. -15Mio/-13 Mio in Afrika) –>Ponginae (Orang-

Utans) und Homininae (Siehe: [WD17r])

- Unterfamilie: Homininae

Aufteilung der Homininae (ab ca. -9 Mio/ -8 Mio) –>

Tribus: Gorillini und Hominini (Siehe: [WE17d])

- Gattung: Graecopithecus (Süden von Griechenland)

- Spezies/ Art: Graecopithecus freybergi (Siehe: [WD17i]) (ca. -7.2 Mio)

- Gattung: Sahelanthropus (ab ca. -7.0/ -6.0 Mio)

- Spezies/ Art: Sahelanthropus tchadensis

(Siehe: [WD17v] [WE17k]) (im Tschad)

- Tribus (Stamm/ Tribe): Hominini

- Aufteilung der Hominini (ab ca. -6.6/-4.2 Mio)

(Siehe: [SWW13]:S.435, [WE17d]) -–>Pan

(Schimpansen) und Homo (Die Lebensform

Panina bildet einen Unterstamm zum

Stamm ’homini’. Für die Trennung zwischen

Schimpansen (Pan) und Menschen (Homo) wird

ein komplexer Trennungsprozess angenommen,

der viele Millionen Jahre gedauert hat. Aktuelle

Schätzungen variieren zwischen ca. -12 Mio und

-6-8 Mio Jahren (Siehe: [WE17a])

VIII. WAS FOLGT AUS ALLEDEM?

Jeder, der diesen Text bis hierher gelesen haben

sollte, wird sich unwillkürlich fragen: Ja und, was heißt

das jetzt? Was folgt aus Alledem?

In der Tat ist dieser Text noch nicht abgeschlossen.

Der Text stellt allerdings eine notwendige

Vorüberlegung dar zu der – hoffentlich – weiter führenden

Frage nach der Besonderheit des homo sapiens als

Erfinder und Nutzer von intelligenten Maschinen.

Während die abschließende Definition von potentiell

intelligenten Maschinen mit dem mathematischen

Konzept der Turingmaschine im Prinzip vollständig

vorliegt, erscheint die Frage, wer oder was denn der

homo sapiens ist, je länger umso weniger klar. Mit

jedem Jahr empirischer Forschung (in allen Bereichen)

enthüllt sich scheibchenweise eine immer unfassbarere

Komplexität vor unseren Augen, die ein Verständnis

des homo sapiens samt seinem gesamten biologischen

Kontext eher in immer weitere Ferne zu rücken scheint.

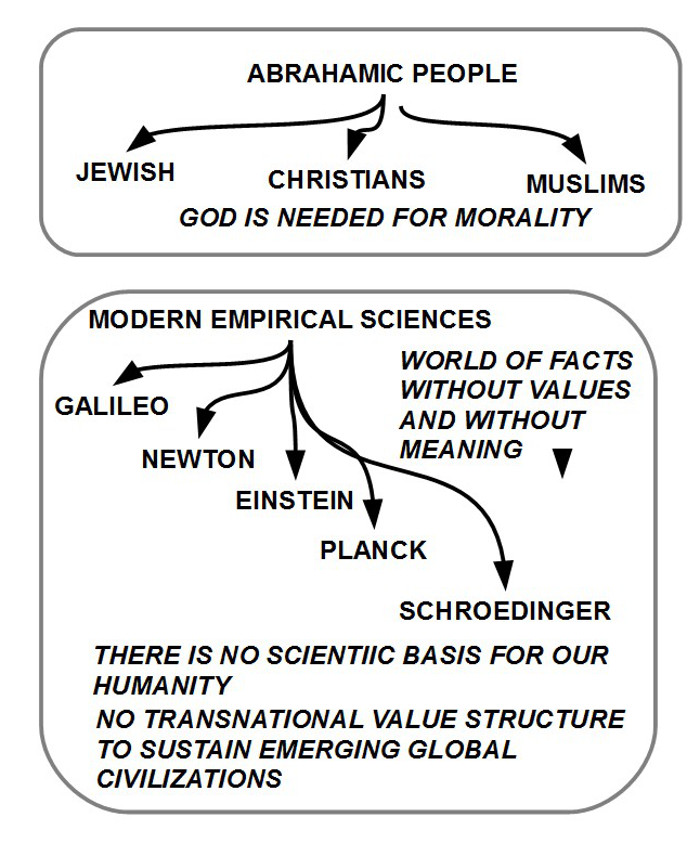

Konnten die großen Offenbarungsreligionen über

viele Jahrhunderte irgendwie glauben, dass sie

eigentlich wissen, wer der Mensch ist (obwohl sie

nahezu nichts wussten), ist uns dies heute – wenn wir

die Wissenschaften ernst nehmen – immer weniger

möglich. Wenn im jüdisch-christlichen Glauben der

Mensch bildhaft als ’Ebenbild Gottes’ bezeichnet werden

konnte und damit – zumindest indirekt – angesichts

dieser unfassbaren Erhabenheit eine Art Schauer über

den Rücken jagen konnte (ohne dass zu dieser Zeit

verstehbar war, worin denn die Besonderheit genau

besteht), so werden wir in den letzten Jahren durch

immer tiefere Einblicke in die Abgründe der Komplexität

von Leben und Lebensprozessen in einem scheinbar

lebensfremden physikalischen Universum provoziert,

herausgefordert, und Gelegenheit zum Staunen gäbe es

allerdings genug.

In diesem anwachsenden Wissen um

unser Nichtwissen begegnen wir einer schwer fassbaren

Größe, die wir salopp ’biologisches Leben’ nennen, die

aber alles übersteigt, dessen wir denkerisch fähig sind.

Eine der vielen Paradoxien des Universums ist

genau dieses Faktum: in einem scheinbar ’leblosen’

physikalischen Universum ’zeigen sich’ materielle

Strukturen, die Eigenschaften besitzen, die es strikt

physikalisch eigentlich nicht geben dürfte, und die sich

in einer Weise verhalten, die das ganze Universum

prinzipiell zu einem ’Un-Ort’ machen: das bekannte

physikalische Universum ist lebensfeindlich, das

biologische Leben will aber genau das Gegenteil:

es will leben. Wie kann das zusammen gehen? Warum

kann ein scheinbar lebloses physikalisches Universum

Überhaupt der Ort sein, wo Leben entsteht, Leben

stattfinden will, Leben sich schrittweise dem inneren

Code des ganzen Universums bemächtigt?

In weiteren Beiträgen wird es darum gehen, dieses

Phänomen ’biologisches Leben’ weiter zu erhellen,

und zu zeigen, wie das biologische Leben sich mit

Hilfe intelligenter Maschinen nicht nur generell weiter

entwickeln wird, sondern diesen Prozess noch erheblich

beschleunigen kann. Es gilt hier die Arbeitshypothese,

dass die intelligenten Maschinen ein konsequentes

Produkt der biologischen Evolution sind und dass es

gerade dieser Kontext ist, der dieser Technologie ihre

eigentliche Zukunftsfähigkeit verleiht.

Die heutigen Tendenzen, die Technologie vom biologischen Leben

zu isolieren, sie in dieser Isolation zugleich in geradezu

religiöser Manier zu Überhöhen, wird die evolutionär

induzierte Entwicklung dieser Technologie eher

behindern, und damit auch das vitale Element der

biologischen Evolution, den homo sapiens.

Der homo sapiens ist kein Individuum, er wird

repräsentiert durch eine Population, die wiederum nur

Teil einer umfassenderen Population von Lebensformen

ist, die sich gegenseitig am und im Leben halten. Es wird

wichtig sein, dass der homo sapiens diese Arbeitsteilung

versteht, bevor er mit seiner wachsenden Aufbau- und

Zerstörungskraft das biologische Universum zu stark

beschädigt hat.

Zum aktuellen Zeitpunkt kann niemand mit Gewissheit

sagen, ob das alles irgendeinen ’Sinn’ besitzt, d.h. ob es

in all den Abläufen in der Zukunft eine Menge möglicher

Zielzustände gibt, die in irgendeinem Sinne als ’gut’/

’schön’/ ’erfüllend’ oder dergleichen bezeichnet werden

können. Genauso wenig kann aber irgend jemand zum

aktuellen Zeitpunkt mit Gewissheit einen solchen Sinn

ausschließen. Rein empirisch kann man schon heute

eine solche Menge an atemberaubenden Strukturen und

Zusammenhänge erfassen, die ’aus sich heraus’ ein

Exemplar der Gattung homo sapiens in ’Erstaunen’ und

’Begeisterung’ versetzen können; aber weder gibt es für

solch ein Erstaunen einen Zwang, eine Regel, ein Muss,

noch ist all dies ’zwingend’. Noch immer können wir

nicht ausschließen, dass dies alles nur ein Spiel ist,

eine gigantische kosmologische Gaukelei, oder – wie

es die physikalischen kosmologischen Theorien nahelegen

– in einem gigantischen Kollaps endet, aus der

möglicherweise wieder ein Universum entsteht, aber ein

anderes.

REFERENCES

- [AJL+15] B. Alberts, A. Johnson, J. Lewis, D. Morgan, M. Raff,

K. Roberts, and P. Walter.Molecular Biology of the Cell.

Garland Science, Taylor & Francis Group, LLC, Abington

(UK) – New York, 6 edition, 2015.

- [GJ79] Michael R. Garey and David S. Johnson.Computers and

Intractibility. A Guide to the Theory of NP.Completeness.

W.H. Freeman an Company, San Francisco (US), 1 edition,

1979.

- [Keg15] Bernhard Kegel.Die Herrscher der Welt. DuMont, Köln (DE),

1 edition, 2015.

- [Kuh62] Thonas S. Kuhn.The Structure of Scientific Revolutions.

University of Chicago Press, Chicago (US), 1 edition, 1962.

- [Par15] Hermann Parzinger.DIE KINDER DES PROMETHEUS.

Geschichte der Menschheit vor der Erfindung der Schrift.

Wissenschaftliche Buchgesellschaft, Darmstadt (DE), 2 edition,

2015.

- [Rot00] Peter Rothe.Erdgeschichte. Spurensuche im Gestein. Wissenschaftliche

Buchgesellschaft, Darmstaadt (DE), 1 edition, 2000.

- [SWW13] Volker Storch, Ulrich Welsch, and Michael Wink, editors.

Evolutionsbiologie. Springer-Verlag, Berlin – Heidelberg, 3 edition, 2013.

- [WD17a] Wikipedia-DE. Archäologie. 2017.

- [WD17b] Wikipedia-DE. Ardipithecus. 2017.

- [WD17c] Wikipedia-DE. Denisova-mensch. 2017.

- [WD17d] Wikipedia-DE. Eiszeitalter. 2017.

- [WD17e] Wikipedia-DE. Evolutionsbiologie. 2017.

- [WD17f] Wikipedia-DE. Genetik. 2017.

- [WD17g] Wikipedia-DE. Geologie. 2017.

- [WD17h] Wikipedia-DE. Geschichte der geologie. 2017.

- [WD17i] Wikipedia-DE. Graecopithecus freybergi. 2017.

- [WD17j] Wikipedia-DE. Heisenbergsche unschärferelation. 2017.

- [WD17k] Wikipedia-DE. Homo cepranensis. 2017.

- [WD17l] Wikipedia-DE. Homo heidelbergensis. 2017.

- [WD17m] Wikipedia-DE. Kenyanthropus platyops. 2017.

- [WD17n] Wikipedia-DE. Klimatologie. 2017.

- [WD17o] Wikipedia-DE. Känozoisches eiszeitalter. 2017.

- [WD17p] Wikipedia-DE. Kosmologie. 2017.

- [WD17q] Wikipedia-DE. Kurt gödel. 2017.

- [WD17r] Wikipedia-DE. Menschenaffen. 2017.

- [WD17s] Wikipedia-DE. Molekularbiologie. 2017.

- [WD17t] Wikipedia-DE. Orrorin tugenensis. 2017.

- [WD17u] Wikipedia-DE. Paläontologie. 2017.

- [WD17v] Wikipedia-DE. Sahelanthropus tchadensis. 2017.

- [WD17w] Wikipedia-DE. Supervulkan. 2017.

- [WE17a] Wikipedia-EN. chimpanzee–human last common ancestor

(chlca). 2017.

- [WE17b] Wikipedia-EN. Cosmology. 2017.

- [WE17c] Wikipedia-EN. Earth science. 2017.

- [WE17d] Wikipedia-EN. Homininae. 2017.

- [WE17e] Wikipedia-EN. Homo antecessor. 2017.

- [WE17f] Wikipedia-EN. Homo erectus. 2017.

- [WE17g] Wikipedia-EN. Homo floresiensis. 2017.

- [WE17h] Wikipedia-EN. Homo gautengensis. 2017.

- [WE17i] Wikipedia-EN. Homo rhodesiensis. 2017.

- [WE17j] Wikipedia-EN. Paranthropus. 2017.

- [WE17k] Wikipedia-EN. Sahelanthropus tchadensis. 2017.

- [WE17l] Wikipedia-EN. Simian. 2017.

Eine FORTSETZUNG findet sich HIER.

VIII. KONTEXTE

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER.