Nick Lane, „Life Ascending“, London: Profile Books Ltd, 2009 (Paperback 2010)

KONTEXT

- Im vorausgehenden Teil 1 wurde nach einer kurzen Einleitung die Entstehung des Lebens im Lichte neuerer Erkenntnisse skizziert. Wer dadurch neugierig geworden ist, sei ermuntert, den Text von Lane und die angegebenen zusätzlichen Artikel und Bücher selbst zu lesen. In dieser Besprechung können nur die großen Linien angesprochen werden und mögliche Zusammenhänge mit dem Thema dieses Blogs. Interessant vielleicht auch die Nachbemerkungen zur Besprechung in Teil 1.

- Nachdem in Teil 1 neuere Forschungsergebnisse andeuten, wie sich das biologische Leben (= das Leben) im Rahmen der allgemeinen physikalischen (und chemischen) Gesetze in Form von grundlegenden hoch stabilen metabolischen Prozessketten formieren konnte, stellt sich die Folgefrage, wie der Weg von diesen komplexen, und doch – verglichen mit den späteren biologischen Strukturen – noch so einfachen Strukturen zu den eigentlichen Selbstreproduktionsmechanismen kommen konnte.

DNA – Der Code des Lebens (SS.34-59)

- Lane beginnt mit dem Sachverhalt, dass die Reproduktion einer Zelle letztlich gesteuert wird vom sogenannten Genom, das aus einer endlichen Menge von DNA-Molekülen besteht, wobei jedes DNA-Molekül jeweils in einem Doppelstrang ausgeführt ist. In diesem Doppelstrang bildet jedes Element ein Paar aus zwei Basen.

- [Anmerkung: ein DNA-Molekül bildet zusammen mit weiteren Elementen ein Chromatin. Ein Chromosom enthält – je nach Zellphase – entweder genau ein Chromatin oder ein Chromatin und seine Kopie (bei der Zellteilung werden diese beiden auf auf zwei neue Zellen als Schwester-Chromatine aufgeteilt). Die Gesamtheit der Chromosome bildet das Genom.]

- [Anmerkung: ein Grundelement (Nukleotid) der DNA besteht aus einem Strukturelement (einem Zucker-Phosphat Molekül), an das sich eine Base anlagern kann. Zwei solche Nukleotide können sich dann über die Basen komplementär zu einem Paar verbinden. (vgl. CELL S.3)]

- Es gibt vier Basen Adenin (A), Thymin (T), Guanin (G) und Cytosin (C). Dazu gibt es die starke chemische Tendenz, dass A sich nur an T bindet und C nur an G. Dadurch sind die beiden Stränge komplementär. (vgl. S.34f) Die Anordnung nutzt also eine vorgegebene chemische Bindungstendenz aus.

- Die Gesamtzahl der Nukleoide in einem menschlichen Genom wird auf ca. 3 Mrd (10^9) geschätzt. Bei ca. 15 Billionen (10^12) Körperzellen [Anmerkung: neuere Schätzungen gehen auf ca. 34 Billionen) bedeutet dies, dass das Genom 15 Billionen Mal (und öfters, da ja Körperzellen absterben und wieder ersetzt werden müssen) kopiert werden muss. Bei einer geschätzten Fehlerrate von 1 Nukleotid in 1 Mrd bedeutet dies, dass bei einer Kopie ca. 3 Fehler auftreten. Der Unterschied zwischen Menschen wird auf ca. 1 Unterschied pro 1000 Nukleotide geschätzt, also ca. 3 Mio; Lane spricht von 6-10 Mio. (vgl. SS.36-38)

- Beispiel: Die Trennung vom Schimpansen soll ca. vor 6 Mio Jahren geschehen sein. Die empirisch ermittelte Abweichungen werden mit 1,4% angegeben, also jede Art hat ca. 0.7% ihres Genoms in dieser Zeit verändert [Anmerkung: Bei einer angenommenen Generationendauer von 30 Jahren ergäben sich ca. 1050 Änderungen an Nukleotiden pro Generation auf jeder Seite].(vgl. S.38)

- Das Wissen um die Kombinatorik der Basen auf einem DNA-Molekül nützt allerdings letztlich nur dann etwas, wenn man auch weiß, welche potentiellen Strukturen und ihre lebensweltbezogenen Funktionen damit kodiert werden.(vgl. S.39) In der Zeit vor der Entdeckung von Watson und Crick 1953 waren die Details der biochemischen Maschinerie unbekannt.(vgl. S.40f)

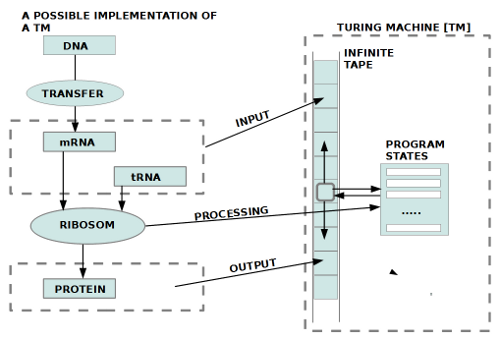

- Nur langsam entdeckte man, dass die Proteine außerhalb des Zellkerns über die Zwischenstationen Messenger RNA (mRNA) (erste Kopie von DNA-Abschnitten) und Transfer RNA (tRNA) (Rückübersetzung) und Ribosom (Zusammenbau von Aminosäuren anhand der tRNA-Informationen) erzeugt werden. Und nur langsam entdeckte man, dass jeweils vier Nukleotide aus der DNA ein Codon bilden, das für genau eine Aminosäure steht, deren Aneinanderreihung ein Protein (bei kürzeren Formen spricht man von einem Peptid) ergibt. Während 4^4 = 64 Kombinationen mit einem Codon möglich wären, schätzten Crick und Watson damals die Zahl der relevanten Aminosäuren für biogene Proteine auf 20. [Anmerkung: im menschlichen Körper kommen 21 verschiedene Aminosäuren vor. Insgesamt sind heute 23 Aminosäuren bekannt, die bei Proteinen Verwendung finden (wobei heute mehr als 400 Aminosäuren bekannt sind, die biologisch wichtig sind aber nicht in Proteinen vorkommt).] Es stellte sich heraus, dass der Kode redundant ist: es können mehrere verschiedene Codons die gleiche Aminosäure kodieren. Drei von 64 Codons dienen als STOP-Signal. Da dieser Kode universell für alle Lebensformen gilt wird daraus geschlossen, dass alle diese Lebensformen einen gemeinsamen Vorläufer gehabt haben müssen, von dem diese Kodierung übernommen wurde. (vgl. SS.39-45) Crick entwickelte daraus die These (1981), dass das Leben von außerhalb der Erde kam (Raumschiff, Aliens,…), und sich dann hier ausgebreitet hat.

- Die Hypothese von Crick wurde durch den Gang der Forschung überholt. Generell erschien die Hypothese von Crick auch nicht sehr plausibel, da das Auftreten von komplexen Molekülen ohne entsprechende Umgebungen wenig Chancen bietet, dass diese Moleküle überleben.(vgl. S.45f)

- Realistischer erschienen solche Hypothesen, die aufzeigen können, wie die Elemente von Aminosäuren aus Vorläufermaterial aus vorgegebenen Umgebungen rekrutiert werden konnten.(vgl. S.46)

- Und in der Tat, man entdeckte nach und nach, dass es einen Kode in den Codons gibt! Die Codons mit ihren vier Elementen haben Positionen 1-4. Ein einzelnes Codon steht nicht nur irgendwie für eine bestimmte Aminosäure, sondern die Abfolge der Elemente im Codon steuern sehr stark auch den Prozess der Aminosäurebildung! So fand man heraus, dass es folgenden Zusammenhang gibt: ein C an erster Stelle legt fest, dass als erster Baustein bei der Aminosäureherstellung ein alpha-ketoglutarate benutzt werden soll; ein A an erster Stelle legt fest, dass als erster Baustein bei der Aminosäureherstellung ein oxalocetate benutzt werden soll; ein T steht für pyruvate; ein G steht für eine beliebige Anzahl von einfachen Vorläufern.(vgl.S46f und Fußnote 5)

- Die zweite Position im Codon reguliert, wo im Spektrum zwischen hydrophob und hydrophil sich die Aminosäure ansiedeln soll: die fünf häufigsten hydrophoben Elemente korrespondieren mit T an Position 2; die meisten hydrophilen Elemente mit dem Element A; G und C stehen für Elemente in der Mitte des Spektrums.(vgl. S.47)

- Position 3 und 4 lassen keine feste Kodierung erkennen. Dies deutet darauf hin, dass die frühen Vorformen des DNA-Kodes möglicherweise nur 2 Elemente hatten, die stark deterministisch waren. Experimente mit Punktmutationen zeigen, dass der genetische Kode verglichen mit zufälligen Anordnungen extrem stabil ist. Er stellt eine interessante Kombination dar aus einem sehr konservativem Anteil (Position 1-2), und einem experimentellen Anteil (Positionen 3-4).(vgl. SS.47-49)

- Bleibt als Frage, wie kam der Prozess zustande, in dem DNA eine Proteinproduktion steuert, wo aber DNA spezifische Proteine für ihr Funktionieren voraussetzt und die spezifischen Proteine eben DNA?(vgl.S.49)

- Eine Lösung deutet sich an über RNA Moleküle: diese sind flexibler und können als Katalysatoren wirken, die zur Bildung jener ersten Proteine geführt haben, die wiederum Vorformen von DNA-Molekülen ermöglichten.(vgl.49-51)

- Allerdings, wo kommen diese RNA-Moleküle her? Man weiß, dass RNA-Moleküle sich nur bei hohen Konzentrationen bilden können, da sie beim Zusammenbau Nukleotide verbrauchen. Wo findet man solche hohen Konzentrationen? Die Entdeckung der unterseeischen Schlote eröffnet ein mögliches Szenario. Modellrechnungen zeigten, dass die Wahrscheinlichkeit sehr hoch ist, dass sich in solchen Schloten (speziell in den Poren des Gesteins) solche hohen Konzentrationen von RNA-Molekülen bilden können. Simuliert man RNA-Moleküle isoliert, dann tendieren sie dazu, sich nur mit einer minimalen Struktur fortzupflanzen, nur genau so viele Elemente, wie zur Reproduktion notwendig sind (die berühmten ‚Spiegelmann Monster‘). Dieses Modell ist offensichtlich nicht dazu geeignet, die Bildung komplexer RNA-Moleküle, dazu noch in Kooperation mit Proteinbildung zu erklären. Eine Lösung muss in einem umfassenderen Rahmen gesucht werden, in dem die RNA-Moleküle nur eine Teilkomponenten sind. Dieser umfassenderer Rahmen wurde wieder in der Struktur der unterseeischen Schlote gesehen. Die Poren bilden natürliche Umgebungen, die wie eine Zelle wirken, in der komplexere metabolische Prozesse ablaufen können, in deren Kontext die RNA-Moleküle nur eine Teilfunktion haben.(vgl. S.53-55)

- Zum Thema umfassender Rahmen gehören auch die Entdeckungen, dass aufgrund genetischer Strukturen die Eukaryotischen Zellen (jene mit einem Zellkern) von den Archaeen abstammen, diese wiederum haben sehr viel mit den Bakterien gemeinsam. Letztere beiden unterscheiden sich aber bei der DNA Replikation, was so gedeutet wird, dass beide einen gemeinsamen Vorläufer haben müssen, von dem sie sich unterschiedlich weiter entwickelt haben.(vgl.S.55f)

- Die Arbeitshypothesen laufen darauf hinaus, dass die flexibleren RNA-Moleküle zwischen Proteinerzeugung und DNA-Bildung vermittelt haben (nach dem Muster von Retroviren?). Erst in dem Maße, wie sich die stabileren DNA-Moleküle bilden konnten, war auf Dauer eine Reproduktion gesichert. Für die beiden chemischen Unterschiede von RNA- und DNA-Molekülen gibt es genügend chemische Bestandteile in der unterseeischen Schlotumgebung, so dass eine DNA-Erzeugung aus RNA-Molekülen prinzipiell möglich erscheint.(vgl. SS.55-59)

DISKURS

- Die Details der neuen Erkenntnisse können einen erschlagen, und doch ist dies ja nur die berühmte Spitze des Eisbergs. Hinter diesen Fakten verbergen sich hochkomplexe Prozesse und entsprechend aufwendige Forschungen, die hier natürlich nicht beschrieben werden können. Nick Lane macht das großartig.

- Aber, treten wir ein paar Schritte zurück und fragen uns, was sich in diesen vielen Fakten an allgemeineren Strukturen andeutet.

- Offensichtlich nimmt man aktuell an, dass man mindestens die folgenden Strukturen unterscheiden sollte:

- Die heutigen eukaryotischen Zellen (Z_eu) (Zellen mit einem komplexen Kern und vielen Teilstrukturen inklusive ganzer ehemaliger Bakterien).

- Die heutigen Prokarytischen Zellen (Z_pro) als Bakterien (Z_ba) und die Archaeen (Z_ar)

- Eine Erzeugungsbeziehung zwischen Archaeen und Eukaryoten (g_ar.eu : Z_ar —> Z_eu)

- Bei dieser Erzeugungsbeziehung sind weitere Einflussfaktoren durch horizontalen Genaustausch nicht völlig ausgeschlossen.

- Es soll einen gemeinsamen Vorläufer (Z_pre) von Archaeen und Bakterien geben.

- Entsprechend muss es auch eine Erzeugungsbeziehung geben: g_pre.ar.ba: Z_pre —> Z_ba u Z_ar.

- Diese Strukturen und Erzeugungsbeziehungen haben nicht im Nichts stattgefunden, sondern haben geeignete Umgebungen ENV benötigt, die sowohl in großen Mengen und kontinuierlich die notwendigen Ausgangsmaterialien M0 bereit halten konnten wie auch die notwendigen Temperaturgefälle DT für die Ermöglichung der chemischen Prozesse: ENV = <M0, DT, Z_pre, Z_ba, Z_ar, Z_eu, g_pre.ar.ba, g_ar.eu>

- Ferner wird angenommen, dass die allgemeinen physikalisch-chemischen Gesetze (G) gelten und ausschließlich diese für das Auftreten und das Reagieren der verschiedenen beteiligten Materialien zuständig sind, also ENV = <M0, DT, Z_pre, Z_ba, Z_ar, Z_eu, g_pre.ar.ba, g_ar.eu, G>

- Dazu gehören auch jene Entstehungsprozesse, die aus den Ausgangsmaterialien M0 die Vorläuferzelle Z_pre hat entstehen lassen, also g_0: ENV x TD x M0 —> Z_pre, also ENV = <M0, DT, Z_pre, Z_ba, Z_ar, Z_eu, g_0, g_pre.ar.ba, g_ar.eu, G>

- Für den Bereich der eukaryotischen Zellen Z_eu werden mindestens angenommen DNA-Moleküle, Boten-RNA (mRNA), Transfer RNA (tRNA), ribosomale RNA (ribRNA) und Proteine PROT. Dazu weitere Großstrukturen wie Chromatin(e), Chromosomen, Mitochondrien, usw.

- Im Bereich der Erzeugungsprozesse muss man ferner eine Art zeitliche und logische Abhängigkeit annehmen, indem der jeweils spätere Hervorbringungsprozess andere frühere voraussetzt, also: G < g_0 < g_pre.ar.ba < g_ar.eu.

- Jeder dieser Hervorbringungsprozesse wiederum zeigt sich nicht im Nichts sondern nur beim Vorhandensein spezifischer Materialien M, die in ihrem beobachtbaren Verhalten phi indirekt das Wirken spezifischer Gesetze manifestieren. Ohne die Beobachtbarkeit spezifischer Materialien und deren Verhalten (Newtons berühmter Apfel, die Planetenbahnen der alten Astronomen, magnetische Kräfte, Vulkanausbrüche, geologische Ablagerungen usw.) wäre es nicht möglich, auf dahinter/ darunter/ damit .. wirkende Kräfte phi zu schließen, die man dann in Form von symbolischen Darstellungen als gesetzmäßige Beziehungen (Relationen, Funktionen, Axiome) beschreibt.

- Während das menschliche Denken beim Vorliegen von irgendwelchen beobachtbaren Materialien, deren Eigenschaften und Veränderungen spontan dazu neigt, diese als gegeben, als auftretend, als seiend, als objektiv, als Objekte zu unterstellen, tut sich das gleiche Denken sehr schwer, das durch diese Materialien sichtbare werdende Verhalten phi in gleicher Weise als gegeben, seiend, objektiv vorkommend zu denken.

- Obgleich die beobachtbaren Materialien ohne dieses unterstellte Verhalten sich in keiner Weise verändern würden, zögern wir, aus den beobachtbaren Veränderungen auf eine interne Eigenschaft der Materialien zu schließen. Im Falle von tierischen Lebewesen wissen wir mittlerweile, dass das gesamte Verhalten in einem Nervensystem gründet, das im Innern des Systems angeordnet ist und von da aus das Verhalten steuert. Aber wir tun uns schwer, in analoger Weise anzunehmen, dass das überall beobachtbare Verhalten von Materialien nicht auch von Strukturen abhängig ist, die im Innern der Materialien zu verorten sind.

- Bei chemischen Molekülen unterstellt man die atomare Struktur mit den unterschiedlichen Bestandteilen, Ladungen und Reaktionstendenzen, die in Wechselwirkung mit der jeweiligen Umgebung sich spezifisch verändern können.

- Bei Atomen bleiben einem nur noch die unterscheidbaren Teilchen, aber auch diese haben mathematisch beschreibbare ( wenngleich in Form von Möglichkeitsräumen) Verhaltenstendenzen.

- Dann bleibt als letzter Referenzpunkt nur die reine Energie E. Diese kann man nicht direkt beobachten, nur in ihren Wirkungen. Mit anderen Worten, die Energie E enthält sowohl alle potentiellen Materialeigenschaften wie auch die dazu gehörigen Verhaltenstendenzen. In diesem Sinne repräsentiert die Energie E eine Art Superobjekt, in dem die in der Makrowelt bekannte Unterscheidung zwischen materiellen Strukturen und Verhalten nicht mehr gilt. Energie als Superobjekt beinhaltet Materie und deren Verhalten in einem. Um diesen Sachverhalt auszudrücken, ist die bekannte Formel von Einstein e = mc^2 möglicherweise zu ungenau. Sie bietet keine Möglichkeit, zwischen materiellen Strukturen und Verhalten zu unterscheiden. Das beobachtbare Verhalten ist aber genau die Sprache, in der sich das Innere der Dinge mitteilt. Alles,was uns Menschen fasziniert, das sind die Erscheinungen der Veränderungen, ihre Vielfalt, ihre Abfolge. Liebe enthüllt sich nur im Gewandte solcher Veränderungen, genauso wie Hass oder Treue. Wissen ist eingeflochten in eine Vielzahl von Strukturen und deren Veränderungen.

- Sowohl die Entwicklung des Universums vor dem ersten Auftreten von Leben wie erst recht dann mit dem Auftreten biologischer Strukturen ist ein Prozess immer komplexerer Verhaltensweisen, die in ihrer Dynamik Gesetze, Regeln, Strukturen erkennen lassen, die den Blick immer tiefer in das Innere aller Dinge öffnen. Das ist eigentlich unfassbar fantastisch, aber es scheint niemand besonders zu rühren.

Keine direkte, aber inhaltlich passende Fortsetzung könnte DIESE sein.

WEITERE QUELLEN/ LINKS (Selektiv)

- Freie Protein-Datenbank: http://www.ebi.ac.uk/pdbe/ (siehe auch http://proteopedia.org/wiki/index.php/Main_Page )

- Visualisierung von Proteindaten: https://de.wikipedia.org/wiki/Jmol und http://wiki.jmol.org/index.php/Jmol_Application#Starting_Jmol_Application

- Proteine (Peptide): https://de.wikipedia.org/wiki/Protein

- Aminosäuren: https://de.wikipedia.org/wiki/Aminos%C3%A4uren

- Alpha-Ketoglutarate: https://en.wikipedia.org/wiki/Alpha-Ketoglutaric_acid

- oxalocetate: https://en.wikipedia.org/wiki/Oxaloacetic_acid

- Pyruvate: https://en.wikipedia.org/wiki/Pyruvic_acid

- Punktmutation: https://de.wikipedia.org/wiki/Punktmutation

- Spiegelmann Monster: https://de.wikipedia.org/wiki/Spiegelmans_Monster

- Bakterien: https://de.wikipedia.org/wiki/Bakterien

- Achaeen: https://de.wikipedia.org/wiki/Archaeen

- Eukaryoten: https://de.wikipedia.org/wiki/Eukaryoten

- Retroviren: https://de.wikipedia.org/wiki/Retroviren

- Chromosom: https://de.wikipedia.org/wiki/Chromosom

- Chromatin: https://de.wikipedia.org/wiki/Chromatin

- CELL: B.Alberts, A.Johnson, J.Lewis (und andere), Molecular Biology of THE CELL, 6.Aufl., 2015, New York: Garland Science, Taylor and Francis Group, LLC.

- V.Storch, U.Welsch, M.Wink (und andere), Evolutionsbiologie,3.überarbeitete und aktualisiere Aufl., 2013, Berlin – Heidelberg: Springer-Verlag

- Francis Harry Compton Crick, Nobelpreisrede: http://www.nobelprize.org/nobel_prizes/medicine/laureates/1962/crick-lecture.html

- Francis Harry Compton Crick Life Itself: Its Origin and Nature (Simon & Schuster, 1981) ISBN 0-671-25562-2

- DNA WikiEN: https://en.wikipedia.org/wiki/DNA

- RNA: https://de.wikipedia.org/wiki/Ribonukleins%C3%A4ure

- Harold Morowitz: https://en.wikipedia.org/wiki/Harold_J._Morowitz (ein großes Thema: Wechselwirkung von Thermodynamik und Leben)

- Michael J.Russel et al: http://www.gla.ac.uk/projects/originoflife/html/2001/pdf_articles.htm: The Origin of Life research project by Michael J. Russell & Allan J. Hall , University of Glasgow, May 2011

- Krebs-Zyklus: https://en.wikipedia.org/wiki/Citric_acid_cycle

- Martin W, Russell MJ., On the origin of biochemistry at an alkaline hydrothermal vent. , Philos Trans R Soc Lond B Biol Sci. 2007 Oct 29; 362(1486):1887-925.

- Martin W, Baross J, Kelley D, Russell MJ., Hydrothermal vents and the origin of life., Nat Rev Microbiol. 2008 Nov; 6(11):805-14.

- Harold Morowitz und Eric Smith , Energy flow and the organization of life , Journal Complexity archive, Vol. 13, Issue 1, September 2007, SS. 51 – 59 ,John Wiley & Sons, Inc. New York, NY, USA

Einen Überblick über alle Blogeinträge des Autors cagent nach Titeln findet sich HIER.