Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 27.August 2015

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

VORBEMERKUNG: Der folgende Text ist ein Vorabdruck zu dem Buch Die andere Superintelligenz. Oder: schaffen wir uns selbst ab?, das im November 2015 erscheinen soll.

Was ist Leben?

Erst die Erde

Etwa 9.2 Mrd Jahre nach dem sogenannten Big Bang kam es zur Entstehung unseres Sonnensystems mit der Sonne als wichtigstem Bezugspunkt. Nur ca. 60 Mio Jahre später gab es unsere Erde. Die Zeitspanne, innerhalb der Spuren von Leben auf der Erde bislang identifiziert wurden, liegt zwischen -4 Mrd Jahre von heute zurück gerechnet bis ca. -3.5 Mrd Jahre. Oder, vom Beginn der Erde aus gesehen, ca. 540 Mio Jahre bis ca. 1 Mrd Jahre nach der Entstehung der Erde.

Alte Bilder vom Leben

Wenn man vom Leben spricht, von etwas Belebtem im Gegensatz zum Unbelebtem, fragt man sich sofort, wie man ‚Leben‘ definieren kann? In der zurückliegenden Geschichte gab es viele Beschreibungs- und Definitionsversuche. Einer, der heute noch begrifflich nachwirkt, ist die Sicht der Philosophie der Antike (ca. -600 bis 650) . Hier wurde das ‚Atmen‘ (gr. ‚pneo‘) als charakteristisches Merkmal für ‚Lebendiges‘ genommen, wodurch es vom ‚Unbelebtem‘ abgegrenzt wurde. Aus dem ‚Atmen‘ wurde zugleich ein allgemeines Lebensprinzip abgeleitet, das ‚Pneuma‘ (im Deutschen leicht missverständlich als ‚Geist‘ übersetzt, im Lateinischen als ’spiritus‘), das sich u.a. im Wind manifestiert und ein allgemeines kosmologisches Lebensprinzip verkörpert, das sowohl die Grundlage für die psychischen Eigenschaften eines Lebewesens bildet wie auch für seine körperliche Lebendigkeit. In der Medizin gab es vielfältige Versuche, das Pneuma im Körper zu identifizieren (z.B. im Blut, in der Leber, im Herzen, im Gehirn und den Nerven). Im philosophischen Bereich konnte das Pneuma ein heißer Äther sein, der die ganze Welt umfasst. Eine andere Auffassung sieht das Pneuma zusammengesetzt aus Feuer und Luft, woraus sich alle Körper der Welt bilden. Das Pneuma wird auch gesehen als die ‚Seele‘, die allein das Leben des Körpers ermöglicht. Bei den Stoikern wird das Pneuma-Konzept zum allumfassenden Begriff einer Weltseele gesteigert. Mit der Zeit vermischte sich der Pneuma-Begriff mit dem Begriff ’nous‘ (Kurzform für ’noos‘)(Englisch als ‚mind‘ übersetzt; Deutsch ebenfalls als ‚Geist‘), um darin die kognitiv-geistige Dimension besser auszudrücken. Weitere einflussreiche begriffliche Koordinierungen finden statt mit dem lateinischen ‚mens‘ (Deutsch auch übersetzt mit ‚Geist‘) und dem hebräischen ‚ruach‘ (im Deutschan ebenfalls mit ‚Geist‘ übersetzt; bekannt in der Formulierung ‚Der Geist Gottes (= ‚ruach elohim‘) schwebte über den Wassern‘; in der Septuaginta, der griechischen Übersetzung der hebräischen Bibel, heißt es ‚pneuma theou‘ (= der Geist Gottes)) (Anmerkung: Diese Bemerkungen sind ein kleiner Extrakt aus der sehr ausführlichen begriffsgeschichtlichen Herleitung in Sandkühler 2010)

Die Zelle im Fokus

War es für die antiken Philosophen, Mediziner und Wissenschaftler noch praktisch unmöglich, die Frage nach den detaillierten Wirkprinzipien des ‚Lebens‘ genauer zu beantworten, erarbeitete sich die moderne Naturwissenschaft immer mehr Einsichten in die Wirkprinzipien biologischer Phänomene (bei Tieren, Pflanzen, Mikroben, molekularbiologischen Sachverhalten), so dass im Laufe des 20.Jahrhunderts klar wurde, dass die Gemeinsamkeit aller Lebensphänomene auf der Erde in jener Superstruktur zu suchen ist, die heute (biologische) Zelle genannt wird.

Alle bekannten Lebensformen auf der Erde, die mehr als eine Zelle umfassen (wir als Exemplare der Gattung homo mit der einzigen Art homo sapiens bestehen aus ca. 10^13 vielen Zellen), gehen zu Beginn ihrer körperlichen Existenz aus genau einer Zelle hervor. Dies bedeutet, dass eine Zelle über alle notwendigen Eigenschaften verfügt, sich zu reproduzieren und das Wachstum eines biologischen Systems zu steuern.

So enthält eine Zelle (Anmerkung: Für das Folgende benutze ich B.Alberts et.al (2008)) alle Informationen, die notwendig sind, um sowohl sich selbst zu organisieren wie auch um sich zu reproduzieren. Die Zelle operiert abseits eines chemischen Gleichgewichts, was nur durch permanente Aufnahme von Energie realisiert werden kann. Obwohl die Zelle durch ihre Aktivitäten die Entropie in ihrer Umgebung ‚erhöht‘, kann sie gegenläufig durch die Aufnahme von Energie auch Entropie verringern. Um einen einheitlichen Prozessraum zu gewährleisten, besitzen Zellen eine Membran, die dafür sorgt, dass nur bestimmte Stoffe in die Zelle hinein- oder herauskommen.

Keine Definition für außerirdisches Leben

Obgleich die Identifizierung der Zelle samt ihrer Funktionsweise eine der größten Errungenschaften der modernen Wissenschaften bei der Erforschung des Phänomens des Lebens darstellt, macht uns die moderne Astrobiologie darauf aufmerksam, dass eine Definition der Lebensphänomene mit Einschränkung des Blicks auf die speziellen Bedingungen auf der Erde nicht unproblematisch ist. Wunderbare Bücher wie „Rare Earth“ von Peter Douglas Ward (Geboren 1949) und Donald Eugene Brownlee (Geboren 1943) „ASTROBIOLOGY. A Multidisciplinary Approach“ von Jonathan I.Lunine (Geb. 1959) machen zumindest sichtbar, wo die Probleme liegen könnten. Lunine diskutiert in Kap.14 seines Buches die Möglichkeit einer allgemeineren Definition von Leben explizit, stellt jedoch fest, dass es aktuell keine solche eindeutige allgemeine Definition von Leben gibt, die über die bekannten erdgebundenen Formen wesentlich hinausgeht. (Vgl. ebd. S.436)

Schrödingers Vision

Wenn man die Charakterisierungen von Leben bei Lunine (2005) in Kap.14 und bei Alberts et.al (2008) in Kap.1 liest, fällt auf, dass die Beschreibung der Grundstrukturen des Lebens trotz aller Abstraktionen tendenziell noch sehr an vielen konkreten Eigenschaften hängen.

Erwin Rudolf Josef Alexander Schrödinger (1887-1961), der 1944 sein einflussreiches Büchlein „What is Life? The Physical Aspect of the Living Cell“ veröffentlichte, kannte all die Feinheiten der modernen Molekularbiologie noch nicht . Schrödinger unterzog das Phänomen des Lebens einer intensiven Befragung aus Sicht der damaligen Physik. Auch ohne all die beeindruckenden Details der neueren Forschung wurde ihm klar, dass das hervorstechendste Merkmal des ‚Biologischen‘, des ‚Lebendigen‘ die Fähigkeit ist, angesichts der physikalisch unausweichlichen Zunahme der Entropie einen gegensätzlichen Trend zu realisieren; statt wachsender Unordnung als Entropie diagnostizierte er eine wachsende Ordnung als negative Entropie, also als etwas, was der Entropie entgegen wirkt.

Diesen Gedanken Schrödingers kann man weiter variieren und in dem Sinne vertiefen, dass der Aufbau einer Ordnung Energie benötigt, mittels der Freiheitsgrade eingeschränkt und Zustände temporär ‚gefestigt‘ werden können.

Fragt sich nur, warum?

Alberts et.al (2008) sehen das Hauptcharakteristikum einer biologischen Zelle darin, dass sie sich fortpflanzen kann, und nicht nur das, sondern dass sie sich selbstmodifizierend fortpflanzen kann. Die Realität biologischer Systeme zeigt zudem, dass es nicht nur um ‚irgendeine‘ Fortpflanzung ging, sondern um eine kontinuierlich optimierende Fortpflanzung.

Metastrukturen

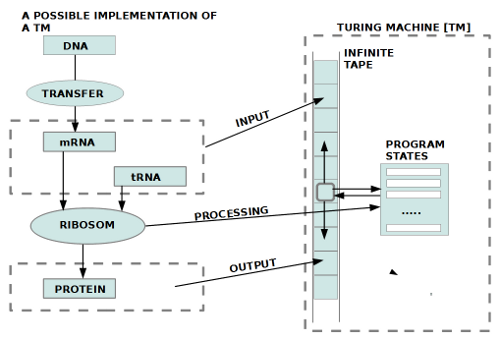

Nimmt man diese Eckwerte ernst, dann liegt es nahe, biologische Zellen als Systeme zu betrachten, die einerseits mit den reagierenden Molekülen mindestens eine Objektebene [O] umfasst und in Gestalt der DNA eine Art Metaebene [M]; zwischen beiden Systemen lässt sich eine geeigneten Abbildung [R] in Gestalt von Übersetzungsprozessen realisieren, so dass die Metaebene M mittels Abbildungsvorschrift R in eine Objektebene O übersetzt werden kann ($latex R: M \longmapsto O$). Damit eine Reproduktion grundsätzlich gelingen kann, muss verlangt werden, dass das System mit seiner Struktur ‚lang genug‘ stabil ist, um solch einen Übersetzungsprozess umsetzen zu können. Wie diese Übersetzungsprozesse im einzelnen vonstatten gehen, ist letztlich unwichtig. Wenn in diesem Modell bestimmte Strukturen erstmals realisiert wurden, dann fungieren sie als eine Art ‚Gedächtnis‘: alle Strukturelemente von M repräsentieren potentielle Objektstrukturen, die jeweils den Ausgangspunkt für die nächste ‚Entwicklungsstufe‘ bilden (sofern sie nicht von der Umwelt ‚aussortiert‘ werden).

Die Rolle dieser Metastrukturen lässt sich letztlich nicht einfach mit den üblichen chemischen Reaktionsketten beschreiben; tut man es dennoch, verliert man die Besonderheit des Phänomens aus dem Blick. Eine begriffliche Strategie, um das Phänomen der ‚wirkenden Metastrukturen‘ in den Griff zu bekommen, war die Einführung des ‚Informationsbegriffs‘.

Information

Grob kann man hier mindestens die folgenden sprachlichen Verwendungsweisen des Begriffs ‚Information‘ im Kontext von Informationstheorie und Molekularbiologie unterscheiden:

- Unreflektiert umgangssprachlich (‚Information_0‘)

- Anhand des Entscheidungsaufwandes (Bit) (‚Information_1‘)

- Rein statistisch (a la Shannon 1948) (‚Information_2‘)

- Semiotisch informell (ohne die Semiotik zu zitieren) (‚Semantik_0‘)

- Als komplementär zur Statistik (Deacon) (‚Semantik_1‘)

- Als erweitertes Shannonmodell (‚Semantik_2‘)

Information_0

Die ‚unreflektiert umgangssprachliche‘ Verwendung des Begriffs ‚Information‘ (hier: ‚Information_0‘) brauchen wir hier nicht weiter zu diskutieren. Sie benutzt den Begriff Information einfach so, ohne weitere Erklärungen, Herleitungen, Begründungen. (Ein Beispiel Küppers (1986:41ff))

Information_1

Die Verwendung des Begriffs Information im Kontext eines Entscheidungsaufwandes (gemessen in ‚Bit‘), hier als ‚Information_1‘ geht auf John Wilder Tukey (1915-2000) zurück.

Information_2

Shannon (1948) übernimmt zunächst diesen Begriff Information_1, verzichtet dann aber im weiteren Verlauf auf diesen Informationsbegriff und führt dann seinen statistischen Informationsbegriff ein (hier: ‚Information_2‘), der am Entropiekonzept von Boltzmann orientiert ist. Er spricht dann zwar immer noch von ‚Information‘, bezieht sich dazu aber auf den Logarithmus der Wahrscheinlichkeit eines Ereignisses, was alles und jedes sein kann. Ein direkter Bezug zu einem ’speziellen‘ Informationsbegriff (wie z.B. Information_1) besteht nicht. Man kann die logarithmierte Wahrscheinlichkeit eines Ereignisses als ‚Information‘ bezeichnen (hier: ‚Information_2‘), aber damit wird der Informationsbegriff inflationär, dann ist alles eine Information, da jedes Ereignis mindestens eine Wahrscheinlichkeit besitzt. (Leider benutzt auch Carl Friedrich von Weizsäcker (1971:347f) diesen inflationären Begriff (plus zusätzlicher philosophischer Komplikationen)). Interessanterweise ist es gerade dieser inflationäre statistische Informationsbegriff Information_2, der eine sehr starke Resonanz gefunden hat.

Semantik 0

Nun gibt es gerade im Bereich der Molekularbiologie zahlreiche Phänomene, die bei einer Beschreibung mittels eines statistischen Informationsbegriffs wichtige Momente ihres Phänomens verlieren. (Dazu eine kleine Übersicht bei Godfrey-Smith, Kim Sterelny (2009)) Ein Hauptkritikpunkt war und ist das angebliche Fehlen von Bedeutungselementen im statistischen Modell von Shannon (1948). Man spricht auch vom Fehlen einer ‚Semantik‘. Allerdings wird eine Diskussion der möglichen Bedeutungsmomente von Kommunikationsereignissen unter Verwendung des Begriffs ‚Semantik‘ auch oft unreflektiert alltagssprachlich vorgenommen (hier: Semantik_0′), d.h. es wird plötzlich von Semantik_0 gesprochen (oft noch erweitert um ‚Pragmatik‘), ohne dass die Herkunft und Verwendung dieses Begriffs in der Wissenschaft der Semiotik weiter berücksichtigt wird. (Ein Beispiel für solch eine verwirrende Verwendungsweise findet sich z.B. wieder bei Weizsäcker (1971:350f), wo Information_0, Information_2 sowie Semantik_0 miteinander frei kombiniert werden, ohne Berücksichtigung der wichtigen Randbedingungen ihrer Verwendung; ganz ähnlich Küppers (1986:61ff); zur Semiotik siehe Noeth (2000)). Ein anderes neueres Beispiel ist Floridi (2015:Kap.3+4) Er benutzt zwar den Begriff ‚Semantik‘ extensiv, aber auch er stellt keinen Bezug zur semiotischen Herkunft her und verwendet den Begriff sehr speziell. Seine Verwendung führt nicht über den formalen Rahmen der statistischen Informationstheorie hinaus.

Semantik 1

Sehr originell ist das Vorgehen von Deacon (2007, 2008, 2010). Er diagnostiziert zwar auch einen Mangel, wenn man die statistische Informationstheorie von Shannon (1948) auf biologische Phänomene anwenden will, statt sich aber auf die schwierige Thematik einer expliziten Semantik einzulassen, versucht er über die Ähnlichkeit des Shannonschen statistischen Informationsbegriffs mit dem von Boltzmann einen Anschluss an die Thermodynamik zu konstruieren. Von dort zum Ungleichgewicht biologischer Systeme, die durch Arbeit und Energieaufnahme ihr Gleichgewicht zu halten versuchen. Diese Interaktionen des Systems mit der Umgebung modifizieren die inneren Zustände des Systems, die wiederum dann das Verhalten des Systems ‚umweltgerecht‘ steuern. Allerdings belässt es Deacon bei diesen allgemeinen Annahmen. Die ‚Abwesenheit‘ der Bedeutung im Modell von Shannon wird über diese frei assoziierten Kontexte – so vermutet man als Leser – mit den postulierten internen Modifikationen des interagierenden Systems begrifflich zusammengeführt. Wie dies genau gedacht werden kann, bleibt offen.

Semantik 2

So anregend die Überlegungen von Deacon auch sind, sie lassen letztlich offen, wie man denn – auch unter Berücksichtigung des Modells von Shannon – ein quasi erweitertes Shannonmodell konstruieren kann, in dem Bedeutung eine Rolle spielt. Hier eine kurze Skizze für solch ein Modell.

Ausgehend von Shannons Modell in 1948 besteht die Welt aus Sendern S, Empfängern D, und Informationskanälen C, über die Sender und Empfänger Signale S eingebettet in ein Rauschen N austauschen können (<S,D,S,N,C> mit C: S —> S x N).

Ein Empfänger-Sender hat die Struktur, dass Signale S in interne Nachrichten M dekodiert werden können mittels R: S x N —> M. Umgekehrt können auch Nachrichten M in Signale kodiert werden mit T: M —> S. Ein minimaler Shannon Sender-Empfänger hat dann die Struktur <M, R, T>. So gesehen funktionieren R und T jeweils als ‚Schnittstellen‘ zwischen dem ‚Äußeren‘ und dem ‚Inneren‘ des Systems.

In diesem minimalen Shannonmodell kommen keine Bedeutungen vor. Man kann allerdings annehmen, dass die Menge M der Nachrichten eine strukturierte Menge ist, deren Elemente Paare der Art (m_i,p_i) in M mit ‚m_i‘ als Nachrichtenelement und ‚p_i‘ als Wahrscheinlichkeit, wie oft dieses Nachrichtenelement im Kanal auftritt. Dann könnte man Shannons Forml H=-Sum(p_i * log2(p_i)) als Teil des Systems auffassen. Das minimale Modell wäre dann <M, R, T, H>.

Will man ‚Bedeutungen‘ in das System einführen, dann muss man nach der Semiotik einen Zeichenbegriff für das System definieren, der es erlaubt, eine Beziehung (Abbildung) zwischen einem ‚Zeichenmaterial‚ und einem ‚Bedeutungsmaterial‚ zu konstruieren. Nimmt man die Signale S von Shannon als Kandidaten für ein Zeichenmaterial, fragt sich, wie man das Bedeutungsmaterial B ins Spiel bringt.

Klar ist nur, dass ein Zeichenmaterial erst dann zu einem ‚Zeichen‘ wird, wenn der Zeichenbenutzer in der Lage ist, dem Zeichenmaterial eine Bedeutung B zuzuordnen. Eine einfache Annahme wäre, zu sagen, die dekodierten Nachrichten M bilden das erkannte Zeichenmaterial und der Empfänger kann dieses Material irgendwelchen Bedeutungen B zuordnen, indem er das Zeichenmaterial M ‚interpretiert‚, also I : M —> B. Damit würde sich die Struktur erweitern zu <B, M, R, T, H, I>. Damit nicht nur ein Empfänger ‚verstehen‘ kann, sondern auch ‚mitteilen‘, müsste der Empfänger als Sender Bedeutungen auch wieder ‚umgekehrt lesen‘ können, also -I: B —> M. Diese Nachrichten könnten dann wieder mittels T in Signale übersetzt werden, der Kanal sendet diese Signale S angereichert mit Rauschen N zum Empfänger, usw. Wir erhalten also ein minimal erweitertes Shannon Modell mit Bedeutung als <B, M, R, T, H, I, -I>. Ein Sender-Empfänger kann also weiterhin die Wahrscheinlichkeitsstruktur seiner Nachrichten auswerten; zusätzlich aber auch mögliche Bedeutungsanteile.

Bliebe als Restfrage, wie die Bedeutungen B in das System hineinkommen bzw. wie die Interpretationsfunktion I entsteht?

An dieser Stelle kann man die Spekulationen von Deacon aufgreifen und als Arbeitshypothese annehmen, dass sich die Bedeutungen B samt der Interpretationsbeziehung I (und -I) in einem Adaptionsprozess (Lernprozess) in Interaktion mit der Umgebung entwickeln. Dies soll an anderer Stelle beschrieben werden.

Für eine komplette Beschreibung biologischer Phänomene benötigt man aber noch weitere Annahmen zur Ontogense und zur Phylogense. Diese seien hier noch kurz skizziert. (Eine ausführliche formale Darstellung wird anderswo nachgeliefert).

Ontogenese

Von der Lernfähigkeit eines biologischen Systems muss man die Ontogenese unterscheiden, jenen Prozess, der von der Keimzelle bis zum ausgewachsenen System führt.

Die Umsetzung der Ontogenese in einem formalen Modell besteht darin, einen Konstruktionsprozess zu definieren, das aus einem Anfangselement Zmin das endgültige System Sys in SYS erstellen würde. Das Anfangselement wäre ein minimales Element Zmin analog einer befruchteten Zelle, das alle Informationen enthalten würde, die notwendig wären, um diese Konstruktion durchführen zu können, also Ontogenese: Zmin x X —> SYS. Das ‚X‘ stünde für alle die Elemente, die im Rahmen einer Ontogenese aus der Umgebung ENV übernommen werden müssten, um das endgültige system SYS = <B, M, R, T, H, I, -I> zu konstruieren.

Phylogenese

Für die Reproduktion der Systeme im Laufe der Zeiten benötigte man eine Population von Systemen SYS, von denen jedes System Sys in SYS mindestens ein minimales Anfangselement Zmin besitzt, das für eine Ontogenese zur Verfügung gestellt werden kann. Bevor die Ontogenese beginnen würde, würden zwei minimale Anfangselemente Zmin1 und Zmin2 im Bereich ihrer Bauanleitungen ‚gemischt‘. Man müsste also annehmen, dass das minimale System um das Element Zmin erweitert würde SYS = <B, M, Zmin, R, T, H, I, -I>.

Erstes Zwischenergebnis

Auffällig ist also, dass das Phänomen des Lebens

- trotz Entropie über dynamische Ungleichgewichte immer komplexere Strukturen aufbauen kann.

- innerhalb seiner Strukturen immer komplexere Informations- und Bedeutungsstrukturen aufbaut und nutzt.

So wie man bislang z.B. die ‚Gravitation‘ anhand ihrer Wirkungen erfasst und bis heute erfolglos zu erklären versucht, so erfassen wir als Lebende das Leben anhand seiner Wirkungen und versuchen bis heute auch erfolglos, zu verstehen, was hier eigentlich passiert. Kein einziges physikalisches Gesetzt bietet auch nur den leisesten Anhaltspunkt für dieses atemberaubende Geschehen.

In dieser Situation den Menschen als eine ‚vermutlich aussterbende Art‘ zu bezeichnen ist dann nicht einfach nur ‚gedankenlos‘, sondern im höchsten Maße unwissenschaftlich, da es letztlich einer Denkverweigerung nahe kommt. Eine Wissenschaft, die sich weigert, über die Phänomene der Natur nachzudenken, ist keine Wissenschaft.

Fortsetzung Folgt.

QUELLEN

- H.J. Sandkühler (Hg.), 2010, „Enzyklopädie Philosophie“, Hamburg: Felix Meiner Verlag, Band 1: Von A bis H, Kapitel: Geist, SS.792ff

- B.Alberts et.al (Hg.), 2008, „Molecular Biology of the CELL“, Kap.1, 5.Aufl., New York: Garland Science, Taylor & Francis Group

- Peter Douglas Ward und `Donald Eugene Brownlee (2000),“Rare Earth: Why Complex Life Is Uncommon in the Universe“, New York: Copernikus/ Springer,

- Jonathan I.Lunine (2005), „ASTROBIOLOGY. A Multidisciplinary Approach“, San Francisco – Boston – New York et al.: Pearson-Addison Wesley

- Zu Schroedinger 1944: Based on Lectures delivered under the auspices of the Institute at Trinity College, Dublin, in February 1943, Cambridge: University Press. 1944. Ich selbst habe die Canto Taschenbuchausgabe der Cambridge University von 1992 benutzt. Diese Ausgabe enthält ‚What is Life?‘, ‚Mind from Matter‘, sowie autobiographischen Angaben und ein Vorwort von Roger Penrose

- Anmerkung zu Schroedinger 1944: Sowohl James D. Watson (2003) wie auch ähnlich Francis Crick (1990) berichten, dass Schrödingers Schrift (bzw. einer seiner Vorträge) sie für ihre Erforschung der DNA stark angeregt hatte.

- James D.Watson und A.Berry(2003), „DNA, the Secret of Life“, New York: Random House

- Francis Crick (1990),„What Mad Pursuit: A Personal View of Scientific Discovery“, Reprint, Basic Books

- Peter Godfrey-Smith und Kim Sterelny (2009) Biological Information“, in: Stanford Enyclopedia of Philosophy

- Carl Friedrich von Weizsäcker (1971), „Die Einheit der Natur“, München: Carl Hanser Verlag

- Bernd-Olaf Küppers (1986), „Der Ursprung biologischer Information. Zur Naturphilosophie der Lebensentstehung“, München – Zürich: Piper Verlag.

- Claude E. Shannon, A mathematical theory of communication. Bell System Tech. J., 27:379-423, 623-656, July, Oct. 1948

- Claude E. Shannon; Warren Weaver (1949) „The mathematical theory of communication“. Urbana – Chicgo: University of Illinois Press.

- Noeth, W., Handbuch der Semiotik, 2. vollst. neu bearb. und erw. Aufl. mit 89 Abb. Stuttgart/Weimar: J.B. Metzler, xii + 668pp, 2000

- Luciano Floridi (2015) Semantic Conceptions of Information, in: Stanford Enyclopedia of Philosophy

- Deacon, T. (2007), Shannon-Boltzmann-Darwin: Redfining information. Part 1. in: Cognitive Semiotics, 1: 123-148

- Deacon, T. (2008), Shannon-Boltzmann-Darwin: Redfining information. Part 2. in: Cognitive Semiotics, 2: 167-194

- Terrence W.Deacon (2010), „What is missing from theories of information“, in: INFORMATION AND THE NATURE OF REALITY. From Physics to Metaphysics“, ed. By Paul Davies & Niels Henrik Gregersen, Cambridge (UK) et al: Cambridge University Press, pp.146 – 169

Einen Überblick über alle Blogbeiträge des Autors cagent nach Titeln findet sich HIER.

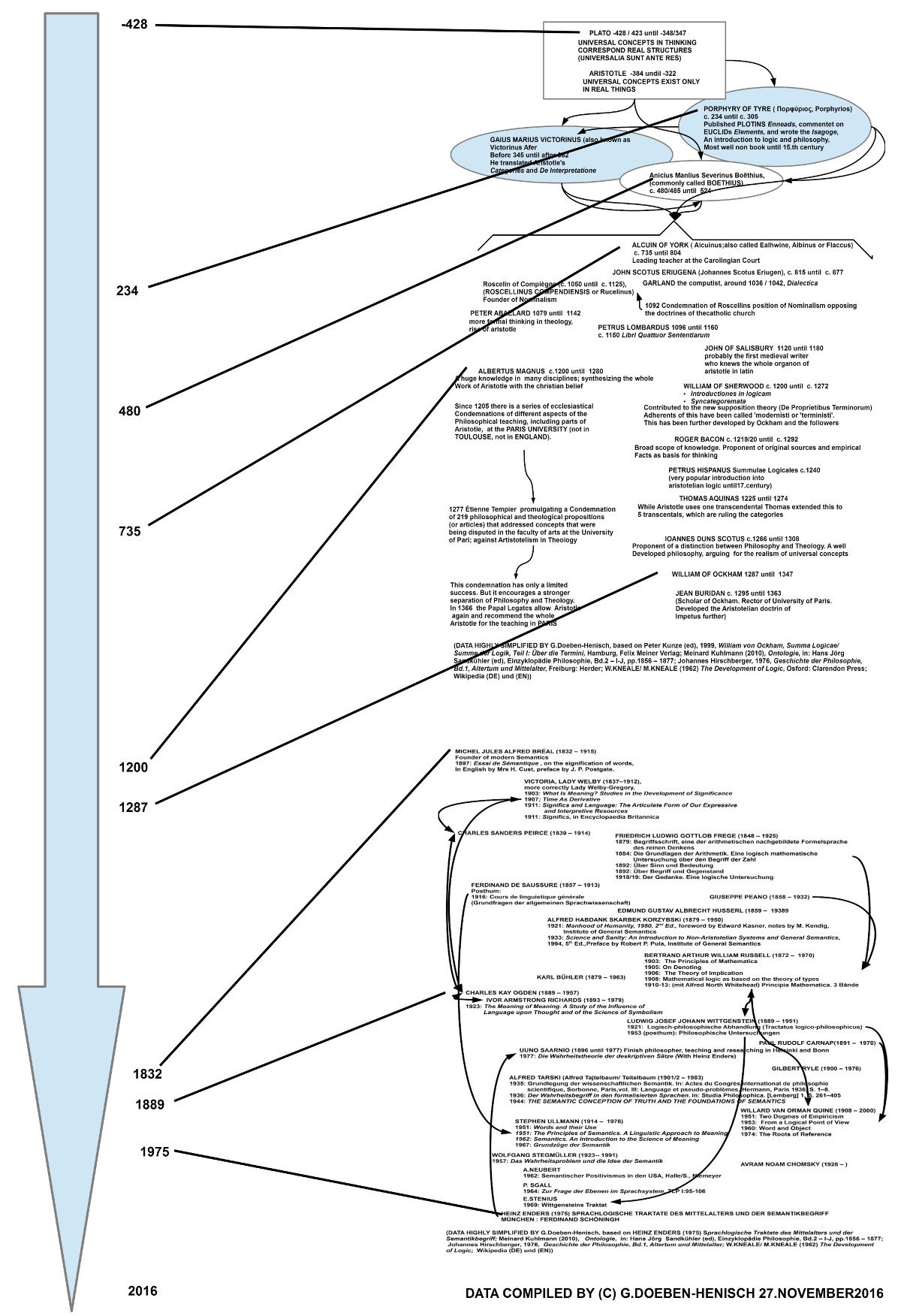

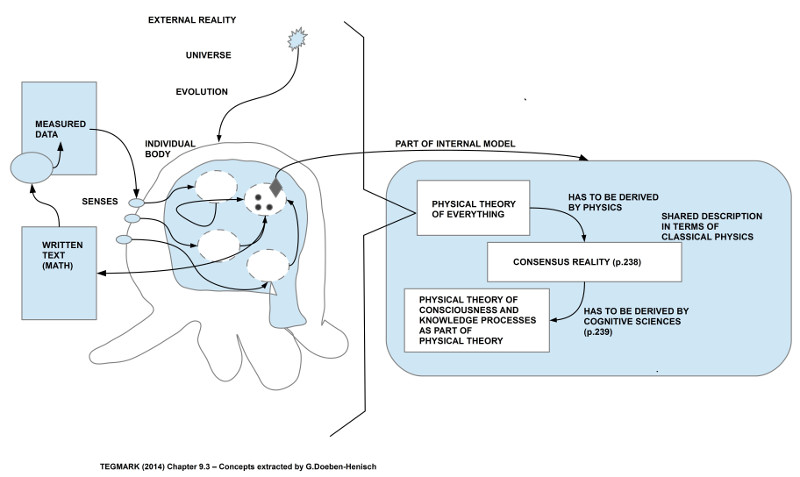

Bild 1

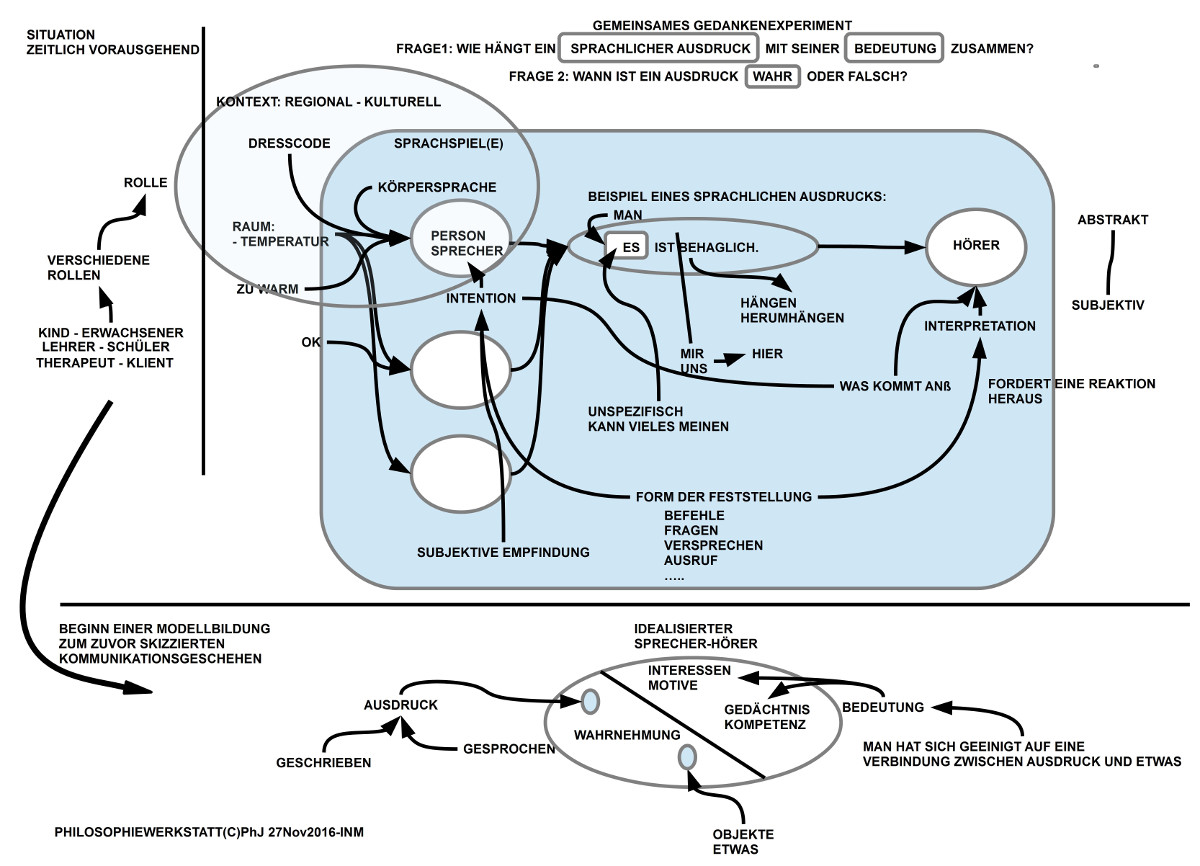

Bild 1 Bild 2

Bild 2