Autor: Gerd Doeben-Henisch

Zeit: 26.Dez 2023 – 8.Jan 2024, 09:45h

Email: gerd@doeben-henisch.de

ENGLISCH: Es entsteht parallel eine Englische Version dieses Blog-Eintrags mit verändertem Titel „There exists only one big Problem for the Future of Human Mankind: The Belief in false Narratives“. Gegenüber dem Deutschen Original ist der Englische Text leicht revidiert.

Dieser Blogeintrag wird heute abgeschlossen werden. Er hat jedoch den Grundstein für Überlegungen gelegt, die in einem neuen Blogeintrag (?) weiterverfolgt werden sollen.

(?) Dieser Link führt ins Leere. Dieser Blogeintrag ist nicht mehr auffindbar. Komisch. Eine weitere Fortsetzung gibt es aber HIER.

EINLEITUNG

UNSCHEINBARER ANFANG

Auslöser für den folgenden Text war die Lektüre eines Buches, das 2023 in 3.Aufl vorliegt und welches das Label führt ‚Spiegel Bestseller‘. Ob das Buch wirklich mal auf der Bestseller Liste stand, konnte ich nicht verifizieren, da der Spiegel nur die jeweils aktuellen Liste anzeigt.

Wie auch immer, ich habe begonnen das Buch zu lesen, weil es mir von einer nahestehenden Person geschenkt wurde… Daraus folgt zwar nicht immer, dass ich dies dann auch lese (die Stapel der ‚zu lesenden Bücher‘ sind hoch), in diesem Fall habe ich es aber getan.

Während der Lektüre beschlich mich immer wieder und immer mehr der Verdacht, dass es sich bei diesem Buch um eine klassische Propagandaschrift handelt.

Beim Versuch, mein Konzept von ‚Propaganda‘ so zu präzisieren, dass ich damit klar argumentieren kann, gewann ich den Eindruck, dass mein Verständnis von Propaganda doch etwas unscharf war.

Ich entschied mich daher, mich zum Thema ‚Propaganda‘ weiter einzulesen (die Liste von Quellen unten auf der Seite enthält davon einige Titel). Dabei wurde offenbar, dass der Begriff der ‚Propaganda‘ in der Literatur eine große Bandbreite von Phänomenen anspricht, ohne dass ein ‚klares, konsistentes Konzept‘ sichtbar wird.

Dies war unbefriedigend.

Kann man über ‚Propaganda‘ entweder gar nicht oder nur ‚vage‘ reden?

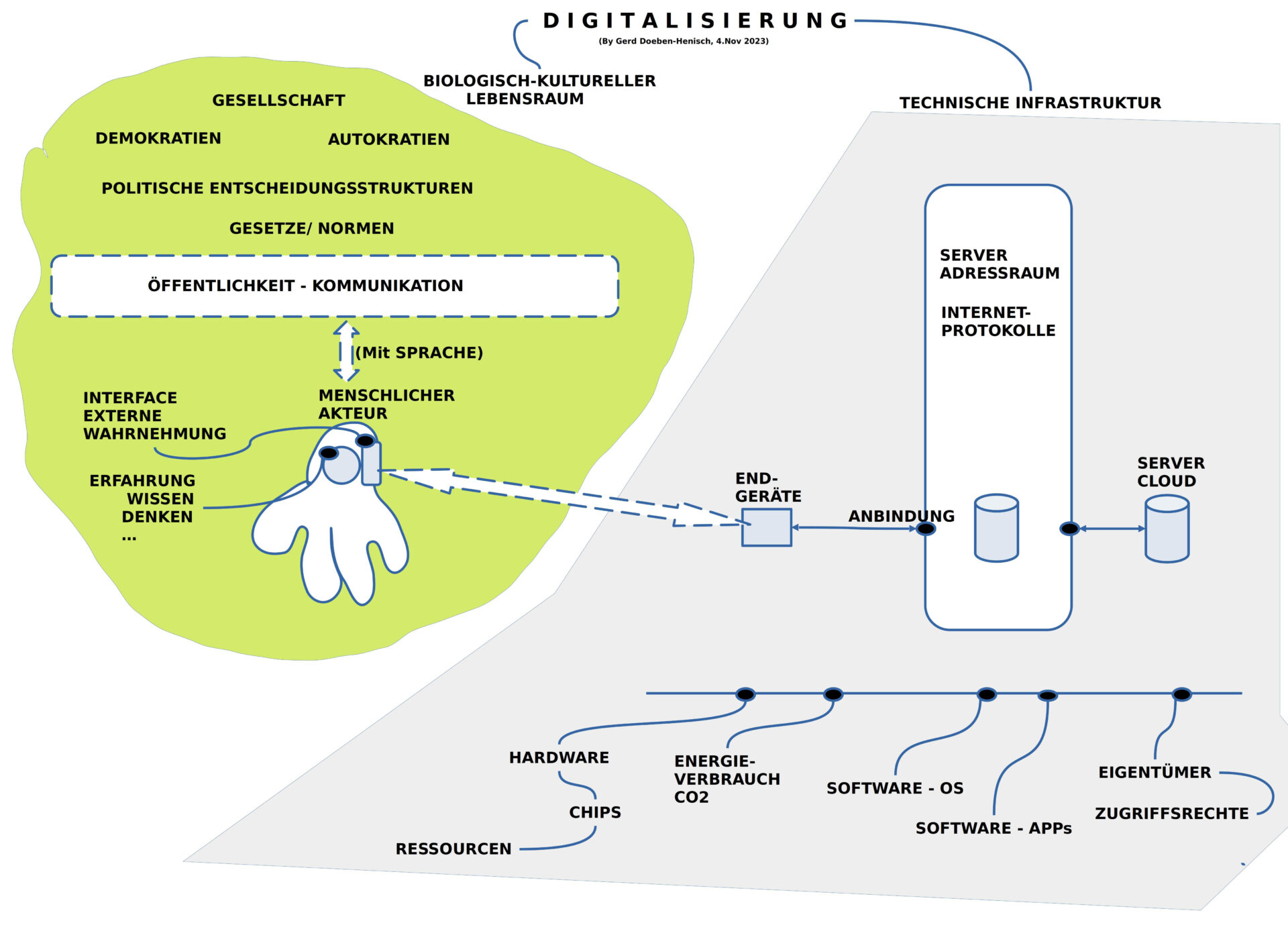

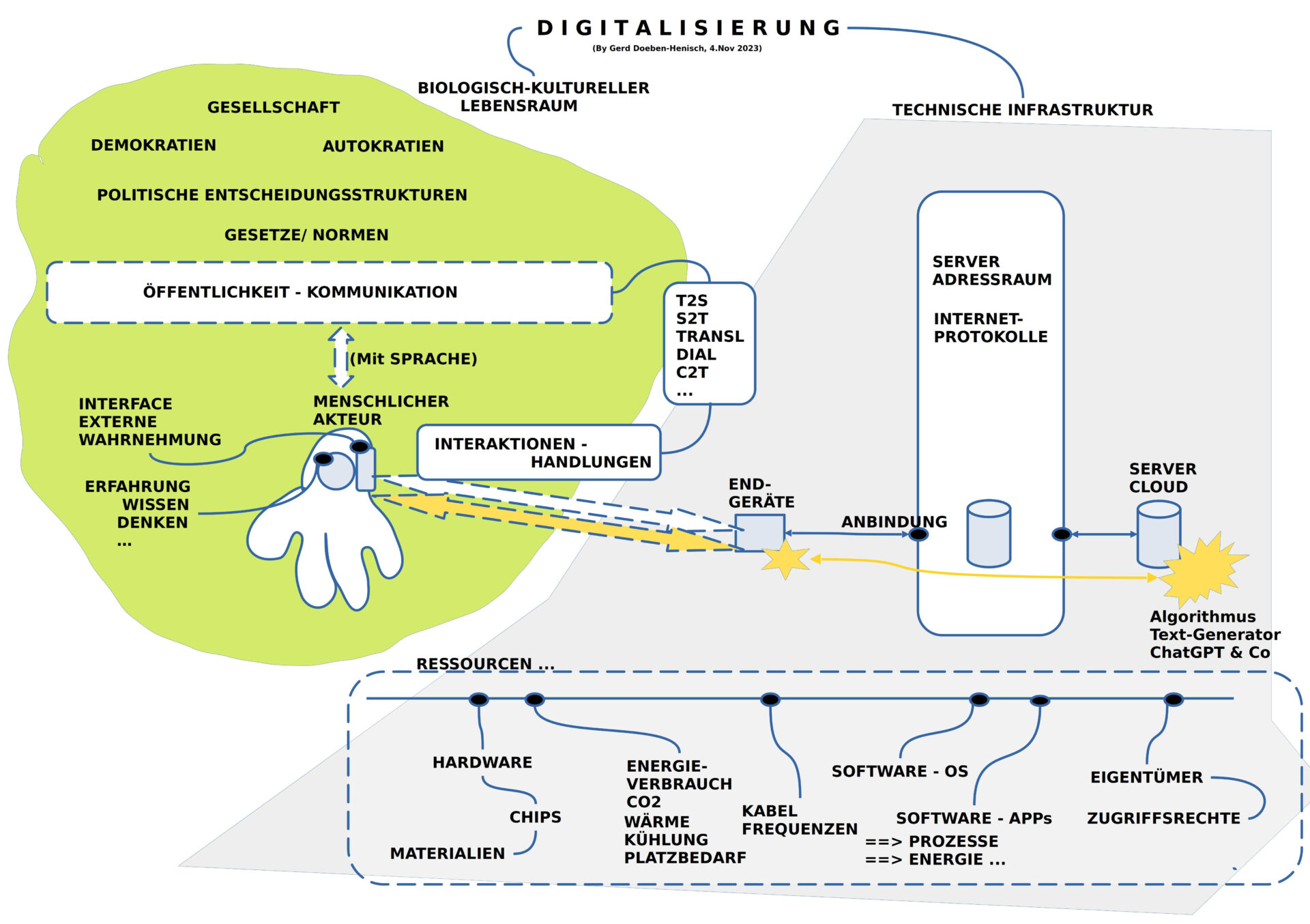

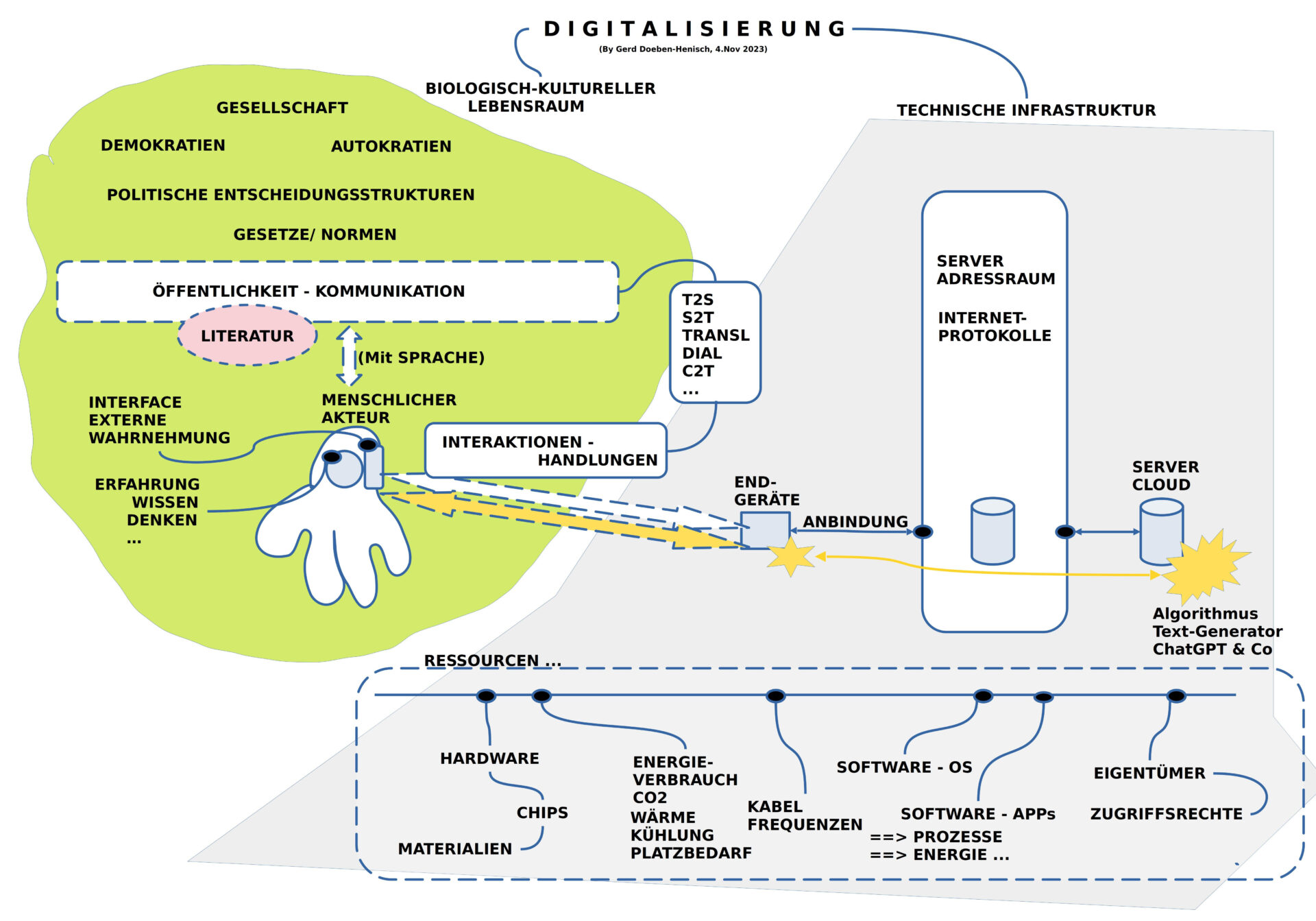

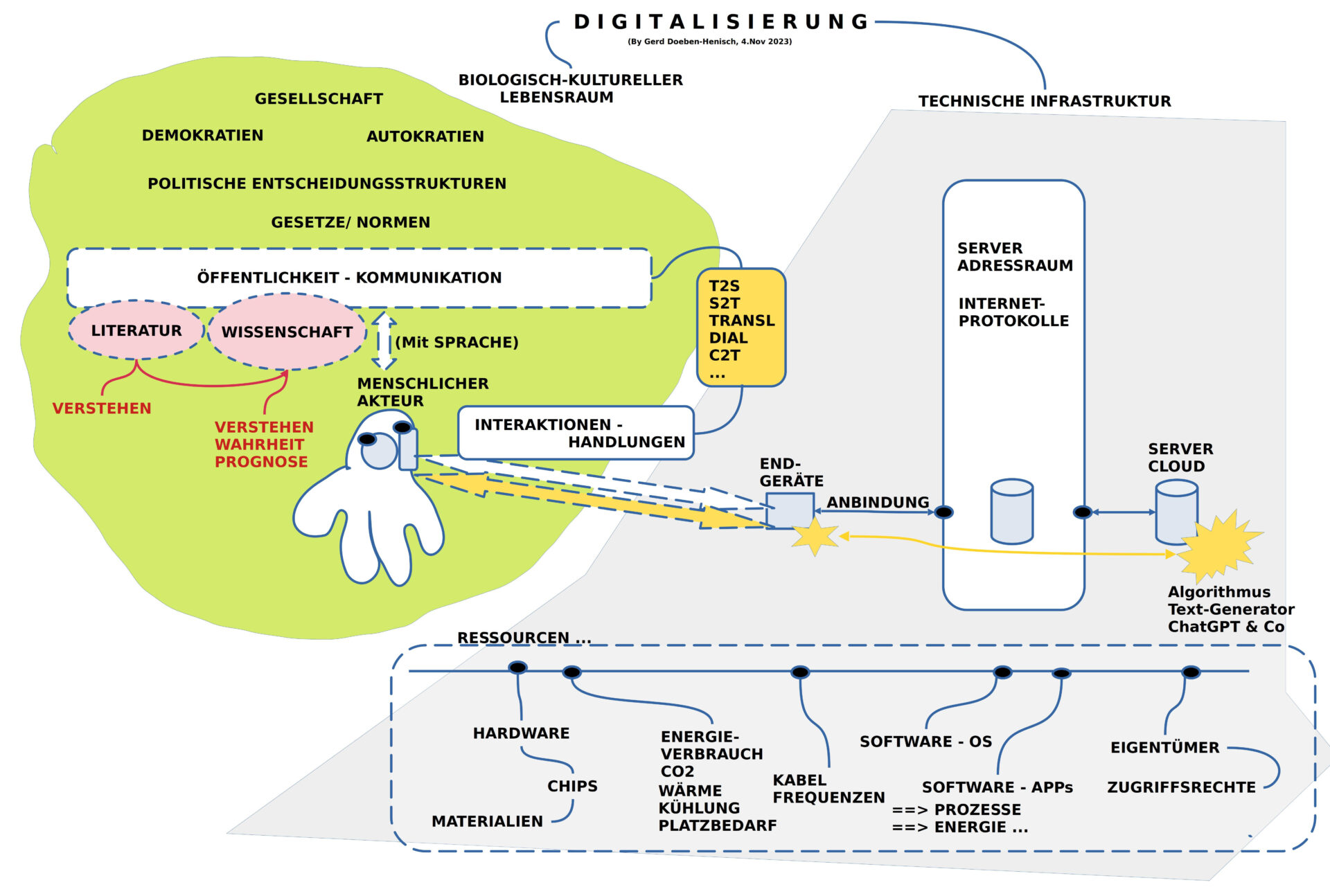

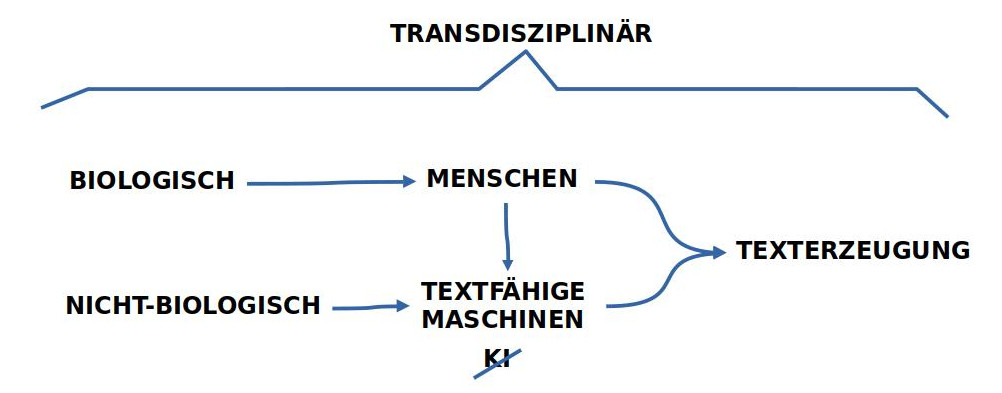

WO WIR JEDEN TAG KOMMUNIZIEREN

Ich entschloss mich daher, mich dem Phänomen der ‚Propaganda‘ so zu nähern, dass ich zunächst versuche, das Phänomen der ‚allgemeinen Kommunikation‘ zu charakterisieren, um ein paar ‚härtere Kriterien‘ zu finden, die es erlauben würden, den Begriff der ‚Propaganda‘ doch einigermaßen verständlich vor diesem allgemeinen Hintergrund abzuheben.

Die Umsetzung dieses Ziels führte dann tatsächlich zu einer immer grundlegenderen Untersuchung unserer normalen (menschlichen) Kommunikation, so dass Formen von Propaganda als ‚Spezialfälle‘ unserer Kommunikation erkennbar werden. Das Beunruhigende daran: auch die sogenannte ’normale Kommunikation‘ umfasst zahlreiche Elemente, die das Erkennen und das Weitergeben von ‚Wahrheit‘ (*) sehr schwer machen können. ‚Massive Fälle von Propaganda‘ haben also ihre ‚Heimat‘ dort, wo wir jeden Tag miteinander kommunizieren. Wenn wir Propaganda verhindern wollen, müssen wir also im Alltag ansetzen.

(*) Der Begriff der ‚Wahrheit‘ wird in dem anschließenden langen Text sehr ausführlich untersucht und erläutert. Leider habe ich dafür noch keine ‚Kurzformel‘ gefunden. Im Kern geht es darum, einen Bezug zu ‚realen‘ Ereignissen und Abläufen in der Welt — einschließlich des eigenen Körpers — so herzustellen, dass sie im Prinzip von anderen nachvollzogen und überprüft werden können.

DIKTATORISCHER KONTEXT

Schwierig wird es allerdings, wenn es genügend viel politische Macht gibt, die die gesellschaftlichen Rahmenbedingungen derart festsetzen kann, dass für den einzelnen Menschen im Alltag — dem Bürger ! — die allgemeine Kommunikation mehr oder weniger vorgeschrieben — ‚diktiert‘ — wird. Dann findet ‚Wahrheit‘ immer weniger bis gar nicht mehr statt. Eine Gesellschaft wird dann durch Unterdrückung von Wahrheit auf ihren eigenen Untergang gleichsam ‚programmiert‘. ([3], [6]).

ALLTAG ALS DIKTATOR ?

Die Stunde der Narrative

Aber — und dies ist die weit gefährlichere Form von ‚Propaganda‘ ! — auch wenn es nicht einen flächendeckenden Machtapparat gibt, der bestimmte Formen von ‚Wahrheit‘ vorschreibt, kann eine Verstümmelung oder eine grobe Verzerrung von Wahrheit dennoch im großen Stil stattfinden. Weltweit können wir heute im Zeitalter von Massenmedien, insbesondere im Zeitalter des Internets, feststellen, dass einzelne Menschen, kleine Gruppen, spezielle Organisationen, politische Gruppierungen, ganze Religionsgemeinschaften, eigentliche alle Menschen und ihre gesellschaftlichen Ausprägungen, einem bestimmten ‚Narrativ‘ [*11] folgen, wenn sie handeln. Typisch für das Handeln nach einem Narrativ ist, dass diejenigen, die dies tun, individuell glauben, dass es ‚ihre eigene Entscheidung‘ ist und dass das Narrativ ‚wahr‘ ist, und dass sie daher ‚im Recht sind‘, wenn sie danach handeln. Dieses sich ‚im Recht fühlen‘, kann bis dahin gehen, dass man für sich das Recht in Anspruch nimmt, andere zu töten, weil sie im Sinne des ‚Narrativ‘ ‚falsch handeln‘. Man sollte hier daher von einer ’narrativen Wahrheit‘ sprechen: Im Rahmen des Narrativs wird ein Bild von der Welt gezeichnet, das ‚als Ganzes‘ eine Perspektive ermöglicht, die von den Anhängern des Narrativ ‚als solche‘ ‚gut gefunden‘ wird, als ‚Sinn stiftend‘. Im Normalfall ist die Wirkung eines Narrativs, was als ‚Sinn stiftend‘ erlebt wird, so groß, dass der ‚Wahrheitsgehalt‘ im einzelnen nicht mehr überprüft wird.

RELIGIÖSE NARRATIVE

In der Geschichte der Menschheit gab es dies zu allen Zeiten. Besonders wirkungsvoll waren Narrative, die als ‚religiöse Überzeugungen‘ auftraten. Von daher ist es auch kein Zufall, dass fast alle Regierungen der letzten Jahrtausende religiöse Überzeugungen als Staatsdoktrin übernahmen; ein wesentlicher Bestandteil religiöser Überzeugungen ist, dass sie ’nicht beweisbar‘, sprich ’nicht wahrheitsfähig‘ sind. Damit ist ein religiöses Narrativ ein wunderbares Werkzeug in der Hand von Mächtigen, Menschen ohne Androhung von Gewalt für bestimmte Verhaltensweisen zu motivieren.

POPULÄRE NARRATIVE

In den letzten Jahrzehnten erleben wir aber neue, ‚moderne Formen‘ von Narrativen, die nicht als religiöse Erzählungen daher kommen, die aber dennoch eine sehr ähnliche Wirkung entfalten: Menschen empfinden diese Narrative als ‚Sinn stiftend‘ in einer Welt, die für jeden heute immer unübersichtlicher und daher bedrohlich wird. Einzelne Menschen, die Bürger, empfinden sich zudem als ‚politische hilflos‘, so dass sie — selbst in einer ‚Demokratie‘ — das Gefühl haben, nichts direkt bewirken zu können: die ‚da oben‘ machen doch, was sie wollen. In einer solchen Situation sind ‚vereinfachende Erzählungen‘ eine Wohltat für die geschundene Seele; man hört sie und hat das Gefühl: ja, so ist es; das ist genau das, was ich ‚fühle‘! Solche ‚populären Narrative‘, die ‚gute Gefühle‘ ermöglichen, gewinnen eine immer größere Kraft. Mit religiösen Narrativen haben sie gemeinsam, dass die ‚Anhänger‘ von populären Narrativen die ‚Wahrheitsfrage‘ nicht mehr stellen; die meisten sind auch nicht genügend ‚trainiert‘, um den Wahrheitsgehalts eines Narrativs überhaupt klären zu können. Typisch für Anhänger von Narrativen ist, dass sie in der Regel individuell kaum in der Lage sind, ihr eigenes Narrativ anderen zu erklären. Man schickt sich typischerweise Links von Texten/ Videos, die man ‚gut‘ findet, weil diese Texte/ Videos irgendwie das populäre Narrativ zu unterstützen scheinen, und überprüft die Autoren und Quellen eher nicht, weil dies doch so ‚anständige Leute‘ sind, weil sie immer genau das Gleiche sagen, wie es das ‚populäre Narrativ‘ vorgibt.(Schönes Beispiel: [10])

FÜR DIE MACHT SIND NARRATIVE SEXY

Wenn man jetzt noch berücksichtigt, dass die ‚Welt der Narrative‘ für alle, die Macht über Menschen haben oder gerne Macht über Menschen erringen wollen, ein äußerst verlockendes Angebot ist, genau solche Narrative ‚in die Welt zu setzen‘ oder bestehende Narrative ‚für sich zu instrumentalisieren‘, dann darf man sich nicht wundern, dass viele Regierungen in dieser Welt, viele andere Machtgruppen, heute genau dies tun: sie versuchen nicht Menschen ‚direkt‘ zu zwingen, sondern sie ‚produzieren‘ populäre Narrative oder ‚Monitoren‘ schon bestehende populäre Narrative‘, um über den Umweg über diese Narrative Macht über die Herzen und den Verstand von immer mehr Menschen zu bekommen. Die einen sprechen hier von ‚hybrider Kriegführung‘, andere von ‚moderner Propaganda‘, aber letztlich geht dies am Kern des Problems vorbei.

DAS NARRATIV ALS KULTURELLES GRUNDMUSTER

Das ‚Irrationale‘ wehrt sich gegen das ‚Rationale‘

Der Kern des Problems ist die Art und Weise, wie menschliche Gemeinschaften schon immer ihr gemeinsames Handeln organisieren, nämlich durch Narrative; über eine andere Möglichkeit verfügen wir Menschen nicht. Solche Narrative — dies zeigen die Überlegungen weiter unten im Text — sind aber hoch komplex und extrem anfällig für ‚Falschheit‘, für eine ‚Verzerrung des Bildes von der Welt‘. Im Rahmen der Entwicklung von Rechtssystemen wurden Ansätze entwickelt, um den Missbrauch von Macht in einer Gesellschaft durch Unterstützung von wahrheitserhaltenden Mechanismen zu ‚verbessern‘. Graduell hat dies sicherlich geholfen, bei allen Defiziten, die bis heute bestehen. Zusätzlich fand vor ca. 500 Jahren eine echte Revolution statt: es gelang der Menschheit, mit dem Konzept eines ‚überprüfbaren Narrativs (empirische Theorie)‘ ein Format zu finden, das den ‚Erhalt von Wahrheit‘ optimiert und das Abgleiten in Unwahrheit minimiert. Dieses neue Konzept von ‚überprüfbarer Wahrheit‘ hat seitdem großartige Einsichten ermöglicht, die ohne dieses neue Konzept jenseits aller Vorstellungen lagen. Die ‚Aura des Wissenschaftlichen‘ hat mittlerweile fast die gesamte menschliche Kultur durchdrungen, fast! Wir müssen konstatieren, dass das wissenschaftliche Denken zwar die Welt des Praktischen durch moderne Technologien umfassend gestaltet hat, dass aber die Art und Weise des wissenschaftlichen Denkens alle anderen Narrative nicht außer Kraft gesetzt hat. Im Gegenteil, die ‚wahrheitsfernen Narrative‘ sind mittlerweile wieder so stark geworden, dass sie in immer mehr Bereichen unserer Welt das ‚Wissenschaftliche‘ zurückdrängen, es bevormunden, es verbieten, es auslöschen. Die ‚Irrationalität‘ der religiösen und populären Narrative ist so stark wie nie zuvor. ‚Irrationale Narrative‘ sind so anziehend, weil sie es dem einzelnen ersparen, selber ’nachdenken zu müssen‘. Echtes Nachdenken ist anstrengend, unpopulär, lästig, behindert den Traum von der einfachen Lösung.

DAS ZENTRALE MENSCHHEITSPROBLEM

Vor diesem Hintergrund erscheint die weit verbreitete Unfähigkeit von Menschen, ‚irrationale Narrative‘ erkennen und überwinden zu können, das zentrale Problem der Menschheit zu sein, um die aktuellen globalen Herausforderungen zu meistern. Bevor wir mehr Technik brauchen (die brauchen wir auf jeden Fall), brauchen wir vor allem mehr Menschen, die fähig und bereit sind, mehr und besser nachzudenken, und auch in der Lage sind, gemeinsam mit anderen ‚echte Probleme‘ zu lösen. Echte Probleme erkennt man darin, dass sie weitgehend ’neu‘ sind, dass es keine ‚einfachen Lösungen von der Stange‘ für sie gibt, dass man gemeinsam wirklich um mögliche Einsichten ‚ringen muss‘; das ‚Alte‘ reicht‘ prinzipiell nicht, um das ‚wahre Neue‘ zu erkennen und umzusetzen!

Der folgende Text untersucht diese hier dargestellte Sicht im Detail.

MODERNE PROPAGANDA ?

Im Beitrag der Englischen Wikipedia zu ‚Propaganda [1b] wird eine ganz ähnliche Strategie versucht, wenn auch in der Ausführung mit nicht ganz scharfen Konturen. Es findet sich dort aber ein breiter Überblick über verschiedenste Formen von Kommunikation, eingebettet darin jene Formen, die ’speziell‘ (‚biased‘) sind, also den zu kommunizierenden Inhalt nicht so wiedergeben, wie man ihn nach ‚objektiven überprüfbaren Kriterien‘ wiedergeben würde. Die Vielfalt der Beispiele deutet aber an, dass es nicht ganz einfach zu sein scheint, eine ’spezielle‘ von einer ’normalen‘ Kommunikation abzugrenzen: Was sind denn diese ‚objektiven überprüfbaren Kriterien‘? Wer legt sie fest?

Nehmen wir für einen Moment mal an, dass es klar sei, welches dies ‚objektiven überprüfbaren Kriterien‘ sind, kann man versuchsweise für einen Ausgangspunkt eine Arbeitsdefinition für den allgemeinen (normalen?) Fall von Kommunikation versuchen:

- Den allgemeinen Fall von Kommunikation könnte man versuchsweise beschreiben als schlichten Versuch, dass eine Person — nennen wir sie den ‚Autor‘ — einer anderen Person — nennen wir sie den ‚Ansprechpartner‘ — versucht, ‚etwas zur Kenntnis zu bringen‘. Das, was zur Kenntnis gebracht werden soll, nennen wir versuchsweise ‚die Botschaft‘. Aus dem Alltag wissen wir, dass ein Autor zahlreiche ‚Eigenschaften‘ aufweisen kann, die sich auf den Inhalt seiner Botschaft auswirken können.

Zum Autor:

- Das verfügbare Wissen des Autors — bewusst wie unbewusst — entscheidet darüber, welche Botschaft der Autor überhaupt erstellen kann.

- Seine Wahrheitsfähigkeit entscheidet darüber, ob und in welchem Umfang er unterscheiden kann, was an seiner Botschaft in der realen Welt — gegenwärtig oder vergangen — nachprüfbar ‚zutrifft‘ bzw. ‚wahr ist‘.

- Seine Sprachfähigkeit bestimmt darüber, ob und wie viel er von seinem verfügbaren Wissen sprachlich kommunizieren kann.

- Die Welt der Emotionen entscheidet darüber, ob er z.B. überhaupt etwas mitteilen möchte, wann, wie, wem, wie intensiv, wie auffällig, usw.

- Der gesellschaftliche Kontext kann sich dahingehend auswirken, ob er eine bestimmte gesellschaftliche Rolle innehat, für die festgelegt ist, wann er wie mit wem was kommunizieren darf oder sollte.

- Die realen Kommunikationsbedingungen entscheiden darüber, ob ein geeignetes ‚Kommunikationsmedium‘ verfügbar ist (Sprachschall, Schrift, Ton, Film, …) und ob und wie dieses für potentielle Ansprechpartner zugänglich ist.

- Die körperliche Beschaffenheit entscheidet darüber, wie weit der Autor überhaupt und in welchem Umfang er kommunizieren kann.

Zum Ansprechpartner:

- Ganz allgemein gelten die Eigenschaften für den Autor auch für den Ansprechpartner. Man kann aber für die Rolle des Ansprechpartners einige Punkte besonders hervorheben:

- Das verfügbare Wissen des Ansprechpartners entscheidet darüber, welche Aspekte der Botschaft des Autors überhaupt verstanden werden können.

- Die Wahrheitsfähigkeit des Ansprechpartners entscheidet darüber, ob und in welchem Umfang auch dieser unterscheiden kann, was an der übermittelten Botschaft nachprüfbar ‚zutrifft‘ bzw. ‚wahr ist‘.

- Die Sprachfähigkeit des Ansprechpartners bedingt, ob und wie viel er von der Botschaft rein sprachlich aufnehmen kann.

- Die Emotionen entscheiden darüber, ob der Ansprechpartner z.B. überhaupt etwas aufnehmen möchte, wann, wie, wie viel, mit welcher inneren Einstellung, usw.

- Der gesellschaftliche Kontext kann sich ebenfalls dahingehend auswirken, ob der Ansprechpartner eine bestimmte gesellschaftliche Rolle innehat, für die festgelegt ist, wann er wie mit wem was kommunizieren darf oder sollte.

- Ferner kann es wichtig sein, ob das Kommunikationsmedium dem Ansprechpartner so vertraut ist, dass er es hinreichend gut nutzen kann.

- Auch bei dem Ansprechpartner kann die körperliche Beschaffenheit darüber entscheiden, wie weit der Ansprechpartner überhaupt und in welchem Umfang kommunizieren kann.

Schon diese kleine Auswahl an Faktoren zeigt, wie vielfältig die Situationen sein können, in denen ’normale Kommunikation‘ durch die ‚Wirkung der verschiedenen Umstände‘ einen ’speziellen Charakter‘ gewinnen kann. So kann z.B. eine eigentlich ‚harmlose Begrüßung‘ bei bestimmten Rollenvorgaben zu einem gesellschaftlichen Problem führen mit vielerlei Konsequenzen. Ein scheinbar ’normaler Bericht‘ kann zum Problem werden, weil der Ansprechpartner die Botschaft rein sprachlich missversteht. Ein an sich ’sachlicher Bericht‘ kann durch die Art und Weise des Vortrags zu emotionalen Wirkungen bei dem Ansprechpartner führen, die dazu führen, dass dieser die Botschaft geradezu begeistert aufgreift oder — ganz im Gegenteil — vehement ablehnt. usw.

Liegen handfeste Interessen beim Autor vor, aufgrund deren er den Ansprechpartner zu einer bestimmten Verhaltensweise bewegen will, dann kann dies dazu führen, dass ein bestimmter Sachverhalt nicht ‚rein sachlich‘ dargestellt wird, sondern es werden dann auch viele Aspekte mitkommuniziert, die dem Autor geeignet erscheinen, den Ansprechpartner dazu zu bewegen, den Sachverhalt in einer ganz bestimmten Weise aufzufassen und entsprechend sich zu eigen machen. Diese ‚zusätzlichen‘ Aspekte können sich über die reine Botschaft hinaus auf viele reale Gegebenheiten der Kommunikationssituation beziehen.

Typen von Kommunikation …

Angesichts dieser potentiellen ‚Vielfalt‘ stellt sich die Frage, ob es überhaupt möglich sein wird, so etwas wie eine normale Kommunikation zu definieren?

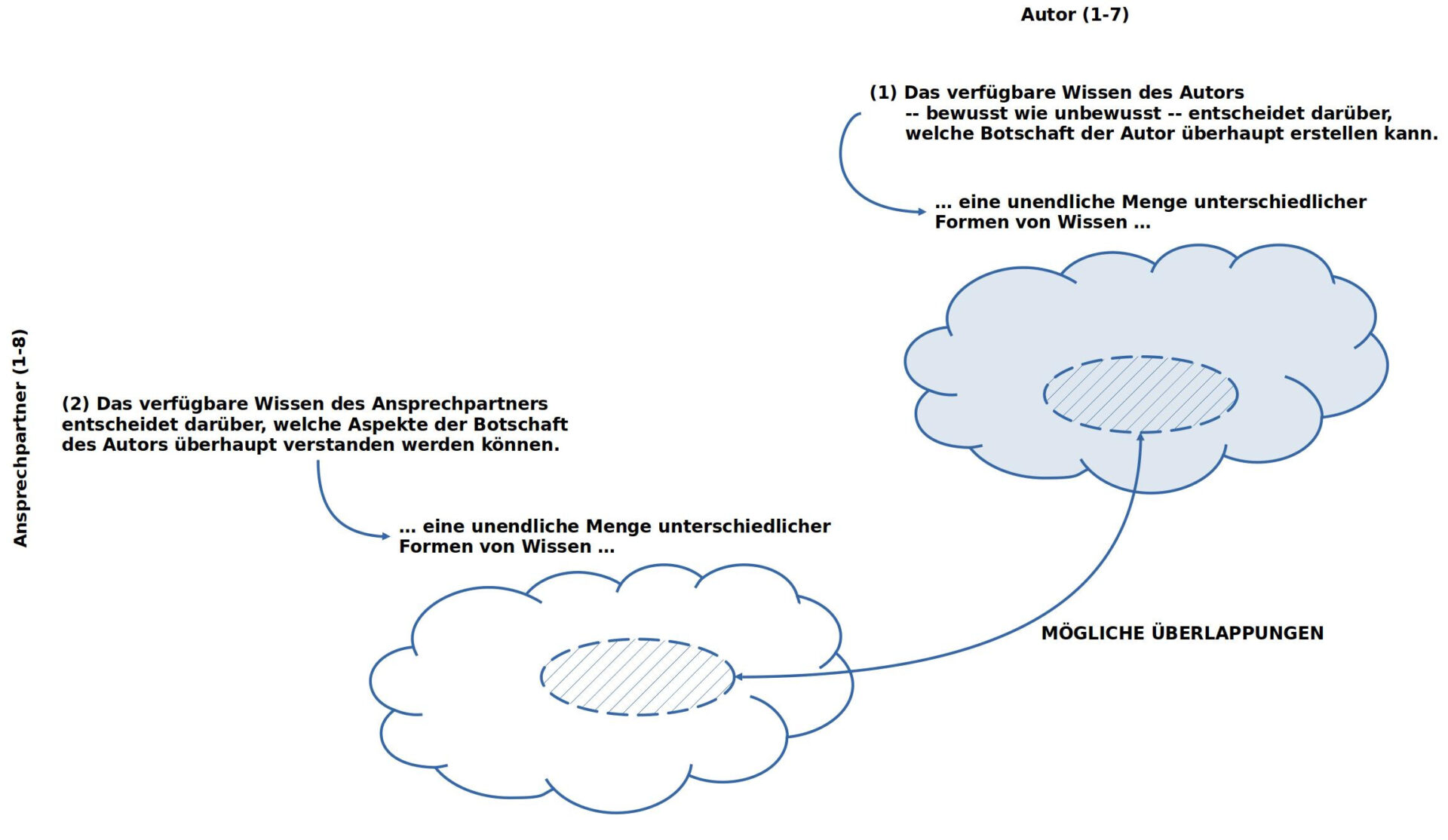

Um diese Frage sinnvoll beantworten zu können, müsste man über eine Art ‚Überblick‘ über alle möglichen Kombinationen von Eigenschaften Autor (1-7) sowie Ansprechpartner (1-8) verfügen und man müsste zusätzlich in der Lage sein, jede dieser möglichen Kombinationen mit Blick auf ‚Normalität‘ zu bewerten.

Dazu sei angemerkt, dass den beiden Listen Autor (1-7) und Ansprechpartner (1-8) ein gewisse ‚Willkür‘ anheftet: Man kann die Listen so aufbauen, wie sie hier aufgebaut wurden, man muss aber nicht.

Dies hängt mit der allgemeinen Art und Weise zusammen, wir wir Menschen denken: auf der einen Seite haben wir ‚einzelne Ereignisse, die passieren‘ — oder an die wir uns ‚erinnern‘ können –, auf der anderen Seite können wir zwischen ‚beliebigen einzelnen Ereignissen‘ ‚beliebige Beziehungen‘ in unserem Denken ’setzen‘. In der Wissenschaft nennt man dies ‚Hypothesenbildung‘. Ob man solche Bildung von Hypothesen vornimmt oder nicht und welche, dies ist nirgends normiert. Ereignisse als solche erzwingen keine bestimmte Hypothesenbildungen. Ob sie ’sinnvoll‘ sind oder nicht erweist sich ausschließlich im späteren Verlauf bei ihrer ‚praktischen Verwendung‘. Man könnte sogar sagen, dass eine solche Hypothesenbildung eine rudimentäre Form von ‚Ethik‘ ist: in dem Moment, wo man eine Hypothese bzgl. einer bestimmten Beziehung zwischen Ereignissen annimmt, hält man sie minimal für ‚wichtig‘, ansonsten würde man diese Hypothesenbildung nicht vornehmen.

Insofern kann man sagen, dass der ‚Alltag‘ der primäre Ort ist für mögliche Arbeitshypothesen und mögliche ‚minimale Werte‘.

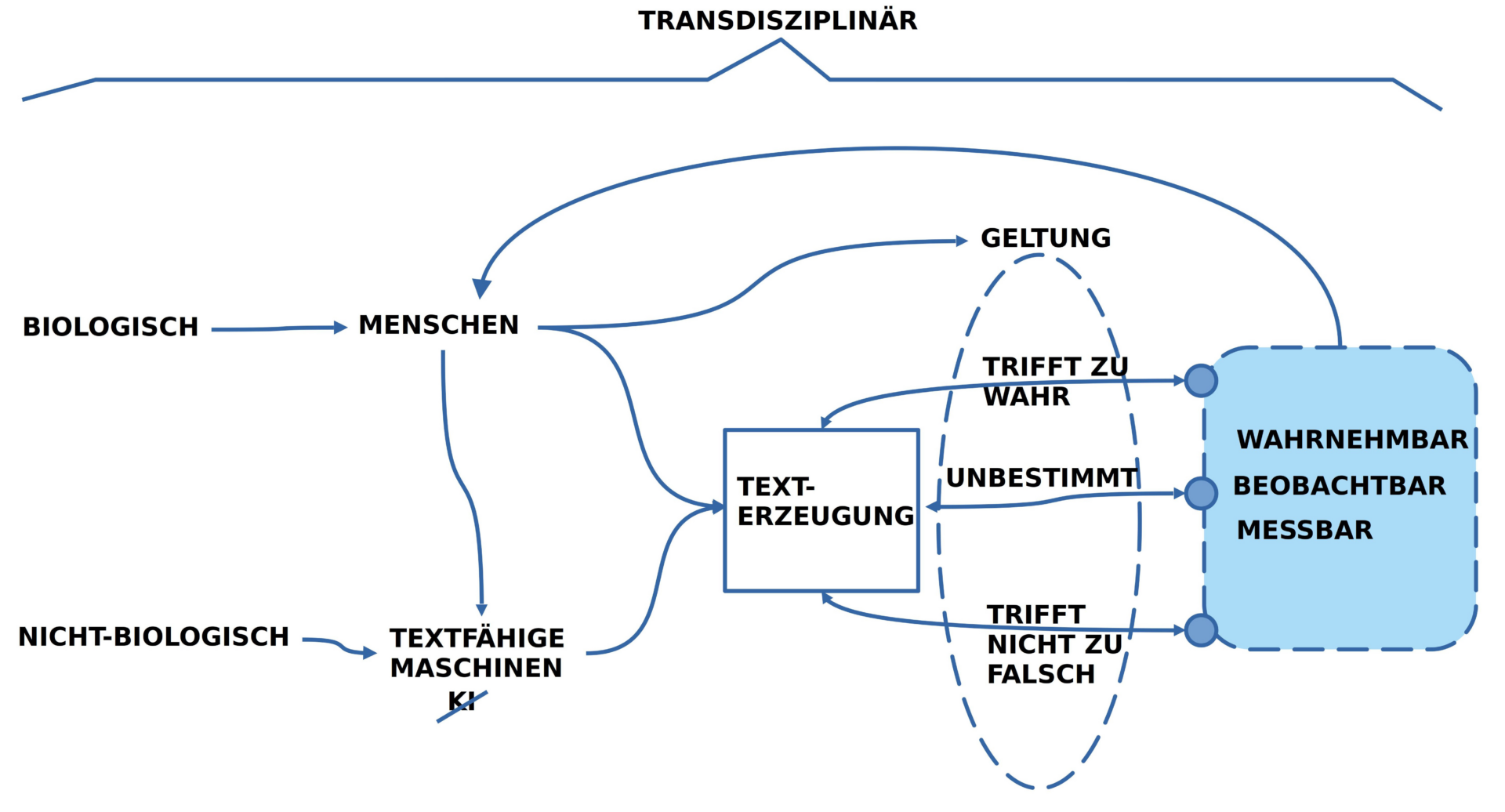

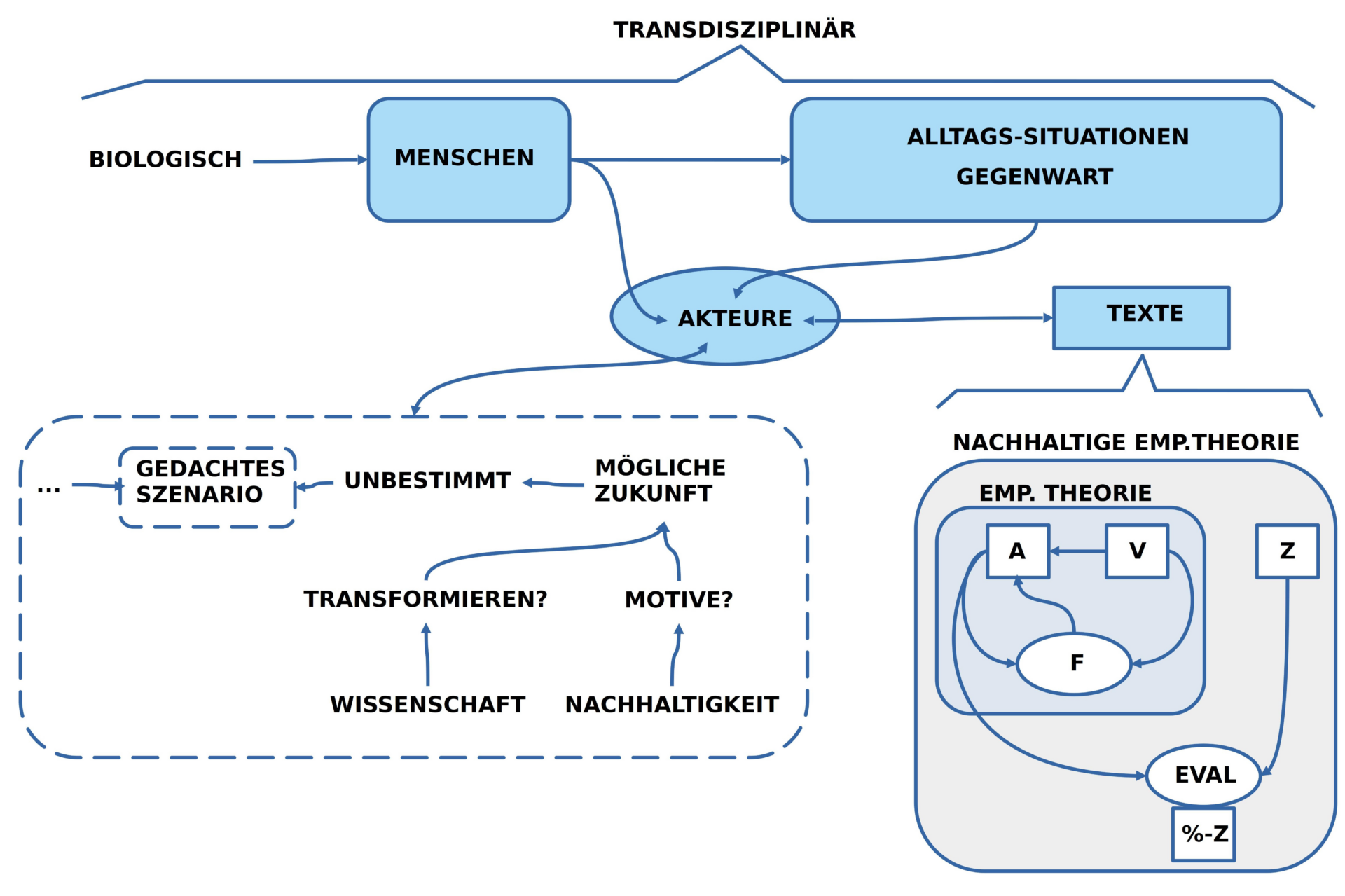

Das folgende Schaubild demonstriert eine mögliche Anordnung der Eigenschaften vom Autor und seinem Ansprechpartner:

BILD : Mögliche Verschränkung von Eigenschaft 1 des Autors — hier: Au1 — und Eigenschaft 2 des Ansprechpartners — hier: An2 –.

Was man unschwer erkennen kann, ist die Tatsache, dass ein Autor natürlich über eine Konstellation von Wissen verfügen kann, die aus einer schier ‚unendlichen Menge von Möglichkeiten‘ schöpft. Das gleiche gilt für den Ansprechpartner. Rein abstrakt ist die Anzahl der möglichen Kombinationen aufgrund der Annahmen Au1 und An2 vom Ansatz her ‚quasi unendlich groß‘, was die Frage nach der ‚Normalität‘ auf der abstrakten Ebene letztlich unentscheidbar macht.

Da aber sowohl Autoren wie Ansprechpartner keine sphärische Wesen aus irgendeinem abstrakten Winkel der Möglichkeiten sind, sondern in der Regel ‚konkrete Menschen‘ mit einer ‚konkreten Geschichte‘ in einer ‚konkreten Lebenswelt‘ zu einer ‚bestimmten historischen Zeit‘ schränkt sich der quasi unendliche abstrakte Möglichkeitsraum ein auf eine endliche überschaubare Menge von Konkretheiten. Doch auch diese können bezogen auf zwei konkrete Menschen immer noch beträchtlich groß sein. Welcher Mensch mit seiner Lebenserfahrung aus welcher Gegend soll jetzt als ‚Norm‘ genommen werden für eine ’normale Kommunikation‘?

Eher scheint es nahe zu liegen, dass man einzelne Menschen irgendwie ‚typisiert‘ z.B. nach Alter und Lerngeschichte, wobei eine ‚Lerngeschichte‘ auch kein klares Bild ergeben muss. Absolventen der gleichen Schule können im Anschluss — wie wir wissen — über ein sehr unterschiedliches Wissen verfügen, wenngleich Gemeinsamkeiten möglicherweise ‚minimal typisch‘ sein können.

Generell erscheint also der Ansatz über die Eigenschaften des Autors und des Ansprechpartners keine wirklich klaren Kriterien für eine Norm zu liefern, auch wenn eine Angabe wie ‚das humanistische Gymnasium in Hadamar 1960 – 1968‘ rudimentäre Gemeinsamkeiten nahelegen würde.

Man könnte jetzt versuchen, die weiteren Eigenschaften Au2-7 sowie An3-8 in die Überlegungen einzubeziehen, aber die ‚Konstruktion einer normalen Kommunikation‘ scheint aufgrund der Annahmen Au1 und An2 eher in immer weitere Ferne zu rücken.

Was bedeutet dies für die Typisierung einer Kommunikation als ‚Propaganda‘. Ist nicht letztlich jede Kommunikation auch ein Stück Propaganda oder gibt es doch die Möglichkeit, die Form der ‚Propaganda‘ hinreichend genau zu kennzeichnen obwohl es nicht möglich erscheint, einen Standard für ’normale Kommunikation‘ zu finden. … oder wird eine bessere Charakterisierung von ‚Propaganda‘ indirekt Hinweise für eine ‚Nicht-Propaganda‘ liefern?

Wahrheit und Bedeutung – Schlüssel ‚Sprache‘

Der spontane Versuch, die Bedeutung des Begriffs ‚Propaganda‘ soweit zu klären, dass man ein paar konstruktive Kriterien an die Hand bekommt, um bestimmte Formen von Kommunikation entweder als ‚Propaganda‘ charakterisieren zu können oder eben nicht, gerät in immer ‚tieferes Fahrwasser‘. Gibt es nun ‚objektive überprüfbare Kriterien‘, mit denen man arbeiten kann, oder nicht? Und: Wer legt sie fest?

Halten wir vorläufig an der Arbeitshypothese 1 fest, dass wir es mit einem Autor zu tun haben, der eine Botschaft artikuliert, für einen Ansprechpartner, und erweitern wir diese Arbeitshypothese um folgenden Zusatz 1: solche eine Kommunikation spielt sich immer in einem gesellschaftlichen Kontext ab. Dies bedeutet, dass die Wahrnehmung und das Wissen der einzelnen Akteure (Autor, Ansprechpartner) kontinuierlich mit diesem gesellschaftlichen Kontext interagieren kann bzw. ‚automatisch interagiert‘. Letzteres liegt daran, dass wir Menschen so gebaut sind, dass unser Körper mit seinem Gehirn dies einfach tut, ohne dass dafür von ‚uns‘ ‚bewusste Entscheidungen‘ getroffen werden müssen.[*1]

Für diesen Abschnitt möchte ich die bisherige Arbeitshypothese 1 samt Zusatz 1 um eine weitere Arbeitshypothese 2 erweitern (Lokalisierung von Sprache) [*4]:

- Jedes Medium (Sprache, Ton, Bild, …) kann eine ‚potentielle Bedeutung‘ beinhalten.

- Beim Erstellen des medialen Ereignisses kann der ‚Autor‘ versuchen, mögliche ‚Inhalte‘, die von ihm ‚mitgeteilt werden sollen‘, mit dem Medium ‚zu verbinden‘ (‚ins Wort/ in den Klang/ in das Bild bringen‘, ‚Enkodieren‘, ….). Diese ‚Zuordnung‘ von Bedeutung geschieht sowohl ‚unbewusst/ automatisiert‘ als auch ‚(teilweise) bewusst‘.

- Bei der Wahrnehmung des medialen Ereignisses kann der ‚Ansprechpartner‘ versuchen, diesem wahrgenommenen Ereignis eine ‚mögliche Bedeutung‘ zuzuordnen. Auch diese ‚Zuordnung‘ von Bedeutung geschieht sowohl ‚unbewusst/ automatisiert‘ als auch ‚(teilweise) bewusst‘.

- Die Zuordnung von Bedeutung setzt sowohl beim Autor wie auch beim Ansprechpartner voraus, dass der jeweilige Akteur ‚Lernprozesse‘ (meist Jahre, viele Jahre) ‚durchlaufen‘ hat, die es möglich gemacht haben, bestimmte ‚Ereignisse der Außenwelt‘ wie auch ‚innere Zustände‘ mit bestimmten medialen Ereignissen zu verknüpfen.

- Das ‚Erlernen von Bedeutungsbeziehungen‘ geschieht immer in gesellschaftlichen Kontexten, da eine mediale Struktur, die zwischen Menschen ‚Bedeutung transportieren‘ soll, immer allen gehört, die an dem Kommunikationsprozess beteiligt sind.[*2]

- Diejenigen medialen Elemente, die für den ‚Austausch von Bedeutungen‘ tatsächlich benutzt werden, bilden alle zusammen das, was man eine ‚Sprache‘ nennt: die ‚medialen Elemente selbst‘ bilden die ‚Oberflächenstruktur‘ der Sprache, ihre ‚Zeichendimension‘, und die ‚inneren Zustände‘ in jedem beteiligten ‚Akteur‘, bilden den ‚individuell-subjektiven Raum möglicher Bedeutungen‘. Dieser innere subjektive Raum umfasst zwei Komponenten: (i) die innerlich verfügbaren Elemente als potentielle Bedeutungsinhalte und (ii) eine dynamische ‚Bedeutungsbeziehung‘, die wahrgenommene Elemente der Oberflächenstruktur und der potentiellen Bedeutungsinhalte ‚miteinander verknüpft‘.[*3]

Will man die Leitfrage, ob man „bestimmte Formen von Kommunikation entweder als ‚Propaganda‘ charakterisieren oder nicht“ beantworten, benötigt man ‚objektive überprüfbare Kriterien‘, anhand deren man eine Aussage formulieren kann. Diese Frage kann man benutzen, um zurück zu fragen, ob es im ’normalen Alltagsdialog‘ ‚objektive Kriterien‘ gibt, anhand deren wir im Alltag gemeinsam entscheiden können, ob ein ‚behaupteter Sachverhalt‘ ‚zutrifft‘ oder eben nicht; in diesem Kontext wird auch das Wort ‚wahr‘ benutzt. Kann man dies ein wenig genauer fassen?

Hier eine weitere Arbeitshypothese 3:

- Mindestens zwei Akteure können sich darüber einigen, dass eine bestimmte Bedeutung, verbunden mit dem medialen Konstrukt, als sinnlich wahrnehmbarer Sachverhalt so vorliegt, dass sie zustimmen können, dass der ‚behauptete Sachverhalt‘ tatsächlich vorliegt. Ein solches punktuelles Zutreffen soll ‚wahr 1‘ bzw. ‚Wahrheit 1‘ genannt werden. Ein ‚punktuelles Zutreffen‘ kann sich aufgrund der Dynamik der realen Welt (einschließlich der Akteure selbst) jederzeit und schnell ändern (z.B.: der Regen hört auf, die Kaffeetasse ist leer, das Autor von eben ist weg, der leere Gehweg wir von einer Gruppe von Menschen belegt, ….)

- Mindestens zwei Akteure können sich darüber einigen, dass eine bestimmte Bedeutung, verbunden mit dem medialen Konstrukt, aktuell nicht als realer Sachverhalt vorliegt. Bezogen auf die aktuelle Situation des ‚Nicht-Zutreffens‘ würde man davon sprechen, dass die Aussage ‚falsch 1‘ ist; der behauptete Sachverhalt liegt entgegen der Behauptung real nicht vor.

- Mindestens zwei Akteure können sich darüber einigen, dass eine bestimmte Bedeutung, verbunden mit dem medialen Konstrukt aktuell nicht vorliegt, aber aufgrund des bisherigen Erfahrungswissens ‚ziemlich sicher‘ in einer ‚möglichen zukünftigen Situation‘ eintreten könnte. Dieser Aspekt soll hier ‚potentiell wahr‘ genannt werden oder ‚wahr 2‘ bzw. ‚Wahrheit 2‘. Sollte der Sachverhalt dann irgendwann ‚tatsächlich vorliegen‘ würde sich Wahrheit 2 in Wahrheit 1 verwandeln.

- Mindestens zwei Akteure können sich darüber einigen, dass eine bestimmte Bedeutung, verbunden mit dem medialen Konstrukt aktuell nicht vorliegt, und aufgrund des bisherigen Erfahrungswissens ‚ziemlich sicher unklar ist‘, ob der gemeinte Sachverhalt in einer ‚möglichen zukünftigen Situation‘ tatsächlich eintreten könnte. Dieser Aspekt soll hier ’spekulativ wahr‘ genannt werden oder ‚wahr 3‘ bzw. ‚Wahrheit 3‘. Sollte der Sachverhalt dann irgendwann ‚tatsächlich vorliegen‘ würde sich Wahrheit 3 in Wahrheit 1 verwandeln.

- Mindestens zwei Akteure können sich darüber einigen, dass eine bestimmte Bedeutung, verbunden mit dem medialen Konstrukt aktuell nicht vorliegt, und aufgrund des bisherigen Erfahrungswissens ‚es ziemlich sicher ist‘, dass der gemeinte Sachverhalt in einer ‚möglichen zukünftigen Situation‘ nie eintreten könnte. Dieser Aspekt soll hier ’spekulativ falsch‘ genannt werden oder ‚falsch 2‚.

Bei näherer Betrachtung dieser 4 Annahmen der Arbeitshypothese 3 wird man feststellen können, dass es in all diesen Unterscheidungen zwei ‚Pole‘ gibt, die zueinander in bestimmten Beziehungen stehen: einerseits gibt es als Pole reale Sachverhalte, die ‚aktuell von allen Beteiligten wahrgenommen bzw. nicht wahrgenommen werden‘ und andererseits gibt es eine ‚gewusste Bedeutung‘ in den Köpfen der Beteiligten, die mit einem aktuellen Sachverhalt in Beziehung gesetzt werden kann oder nicht. Dies ergibt folgende Verteilung von Werten:

| Realer Sachverhalt | Beziehung zu Gedacht | |

| Gegeben | 1 | Passt (wahr 1) |

| Gegeben | 2 | Passt nicht (falsch 1) |

| Nicht gegeben | 3 | Könnte in der Zukunft passen (wahr 2) |

| Nicht gegeben | 4 | Passen in der Zukunft unklar (wahr 3) |

| Nicht gegeben | 5 | Kann in der Zukunft nicht passen (falsch 2) |

In diesem — noch etwas grobem — Schema kann ‚Gedachtes‘ qualifiziert werden zu einem aktuell Gegebenem als ‚passend‘ oder ’nicht passend‘, oder in Abwesenheit von etwas real Gegebenem als ‚könnte passen‘ oder ‚unklar, ob es passen kann‘ oder ’sicher, dass es nicht passen könnte‘.

Hierbei ist aber zu beachten, dass diese Qualifizierungen ‚Einschätzungen‘ sind, welche die Akteure aufgrund ihres ‚eigenen Wissens‘ vornehmen. Wie wir wissen, ist solch eine Einschätzung immer fehleranfällig! Neben Fehlern in der Wahrnehmung [*5] kann es Fehlern im eigenen Wissen geben. [*6] Also entgegen den Überzeugungen der Akteure kann ‚wahr 1‘ tatsächlich ‚falsch 1‘ sein oder umgekehrt, ‚wahr 2‘ könnte ‚falsch 2‘ sein und umgekehrt.

Aus all diesem folgt, dass eine ‚klare Qualifizierung‘ von Wahrheit und Falschheit letztlich immer fehlerbehaftet ist. Für eine Gemeinschaft von Menschen, die ‚positiv‘ denken ist dies kein Problem: sie wissen um diese Sachlage und sie bemühen sich, ihre ’natürliche Fehleranfälligkeit‘ durch bewusstes methodisches Vorgehen ‚möglichst klein‘ zu halten.[*7] Menschen, die — aus vielerlei Gründen — eher negativ denken, die fühlen sich in dieser Situation dazu motiviert, überall und immer nur Fehler oder gar Bosheit zu sehen. Sie tun sich schwer damit, mit ihrer ’natürlichen Fehlerbehaftetheit‘ positiv-konstruktiv umzugehen.

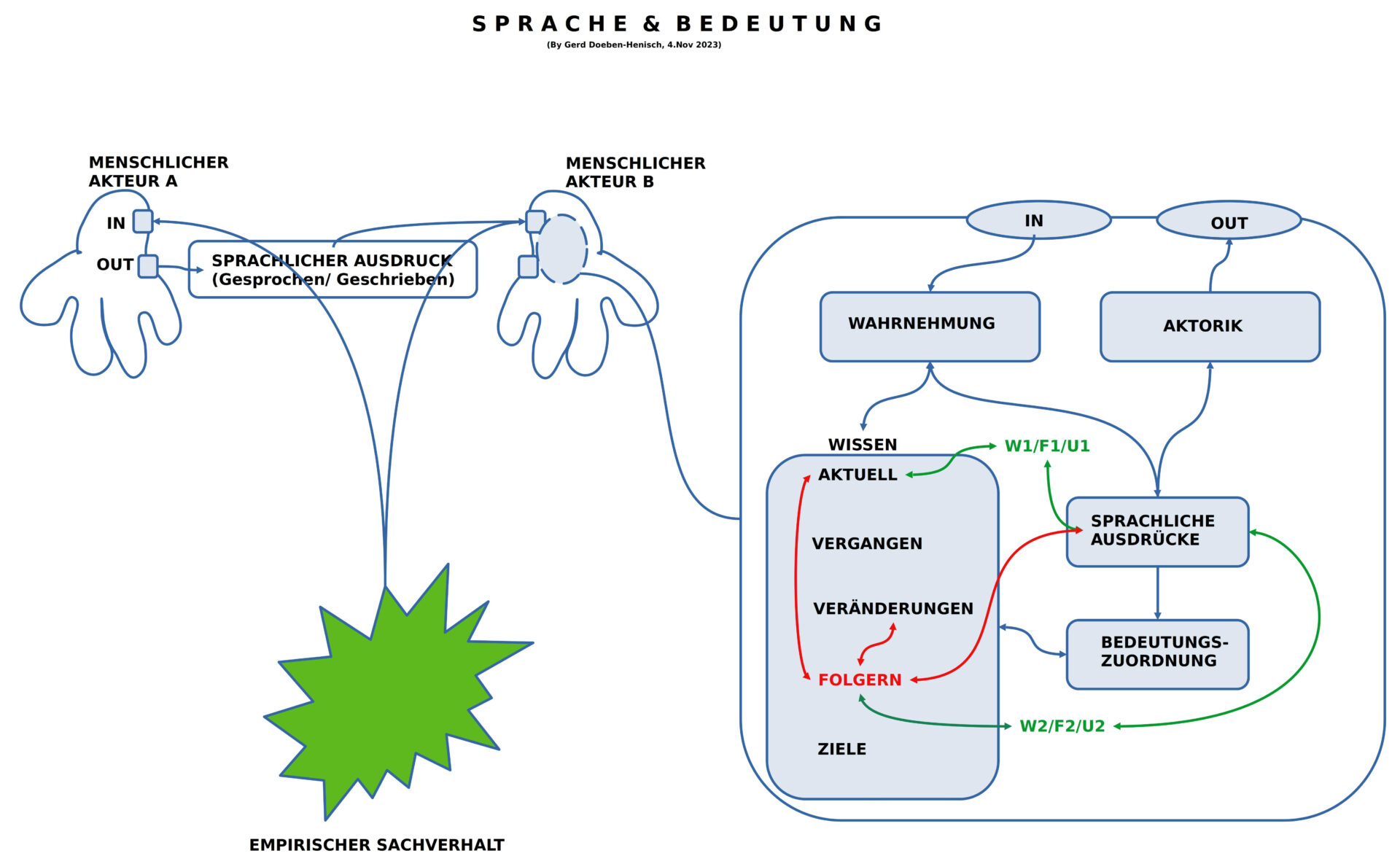

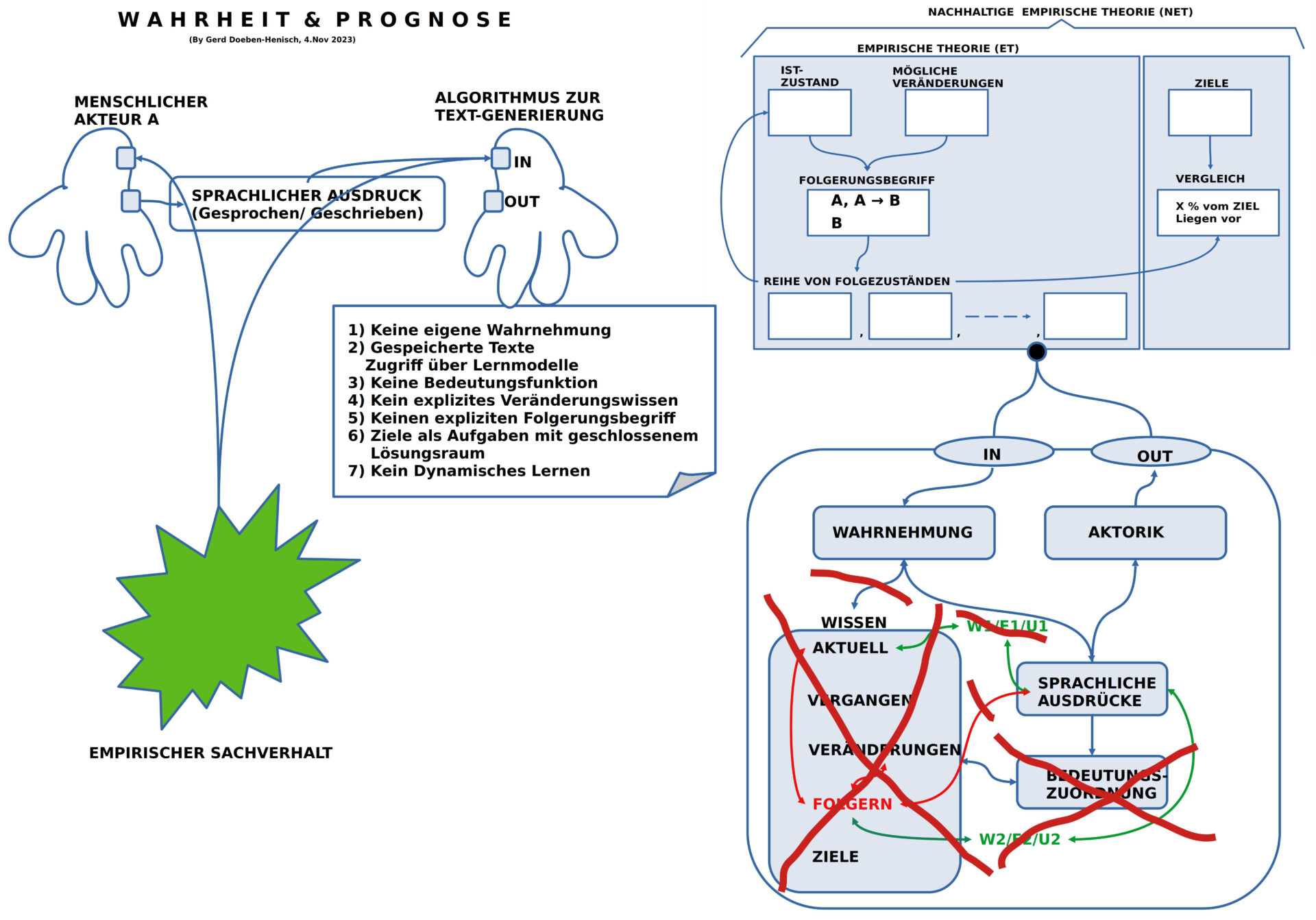

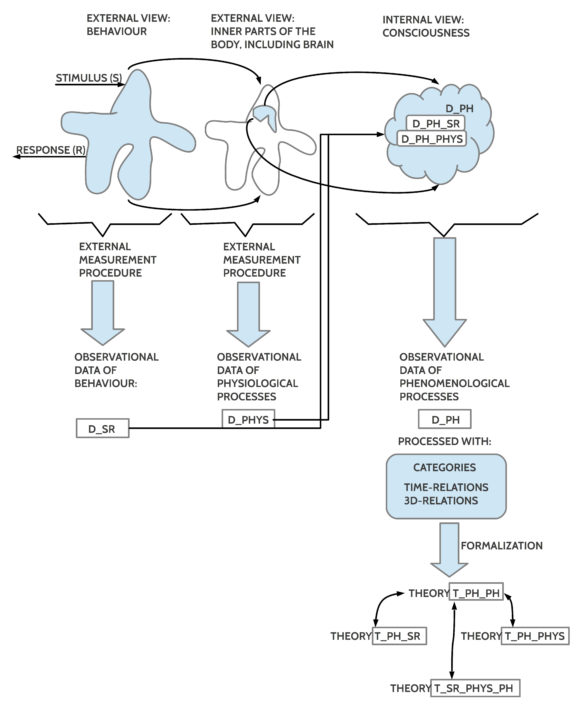

WAHRHEIT UND BEDEUTUNG – Im Prozess

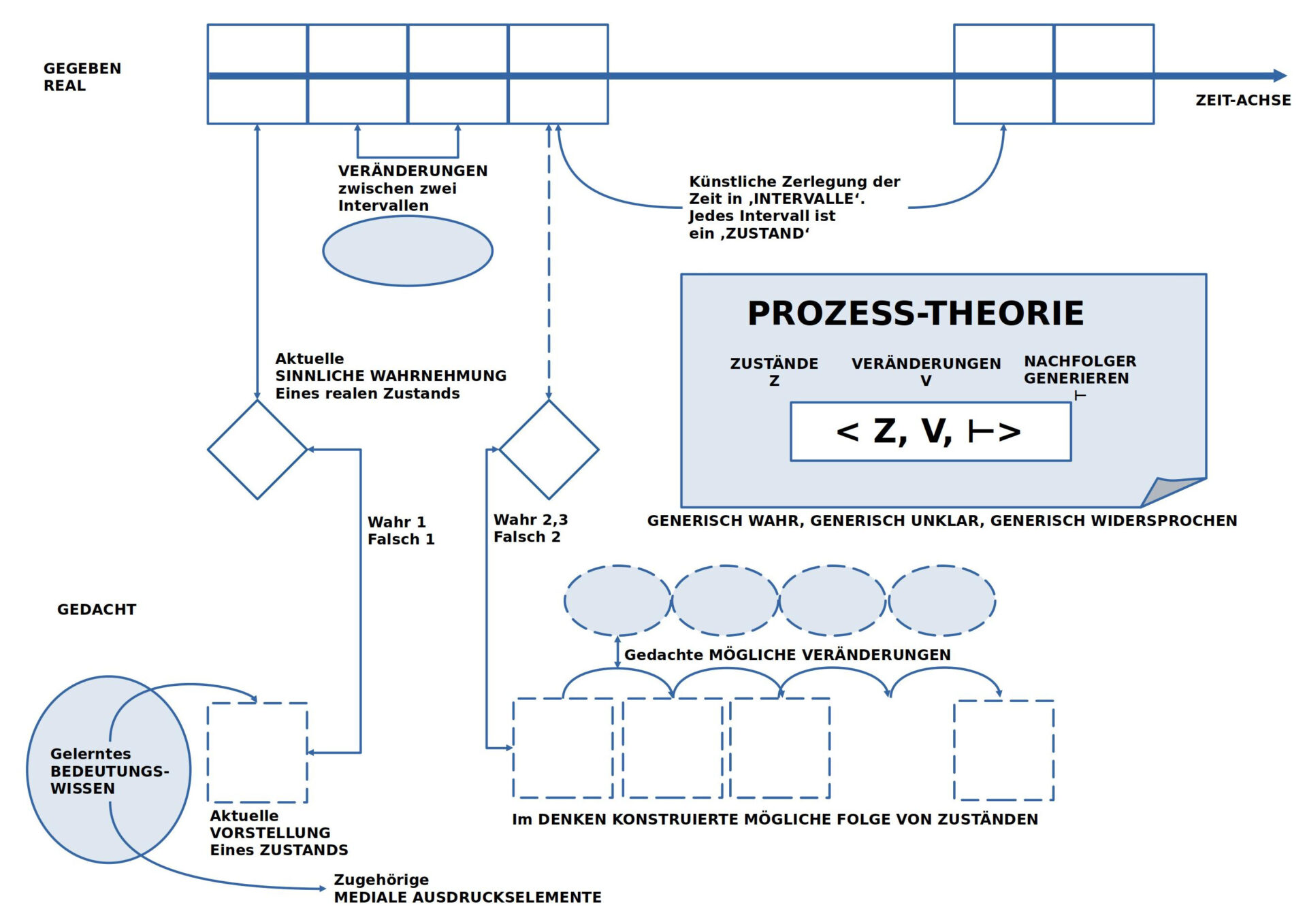

In dem vorausgehenden Abschnitt sind die verschiedenen Begriffe (‚wahr1,2‘, ‚falsch 1,2‘, ‚wahr 3‘) noch eher unverbunden, sind noch nicht wirklich in einem fassbaren Zusammenhang verortet. Dies soll hier mit Hilfe der Arbeitshypothese 4 (Skizze eines Prozessraums) versucht werden.

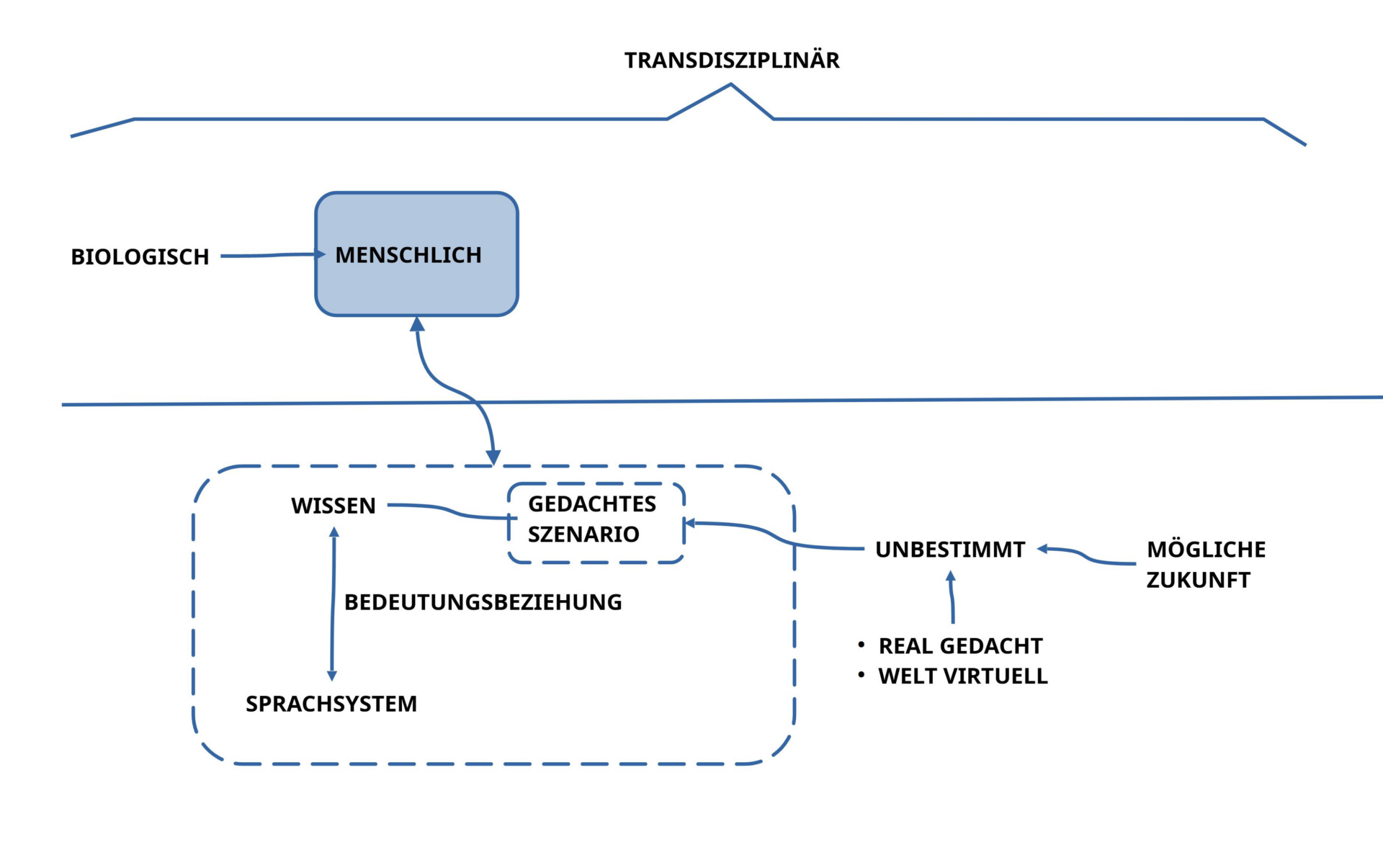

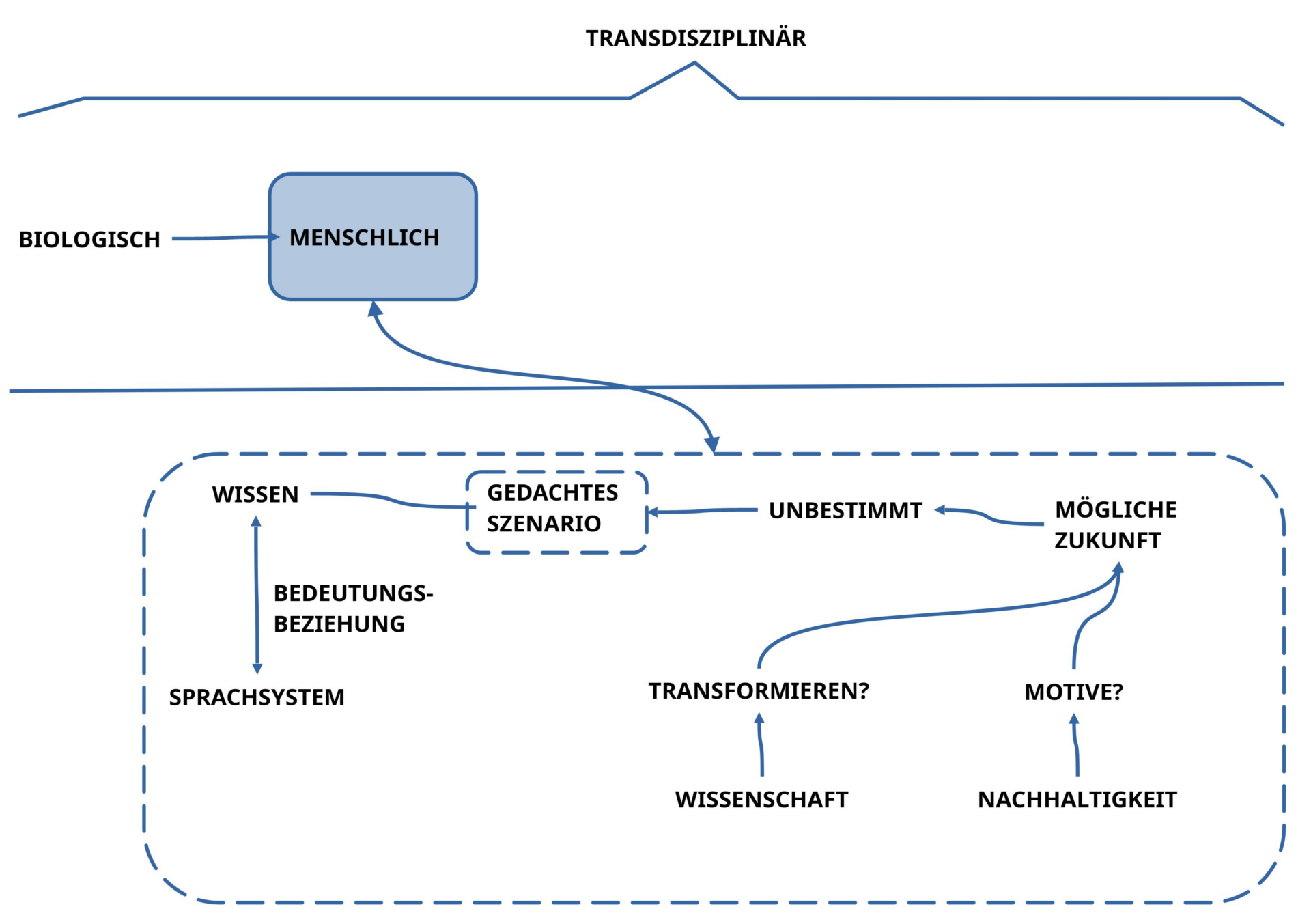

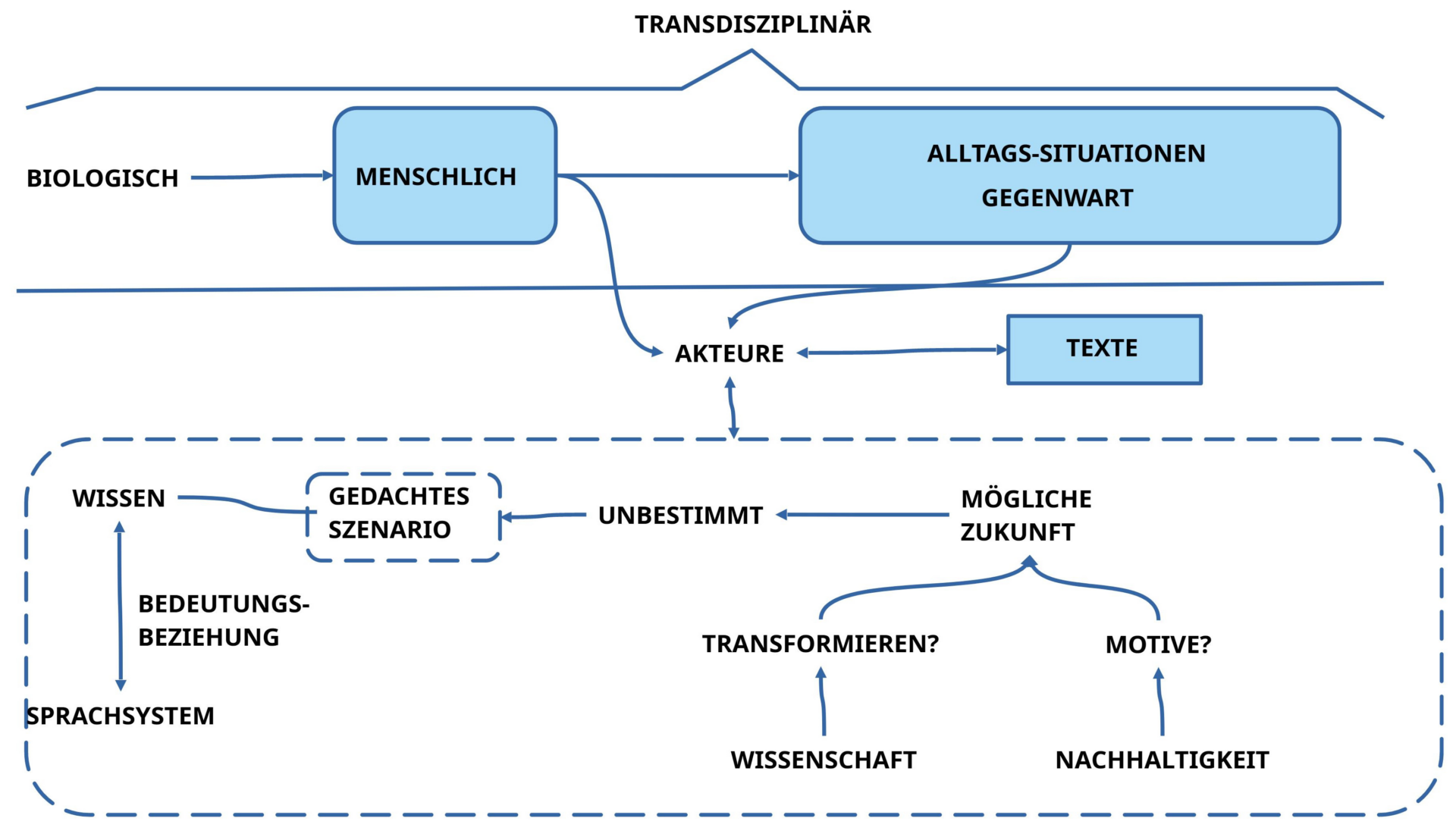

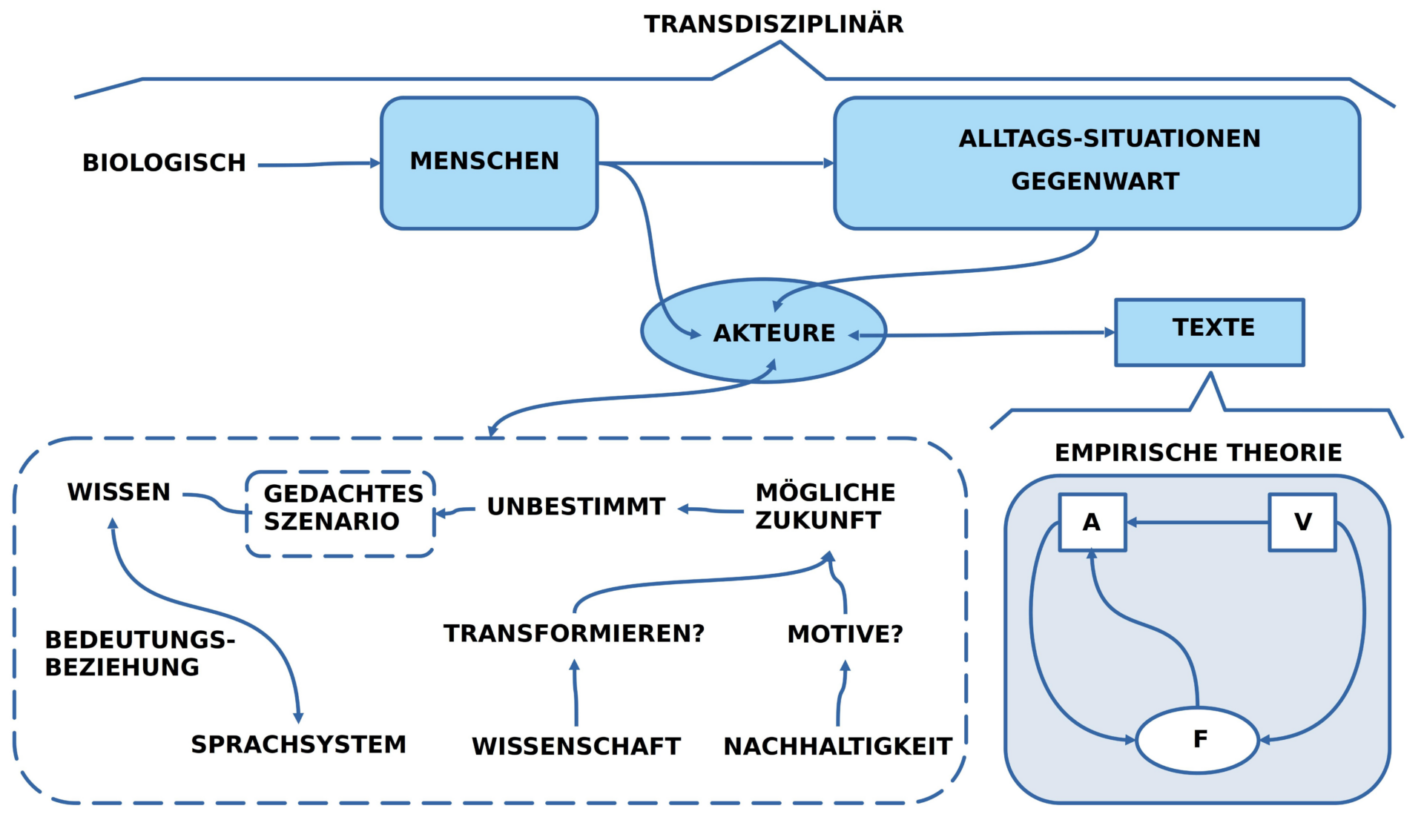

BILD : Der Prozessraum in der realen Welt und im Denken samt möglicher Wechselwirkungen

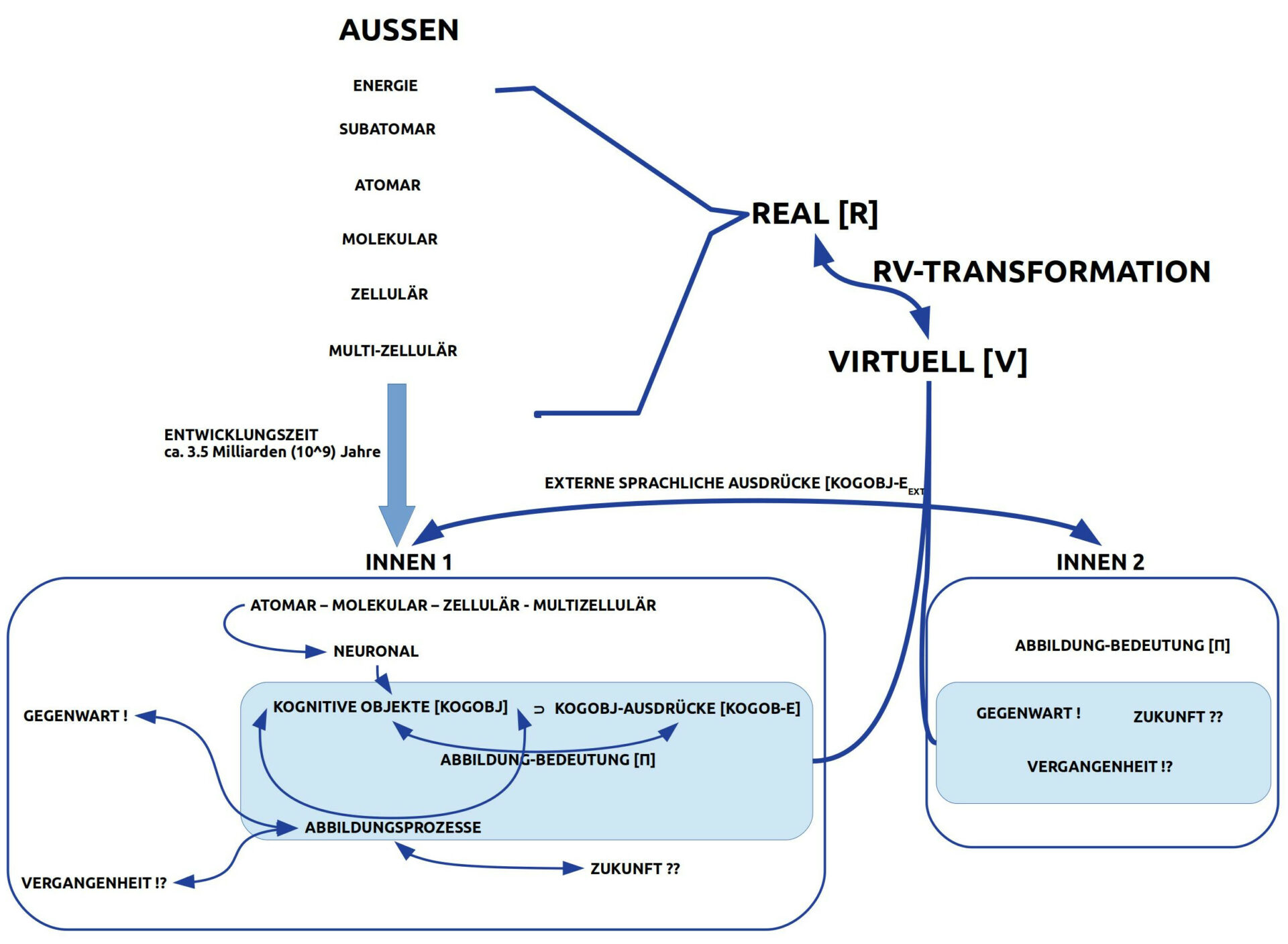

Die Grundelemente der Arbeitshypothese 4 lassen sich wie folgt charakterisieren:

- Es gibt die reale Welt mit ihren kontinuierlichen Veränderungen und innerhalb eines Akteurs einen virtuellen Raum für Prozesse mit Elementen wie Wahrnehmungen, Erinnerungen und gedachte Vorstellungen.

- Das Bindeglied zwischen realem Raum und virtuellem Raum läuft über Wahrnehmungsleistungen, die spezielle Eigenschaften der realen Welt für den virtuellen Raum repräsentieren, und zwar so, dass ‚wahrgenommene Inhalte‘ und ‚gedachte Inhalte‘ unterscheidbar sind. Auf diese Weise ist ein ‚gedanklicher Abgleich‘ von Wahrgenommenem und Gedachtem möglich.

- Veränderungen in der realen Welt zeigen sich nicht explizit sondern manifestieren sich nur indirekt durch die wahrnehmbaren Veränderungen, die durch sie hervorgerufen werden.

- Es ist Aufgabe der ‚denkerischen Rekonstruktion‘ Veränderungen zu ‚identifizieren‘ und die sprachlich so zu beschreiben, dass nachvollziehbar ist, aufgrund welcher Eigenschaften eines gegebenen Zustands daraus ein möglicher Nachfolgezustand entstehen kann.

- Zusätzlich zur Unterscheidung von ‚Zuständen‘ und ‚Veränderungen‘ zwischen Zuständen muss auch geklärt werden, wie man eine gegebene Veränderungsbeschreibung auf einen gegebenen Zustand so ‚anwendet‘, dass daraus ein ‚Nachfolgezustand‘ entsteht. Dies wird hier ‚Nachfolger-Generierungs-Vorschrift‘ (symbolisch: ⊢) genannt. Ein Ausdruck wie Z ⊢V Z‘ würde dann bedeuten, dass man mit der Nachfolger-Generierungs-Vorschrift ⊢V unter Benutzung der Veränderungsregel V den nachfolgenden Zustand Z‘ aus dem Zustand Z generieren kann. Dabei kann allerdings auch mehr als eine Veränderungsregel V zum Einsatz kommen, also z.B. ⊢{V1, V2, …, Vn} mit den Veränderungsregeln V1, …, Vn.

- Bei der Formulierung von Veränderungsregeln können immer Fehler unterlaufen. Sofern sich bestimmte Veränderungsregeln in der Vergangenheit schon in Ableitungen ‚bewährt‘ haben, würde man für den ‚gedachten Folgezustand‘ tendenziell annehmen, dass er vermutlich auch real eintreten wird. Wir hätten es also mit dem Fall ‚wahr 2‚ zu tun. Ist eine Veränderungsregel neu und es liegen noch keine Erfahrungen mit ihr vor, hätten wir es für den gedachten Folgezustand mit dem Fall ‚wahr 3‘ zu tun. Währe eine bestimmte Veränderungsregel in der Vergangenheit schon mehrfach gescheitert, dann könnte Fall ‚falsch 2‘ vorliegen.

- Das skizzierte Prozessmodell lässt aber auch erkennen, dass die bisherigen Fälle (1-5 in der Tabelle) immer nur Teilaspekte beschreiben. Angenommen, eine Gruppe von Akteuren schafft es, mit vielen Zuständen und mit vielen Veränderungsregeln samt einer Nachfolger-Generierungs-Anweisung eine rudimentäre Prozess-Theorie zu formulieren, dann interessiert es natürlich, wie sich die ‚Theorie als Ganze‘ ‚bewährt‘. Dies bedeutet, dass jede ‚gedankliche Konstruktion‘ einer Abfolge möglicher Zustände entsprechend den angewendeten Veränderungsregeln unter Voraussetzung der Prozess-Theorie sich in allen Anwendungsfällen ‚bewähren muss‘, damit von der Theorie gesagt werden kann, dass sie ‚generisch wahr‘ ist. Während z.B. der Fall ‚wahr 1‘ sich nur auf einen einzigen Zustand bezieht, bezieht sich der Fall ‚generisch wahr‘ auf ‚ganz viele‘ Zustände, so viele, bis ein ‚Endzustand‘ erreicht wird, der als ‚Zielzustand‘ gelten soll. Der Fall ‚generisch widersprochen‘ soll vorliegen, wenn es wenigstens eine Folge von generierten Zuständen gibt, die immer wieder einen Endzustand generiert, der falsch 1 ist. Solange eine Prozess-Theorie noch nicht in allen möglichen Fällen mit wahr 1 für einen Endzustand bestätigt worden ist, bleibt ein ‚Rest an Fällen‘, die unklar sind. Dann würde eine Prozess-Theorie als ‚generisch unklar‘ bezeichnet werden, obgleich sie für die Menge der bislang erfolgreich getesteter Fälle als ‚generisch wahr‘ gelten darf.

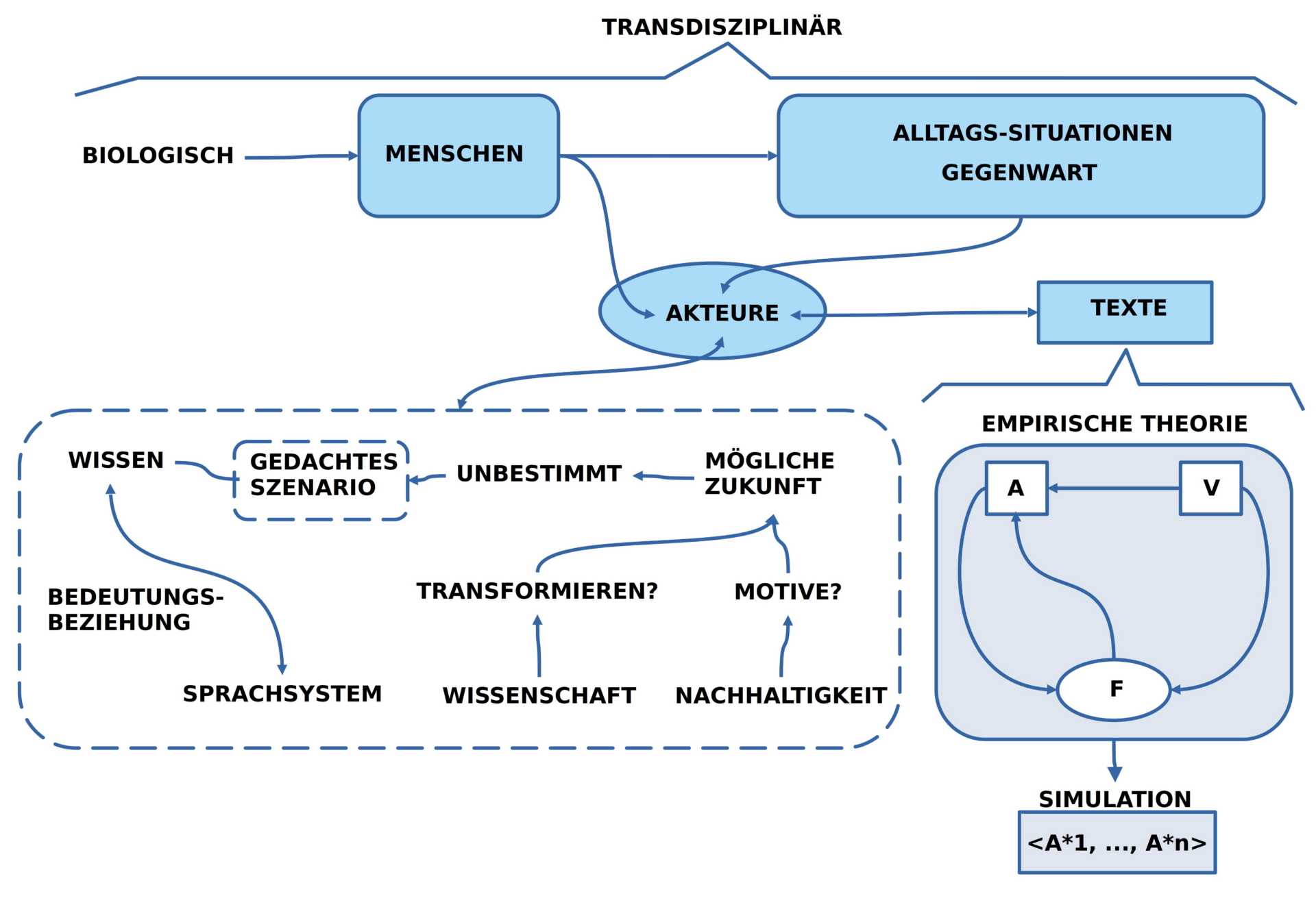

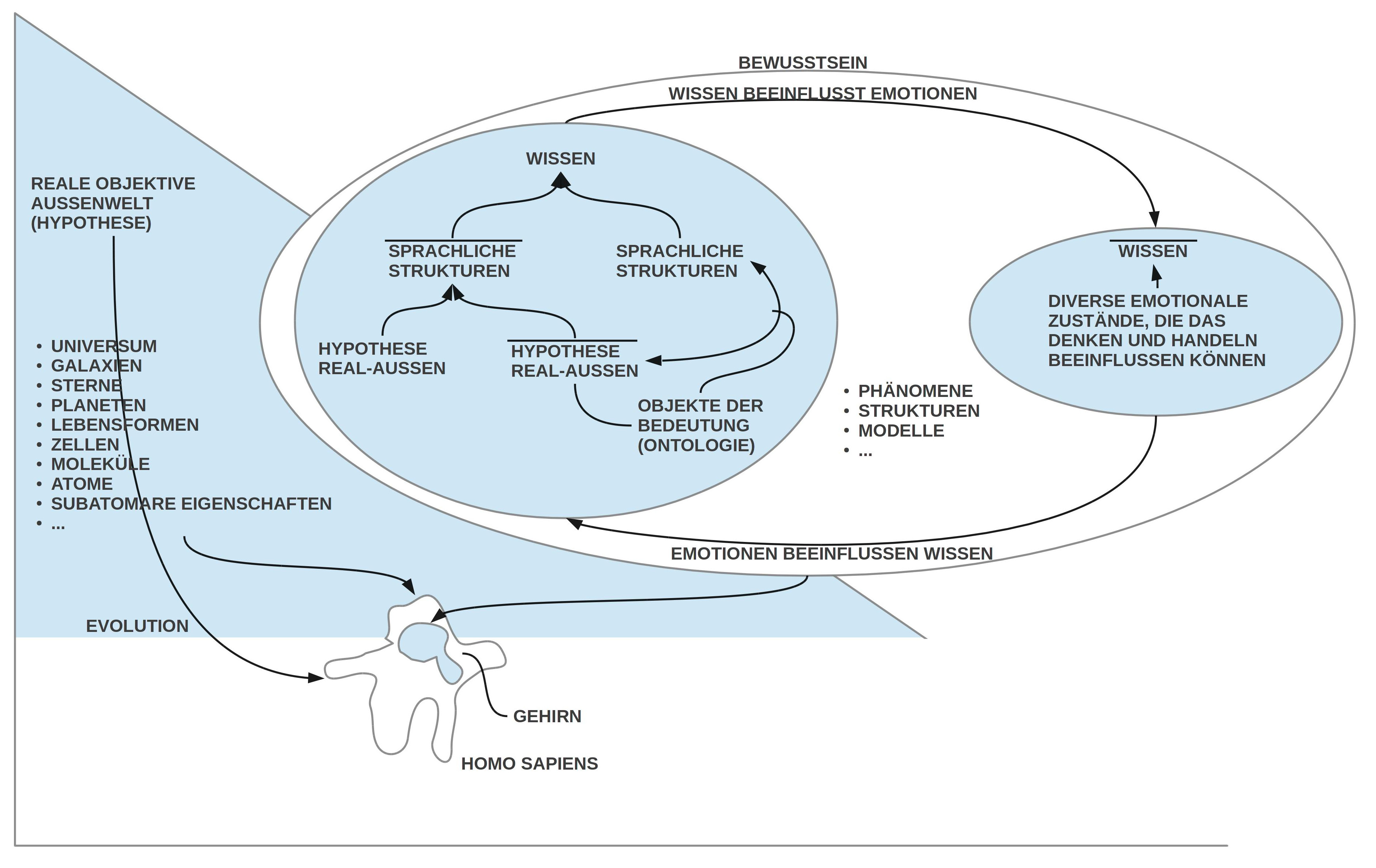

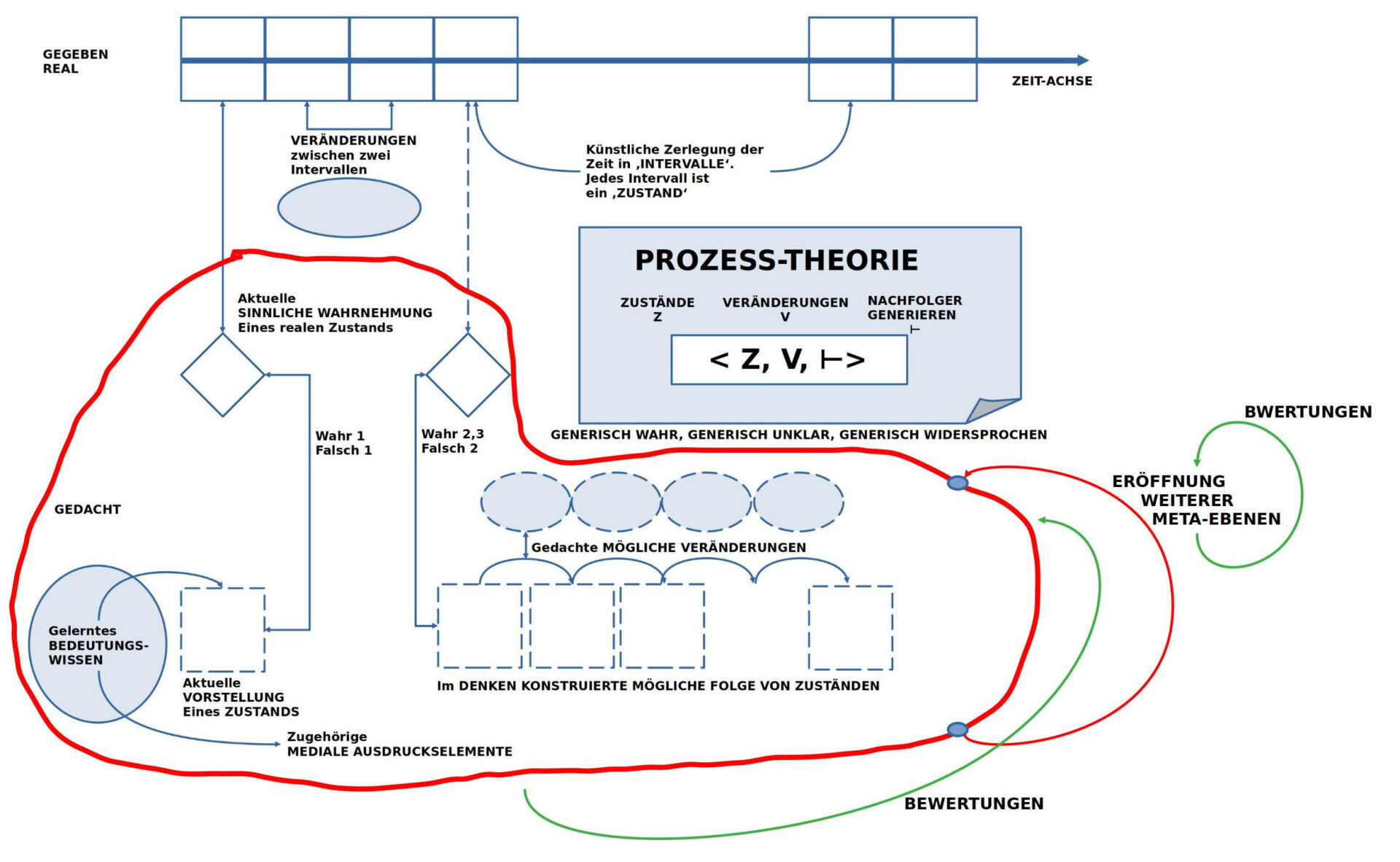

BILD : Der individuelle erweiterte Prozessraum mit Andeutung der Dimension Weitere Meta-Ebenen‘ sowie ‚Bewertungen‘.

Wem das vorausgehende erste Bild mit dem Prozessraum schon arg ’schwierig‘ vorkommt, der wird bei diesem zweiten Bild zum ‚erweiterten Prozessraum‘ natürlich ‚ins Schwitzen‘ kommen. Aber der individuelle Denkraum ist nun mal ein Spitzenprodukt der Evolution, das einiges zu bieten hat.

So kann jeder bei sich selbst überprüfen, dass wir Menschen über die Fähigkeit verfügen, egal, was wir Denken, dieses Denken jederzeit selbst wieder zum ‚Gegenstand des Denkens‘ zu machen, und zwar eben ‚innerhalb des Denkens selbst‘. Mit diesem ‚Denken über das Denken‘ eröffnen sich eine ‚zusätzliche Ebene des Denkens‘ — hier ‚Meta-Ebene‘ genannt –, auf der wir Denkenden all das ‚thematisieren‘, was uns am vorausgehenden Denken auffällt und wichtig ist. [*8] Neben dem ‚Denken über das Denken‘ verfügen wir auch über die Fähigkeit, das, was wir Wahrnehmen und Denken zu ‚bewerten‘. Diese ‚Bewertungen‘ werden gespeist aus dem Raum unserer ‚Emotionen‘ [*9] und ‚gelernten Bevorzugungen‘. Dies ermöglicht uns, mit Hilfe unserer Emotionen und gelernten Bevorzugungen zu ‚lernen‘: Wenn wir also bestimmte Handlungen vornehmen und dabei ‚Schmerzen‘ erleiden, dann werden wir diese Handlungen beim nächsten Mal eher vermeiden. Wenn wir im Restaurant X Essen gehen, weil jemand uns dies ‚empfohlen‘ hat, und das Essen und/ oder der Service waren richtig schlecht, dann werden wir diesen Vorschlag künftig eher nicht mehr berücksichtigen. Von daher kann unser Denken (und unser Wissen) zwar ‚Möglichkeiten sichtbar machen‘, aber es sind die Emotionen, die das kommentieren, was bei Umsetzung des Wissens ‚gut‘ oder ’schlecht‘ passiert. Doch, Achtung, auch Emotionen können irren, und zwar massiv. [*10]

WAHRHEIT UND BEDEUTUNG – Als eine kollektive Leistung

Die bisherigen Überlegungen zum Thema ‚Wahrheit und Bedeutung‘ im Kontext individueller Prozesse haben umrisshaft angedeutet, dass und wie ‚Sprache‘ eine zentrale Rolle spielt, um Bedeutung und darauf aufbauend Wahrheit zu ermöglichen. Ferner wurde ebenfalls skizzenhaft umrissen, dass und wie man Wahrheit und Bedeutung in einem dynamischen Kontext einordnen muss, in ein ‚Prozessmodell‘, wie es in einem Individuum in enger Interaktion mit der Umgebung stattfindet. Dieses Prozessmodell umfasst die Dimension des ‚Denkens‘ (auch ‚Wissen‘) wie auch die Dimension der ‚Bewertungen‘ (Emotionen, Präferenzen); innerhalb des Denkens gibt es potentiell viele ‚Betrachtungsebenen‘, die aufeinander Bezug nehmen können (natürlich können sie auch ‚parallel‘ stattfinden ohne direkten Kontakt zueinander (die unverbundene Parallelität ist aber der weniger interessante Fall).

So faszinierend die dynamische emotional-kognitive Struktur im Innern eines einzelnen Akteurs sein kann, die ‚wahr Kraft‘ des expliziten Denkens zeigt sich erst dort, wo verschiedene Menschen beginnen, sich mittels Kommunikation in ihrem Handeln zu koordinieren. Wenn auf diese Weise das individuelle Handeln sich in ein kollektives Handeln transformiert, wird eine Dimension von ‚Gesellschaft‘ sichtbar, welche die ‚einzelnen Akteure‘ in gewisser Weise ‚vergessen‘ lässt, weil die ‚Gesamtleistung‘ der ‚kollektiv miteinander verbundenen einzelnen‘ um Dimensionen komplexer und nachhaltiger sein kann als dies jemals ein einzelner realisieren könnte. Während ein einzelner Mensch maximal in seiner individuellen Lebenszeit einen Beitrag leisten kann, können kollektiv verbundene Menschen Leistungen vollbringen, die viele Generationen umfassen.

Andererseits wissen wir aus der Geschichte, dass kollektive Leistungen nicht automatisch ’nur Gutes‘ bewirken müssen; die bekannte Geschichte von Unterdrückung, blutigen Kriegen und Zerstörung ist umfangreich und findet sich in allen zeitlichen Abschnitten der menschlichen Geschichte.

Dies verweist darauf, dass die Frage von ‚Wahrheit‘ und ‚Gut sein‘ nicht nur eine Frage für den jeweils individuellen Prozess ist, sondern sehr wohl auch eine Frage für den kollektiven Prozess, und hier, im kollektiven Fall, ist diese Frage eher noch wichtiger, da ja im Fehlerfall nicht nur einzelne unter negativen Wirkungen leiden müssen, sondern eher sehr viele; schlimmstenfalls alle.

Anmerkungen

[*1] In einer systemtheoretischen Betrachtung des Systems ‚menschlicher Körper‘ kann man die Arbeitshypothese formulieren, dass weit mehr als 99% der Ereignisse in einem menschlichen Körper Nicht bewusst sind. Dies kann man erschreckend finden oder beruhigend. Ich tendiere zum Letzteren, zur ‚Beruhigung‘. Denn wenn man sieht, was ein menschlicher Körper als ‚System‘ aus sich heraus zu tun in der Lage ist, in jeder Sekunde, viele Jahre, sogar Jahrzehnte lang, dann erscheint dies äußerst beruhigend angesichts der vielen, auch groben Fehler, die wir mit unserem kleinen ‚Bewusstsein‘ vollbringen können. In Kooperation mit anderen Menschen können wir unsre bewussten menschlichen Leistungen zwar dramatisch verbessern, aber immer nur unter Voraussetzung der Systemleistung eines menschlichen Körpers. In ihm stecken immerhin 3.5 Milliarden Jahre Entwicklungsarbeit des BIOMs auf diesem Planeten; die Bausteine dieses BIOMs, die Zellen, funktionieren wie ein gigantischer Parallelcomputer, verglichen mit dem die heutigen technischen Supercomputer (einschließlich der viel gepriesenen ‚Quantencomputer‘) so klein und schwach aussehen, dass man diese Relation praktisch nicht ausdrücken kann.

[*2] Eine ‚Alltagssprache‘ setzt immer ‚die Vielen‘ voraus, die miteinander kommunizieren wollen. Einer alleine kann keine Sprache haben, die andere verstehen können sollen.

[*3] Eine Bedeutungsbeziehung tut real das, was mathematisch ‚Abbildung‘ genannt wird: Elemente der einen Sorte (Elemente der Oberflächenstruktur der Sprache) werden Elementen einer anderen Sorte (die potentiellen Bedeutungselemente) zugeordnet. Während eine mathematische Abbildung normalerweise fest definiert ist, kann sich die ‚reale Bedeutungsbeziehung‘ beständig ändern; sie ist ‚flexibel‘, Teil eines übergeordneten ‚Lernprozesses‘, der in Abhängigkeit von der Wahrnehmung und inneren Zuständen die Bedeutungsbeziehung beständig ’neu anpasst‘.

[*4] Die Inhalte von Arbeitshypothese 2 stammen aus den Erkenntnissen der modernen Kognitionswissenschaften (Neurowissenschaften, Psychologie, Biologie, Linguistik, Semiotik, …) und der Philosophie; sie verweisen auf viele tausend Artikel und Bücher. Die Arbeitshypothese 2 stellt daher eine hochverdichtete Zusammenfassung von all diesem dar. Ein direktes Zitieren ist dazu rein praktisch nicht möglich.

[*5] Wie aus Forschungen zu Zeugenaussagen und aus der allgemeinen Wahrnehmungsforschung bekannt ist, gibt es neben allerlei direkten Wahrnehmungsfehlern sehr viele Fehler in der ‚Interpretation der Wahrnehmung‘, die weitgehend unbewusst/ automatisiert ablaufen. Gegen solche Fehler sind die Akteure normalerweise machtlos; sie merken es einfach nicht. Nur methodisch bewusste Kontrollen der Wahrnehmung können partiell auf diese Fehler aufmerksam machen.

[*6] Menschliches Wissen ist ’notorisch Fehlerbehaftet‘. Dafür gibt es viele Gründe. Einer liegt in der Arbeitsweise des Gehirns selbst. Ein ‚korrektes‘ Wissen ist nur möglich, wenn die aktuellen Wissensprozesse immer wieder ‚abgeglichen‘, ‚kontrolliert‘ werden, um sie korrigieren zu können. Wer dies nicht tut, hat notgedrungen ein unvollständiges und vielfach falsches Wissen. Wie bekannt hindert dies Menschen nicht daran, zu glauben, alles ist ‚wahr‘, was sie im Kopf mit sich herum tragen. Wenn es ein großes Problem in dieser Welt gibt, dann gehört dieses dazu: die Unwissenheit über die eigene Unwissenheit.

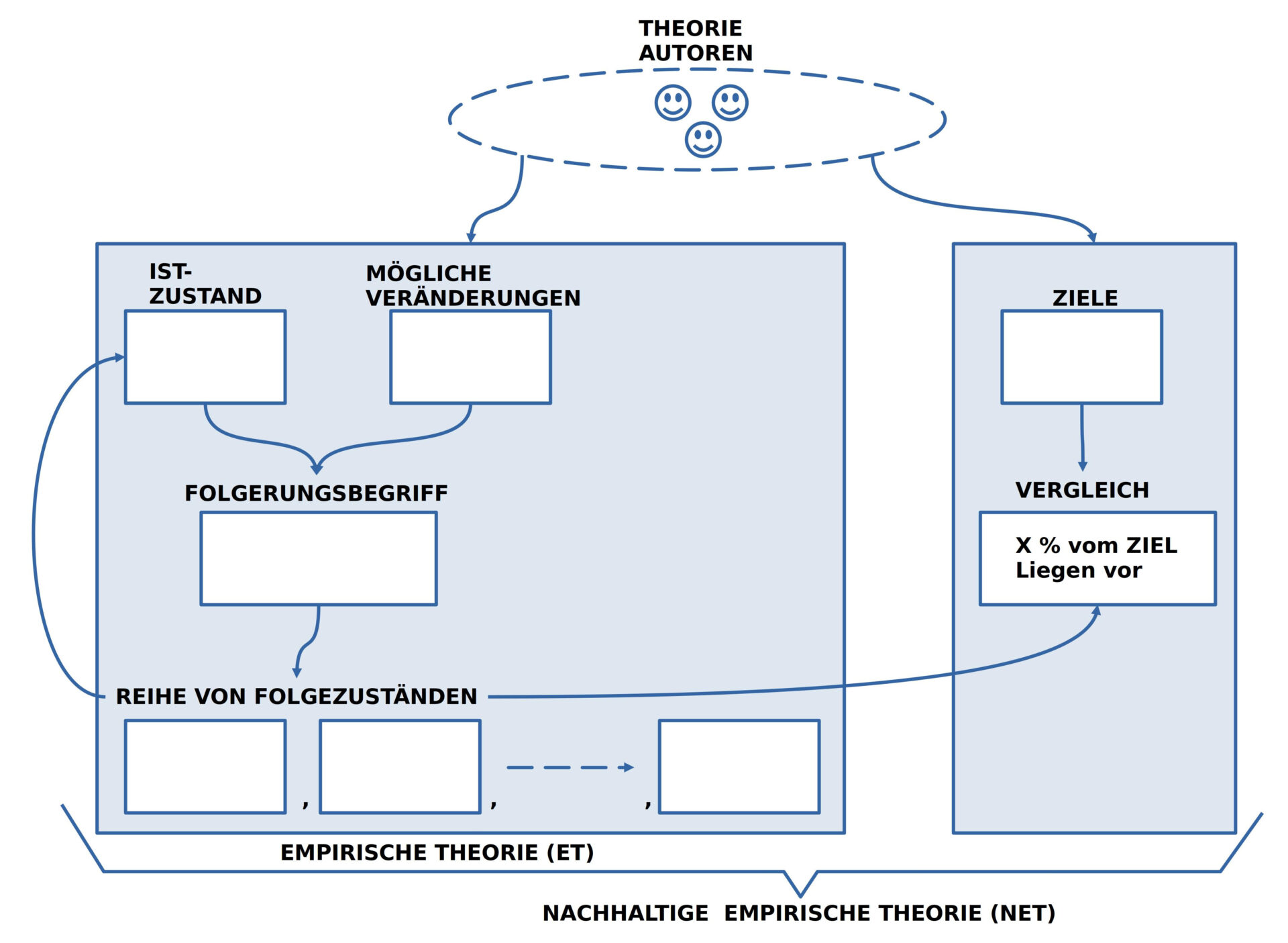

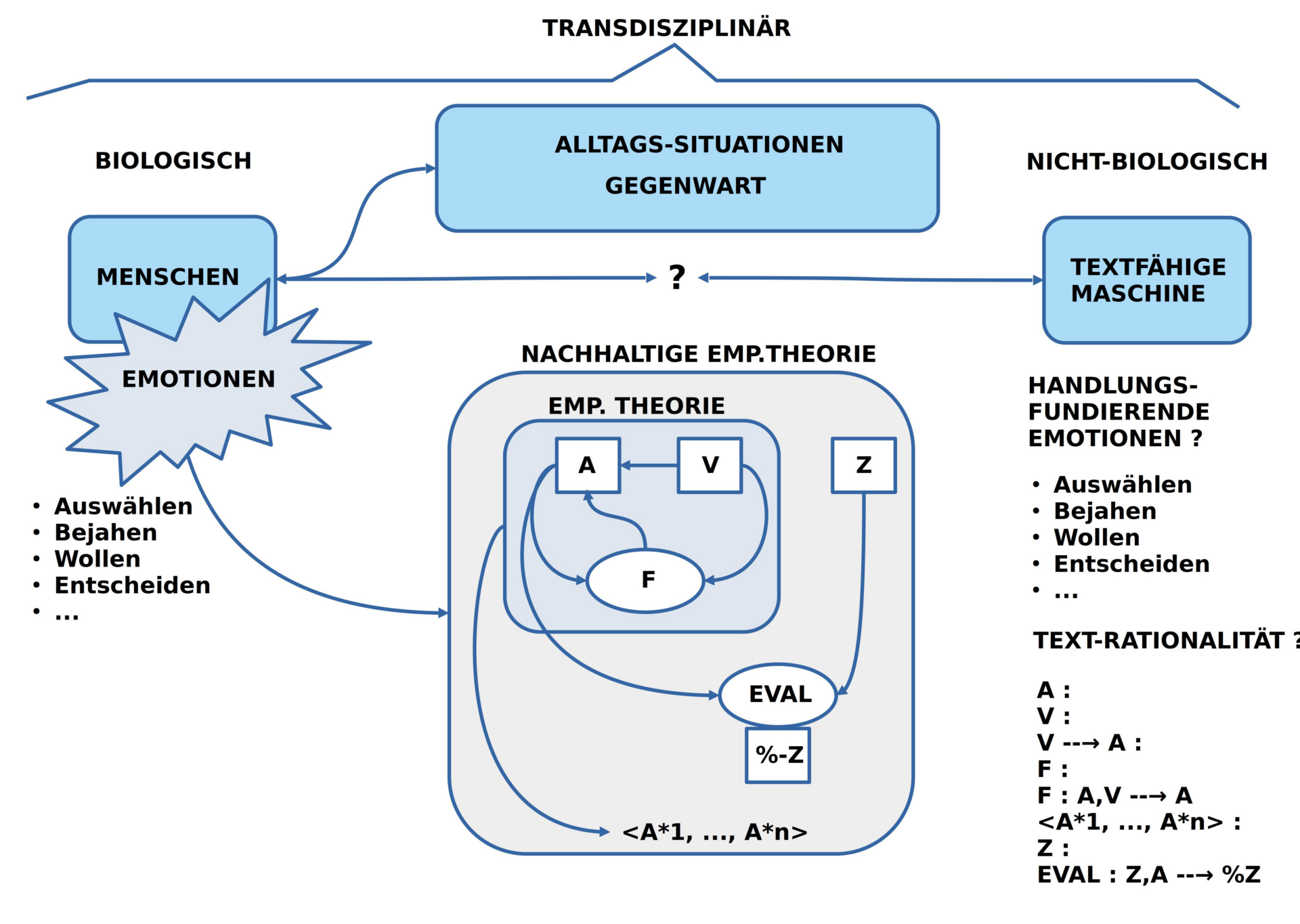

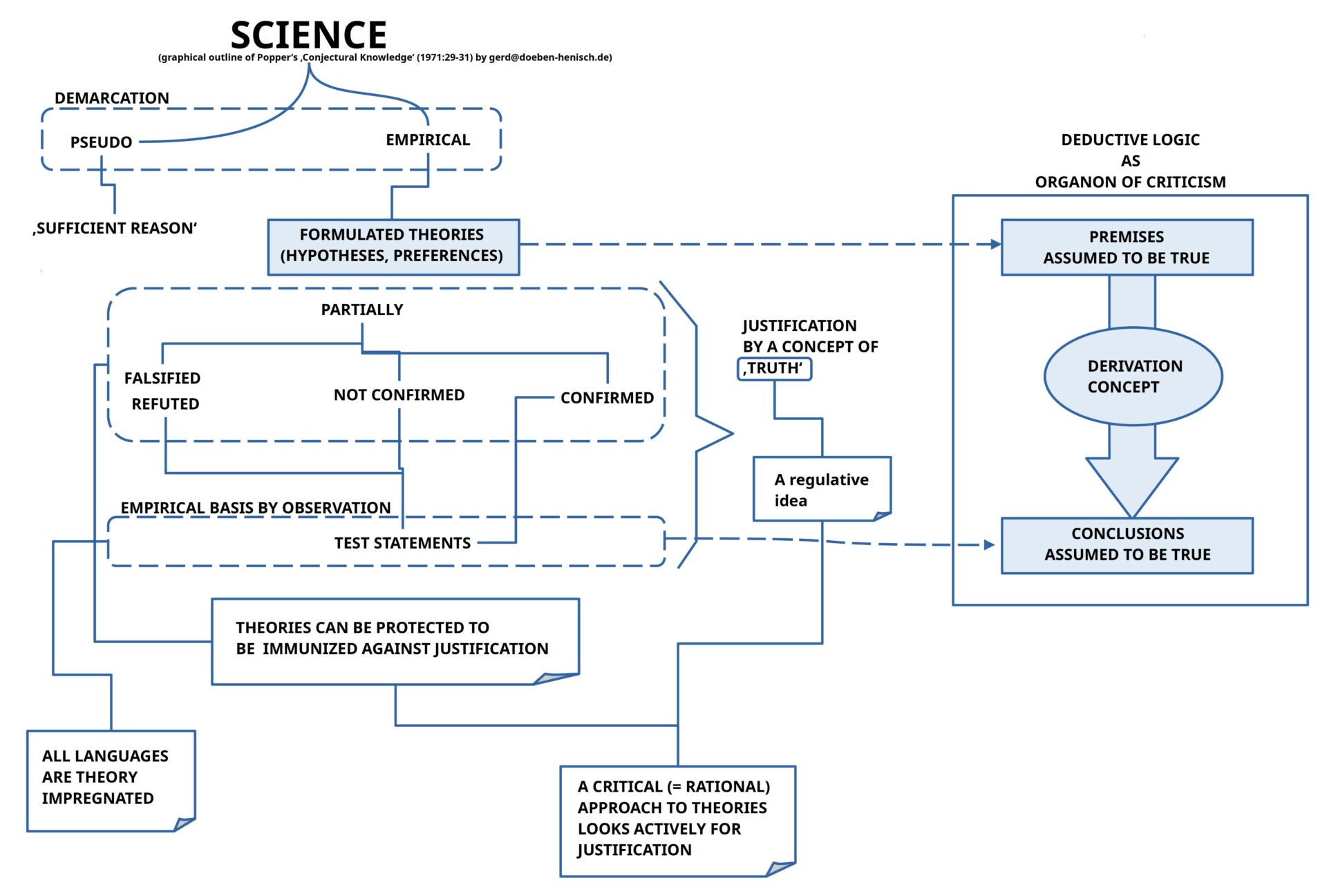

[*7] In der bisherigen Kulturgeschichte der Menschheit gab es erst sehr spät (seit ca. 500 Jahren?) die Entdeckung eines Erkenntnisformats, das es beliebig vielen Menschen ermöglicht, sich ein Tatsachenbasiertes Wissen aufzubauen, das, verglichen mit allen anderen bekannten Wissensformaten, die ‚besten Ergebnisse‘ ermöglicht (was Fehler natürlich nicht vollständig ausschließt, aber extrem minimiert). Dieses bis heute revolutionäre Wissensformat hat den Namen ‚empirische Theorie‘, von mir mittlerweile erweitert zu ’nachhaltiger empirischer Theorie‘. Wir Menschen sind einerseits die Hauptquelle für ‚wahres Wissen‘, zugleich sind wir selbst aber auch die Hauptquelle für ‚falsches Wissen‘. Dies erscheint auf den ersten Blick wie ein ‚Paradox‘, hat aber eine ‚einfache‘ Erklärung, die in ihrer Wurzel aber ’sehr tief blicken lässt‘ (vergleichbar mit der kosmischen Hintergrundstrahlung, die gegenwärtig einfach ist, aber aus den Anfängen des Universums stammt).(Anmerkung: eine kurze Beschreibung der Begriffe ‚empirische Theorie‘ und ’nachhaltige empirische Theorie‘ finde sich ab Abschnitt 6 in folgendem Blog-Eintrag: https://www.cognitiveagent.org/2023/11/06/kollektive-mensch-maschine-intelligenz-im-kontext-nachhaltiger-entwicklung-brauchen-wir-ein-neues-menschenbild-vorlesung-fuer-ag-enigma-im-rahmen-von-u3l-der-goethe-universitaet/ )

[*8] Von seiner Architektur her kann unser Gehirn beliebig viele solcher Meta-Ebenen eröffnen, aber aufgrund seiner konkreten Endlichkeit bietet es für verschiedene Aufgaben nur eine begrenzte Zahl von Neuronen an. So ist bekannt (und mehrfach experimentell nachgewiesen), dass z.B. unser ‚Arbeitsgedächtnis‘ (auch ‚Kurzzeitgedächtnis genannt oder ‚Short Term Memory‘) nur auf ca. 6-9 ‚Einheiten‘ limitiert ist (wobei der Begriff ‚Einheit‘ kontextabhängig zu definieren ist). Wollen wir also umfangreiche Aufgaben durch unser Denken lösen, brauchen wir ‚externe Hilfsmittel‘ (Blatt Papier und Schreibstift oder einen Computer, …), um die vielen Aspekten festzuhalten und entsprechend zu notieren. Obwohl die bekannten Computer heutzutage nicht einmal ansatzweise in der Lage sind, die komplexen Denkprozesse von Menschen zu ersetzen, können sie begrenzt für die Durchführung komplexer Denkprozesse ein fast unersätzliches Hilfsmittel sein. Allerdings nur dann, wenn WIR tatsächlich WISSEN, was wir da tun!

[*9] Das Wort ‚Emotionen‘ ist ein ‚Sammelbegriff‘ für sehr viele verschiedene Phänomene und Sachverhalte. Trotz umfangreicher Forschungen seit über hundert Jahren können die verschiedenen Disziplinen der Psychologie noch kein einheitliches Bild, geschweige denn eine einheitliche’Theorie‘ zum Thema anbieten. Dies verwundert auch nicht, da vieles davon weitgehend ‚unbewusst‘ abläuft bzw. ausschließlich als ‚internes Ereignis‘ im Individuum direkt verfügbar ist. Klar scheint nur zu sein, dass wir als Menschen niemals ‚emotionsfrei‘ sind (dies gilt auch für sogenannte ‚coole‘ Typen, denn das scheinbare ‚verdrängen‘ oder ‚unterdrücken‘ von Emotionen ist selbst wieder Teil unserer angeborenen Emotionalität.

[*10] Natürlich können Emotionen uns auch gewaltig in die Irre oder gar in den Untergang führen (sich in anderen Menschen irren, sich in sich selbst irren, …). Es ist also nicht nur wichtig, die sachlichen Dinge in der Welt durch ‚Lernen‘ in nützlicher Weise zu ’sortieren‘, sondern man muss auch tatsächlich die ‚eigenen Emotionen im Blick haben‘ und überprüfen, wann und wie diese auftreten und ob sie uns tatsächlich helfen. Primäre Emotionen (wie z.B. Hunger, Sexualtrieb, Wut, Sucht, ‚Verknallt sein‘, …) sind punktuell, Situationsbezogen , können eine große ‚psychische Kraft‘ entwickeln, und verstellen damit den Blick auf die möglichen oder sehr wahrscheinlichen ‚Folgen‘, die für uns erheblich schädigend sein können.

[*11] Der Begriff ‚Narrativ‘ wird heutzutage immer mehr benutzt, um zu beschreiben, dass eine Gruppe von Menschen in ihrem Denken für ihre Wahrnehmung der Welt ein bestimmtes ‚Bild‘, eine bestimmte ‚Erzählung‘ benutzt, um ihr gemeinsames Handeln koordinieren zu können. Letztlich gilt dies für jedes gemeinsame Handeln, selbst für Ingenieure, die eine technische Lösung erarbeiten wollen. Insofern ist die Darstellung in der deutschen Wikipedia ein bisschen ‚eng‘: https://de.wikipedia.org/wiki/Narrativ_(Sozialwissenschaften)

QUELLEN

Die folgenden Quellen bilden nur eine winzige Auswahl aus vielen hunderten, eher tausenden von Artikeln, Büchern, Tondokumenten und Filmen, die zum Thema gehören. Vielleicht können sie dennoch für einen ersten Einstieg hilfreich sein. Die Liste wird gelegentlich erweitert.

[1a] Propaganda, siehe z.B. hier: https://de.wikipedia.org/wiki/Propaganda oder [1b] die Englische Version : https://en.wikipedia.org/wiki/Propaganda /* Die Englische Version wirkt systematischer, überdeckt grössere Zeiträume und mehr unterschiedliche Anwendungsgebiete */

[2] Florian Schaurer, Hans-Joachim Ruff-Stahl, (21.10.2016), Hybride Bedrohungen Sicherheitspolitik in der Grauzone, Bundeszentrale für politische Bildung, Adenauerallee 86, 53113 Bonn, https://www.bpb.de/shop/zeitschriften/apuz/235530/hybride-bedrohungen/

[3] Propaganda der Russischen Föderation, hier: https://de.wikipedia.org/wiki/Propaganda_der_Russischen_F%C3%B6deration

[4] Russische Einflussnahme auf den Wahlkampf in den Vereinigten Staaten 2016, hier: https://de.wikipedia.org/wiki/Russische_Einflussnahme_auf_den_Wahlkampf_in_den_Vereinigten_Staaten_2016 /* Sehr ausführlich */

[5] Meduza, hier: https://de.wikipedia.org/wiki/Meduza

[6] Mischa Gabowitsch, Mai 2022, Von »Faschisten« und »Nazis«, https://www.blaetter.de/ausgabe/2022/mai/von-faschisten-und-nazis#_ftn4

[7] L. Wienand, S. Steurenthaler und S. Loelke, 30.8.22, Infokrieg Putins Troll-Armee greift Deutschland an

[8] Pomerantsev, Peter, (2019), This Is Not Propaganda: Adventures in the War Against Reality, Faber & Faber. Kindle-Version.

[9] Propaganda in China, hier: https://de.wikipedia.org/wiki/Propaganda_in_der_Volksrepublik_China /* Nur fragmentarisch; müsste deutlich ergänzt werden */

[10] Lena Bäunker, 25.12.2023, Reden ist Gold. Über die Kehrseiten von Flugreisen, Kreuzfahrten oder Fleischkonsum zu sprechen, ist nicht einfach. Wissenschaftler:innen haben untersucht, wie sich effektivere Klimagespräche führen lassen. https://www.klimareporter.de/gesellschaft/reden-ist-gold

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.