Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

Datum: 21.Juni 2020 (Korrekturen: 24.Juni 2020)

KONTEXT

Wenn man sich nicht nur wundern will, warum das Phänomen von ‚Fake News‘ oder ‚Verschwörungstheorien‘ so verbreitet ist und selbst vor akademischer Bildung nicht Halt macht, dann muss man versuchen, den Mechanismus zu verstehen, der diesem Phänomen zugrunde liegt. Von den vielen Zugängen zu dieser Frage finde ich das Buch von Maslow (1966) The Psychology of Science besonders aufschlussreich.

VERLUST DES PHÄNOMENS

Maslow erlebte seine Arbeit als Psychotherapeut im Spannungsfeld zur damaligen experimentellen verhaltensorientierten Psychologie im Stil von Watson. Während er als Psychotherapeut versuchte, die ganze Bandbreite der Phänomene ernst zu nehmen, die sich in der Begegnung mit konkreten Menschen ereignet, gehörte es zum damaligen Programm einer empirischen Verhaltens-Psychologie, die Phänomene im Kontext von Menschen auf beobachtbares Verhalten zu beschränken, und hier auch nur auf solche Phänomene, die sich in (damals sehr einfachen) experimentellen Anordnungen reproduzieren lassen. Außerdem galt das Erkenntnisinteresse nicht den individuellen Besonderheiten, sondern allgemeinen Strukturen, die sich zwischen allen Menschen zeigen.

Maslow verallgemeinert die Betrachtung dahingehend, dass er die Einschränkung der Phänomene aus Sicht einer bestimmten Disziplin als Charakteristisch für die Wissenschaft seiner Zeit diagnostiziert. Er meinte in dieser Ausklammerung von Phänomenen eine tiefer liegende Tendenz zu erkennen, in der letztlich die Methode über das Phänomen gestellt wird: wehe dem Phänomen, wenn es nicht zu den vereinbarten Methoden passt; es hat hier nichts zu suchen. In dem Moment, in dem die Wissenschaft von sich aus entscheiden darf, was als Phänomen gelten darf und was nicht, gerät sie in Gefahr, ein Spielball von psychologischen und anderen Dynamiken und Interessen zu werden, die sich hinter der scheinbaren Rationalität von Wissenschaft leicht verstecken können. Aus der scheinbar so rationalen Wissenschaft wird verdeckt eine irrationale Unternehmung, die sich selbst immunisiert, weil sie ja alle Phänomene ausklammern kann, die ihr nicht passen.

VERLUST DER EINHEIT

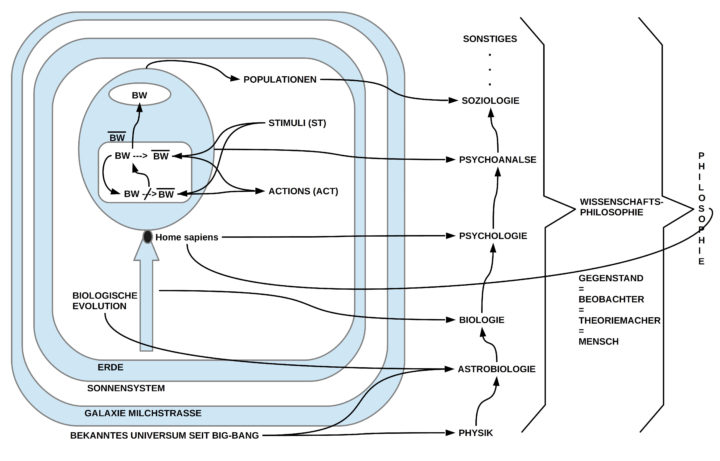

Zu der verdeckten Selbstimmunisierung von wissenschaftlichen Disziplinen kommt erschwerend hinzu, dass die vielen einzelnen Wissenschaften weder begrifflich noch prozedural auf eine Integration, auf eine potentielle Einheit hin ausgelegt sind. Dies hier nicht verstanden als eine weitere Immunisierungsstrategie, sondern als notwendiger Prozess der Integration vieler Einzelaspekte zu einem möglichen hypothetischen Ganzen. Ohne solche übergreifenden Perspektiven können viele Phänomene und daran anknüpfende einzelwissenschaftliche Erkenntnisse keine weiterreichende Deutung erfahren. Sie sind wie einzelne Findlinge, deren Fremdheit zu ihrem Erkennungszeichen wird.

SUBJEKTIV – OBJEKTIV

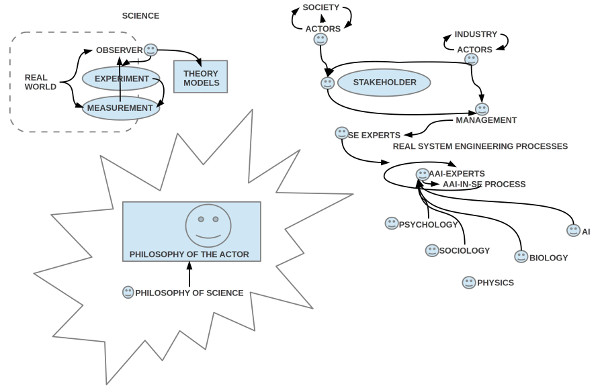

In der orthodoxen Wissenschaft, wie Maslow die rigorosen empirischen Wissensschaften nennt, wird ein Begriff von empirisch, von objektiv vorausgesetzt, der den Anspruch erhebt, die reale Welt unabhängig von den internen Zuständen eines Menschen zu vermessen. Dies geht einher mit der Ausklammerung der Subjektivität, weil diese als Quelle allen Übels in den früheren Erkenntnistätigkeiten des Menschen diagnostiziert wurde. Mit der Ausklammerung der Subjektivität verschwindet aber tatsächlich auch der Mensch als entscheidender Akteur. Zwar bleibt der Mensch Beobachter, Experimentator und Theoriemacher, aber nur in einem sehr abstrakten Sinne. Die inneren Zustände eines Menschen bleiben in diesem Schema außen vor, sind quasi geächtet und verboten.

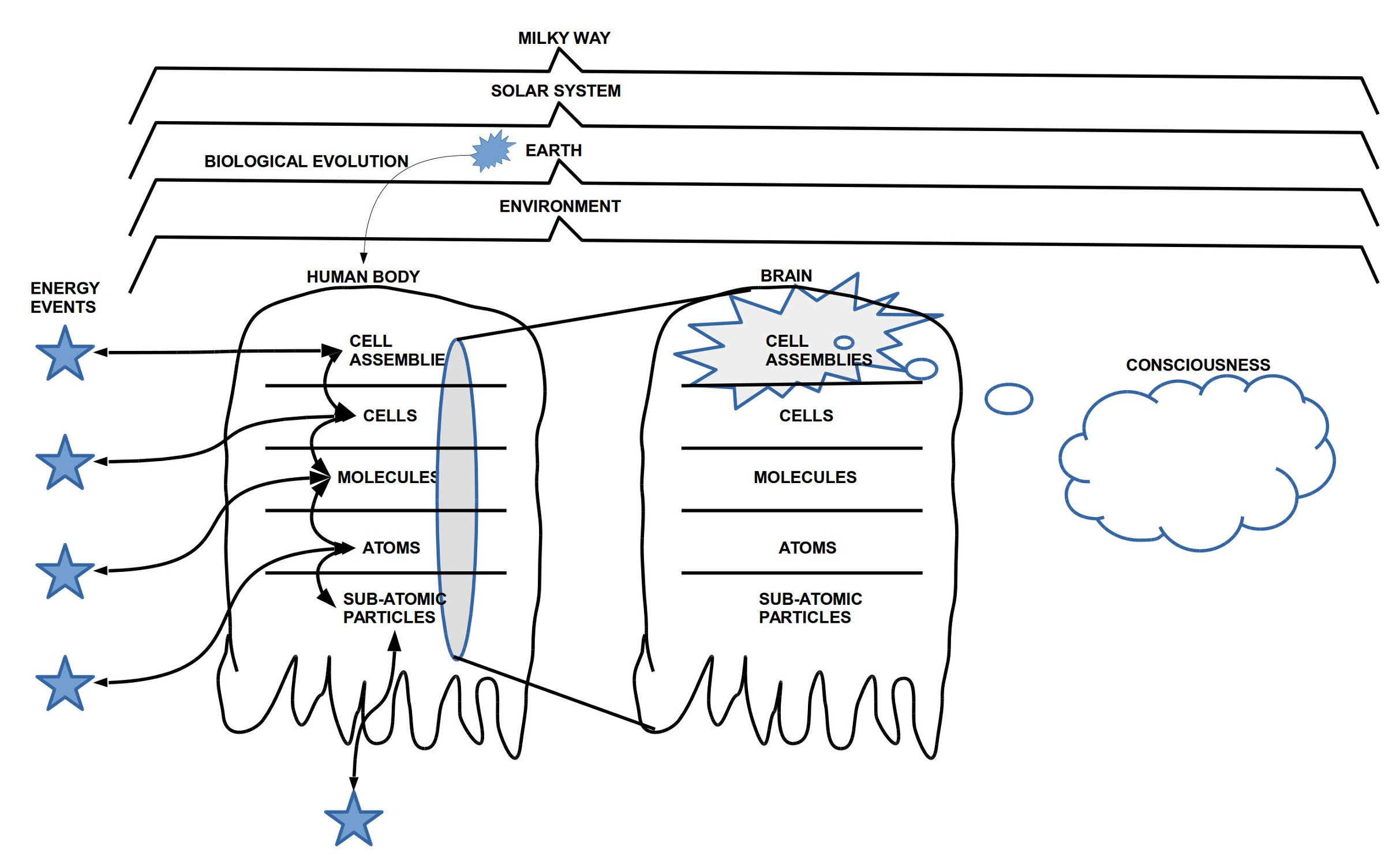

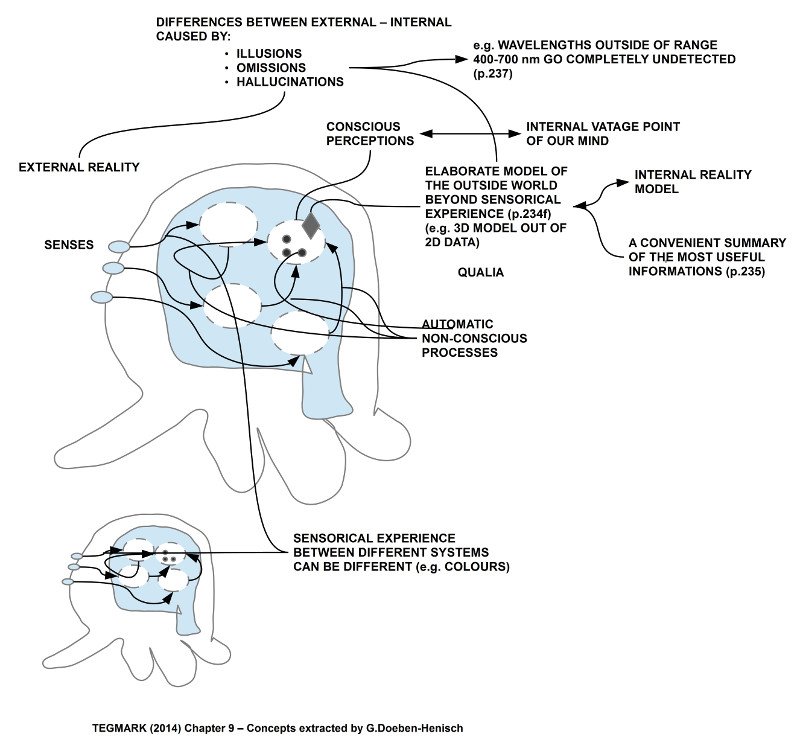

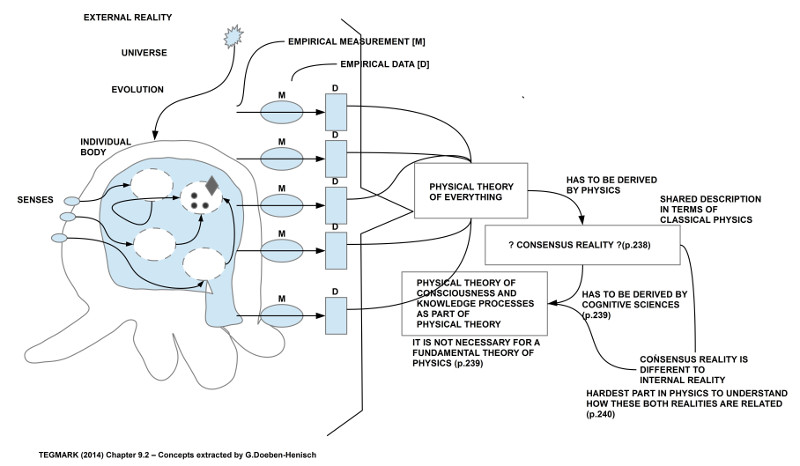

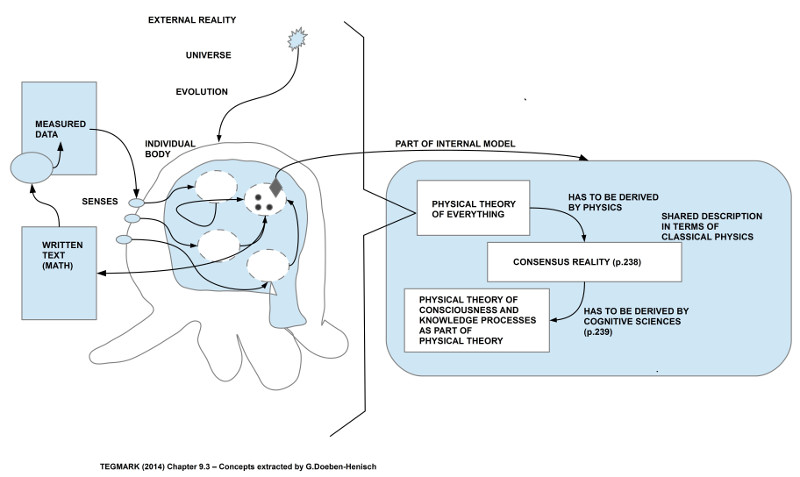

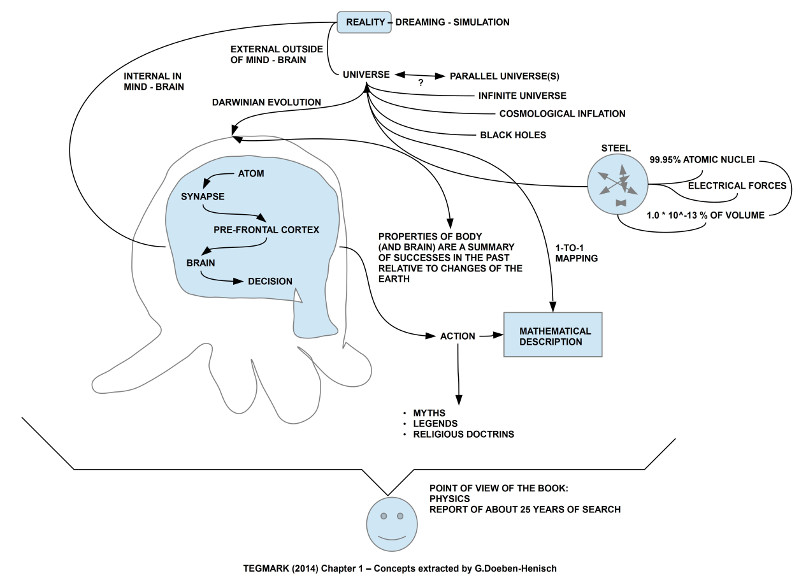

Diese Sehweise ist selbst im eingeschränkten Bild der empirischen Wissenschaften heute durch die empirischen Wissenschaften selbst grundlegend in Frage gestellt. Gerade die empirischen Wissenschaften machen deutlich, dass unser Bewusstsein, unser Wissen, unser Fühlen funktional an das Gehirn gebunden sind. Dieses Gehirn sitzt aber im Körper. Es hat keinen direkten Kontakt mit der Welt außerhalb des Körpers. Dies gilt auch für die Gehirne von Beobachtern, Experimentatoren und Theoriekonstrukteuren. Keiner von ihnen sieht die Welt außerhalb des Körpers, wie sie ist! Sie alle leben von dem, was das Gehirn aufgrund zahlloser Signalwege von Sensoren an der Körperoberfläche oder im Körper einsammelt und daraus quasi in Echtzeit ein dreidimensionales Bild der unterstellten Welt da draußen mit dem eigenen Körper als Teil dieser Welt errechnet. Dies bedeutet, dass alles, was wir bewusst wahrnehmen, ein internes, subjektives Modell ist, eine Menge von subjektiven Ereignissen (oft Phänomene genannt, oder Qualia), von denen einige über Wahrnehmungsprozesse mit externen Ursachen verknüpft sind, die dann bei allen Menschen in der gleichen Situation sehr ähnliche interne Wahrnehmungsereignisse erzeugen. Diese Wahrnehmungen nennen wir objektiv, sie sind aber nur sekundär objektiv; primär sind sie interne, subjektive Wahrnehmungen. Die Selbstbeschränkung der sogenannten empirischen Wissenschaften auf solche subjektiven Phänomene, die zeitgleich mit Gegebenheiten außerhalb des Körpers korrelieren, hat zwar einen gewissen praktischen Vorteil, aber der Preis, den die sogenannten empirischen Wissenschaften dafür zahlen, ist schlicht zu hoch. Sie opfern die interessantesten Phänomene im heute bekannten Universum nur, um damit ihre einfachen, schlichten Theorien formulieren zu können.

In ihrer Entstehungszeit — so im Umfeld der Zeit von Galilelo Galilei — war es eine der Motivationen der empirischen Wissenschaften gewesen, sich gegen die schwer kontrollierbaren Thesen einer metaphysischen Philosophie als Überbau der Wissenschaften zu wehren. Die Kritik an der damaligen Metaphysik war sicher gerechtfertigt. Aber In der Gegenbewegung hat die empirische Wissenschaft gleichsam — um ein Bild zu benutzen — das Kind mit dem Bade ausgeschüttet: durch die extreme Reduktion der Phänomene auf jene, die besonders einfach sind und durch das Fehlen eines klaren Kriteriums, wie man der Gefahr entgeht, wichtige Phänomene schon im Vorfeld auszugrenzen, wurde die moderne empirische Wissenschaft selbst zu einer irrationalen dogmatischen Veranstaltung.

Es ist bezeichnend, dass die modernen empirischen Wissenschaften über keinerlei methodischen Überbau verfügen, ihre eigene Position, ihr eigenes Vorgehen rational und transparent zu diskutieren. Durch die vollständige Absage an Philosophie, Erkenntnistheorie, Wissenschaftsphilosophie — oder wie man die Disziplinen nennen will, die sich genau mit diesen Fragen beschäftigen — hat sich die empirische Wissenschaft der Neuzeit einer nachhaltigen Rationalität beraubt. Eine falsche Metaphysik zu kritisieren ist eines, aber sich selbst angemessen zu reflektieren, ein anderes. Und hier muss man ein Komplettversagen der modernen empirischen Wissenschaften konstatieren, was Maslow in seinem Buch über viele Kapitel, mit vielen Detailbeobachtungen aufzeigt.

DAS GANZE IST EIN DYNAMISCHES ETWAS

Würden die empirischen Wissenschaften irgendwann doch zur Besinnung kommen und ihren Blick nicht vor der ganzen Breite und Vielfalt der Phänomene verschließen, dann würden sie feststellen können, dass jeder Beobachter, Experimentator, Theoriemacher — und natürlich alle Menschen um sie herum — über ein reiches Innenleben mit einer spezifischen Dynamik verfügen, die kontinuierlich darauf einwirkt, was und wie wir denken, warum, wozu usw. Man würde feststellen, dass das Bewusstsein nur ein winziger Teil eines Wissens ist, das weitgehend in dem um ein Vielfaches größeren Unbewusstsein verortet ist, das unabhängig von unserem Bewusstsein funktioniert, kontinuierlich arbeitet, all unsere Wahrnehmung, unser Erinnern, unser Denken usw. prägt, das angereichert ist mit einer ganzen Bandbreite von Bedürfnissen und Emotionen, über deren Status und deren funktionale Bedeutung für den Menschen wir bislang noch kaum etwas wissen (zum Glück gab und gibt es Wissenschaften, die sich mit diesen Phänomenen beschäftigen, wenngleich mit großen Einschränkungen).

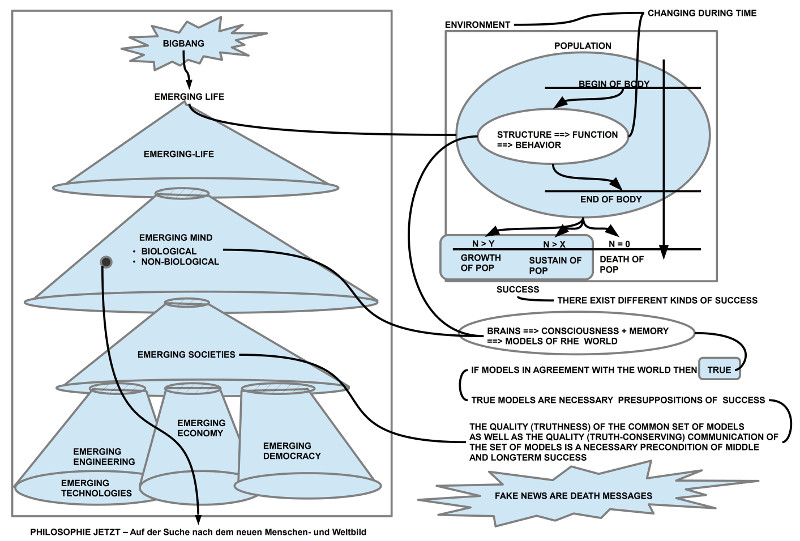

Und dann zeigt sich immer mehr, dass wir Menschen vollständig Teil eines größeren BIOMs sind, das eine dynamische Geschichte hinter sich hat in einem Universum, das auch eine Geschichte hinter sich hat. Alle diese Phänomene hängen unmittelbar untereinander zusammen, was bislang aber noch kaum thematisiert wird.

Das Erarbeiten einer Theorie wird zu einem dynamischen Prozess mit vielen Faktoren. Bei diesem Prozess kann man weder die primäre Wahrnehmung gegen konzeptuelle Modelle ausspielen, noch konzeptuelle Modelle gegen primäre Wahrnehmung, noch kann man die unterschiedlichen internen Dynamiken völlig ausklammern. Außerdem muss der Theoriebildungsprozess als gesellschaftlicher Prozess gesehen werden. Was nützt eine elitäre Wissenschaft, wenn der allgemeine Bildungsstand derart ist, dass Verschwörungstheorien als ’normal‘ gelten und ‚wissenschaftliche Theorien‘ als solche gar nicht mehr erkannt werden können? Wie soll Wissenschaft einer Gesellschaft helfen, wenn die Gesellschaft Wissenschaft nicht versteht, Angst vor Wissenschaft hat und die Wissenschaft ihrer eigenen Gesellschaft entfremdet ist?

BOTSCHAFT AN SICH SELBST?

Das biologische Leben ist das komplexeste Phänomen, das im bislang bekannten Universum vorkommt (daran ändert zunächst auch nicht, dass man mathematisch mit Wahrscheinlichkeiten herumspielt, dass es doch irgendwo im Universum etwas Ähnliches geben sollte). Es ist ein dynamischer Prozess, dessen Manifestationen man zwar beobachten kann, dessen treibende Dynamik hinter den Manifestationen aber — wie generell mit Naturgesetzen — nicht direkt beobachtet werden kann. Fasst man die Gesamtheit der beobachtbaren Manifestationen als Elemente einer Sprache auf, dann kann diese Sprache möglicherweise eine Botschaft enthalten. Mit dem Auftreten des homo sapiens als Teil des BIOMs ist der frühest mögliche Zeitpunkt erreicht, an dem das Leben ‚mit sich selbst‘ sprechen kann. Möglicherweise geht es gerade nicht um den einzelnen, wenngleich der einzelne im Ganzen eine ungewöhnlich prominente Stellung einnimmt. Vielleicht fängt die neue Wissenschaft gerade erst an. In der neuen Wissenschaft haben alle Phänomene ihre Rechte und es gibt keine Einzelwissenschaften mehr; es gibt nur noch die Wissenschaft von allen für alles ….

KONTEXT ARTIKEL

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.