Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 5.Dez. 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

Gerald M.Edelman, Bright Air, Brilliant Fire. On the Matter of the Mind, New York: 1992, Basic Books

DAS PROBLEM

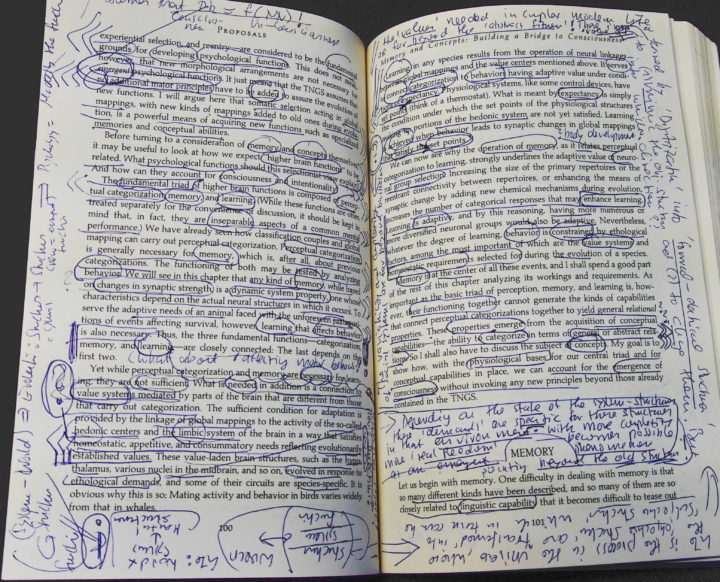

Bei der Relektüre von Edelman (siehe Überblick über alle bisherigen Beiträge HIER) stellt sich die Frage, um welche Theorie es hier überhaupt geht?

Es ist ein großes Verdienst von Edelman, dass er versucht, die Gehirnforschung nicht isoliert zu betrachten, sondern sehr wohl im Kontext von Bewusstsein und Verhalten, sehr wohl auch im Kontext einer Evolution des Lebens bzw. auch im Kontext von ontogenetischen Wachstumsprozessen. Als wäre dies noch nicht genug, stellt er gelegentlich auch explizite philosophische Überlegungen an oder wagt sich vor in den Bereich des Engineering, insofern er konkrete materielle Modelle von Gehirnen baut (mittels künstlicher neuronaler Netze), um die Plausibilität seiner Überlegungen zum Gehirn zu überprüfen. Nimmt man all dies ernst, dann findet man sich unversehens in einer Situation wieder, wo man nicht mehr so richtig weiß, um ‚welche Theorie von was‘ es hier eigentlich geht.

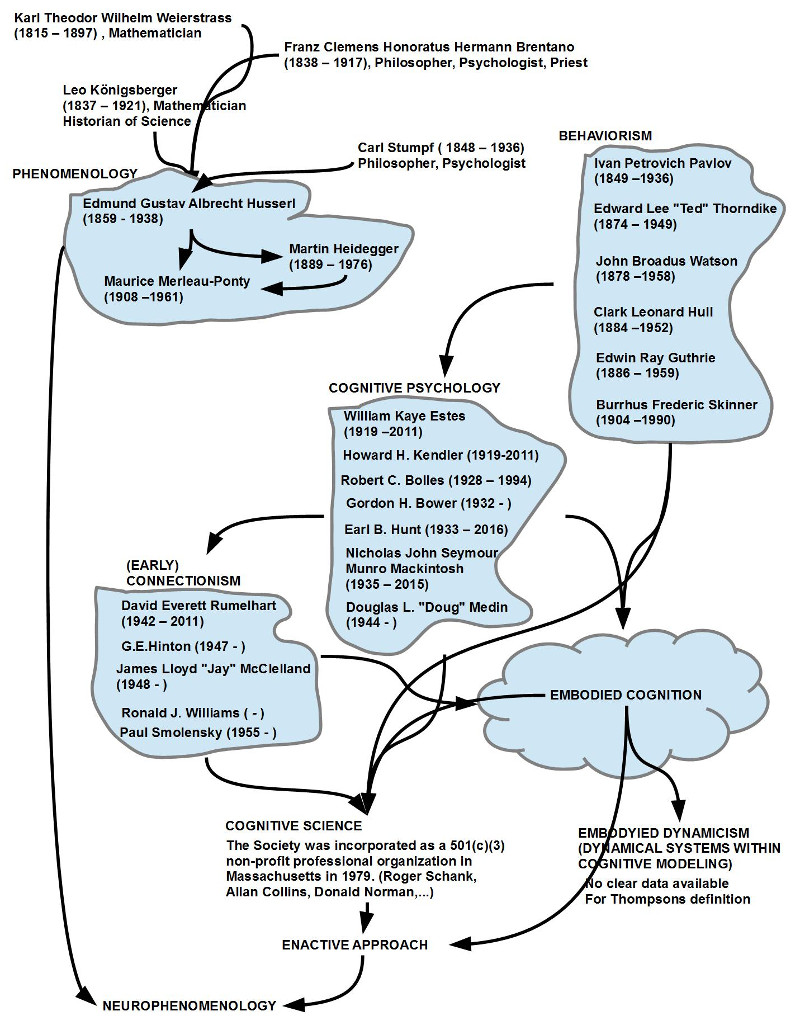

PANORAMA VON PHÄNOMENEN

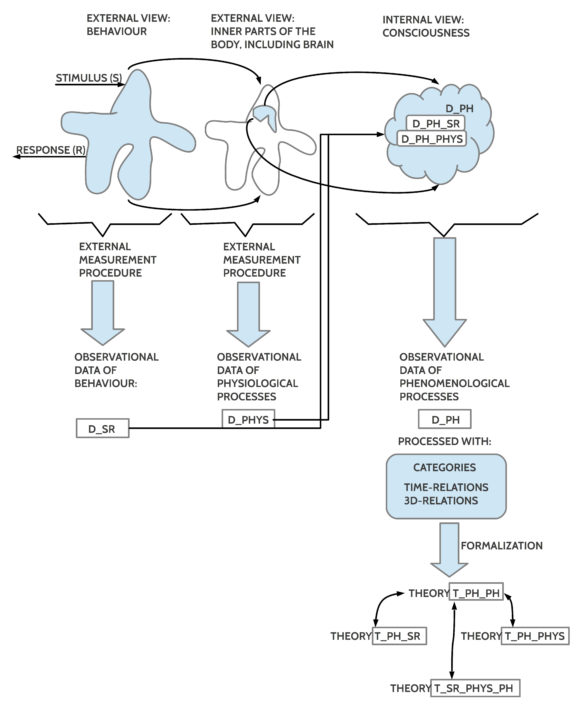

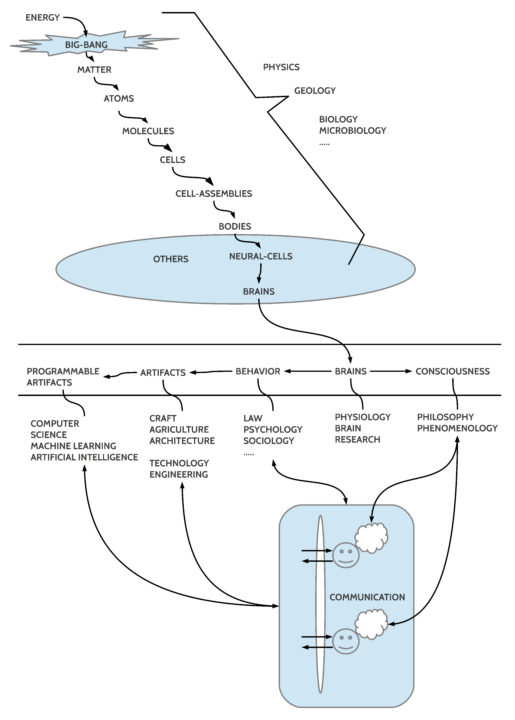

Versucht man die vielen Aspekte irgendwie zu ‚ordnen‘, die im Buch von Edelman aufscheinen, dann eröffnet sich ein breites Panorama von Phänomenen, die alle ineinander greifen (siehe Schaubild), und die – strenggenommen – auch genauso, in diesem dynamischen Zusammenhang, zu betrachten sind, will man die Eigenart dieser Phänomene ‚voll‘ erfassen.

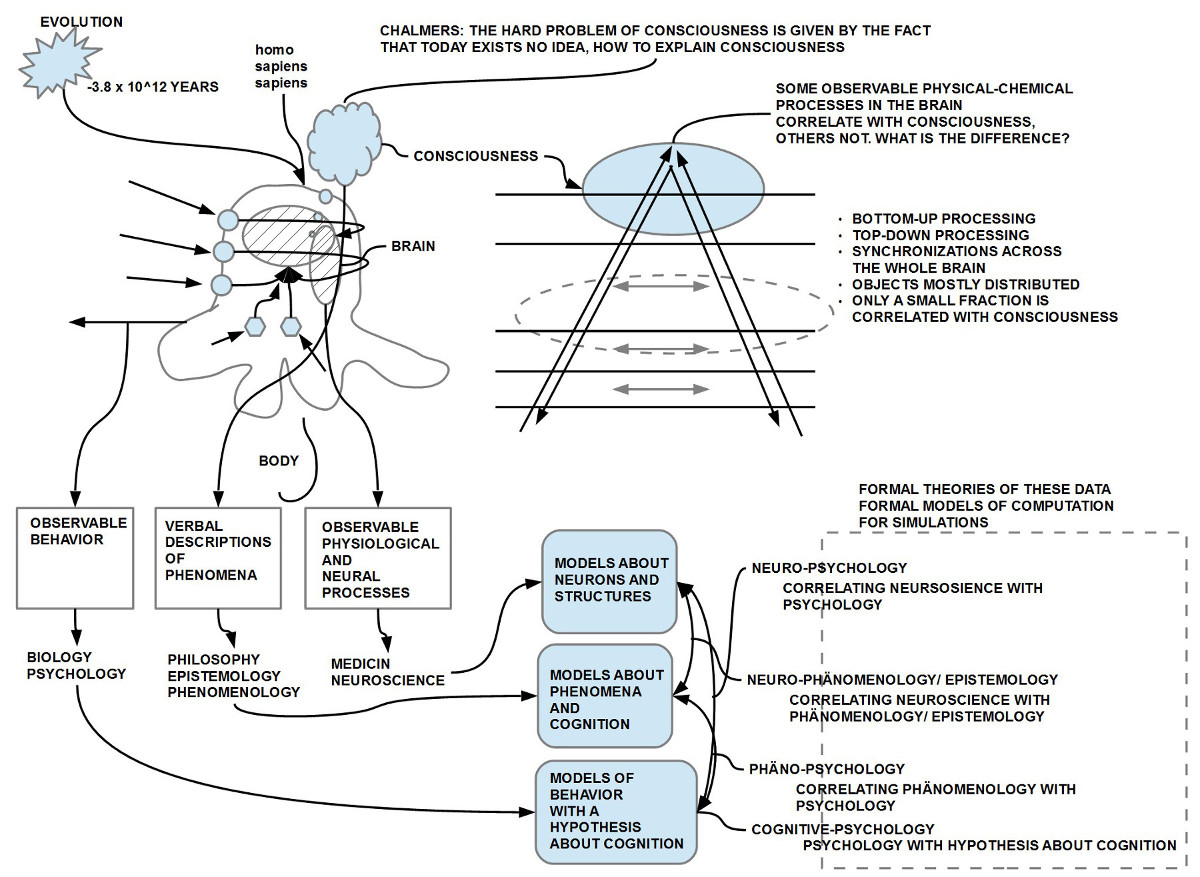

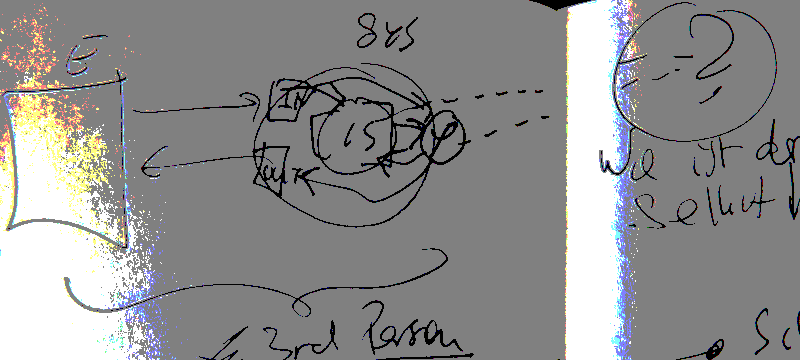

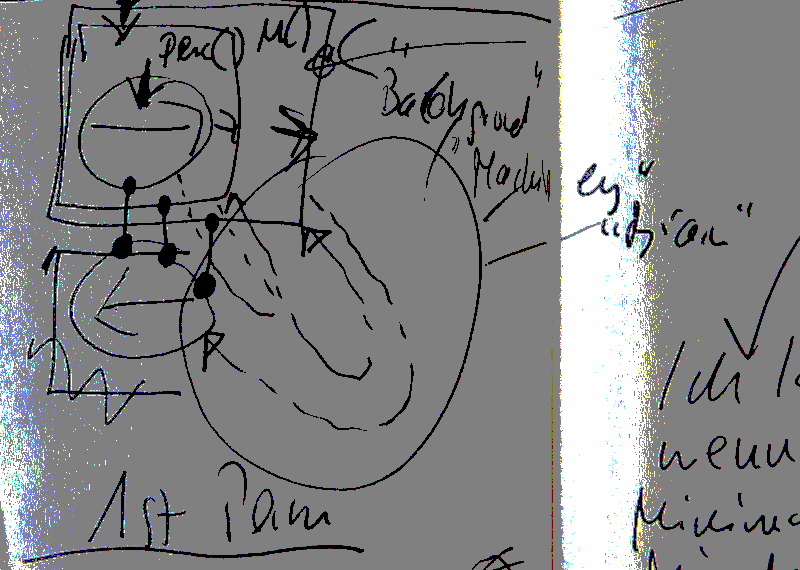

Eigentlich geht es Edelman um ein besseres Verständnis des ‚Gehirns‘. Doch kommt das Gehirn ja schon im Ansatz nicht alleine, nicht isoliert vor, sondern als Teil eines übergeordneten ‚Körpers‘, der von außen betrachtet (Dritte-Person Perspektive) ein dynamisches ‚Verhalten‘ erkennen lässt. Dieses Verhalten ist – im Fall des homo sapiens, also in unserem Fall als Menschen – nicht isoliert, sondern ist sowohl durch ‚Kommunikation‘ mit anderen Menschen ‚vernetzt‘ als auch durch vielfältige Formen von Interaktionen mit einer Welt der Objekte, von Artefakten, von Maschinen, und heute sogar ‚programmierbaren Maschinen‘, wobei letztere ein Verhalten zeigen können, das zunehmend dem menschliche Verhalten ‚ähnelt‘. Ferner konstatieren wir im Fall des homo sapiens in der Ersten-Person Perspektive noch etwas, das wir ‚Bewusstsein‘ nennen, das sich aber nur schwer in seiner Beschaffenheit kommunizieren lässt.

WISSENSCHAFTLICHE DISZIPLINEN

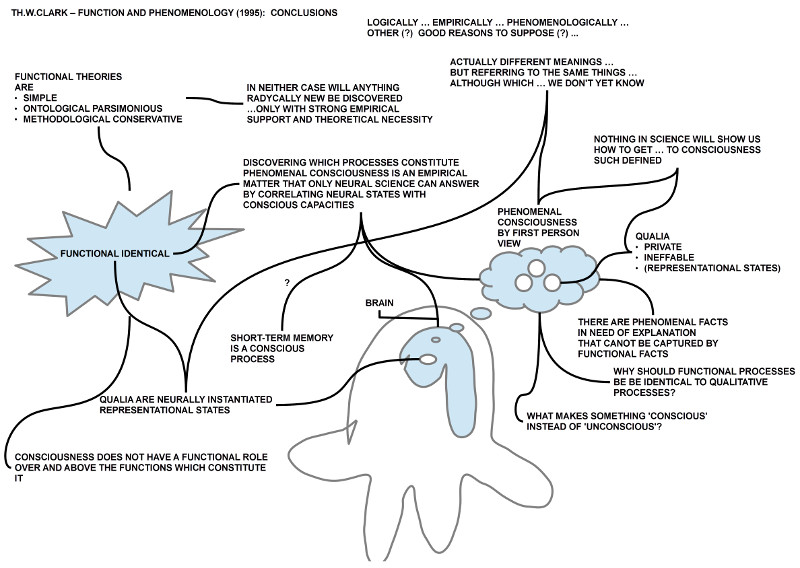

Im Versuch, die Vielfalt der hier beobachtbaren Phänomene beschreiben zu können, hat sich eine Vielzahl von Disziplinen herausgebildet, die sich — neben der Sonderstellung der Philosophie — als ‚wissenschaftliche Disziplinen‘ bezeichnen. ‚Wissenschaftlich‘ heißt hier in erster Linie, dass man die Phänomene des Gegenstandsbereichs nach zuvor vereinbarten Standards reproduzierbar ‚misst‘ und man nur solche so vermessenen Phänomene als Basis weitergehender Überlegungen akzeptiert. Das Paradoxe an dieser Situation ist – was Edelman auf S.114 auch notiert –, dass sich dieses wissenschaftliche Paradigma nur umsetzen lässt, wenn man Beobachter mit Bewusstsein voraussetzt, dass man aber zugleich im Ergebnis der Messung und der Überlegungen von dem ermöglichenden Bewusstsein (samt Gehirn) abstrahiert.

PHILOSOPHIE FÜR DEN ‚REST‘

Eine Konsequenz dieser ‚Abstraktion von den Voraussetzungen‘ ist, dass ein Wissenschaftler letztlich keine Möglichkeit hat, in ‚offizieller‘ Weise, über sich selbst, über sein Tun, und speziell auch nicht über die Voraussetzungen seines Tuns, zu sprechen. Ein solches sich selbst reflektierende Denken und Sprechen bleibt damit der Philosophie überlassen, die als solche bei der Entstehung der empirischen Wissenschaften offiziell vom Wissenschaftsbetrieb ausgeschlossen wurde. Als Wissenschaftsphilosophie hat die Philosophie zwar immer wieder versucht, sich dem empirischen Wissenschaftsbetrieb offiziell anzunähern, aber bis heute ist das Verhältnis von empirischen Wissenschaften und (Wissenschafts-)Philosophie aus Sicht der empirischen Wissenschaften ungeklärt. Für die empirischen Wissenschaften wundert dies nicht, da sie sich von ihrem methodischen Selbstverständnis her auf ihre isolierte Betrachtungsweisen verpflichtet haben und von diesem Selbstverständnis her sich jeder Möglichkeit beraubt haben, diese Isolation mit den typischen wissenschaftlichen Bordmitteln aufzubrechen. Allerdings produziert dieses ’selbst isolierende Paradigma‘ immer mehr Einzeldisziplinen ohne erkennbaren Zusammenhang! Es ist nur eine Frage der Zeit, bis wann sich diese Explosion der nicht-integrierten Einzelbilder selbst zerstört.

ANSPRUCH, ALLES ZU ERKLÄREN

Die Wissenschaften selbst, allen voran die Physik, kennen sehr wohl den Anspruch, mit ihrer Arbeit letztlich ‚alles aus einer Hand‘ zu erklären (z.B. formuliert als ‚Theory of Everything (ToE)‘ oder mit dem Begriff der ‚Weltformel‘), doch sowohl die konkrete Realität als auch grundlegende philosophische und meta-theoretische Untersuchungen legen eher den Schluss nahe, dass dies vom Standpunkt einer einzelnen empirischen Wissenschaft aus, nicht möglich ist.

VISION EINES RATIONALEN GESAMT-RAHMENS

Um also die Vielfalt der einzelnen wissenschaftlichen Disziplinen zu bewahren, mehr noch, um sie in ihren inhaltlichen und methodischen Beschränkungen untereinander transparent und verständlich zu machen, wird man die (philosophische) Arbeitshypothese aufstellen müssen, dass die Rationalität der Einzelwissenschaften letztlich nur aufrecht erhalten werden kann, wenn man sowohl für jede Einzelwissenschaft wie auch für ihr Zusammenspiel eine rationale Begründung sichtbar machen kann, die für alle ‚gilt‘. Ein solcher Rationalitätsanspruch ist nicht zu verwechsel mit der alten Idee einer einzelwissenschaftlichen ‚Weltformel‘ oder einer einzelwissenschaftlichen ‚Theory of Everything‘. Eher eignet sich hier das Paradigma einer kritischen Philosophie von Kant, die nach der Voraussetzung für den Wahrheitsanspruch einer Theorie fragt. Während Kant allerdings die Frage nach den Voraussetzungen bei den Grenzen des Bewusstseins mangels verfügbarem Wissens enden lassen musste, können wir heute – auch Dank der Arbeiten von Edelman und anderen – diese Grenzen weiter hinausschieben, indem wir die Voraussetzungen des Bewusstseins einbeziehen. Eine solche bewusste Erweiterung der philosophischen Frage nach den Voraussetzungen des menschlichen Erkennens über die Grenzen des Bewusstseins hinaus führt dann nicht nur zum ermöglichenden Gehirn und dem zugehörigen Körper, sondern geht dann weiter zur umgebenden Welt und ihrer Dynamik, die sich im Evolutionsgeschehen und in der Entstehung des bekannten Universums zeigt.

PHILOSOPHIE UND WISSENSCHAFTEN

Die schon immer nicht leichte Aufgabe des philosophischen Denkens wird mit diesen methodischen Erweiterungen keinesfalls einfacher, sondern erheblich schwieriger. Andererseits muss die Philosophie diese Reflexionsarbeit nicht mehr alleine leisten, sondern sie kann die ganze Fülle der einzelwissenschaftlichen Arbeiten aufgreifen, um sie dann in einem gemeinsamen Rationalitätsrahmen neu anzuordnen.

Beispiele für Integrationsbemühungen gibt es sogar seitens der Einzelwissenschaften, wenngleich meistens methodisch wenig überzeugend. So versuchen Gehirnforscher schon seit vielen Jahren Zusammenhänge zwischen messbaren Aktivitäten des Gehirns und des beobachtbaren Verhaltens (unter dem Label ‚Neuropsychologie‘) oder zwischen messbaren Aktivitäten des Gehirns und Erlebnissen des Bewusstseins (kein wirkliches Label; man würde ‚Neurophänomenologie‘ erwarten) heraus zu finden. Bislang mit begrenztem Erfolg.

Bei aller Problematik im Detail kann es aber nur darum gehen, die ungeheure Vielfalt der Phänomene, wie sie die Einzelwissenschaften bislang zutage gefördert haben, vor-sortiert in einer Vielzahl von Arbeitshypothesen, Modellen und Theoriefragmenten, in einen von allen akzeptierbaren Rationalitätsrahmen einordnen zu können, der eine Gesamt-Theorie reflektiert, die als solche möglicherweise immer unvollendet bleiben wird

WOMIT FANGEN WIR AN?

Damit stellt sich ganz praktisch die Frage, wo und wie soll man anfangen? Das Buch von Edelman kann erste Hinweise liefern.

- KEINE WISSENSINSELN: Am Beispiel des homo sapiens wird deutlich, dass ein Verständnis von Bewusstsein, Gehirn, Körper, Verhalten und hier insbesondere die symbolische Kommunikation je für sich nicht gelingen kann. Und Edelman demonstriert eindrücklich, dass man zusätzlich die ontogenetische und evolutive Dimension einbeziehen muss, will man zu einem befriedigenden Verständnis kommen.

- INTEGRATION VON EINZELWISSEN: Man muss also Wege finden, wie man diese verschiedenen Aspekte in einem gemeinsamen Rationalitätsrahmen so anordnen kann, dass sowohl die einzelwissenschaftliche Methodik gewahrt bleibt, wie auch eine ‚Integration‘ all dieser Aspekte auf einer ‚gemeinsamen Ebene‘ möglich wird, die dabei von den Einzelwissenschaften nicht ‚isoliert‘ ist.

- META-WISSEN ALS LEITFADEN: Das geforderte Vorgehen betrachtet die konkreten einzelwissenschaftlichen Erklärungsansätze als einen ‚Gegenstand sui generis‘, macht also die Einzelwissenschaften zu ‚Untersuchungsgegenständen‘. Dies entspricht dem Paradigma der Wissenschaftsphilosophie.

- NEUE WISSENSCHAFTSPHILOSOPHIE: Mit Blick auf die Geschichte der modernen Wissenschaftsphilosophie (etwa seit dem Wiener Kreis) muss man dafür offen sein, dass das Paradigma der Wissenschaftsphilosophie für diese Aufgabenstellung möglicherweise neu zu formatieren ist.

- KOMMUNIKATIONSPROZESS ALS RAHMEN: So liegt es nahe, zu sagen, es gehe nicht primär um einen isolierten Theoriebegriff, sondern um einen Kommunikationsprozess, der Kommunikationsinhalte generiert, die im Rahmen des Kommunikationsprozesses ‚verstehbar‘ sein sollen.

- SYSTEMS-ENGINEERING ALS BEISPIEL: Ein modernes Beispiel für einen problemorientierten Kommunikationsprozess findet sich im Paradigma des modernen Systems-Engineering. Auslöser des Kommunikationsprozesses ist eine ‚Frage‘ oder eine ‚Problemstellung‘, und der Kommunikationsprozess versucht nun durch Ausnutzung des Wissens und der Erfahrungen von allen Beteiligten einen gemeinsames Bild von möglichen Lösungen zu generieren. Zu Beginn werden alle Kriterien kenntlich gemacht, die für die intendierte Lösung berücksichtigt werden sollen.

- EINBEZIEHUNG AUTOMATISIERTEN WISSENS: Insbesondere soll der Kommunikationsprozess so ausgelegt sein, dass er den Einsatz moderner Wissenstechnologien wie z.B.. ‚Interaktive Simulationen‘, ‚Kommunikationstests‘, ‚benutzerzentrierte künstliche Intelligenz‘, sowie automatisierte ‚Simulationsbibliotheken‘ erlaubt.

Dies ist nur eine erste, noch sehr vage Formulierung. Es wird notwendig sein, diese anhand von vielen Beispielen weiter zu konkretisieren und zu verfeinern.

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER.