Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 11.-12.Februar 2021

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Letzte Änderung: 23.Februar 2021: (i) Querverweis zu meiner philosophischen Position vom 8.Dezember 2008! (ii) Querverweis zum Aspekt der kognitiv verschränkten Personen, die sich im Alltag in verteilten Einzelaktionen manifestieren.

KONTEXT

In diesem Beitrag soll das Konzept einer praktischen kollektiven Mensch-Maschine Intelligenz by design an einem konkreten Beispiel durchgespielt werden. Als Rahmen wird das vorausgesetzt, was in dem vorausgehenden Beitrag INGENIEURE UND DAS GLÜCK. Anmerkung 1 [1] vorgestellt wurde.

RAHMENANNAHMEN – FRAMEWORK

Im vorausgehenden Beitrag wurde der Gesamtrahmen wie folgt kurz charakterisiert:

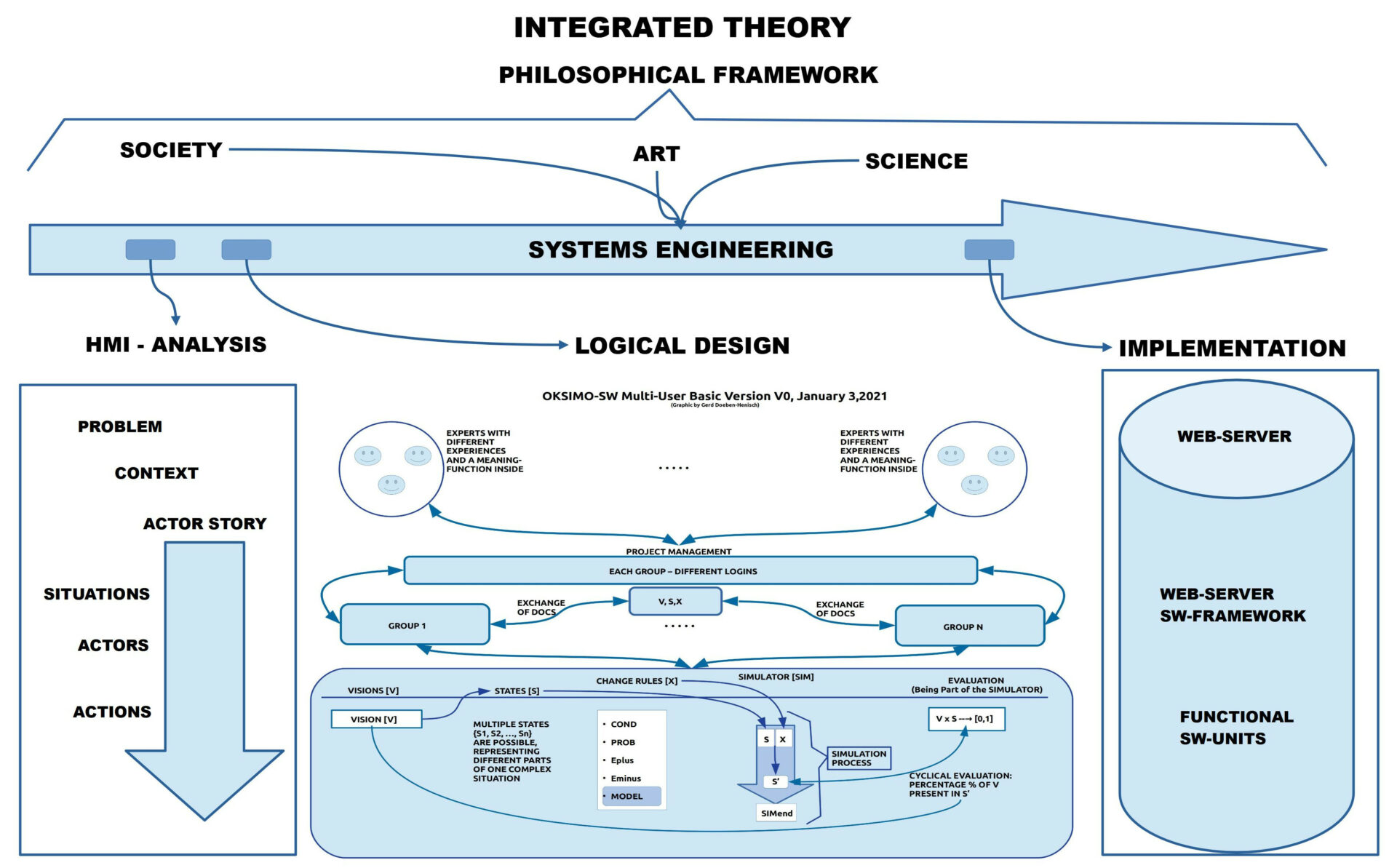

Zum Konzept einer integrierten Theorie des Engineerings [2] gehören die folgenden (stark vereinfachten) Wissensdimensionen:

- Ein wissenschaftsphilosophischer Rahmen, der die Einbettung der Engineering-Prozesse in die Alltagswelt, in die Gesellschaft, in die umgebende Realität ermöglicht.[1b]

- Der Engineering-Prozess selbst, in dem Ingenieure und Manager als Experten einen Prozess starten, organisieren und zu einer nachhaltigen Lösung führen.

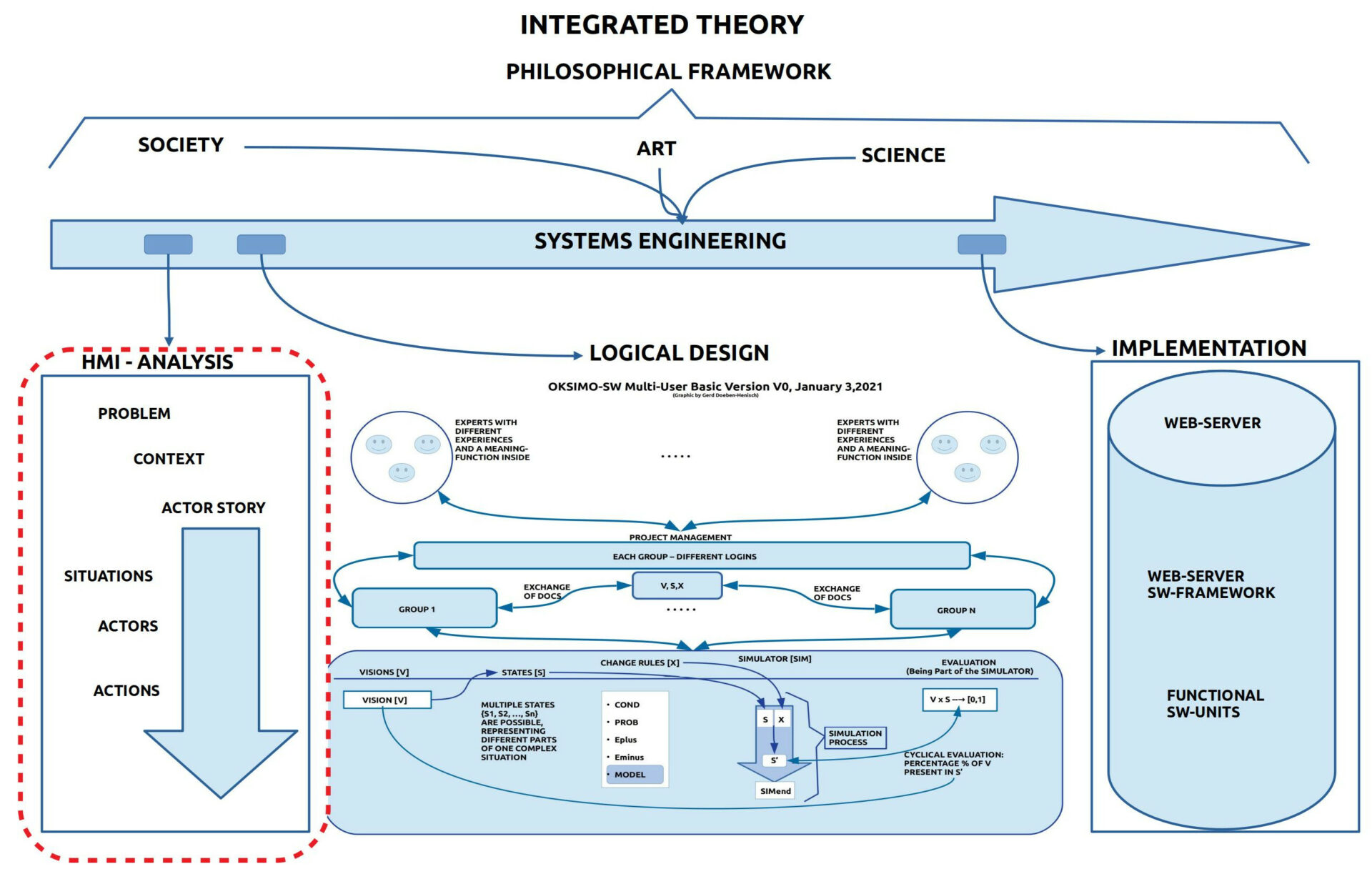

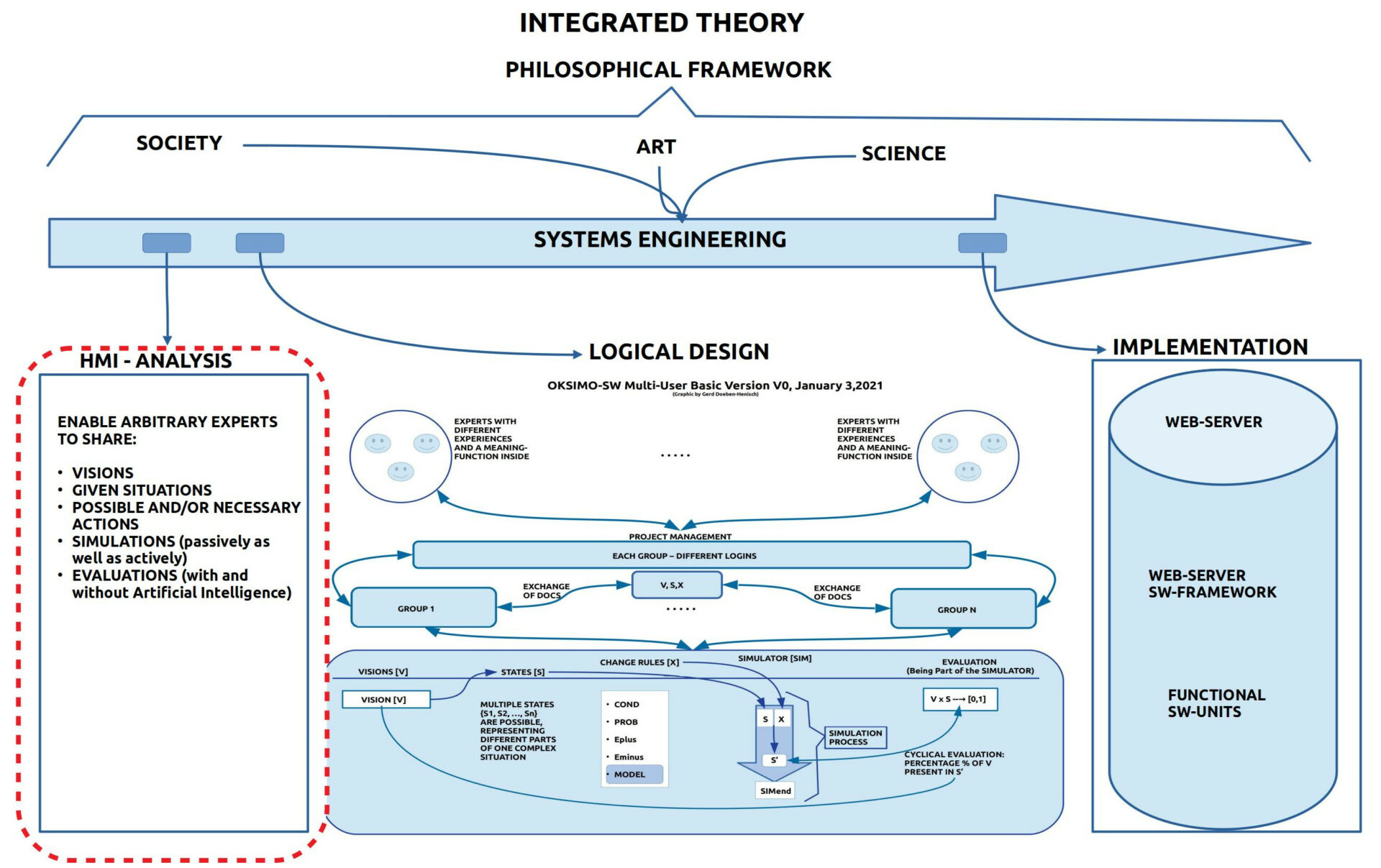

- Innerhalb des Engineering Prozesses nimmt die Analyse der Mensch-Maschine Interaktion [MMI] (Engl. oft auch Human-Machine Interaction [HMI]) eine fundamentale Rolle ein: hier wird analysiert welche Problem unter Berücksichtigung welcher Kontexte (Rahmenbedingungen, Ziele,…) so umgesetzt werden sollen, dass die intendierten Anwender die neue Lösung optimal nutzen können. Im vorliegenden Fall soll es möglich gemacht werden, dass beliebige Anwender beliebige Problemstellung mit Alltagssprache kommunizieren, modellieren und simulieren können einschließlich diverser Bewertungsverfahren (Ein Teil der Bewertungsverfahren können intelligente Algorithmen (volkstümlich: Künstliche Intelligenz [KI]) beinhalten).[1c]

- Im logischen Design, das auf der MMI-Analyse aufbaut, wird im Rahmen einer abstrakten mathematischen Struktur festgelegt, wie die gewünschten Systemleistungen organisiert werden sollen. Die mathematische Struktur muss so sein, dass sie sich formal in eine Menge von Algorithmen abbilden lässt, die sich mit einer verfügbaren Programmiersprache implementieren lassen.

- In der Implementierung wird dann die logische Analyse in ein konkretes funktionierendes technisches System umgesetzt. Im konkreten Fall handelt es sich um eine bestimmte Software, die auf Servern läuft, die als Knoten im Internet funktionieren. Der Anwender kann mit dieser Software über interaktive Internetseiten kooperieren.

Im folgenden Text wird der Aspekt der Mensch-Maschine Analyse näher betrachtet.

FOKUS AUF die Analyse der MENSCH-MASCHINE INTERAKTION

Ich hatte einige Jahre eine Vorlesung zu diesem Thema und hatte anlässlich dieser Vorlesung den Versuch unternommen, aktuelle Konzepte der Mensch-Maschine Interaktion [MMI] im Kontext des Systems Engineering [SE] und unter dem Blickwinkel einer formalen Theorie zu rekonstruieren.[3] Zumindest die Grundlinien dieses Konzeptes sind erkennbar.

WELCHE EXPERTEN?

Durch die Erweiterung des Kontextes über das klassische Engineering hinaus hinein in beliebige gesellschaftliche Kontexte mit beliebigen potentiellen Anwendern — also auch Bürger, Büroangestellte, Lokalpolitiker, Jugendliche, Schüler … — und durch Verschiebung des Hauptprozesses weg von ausgewählten Experten hin zum allgemeinen Expertentum, ergab sich eine Form von Generalisierung, innerhalb deren das klassische Systems Engineering nur noch ein Spezialfall ist. Aus den verteilten Akteuren im klassischen Systems Engineering wird jetzt die Population der allgemeinen Experten [PAE], die sich zu jeder Zeit an jedem Ort aus beliebigen Menschen rekrutieren können. Dies versucht der Tatsache Rechnung zu tragen, dass für die Zukunft entscheidend ist, dass wir über eine hinreichend große Vielfalt verfügen, wobei wir selbst nur sehr bedingt fähig sind, in der Gegenwart zu entscheiden, wer jetzt der richtige Experte ist. Am Beispiel der Kommunen ist ganz klar, dass die wenigen Bürger, die als Kommunalpolitiker gewählt werden, in keinster Weise repräsentative sind für das Wissen, die Erfahrungen, die Intelligenz, die Visionen, die sich in einer Kommune in der Gesamtheit der Bürger verkörpern. Diese Diskrepanz ist gravierend. Sie nicht zu überbrücken wäre in höchstem Maße fahrlässig für die Gestaltung unserer Zukunft.

PRAKTISCHE KOLLEKTIVE INTELLIGENZ?

In einer ersten Annäherung — und zugleich Vereinfachung — könnte man die Gesamtheit des Wissens und der Erfahrung, die sich in den Bürgern einer Kommune vorfindet, Kollektive Intelligenz nennen [4]. Hier geht es — wie jeder aus seiner Erfahrung von Kommunen selbst ergänzen kann — aber nicht nur um das Wissen, das Kognitive im engeren Sinne, sondern um solches Wissen, das in Form von Erfahrungen auch handlungsfähig ist, das sich im Handeln herausbildet, das verflochten ist mit einem ganzen Netzwerk von emotionalen Faktoren, Motiven und Werten. Ein solches Wissen im erweiterten Sinne nenne ich hier Praktisches Kollektives Wissen [PKW].

Vor 100 oder mehr Jahren wäre damit alles gesagt. Im Zeitalter der Digitalisierung reicht dies aber nicht mehr.

MENSCH-MASCHINE SYMBIOSE

Mit der zunehmenden Durchdringung unseres Alltags mit Computern, also mit programmierbaren Maschinen, die ansatzweise die biologische Intelligenz nachbilden können, stellen wir fest, dass wir Menschen im Alltag, in unserem menschlichen Handlungsraum, zunehmend mit solchen Computern interagieren. Das Innere dieser Computer ist den meisten weitgehend unbekannt, selbst ihre Oberfläche (das System Interface, die Systemschnittstelle) lässt sich immer öfter nicht mehr direkt erkennen, da die Computer über Sensoren und Aktoren direkt oder vermittelt über andere Objekte und Geräte in unserem Alltag mit uns interagieren. Und hinter dieser kaum wahrnehmbaren Oberfläche tauschen diese Computer mit anderen Computern immer größere Datenmengen aus, die wir als Menschen gar nicht mitbekommen.

Aus Sicht der Mensch-Maschine Interaktion kann und muss man die Frager stellen, welche Rolle wir auf lange Sicht dem Computer einerseits und dem Menschen andererseits zuordnen wollen. Grundsätzlich kann man drei typische Rollen unterscheiden:

- Den Computer so weiter entwickeln, dass er letztlich in allen Belangen den Menschen übertrifft und letztlich den Menschen nicht mehr braucht. Kennwort: Super-Human Computing.

- Den Computer so unvollständig und dumm lassen, dass er den Menschen grundsätzlich nicht gefährden und beeinträchtigen kann. Kennwort: Inferior-Human Computing.

- Den Computer maximal entwickeln, aber in Sandbox-Artigen Problemräumen. Kennwort: Man-Machine Computing.

Die Variante Inferior-Human Computing ist eigentlich schon aus dem Rennen, da der Computer in Teilbereichen den Menschen schon jetzt haushoch übertrifft. Und in dieser Rolle hat der Computer schon jetzt massive Auswirkungen z.B. auf Arbeitsprozesse, Geschäftsmodelle, ganze Marktmodelle, auf die Kriegsführung, auf die gesamte Technologiebranche, auf die Forschung, selbst auf die Kunst und die gesamte Unterhaltungsindustrie. Was wir hier haben ist schon eine Art von mindestens partiellem Super-Human Computing. Dass die Vielzahl der Beispiele in diesem Bereich die Fantasie anregen, ist verständlich.

Beispiele für Super-Computing innerhalb eines Problemraumes, der als Sandbox dient, wobei der Problemraum ausschließlich von Menschen konstituiert wird, sind bislang nicht wirklich bekannt. In einer solchen Umgebung — wie sie die oksimo Software ermöglicht — können Menschen die ganze Fülle ihres Wissens gemeinsam und strukturiert als Problemraum einbringen, der beständig abgeändert und kumulativ — Prinzip Wikipedia — erweitert werden kann. Relativ dazu kann man beliebig viele intelligente Programme zum Einsatz bringen, die diesen Problemraum erkunden, erforschen, erlernen und seine formalen Möglichkeiten entsprechend den verfügbaren Bewertungsprofilen auswerten und selbständig optimieren. In diesem Kontext könnten die programmierbaren Maschinen sogar die Bewertungskriterien fallweise abändern, um weitere alternative Lösungen sichtbar zu machen. Während die Menschen in dieser Konstellation die volle Breite ihres Wissens samt Bewertungsstrukturen für sich selbst und füreinander sichtbar machen können, können die lernfähigen Programme aus den für Menschen schwer erfassbaren kombinatorischen Räumen jene Teilbereiche identifizieren, die im Lichte von bestimmten Kriterien besonders günstig erscheinen. In einem solchen Sandbox-Vermittelten Miteinander können die Menschen ihr Optimum ausleben und dazu programmierbare Maschinen benutzen, die ihrerseits ihr Optimum bis an die Grenzen der Berechenbarkeit ausdehnen. In dieser Mensch-Maschine Symbiose eines Man-Machine Computing könnten die beteiligten Computer beliebig gut werden ohne dem Menschen schaden zu können (in der Regel ist nicht die Maschine sondern der Mensch sich selbst nicht nur der potentiell größte Freund, sondern auch der potentiell größte Feind; Freiheit ist eben real …).

DESIGN EINER KOLLEKTIVEN ZUKUNFTSMASCHINE

Wie eingangs angedeutet, geht es im Rahmen der Analyse der Mensch-Maschine Interaktion darum, unter Vorlage einer groben Problemstellung [P] mitsamt einer groben Vision [V] (idealerweise in einem Problem-Visions-Dokument festgehalten) im einzelnen zu klären, wie dieses Aufgabenstellung so umgesetzt werden kann, dass die Auftraggeber zufrieden sind.

Im Normalfall sind die Auftraggeber und die späteren Anwender unterschiedliche Akteure. Im konstitutiven Fall werden Anwender zu ihren eigenen Auftraggebern, um etwas zu finden, was dazu beiträgt, ihre aktuelle Situation zu verbessern.

Im Fall der oksimo Software und des damit angezielten Paradigmas einer neuen allgemeinen Zukunftsmaschine liegt eher der konstitutiver Fall vor: allseits kann man heute ein Mangel an solchen Diskursräumen feststellen, in denen beliebige Experten gemeinsam Problemräume [6] aufspannen, innerhalb deren sie Lösungswege sichtbar machen und gemeinsam bewerten. Zusätzlich sollte ein Maximum an lernenden Algorithmen für diese Problemräume verfügbar gemacht werden können.

BY DESIGN

Die Erfahrungen des Alltags zeigen, dass die wenigsten Menschen aus dem Stand heraus in der Lage sind, zusammen mit anderen konstruktiv eine — oder gar mehrere — mögliche Zukunft (Zukünfte) zu denken: weder in den großen Linien, noch in den vielen Details und Querwirkungen. Die Vision der oksimo Software ist es nun, einen kompletten Rahmen für das gemeinsame Entwickeln von möglichen Zukünften ‚by design‘ zur Verfügung zu stellen, und das nur mit den Mitteln der Alltagssprache: miteinander reden; Gegenwart beschreiben; mögliche zukünftigen Szenarien aussprechen; mögliche Aktionen suchen, die von der Gegenwart in die Zukunft führen; sich die bisherigen Überlegungen immer wieder als Prozess vorführen zu lassen, ob es schon funktioniert; Rückmeldungen bekommen, wieweit man schon ist ….

QUELLENANGABEN

[1a] Gerd Doeben-Henisch, 6.Febr.2021, INGENIEURE UND DAS GLÜCK. Anmerkung 1, https://www.cognitiveagent.org/2021/02/06/ingenieure-und-das-glueck-anmerkung-1/

[1b] Gerd Doeben-Henisch, 8.Dez.2012, EIN ABEND MIT DEM SALON SLALOM, https://www.cognitiveagent.org/2012/12/08/ein-abend-mit-dem-salon-slalom-vorlaufig-bilder-und-endredaktion-fehlt-noch/ . Dieser Text beschreibt ziemlich umfassend meine philosophische Position am Ende des Jahres 2008 (dazu ein bisschen ‚Musik-Philosophie‘ mit praktischen Beispielen). Letztlich sind es diese philosophischen Gedanken, die den Hintergrund bilden für die nachfolgenden und auch heutigen Überlegungen.

[1c] Gerd Doeben-Henisch, 5.Dezember 2020, SW. Software? Müssen wir umdenken? Notiz, https://www.cognitiveagent.org/2020/12/05/sw-software-muessen-wir-umdenken-notiz/ //* In der ‚klassischen‘ MMI-Analyse liegt der Fokus eher auf dem unmittelbaren Interaktionsfeld zwischen Anwendern und System-Interface. Dies legt sich nahe, da die konkrete Spezifikation des System-Interfaces nur unter Voraussetzung von möglichst konkreten Interaktionsbeschreibungen gelingen kann. Wie aber der hier zitierte Beitrag deutlich zu machen versucht, ist Alltagshandeln von Menschen durchtränkt von konkreten Aktionen, die im Menschen Teil von kognitiv verankerten Rollen/ Protokollen sind, durch die viele einzelne zu einer verschränkten Person werden, deren Einzelhandeln nicht verstanden werden kann, wenn man nicht diese kognitive Verschränktheit berücksichtigt. Diese Dimension des Anwenderverhaltens ist bislang aber noch nicht wirklich in MMI-Analysen eingebunden.*//

[2] Der Begriff einer ‚Integrierten Theorie des Engineerings‘ [ITE] ist klar abzugrenzen von dem Konzept der ‚Integralen Theorie‚, wie es von Ken Wilbert und vielen anderen vertreten wird, siehe z.B.: https://de.wikipedia.org/wiki/Integrale_Theorie

[3] Gerd Doeben-Henisch, Distributed Actor-Actor Interaction [DAAI], 18.Januar 2020, Version 1 5 . 0 6 . 0 7, https://www.uffmm.org/wp-content/uploads/2019/05/aaicourse-15-06-07.pdf

[4] Stichwort ‚Kollektive Intelligenz‘ in Wikipedia [DE]: https://de.wikipedia.org/wiki/Kollektive_Intelligenz

[5] Stichwort ‚Sandbox‘, Wikipedia [DE]: https://de.wikipedia.org/wiki/Sandbox

[5b] Stichwort ‚Sandbox‘ in Wikipedia [EN]: https://en.wikipedia.org/wiki/Sandbox_(software_development)

[6] Im Sprachspiel von Russel und Norvig wird unter einem ‚Problemraum‘ ein ‚Zustandsraum‘ (Engl.: state space) (S.67) verstanden. Im Prinzip lässt sich der ’state space‘ von Norvig und Russell im hier benutzten Konzept des ‚Problem-Raumes‘ abbilden. Siehe später im Text. Stuart Russell und Peter Norvig, Artificial Intelligence: A Modern Approach, Global Edition (Englisch) Taschenbuch, Herausgeber : Addison Wesley; 3. Edition (18. Mai 2016) Sprache : Englisch, Taschenbuch : 1132 Seiten ISBN-10 : 1292153962 ISBN-13 : 978-1292153964

FORTSETZUNG

Eine Fortsetzung findet sich HIER.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.