(16.Juni 2023 – 19.Juni 2023, 15:15h)

KONTEXT

Die Bedeutung und die Befolgung von moralischen Werten im Kontext des alltäglichen Handelns hat schon immer für Spannungen, Diskussionen und handfeste Konflikte gesorgt.

In diesem Text soll kurz beleuchtet werden, warum dies so ist, und warum dies vermutlich nie anders sein wird, so lange wir Menschen so sind, wie wir sind.

ENDLICHE-UNENDLICHE WELT

In diesem Text wird angenommen, dass die Wirklichkeit, in der wir uns von Kindheit an ‚vorfinden‘, eine ‚endliche‘ Welt ist. Damit ist gemeint, dass kein Phänomen, auf das wir in dieser Welt stoßen — wir selbst mit eingeschlossen — ‚unendlich‘ ist. Anders ausgedrückt: alle Ressourcen, auf die wir stoßen, sind ‚begrenzt‘. Auch die ‚Sonnenenergie, die im heutigen Sprachgebrauch als ‚erneuerbar‘ angesehen wird, ist ‚begrenzt‘, wenngleich diese Begrenzung die Lebenszeit vieler Generationen von Menschen überdauert.

Diese ‚Endlichkeit‘ ist aber kein Gegensatz dazu, dass sich unsere endliche Welt kontinuierlich in einem ‚Veränderungsprozess‘ befindet, der von vielen Seiten gespeist wird. Eine ’sich-selbst-verändernde Endlichkeit‘ ist damit ein Etwas, was an und in sich irgendwie ‚über sich hinaus weist‘! Die ‚Wurzeln‘ dieser ‚immanenten Veränderlichkeit‘ sind weitgehend vielleicht noch unklar, aber die ‚Auswirkungen‘ der immanenten Veränderlichkeit‘ deuten an, dass das jeweils ‚konkret Endliche‘ nicht das Entscheidende ist; das ‚jeweils konkret Endliche‘ ist eher eine Art ‚Indikator‘ für eine ‚immanente Veränderungsursache‘, die sich mittels konkreter Endlichkeiten in Veränderung ‚manifestiert‘. Die ‚Formen konkreter Veränderungsmanifestationen‘ können daher vielleicht eine Art ‚Ausdruck‘ sein, von etwas, was ‚dahinter immanent wirkt‘.

In der Physik gibt es das Begriffspaar ‚Energie‘ und ‚Masse‘, letztere als Synonym für ‚Materie‘. Atomphysik und Quantenmechanik haben uns gelehrt, dass die verschieden ‚Manifestationen von Masse/ Materie‘ nur eine ‚Zustandsform von Energie‘ sein können. Die überall und immer angenommene ‚Energie‘ ist jener ‚Ermöglichungsfaktor‘, der sich in all den bekannten Formen von Materie ‚manifestieren‘ kann. ‚Sich-verändernde-Materie‘ kann man dann verstehen als eine Form von ‚Information‘ über die ‚ermöglichende Energie‘.

Setzt man das, was die Physik bislang über ‚Energie‘ herausgefunden hat, als jene Form von ‚Unendlichkeit‘, die sich uns über die erfahrbare Welt erschließt, dann sind die verschiedenen ‚Manifestationen von Energie‘ in diversen ‚Formen von Materie‘ Formen konkreter Endlichkeiten, die aber im Kontext der unendlichen Energie letztlich nicht wirklich endlich sind. Alle bekannten materiellen Endlichkeiten sind nur ‚Übergänge‘ (‚Transitionen‘) in einem nahezu unendlichen Raum von möglichen Endlichkeiten, der letztlich in der ‚unendlichen Energie‘ gründet. Ob es ’neben‘ oder ‚hinter‘ oder ‚qualitativ nochmals ganz anders zu‘ der ‚erfahrbaren Unendlichkeit‘ noch eine ‚andere Unendlichkeit‘ gibt, ist damit völlig offen.[1]

ALLTAGSERFAHRUNGEN

Unser normale Lebenskontext ist das, was wir heute ‚Alltag‘ nennen: ein Bündel von regelmäßigen Abläufen, vielfach verbunden mit charakteristischen Verhaltens-Rollen. Dazu gehört die Erfahrung, einen ‚endlichen Körper‘ zu haben; dass ‚Abläufe real Zeit benötigen‘; dass jeder Prozess durch seinen eigenen ‚typischen Ressourcenverbrauch‘ charakterisiert ist; dass ‚alle Ressourcen endlich‘ sind (wobei es hier unterschiedliche Zeit-Skalen geben kann (siehe das Beispiel mit der Sonnenenergie)).

Aber auch hier: das ‚Eingebettet-Sein‘ aller Ressourcen und ihr Verbrauch in eine umfassende Veränderlichkeit macht aus allen Angaben ‚Momentaufnahmen‘, die ihre ‚Wahrheit‘ nicht allein ‚im Moment‘ haben, sondern in der ‚Gesamtheit der Abfolge‘! An sich ‚kleine Veränderungen‘ im Alltag können, wenn sie andauern, Größen annehmen und Wirkungen erzielen, die einen ‚bekannten Alltag‘ soweit verändern, dass lang bekannte ‚Anschauungen‘ und ‚lang praktizierte Verhaltensweisen‘ irgendwann ’nicht mehr stimmen‘: Das Format des eigenen Denkens und Verhaltens gerät dann in zunehmendem Widerspruch zur erfahrbaren Welt. Dann ist der Punkt gekommen, wo die immanente Unendlichkeit sich in der alltäglichen Endlichkeit ‚manifestiert‘ und uns darin ‚demonstriert‘, dass der ‚gedachte Kosmos in unserem Kopf‘ eben nicht der ‚wahre Kosmos‘ ist. Letztlich ist diese immanente Unendlichkeit ‚wahrer‘ als die ’scheinbare Endlichkeit‘.

HOMO SAPIENS (Wir)

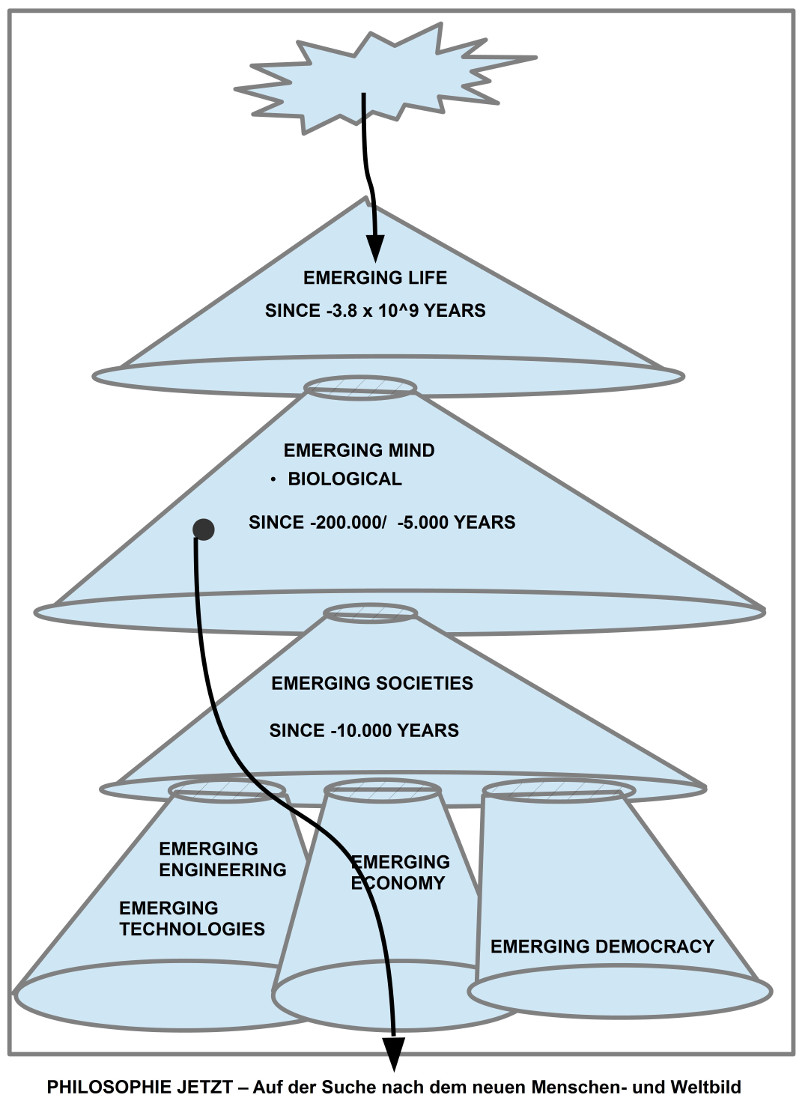

Neben den lebensfreien materiellen Prozessen in dieser endlichen Welt gibt es seit ca. 3.5 Mrd. Jahren die Erscheinungsformen, die wir ‚Leben‘ nennen, und sehr spät — quasi ‚gerade eben‘ — zeigte sich in den Milliarden von Lebensformen eine, die wir ‚Homo sapiens‘ nennen. Das sind wir.

Die heutigen Kenntnisse von dem ‚Weg‘, den das Leben in diesen 3.5 Mrd. Jahren ‚genommen‘ hat, waren und sind nur möglich, weil die Wissenschaft gelernt hat, das ’scheinbar Endliche‘ als ‚Momentaufnahme‘ eines andauernden Veränderungsprozesses zu begreifen, der seine ‚Wahrheit‘ nur in der ‚Gesamtheit der einzelnen Momente‘ zeigt. Dass wir als Menschen, als die ‚Spätlinge‘ in diesem Lebens-Entstehungs-Prozess‘, über die Fähigkeit verfügen, aufeinander folgende ‚Momente‘ ‚einzeln‘ wie auch ‚in Abfolge‘ ‚erkennen‘ zu können, liegt an der besonderen Beschaffenheit des ‚Gehirns‘ im ‚Körper‘ und der Art und Weise, wie unser Körper mit der umgebenden Welt ‚interagiert‘. Von der ‚Existenz einer immanenten Unendlichkeit‘ wissen wir also nicht ‚direkt‘, sondern nur ‚indirekt‘ über die ‚Prozesse im Gehirn‘, die auf eine ’neuronal programmierte Weise‘ Momente identifizieren, speichern, prozessieren und in möglichen Abfolgen ‚anordnen‘ können. Also: unser Gehirn ermöglicht uns aufgrund einer vorgegebenen neuronalen und körperlichen Struktur, ein ‚Bild/ Modell‘ einer möglichen immanenten Unendlichkeit zu ‚konstruieren‘, von dem wir annehmen, dass es die ‚Ereignisse um uns herum‘ einigermaßen gut ‚repräsentieren‘.

DENKEN

Eine Eigenschaft, die dem Homo Sapiens zugeschrieben wird, heißt ‚Denken‘; ein Begriff, der bis heute nur vage und sehr vielfältig durch verschiedene Wissenschaften beschrieben wird. Von einem anderen Homo Sapiens erfahren wir von seinem Denken nur durch seine Art des ‚Sich Verhaltens‘, und ein Spezialfall davon ist ’sprachliche Kommunikation‘.

Sprachliche Kommunikation ist dadurch gekennzeichnet, dass sie grundsätzlich mit ‚abstrakten Begriffen‘ arbeitet, denen als solches direkt kein einzelnes Objekt in der realen Welt entspricht (‚Tasse‘, ‚Haus‘, ‚Hund‘, ‚Baum‘, ‚Wasser‘ usw.). Stattdessen ordnet das menschliche Gehirn ‚völlig automatisch‘ (‚unbewusst‘!) unterschiedlichste konkrete Wahrnehmungen dem einen oder anderen abstrakten Begriff so zu, dass ein Mensch A sich mit einem Menschen B darüber einigen kann, ob man dies konkrete Phänomen da vorne dem abstrakten Begriff ‚Tasse‘, ‚Haus‘, ‚Hund‘, ‚Baum‘, oder ‚Wasser‘ zuordnet. Irgendwann weiß im Alltag Mensch A welche konkrete Phänomene gemeint sein können, wenn Mensch B ihn fragt, ob er eine ‚Tasse Tee‘ habe, bzw. ob der ‚Baum‘ Äpfel trägt usw.

Diese empirische belegte ‚automatische Bildung‘ von abstrakten Konzepten durch unser Gehirn basiert nicht nur auf einem einzigen Moment, sondern diese automatischen Konstruktionsprozesse arbeiten mit den ‚wahrnehmbaren Abfolgen‘ von endlichen Momenten ‚eingebettet in Veränderungen‘, die das Gehirn selbst auch automatisch ‚erstellt‘. ‚Veränderung als solche‘ ist insofern kein ‚typisches Objekt‘ der Wahrnehmung, sondern ist das ‚Resultat eines Prozesses‘, der im Gehirn stattfindet, der ‚Folgen von einzelnen Wahrnehmungen‘ konstruiert, und diese ‚errechneten Folgen‘ gehen als ‚Elemente‘ in die Bildung von ‚abstrakten Begriffen‘ ein: ein ‚Haus‘ ist von daher kein ’statisches Konzept‘, sondern ein Konzept, das viele einzelne Eigenschaften umfassen kann, das aber als ‚Konzept‘ ‚dynamisch erzeugt‘ wird, so dass ’neue Elemente‘ dazu kommen können oder ‚vorhandene Elemente‘ möglicherweise wieder ‚weg genommen‘ werden.

MODELL: WELT ALS PROZESS

Obwohl es bislang keine allgemein akzeptierte umfassende Theorie des menschlichen Denkens gibt, gibt es doch viele unterschiedliche Modelle (alltäglicher Begriff für den korrekteren Begriff ‚Theorien‘), die versuchen, wichtige Aspekte des menschlichen Denkens anzunähern.

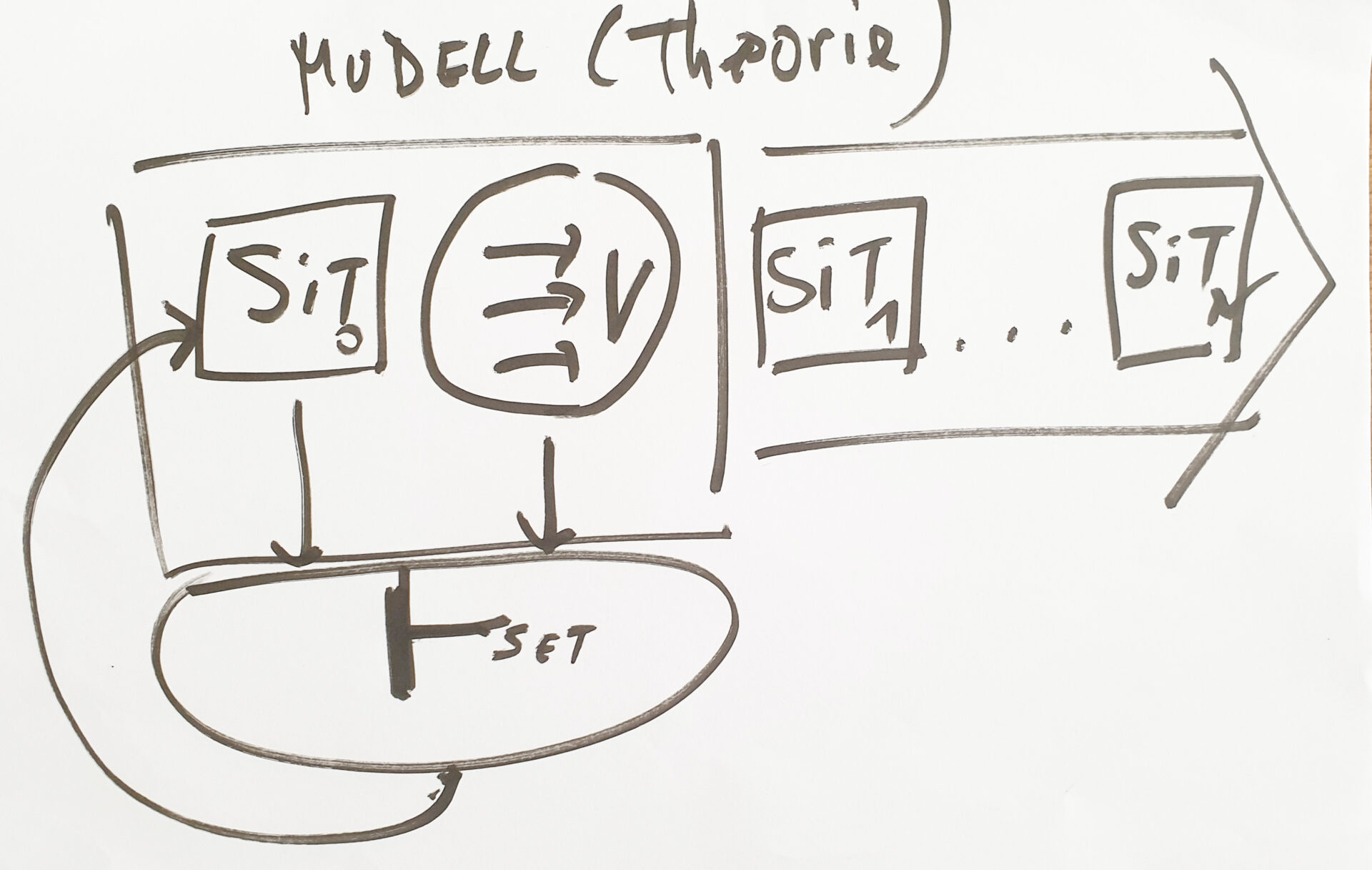

Das vorausgehende Bild zeigt die Umrisse eines minimal einfachen Modells zu unserem Denken.

Dieses Modell nimmt an, dass die umgebende Welt — mit uns selbst als Bestandteile dieser Welt — als ein ‚Prozess‘ zu verstehen ist, bei dem man zu einem gewählten ‚Zeitpunkt‘ in idealisierter Weise alle ‚beobachtbaren Phänomene‘ beschreiben kann, die dem Beobachter zu diesem Zeitpunkt wichtig sind. Diese Beschreibung eines ‚Weltausschnitts‘ sei hier ‚Situationsbeschreibung‘ zum Zeitpunkt t oder einfach ‚Situation‘ zu t genannt.

Dann benötigt man ein ‚Wissen über mögliche Veränderungen‘ von Elementen der Situationsbeschreibung in der Art und Weise (vereinfacht): ‚Wenn X Element der Situationsbeschreibung zu t ist, dann wird für eine nachfolgende Situation zu t entweder X gelöscht oder durch ein neues X* ersetzt‘. Möglicherweise gibt es für das Löschen oder die Ersetzung mehrere Alternativen mit unterschiedlichen Wahrscheinlichkeiten. Solche ‚Beschreibungen von Veränderungen‘ werden hier vereinfachend ‚Veränderungsregeln‘ genannt.

Zusätzlich gibt es als Teil des Modells noch eine ‚Spielanleitung‘ (klassisch: ‚Folgerungsbegriff‘), die erklärt wann und wie man einer Veränderungsregel auf eine gegebene Situation Sit zu t so anwenden kann, dass zum nachfolgenden Zeitpunkt t+1 eine Situation Sit* existiert, in der die Veränderungen vorgenommen worden sind, die die Veränderungsregel beschreibt.

Im Normalfall gibt es mehr als eine Veränderungsregel, die gleichzeitig mit den anderen angewendet werden kann. Auch dies gehört zur Spielanleitung.

Dieses minimale Modell kann und muss man auch vor dem Hintergrund der durchgängigen Veränderung sehen.

Für diese Struktur von Wissen wird vorausgesetzt, dass man ‚Situationen‘ beschreiben kann, mögliche Veränderungen solch einer Situation, und dass man ein Konzept haben kann, wie man Beschreibungen von erkannte möglichen Veränderungen auf eine gegebene Situation anwenden kann.

Mit der Erkenntnis einer immanenten Unendlichkeit, die sich in vielen konkreten endlichen Situationen manifestiert, ist sogleich klar, dass die Menge der angenommenen Veränderungsbeschreibungen mit den beobachtbaren Veränderungen korrespondieren sollte, da ansonsten die Theorie nur einen geringen praktischen Nutzen hat. Ebenso ist es natürlich wichtig, dass die angenommenen Situationsbeschreibungen mit der beobachtbaren Welt korrespondieren. Die Korrespondenz-Anforderungen zu erfüllen bzw. ihr Zutreffen zu überprüfen ist alles andere als trivial.

ABSTRAKT – REAL – INDETERMINIERT

Zu diesen ‚Korrespondenz-Anforderungen‘ hier einige zusätzliche Überlegungen, in denen die Sicht der Alltagsperspektive zur Sprache kommt.

Zu beachten ist, dass ein ‚Modell‘ nicht die Umwelt selbst ist, sondern nur eine ’symbolische Beschreibung‘ eines Umweltausschnitts aus der Sicht und mit dem Verständnis eines menschlichen ‚Autors‘! Auf welche Eigenschaften der Umwelt sich eine Beschreibung bezieht, das weiß nur der Autor selbst, der die gewählten ‚Symbole‘ (Text oder Sprache) ‚in seinem Kopf‘ mit bestimmten Eigenschaften der Umwelt ‚verknüpft‘, wobei diese Eigenschaften der Umwelt ebenfalls ‚im Kopf‘ repräsentiert sein müssen, quasi ‚Wissensabbilder‘ von ‚Wahrnehmungsereignissen‘, die durch die Umwelteigenschaften ausgelöst worden sind. Diese ‚Wissensabbilder im Kopf‘ sind für den jeweiligen Kopf ‚real‘; verglichen mit der Umgebung sind sie aber grundsätzlich nur ‚fiktiv‘; es sei denn, es gibt zwischen aktuellen fiktiven ‚Bilder im Kopf‘ und den ‚aktuellen Wahrnehmungen‘ von ‚Umweltereignissen‘ aktuell einen Zusammenhang, der die ‚konkreten Elemente der Wahrnehmung‘ als ‚Elemente der fiktiven Bilder‘ erscheinen lässt. Dann wären die ‚fiktiven‘ Bilder ‚fiktiv und real‘.

Aufgrund des ‚Gedächtnisses‘, dessen ‚Inhalt‘ im ‚Normalzustand‘ mehr oder weniger ‚unbewusst‘ sind, können wir aber ‚erinnern‘, dass bestimmte ‚fiktive Bilder‘ in der Vergangenheit mal ‚fiktiv und real‘ waren. Dies kann dazu führen, dass wir im Alltag dazu tendieren, fiktiven Bilder, die in der Vergangenheit schon mal ‚real‘ waren, auch in der aktuellen Gegenwart eine ‚vermutliche Realität‘ zuzuschreiben. Diese Tendenz ist im alltäglichen Leben vermutlich von hoher praktischer Bedeutung. In vielen Fällen funktionieren diese ‚Annahmen‘ auch. Dieses ’spontan-für-real-Halten‘ kann aber auch oft daneben liegen; eine häufige Quelle für Fehler.

Das ’spontan-für-real-Halten‘ kann aus vielen Gründen nachteilig sein. So können die fiktiven Bilder (als unausweichlich abstrakte Bilder) schon als solche vielleicht nur ‚partiell angemessen‘ sein. Der Kontext der Anwendung kann sich geändert haben. Generell befindet sich die Umgebung ‚im Fluss‘: Sachverhalte, die gestern gegeben waren, können heute anders sein.

Die Gründe für die anhaltenden Veränderungen sind verschieden. Neben solchen Veränderungen, die wir durch unsere Erfahrung als ein ‚identifizierbares Muster‘ erkennen konnten, gibt es auch Veränderungen, die wir noch keinem Muster zuordnen konnten; diese können für uns einen ‚zufälligen Charakter‘ haben. Schließlich gibt es auch noch die verschiedenen ‚Lebensformen‘, die von ihrer Systemstruktur her bei aller ‚partiellen Determiniertheit‘ grundsätzlich ’nicht determiniert‘ sind (man kann dies auch ‚immanente Freiheit‘ nennen). Das Verhalten diese Lebensformen kann zu allen anderen erkannten Mustern konträr liegen. Ferner verhalten sich Lebensformen nur partiell ‚einheitlich‘, wenngleich Alltagsstrukturen mit ihren ‚Verhaltensregeln‘ — und viele anderen Faktoren — Lebensformen mit ihrem Verhalten in eine bestimmte Richtung ‚drängen‘ können.

Erinnert man sich an dieser Stelle nochmals an die vorausgehenden Gedanken zur ‚immanenten Unendlichkeit‘ und der Sicht, dass die einzelnen, endlichen Momente nur als ‚Teil eines Prozesses‘ verstehbar sind, dessen ‚Logik‘ bis heute weitgehend noch nicht entschlüsselt ist, dann ist klar, dass jegliche Art von ‚Modellbildung‘ von innerhalb der umfassenden Veränderungsprozesse immer nur einen vorläufigen Näherungscharakter haben kann, zumal erschwerend dazu kommt, dass die menschlichen Akteure ja nicht nur ‚passiv Aufnehmende‘ sind, sondern zugleich immer auch ‚aktiv Handelnde‘, die durch ihr Handeln mit auf den Veränderungsprozess einwirken! Diese menschlichen Einwirkungen resultieren aus der gleichen immanenten Unendlichkeit wie jene, die alle übrigen Veränderungen bewirkt. Die Menschen (wie das gesamte Leben) sind damit real ‚ko-Kreativ‘ …. mit all den Verantwortlichkeiten, die sich daraus ergeben.

MORAL ÜBER ALLEM

Was man unter ‚Moral‘ genau zu verstehen hat, muss man aus vielen hundert — oder gar mehr — verschiedenen Texten heraus lesen. Jede Zeit — und sogar jede Region in dieser Welt — hat dazu unterschiedliche Versionen entwickelt.

In diesem Text wird davon ausgegangen, dass mit ‚Moral‘ solche ‚Anschauungen‘ gemeint sind, die dazu beitragen sollen, dass ein einzelner Mensch (oder eine Gruppe oder …) in Fragen der ‚Entscheidung‘, soll ich eher A oder B tun, ‚Hinweise‘ bekommen soll, wie diese Frage ‚am besten‘ beantwortet werden kann.

Erinnert man sich an dieser Stelle daran, was zu vor gesagt wurde zu jener Denkform, die ‚Prognosen‘ erlaubt (das Denken in expliziten ‚Modellen‘ oder ‚Theorien‘) , dann müsste es unabhängig von eine aktuellen ‚Situationsbeschreibung‘ und unabhängig vom möglichen ‚Veränderungswissen‘ eine ‚Bewertung‘ der ‚möglichen Fortsetzungen‘ geben. Es muss also ’neben‘ der Beschreibung einer Situation, wie sie ‚ist‘ mindestens eine ‚zweite Ebene‘ (eine ‚Meta-Ebene‘) geben, die ‚über‘ die Elemente der ‚Objektebene so sprechen kann, dass z.B. gesagt werden kann, dass ein ‚Element A‘ aus der Objektebene ‚gut‘ oder ’schlecht‘ oder ’neutral‘ ist oder mit einer bestimmten graduellen ‚Abstimmung‘ ‚gut‘ oder ’schlecht‘ oder ’neutral‘. Dies kann auch mehrere Elemente oder ganze Teilmengen der Objektebene betreffen. Dies kann man machen. Damit es ‚rational akzeptierbar‘ ist, müssten diese Bewertungen aber mit ‚irgendeiner Form von Motivation‘ verknüpft sein, ‚warum‘ diese Bewertung angenommen werden soll. Ohne solch eine ‚Motivation von Bewertungen‘ würde solch eine Bewertung als ‚pure Willkür‘ erscheinen.

An dieser Stelle wird die ‚Luft‘ recht ‚dünn‘: in der bisherigen Geschichte wurde bislang kein überzeugendes Modell für eine moralische Begründung bekannt, das letztlich nicht auf die Entscheidung von Menschen zurück zu führen ist, bestimmte Regeln als ‚gültig für alle‘ (Familie, Dorf, Stamm, …) anzusetzen. Oft lassen sich die Begründungen noch in den konkreten ‚Lebensumständen‘ verorten, genauso oft treten die konkreten Lebensumstände im Laufe der Zeit ‚in den Hintergrund‘ und stattdessen werden abstrakte Begriffe eingeführt, die man mit einer ’normativen Kraft‘ ausstattet, die sich einer konkreteren Analyse entziehen. Ein rationaler Zugriff ist dann kaum bis gar nicht mehr möglich.

In einer Zeit wie im Jahr 2023, in dem das verfügbare Wissen dazu ausreicht, die wechselseitigen Abhängigkeiten von buchstäblich jedem von jedem erkennen zu können, dazu die Veränderungsdynamik, die mit der Komponenten ‚Erderwärmung‘ den ’nachhaltigen Bestand des Lebens auf der Erde‘ substantiell bedrohen kann bzw. bedroht, erscheinen ‚abstrakt gesetzte Normbegriffe‘ nicht nur ‚aus der Zeit‘ gefallen, nein, sie sind höchst gefährlich, da sie den Erhalt des Lebens für die weitere Zukunft substantiell behindern können.

META-MORAL (Philosophie)

Es stellt sich dann die Frage, ob dieses ‚rationale schwarze Loch‘ von ‚begründungsfreien Normbegriffen‘ die Endstation menschlichen Denkens markiert oder ob das Denken hier nicht gerade erst anfangen sollte?

Traditionell versteht sich eigentlich die Philosophie als jene Denkhaltung, in der jedes ‚Gegebene‘ — dazu gehören dann auch jegliche Art von Normbegriffen — zu einem ‚Gegenstand des Denkens‘ gemacht werden kann. Und gerade das philosophische Denken hat in Jahrtausende langem Ringen genau dieses Ergebnis hervorgebracht: es gibt keinen Punkt im Denken, aus dem sich alles Sollen/ alles Bewerten, ‚einfach so‘ ‚ableiten lässt.

Im Raum des philosophischen Denkens, auf der Meta-Moral-Ebene, kann man zwar immer mehr Aspekte unserer Situation als ‚Menschheit‘ in einer dynamischen Umwelt (mit dem Menschen selbst als Teil dieser Umwelt) ‚thematisieren‘, ‚benennen‘, in eine ‚potentielle Beziehungen‘ einordnen, ‚Denkexperimente‘ über ‚mögliche Entwicklungen‘ anstellen, aber dieses philosophische Meta-Moral-Wissen ist komplett transparent und immer identifizierbar. Die Folgerungen, warum etwas ‚besser‘ erscheint als etwas anderes, sind immer ‚eingebettet‘, ‚bezogen‘. Die Forderungen nach einer ‚autonomen Moral‘, nach einer ‚absoluten Moral‘ neben dem philosophischen Denken erscheinen vor diesem Hintergrund ‚grundlos‘, ‚willkürlich‘, der ‚Sache fremd‘. Eine rationale Begründung ist nicht möglich.

Ein ‚rational Unerkennbares‘ mag es geben, gibt es sogar unausweichlich, aber dieses rational Unerkennbare ist unsere schiere Existenz, das tatsächliche reale Vorkommen, für das es bislang keine rationale ‚Erklärung gibt‘, genauer: noch nicht gibt. Dies ist aber kein ‚Freifahrschein‘ für Irrationalität. In der ‚Irrationalität‘ verschwindet alles, sogar das ‚rational Unerkennbare‘, und dieses gehört mit zu den wichtigsten ‚Sachverhalten‘ in der Welt des Lebens.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.

ANMERKLUNGEN

[1] Die verschiedenen Formen von ‚Unendlichkeit‘, die mit den Arbeiten von Georg Cantor in die Mathematik eingeführt und intensiv weiter untersucht wurden, haben mit der im Text beschrieben erfahrbaren Endlichkeit/ Unendlichkeit nichts zu tun: https://de.wikipedia.org/wiki/Georg_Cantor . Allerdings, will man die ‚Erfahrung‘ von realer Endlichkeit/ Unendlichkeit ‚beschreiben‘, dann wird man möglicherweise auf Beschreibungsmittel der Mathematik zurückgreifen wollen. Nur ist nicht von vornherein ausgemacht, ob die mathematischen Konzepte mit der zur Sache stehenden empirischen Erfahrung ‚harmonieren‘.