Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 19.-21.Februar 2022, 14:05h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Vorbemerkung

Bei diesem Beitrag handelt es sich um eine Fortsetzung der vorausgehenden Besprechung von Popper’s erstem Artikel „A World of Propensities“ (1988, 1990). In diesem neuen Post steht der zweite Artikel von Popper im Zentrum „Towards an Evolutionary Theory of Knowledge“ (1989,1990)[0]. Der Text von Popper geht zurück auf seine erste öffentliche Rede für die Alumni der London School of Economics 1989, 40 Jahre nach seiner Ernennung zum Professor für Logik und wissenschaftliche Methoden an der L.S.E. Der Text des Artikels wurde von ihm gegenüber der ursprünglichen Rede leicht erweitert.

Rückblick als Zusammenfassung

(Mit eigenen Worten …)

Im vorausgehenden Text hatte Popper sehr grundsätzlich die Idee entwickelt, dass in der Abfolge beobachtbarer Ereignisse mit möglichen Häufigkeiten ‚mehr enthalten‘ ist als bloß ein ‚wiederholtes Auftreten‘. Ereignisse in der uns umgebenden Ereigniswelt — mit unserem Körper ebenfalls als ein Ereignis darin — stehen nicht beziehungslos im Raum, sondern stehen in einem realen Zusammenhang mit allem anderen, kontinuierlich eingebettet in reale Wechselbeziehungen vielfältiger Art, und dieser Zusammenhang dauert an als ‚Gegenwart‘, in der sich diese realen Konstellationen in Form von ‚Wirkungen‘ manifestieren. Die Wirklichkeit erscheint in dieser Sicht als ein ‚Prozess‘, in dem alles mit allem verbunden ist und sich durch die kontinuierlichen ‚Wirkungen‘, die von den einzelnen Komponenten ausgehen, sich selbst kontinuierlich auch verändern kann. Eine Wirkung, die innerhalb solch eines dynamischen Prozesses als ‚Ereignis‘ beobachtbar (= messbar) wird, muss man daher als eine ‚Tendenz‘ (‚propensity‘) begreifen, die ‚vorkommt‘, weil es einen realen Zusammenhang gibt, der sie bedingt. Tendenzen kann man daher verstehen als ‚Geräusche des Daseins‘, ‚Mitteilungen des So-Seins‘, oder als ‚Sound der Welt‘. Man kann es beim bloßen Wahrnehmen, beim Sound als solchem, belassen, oder man kann den Sound als ‚Spur‘ sehen, als ‚Zeichen‘, als ‚Abdruck von etwas‘, das sich ‚mitteilt.

Popper legt Wert darauf, dass die einzelnen Töne des Sounds, die einzelnen Ereignisse, weder ‚deterministisch‘ sind noch ‚rein zufällig‘. Irgendetwas dazwischen. Das Auftreten dieser Töne kann ‚Muster‘ andeuten, ‚Regelhaftigkeiten‘, durch die unser Denken angeregt werden kann, zwischen aufeinander folgenden Ereignissen ‚Beziehungen‘ zu sehen, ‚Zusammenhänge‘, aber diese Beziehungen sind aufgrund der Art ihres Auftretens ‚fragil‘: sie können auftreten mit einer gewissen Häufigkeit, phasenweise vielleicht sogar mit einer gewissen ‚Konstanz der Häufigkeiten‘, aber es gibt ‚keine absoluten Garantien‘, dass dies immer so bleiben wird. Im Alltag neigen wir dazu, solche sich wiederholenden ‚Beziehungen‘ in ‚Hypothesen‘ umzuwandeln, an die wir die ‚Erwartung‘ knüpfen, dass sich ein solches hypothetische Muster reproduziert. Falls ja, fühlen wir uns ‚bestätigt‘; falls nein, steigen Zweifel auf, ob wir uns mit unserer Annahme geirrt haben. Im einen Grenzfall, wenn das Muster sich immer und immer wiederholt, neigen wir dazu es als ‚feste Regel‘, als ‚Gesetz‘ zu sehen. Im anderen Grenzfall, wenn das Muster sich trotz aller Versuche, es als Ereignis zu reproduzieren (Experiment, Test), nicht wieder einstellt, dann neigen wir dazu, unsere ‚Hypothese‘ wieder zu verwerfen. Doch zwischen ‚Annahme‘ eines Musters als ‚gesetzmäßig‘ und als ‚verworfen‘ liegt ein Raum voller Schattierungen. Der bekannte Spruch ‚Die Hoffnung stirbt zuletzt‘ kann andeuten, dass das ‚Verwerfen‘ einer Hypothese — je nach Art und Stärke der Erwartungen — sehr lange hinausgezögert werden kann … manche ‚glauben‘ auf jeden Fall, dass es irgendwie doch möglich sein kann, egal was passiert …

Diese Sichtweise Poppers deckt sich nicht mit einer theoretischen (mathematischen) Wahrscheinlichkeit, nicht mit einer rein subjektiven Wahrscheinlichkeit, auch nicht mit einer deskriptiven (empirischen) Wahrscheinlichkeit, selbst wenn es jeweils ‚Überschneidungen‘ gibt. Eher ist es eine Kombination von allen Dreien plus eine charakteristische Erweiterung:

- Wenn man beginnt, beobachtbare Ereignisse zu ’notieren‘, zu ‚protokollieren‘ und sie nach verschiedenen formalen Kriterien ‚anzuordnen‘ ohne weiter reichenden Interpretationen zu formulieren, dann bewegt man sich im Feld einer empirischen deskriptiven Wahrscheinlichkeit, die mit Häufigkeiten arbeitet. Damit würde auch Popper anfangen.

- Wenn man diese ‚empirischen Befunde‘ dann versucht in weiter reichende ‚Beziehungen‘ einzuordnen, dann braucht man eine theoretische Struktur. Eine solche bietet die theoretische Wahrscheinlichkeit. In ihr kann man beliebig viele Strukturen (= Modelle, Theorien) definieren und versuchsweise in Beziehung setzen zu empirischen Befunden. Je nach Modell kann man dann die empirischen Befunde unterschiedlich interpretieren und daraus unterschiedliche Voraussagen ableiten. Im Experiment kann man weiter versuchen, zu überprüfen, welches angenommene Modell sich ‚mehr‘ bestätigt als ein anderes.

- Jeder einzelne Mensch bildet im Alltag automatisch sein ’subjektives Modell‘ von Wahrscheinlichkeiten aufgrund seiner Alltagserfahrung. Dies kann sich auf Dauer als ‚mehr oder weniger zutreffend‘ erweisen. Würde jemand versuchen, seine Alltagserfahrung ‚wissenschaftlich zu analysieren‘ würde er sowohl eine ‚deskriptive‘ Wahrscheinlichkeit ausbilden können wie auch eine ‚theoretische‘ Wahrscheinlichkeit.

- Die Sichtweisen (1) – (3) zwingen nicht dazu, jenseits der beobachtbaren und klassifizierbaren Ereignisse eine ‚reale Welt von Kontexten (mit Situationen als Teilaspekten)‘ anzunehmen, deren reale Beschaffenheit so ist, dass von ihr ‚Wirkungen‘ ausgehen, die sich als ‚beobachtbare Ereignisse‘ manifestieren und die in ihrer zeitlich geordneten ‚Gesamtheit‘ dann als ‚Tendenzen‘ verstanden werden können, die ‚objektiv‘ sind, da sie mit realen Kontexten in einem unauflösbaren Zusammenhang stehen. Diese vierte Dimension der ‚objektiven Tendenzen‘ ist der ‚Mehrwert, den Popper in die Sicht der Dinge einbringt

Soweit die Kernthese von Popper zu ‚objektiven Tendenzen‘, zusammengefasst, nicht als 1-zu-1 Formulierung von Popper.

Ein wissender Körper

Im vorausgehenden Text hatte ich bei der Kommentierung von Poppers Text spontan an verschiedenen Stellen Überlegungen eingestreut, in denen ich weitergehende Annahmen über die Arbeitsweise unseres Körpers mit seinem Gehirn beschrieben habe. Zu diesem Zeitpunkt hatte ich Poppers Beitrag zu einer evolutionären Theorie des Wissens noch nicht gelesen. Ich selbst hatte mich aber auch schon seit mindestens 30 Jahren mit der evolutionären Perspektive unserer körperlich-geistigen Existenz beschäftigt und erleben dürfen, dass erst mit Einbeziehung der evolutionären Perspektive viele grundlegenden Eigenschaften unser Daseins in einem rationalen Kontext (= Menge von Hypothesen) erscheinen, der ‚plausibel‘ wirkt (aber ‚auf Abruf‘; es kann sich ändern).

Mit Beginn der Lektüre des zweiten Artikels war ich daher nicht wenig (positive) überrascht, dass Popper der evolutionären Perspektive unseres wissenden Körpers so viel Gewicht beimaß. [0b]

Popper beginnt seinen Artikel mit der (Hypo-)These, dass Tiere Wissen (‚knowledge‘) besitzen.(vgl. S.30) Da wir als Menschen nicht direkt wissen können, was ‚Wissen‘ aus der Innensicht von Tieren ist sondern nur aus unserer ‚Selbsterfahrung‘ als Menschen, räumt Popper ein, dass die These „Tiere besitzen Wissen“ im ersten Augenblick ‚anthropomorph‘ klingt; das wäre dann eine bloße ‚Projektion‘ von menschlichen Eigenschaften auf Tiere; einer solchen Projektion käme dann zunächst kein weiterer empirischer Erkenntniswert zu. Aber Popper bleibt beharrlich und stellt fest, dass seine Rede nicht als „bloße Metapher“ gemeint sei. Darüber hinaus verteidigt er seine anthropomorphe Redeweise mit dem Argument, dass wir über biologische Phänomene gar nicht anders als anthropomorph reden könnten, da unser eigener Körper mit seinen Eigenschaften als (natürlicher) Referenzpunkt dient, über den wir einen ersten Zugang zu ‚homologen‘ (= strukturähnlichen, formähnlichen) Eigenschaften der anderen Lebensformen finden.(vgl. S.30) Und er wiederholt seine These, dass die ‚Formähnlichkeiten‘ zwischen menschlichem Körper (und Verhalten) mit nicht-menschlichen Körpern (und Verhalten) nicht rein äußerlich sei, sondern dass die formähnlichen Teile auch ähnliche Funktionen haben, z.B. die Annahme, dass das Gehirn eines Tieres auch irgendwie ‚Wissen‘ hat, erzeugt analog wie beim Menschen.(vgl.S.30f).

Er unterscheidet sehr schnell zwischen ‚Wissen‘ und dem ‚Wissen um Wissen‘ (‚being aware of‘) und meint, dass aus der Annahme von ‚Wissen‘ in nicht-menschlichen Lebensformen nicht unbedingt folgt, dass diese sich ihres Wissens ‚bewusst‘ seien noch ist auszuschließen, dass bei uns Menschen ‚Wissen‘ auch ‚unbewusst‘ (’not aware of‘, ‚unconscious‘) sein kann.(vgl. S.31) Bei Menschen manifestiert sich ‚unbewusstes Wissen‘ oft in Form von ‚Erwartungen‘, deren wir uns oft erst bewusst werden, wenn sie ‚enttäuscht‘ werden.(vgl. S.31)

Popper stellt dann eine Art Liste von Vermutungen zusammen, die sich aus der Eingangs-Annahme ergeben können, dass Tiere über Wissen verfügen (vgl. SS.32-39):

- ERWARTUNGEN: Wie schon zuvor erwähnt, zeigt sich Wissen in Form von ‚Erwartungen‘

- UNSICHERHEIT: Erwartungen sind objektiv unsicher; der jeweilige Akteur kann mit einer Erwartung aber so umgehen, als ob sie ’sicher‘ sei.

- HYPOTHESEN: Die überwiegende Menge an Wissen besteht aus Hypothesen.

- OBJEKTIV WAHR: Trotz eines hypothetischen Charakters kann Wissen ‚objektiv wahr‘ sein, weil es sich auf ‚objektive Fakten‘ (= reale Ereignisse) stützt.

- WAHR ≠ SICHER: Wahrheit und Sicherheit müssen klar unterschieden werden. In der Welt der realen Ereignisse kann etwas ‚wahr‘ und zugleich unsicher sein. In der Welt des abstrakten Denkens (z.B. Mathematik) kann es wahr und zugleich sicher sein.

- TESTEN: Wegen mangelnder Sicherheit in der realen Welt müssen wahre Aussagen immer wieder getestet werden, ob sie ’noch‘ zutreffen (weil die reale Welt sich in konstanter Veränderung befindet).

- Wie (4)

- FALSCHE SICHERHEIT: In der realen, sich ständig verändernden Welt, kann es keine absolute Sicherheit geben.

- WISSEN ÜBERALL: Verknüpft man ‚Wissen‘ an der Wurzel mit ‚Erwartungen‘, dann muss man allen biologischen Lebensformen ein Minimum an Wissen zusprechen.

- Erläuterung zu (9) mit Bäumen.

- Weitere Erläuterung zu (9) mit Bäumen.

- LANGZEIT und KURZZEIT EREIGNISSE: Reaktionen eines Organismus auf Kurzzeit Ereignisse setzten gewisse ‚Fähigkeiten‘ voraus, die sich über Generationen als ’strukturelle Eigenschaften‘ adaptiv herausgebildet haben müssen, damit sie als Basis des Reagierens verfügbar sind.

- Erläuterung zu (12) am Beispiel von Wildgänsen, die adaptiert sind, auf jagende Füchse zu reagieren.

- Erläuterung zu (12). Strukturelle Anpassungen setzen voraus, dass es Umweltbedingungen gibt, die über lange Zeit hinreichend konstant waren.

- ADAPTION und WISSEN mit ERWARTUNGEN durch VERSUCH & IRRTUM: Ein reales Ereignis wird nur dann für einen einzelnen Akteur zu einer ‚Sache‘ (zu einem ‚Fakt‘, zu einer ‚Information‘) wenn verfügbares Wissen das Ereignis entsprechend ‚einordnen‘ kann. Verfügbares Wissen entsteht aber nur durch einen individuellen ‚Lernprozess‘ bestehend aus vielen kleinen ‚Versuchen‘ mit Erwartung und nachfolgender Bestätigung/ Nicht-Bestätigung. Adaptierte Strukturen in einem Individuum in einer sich verändernden Welt mit partiell konstanten Mustern können nur über einen Prozess von vielen ‚Reproduktions-Versuchen‘ in einer Population entstehen, wenn’un-passende‘ Strukturen weniger leistungsfähig sind wie andere.

- LANGZEIT-/KURZZEIT ANPASSUNG/WISSEN: Kurzzeit-Wissen setzt Langzeit-Anpassung und darin kodiertes Wissen voraus. Sowohl Langzeit-Strukturen/Wissen als auch Kurzzeit-Wissen sind beide ‚hypothetisch‘: sie bilden sich anlässlich ‚realer Ereignisse‘, erben aber die Unsicherheit der Ereigniswelt als solcher.

- WISSEN IST ÜBERLEBENSORIENTIERT: Jede Form von Wissen in jedem biologischen Organismus (von der kleinsten Zelle bis zum Menschen) dient dazu, dem Menschen für sein Überleben zu dienen.

- ALTER DES WISSENS: Das Phänomen des Wissens begleitet das Leben von Anfang an.

- UNIVERSUM-LEBEN-WISSEN: Insofern das Leben mit dem ganzen Universum verknüpft ist (zu 100%!) ist auch das Wissen ein Aspekt des gesamten Universums.

Popper illustriert viele der in der Liste aufgeführten Punkte dann an der realen Geschichte der Evolution anhand konkreter Forschungen aus seiner Zeit. (vgl. SS.39 – 45) Der Grundtenor: Leben spielt sich primär in Form von chemischen Prozessen in jeweiligen Umgebungen ab. Die ‚Makro‘-Phänomene, die wir vom Leben aus dem ‚Alltag der Körper‘ kennen, sind im Sinne der Komplexität so ‚unfassbar weit‘ von diesen elementaren Prozessen entfernt, dass es für uns Menschen bis heute — trotz Wissenschaft — noch kaum möglich ist, alle diese Prozesse hinreichend zu verstehen. Speziell der Übergang vom Planeten Erde ‚vor‘ den Phänomenen einzelligen Lebens hin zu einzelligem Leben ist trotz mittlerweile vielfacher Versuche leider noch nicht wirklich klar.[5],[6]

Die wichtigsten Erkenntnisse aus alledem

An dieser Stelle stellt sich Popper selbst die Frage, was aus alledem jetzt folgt? („… the main lesson to be drawn …“(S.45)

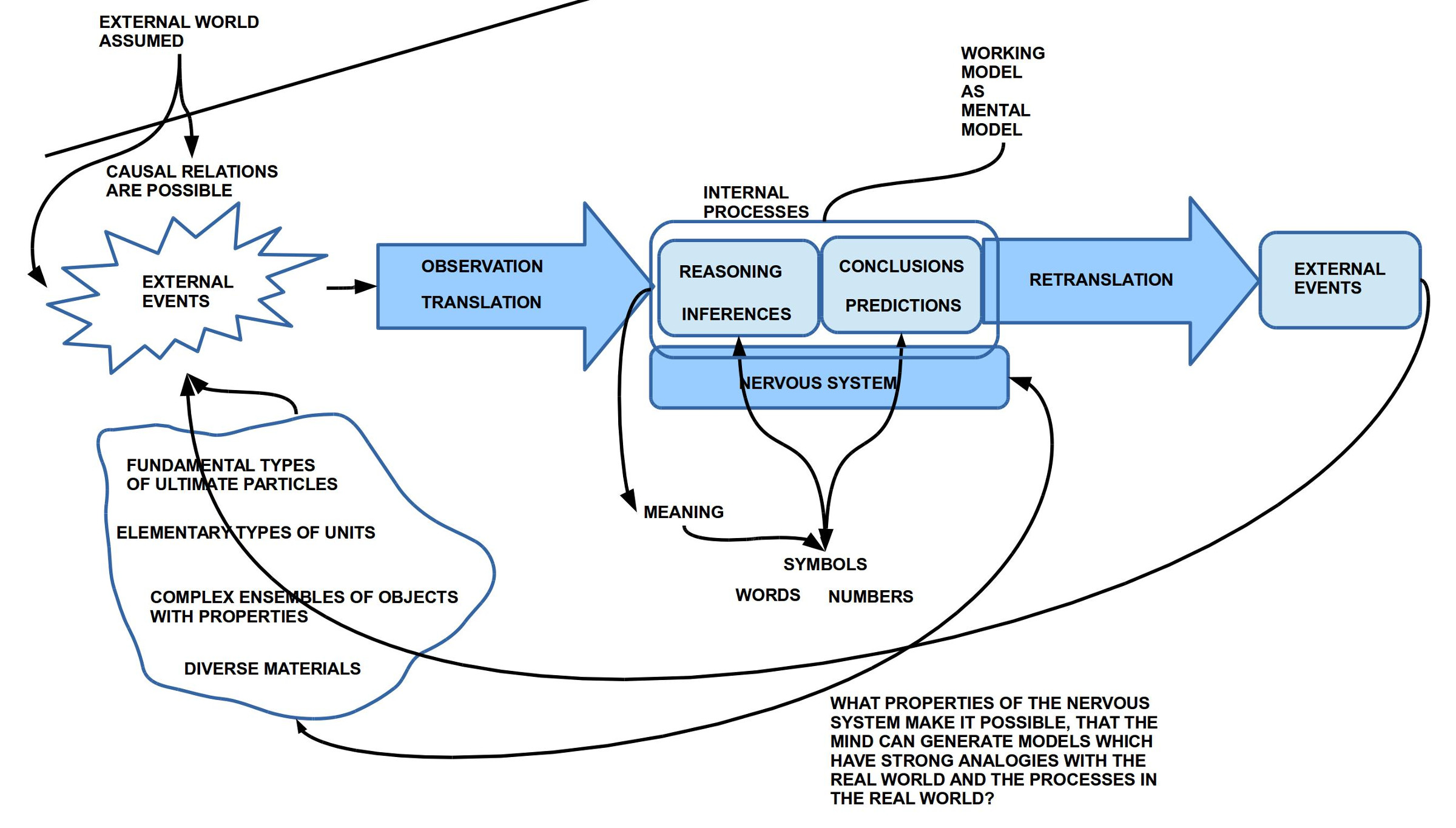

Und mit all den ungeheuerlichen Geschehnissen der Evolution vor Augen fällt eines ganz klar auf: allein nur um zu wissen, was ‚um ihn herum‘ der Fall ist, benötigt der Organismus eine ‚Struktur‘, deren Eigenschaften den Organismus in die Lage versetzen, bestimmte Umweltereignisse zu ‚registrieren‘, dieses ‚Registrierte‘ in interne Zustände so zu ‚übersetzen‘, dass der Organismus darauf in einer Weise ‚reagieren‘ kann, die für sein Überleben zuträglich ist. Und da es neben den ‚Langzeit-Ereignissen‘ (Eigenschaften der Umgebung, die sich nur langfristig ändern), auch sehr viele ‚Kurzzeit-Ereignisse‘ gibt, die mal so oder mal so sind, benötigt der Organismus neben den ‚Strukturen‘ auch ‚flexible Prozesse‘ des ‚akuten Lernens‘, die aktuell, ‚on demand‘, Antworten ermöglichen, die jetzt gebraucht werden, nicht irgendwann.

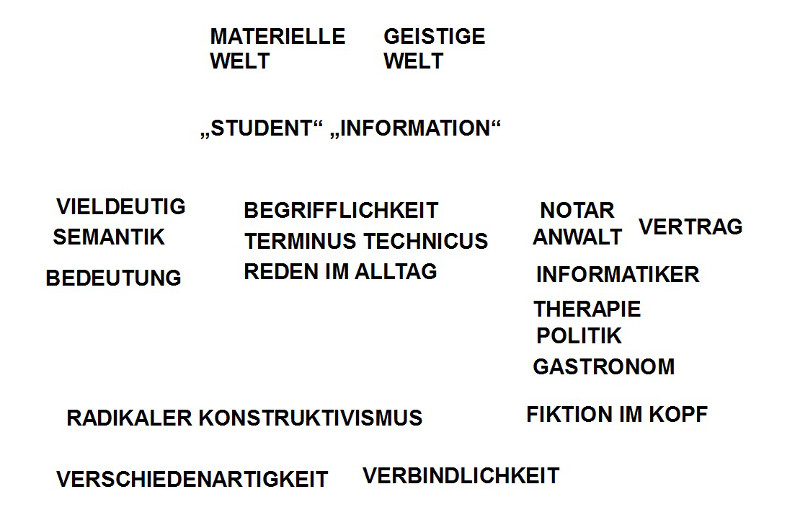

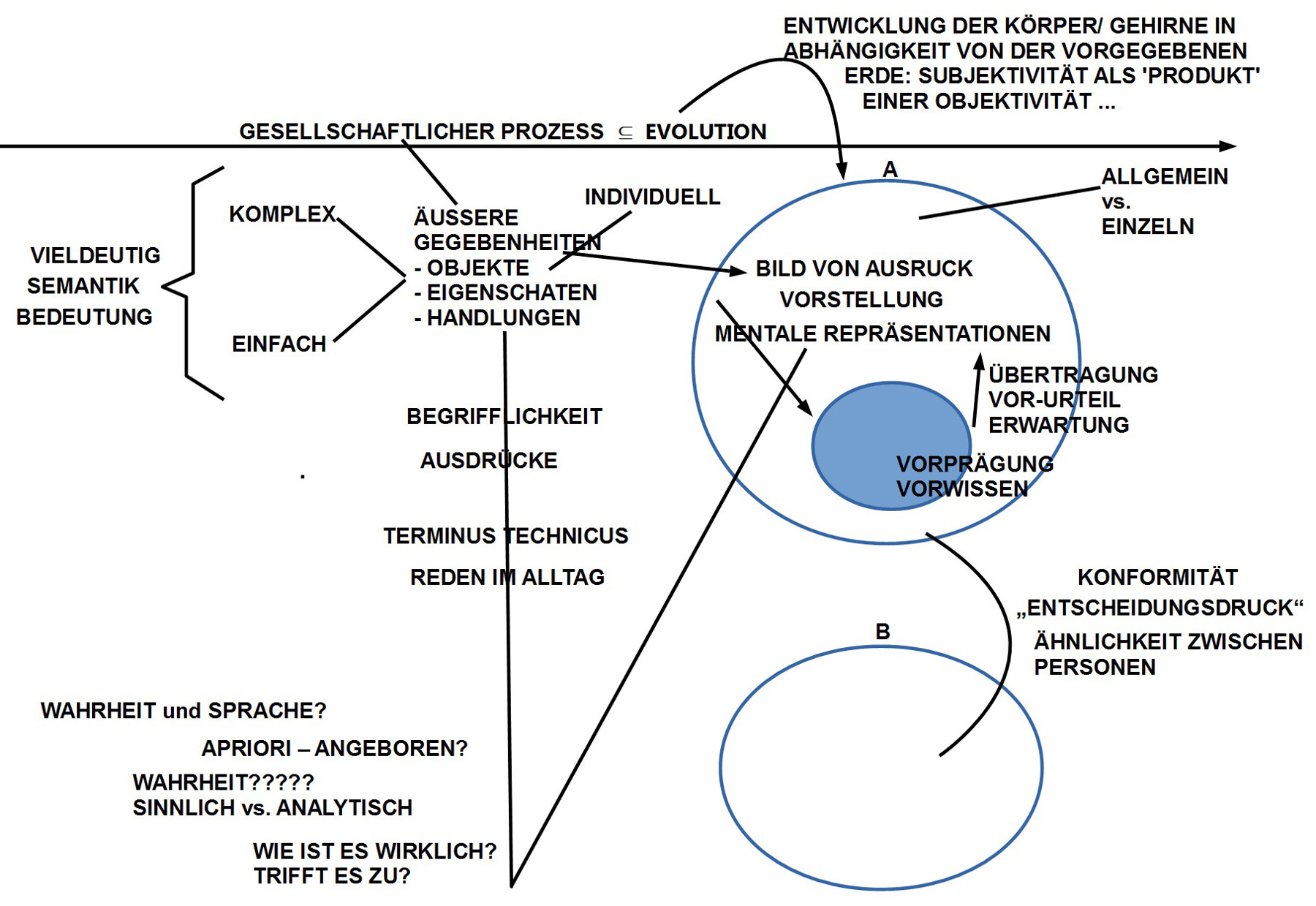

Popper greift an dieser Stelle eine Terminologie von Kant [7] auf der zwischen ‚a priori‘ und ‚a posteriori‘ Wissen unterschieden hat. [6] Angewendet auf seine Untersuchungen interpretiert Popper das ‚Wissen a priori‘ als jenes Wissen, das schon da sein muss, damit ein konkretes Ereignis überhaupt ‚als irgendetwas‘ erkannt werden kann („to make sense of our sensations“, S.46). Und dieses ‚voraus zu setzende Wissen‘ sieht er als Wissen a priori‘, das sowohl als verfügbare Struktur (= Körper, Gehirn…) auftritt wie auch innerhalb dieser Struktur als ein ‚Wissen a posteriori‘, das ein Ereignis zu einem ‚irgendwie sinnhaften Ereignis‘ werden lassen kann.(„… without it, what our senses can tell us can make no sense.“ (S.46) Innerhalb dieses voraus zu setzenden Wissens müssen die grundsätzlichen Unterscheidungen zu ‚Raum‘, ‚Zeit‘ und ‚Kausalität‘ möglich sein. Und Popper meint, dass Kant mit seinen erkenntniskritischen Rekonstruktionen grundlegende Einsichten der Evolutionstheorie vorweg genommen habe.(vgl. S.46)

Und, indem Popper Kant so hoch lobt, geht er unmittelbar dazu über, ihn — auf seine Weise — gewissermaßen zu ‚transformieren‘, indem er sagt, dass der Anteil des ‚apriorischen Wissens‘ eher bei 99% liegt und der des ‚aposteriorischen Wissens‘ eher bei 1%. Diesen Schluss zieht er aus der Tatsache (= seine Interpretation von einer Sachlage!), dass die verschiedenen sensorischen Ereignisse im Körper eines Organismus als solche nur ‚Ja-Nein-Zustände‘ sind, die eine wie auch immer geartete ‚Bedeutung‘ nur bekommen, wenn es einen ‚Deutungsrahmen‘ gibt, mit Hilfe von dem ein sensorisches Ja-Nein als ‚Laut‘ oder als ‚Farbe‘ oder als ‚Geschmack‘ usw. ‚gedeutet‘ (abgebildet) werden kann. Dies heißt, dass generell Ereignisse nach einem Deutungsrahmen verlangen, der schon ‚da sein muss‘, damit er wirken kann. Und da ein Organismus primär aus chemischen Prozessen besteht, muss das ‚apriorische Wissen‘ in diesen chemischen Prozessen verfügbar sein („… inborn … in our chemical constitution“. (S.46)) Ferner kann das Verhältnis zwischen zu klassifizierenden sensorischen Daten und dem Wissen a priori nicht deterministisch sein, da diese Klassifikationen ‚falsch‘ sein können, sie partiell erst durch ‚Versuch und Irrtum‘ entstehen. Insgesamt ermöglicht das Wissen zudem ‚Erwartungen‘, aufgrund deren der Organismus handelt (und deshalb ‚irren‘ kann).

Hier deutet sich ein konstruktiver Konflikt an in der Annahme, dass es schon ein apriorisches Wissen geben muss, das zu Klassifikationsleistungen befähigt, und zugleich, dass solch ein apriorisches Wissen weder ‚vollständig‘ zu sein scheint (Poppers Beispiel: der Frosch, der zwar Fliegen erkennen kann als sein Futter, aber nur dann, wenn sie sich bewegen), noch ‚fertig im Detail‘, da ‚Irrtümer‘ auftreten können, aus denen ‚gelernt‘ werden kann. Dem Ganzen (Wissen) haftet etwas ‚prozesshaftes‘ an: es hat schon immer etwas, was ‚funktioniert‘, aber es kann sich selbst in Interaktion mit ‚dem Anderen‘ irgendwie immer weiter verändern.(vgl. S.47)

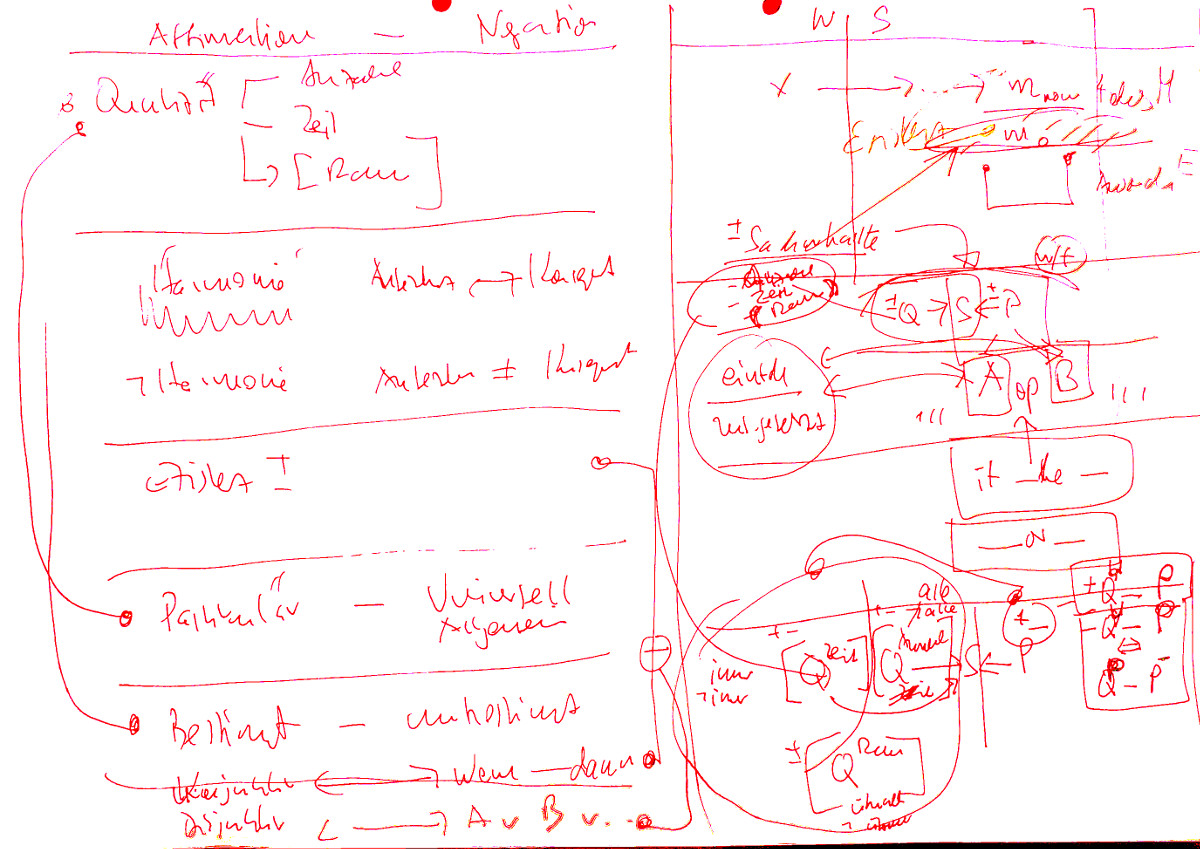

Das zugrunde liegende Schema könnte man vielleicht wie folgt formulieren: (i) ein Organismus braucht eine Struktur, die registrierte Ja-Nein-Ereignisse ‚Klassifizieren/ Deuten‘ kann, und parallel (ii) braucht es aufgrund des bisherigen Wissens eine ‚Erwartung‘, anhand deren eine aktuelle Deutung als ‚bestätigend‘ erscheint oder ’nicht-bestätigend‘. Aus dieser Differenz kann dann eine Veränderung des Verhaltens resultieren, das ‚versuchsweise‘ Ereignisse schafft, die dann ‚eher bestätigen‘ und ‚weniger enttäuschen (Irrtum, Fehler, …)‘. Das Ganze wird dadurch ‚komplex‘, dass für dieses Schema mindestens zwei Zeitschemata anzunehmen sind: (a) langfristige strukturelle Änderungen (’strukturelles Lernen‘) des gesamten Organismus über Reproduktion und ‚Erfolg‘ in der Population (wer überlebt besser), sowie (b) kurzfristige Änderungen (’situationsbezogenes Lernen‘), das in wechselnden ‚hypothetischen Bildern der Welt‘ beständig als Hypothese und Erwartung wirksam ist, die im Konfliktfall (keine Bestätigung) ‚modifiziert‘ werden können.

Popper zieht in diesem Kontext eine Parallele zum modernen Begriff einer Theorie, die als Hypothese versucht, hilfreiche Deutungen zu liefern, und die in Konfrontation mit der Ereigniswelt (über Experimente) bestätigt oder nicht bestätigt wird. Im Prozess des Erwartens und Korrigierens vollzieht sich eine Form der ‚Anpassung‘ des menschlichen Denkens an jene Ereigniswelt (die wir ‚Welt‘ nennen, ‚Natur‘, ‚Universum‘, …), in der wir uns — ungefragt — vorfinden, in der wir versuchen, zu überleben. (vgl. S.48f) Popper äußert dann noch eine Analogie der Art, dass der Unterschied zwischen der hochentwickelten Wissenskultur eines einzelnen Homo sapiens und jener eines einzelnen Bakteriums letztlich nur graduell ist; grundsätzlich hat ein Bakterium, ein Einzeller, schon alle Merkmale, über die höher entwickelte biologische Lebensformen verfügen.(vgl. S.49f) Insbesondere sieht Popper in jedem lernfähigen Organismus auch — mindestens implizit — ‚Werte‘ in Aktion, nämlich überall dort, wo ‚entschieden‘ werden muss, welche der möglichen Optionen ausgewählt werden soll. In einfachen Organismen geschieht dies weitgehend strukturell-apriorisch; im Fall komplexer Lebewesen mit elaborierten Nervensystemen kann es zusätzlich künstlich eingeführte ‚Regelsysteme‘ geben — wie z.B. ‚gesellschaftliche Normen‘, ‚Konventionen‘, ‚Sitten und Gebräuche‘, ‚Vereinbarte Gesetze‘ usw. –, die auf einen individuellen Entscheidungsprozess einwirken können, ohne den individuellen Entscheidungsprozess dabei ganz außer Kraft zu setzen.(vgl. S.50f)

Nachbemerkung – Epilog

Nimmt man beide Beiträge als eine mögliche Einheit, dann entsteht ein spannender Zusammenhang, eine spannende Gesamt-Hypothese über die Natur der uns umgebenden Ereigniswelt mit uns selbst (über unseren Körper) als Teil davon.

Mit unserem Körper erleben wir interne Ereignisse in Form angeborener und angelernter gedeuteter Strukturen, die uns ein ‚Bild von der Welt mit uns als Teil‘ liefern, mit ‚Erwartungen‘, die in uns entstehen, mit Bestätigungen und Mangel an Bestätigungen, mit der Möglichkeit eines Handelns, das die Struktur der Ereignisse um uns herum — und uns selbst — verändern kann.

Die Welt ist ein dynamisches, changierendes Etwas, ein Gesamtprozess, dessen endgültige Gestalt, dessen inneren ‚Antriebskräfte‘ schwer fassbar sind, ist doch jedes Lebewesen — nicht nur wir Menschen — Teil davon.

Im Versuch dieses dynamische Etwas ‚zu fassen‘, ‚dingfest‘ zu machen, bleiben uns nur einzelne Ereignisse, hier und jetzt, und immer wieder neue Ereignisse im hier und jetzt; abstrakte Bilder (Schatten der Erinnerung), in denen einige häufiger vorkommen als andere. Bisweilen haben wir das Gefühl, dass sich ‚Regeln‘ andeuten, ‚Muster‘, aber sie sind niemals ‚100-prozentig stabil‘ (‚deterministisch‘), aber auch niemals nur ‚rein zufällig‘, sondern irgendwie genau dazwischen. Was ist das? Der Sound des Lebens? Wir sind Teil dieses Sounds. Verstehen wir uns selbst? Verstehen wir die große Partitur, in der wir vorkommen? Alles deutet darauf hin, dass das Gesamtereignis ’sich selbst komponiert‘! Im Kern aller Ereignisse findet man eine große ‚Freiheit‘, die sich im ‚Kleid der Optionen‘ eine Gestalt sucht, eine Gestalt die vorweg niemand kennen kann, und die doch nicht beliebig sein wird…

Im Alltagsgeschäft der heutigen wissenschaftlichen Einzeldisziplinen — die absolut notwendig sind; ohne die geht gar nichts — findet man von diesem erfrischenden Hauch einer super-lebendigen Singularität nicht viel. Jeder ist mit dem Auszählen seiner Einzelexperimente beschäftigt. Im Mainstream träumt man von sogenannter Künstlicher Intelligenz, die alle unsere Problem überwinden wird; welch absolut schrottige Idee. Der ‚Supercomputer‘ des Lebens auf diesem Planeten ist davon mehrfache Galaxien weit entfernt.

Anmerkungen

[0] Karl Popper, „Towards an Evolutionary Theory of Knowledge“, Vortrag 1989, erweiterter Text in: Karl Popper, „A World of Propensities“, Thoemmes Press, Bristol, (1990, repr. 1995)

[0b] Die Einbeziehung der Erkenntnisse der Evolutionsbiologie in eine philosophische Gesamtsicht findet sich nicht nur bei Popper. Schon der Verhaltensforscher und Philosoph Konrad Lorenz [2] hatte in einem Aufsatz 1941 [2b]einen Zusammenhang zwischen der Erkenntnistheorie von Kant und den Erkenntnissen der Biologie hergestellt. Dies wird bei Lorenz dann 1973 in sein Hauptwerk „Die Rückseite des Spiegels …“ zu einer großen Gesamtschau ausgeweitet, in dem er explizit eine Verbindung zieht zwischen der morphologischen Entwicklung in der Evolution und den Formen der Erkenntnis. [2c]. Ein anderer starker Denker im Spannungsfeld von Biologie und Philosophie war Humberto Maturana [3], der in den Jahren 1968 – 1978 viele grundlegende Beiträge zum Thema verfasst hat.[2b] In Deutschland ist u.a. noch zu nennen Gerhard Vollmer mit seinem Buch Evolutionäre Erkenntnistheorie‘ von 1975.

[1] Evolutionäre Erkenntnistheorie in wkp-de: https://de.wikipedia.org/wiki/Evolution%C3%A4re_Erkenntnistheorie //* Dieser Artikel ist nicht besonders gut *//

[1b] Evolutionary Epistemology in wkp-en: https://en.wikipedia.org/wiki/Evolutionary_epistemology //* Dieser Artikel ist nicht besonders gut *//

[2] Konrad Lorenz in wkp-ed: https://en.wikipedia.org/wiki/Konrad_Lorenz und in wkp-de: https://de.wikipedia.org/wiki/Konrad_Lorenz

[2b] K. Lorenz: Kants Lehre vom Apriorischen im Lichte gegenwärtiger Biologie. In: Blätter für Deutsche Philosophie. Band 15, 1941, S. 94–125

[2c] K.Lorenz, Die Rückseite des Spiegels. Versuch einer Naturgeschichte des menschlichen Erkennens (1973), in wkp-de: https://de.wikipedia.org/wiki/Die_R%C3%BCckseite_des_Spiegels

[3] Humberto Maturana in wkp-en: https://en.wikipedia.org/wiki/Humberto_Maturana

[3b] Humberto R.Maturana, Erkennen; Die Organisation und Verkörperung von Wirklichkeit, Friedr.Viehweg & Sohn, Braunschweig – Wiesbaden, 1982 (Enthält von Maturana autorisiert in deutscher Übersetzung Arbeiten aus den Jahren 1968 – 1978).

[4] Gerhard Vollmer, Evolutionäre Erkenntnistheorie. Angeborene Erkenntnisstrukturen im Kontext von Biologie, Psychologie, Linguistik, Philosophie und Wissenschaftstheorie. S. Hirzel, Stuttgart 1975. Zu Vollmer in der wkp-de: https://de.wikipedia.org/wiki/Gerhard_Vollmer

[5] Evolution in wkp-en: https://en.wikipedia.org/wiki/Evolution

[6] Hans R.Kricheldorf, Leben durch chemische Evolution?, Springer-Verlag, 2019, ISBN: 978-3-662-57978-7

[7] A priori in wkp-de: https://de.wikipedia.org/wiki/A_priori

[8] Immanuel Kant in wpd-de: https://de.wikipedia.org/wiki/Immanuel_Kant

[9] Die hier benutzten anthropomorphen Begriffe sind als ‚Hilfsbegriffe‘ zu betrachten, da eine ‚präzisere‘ Begrifflichkeit einen ausgearbeiteten begrifflichen Rahmen (Modell, Theorie) voraussetzen würde, die erst dann möglich ist, wenn man sich über die grundsätzlichen Sachverhalte besser verständigt hat.

Fortsetzung

Es gibt einen dritten Artikel von Popper, der in diesen Zusammenhang gehört. Eine Besprechung findet sich HIER.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.