-

Gelegentlich gehe ich zu den interessanten Gastvorträgen des Max-Planck-Institutes (MPI) für Hirnforschung in Frankfurt. So auch wieder mal am 12.9.2012 zu einem Vortrag von Stefan Leutgeb (siehe Link). Auslöser war das Thema ‚Räumliches Gedächtnis‘.

-

Das Hervorstechende bei diesen Vorträgen ist in der Regel der ungeheure Aufwand an Ressourcen, der notwendig ist, um die überwiegend neuro-psycholoischen Untersuchungen durchführen zu können. Das Ernüchternde ist oft die Kargheit der Ergebnisse, und nicht nur das, sondern auch die ‚methodische Verpackung‘ sowohl der Experimente selbst wie deren Auswertung. Während die Randbedingungen der Experimente (erfreulicherweise) in der Regel mit großer Akribie beschrieben werden (vgl. als Beispiel den Artikel von Amir S. Bahar et al. (2011), mit Link), sucht man einen expliziten theoretischen Rahmen vergeblich (mir ist es bislang noch nicht gelungen, einen Artikel oder Buch aus diesem Bereich zu finden, der auch nur ansatzweise die notwendigen Bestandteile eines theoretischen Modells beschreibt). Dies ist sehr bedauerlich, da viele der Artikel mit Sicherheit an Klarheit und Durchschlagskraft gewinnen würden (manche würden dann möglicherweise gar nicht mehr geschrieben werden…).

-

In einem älteren Eintrag hatte ich mal kurz skizziert (vgl. Wissenschaftliches Denken-2), welche Elemente eine moderne wissenschaftliche Theorie ausmachen. Davon ist die Neurowissenschaft (zumindest so, wie sie sich bislang in ihren Publikationen darstellt), meilenweit entfernt. Eine grundlegende Änderung ist nicht in Sicht (in der Ausbildung eines Neurowissenschaftlers kommt formale Logik und Wissenschaftstheorie normalerweise nicht vor).

-

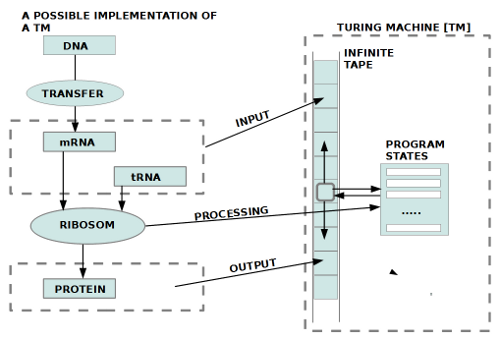

Sofern ich als Informatiker an berechenbaren Modellen von menschenähnlicher Intelligenz interessiert bin, bräuchten mich diese Defizite der Neurowissenschaften eigentlich nicht kümmern. Als Informatiker will ich primär nicht das Gehirn ‚1-zu-1‘ nachbauen, sondern bestenfalls versuche ich die Prinzipien neuronaler Maschinen zu verstehen, um sie mit ‚anderen‘ Mitteln nachzubauen. Da 98% oder mehr einer Nervenzelle nichts mit ihrer Signalfunktion im engeren Sinne zu tun haben kann ich diese 98% quasi ‚vernachlässigen‘. Ein Neurowissenschaftler kann dies nicht. Er muss die molekularen Prozesse hinreichend aufhellen, um die daraus resultierenden Funktionen mit Bezug auf diese Maschinerie zu erklären. Als Informatiker könnte ich zwar auch die verschiedenen elektronischen Bausteine eines Computers beschreiben, um deutlich zu machen, wie diese komplexen chemischen Materialien spezielle Signalfunktionen erlauben, aber normalerweise wird man dies nicht tun, da die Materialien austauschbar sind. Das Material selbst erklärt nicht die ‚Funktion‘, die damit realisiert wird. So wissen wir seit langem, dass ich einen Computer statt mit elektronischen Chips auch mit neuronalen Zellen realisieren kann oder direkt mit bestimmten Molekülen (z.B. DNA-Computing). Entscheidend ist nie das Material, sondern immer nur die Funktionen. Die Funktionen kann ich nicht aus dem Material ‚herleiten‘. Das ‚Herumstochern‘ in der molekularen Maschinerie des Gehirns ist von daher wenig geeignet, die entscheidenden Funktionen zu ‚enthüllen‘. Sehr zugespitzt könnte man formulieren „Die Neurowissenschaften wühlen im molekularen Schlamm, um das ‚Gold‘ der neuronalen Funktionen zu finden, aber es liegt nicht dort.“

-

Dies führt zu einem grundlegenden wissenschaftsphilosophischen Problem: Im Kontext der Physik hat man sich spätestens seit Kant die Frage gestellt, wieso abstrakte mathematische Modelle die komplexen Phänomene der Natur auf einfache elegante Weise hinreichend beschreiben können? Nicht die Anhäufung noch so vieler einzelner empirischer Daten führt zur Einsicht in grundlegende Zusammenhänge, sondern die Entwicklung abstrakter theoretischer Modelle, die es dann erlauben, die vielen Einzeldaten zusammenhängend erklären zu können. Wir verstehen bis heute zwar nicht, wie wir erklärungsfähige abstrakte Modelle ‚denken‘ können, da dies ja letztlich von unserem Gehirn geleistet wird, das nur eine endliche chemische Maschine einer speziellen Art darstellt, aber Fakt ist, dass wir nur mit solchen Modellen den ‚Wust der Daten‘ sinnvoll nutzen können. Dies gilt auch für die anhaltende Datenflut in den Neurowissenschaften, die einhergeht mit einer gleichzeitigen Modellarmut.

-

Wie gesagt, mein Interesse an dem Vortrag (und an den in diesem Zusammenhang recherchierten anderen Artikeln (siehe Quellen unten)) resultiert aus dem Interesse für Phänomene des Gedächtnis, da ich im Laufe der Jahre gelernt habe, dass es für adaptive lernende Strukturen zwei Kernelemente gibt, ohne die nichts geht: Gedächtnis und Preferenzen.

-

Eine erste ‚Stichprobe‘ von Artikeln im Umfeld des Vortrags von Leutgeb zeigt, dass keiner dieser Artikel sich die Mühe macht, zu Beginn genau das Feld zu beschreiben, innerhalb dessen eine Aufgabenstellung definiert wird (und ich spreche hier von Artikeln in Journalen wie ‚Science‘ oder den ‚Proceedings of the National Academy of Science of the USA‘ oder dem ‚Journal of Neuroscience‘). Nach ein paar (unvollständigen!) Andeutungen zu möglichen Kontextfaktoren formulieren diese Artikel eine Aufgabenstellung, die durchgehend vage ist. Will man sich vorweg selbst einen Überblick über die Thematik verschaffen, hat man nur die Wahl zwischen anerkannten Textbüchern, deren Inhalt aber zwangsläufig fünf und mehr Jahre alt ist, oder Wikipedia-Einträgen, die zwar recht aktuell sind, dafür aber eine sehr schwankende Qualität aufweisen (es gib aber auch einige sehr gute!). Ansätze zu theoretischen Modellen finden sich aber nirgends.

-

Da die neuronale Maschinerie ‚für sich‘ keinerlei ‚pragmatische‘ Bedeutung aufweist, sondern nur durch ihren Bezug zu Körperfunktionen und/ oder zu beobachtbarem dem Verhalten, folgen die meisten Beiträge dem Schema ‚Korrelation zwischen beobachtbarem Verhalten (Vh) und messbaren neuronalen Zuständen (NN), also CORR(Vh, NN), dies entlang einer Zeitachse. Im Prinzip handelt es sich um eine zweiseitige Abbildung. Normalerweise bedeutet dies, dass man sowohl den Bereich des Verhaltens entweder als Mengen von Eigenschaften beschreibt, die sich in einem Prozessbaum darstellen lassen, oder noch besser als theoretische Struktur VH(……); analog mit den neuronalen Zuständen NN(…..). Sofern man dies getan hat, kann man versuchen, geeignete Abbildungsbeziehungen zu formulieren. Ich sehe nicht, dass dies in irgendeinem dieser Papiere geschieht. Dazu kommt, dass zentrale theoretische Begriffe in den Artikeln (wie z.B. Netz-Zellen, Orts-Zellen, Orts-Feld, Pfadintegration, episodisches Gedächtnis,…), wenn überhaupt, nur äußerst vage definiert sind (ohne theoretisches Modell auch ziemlich schwierig).

-

Aus all dem folgt für meine Arbeiten an evolutionären semiotischen Systemen, dass für die Konstruktion adaptiver Systeme mit Gedächtnis diese Artikel nicht mehr als ‚Stimuli‘ auf dem Weg zu einer besseren Theorie sein können.

-

Im weiteren Text finden sich Kurzcharakterisierungen der verschiedenen Artikeln. Diese basieren entweder nur auf den Zusammenfassungen oder – in einigen Fällen – auf den Zusammenfassungen ergänzt um Teile aus dem Text. In einer Reihe von Fällen konnte ich Online-Versionen finden, so dass jeder sich dire Artikel im Original selbst anschauen kann. Aus Sicht des heutigen Wissenschaftsbetriebes sind wissenschaftliche Artikel, die nicht Online sind, eigentlich tote Artikel. Die Kosten für Abonnements von wissenschaftlichen Zeitschriften sind so hoch, dass eine durchschnittliche Hochschule in Deutschland nicht genügend Geld hat, um auch nur eine repräsentative Auswahl in hinreichendem Umfang und mit hinreichender Aktualität online anbieten zu können. Damit behindert sich die Wissenschaft genau da, wo ihr eigentliches Herz schlägt: in der Kommunikation. Der scheinbare wirtschaftliche Vorteil aus Sicht der Verlage erweist sich als Bumerang für die gesamte Wissenschaft (auch wenn eine Zeitung wie die FAZ dies oft anders sieht).

MATERIALSAMMLUNG

-

Laut Ankündigung von Stefan Leutgeb (2005, 2012) versucht sein Laboratorium auf der Systemebene die neuronalen Mechanismen zu identifizieren, die verantwortlich sind für die Langzeitspeicherung von Gedächtnisinhalten. Da man aufgrund bisheriger Forschungen weiß, dass spezielle Schaltkreise des Hippocampus für viele Arten von Gedächtnis notwendig sind, haben sie die Schnittstelle zwischen dem Hippocampus und dem entorhinalen Kortex näher untersucht. An dieser Schnittstelle lassen sich Signalmuster messen. Sein Laboratorium stellte sich die Frage, ob und wie diese Signalmuster räumliche Erinnerungen beeinflussen. Bei der Signalerzeugung sind sehr viele verschiedenen Zellen beteiligt, insbesondere sogenannte ‚Gitter-Zellen‘ (‚grid cells‘). Dabei hat sein Laboratorium herausgefunden, dass die Unterdrückung von sogenannten Theta Wellen zwar die gitter-artigen räumlichen Signalmuster im entorhinalen Kortex zerstörten, nicht aber die hippocampalen räumlichen Signalmuster, sofern die Versuchstiere sich in vertrauten Umgebungen bewegten. Sein Team stellte sich von daher die Frage, ob der entorhinale Input mit den Gitter-Zellen möglicherweise nur beim Erlernen von etwas ‚Neuem‘ notwendig sei, nicht aber beim ‚Erinnern‘ von ’schon Bekanntem‘. Beim Erlernen von Neuem stellte sich die zusätzliche Frage, ob dazu auch eine zeitliche Koordinierung von entorhinalen und hippocampalen Signalen notwendig sei.

-

György Buzsáki (2005) geht davon aus, dass der Hippocampus einen Beitrag leistet zur Repräsentation der Umwelt. Andererseits gibt es auch andere Signale, die den Hippocampus beeinflussen. Es fragt sich, wie diese unterschiedlichen Signale im Hippocampus koordiniert werden. Stefan Lautgeb et al. (2005) identifizieren unterschiedliche Signalmuster im Hippocampus, die sie mit Situationen korrelierten, die mit Raum- und episodischem Gedächtnis in Verbindung bringen lassen. James J. Knierim (2006) thematisiert sogenannte ‚Orts-Zellen‘ (‚place cells‘) die sich im Hippocampus oder in angrenzenden Regionen finden. Dazu kommen Signalmuster, die nicht ortsgebunden sind. Der genaue Mechanismus des Zusammenspiels all dieser Signale ist aber noch nicht klar. Eva Pastalkova et al. (2006) weisen nach, dass der LTP-Mechanismus, der Langzeitspeicherung unterstützt, auch bei der Speicherung räumlicher Informationen eine Rolle spielt. James A. Ainge et al. (2007) können präzisieren, dass im Hippocampus räumliche Informationen mit ‚intendierten‘ Zielen korreliert werden können. Caswell Barry et al. (2007) finden heraus, dass die sogenannten ‚Gitter-Zellen‘ (‚grid cells‘) im entorhinalen Kortex (benachbart zum Hippocampus), den Abstand zwischen benachbarten Orten repräsentieren können (und damit die Ortsinformationen der Orts-Zellen ergänzen). Daoyun Ji und Matthew A Wilson (2007) finden Hinweise, dass im Schlaf der Neokortex und der Hippocampus so zusammenwirken können, dass Signalmuster von ‚gemachten Erfahrungen‘ sich wechselseitig regenerieren. Gergely Papp et al. (2007) vergleichen Gehirnstrukturen zwischen sehr vielen Arten von Wirbeltieren und untersuchen die Anwendbarkeit unterschiedlicher neuronaler Modelle zur Simulation des messbaren Verhaltens. Sie kommen zur Vermutung, dass für den Erwerb neuer Gedächtnisrepräsentationen allgemein wie auch speziell von räumlichen Gedächtnis-Repräsentationen der CA3-Teilbereich des Hippocampus nicht ausreicht. Daoyun Ji und Matthew A. Wilson (2008) untersuchten ferner die Rolle des Hippocampus im Kontext des sequentiellen Wege-Lernens. Sie fanden heraus, dass die hippocampalen Orts-Zellen bei Wiederholungen immer mehr von den Signalmustern unmittelbar vorausgehender Ortszellen beeinflusst wurden. C. D. Clelland et al. (2009) finden Hinweise (bei Mäusen), dass der Bereich Gyrus dentatus des Hippocampus wichtig ist für die Unterscheidung räumlicher Muster. Dori Derdikman et al. (2009) fanden heraus, dass räumliche Umgebungen im entorhinalen Kortex (Umgebung des Hippocampus) repräsentiert sind als ein Mosaik diskreter Teilkarten, die der Geometrie des umgebenden Raumes entsprechen. Pamela J. Kennedy und Matthew L. Shapiro (2009) können aufzeigen, dass im Hippocampus sowohl räumliche Informationen kodiert werden wie auch innere Zustände, die Bedürfnisse repräsentieren. Sofern Bedürfnisse vorliegen beeinflussen diese die neuronalen Muster in Richtung des Auffindens geeigneter Lösungen. Joseph R. Manns und Howard Eichenbaum (2009) kamen zur Hypothese, dass Objekte der Umgebung in einer Art Wissenslandkarte (‚cognitive map‘) im Hippocampus repräsentiert (kodiert) werden, und zwar einmal als ‚Orte von Interesse‘ (‚points of interest‘) wie auch als erinnerbare Unterstützung beim Suchen nach Objekten von speziellem Interesse. Charlotte N Boccara et al. (2010) fanden einen gemeinsamen Pool von raum-sensitiven Zellen in verschiedenen Unter- und Nachbarschaftsbereichen des Hippocampus (im medialen entorhinalen Kortex (MEC) und im Prä- and Parasubiculum (zwischen Hippocampus und Kortex). Diese Zellen befanden sich ferner in der Nachbarschaft von sogenannten ‚Richtungs-‚ und ‚Kanten-Zellen‘ (‚head‘, ‚boarder‘).

-

Laura L. Colgin et al. — mit Leutgeb — (2010) kommen in ihrer Untersuchung zu dem Schluss, dass der Bereich CA3 (Teilbereich des Hippocampus) sich nicht wie ein standardmäßiges autoassoziatives neuronales Netz verhält, das unterschiedliche Eigenschaften der Umgebung miteinander verknüpft. Diese Ergebnisse stimmen auch überein mit anderen Untersuchungen (vgl. S.48). Damit stellt sich die Frage nach der Funktion des CA3-Bereichs neu. In Übereinstimmung mit zahlreichen anderen Untersuchungen (Zitate in diesem Artikel) scheint die primäre Aufgabe des Hippocampus zu sein, Pfadinformationen zu kodieren, so, dass nach Bedarf eine günstige Route wiedergefunden werden kann. Zugleich können diese Pfadinformationen Hinweise sein für episodische Erinnerungen, die verteilt im Neokortext abgelegt sind. André A. Fenton et al. (2010) konnten bestätigen, dass der Ortskode des Hippocampus eine dynamische räumliche Repräsentation realisiert, die durch Aufmerksamkeit kontrolliert werden kann. Die Aufmerksamkeit von von den aktuellen Bedürfnissen gesteuert, die aus den verfügbaren Zeitfenstern jenes auswählen, dessen Inhalt am meisten mit den Bedürfnissen korreliert.

-

Inah Lee und Jangjin Kim (2010) haben auch die Abhängigkeit der räumlichen Repräsentationen im Hippocampus von internen Zuständen untersucht, insbesondere im Kontext von Lernaufgaben, die von Ratten verlangten, neue Strategien zu entwickeln. Neben der Assoziationsaufgabe, Objekte mit bestimmten Orten zu verknüpfen, mussten die Ratten auch lernen, dass es aber nur an einem bestimmten Ort eine Belohnung gab. Bei Messungen an Neuronen in CA1 konnten sie feststellen, dass sich die Signalmustern entsprechend der jeweiligen Strategie änderten. Diese Ergebnisse führen die beiden zu der Annahme, dass die räumliche Information im Hippocampus als Referenzrahmen im Hippocampus dient, innerhalb dessen dann die anderen Informationen organisiert werden. In dieses Gesamtbild passen die Funde, dass Objektinformationen im Hippocampus der Ratten ausschließlich zusammen mit Rauminformationen auftreten. Ferner legen die Ergebnisse dieser Untersuchung die Annahme nahe, dass auch nichträumliche Informationen – zumindest in CA1 — nicht unabhängig von den räumlichen Informationen sind.

-

Die Autoren Francesco Savelli und James J. Knierim (2010) sind geleitet von dem Interesse, ein bestimmtes formales Modell (hebbsches neuronales Lernen) im Kontext von ‚Gitter-‚ und ‚Orts-Zellen‘ im medialen entorhinalen Kortex (MEC) sowie im Hippocampus zu überprüfen. Speziell untersuchen sie die Übersetzung von Signalmustern von Gridzellen in die Signalmuster von Ortszellen.

-

Annabelle C. Singer et al. (2010) mit ihrem Team geht davon aus, dass sich wiederholende Objekte eindeutig identifizieren lassen müssen, aber auch Eigenschaften der Umgebungen, in denen diese Objekt vorkommen. Ein anderer Aspekt ist die Ähnlichkeit von Wegen (‚path equivalence‘). Das Team unterstellt koordinierte gelernte Generalisierungen über verschiedene Plätze und Episoden. Untersucht wurden neuronale Aktivitäten in CA3 und CA1 während die Tiere Aufgaben abarbeiten müssen, bei denen sie zwischen ähnlichen Elementen unterscheiden müssen. Das Team meint pfad-äquivalente Neuronenensembles identifiziert zu haben.

-

Die Untersuchung von Janina Ferbinteanu et al. (2011) beginnt bei den bisherigen Ergebnissen, dass hippocampale Neuronen sowohl aktuelle Positionen im Raum repräsentieren können (Ortsfelder – Orts-Zellen), aber sie können auch vergangene und zukünftige Positionen im Kontext einer ‚Reise‘ (‚journey‘) repräsentieren. Letzteres verweist auf andere zeitlich zusammenhängende Gedächtniseintragungen (z.B. autobiographisches [oder auch episodisches] Material). Die Bedeutung der reise-abhängigen Aktivitäten für die Repräsentationen ist aber nicht besonders gut verstanden. Zu diesem Zweck haben sie eine experimentelle Anordnung ersonnen, in der man sowohl ortsspezifische Reize zur Verfügung hat wie auch reisespezifische Anforderungen unterstellen kann. Sie unterstellten, dass der Beginn einer Reise, ein auftretender Entscheidungspunkt sowie der Restweg nach der Entscheidung unterschiedliche Anforderungen darstellen, denen unterschiedliche ‚Strategien‘ entsprechen, die sich in den Signalmustern und darin kodiert in unterschiedliche beteiligten Gedächtnisarealen manifestieren. Mit einer — für neuronale Studien typischen — sehr aufwendigen Untersuchung wurden Daten gewonnen, die das Team dahingehend interpretiert, dass sie ein ‚Umschalten‘ (’switch‘) zwischen verschiedenen Aufgaben (aktuelle Position, zu erledigende Reise) erkennen können. So kodierten die Signalmuster im Startbereich sowohl Aufgabe und Reise, während die Signalmuster im Restbereich überwiegend die Reise kodierten. Sie deuten diese Daten zusätzlich als einen Hinweis auf eine Verzahnung zwischen den aktuellen Reisedaten und einem episodenorientierten Gedächtnis. Interessant ist die Charakterisierung von ‚Reise‘. Sie sagen, dass in ihrer Interpretation eine Reise nicht einfach eine Trajektorie von verknüpften physikalischen Orten darstellt, sondern eine Verbindung zwischen einem Start-Ort und einem Ziel (‚goal‘) kodiert, wobei diese Verbindung durch interne Zustände (einschließlich Motivation) und verfügbaren Gedächtnisinhalten ‚moduliert‘ werden kann.

-

In einer Untersuchung, die dem Aufbau von Ferbinteanu et al. (2011) ähnelt, haben Amir S. Bahar et al. (2011) versucht, herauszufinden, wie man sich den Einfluss des Gedächtnisses beim Lernen genauer vorzustellen habe. Mit Bezug auf einfache Lernaufgaben untersuchten sie insbesondere das Signalverhalten von Ortszellen-Karten in CA1 und CA3. Obgleich zwischen CA1 und CA2 deutliche Unterschiede je nach Aufgabenstellungen gefunden werden konnten, gibt es aber auch Kooperationen.

-

Die Untersuchung von Lindsay K. Morgan et al. (2011) unterscheidet sich von den vorausgehenden dahingehend, dass als Versuchslebewesen nicht Ratten dienen, sondern Menschen. Damit sind die Messmöglichkeiten stark eingeschränkt. Ausgangshypothese ist, dass die räumliche Navigation teilweise unterstützt wird durch Bezug auf eine intern Wissenskarte (‚cognitive map‘) der Umgebung. Eine Schlüsseleigenschaft solcher angenommener Wissenskarten ist die Repräsentation von Realweltabständen. Es wird angenommen, dass man diese mit Hilfe eines funktionellen Magnetresonanstomographen (oder als Verfahren ‚functional magnetic resonance imaging (fMRI)‘) messen kann. Als Versuchslebewesen dienten Universitätstudenten, während sie Fotos von bekannten Ausschnitten des Universitätsgeländes anschauten. Aus den fMRI-Daten zog das Team den Schluss, dass im linken Hippocampus die fMRI-Antwortniveaus (‚response levels‘) mit den Realweltdistanzen ‚korrespondierten‘ (‚corresponded‘) mit jenen in den gezeigten Bildern. Dabei meinte das Team erkennen zu können, dass jene Orientierungspunkte (‚landmarks‘), die im Bild ’näher‘ (‚closer‘) waren, repräentationell (‚representationally‘) ähnlicher waren als solche, die im Bild ‚weiter entfernt‘ (‚mor distant‘) waren. In anderen Regionen wie dem retrosplenialen Kortex oder dem parahippocampalen Bereich waren laut dem Team solche Beziehungen nicht zu beobachten. Der Anteil von Wörtern wie ‚glauben‘ und ‚vermuten‘ ist sehr hoch. Zudem werden verhaltensbasierte Ergebnisse mit Messungen an physiologidschen Substraten recht freitügig kombiniert ohne große Reflexion auf die unterschiedliche Qualitäten von bildgebenden Verfahren und direkten Messungen an Zellen.

-

David C.Rowlanda et al. (2011) gingen von der Annahme aus, dass (nach den bisherigen Erkenntnissen) der Hippocampus für Menschen und andere Säugetiere kritisch ist für episodisches Gedächtnis (‚episodic memory‘). Damit sind die autobiographischen Aufzeichnungen von Ereignissen gemeint, zu denen die Aspekte ‚wo‘ und ‚wann‘ gehören. Sie meinen, dass bei wachen, sich verhaltenden (‚behaving‘) Nagetieren (‚rodents‘) ganz offensichtlich die Signalmuster von hippocampalen Pyramidenzellen mit der aktuellen Position in einer bestimmten Umgebung ‚korreliert‘ (von daher der Name ‚Orts-Zellen‘ (‚place cells‘)). Wenn ein Tier eine neue Umgebung erkundet, dann bilden die pyramidalen Neuronen innerhalb von wenigen Minuten ihre raumbezogenen rezeptiven Felder aus, und diese sind in der Regel danach stabil. Das Team nimmt daher an, dass diese erfahrungsabhängige Stabilisierung der Orts-Felder (‚place fields‘) ein attraktiver Kandidat eines neuronalen Korrelates für die Bildung eines hippocampalen Gedächtnisses bietet. Zusätzlich wird angenommen, dass (a) raumabhängiges Feuern als solches angeboren ist (‚innate property‘) und (b), dass Ratten während Schlaf- und Ruhephasen sich Orte und Wege ‚vorstellen‘ können (‚mentally explore‘, ‚preplay‘), bevor diese physisch untersucht werden. Unklar ist hierbei, wie genau die Überführung der Erfahrung eines Tieres von einem Kontext in ein stabiles Ortsfeld vonstatten geht, z.B. weiß man nicht, ob die Beobachtung eines Raumes bzw. die rein mentale Exploration alleine für eine stabile hippocampale Repräsentation des Raumes ausreicht, da normalerweise ein Tier dafür einen bestimmten Punkt (’spot‘) physisch besuchen muss, um demonstrieren zu können, dass bestimmte Zellen dort feuern. Um diese beiden Fälle zu klären, nutzte das Team die Erkenntnis, dass NMDA-Rezeptoren neu gebildete Orts-Felder destabilisieren können. Das Team fand heraus, dass Beobachtung alleine nicht ausreicht, um Ortsfelder zu stabilisieren. Sie deuten ihre Ergebnisse dahingehend, dass die hippocampale Repräsentation von Raum so lange ‚plastisch‘ (‚plastic‘) bleibt, bis das Tier alle Bereiche der Umgebung erkundet hat. In diesem Sinne sind Ortsfelder weniger die Repräsentation des geometrischen Raumes an sich, sondern eher die Repräsentation der Erfahrung des Tieres im Raum.

-

Das Team Junghyup Suh et al. (2011) geht von der Annahme aus, dass das entorhinale und hippocampale Netzwerk für die Formierung eines episodischen und Arbeitsgedächtnis wichtig ist. Kennzeichnend für beide Gedächtnisformen ist die Fähigkeit der Verknüpfung von zeitlich nicht zusammenhängenden Elementen. Nach Auffassung des Teams sind die genauen neuronalen Schaltkreise unbekannt, die diese Verknüpfungen ermöglichen. So beschloss das Team, zu untersuchen, ob z.B. die Input-Neuronen von der Schicht III des entorhinalen Kortex einen Beitrag leisten. Um diese Annahme zu testen hat das Team eine transgenetische (‚transgenetic‘) Maus ‚hergestellt‘ (‚generated‘), in der diese Input-Neuronen spezifisch inhibiert waren. Diese Mutanten-Mäuse zeigten dann tatsächlich signifikante Beeinträchtigungen sowohl bei Aufgaben, bei denen normalerweise das räumliche Arbeitsgedächtnis wirksam ist wie auch bei der Enkodierung von Angstreaktionen. Das Team zieht daraus den Schluss, dass die gefundenen Ergebnisse eine kritische Rolle der Input-Neuronen der Schicht III des entorhinalen Kortex in Weiterleitung zum Hippocampus für zeitliche Verknüpfungen im Gedächtnis darstellen.

-

Ausgehend von hippocampalen Orts-Zellen, die Rauminformationen durch eine Kombination von räumlichem selektiven Feuern und Thetawellen-Phasen-Präzession auszeichnen, untersuchte das Team Steve M. Kim et al. (2012) eine mögliche Wirkung auf die Neuronen des Subiculums. Das Subiculum empfängt direkten Input von der Region CA1 (innerhalb des Hippocampus) und sendet unterschiedliche Ausgangsprojektionen zu vielen anderen Gehirnbereichen. Das Team fokussierte sich darauf, die Signalmuster von Neuronen im Subiculum von Ratten zu untersuchen. Rein aufgrund der Signalmuster (ohne korrelierte Verhaltensbeobachtungen) errechnete das Team einen höheren Informationsgehalt in den Signalmustern des Subiculums, dazu auffällig robuste Thetawellen-Phasen-Präzessionen mit ähnlichen Spike-Oszillations-Frequenzen (‚spiking oscillation frequencies‘) wie Neuronen aus CA1.

-

Das Team Eun Joo Kim et al. (2012) geht aus von der Annahm, dass Streß ein biologischer Faktor ist, der allgegenwärtig ist. Wenn er als unkontrollierbar durch Menschen (oder Tiere) als wahrgenommen wird, kann er andauernde negativen Effekte für das Gehirn und seine kognitiven Funktionen haben. In einer früheren Untersuchung hatte das Team am Beispiel von Ratten darüber berichtet, dass diese eine Abnahme in der Stabilität von Signalraten in CA1 erkennen liesen verbunden mit Behinderungen von Langzeit-Potentialen in CA1 sowie der Konsolidierung von räumlichem Gedächtnis. Diese Ergebnisse wurden dahingehend verfeinert, dass es eher die erhöhte Aktivität der Amygdalar-Neuronen ist, die Stress auslöst, als die Konzentration von Kortikosteron, Stress, der dazu führt, dass sich die Stabilität der Signalraten der Ortszellen verändert.

-

Ausgangspunkt für das Team Carien S. Lansink et al. (2012) ist die Annahme, dass die Verknüpfungen von Orten mit Belohnungen kritisch abhängt von der Integrität des hippocampalen-ventralen Systems. Das ventrale Striatum (VS) empfängt einen starken räumlich-kontextuellen Input vom Hippocampus (CA1), aber es ist nicht klar, wie das ventrale Striatum diese Informationen so verarbeiten kann, dass damit ein belohnungsbezogenes Verhalten entsteht. Um diese Frage zu beantworten wurde ein Verhaltensexperiment gestartet, bei dem eine konditionierte Aufgabe durch Pfadintegration zu lösen war. Dabei wurden simultan sowohl die Signale im Hippocampus (HC) wie auch im VS von Ratten gemessen. Im Gegensatz zum HC zeigten VS-Neuronen eine geringe räumliche Auflösung; dafür kodierten sie verhaltensbezogene Aufgaben-Phasen (‚task phases‘) mit Bezug auf die Erreichung von Zielorten (‚goal sites‘). Solche Schlüsselreize (‚cues‘)(z.B. Lichtreize), die einen bestimmten Ausgang voraussagen können, bewirkten eine Umprogrammierung (‚remapping‘) von Signalmustern im HC; für das Team steht dies in Übereinstimmung mit der Rolle des HC für das episodische Gedächtnis. Eine solche Umprogrammierung kann für die gleiche Aufgabe in unterschiedlichen Gehirnregionen stattfinden. Im Gesamtergebnis zeigen diese Resultate, dass einerseits zwar ein großer Unterschied im Verarbeiten räumlicher Informationen zwischen CA1 (Hyppocampus) und VS besteht, doch besteht eine Ähnlichkeit darin, dass diskrete Schlüsselreize diese Prozesse beinflussen.

Literaturhinweise:

2005

György Buzsáki, Similar Is Different in Hippocampal Networks, Science 309 (5734): 568-569, 2005

Stefan Leutgeb, Jill K. Leutgeb, Carol A. Barnes, Edvard I. Moser, Bruce L. McNaughton, May-Britt Moser, Independent Codes for Spatial and Episodic Memory in Hippocampal Neuronal Ensembles, Science 22 July 2005: Vol. 309 no. 5734 pp. 619-623

2006

James J. Knierim, Neural representations of location outside the hippocampus (online at http://www.learnmem.org/cgi/doi/10.1101/lm.224606 ), Copyright © 2006, Cold Spring Harbor Laboratory Press

Eva Pastalkova, Peter Serrano, Deana Pinkhasova, Emma Wallace, André Antonio Fenton, Todd Charlton Sacktor, Storage of Spatial Information by the Maintenance Mechanism of LTP, Science 25 August 2006: Vol. 313 no. 5790 pp. 1141-1144 DOI: 10.1126/science.1128657

2007

James A. Ainge, Minija Tamosiunaite, Florentin Woergoetter, Paul A. Dudchenko, Hippocampal CA1 Place Cells Encode Intended Destination on a Maze with Multiple Choice Points, Copyright © 2007 Society for Neuroscience 0270-6474/07/27l119769-

Caswell Barry, Robin Hayman, Neil Burgess & Kathryn J Jeffery, Experience-dependent rescaling of entorhinal grids, Nature Neuroscience 10, 682 – 684 (2007)

Daoyun Ji, Matthew A Wilson, Coordinated memory replay in the visual cortex and hippocampus during sleep, Nature Neuroscience 10, 100 – 107 (2007)

Gergely Papp, Menno P Witter, Alessandro Treves, The CA3 network as a memory store for spatial representations, online at http://www.learnmem.org/cgi/doi/10.1101/lm.687407, Received July 1, 2007, Accepted September 5, 2007, Copyright © 2007, Cold Spring Harbor Laboratory Press

2008

Daoyun Ji, Matthew A. Wilson, Firing Rate Dynamics in the Hippocampus Induced by Trajectory Learning, The Journal of Neuroscience, 30 April 2008, 28(18): 4679-4689; doi: 10.1523/JNEUROSCI.4597-07.2008

2009

C. D. Clelland, M. Choi, C. Romberg, G. D. Clemenson Jr., A. Fragniere, P. Tyers, S. Jessberger, L. M. Saksida, R. A. Barker, F. H. Gage, T. J. Bussey, A Functional Role for Adult Hippocampal Neurogenesis in Spatial Pattern Separation, Science 10 July 2009: Vol. 325 no. 5937 pp. 210-213, DOI: 10.1126/science.1173215

Dori Derdikman, Jonathan R Whitlock, Albert Tsao, Marianne Fyhn, Torkel Hafting, May-Britt Moser, Edvard Moser, Fragmentation of grid cell maps in a multicompartment environment, Nature Neuroscience 12, 1325 – 1332 (2009) Published online: 13 September 2009, doi:10.1038/nn.2396

Pamela J. Kennedy, Matthew L. Shapiro, Motivational states activate distinct hippocampal representations to guide goal-directed behaviors, approved May 6, 2009 (received for review March 26, 2009). Published online before print June 15, 2009, doi: 10.1073/pnas.0903259106 PNAS June 30, 2009 vol. 106 no. 26 10805-10810. This article contains supporting information online at www.pnas.org/cgi/content/full/0903259106/DCSupplemental.

Joseph R. Manns, Howard Eichenbaum, A cognitive map for object memory in the hippocampus, Online at http://www.learnmem.org/cgi/doi/10.1101/lm.1484509, Received May 14, 2009, accepted July 21, 2009, Copyright © 2009 by Cold Spring Harbor Laboratory Press, Supplemental material is available online at http://www.learnmem.org.

2010

Charlotte N Boccara, Francesca Sargolini, Veslemøy Hult Thoresen, Trygve Solstad, Menno P Witter, Edvard I Moser, May-Britt Moser. Grid cells in pre- and parasubiculum, Nature Neuroscience 13, 987–994,(2010) doi:10.1038/nn.2602, Received 25 March 2010

Laura L. Colgin, Stefan Leutgeb, Karel Jezek, Jill K. Leutgeb, Edvard I. Moser, Bruce L. McNaughton, May-Britt Moser, Attractor-Map Versus Autoassociation Based Attractor Dynamics in the Hippocampal Network, Published online before print May 5, 2010, doi: 10.1152/jn.00202.2010 AJP – JN Physiol July 1, 2010 vol. 104 no. 1 35-50 Submitted 25 February 2010, accepted in final form 3 May 2010,

Copyright © 2010 The American Physiological Society. Online at http://jn.physiology.org/content/104/1/35.full.pdf+html

André A. Fenton, William W. Lytton, Jeremy M. Barry, Pierre-Pascal Lenck-Santini, Larissa E. Zinyuk, Štepan Kubík, Jan Bureš, Bruno Poucet, Robert U. Muller, Andrey V. Olypher, Attention-Like Modulation of Hippocampus Place Cell Discharge, online at: http://www.ncbi.nlm.nih.gov/pmc/articles/PMC2858227/

Inah Lee, Jangjin Kim, The shift from a response strategy to object-in-place strategy during learning is accompanied by a matching shift in neural firing correlates in the hippocampus, online at: http://learnmem.cshlp.org/content/17/8/381.full.pdf+html doi: 10.1101/lm.1829110 Learn. Mem. 2010. 17: 381-393 © 2010 Cold Spring Harbor Laboratory Press

Francesco Savelli, James J. Knierim, Hebbian Analysis of the Transformation of Medial Entorhinal Grid-Cell Inputs to Hippocampal Place Fields, Submitted 16 October 2009, accepted in final form 25 March 2010. Published online before print March 31, 2010, online at: http://jn.physiology.org/content/103/6/3167.full.pdf+html, doi: 10.1152/jn.00932.2009 AJP – JN Physiol June 1, 2010 vol. 103 no. 6 3167-3183

Annabelle C. Singer, Mattias P. Karlsson, Ana R. Nathe, Margaret F. Carr, Loren M. Frank, Experience-Dependent Development of Coordinated Hippocampal Spatial Activity Representing the Similarity of Related Locations, The Journal of Neuroscience, 1 September 2010, 30(35): 11586-11604; doi: 10.1523/JNEUROSCI.0926-10.2010, online at: http://www.jneurosci.org/content/30/35/11586.full

2011

Janina Ferbinteanu, Prasad Shirvalkar, Matthew L. Shapiro, Memory Modulates Journey-Dependent Coding in the Rat Hippocampus, The Journal of Neuroscience, 22 June 2011, 31(25): 9135-9146; doi: 10.1523/JNEUROSCI.1241-11.2011. Online at: http://www.jneurosci.org/content/31/25/9135.full

Amir S. Bahar, Prasad R. Shirvalkar, Matthew L. Shapiro, Memory-Guided Learning: CA1 and CA3 Neuronal Ensembles Differentially Encode the Commonalities and Differences between Situations, The Journal of Neuroscience, 24 August 2011, 31(34): 12270-12281; doi: 10.1523/JNEUROSCI.1671-11.2011, online at: http://www.jneurosci.org/content/31/34/12270.full.pdf+html?sid=da480191-1abf-4e09-b784-7f0dca5dd10e

Lindsay K. Morgan, Sean P. MacEvoy, Geoffrey K. Aguirre, Russell A. Epstein, Distances between Real-World Locations Are Represented in the Human Hippocampus, J Neurosci. 2011 January 26; 31(4): 1238–1245. doi:10.1523/JNEUROSCI.4667-10.2011, online at: http://www.ncbi.nlm.nih.gov/pmc/articles/PMC3074276/pdf/nihms266858.pdf

David C. Rowlanda, Yelizaveta Yanovich, Clifford G. Kentrosb, A stable hippocampal representation of a space requires its direct experience, Published online before print August 18, 2011, doi: 10.1073/pnas.1105445108 PNAS August 18, 2011 online at: http://www.pnas.org/content/early/2011/08/17/1105445108.full.pdf+html?with-ds=yes

Junghyup Suh, Alexander J. Rivest, Toshiaki Nakashiba, Takashi Tominaga, Susumu Tonegawa, Entorhinal Cortex Layer III Input to the Hippocampus Is Crucial for Temporal Association Memory, Published Online November 3 2011, Science 9 December 2011:

Vol. 334 no. 6061 pp. 1415-1420, DOI: 10.1126/science.1210125, abstract online at: http://www.ncbi.nlm.nih.gov/pubmed/22052975

2012

Steve M. Kim, Surya Ganguli, Loren M. Frank, Spatial Information Outflow from the Hippocampal Circuit: Distributed Spatial Coding and Phase Precession in the Subiculum, The Journal of Neuroscience, 22 August 2012, 32(34): 11539-11558; doi: 10.1523/JNEUROSCI.5942-11.2012

Eun Joo Kim, Earnest S. Kim, Mijeong Park, Jeiwon Cho, Jeansok J. Kim, Amygdalar Stimulation Produces Alterations on Firing Properties of Hippocampal Place Cells, J Neurosci. 2012 Aug 15;32(33):11424-34.

Carien S. Lansink, Jadin C. Jackson, Jan V. Lankelma, Rutsuko Ito, Trevor W. Robbins, Barry J. Everitt, Cyriel M.A. Pennartz, Reward Cues in Space: Commonalities and Differences in Neural Coding by Hippocampal and Ventral Striatal Ensembles. Received February 7, 2012. Revision received June 14, 2012. Accepted July 12, 2012. The Journal of Neuroscience, 5 September 2012, 32(36): 12444-12459; doi: 10.1523/JNEUROSCI.0593-12.2012

Hilfreiche zusätzliche Links:

Stefan Leutgeb: http://biology.ucsd.edu/faculty/sleutgeb.html (zuletzt 17.Sept.2012)

Gitter-Zellen: http://en.wikipedia.org/wiki/Grid_cell (zuletzt 15.Sept.2012)

Pfad Integration: http://en.wikipedia.org/wiki/Path_integration (zuletzt 15.Sept.2012)

Orts-Zellen: http://en.wikipedia.org/wiki/Place_cell (zuletzt 15.Sept.2012)

Kopf-Richtungs-Zellen: http://en.wikipedia.org/wiki/Head_direction_cells (zuletzt 15.Sept.2012)

Raum-Sicht-Zellen: http://en.wikipedia.org/wiki/Spatial_view_cells (zuletzt 15.Sept.2012)

Grenz-Zellen: http://en.wikipedia.org/wiki/Border_cell_%28brain%29 (zuletzt 15.Sept.2012)

Striatum: http://en.wikipedia.org/wiki/Striatum (zuletzt 17.Sept.2012)

Einen Überblick über alle bisherigen Themen findet sich HIER