Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 1.Februar 2021 (Zuletzt 1.2.2021, 13:45h)

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

KONTEXT

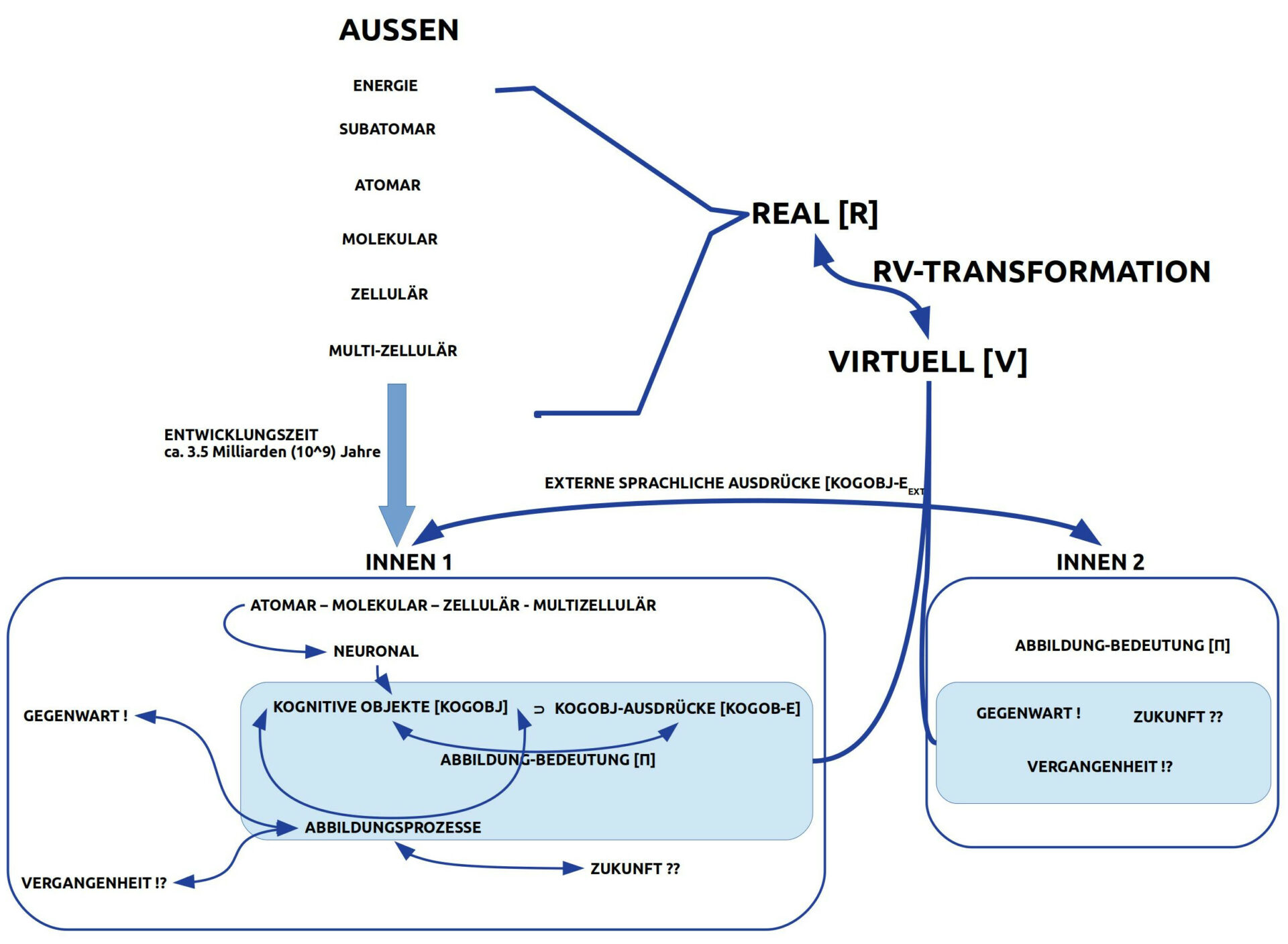

Den wenigsten Menschen ist bewusst, dass das Bild von der Welt, das sie haben, nicht tatsächlich die Welt ist, wie sie unabhängig vom Gehirn (=real) ist, sondern die Welt, die das Gehirn von der Welt da draußen aus all den sensorischen und bislang gespeicherten Daten (Gedächtnis) zusammen rechnet (=virtuell). Dies erklärt, warum die gleiche Welt (da draußen) von verschiedenen Menschen so total verschieden wahrgenommen werden kann.

AUSSEN – INNEN

Der Begriff Außen ist letztlich nur sinnvoll im Gegensatz zu einem aufzeigbaren Innen. Beispiel für solch ein aufzeigbares Innen ist das menschliche Bewusstsein, das wiederum verweist auf kognitive Zustände unseres Gehirns, das sich in unserem Körper befindet.

Für uns als Menschen ist zunächst das subjektive Erleben unserer Bewusstseinsinhalte wie das Erleben selbst (einschließlich Denken, Vorstellen, Erinnern usw.) primär real. Im Laufe des Lebens kann man aber erkennen, dass diese primäre Realität eindeutig nicht die Welt selbst ist, da sie an unser Bewusstsein gebunden ist, das über das Gehirn in unserem Körper verankert ist. Die subjektive Realität ist eine abgeleitete Realität; unser Gehirn produziert eine virtuelle Realität, die sich für uns als subjektives Erlebende wie eine Realität darstellt!

KONVERSION: REALITÄT ZU VIRTUALITÄT

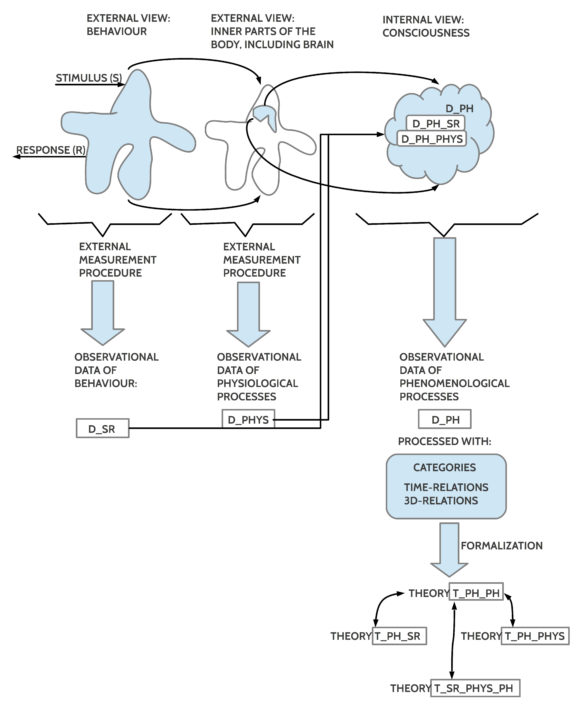

Hat man diesen Erkenntnispunkt erreicht, dass die subjektive Realität eine abgeleitete Realität ist, ein Rechenergebnis des Gehirns, das sensorische Fragmente einer Welt da draußen (=real) in neuronale Strukturen und Prozesse übersetzt/ konvertiert, die als neuronale Prozesse zwar real sind, aber in den erzeugten internen Informationsstrukturen innerhalb der neuronalen Prozesse als Repräsentanten der mit-verursachenden externen Realität ein Abbildungsprodukt, sind, erzeugt durch Abbildungsprozesse, und so gesehen nur als bildhaft, als virtuell bezeichnete werden können, dann kann man begreifen, dass ein biologischer Organismus wie der des homo sapiens — neben vielen anderen Funktionen — eine Funktion ganz speziell erkennen lässt: der gesamte Organismus ist ein Konverter von Realität in Virtualität!

Der Aufwand, der getrieben werden muss (musste), um dies zu ermöglichen ist extrem hoch und man fragt sich unwillkürlich, wofür das gut sein soll?

Bevor man eine Antwort zu geben versucht, sollte man sich noch eine weitere bemerkenswerten Funktion von homo sapiens Organismen vor Augen führen.

AUSTAUSCH: INNEN ZU INNEN

Von Bakterien und Viren ist bekannt, dass sie als Gesamtheiten schon immer einen intensiven Informationsaustausch pflegen (was mich dazu inspiriert hatte von diesen Gesamtheiten als BIOM zu sprechen und das gesamte BIOM als biologischen Super-Computer zu sehen, der die unfassbaren Formenproduktionen der Evolution in Interaktion mit den jeweiligen Umgebungen ermöglicht hat).

Durch die biologische Ermöglichung einer Konversion von Realität in neuronal ermöglichte Virtualität eröffnete sich nicht nur die Möglichkeit, im Bereich der Virtualität verschiedene kreative Prozesse zu gestalten, die abgeleitete Formen von Realität generieren können, für die es aktuell so noch keine Vorgaben in der umgebenden Realität gibt. Dies neuen Formen können indirekt zu Änderungen in der realen Welt führen, die ohne diese kreativen virtuellen Prozesse entweder gar nicht oder erst sehr viel später möglich gewesen wären. Da Änderungen nicht per se von irgendeinem Vorteil sein müssen — sie können schädlich bis zerstörerisch sein –, ist diese neuartige Befähigung zu inneren kreativen Prozessen somit zwar eine neue Chance, zugleich aber auch ein neues Risiko.

Um nun sowohl die Chance — als auch das Risiko — zu erhöhen, gibt es noch eine weitere speziell Funktion von biologischen Lebensformen — am extremsten ausgeprägt beim homo sapiens –: die zusätzliche Abbildung von kognitiven Strukturen auf andere kognitive Strukturen, bei denen die kognitiven Strukturen auf der einen Seite der Abbildung in Form eines Ausdruckssystems [E] organisiert sind. Betrachtet man kognitive Strukturen generell als kognitive Objekte [KOGOBJ], dann kann man diejenigen kognitiven Objekte, die zusätzlich speziell als kognitive Objekte innerhalb eines Ausdruckssystems E organisiert sind, als KOGOBJ-E abkürzen. Die Abbildungsbeziehung zwischen der speziellen Menge von kognitiven Objekten, die als Ausdrücke KOGOBJ-E fungieren, und allen anderen kognitiven Objekten KOGOBJ (mit KOGOBJ-E als Teilmenge!) wird normalerweise Bedeutungsbeziehung [Π] genannt, geschrieben: Π: KOGOBJ <—–> KOGOBJ-E.

Warum wieder dieser enorme zusätzliche Aufwand?

Wie wir am Verhalten des homo sapiens — Wir — sehen können, kann aufgrund der Bedeutungsbeziehung ein biologischer Organismus A die Ausdruckselemente benutzen, um auf bestimmte virtuelle Aspekte in sich Bezug zu nehmen, und diese internen Ausdruckselemente können dann in Form von Sprachlauten — oder später in der kulturellen Entwicklung auch durch Schriftzeichen — dazu genutzt werden, auf einen anderen Organismus B einzuwirken, so dass dieser — falls man die gleichen Ausdruckselemente mit der gleichen Bedeutungsbeziehung gemeinsam gelernt hat — ‚in sich selbst‘ möglicherweise ähnliche kognitiven Objekte aktiviert wie der andere biologische Organismus A möglicherweise intendiert hat.

Dieser hochkomplexe Vorgang einer zwischen-biologischen Kommunikation ermöglicht es — wie wir aus unserem Alltag wissen können — dass sich auf diese Weise — bis zu einem gewissen Grad — nicht nur das Verhalten generell koordinieren lässt, sondern dass dabei auch — wiederum nur bis zu einem gewissen Grad — inhaltliche Informationen über die Welt ausgetauscht werden können, die eine kognitive erweiterte Koordination möglich machen.

WELTBILDER: WISSENSCHAFT ODER MYTHEN?

Diese ineinander verschränkten Abbildungen von Realität in Virtualität einerseits bzw. Virtualität 1 nach Virtualität 2 andererseits stellen im Kontext der biologischen Evolution mehr als eine Revolution dar. Dies soll jetzt hier gar nicht weiter diskutiert werden. Wohl aber sei der Hinweis gestattet auf das Alltagsphänomen, dass ganze Populationen von Menschen ein virtuelles Bild von der Welt erzeugen, pflegen und danach handeln können, das teilweise oder gar überwiegend falsch ist, mit den entsprechend verheerenden Folgern für alle.

Vor diesem Hintergrund der Massen-Verirrungen — in allen Zeiten der Menschheit gegeben, auch im Jahr 2021 — stellt sich die kritische Frage, was kann eine Gesellschaft als Ganze tun, um durch ihre Kultur Massen-Verirrungen zu verhindern.

Wie Blicke zurück in die Geschichte und hinweg über alle nationale Grenzen heute andeuten, ist ein gemeinsamer Schutz vor Verirrungen alles andere als einfach. Intelligenz alleine ist offensichtlich kein ausreichender Schutz…

So zeigt ein Blick in die Geschichte der Wissenschaften, dass es selbst in der Wissenschaft trotz all der vereinbarten Qualitätssicherungen immer wieder zu strittigen Meinungen kommen kann, die ganze Schulen ausbilden, um die anderen Meinungen ‚zu bekämpfen‘ statt aus den Unterschieden konstruktiv zu lernen.

Die Aufgabe der Gestaltung einer gemeinsamen Kultur der minimalen Verirrungen ist für uns alle real, sie ist hart, sie ist schwierig, und die scheinbar einfachen und griffigen Lösungen sollten eigentlich routinemäßig schon mal eine besondere Aufmerksamkeit erregen, ob das überhaupt so stimmen kann …

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.