Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 13.März 2022 – 13.März, 11:11h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Kontext

Bei diesem Beitrag handelt es sich um die Fortsetzung des Diskurses zu den zuvor besprochenen Artikeln von Popper: „A World of Propensities“ (1988, 1990), „Towards an Evolutionary Theory of Knowledge“ (1989,1990)[1] sowie „All Life is Problem Solving“ (1991, 1994/1999). [2] Der Beitrag „(SPÄTER) POPPER – WISSENSCHAFT – PHILOSOPHIE – OKSIMO-DISKURSRAUM“ spielt hier keine Rolle. Es wird aber direkt Bezug genommen auf einen Text von Popper von 1971 „Conjectural Knowledge: My Solution of the Problem of Induction.“[3],[4] Dieser wurde in meinem Englischen Blog diskutiert „POPPER – Objective Knowledge (1971). Summary, Comments, how to develope further„.

Vorbemerkung

Die Begegnung des Autors mit Popper spielt sich in unterschiedlichen Etappen ab. Die erste Begegnung fand statt im März 2021 mit einer Diskussion der ersten 17 Kapitel von Popper’s Frühwerk „Logik der Forschung“ (1935), allerdings in der Englischen Fassung von 1959.[5] Diese erste Begegnung war eingebettet in eine größere Diskussion (mehrere längere Posts) zum Theoriebegriff und dem Zusammenhang mit dem oksimo Projekt.

In dieser ersten Begegnung wurde die Position Poppers vornehmlich wahrgenommen aus einer bestimmten, schon bestehenden wissenschaftsphilosophischen Perspektive, zusätzlich eingefärbt durch den Blick auf die Anwendbarkeit dieses Theoriebegriffs auf das oksimo Projekt. Wenngleich für den Autor in vielfacher Hinsicht sehr erhellend, kommt die Position Popper’s nicht so richtig zum Vorschein.

Erste die Lektüre von drei Beiträgen Popper’s aus der Zeit 1988 – 1991 führte zu einer neuen mehr Popper-zentrierten Wahrnehmung. In diesem Spannungsfeld von ‚frühem‘ Popper 1935/1959 und ’spätem‘ Popper 1988 – 1991 führte die Begegnung mit dem Text des ‚mittleren‘ Popper von 1971 zu einer sehr direkten Begegnung, die die Gedanken zu Popper weiter belebten.

Popper: Früh – Mittel – Spät

Die hier provisorisch vorgenommene Einordnung Poppers in einen ‚frühe‘, bzw. ‚mittleren‘ bzw. ’späten‘ Popper ist natürlich — gemessen an dem gesamten Werk Poppers ein bisschen gewagt. Dies entspricht aber letztlich dem Stil einer Theoriebildung im Sinne von Popper, in der — ausgehend von einzelnen Beobachtungen –, schrittweise Hypothesen gebildet werden, die dann versuchsweise angewendet werden. Im Scheitern bzw. in partiellen Bestätigungen entwickelt sich dann solch eine Theorie weiter. Eine ‚absolute Endform‘ wird sie nie haben, aber sie kann immer differenzierter werden, begleitet von immer stärkeren ‚Evidenzen‘, die allerdings ‚Wahrheit‘ niemals ersetzen können.

So also hier eine meine ‚Mini-Theorie‘ über Popper anhand von nur vier Artikeln und 17 Kapiteln aus einem Buch.

Bei meiner bisherigen Lektüre entsteht der Eindruck, dass die Strukturen des ‚frühen‘ (1935 – 1959) Popper denen des mittleren‘ (1971) Popper sehr ähnlich sind. Die Texte des ’späten‘ (1988 – 1991) Popper hingegen bringen einen starken neuen Akzent in die Überlegungen ein.

Wahrheit ohne Wahrheit

Ein Grundthema des frühen und mittleren Popper ist einerseits die starke Betonung, dass ‚Wahrheit‘ — zumindest als ‚regulative Idee‘ — unverzichtbar ist, soll empirische Wissenschaft stattfinden, andererseits aber sein unermüdliches Bemühen, darauf hinzuweisen, dass die Aussagen einer Theorie, selbst wenn sie sich eine lange Zeit ‚bewährt‘ haben, dennoch keine ‚absolute Wahrheit‘ widerspiegeln; sie können jederzeit widerlegt werden.[6] Diese Position führt ‚aus sich heraus‘ natürlich zu der Frage, was denn ‚Wahrheit als regulative Idee‘ ist bzw. zu der komplementären Frage, welchen ‚Status‘ dann jene Aussagen haben, auf die Theorieentwürfe aufbauen. Was ist eine ‚Beobachtungsausage‘ (Spezialfall ein ‚Messwert‘), die zum Ausgangspunkt von Theorien werden?

Poppers Prozessmodell von Wahrheit

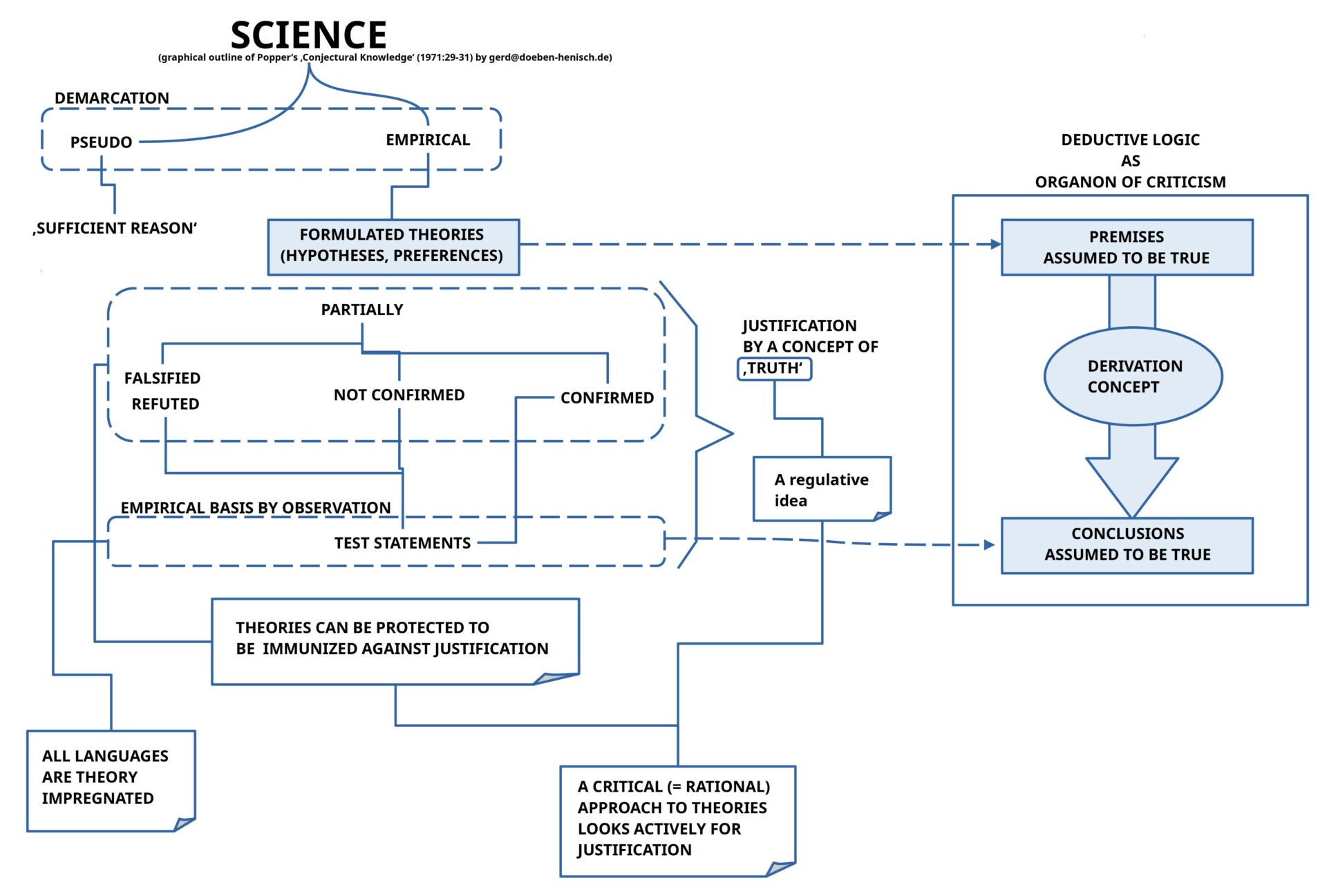

Popper löst das Problem der notwendigen Wahrheit, die eigentlich nicht da ist, aber irgendwie dann doch, indem er in seinem 1971-Text [4] die einzelnen Aspekte dieses Wahrheitsbegriffs schildert und sie dann auf den letzten Seiten (29-31) wie in einem ‚Puzzle‘ zusammenfügt, allerdings so, dass viele Details offen bleiben.

Primären Halt in der empirischen Realität bieten Beobachtungssätze, die im Fall der Überprüfung einer Theorie, die Rolle von ‚Testsätzen‘ übernehmen. Die Theorie selbst besteht aus einer Ansammlung von ‚Hypothesen‘ (‚conjectures‘), in denen einzelne Beobachtungsaussagen zueinander in Beziehung gesetzt werden, die als solche natürlich nicht beobachtet (‚gemessen‘) werden können.[7]

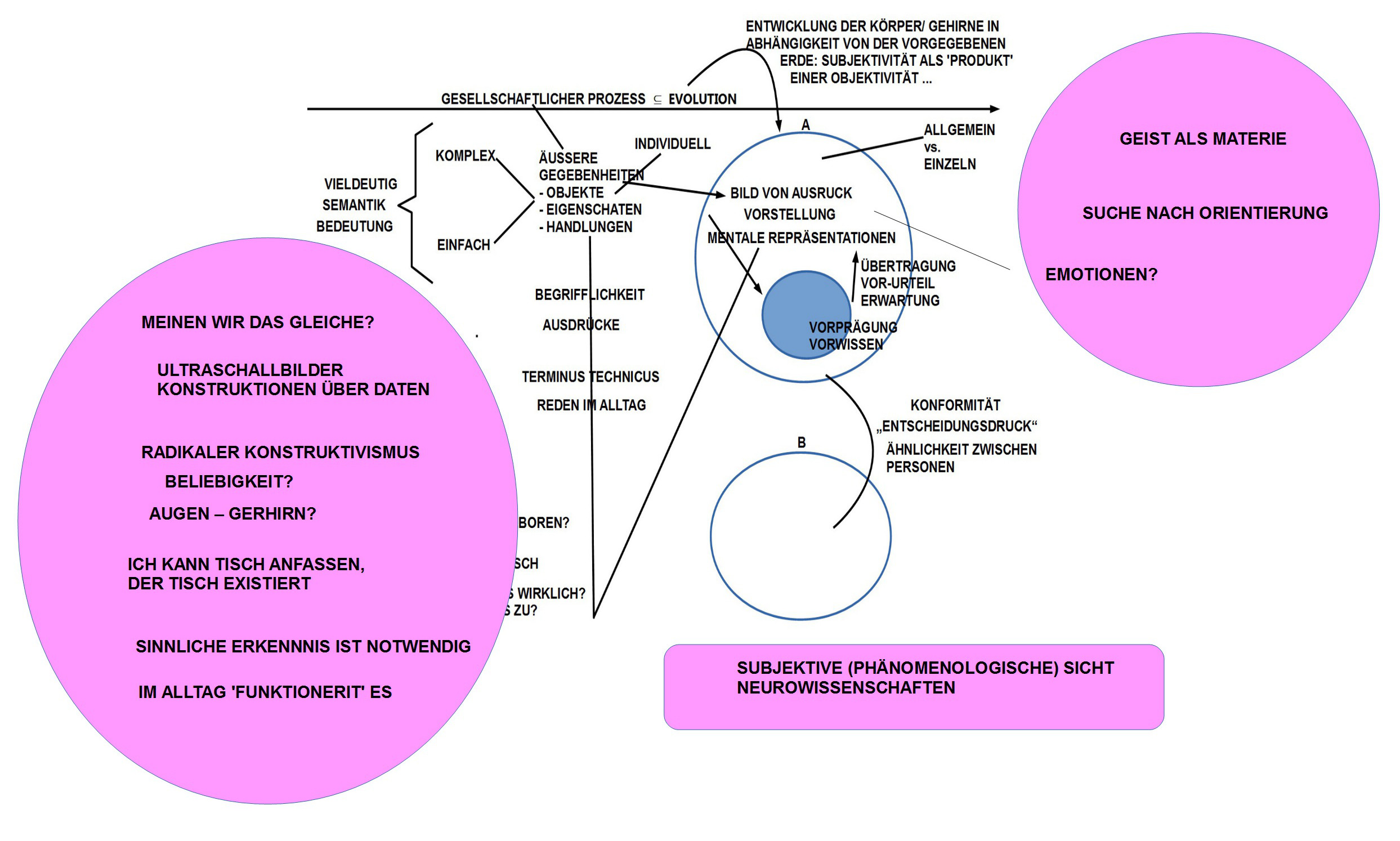

Bei dem Übergang vom ‚Beobachtungswert‘ (‚Messwert‘) zur ‚Hypothese‘ finden aber unweigerlich ‚Verallgemeinerungen‘ statt [8], die dann sprachlich repräsentiert werden. Nur die ‚teilnehmenden‘ Beobachter wissen ‚implizit‘, auf welches konkrete Ereignis sie sich mit ihren sprachlichen Ausdrücken beziehen. Der Versuch der Wissenschaft, dieses Problem des ‚impliziten‘ (= subjektiven)‘ Wissens durch vereinbarte Messprozeduren aufzulösen, hilft nur partiell. Das Zustandekommen des Beobachtungsereignisses wird damit zwar ‚objektiviert‘, aber die ‚Übersetzung‘ dieses objektivierten Ereignisses, das als Wahrnehmungsphänomen bei den teilnehmden Beobachtern ‚ankommt‘, wird im Beobachter ‚unbewusst‘ zu einem Konzept verarbeitet, dass dann in einen sprachlichen Ausdruck transformiert wird, der dann als Beobachtungsaussage ‚funktioniert‘. Alle, die an diesem ‚Spiel‘ [9] teilnehmen, wissen, wie sie sich verhalten sollen. Ein ‚Außenstehender‘ versteht es nicht automatisch.

Anders betrachtet, selbst objektivierenden Beobachtungsprozesse klammern die subjektvie Komponenten nicht völlig aus.

Hat man verallgemeinernde Beobachtungsaussagen („Der Main-Kinzig Kreis hat 2018 418.950 Einwohner.“, „Dieser Stein wiegt 4.5 kg.“, „Das Wasser hat eine Temperatur von 13 Grad Celsius.“) , dann kann man auf dieser Basis versuchen, Hypothesen zu bilden (z.B. bzgl. des Aspektes möglicher Veränderungen wie Einwohnerzahl, Länge, Temperatur). Im Fall der Einwohnerzahl bräuchte man dann z.B. Beobachtungen zu mindestens zwei verschiedenen Zeitpunkten‘ (2018, 2019)[14], um aus der ‚Differenz‘ Hinweise ‚abzuleiten‘, welches Ausmaß ein ‚Wachstumsfaktor‘ haben könnte. Im Fall des Main-Kinzig Kreises wird für diesen Zeitraum z.B. ein Wachstumsfaktor von 0.4% ermittelt.

Wie ist solch ein ‚abgeleiteter Wachstumsfaktor‘ einzuordnen? Er beschreibt eine ‚abgeleitete‘ Größe, mit der man eine Formel bilden könnte wie ‚Die Einwohnerzahl im Jahr t+1 = Einwohnerzahl im Jahr t + (Einwohnerzahl im Jahr t * Wachstumsfaktor). Dies ist eine Rechenanweisung, die mit beobachteten Größen (Einwohnerzahl) und daraus abgeleiteten mathematischen Eigenschaften (Wachstumsfaktor) eine ‚Voraussage‘ berechnen lässt, wie die Einwohnerzahl in nachfolgenden Jahren aussehen [14] würde, wenn der Wachstumsfaktor sich nicht verändern würde.

Klar ist, dass solch ein sprachlicher Ausdruck seine Bedeutung aus dem ‚Bedeutungswissen‘ der Teilnehmer bezieht. Der Ausdruck selbst ist nichts anderes als eine Menge von Zeichen, linear angeordnet. Also auch hier eine fundamentale ’subjektive Dimension‘ als Voraussetzung für ein ‚objektives Agieren‘.

Diese Aspekte sprachlicher Bedeutung und deren Verankerung in der inneren Struktur der Beobachter und Theoriebauer [10] diskutiert Popper nicht explizit. Wohl postuliert er eine ‚Logik‘, die die ‚Herleitung‘ von Prognosen aus den theoretischen Annahmen beschreiben soll.

Die moderne formale Logik hat viele wunderbare Eigenschaften, aber eines hat sie nicht: irgendeinen Bezug zu irgendeiner Bedeutung‘. In einem formalen Logikkalkül [11] gibt es eine Menge von formalen Ausdrücken, die als ‚Annahmen‘ funktionieren sollen, und das einzige, was man von diesen wissen muss, ist, ob sie als ‚wahr‘ eingestuft werden (was bei Annahmen der Fall ist). Was mit ‚wahr inhaltlich gemeint ist, ist aber völlig unbestimmt, zumal formale Ausdrücke als solche keine Bedeutung haben. Wenn es eine Bedeutung geben soll, dann muss man die formalen Ausdrücke an die ’subjektive Bedeutungsdimension der Teilnehmer‘ knüpfen, die nach Bedarf spezielle Messverfahren zu Hilfe nehmen.

Angenommen, man hat die ‚formalisierten Ausdrücke‘ mit den verallgemeinerten Aussagen der Hypothesen verknüpft [12] und man nutzt die Logik, um ‚Ableitungen‘ zu machen, die zu ‚Prognosen‘ führen[13], dann stellt sich das Problem, wie man das Verhältnis einer ‚abgeleiteten‘ Aussage zu einer ‚Beobachtungsaussage‘ bestimmten soll. Popper benutzt hier zwar Klassifikationen wie ‚bestätigend‘, ’nicht bestätigend‘, ‚falsifiziert‘, aber eine Diskussion im Detail zu „A bestätigt B“/ „A bestätigt B nicht“/ „A falsifiziert B“ scheitert an vielen ungeklärten Details und Randbedingungen, die im vorausgehenden Text nur angedeutet werden konnten.

Der Diskurs geht weiter.

Kommentare

[1] Karl Popper, „A World of Propensities“,(1988) sowie „Towards an Evolutionary Theory of Knowledge“, (1989) in: Karl Popper, „A World of Propensities“, Thoemmes Press, Bristol, (1990, repr. 1995)

[2] Karl Popper, „All Life is Problem Solving“, Artikel, ursprünglich ein Vortrag 1991 auf Deutsch, erstmalig publiziert in dem Buch (auf Deutsch) „Alles Leben ist Problemlösen“ (1994), dann in dem Buch (auf Englisch) „All Life is Problem Solving“, 1999, Routledge, Taylor & Francis Group, London – New York

[3] Karl R.Popper, Conjectural Knowledge: My Solution of the Problem of Induction, in: [2], pp.1-31

[4] Karl R.Popper, Objective Knowledge. An Evolutionary Approach, Oxford University Press, London, 1972 (reprint with corrections 1973)

[5] Karl Popper, The Logic of Scientific Discovery, First published 1935 in German as Logik der Forschung, then 1959 in English by Basic Books, New York (more editions have been published later; I am using the eBook version of Routledge (2002))

[6] Popper verweist hier gerne und häufig auf die Geschichte der Physik mit den unterschiedlichen Konzepten, wie man die Erde als Teil des Sonnensystems und dann später das ganzen Universums beschrieben hat bzw. heute beschreibt. Hauptbeispiel: Newtons System, das dann mit immer neuen Beobachtungen und dann schließlich mit Einsteins Relativitätstheorie als ‚zu eng‘ klassifiziert wurde.

[7] ‚Beziehungen‘ existieren ausschließlich in unserem ‚Denken‘ (das alte Hume Problem, das Kant schon zu lösen versuchte, und das Popper in seinen Texten wieder und wieder aufgreift). Wenn wir diese ‚gedachten Beziehungen‘ in die beobachtbaren Einzelereignisse (Zeit, Ort, Beobachter) ‚hinein-sehen‘, dann ist dies der Versuch, zu ‚prüfen‘, ob diese Beziehung sich ‚bestätigen‘ oder ‚widerlegen‘ lässt. Anmerkung: die moderne expermentelle Psychologie (auch als Neuropsychologie) hat diese Sachverhalte extensiv untersucht und mit neuen Evidenzen versehen.

[8] Wie die Alltagssprache zeigt — und die moderne Wissenschaft bestätigt –, werden konkrete empirische Phänomene immer abstrakten Konzepten zugeordnet, die dann mit Allgemeinbegriffen verknüpft werden. Ob ein konkretes Wahrnehmungsereignis zu einem abstrakten Konzept X (z.B. ‚Tasse‘) oder Y (z.B. ‚Glas‘) gehört, das entscheidet das Gehirn unbewusst (Menschen können nur entscheiden, welche sprachlichen Ausdrücke sie verwenden wollen, um die kognitven Konzepte zu ‚benennen‘).

[9] … erinnert an das Sprachspielkonzept des späten Wittgenstein …

[10] Manche glauben heute, dass die Rolle des ‚Beoachters‘ und/oder des ‚Theoriebauers‘ von ‚intelligenten Programmen‘ übernommen werden können. In ‚Kooperation mit Menschen‘ im Rahmen eines modernen Konzepts von ‚kollektiver Intelligenz‘ kann es funktionieren, aber nur in Kooperation.

[11] Es gibt nicht nur ‚einen‘ Logikkalkül, sondern — rein formal — nahezu unendliche viele. Welcher für welche Aufgabenstellung ‚geeignet‘ ist, muss im Rahmen einer konkreten Aufgabe ermittelt werden.

[12] In der Wisenschaftsphilosophie ist dies bis heute noch nicht so gelöst, dass es dazu ein allgemein akzeptiertes Verfahren gibt.

[13] Da es viele verschiedene Ableitungsbegriffe gibt, von denen bis heute kein einziger meta-theoretisch für bestimmte empirische Bereich als ‚zuverlässig im Sinne eines Kriteriums K‘ erwiesen wurde, ist die lose Bezugnahme auf einen solchen Ableitungsbegriff eigentlich zu wenig.

[14] An dieser Stelle wird deutlich, dass das Beobachten wie auch dann die Auswertung von einer ‚Menge‘ von Beobachtungswerten in unserer Körperwelt ein ‚Zeitmodell‘ voraussetzt, in dem Ereignisse ein ‚vorher‘ und ’nachher‘ haben, so dass das Konzept einer ‚Prognose’/ ‚Voraussage‘ überhaupt Sinn macht.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.