Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062 20.Juli 2020

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

AKTUALISIERUNGEN: Letzte Aktualisierung 21.7.2020 (Korrekturen; neue Links)

KONTEXT

In den vielen vorausgehenden Beiträgen in diesem Blog wurde die Frage nach dem Menschen, was das angemessene Bild vom Menschen sein könnte, schon oft gestellt. Möglicherweise wird diese Frage auch in der Zukunft sich immer wieder neu stellen, weil wir immer wieder auf neue Aspekte unseres Menschseins stoßen. Ich bin diese Tage auf einen Zusammenhang gestoßen, der mir persönlich in dieser Konkretheit neu ist (was nicht ausschließt, dass andere dies schon ganz lange so sehen). Hier einige weitere Gedanken dazu.

DER MENSCH IN FRAGMENTEN

In der evolutionsbiologischen Perspektive taucht der homo sapiens — also wir — sehr, sehr spät auf. Vom Jahr 2020 aus betrachtet, bilden wir den aktuellen Endpunkt der bisherigen Entwicklung wohl wissend, dass es nur ein Durchgangspunkt ist in einem Prozess, dessen Logik und mögliche Zielrichtung wir bislang nur bedingt verstehen.

Während man bei der Betrachtung der letzten Jahrtausende Menschheitsgeschichte bisweilen den Eindruck haben könnte, dass die Menschen sich als Menschen als etwas irgendwie Besonderes angesehen haben (was die Menschen aber nicht davon abgehalten hat, sich gegenseitig zu bekämpfen, sich zu bekriegen, sich regelrecht abzuschlachten), könnte man bei der Betrachtung der letzten 100 Jahre den Eindruck gewinnen, als ob die Wissenschaft die Besonderheit des Menschen — so es sie überhaupt gab — weitgehend aufgelöst hat: einmal durch die Einbettung in das größere Ganze der Evolution, dann durch einen vertieften Blick in die Details der Anatomie, des Gehirns, der Organe, der Mikro- und Zellbiologie, der Genetik, und schließlich heute durch das Aufkommen digitaler Technologien, der Computer, der sogenannten künstlichen Intelligenz (KI); dies alles lässt den Menschen auf den ersten Blick nicht mehr als etwas Besonders erscheinen.

Diese fortschreitende Fragmentierung des Menschen, des homo sapiens, findet aber nicht nur speziell beim Menschen statt. Die ganze Betrachtungsweise der Erde, des Universums, der realen Welt, ist stark durch die empirischen Wissenschaften der Gegenwart geprägt. In diesen empirischen Wissenschaften gibt es — schon von ihrem methodischen Ansatz her — keine Geheimnisse. Wenn ich nach vereinbarten Messmethoden Daten sammle, diese in ein — idealerweise — mathematisches Modell einbaue, um Zusammenhänge sichtbar zu machen, dann kann ich möglicherweise Ausschnitte der realen Welt als abgeschlossene Systeme beschreiben, bei denen der beschreibende Wissenschaftler außen vor bleibt. Diese partiellen Modelle bleiben notgedrungen Fragmente. Selbst die Physik, die für sich in Anspruch nimmt, das Ganze des Universums zu betrachten, fragmentiert die reale Welt, da sich die Wissenschaftler selbst, auch nicht die Besonderheiten biologischen Lebens generell, in die Analyse einbeziehen. Bislang interessiert das die meisten wenig. Je nach Betrachtungsweise kann dies aber ein fataler Fehler sein.

DER BEOBACHTER ALS BLINDE FLECK

Die Ausklammerung des Beobachters aus der Beschreibung des Beobachtungsgegenstands ist in den empirischen Wissenschaften Standard, da ja das Messverfahren idealerweise invariant sein soll bezüglich demjenigen, der misst. Bei Beobachtungen, in denen der Beobachter selbst das Messinstrument ist, geht dies natürlich nicht, da die Eigenschaften des Beobachters in den Messprozess eingehen (z.B. überall dort, wo wir Menschen unser eigenes Verhalten verstehen wollen, unser Fühlen und Denken, unser Verstehen, unser Entscheiden, usw.). Während es lange Zeit eine strenge Trennung gab zwischen echten (= harten) Wissenschaften, die strikt mit dem empirischen Messideal arbeiten, und jenen quasi (=weichen) Wissenschaften, bei denen irgendwie der Beobachter selbst Teil des Messprozesses ist und demzufolge das Messen mehr oder weniger intransparent erscheint, können wir in den letzten Jahrzehnten den Trend beobachten, dass die harten empirischen Messmethoden immer mehr ausgedehnt werden auch auf Untersuchungen des Verhaltens von Menschen, allerdings nur als Einbahnstraße: man macht Menschen zwar zu Beobachtungsgegenständen partieller empirischer Methoden, die untersuchenden Wissenschaftler bleiben aber weiterhin außen vor. Dieses Vorgehen ist per se nicht schlecht, liefert es doch partiell neue, interessante Einsichten. Aber es ist gefährlich in dem Moment, wo man von diesem — immer noch radikal fragmentiertem — Vorgehen auf das Ganze extrapoliert. Es entstehen dann beispielsweise Bücher mit vielen hundert Seiten zu einzelnen Aspekten der Zelle, der Organe, des Gehirns, aber diese Bücher versammeln nur Details, Fragmente, eine irgendwie geartete Zusammenschau bleibt aus.

Für diese anhaltende Fragmentierung gibt es sicher mehr als einen Grund. Einer liegt aber an der Wurzel des Theoriebegriffs, der Theoriebildung selbst. Im Gegensatz zu einer weit verbreiteten Anschauung entstehen Theorien, Modelle, also jene begrifflichen Gebilde, mit denen wir einzelne Daten deuten, nicht aus einem Automatismus, sondern sie beruhen auf gedanklichen Entscheidungen in den Köpfen der Wissenschaftler selbst: grundsätzlich gibt es immer mehr als eine Option, wie ich etwas angehen will. Jede Option verlangt also eine Entscheidung, eine Wahl aus einem großen Bereich von Möglichkeiten. Die Generierung einer Theorie ist von daher immer ein komplexer Prozess. Interessanterweise gibt es in kaum einer der heutigen empirischen Disziplinen das Thema Wie generieren wir eine Theorie? als eigene Themenstellung. Obwohl hier viele Grundentscheidungen fallen, obwohl hier viel Komplexität rational aufgehellt werden müsste, betreiben die sogenannten harten Wissenschaften hier ein weitgehend irrationales Geschäft. Das Harte an den empirischen Wissenschaften gründet sich in diesem Sinne nicht einmal in einer weichen Reflexion; es gibt schlicht gar keine offizielle Reflexion. Die empirischen Wissenschaften sind in dieser Hinsicht fundamental irrational. Dass sie trotz ihrer fundamentalen Irrationalität interessante Detailergebnisse liefern kann diesen fundamentalen Fehler in der Wurzel nur bedingt ausgleichen. Die interessante Frage ist doch, was könnten die empirischen Wissenschaften noch viel mehr leisten, wenn sie ihre grundlegende Irrationalität an der Wurzel der Theoriebildung schrittweise mit Rationalität auffüllen würden?

HOMO SAPIENS – DER TRANSFORMER

(Ein kleiner Versuch, zu zeigen, was man sehen kann, wenn man die Grenzen der Disziplinen versuchsweise (und skizzenhaft) überschreitet)

Trotz ihrer Irrationalität an der Wurzel hat die Evolutionsbiologie viele interessante Tatbestände zum homo sapiens sichtbar gemacht, und andere Wissenschaften wie z.B. Psychologie, Sprachwissenschaften, und Gehirnwissenschaft haben weitere Details beigesteuert, die quasi ‚auf der Straße‘ herumliegen; jeder produziert für sich fleißig partielle Modelle, aber niemand ist zuständig dafür, diese zusammen zu bauen, sie versuchsweise zu integrieren, mutig und kreativ eine Synthese zu versuchen, die vielleicht neue Aspekte liefern kann, mittels deren wir viele andere Details auch neu deuten könnten. Was Not tut ist eine Wissenschaft der Wissenschaften, nicht als Privatvergnügen eines einzelnen Forschers, sondern als verpflichtender Standard für alle. In einer Wissenschaft der Wissenschaften wäre der Beobachter, der Forscher, die Forschergruppe, selbst Teil des Untersuchungsgegenstandes und damit in der zugehörigen Meta-Theorie aufzuhellen.

Anmerkung: Im Rahmen der Theorie des Engineering gibt es solche Ansätze schon länger, da das Scheitern eines Engineeringprozesses ziemlich direkt auf die Ingenieure zurück schlägt; von daher sind sie äußerst interessiert daran, auf welche Weise der Faktor Mensch — also auch sie selbst — zum Scheitern beigetragen hat. Hier könnte die Wissenschaft eine Menge von den Ingenieuren lernen.

Neben den vielen Eigenschaften, die man am homo sapiens entdecken kann, erscheinen mir drei von herausragender Bedeutung zu sein, was sich allerdings erst so richtig zeigt, wenn man sie im Zusammenspiel betrachtet.

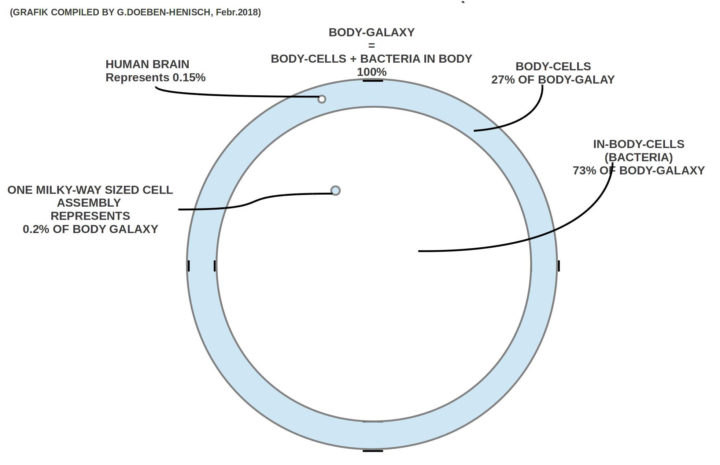

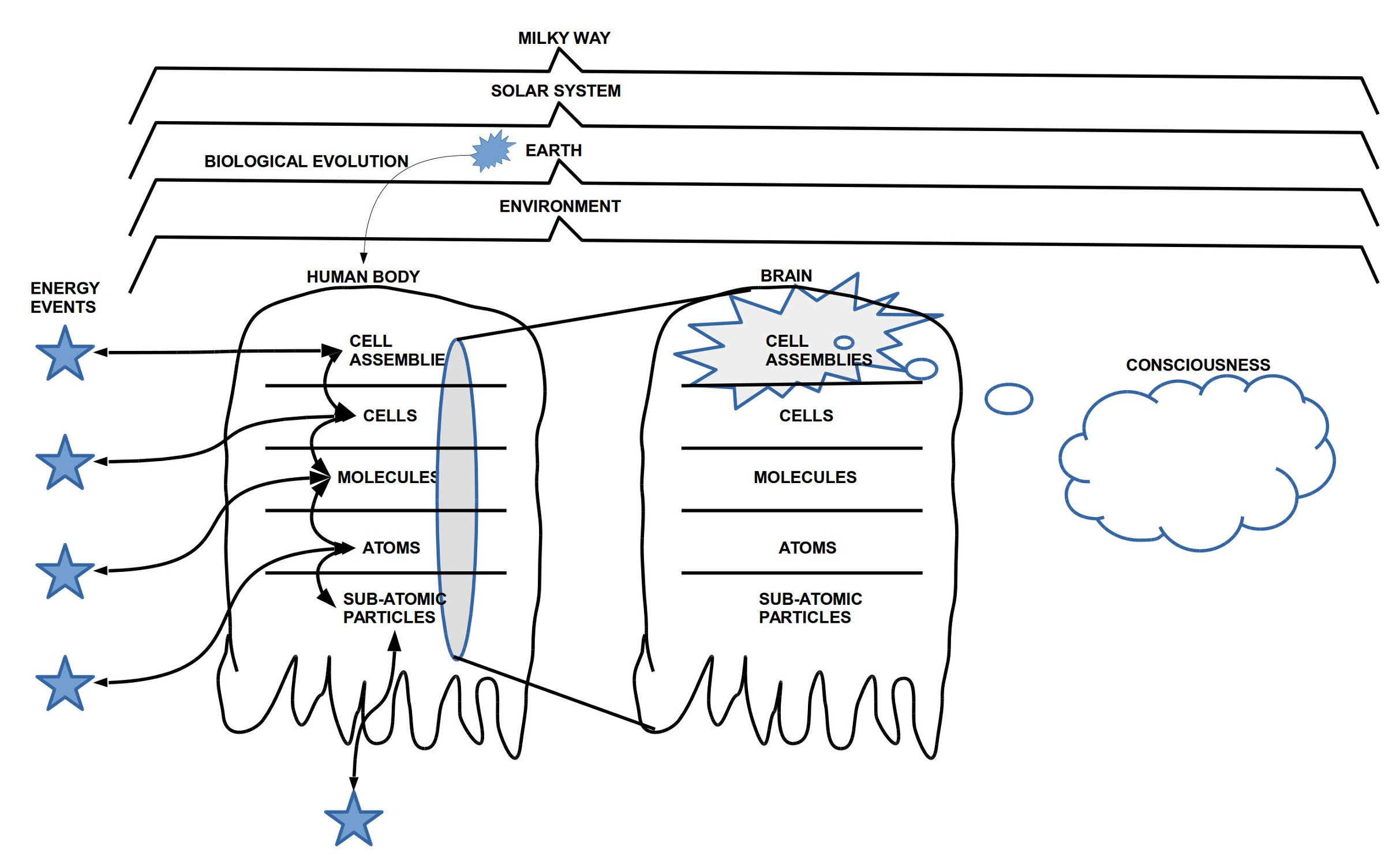

Faktor 1: Dass ein homo sapiens einen Körper [B, body] mit eingebautem Gehirn [b, brain] hat, unterscheidet ihn nicht unbedingt von anderen Lebensformen, da es viele Lebensformen im Format Körper mit eingebautem Gehirn gibt. Dennoch ist schon mal festzuhalten, dass der Gehirn-Körper [b_B] eines homo sapiens einen Teil der Eigenschaften seiner Realwelt-Umgebung [RW] — und der eigene Körper gehört aus Sicht des Gehirns auch zu dieser Realwelt-Umgebung — ausnahmslos in neuronale Zustände [NN] im Gehirn verwandelt/ transformiert/ konvertiert und diese neuronale Zustände auf vielfältige Weise Prozesshaft bearbeitet (Wahrnehmen, Speichern, Erinnern, Abstrahieren, Assoziieren, bewerten, …). In dieser Hinsicht kann man den Gehirn-Körper als eine Abbildung, eine Funktion verstehen, die u.a. dieses leistet: b_B : RW —–> RW_NN. Will man berücksichtigen, dass diese Abbildung durch aktuell verfügbare Erfahrungen aus der Vergangenheit modifiziert werden kann, dann könnte man schreiben: b_B : RW x RW_NN —–> RW_NN. Dies trägt dem Sachverhalt Rechnung, dass wir das, was wir aktuell neu erleben, automatisch mit schon vorhandenen Erfahrungen abgleichen und automatisch interpretieren und bewerten.

Faktor 2: Allein schon dieser Transformationsprozess ist hochinteressant, und er funktioniert bis zu einem gewissen Grad auch ganz ohne Sprache (was alle Kinder demonstrieren, wenn sie sich in der Welt bewegen, bevor sie sprechen können). Ein homo sapiens ohne Sprache ist aber letztlich nicht überlebensfähig. Zum Überleben braucht ein homo sapiens das Zusammenwirken mit anderen; dies verlangt ein Minimum an Kommunikation, an sprachlicher Kommunikation, und dies verlangt die Verfügbarkeit einer Sprache [L].

Wir wir heute wissen, ist die konkrete Form einer Sprache nicht angeboren, wohl aber die Fähigkeit, eine auszubilden. Davon zeugen die vielen tausend Sprachen, die auf dieser Erde gesprochen werden und das Phänomen, dass alle Kinder irgendwann anfangen, Sprachen zu lernen, aus sich heraus.

Was viele als unangenehm empfinden, das ist, wenn man als einzelner als Fremder, als Tourist in eine Situation gerät, wo alle Menschen um einen herum eine Sprache sprechen, die man selbst nicht versteht. Dem Laut der Worte oder dem Schriftzug eines Textes kann man nicht direkt entnehmen, was sie bedeuten. Dies liegt daran, dass die sogenannten natürlichen Sprachen (oft auch Alltagssprachen genannt), ihre Bedeutungszuweisungen im Gehirn bekommen, im Bereich der neuronalen Korrelate der realen Welt RW_NN. Dies ist auch der Grund, warum Kinder nicht von Geburt an eine Sprache lernen können: erst wenn sie minimale Strukturen in ihren neuronalen Korrelaten der Außenwelt ausbilden konnten, können die Ausdrücke der Sprache ihrer Umgebung solchen Strukturen zugeordnet werden. Und so beginnt dann ein paralleler Prozess der Ausdifferenzierung der nicht-sprachlichen Strukturen, die auf unterschiedliche Weise mit den sprachlichen Strukturen verknüpft werden. Vereinfachend kann man sagen, dass die Bedeutungsfunktion [M] eine Abbildung herstellt zwischen diesen beiden Bereichen: M : L <–?–> RW_NN, wobei die sprachlichen Ausdrücke letztlich ja auch Teil der neuronalen Korrelate der Außenwelt RW_NN sind, also eher M: RW_NN_L <–?–>RW_NN.

Während die grundsätzliche Fähigkeit zur Ausbildung einer bedeutungshaltigen Sprache [L_M] (L :_ Ausrucksseite, M := Bedeutungsanteil) nach heutigem Kenntnisstand angeboren zu sein scheint, muss die Bedeutungsrelation M individuell in einem langen, oft mühsamen Prozess, erlernt werden. Und das Erlernen der einen Sprache L_M hilft kaum bis gar nicht für das Erlernen einer anderen Sprache L’_M‘.

Faktor 3: Neben sehr vielen Eigenschaften im Kontext der menschlichen Sprachfähigkeit ist einer — in meiner Sicht — zusätzlich bemerkenswert. Im einfachen Fall kann man unterscheiden zwischen den sprachlichen Ausdrücken und jenen neuronalen Korrelaten, die mit Objekten der Außenwelt korrespondieren, also solche Objekte, die andere Menschen zeitgleich auch wahrnehmen können. So z.B. ‚die weiße Tasse dort auf dem Tisch‘, ‚die rote Blume neben deiner Treppe‘, ‚die Sonne am Himmel‘, usw. In diesen Beispielen haben wir auf der einen Seite sprachliche Ausdrücke, und auf der anderen Seite nicht-sprachliche Dinge. Ich kann mit meiner Sprache aber auch sagen „In dem Satz ‚die Sonne am Himmel‘ ist das zweite Wort dieses Satzes grammatisch ein Substantiv‘. In diesem Beispiel benutze ich Ausdrücke der Sprache um mich auf andere Ausdrücke einer Sprache zu beziehen. Dies bedeutet, dass ich Ausdrücke der Sprache zu Objekten für andere Ausdrücke der Sprache machen kann, die über (meta) diese Objekte sprechen. In der Wissenschaftsphilosophie spricht man hier von Objekt-Sprache und von Meta-Sprache. Letztlich sind es zwei verschiedenen Sprachebenen. Bei einer weiteren Analyse wird man feststellen können, dass eine natürliche/ normale Sprache L_M scheinbar unendlich viele Sprachebenen ausbilden kann, einfach so. Ein Wort wie Demokratie z.B. hat direkt kaum einen direkten Bezug zu einem Objekt der realen Welt, wohl aber sehr viele Beziehungen zu anderen Ausdrücken, die wiederum auf andere Ausdrücke verweisen können, bis irgendwann vielleicht ein Ausdruck dabei ist, der Objekte der realen Welt betrifft (z.B. der Stuhl, auf dem der Parlamentspräsident sitzt, oder eben dieser Parlamentspräsident, der zur Institution des Bundestages gehört, der wiederum … hier wird es schon schwierig).

Die Tatsache, dass also das Sprachvermögen eine potentiell unendlich erscheinende Hierarchie von Sprachebenen erlaubt, ist eine ungewöhnlich starke Eigenschaft, die bislang nur beim homo sapiens beobachtet werden kann. Im positiven Fall erlaubt eine solche Sprachhierarchie die Ausbildung von beliebig komplexen Strukturen, um damit beliebig viele Eigenschaften und Zusammenhänge der realen Welt sichtbar zu machen, aber nicht nur in Bezug auf die Gegenwart oder die Vergangenheit, sondern der homo sapiens kann dadurch auch Zustände in einer möglichen Zukunft andenken. Dies wiederum ermöglicht ein innovatives, gestalterisches Handeln, in dem Aspekte der gegenwärtigen Situation verändert werden. Damit kann dann real der Prozess der Evolution und des ganzen Universums verändert werden. Im negativen Fall kann der homo sapiens wilde Netzwerke von Ausdrücken produzieren, die auf den ersten Blick schön klingen, deren Bezug zur aktuellen, vergangenen oder möglichen zukünftigen realen Welt nur schwer bis gar nicht herstellbar ist.

Hat also ein entwickeltes Sprachsystem schon für das Denken selbst eine gewisse Relevanz, spielt es natürlich auch für die Kommunikation eine Rolle. Der Gehirn-Körper transformiert ja nicht nur reale Welt in neuronale Korrelate b_B : RW x RW_NN —–> RW_NN (mit der Sprache L_B_NN als Teil von RW_NN), sondern der Gehirn-Körper produziert auch sprachliche Ausdrücke nach außen b_B : RW_NN —–> L. Die sprachlichen Ausdrücke L bilden von daher die Schnittstelle zwischen den Gehirnen. Was nicht gesagt werden kann, das existiert zwischen Gehirnen nicht, obgleich es möglicherweise neuronale Korrelate gibt, die wichtig sind. Nennt man die Gesamtheit der nutzbaren neuronalen Korrelate Wissen dann benötigt es nicht nur eine angemessene Kultur des Wissens sondern auch eine angemessene Kultur der Sprache. Eine Wissenschaft, eine empirische Wissenschaft ohne eine angemessene (Meta-)Sprache ist z.B. schon im Ansatz unfähig, mit sich selbst rational umzugehen; sie ist schlicht sprachlos.

EIN NEUES UNIVERSUM ? !

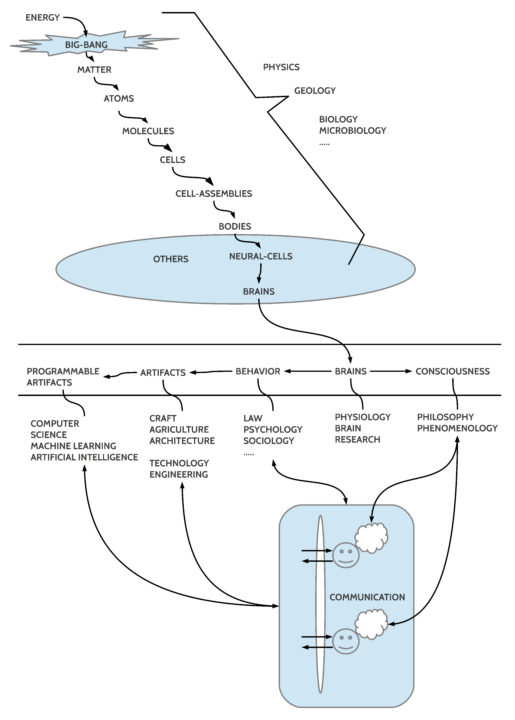

Betrachtet man die kontinuierlichen Umformungen der Energie-Materie vom Big Bang über Gasnebel, Sterne, Sternenhaufen, Galaxien und vielem mehr bis hin zur Entstehung von biologischem Leben auf der Erde (ob auch woanders ist komplexitätstheoretisch extrem unwahrscheinlich, aber nicht unmöglich), dort dann die Entwicklung zu Mehrzellern, zu komplexen Organismen, bis hin zum homo sapiens, dann kommt dem homo sapiens eine einzigartig, herausragende Rolle zu, der er sich bislang offensichtlich nicht richtig bewusst ist, u.a. möglicherweise auch, weil die Wissenschaften sich weigern, sich professionell mit ihrer eigenen Irrationalität zu beschäftigen.

Der homo sapiens ist bislang das einzig bekannte System im gesamten Universum, das in er Lage ist, die Energie-Materie Struktur in symbolische Konstrukte zu transformieren, in denen sich Teile der Strukturen des Universums repräsentieren lassen, die dann wiederum in einem Raum hoher Freiheitsgrade zu neue Zuständen transformiert werden können, und diese neuen — noch nicht realen — Strukturen können zum Orientierungspunkt für ein Verhalten werden, das die reale Welt real transformiert, sprich verändert. Dies bedeutet, dass die Energie-Materie, von der der homo sapiens ein Teil ist, ihr eigenes Universum auf neue Weise modifizieren kann, möglicherweise über die aktuellen sogenannten Naturgesetze hinaus.

Hier stellen sich viele weitere Fragen, auch alleine schon deswegen, weil der Wissens- und Sprachaspekt nur einen kleinen Teil des Potentials des homo sapiens thematisiert.