Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

16.Mai 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

Den folgenden Text hatte ich als Buchbesprechung zu Schätzings neuem Buch auf der Verkaufsseite des Buches bei amazon veröffentlicht. Es geht tatsächlich um eine Sachlage, um die Sachlage von uns Menschen. Hier der Link auf meine Besprechungsseite bei amazon.

KRITISCHE REZENSIONEN

Wer vor der Lektüre von Schätzings neuem Roman „Die Tyrannei des Schmetterlings. Roman. Kiepenheuer & Witsch, 736 Seiten“ versucht hat, Rezensionen zu diesem Buch zu lesen, der wird wenig ermutigt sein, sich diesem Buch zu widmen. In angesehenen Zeitungen finden sich Verrisse wie die von Jan Wiele (FAZ), 25.4.2018, Elmar Krekeler (Die Welt, 27.4.2018), Gerhard Matzig (SZ, 28.4.), und Alard von Kittlitz (Die Zeit, 5.5.2018). Ähnlich kritisch (wenngleich auch mit unterschiedlichen Argumenten) die Mehrheit der Reaktionen bei den Lesermeinungen zum Buch auf amazon. Bei amazon finden sich dann zwar auch positive Stimmen, aber aus ihnen kann man nicht so recht entnehmen, warum das Buch positiv ist. Von all diesen verrissartigen Besprechungen hebt sich wohltuend die ausführliche Besprechung von Peter Körting ab (FAZ, 24.4.2018). Sehr sachlich, sehr differenziert und sehr ausführlich gibt er einen Überblick über die Struktur des Romans, benennt Schwächen, lässt die Stärken nicht aus, und überlässt es dem Leser, zu einem endgültigen Urteil zu kommen.

STANDPUNKT DES REZENSENTEN

Ich hatte im Vorfeld den Verriss von Jan Wiele zum Buch gesehen, zwei Talkshows mit Schätzing, in denen die üblichen Klischees zu Künstlicher Intelligenz ausgetauscht wurden, und hatte nach dem begeisternden ‚Schwarm‘ zwei nachfolgende Romane von ihm nur mit Unlust zu Ende gebracht. Sein tendenziell schwulstiger Stil mit vielen Längen, dazu relativ flache Personenprofile, ist nicht unbedingt mein Stil. Dazu kommt, dass ich ein Experte in Sachen Künstlicher Intelligenz und angrenzender Themenfelder bin, seit mehr als 30 Jahren, und die Signale, die das Buch im Vorfeld aussendete, waren eher dazu angetan, es nicht auf die Leseliste zu setzen. Aber, zum Glück, ist das Leben trotz aller Pläne und Steuerungen doch immer noch von Zufällen geprägt: meine Frau bekam das Buch als Hörbuch zum Geburtstag geschenkt und aktuell anstehende lange Autofahrten brachten mich in eine Art Schicksalsgemeinschaft mit diesem Buch.

REINKOMMEN

Die ersten Minuten des Hörbuchs waren bei meiner Voreinstellung eine harte Prüfung: ein erhebliches Wortgetöse für eine Situation, die man mehr erahnen als verstehen konnte, mit einem abrupten harten Schnitt, der den Hörer von einem afrikanischen Land direkt nach Nord-Kalifornien, ins Land des Silicon Valley, führte. Die geringen Ausweichmöglichkeiten einer langen Fahrgemeinschaft hielten mich dann – glücklicherweise – fest, und ich konnte in der Folge minutenweise, stündlich erleben, wie sich aus einer scheinbaren Idylle langsam ein Thriller entwickelte, der bis zum Schluss (verteilt über mehrere Fahrten) häppchenweise an Dramatik zulegte. Nach ca. drei-viertel des Hörbuchs bin ich dann auf die Ebook-Version umgestiegen, da das dann einfach schneller ging.

ÄSTHETISCHE VERPACKUNG VON IDEEN

Die große Masse der Rezensionen arbeitet sich stark an der ästhetischen Verpackung ab, kritisiert die vielen Wortungetüme oder scheinbare ‚Slangs‘, die dem deutschen Bildungsbürger abartig erscheinen, leidet an empfundenen Längen, findet die Personen nicht so dargestellt, wie man selbst sie gerne sehen würde …. aber das ist weitgehend wirklich Geschmackssache und sagt nicht wirklich etwas über die ‚Botschaft‘, die in diesem Buch mutig und – man muss es schon mal hier sagen – ‚genial‘ verpackt wurde.

DER ZEITGEIST UND KÜNSTLICHE INTELLIGENZ

Während Experten im Bereich künstliche Intelligenz sich mit den Themen mindestens seit der Mitte des vorausgehenden Jahrhunderts intensiv beschäftigen, wurde die deutsche Öffentlichkeit so richtig erst seit der Cebit 2016 mit diesen Themen überrollt. Mit einem Mal besetzte das Thema ‚künstliche Intelligenz‘ nach und nach alle Medienkanäle, fortan täglich, stündlich. Es waren nicht unbedingt die Forscher selbst, die sich hier artikulierten, sondern vorwiegend die Marketingabteilungen der großen Konzerne, die verkaufen wollten, und die vielen Journalisten, die kaum etwas verstanden, aber nichts desto trotz als ‚Verstärker‘ der Marketingabteilungen viele Schlagworte in die Welt setzten, ohne sie wirklich zu erklären.

Während sich die Öffentlichkeit mit möglichen Schreckgespensten wie einer neuen kommenden Arbeitslosigkeit beschäftigte, das – in der Tat ungute – globale Ausspähen zum Thema machte, die Politik Digitalisierung und Industrie 4.0 propagierte, bunte lustige Filmchen von Robotern herumgereicht wurden, die merkwürdig aussahen und merkwürdige Dinge taten, blieb die ‚wahre Natur‘ von künstlicher Intelligenz, die rasant voranschreitende Forschungen zu immer komplexeren Steuerungen, Vernetzungen, und vor allem zur Kombination von künstlicher Intelligenz und Mikrobiologie, vor allem Genetik, weitgehend unsichtbar. Neueste Erkenntnisse zur Evolution des Lebens, zur Astrophysik, die weitgehende Auflösung aller alten Menschenbilder samt einer damit verbundenen Auflösung aller bekannten Ethiken wurde nie und wird immer noch nicht offiziell in der Öffentlichkeit diskutiert. Das weltweit zu beobachtende Phänomen von neuen, starken Strömungen in Richtung Populismus, Fanatismus, Nationalismus, verbunden mit stark diktatorischen Zügen ist – in diesem Kontext – kein Zufall.

In einer solchen Situation ist es wichtig, dass man anfängt, die vielen scheinbar isolierten Einzelphänomene aus ganz unterschiedlichen Bereichen in ihrem Zusammenhang sichtbar zu machen, in ihrer tatsächlichen Dynamik, in ihrer möglichen synergistischen Logik, ansatzweise verstehbar ohne die vielen komplexen Details, die ja selbst die Fachwissenchaftler kaum verstehen. Ich gebe offen zu, dass ich selbst – als Fachexperte – schon mehrfach erwogen hatte, etwas Populäres zu schreiben, um die komplexen Sachverhalte irgendwie verständlicher zu machen. Ich bin aber über erste Plots nicht hinaus gekommen. Ich fand einfach keinen Weg, wie man diese Komplexität erzählbar machen kann.

JENSEITS DER EINZELFAKTEN

Sieht man von den ästhetischen Besonderheiten des Textes bei Schätzing ab (die einen finden seinen Stil gut, andere leiden), dann kann man im Verlaufe seiner Schilderungen nicht nur eine erstaunliche große Bandbreite an technischen Details kennenlernen, die den aktuellen und denkbar kommenden Forschungsstand sichtbar machen, sondern er vermag es, diese vielen Details in funktionale Zusammenhänge einzubetten, die nicht so ohne weiteres auf der Hand liegen und die sich so auch in kaum einer anderen Publikation finden, nicht in dieser Explizitheit. In seinem Text offenbart er eine innovative, kreative Kraft des Weiter-Denkens und des Zusammen-Denkens, die beeindruckend ist, die sehr wohl zu weiterführenden und intensiven Diskussionen geeignet sein könnte.

PARALLEL-UNIVERSEN

Verglichen mit dem mittlerweile schon abgedroschen wirkendem Stilmittel der Zeitreisen eröffnet seine Verwendung der Idee von Parallel-Universen viele neue, interessante Szenarien, die erzählerisch zu ungewohnten, und darin potentiell aufschlussreichen, Konstellationen führen können. Wissenschaftlich ist dieses Thema hochspekulativ und in der Art der Umsetzung wie bei Schätzing eher extrem unwahrscheinlich. Erzählerisch eröffnet es aber anregende Perspektiven, die viele philosophisch relevante Themen aufpoppen lassen, einfach so, spielerisch. Ob es Schätzing gelungen ist, dieses Stilmittel optimal zu nutzen, darüber kann man streiten. In seinem Text eröffnet dieses Stilmittel allerdings eine Diskussion über alternative Entwicklungsmöglichkeiten, die ohne das Stilmittel Parallel-Universen, wenn überhaupt, nur sehr umständlich hätten diskutiert werden können.

CYBORGS

Was Schätzing hier mit vielen Beispielen zum Thema ‚Design von neuen biologischen Strukturen‘ schreibt, ist in so manchem Entwicklungslabors Alltag. Die Fassade einer Ethik, die es inhaltlich gar nicht mehr gibt, verhindert in manchen Ländern die offizielle Forschung mit neuen molekularbiologischen Strukturen, aber sie passiert trotzdem. Unterstützt durch Computer mit immer leistungsfähiger Software werden immer schneller immer neuere biologische Strukturen geschaffen, die mit anderen Technologien (z.B. Nanotechnologie) verknüpft werden. Und der Einbau von künstlicher Intelligenz in biologische Strukturen (die als solche ja schon unterschiedliche Formen von Intelligenz haben) ist in vollem Gange. Aktuell sind diese Spezialentwicklungen. Es ist das Verdienst von Schätzing, beispielhaft Zusammenhänge zu denken, in denen sich diese Spezialentwicklungen im größeren Kontext zeigen und was sie bewirken können, wenn Geld und Macht gezielt genutzt werden, um sie bewusst zu nutzen. Diese Art von Science Fiction ist unserer Gegenwart erschreckend nahe.

SUPERINTELLIGENZ

Während heute selbst seriöse Forscher immer öfter über die Möglichkeit von technischen Superintelligenzen nachdenken, ist das Verständnis einer solchen Technologie bislang noch nicht wirklich da. Es gibt bis jetzt ja noch nicht einmal eine allgemein akzeptierte Definition von ‚künstlicher Intelligenz‘. Das Ausweichen auf den harmloser klingenden Ausdruck ‚maschinelles Lernen‘ löst das Problem nicht. Die Wissenschaft hat bislang keine klare Meinung, was sie wirklich unter einer ‚künstlichen Intelligenz‘ verstehen soll, geschweige denn, was eine ‚Superintelligenz‘ sein soll, eine solche, die die ‚menschliche Intelligenz‘ deutlich übertrifft. Erstaunlich ist in diesem Zusammenhang, dass auch die sogenannte ‚menschliche Intelligenz‘ nach ungefähr 150 Jahren Intelligenzforschung noch nicht vollständig geklärt ist. Gemeinsam ist allen Positionen, dass man den Menschen in seiner aktuellen biologischen Verfassung bezüglich Datenmenge und Geschwindigkeit der Verarbeitung von Daten einer potentiellen Maschine gegenüber als hoffnungslos unterlegen ansieht. Aus diesen sehr äußerlichen Kriterien leitet man ab, dass eine solche Maschine dann ‚irgendwie‘ den Menschen auch in Sachen ‚Intelligenz‘ haushoch überlegen sein wird.

Schätzing kann das Fehlen wissenschaftlicher Erklärungen zu künstlicher Intelligenz nicht ersetzen, aber als innovativ-kreativer Geist kann er literarisch ein Szenario erschaffen, in dem ansatzweise sichtbar wird, was passieren könnte, wenn es eine solche maschinelle Superintelligenz gäbe, die über Netze und steuerbare Körper mit der Welt verbunden ist. Es ist auch bemerkenswert, dass Schätzing sich dabei nicht von technischen Details ablenken lässt sondern den Kern des Super-Intelligenz-Problems im Problem der ‚Werte‘, der ‚Präferenzen‘ verortet. Das, was heute weltweit als ‚künstliche Intelligenz‘ propagiert wird, ist in der Regel noch weitab von einer ‚vollen künstlichen Intelligenz‘, da diese ‚gezähmten Intelligenzen‘ nur innerhalb eng vorgegebener Zielgrößen lernen und dann agieren dürfen. Andernfalls könnten die Firmen die Zuverlässigkeit des Betriebs nicht garantieren. Jene wenigen Forschungsgruppen, die sich mit echten ‚ungezähmten‘ künstlichen Intelligenzen beschäftigen (z.B. im Bereich ‚developmental robotics‘), stehen vor dem riesigen Problem, welche Werte diese offen lernenden Systeme haben sollten, damit sie tatsächlich ‚autonom‘ ‚alles‘ lernen können. Aktuell hat niemand eine befriedigende Lösung. Und diese Forschungen zeigen, dass wir Menschen über die Art und Weise, wie wir selbst Werte finden, entwickeln, benutzen bislang kein wirklich klares Bild haben. Das bisherige Reden über Ethik hat eher den Charakter einer ‚Verhinderung von Klärung‘ statt einer offenen Klärung.

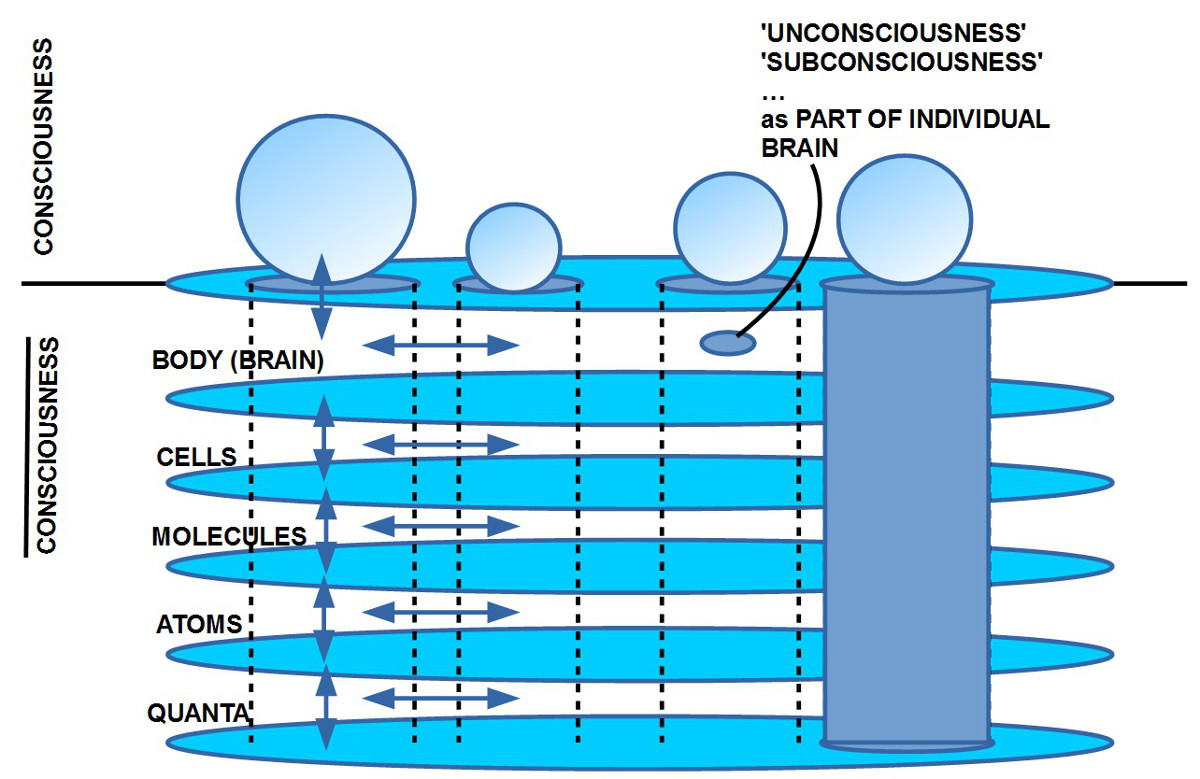

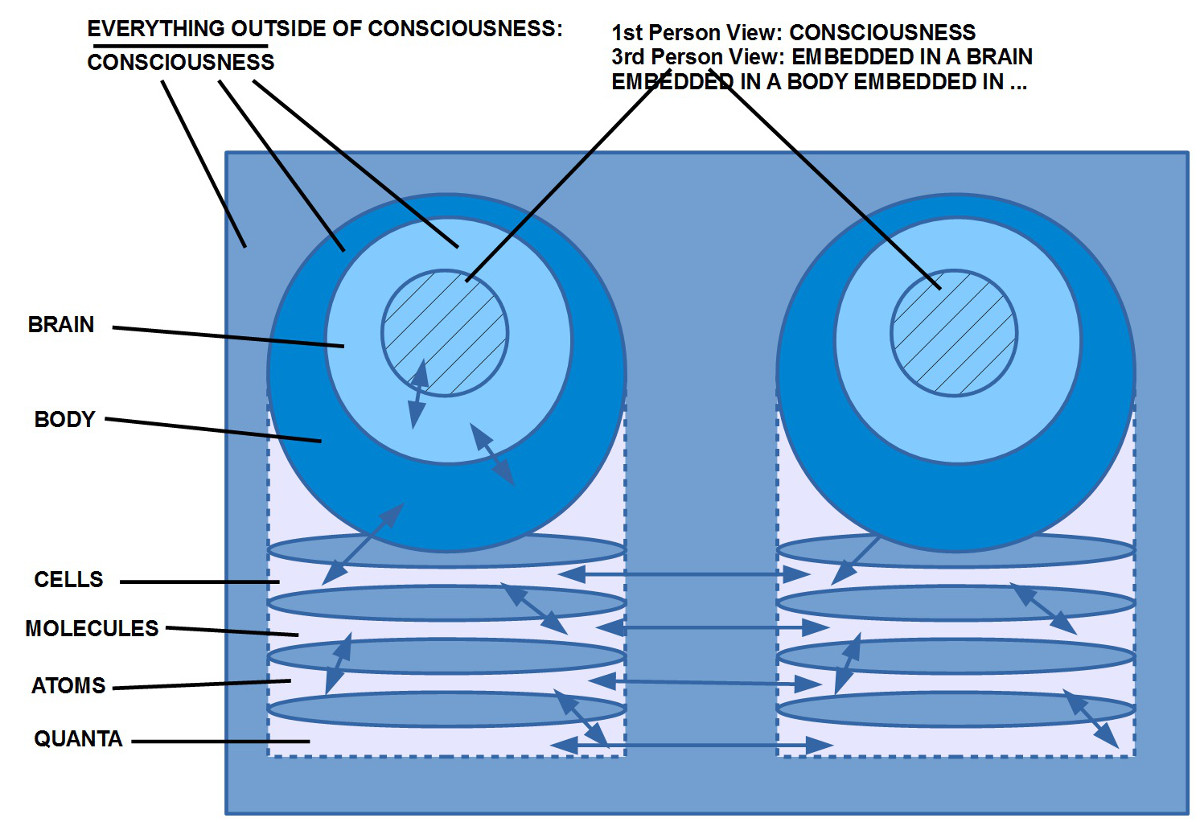

Schätzing wagt es sogar, über das mögliche Bewusstsein einer solchen maschinellen Superintelligenz zu spekulieren. Dies ist nicht abwegig, es ist sogar notwendig. Aber auch hier zeigt sich, dass wir Menschen unsere eigenen Hausaufgaben noch lange nicht gemacht haben. Auch das Thema ‚Bewusstsein‘ ist weder von der Philosophie noch von den unterstützenden empirischen Wissenschaften bislang gelöst. Es gibt viele hundert Artikel und Bücher zum Thema, aber keine allgemein akzeptierte Lösung.

Ich finde es daher gut und mutig, dass Schätzing in diesem Zusammenhang es wagt, das Thema anzusprechen. Künstliche Intelligenzforschung kann ein wunderbarer Gesprächspartner für Psychologen, Neuropsychologen und Philosophen sein. Leider wissen die jeweiligen Gesprächspartner aber oft zu wenig voneinander.

DEN ZEITGEIST DURCHBUCHSTABIERT

Nimmt man alle Einzelheiten zusammen, würdigt die vielen kreativ-innovativen Zusammenhänge, die Schätzing sichtbar macht, schaut sich an, wie er es schafft, das schwierige Thema ‚maschinelle Superintelligenz‘ in einem größeren komplexen Kontext in Szene zu setzen, dann bin ich bereit, zu konzedieren, dass dies eine tatsächlich geniale Leistung ist. Er kondensiert die vielen losen Fäden zu einem Gesamtbild, das unserer tatsächlichen und der sehr bald möglichen Zukunft sehr nahe ist, und macht deutlich, dass hier ein erheblicher Diskussionsbedarf besteht, und zwar über alle Positionen und Fachgrenzen hinweg. Ich kenne kein Buch, das in der aktuellen Situation auch nur ansatzweise literarisch das leistet, was Schätzing hier vorgestellt hat. Ich kann nur hoffen, dass diesem Aufschlag von Schätzing noch viele Reaktionen folgen (allerdings bitte nicht als billiger Verriss).

KONTEXT BLOG

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER