Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

24.Juni 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

VORBEMERKUNG

Der folgende Text wurde im September in einer christlichen Zeitschrift veröffentlicht [*]. Es war (und ist) ein ‚experimenteller Text‘, bei dem ich versucht habe, auszuloten, was gedanklich passiert, wenn man die beiden Themenkreise ‚Glaube an Gott im Format christlicher Theologie‘ mit dem Themenkreis ‚Künstliche Intelligenz‘ zusammen führt. Das Ergebnis kann überraschen, muss aber nicht. Dieser ganze Blog ringt von Anbeginn um das Verhältnis von Philosophie, Wissenschaft (mit Technologie) und dem Phänomen der Spiritualität als Menschheitsphänomen, und die christliche Sicht der Dinge (die in sich ja keinesfalls einheitlich ist), ist nur eine Deutung von Welt unter vielen anderen. Wer die Einträge dieses Blogs durch mustert (siehe Überblick) wird feststellen, dass es sehr viele Beiträge gibt, die um die Frage nach Gott im Lichte der verfügbaren Welterfahrung kreisen. Die aktuelle Diskussion von W.T.Stace’s Buch ‚Religion and the Modern Mind‘ (Beginn mit Teil 1 HIER) setzt sich auch wieder mit dieser Frage auseinander.

INHALT BEITRAG

Im Alltag begegnen wir schon heute vielfältigen Formen von Künstlicher Intelligenz. Bisweilen zeigt sie sehr menschenähnliche Züge. In Filmen werden uns Szenarien vorgeführt, in denen Superintelligenzen zukünftig die Herrschaft über uns Menschen übernehmen wollen. Wie verträgt sich dies mit unserem Menschen-und Gottesbild? Macht Glauben an Gott dann noch Sinn?

I. KI IST SCHON DA …

Vielen Menschen ist gar nicht bewusst, wo sie im Alltag schon mit Programmen der Künstlichen Intelligenz (KI) zu tun haben. Schaut man sich aber um, wird man entdecken, dass Sie scheinbar schon überall am Werk ist. Hier ein paar Stichworte: Kundenanfragen werden immer mehr durch KI-Programme bestritten. In der Logistik: In Lagerhallen und ganzen Häfen arbeiten intelligente Roboter, die wiederum von anderen KI-Programmen überwacht und optimiert werden. Ähnliches in Fabriken mit Produktionsstraßen. Für die Wartung von Maschinenbenutzen Menschen Datenhelme, die über ein KI-Programm gesteuert werden und die dem Menschensagen, was er sieht, und wo er was tun soll. In der Landwirtschaft sind die beteiligten Maschinen vernetzt, haben KI-Programme entweder an Bord oder werden über Netzwerke mit KI-Programmen verbunden: diese kontrollieren den Einsatz und steuern Maßnahmen. Auf den Feldern können diese Maschinen autonom fahren. Im Bereich Luftfahrt und Schifffahrt können sich Flugzeuge und Schiffe schon heute völlig autonom bewegen, ebenso beim LKW-Verkehr und auf der Schiene. Durch das Internet der Dinge (IoT) wird gerade der Rest der Welt miteinander vernetzt und damit einer zunehmenden Kontrolle von KI-Programmen zugänglich gemacht. In der Telemedizin ist dies schon Alltag: Ferndiagnose und Fernbehandlung sind auf dem Vormarsch. Schon heute wird für die Diagnose schwieriger und seltener Krankheiten KI eingesetzt, weil sie besser ist als ganze Gruppen menschlicher Experten. Viele komplizierte Operationen – speziell im Bereich Gehirn – wären ohne Roboter und KI schon heute unmöglich. KI-Programme entschlüsseln das Erbgut von Zellen, Suchen und Finden neue chemische Verbindungen und pharmakologische Wirkstoffe.

In der Finanzwirtschaft haben KI-Programme nicht nur den Handel mit Aktien und anderen Finanzprodukten übernommen (Stichwort: Hochfrequenzhandel), sondern sie verwalten auch zunehmend das Vermögen von Privatpersonen, übernehmen den Kontakt mit den Kunden, und wickeln Schadensfälle für Versicherungen ab. Bei anwaltlichen Tätigkeiten werden Routineaufgaben von KI-Programmen übernommen. Richter in den USA lassen sich in einzelnen Bundesländern mit KI-Programmen die Wahrscheinlichkeit ausrechnen, mit der ein Angeklagter wieder rückfällig werden wird; dies wird zum Schicksal für die Angeklagten, weil die Richter diese Einschätzungen in ihr Urteil übernehmen. Das Militär setzt schon seit vielen Jahren in vielen Bereichen auf KI-Programme. Zuletzt bekannt durchfliegende Kampfroboter (Drohnen). Dazu weltweite Ausspähprogramme von Geheimdiensten, die mit Hilfe von KI-Programmen gewaltige Datenströme analysieren und bewerten.Diese Aufzählung mag beeindruckend klingen, sie ist aber nicht vollständig. In vielen anderen Bereichen wie z.B. Spielzeug, Online-Spiele, Musikproduktion,Filmproduktion, Massenmedien, Nachrichtenproduktion,… sind KI-Programme auch schon eingedrungen. So werden z.B. mehr und mehr Nachrichtentexte und ganze Artikel für Online-Portale und Zeitungen durch KI-Programme erstellt; Journalisten waren gestern. Dazu hunderttausende von sogenannten ’Bots’ (Computerprogramme, die im Internet kommunizieren, als ob sie Menschen wären), die Meinungen absondern, um andere zu beeinflussen. Was bedeuten diese Erscheinungsformen Künstlicher Intelligenz für uns?

A. Freund oder Konkurrent?

Bei einem nächtlichen Biergespräch mit einem der berühmtesten japanischen Roboterforschern erzählte er aus seinem Leben, von seinen Träumen und Visionen. Ein Thema stach hervor: seine Sicht der Roboter. Für ihn waren Roboter schon seit seiner Kindheit Freunde der Menschen, keinesfalls nur irgendwelche Maschinen. Mit diesen Roboter-Freunden soll das Leben der Menschen schöner, besser werden können. In vielen Science-Fiction Filmen tauchen Roboter in beiden Rollen auf: die einen sind die Freunde der Menschen, die anderen ihre ärgsten Feinde; sie wollen die Menschen ausrotten, weil sie überflüssig geworden sind. Bedenkt man, dass die Filme auf Drehbüchern beruhen, die Menschen geschrieben haben, spiegelt sich in diesem widersprüchlichen Bild offensichtlich die innere Zerrissenheit wieder, die wir Menschen dem Thema Roboter, intelligenten Maschinen, gegenüber empfinden. Wir projizieren auf die intelligenten Maschinen sowohl unsere Hoffnungen wie auch unsere Ängste, beides übersteigert, schnell ins Irrationale abrutschend.

B. Neue Verwundbarkeiten

Ob intelligente Maschinen eher die Freunde der Menschen oder ihre Feinde sein werden, mag momentan noch unklar sein, klar ist jedoch, dass schon jetzt der Grad der Vernetzung von allem und jedem jeden Tag einen realen Raum mit realen Bedrohungen darstellt. Global operierenden Hacker-Aktivitäten mit Datendiebstählen und Erpressungen im großen Stil sind mittlerweile an der Tagesordnung. Während die einen noch versuchen, es klein zu reden, lecken andere schon längst ihre Wunden und es gibt immer mehr Anstrengungen, diesen Angriffen mehr ’Sicherheit’ entgegen zu setzen. Doch widerspricht das Prinzip der Zugänglichkeit letztlich dem Prinzip der vollständigen Abschottung. Wenn die Vernetzung irgendeinen Sinn haben soll, dann eben den, dass es keine vollständige Abschottung gibt. Dies läuft auf die große Kunst einer ’verabredeten Abschottung’ hinaus: es gibt eine ’bestimmte Datenkonstellation, die den Zugang öffnet’. Dies aber bedeutet, jeder kann herumprobieren, bis er diese Datenkonstellation gefunden hat. Während die einen KI-Programme einsetzen, um diese Datenschlüssel zu finden, versuchen die anderen mit KI-Programmen, mögliche Angreifer bei ihren Aktivitäten zu entdecken. Wie dieses Spiel auf lange Sicht ausgehen wird, ist offen. In der Natur wissen wir, dass nach 3.8 Milliarden Jahren biologischem Leben die komplexen Organismen bis heute beständig den Angriffen von Viren und Bakterien ausgeliefert sind, die sich um Dimensionen schneller verändern können, als das biologische Abwehrsystem(das Immunsystem) lernen kann. Die bisherige Moral aus dieser Geschichte ist die, dass diese Angriffe bei komplexen Systemen offensichtlich ko-existent sind, dazu gehören. Nur ein schwacher Trost ist es, dass der beständige Abwehrkampf dazu beiträgt, die Systeme graduell besser zu machen. Mit Blick auf diese fortschreitende Vernetzung ist es wenig beruhigend, sich vorzustellen, dass es in ca. 70- 90 Jahren (wie viele vermuten) (Anmerkung: Siehe dazu eine längere Argumentation im 1.Kap. von Bostrom (2014) [Bos14]) tatsächlich eine echte technische Superintelligenz geben wird, die allen Menschen gegenüber überlegen ist; eine solche technische Superintelligenz könnte im Handumdrehen alle Netze erobern und uns alle zu ihren Gefangenen machen. Nichts würde mehr in unserem Sinne funktionieren: die Super-KI würde alles kontrollieren und uns vorschreiben, was wir tun dürfen. Über das Internet der Dinge und unsere Smartphones wäre jeder 24h unter vollständiger Kontrolle. Jede kleinste Lebensregung wäre sichtbar und müsste genehmigt werden. Ob und was wir essen, ob wir noch als lebenswert angesehen werden …

C. Noch ist es nicht soweit …

Zum Glück ist dieses Szenario einer menschenfeindlichen Superintelligenz bislang nur Science-Fiction. Die bisherigen sogenannten KI-Programme sind nur in einem sehr eingeschränkten Sinne lernfähig. Bislang sind sie wie abgerichtete Hunde, die nur das suchen,was ihnen ihre Auftraggeber vorgeben, zu suchen. Sie haben noch keine wirkliche Autonomie im Lernen, sie können sich noch nicht selbständig weiter entwickeln(nur unter speziellen Laborbedingungen). Allerdings sammeln sie Tag und Nacht fleißig Daten von allem und jedem und erzeugen so ihre einfachen Bilder von der Welt: z.B. dass die Männer im Alter von 21 in der Region Rhein-Main mit Wahrscheinlichkeit X folgende Gewohnheiten haben …. Herr Müller aus der Irgendwo-Straße hat speziell jene Gewohnheiten …. seine Freunde sind … Es gibt eine hohe Wahrscheinlichkeit dass er Partei Y wählen wird … dass er in drei Monaten ein neues Auto vom Typ X kaufen wird ….am liebsten klickt er folgende Adressen im Internet an …

In den Händen von globalen Firmen, anonymen Nachrichtendiensten, autoritären Regierungen oder verbrecherischen Organisationen können allerdings schon diese Daten zu einer echten Bedrohung werden, und diese Szenarien sind real. Die Rolle der bösen Superintelligenz wird hier bis auf weiteres noch von Menschen gespielt; Menschen haben in der Vergangenheit leider zur Genüge bewiesen, dass sie das Handwerk des Bösen sehr gut beherrschen können…Es stellt sich die Frage, ob sich die bisherigen einfachen künstlichen Intelligenzen weiter entwickeln können? Lernen künstliche Intelligenzen anders als Menschen? Welche Rolle spielen hier Werte? Sind Werte nicht ein altmodischer Kram, den nur Menschen brauchen (oder selbst diese eigentlich nicht)? Schließlich, wo kommt hier Gott ins Spiel? Tangieren künstliche Intelligenzen den menschlichen Glauben an Gott überhaupt?

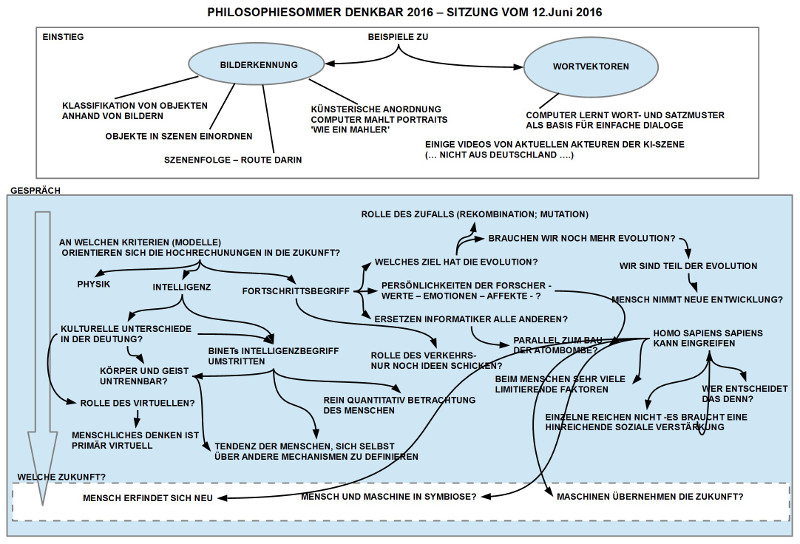

II. WAS IST ’KÜNSTLICHE INTELLIGENZ’

Für eine Erkundungsreise in das Land der Künstlichen Intelligenz ist die Lage nicht ganz einfach, da das Gebiet der KI sich mittlerweile sehr stürmisch entwickelt. Immer mehr Konzepte stehen nebeneinander im Raum ohne dass es bislang allgemein akzeptierte Theorie- und Ordnungskonzepte gibt. (Anmerkung: Für zwei sehr unterschiedliche historische Rückblicke in das Thema sei verwiesen auf Mainzer (1995) [Mai95] und Nilsson (2010) [Nil10]. Für eine sehr populäre, wenngleich methodisch problematische, Einführung in den Stand der Disziplin siehe Russel und Norvik (2010) [RN10]).

Wir besuchen hier für einen Einstieg einen der großen Gründungsväter ganz zu Beginn 1936 – 1950 Alan Matthew Turing, und dann für die Zeit 1956 – 1976 Alan Newell und Herbert A.Simon. (Anmerkung: Simon war auch ein Nobelpreisträger im Gebiet der Wirtschaftswissenschaften 1978.) Dann schauen wir noch kurz in allerneueste Forschungen zum Thema Computer und Werte.

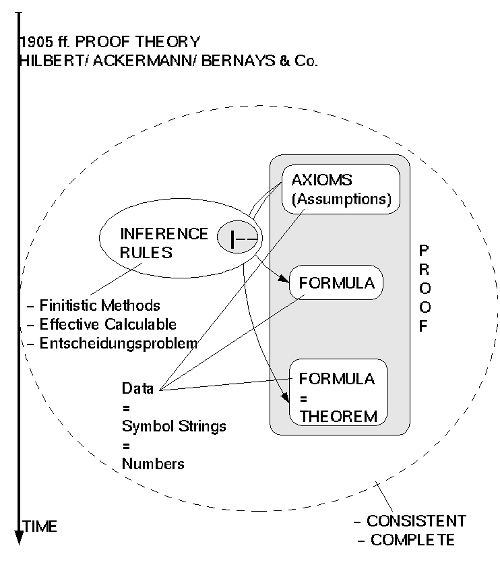

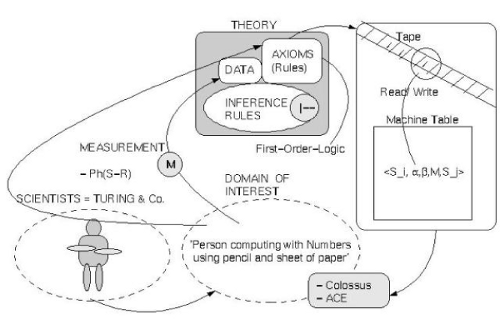

A. Am Anfang war der Computer

Wenn wir von künstlicher Intelligenz sprechen setzen wir bislang immer voraus, dass es sich um Programme (Algorithmen) handelt, die auf solchen Maschinen laufen, die diese Programme verstehen. Solche Maschinen gibt es seit 1937 und ihre technische Entwicklung hing weitgehend davon ab, welche Bauteile ab wann zur Verfügung standen. Das Erstaunliche an der bisherigen Vielfalt solcher Maschinen, die wir Computer nennen, ist, dass sich alle diese bis heute bekannt gewordenen Computer als Beispiele (Instanzen) eines einzigen abstrakten Konzeptes auffassen lassen. Dieses Konzept ist der Begriff des universellen Computers, wie er von Alan Matthew Turing 1936/7 in einem Artikel beschrieben wurde (siehe: [Tur 7] 4 ). In diesem Artikel benutzt Turing das gedankliche Modell einer endlichen Maschine für jene endlichen Prozesse, die Logiker und Mathematiker intuitiv als ’berechenbar’ und ’entscheidbar’ ansehen. (Anmerkung: Zum Leben Turings und den vielfältigen wissenschaftlichen Interessen und Einflüssen gibt es die ausgezeichnete Biographie von Hodges (1983) [Hod83].) Das Vorbild für Turing, nach dem er sein Konzept des universellen Computers geformt hat, war das eines Büroangestellten, der auf einem Blatt Papier mit einem Bleistift Zahlen aufschreibt und mit diesen rechnet.

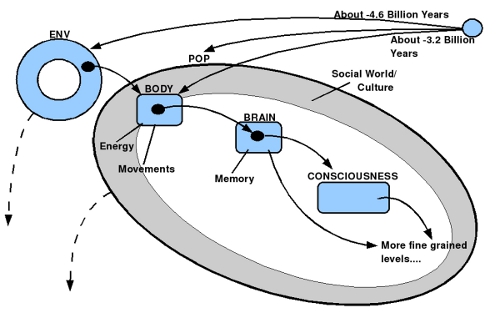

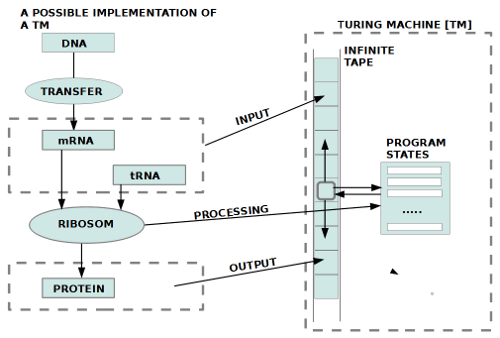

B. Computer und biologische Zelle

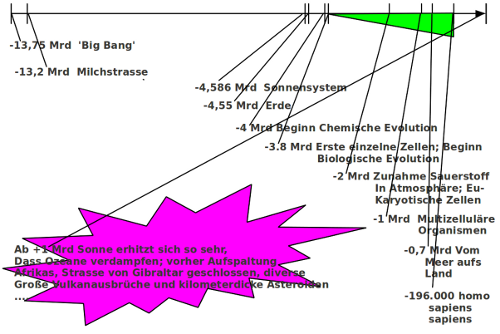

Was Turing zur Zeit seiner kreativen Entdeckung nicht wissen konnte, ist die Tatsache, dass sein Konzept des universellen Computers offensichtlich schon seit ca. 3.5 Milliarden Jahre als ein Mechanismus in jeder biologischen Zelle existierte. Wie uns die moderne Molekularbiologie über biologische Zellen zur Erfahrung bringt(siehe [AJL + 15]), funktioniert der Mechanismus der Übersetzung von Erbinformationen in der DNA in Proteine (den Bausteinen einer Zelle) mittels eines Ribosom-Molekülkomplexes strukturell analog einem universellen Computer. Man kann dies als einen Hinweis sehen auf die implizite Intelligenz einer biologischen Zelle. Ein moderner Computer arbeitet prinzipiell nicht anders.

C. Computer und Intelligenz

Die bei Turing von Anfang an gegebene Nähe des Computers zum Menschen war möglicherweise auch die Ursache dafür, dass sehr früh die Frage aufgeworfen wurde, ob, und wenn ja, wieweit, ein Computer, der nachdem Vorbild des Menschen konzipiert wurde, auch so intelligent werden könnte wie ein Mensch?

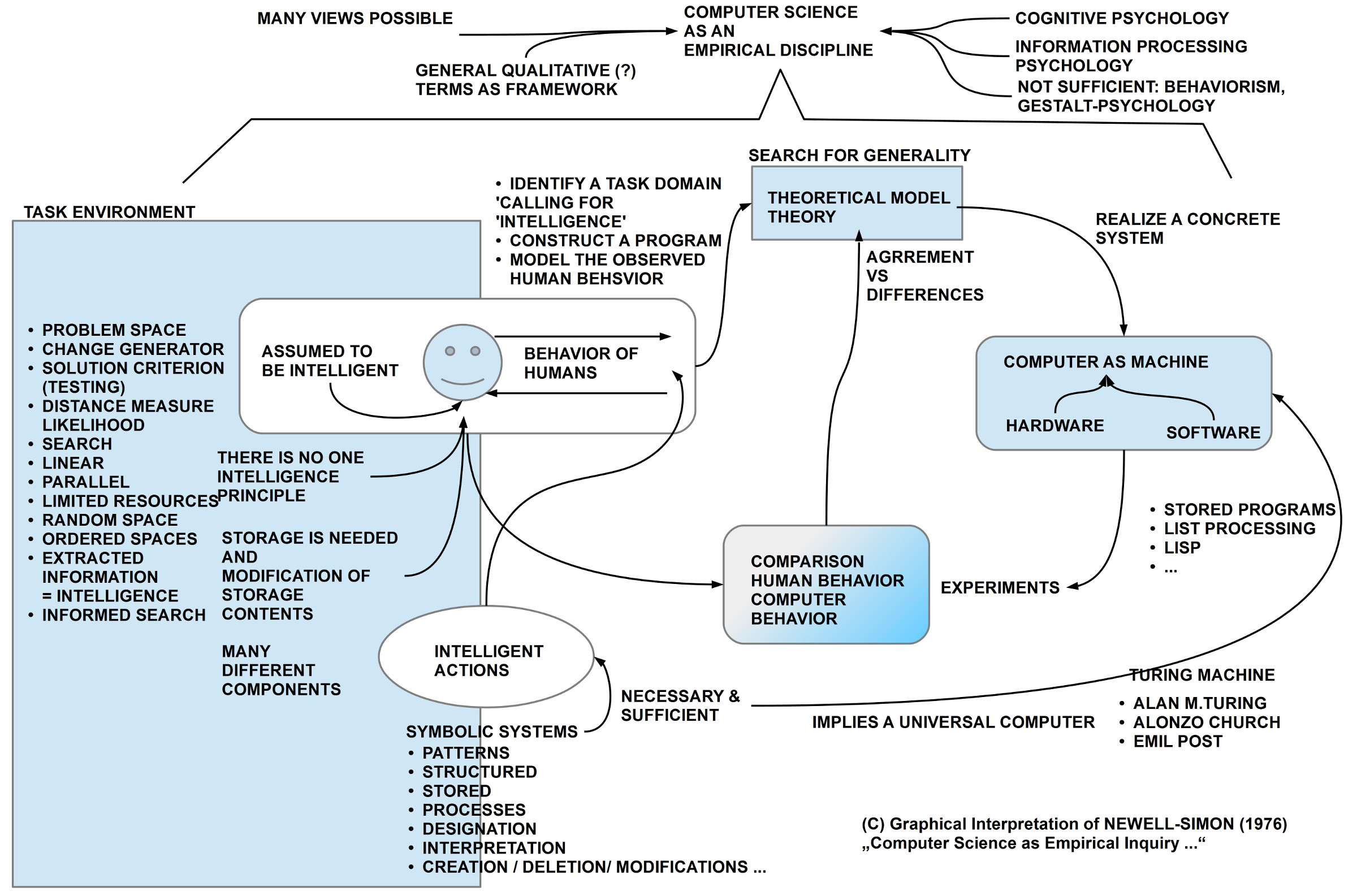

Der erste, der diese Frage in vollem Umfang aufwarf und im einzelnen diskutierte, war wieder Turing. Am bekanntesten ist sein Artikel über Computerintelligenz von 1950 [Tur50]. Er hatte aber schon 1948 in einem internen Forschungsbericht für das nationale physikalische Labor von Großbritannien einen Bericht geschrieben über die Möglichkeiten intelligenter Maschinen. (Anmerkung: Eine Deutsche Übersetzung findet sich hier: [M.87]. Das Englische Original ’Intelligent Machinery’ von 1948 findet sich online im Turing Archiv: http://www.alanturing.net/intelligent_machinery.) In diesem Bericht analysiert er Schritt für Schritt, wie eine Maschine dadurch zu Intelligenz gelangen kann, wenn man sie, analog wie bei einem Menschen, einem Erziehungsprozess unterwirft, der mit Belohnung und Strafe arbeitet. Auch fasste er schon hier in Betracht, dass sein Konzept einer universellen Maschine das menschliche Gehirn nachbaut. Turing selbst konnte diese Fragen nicht entscheiden, da er zu dieser Zeit noch keinen Computer zur Verfügung hatte, mit dem er seine Gedankenexperimente realistisch hätte durchführen können. Aber es war klar, dass mit der Existenz seines universellen Computerkonzeptes die Frage nach einer möglichen intelligenten Maschine unwiderruflich im Raum stand. Die Fragestellung von Turing nach der möglichen Intelligenz eines Computers fand im Laufe der Jahre immer stärkeren Widerhall. Zwei prominente Vertreter der KI-Forschung, Allen Newell und Herbert A.Simon, hielten anlässlich des Empfangs des ACM Turing-Preises1975 eine Rede, in der sie den Status der KI-Forschung sowie eigene Arbeiten zum Thema machten (siehe dazu den Artikel [NS76]).

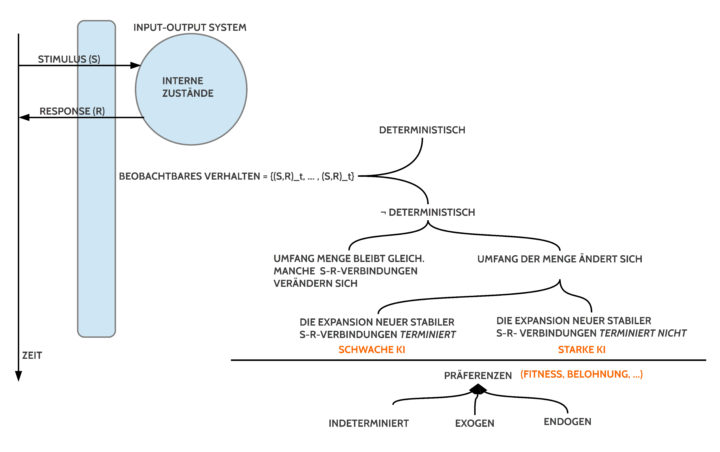

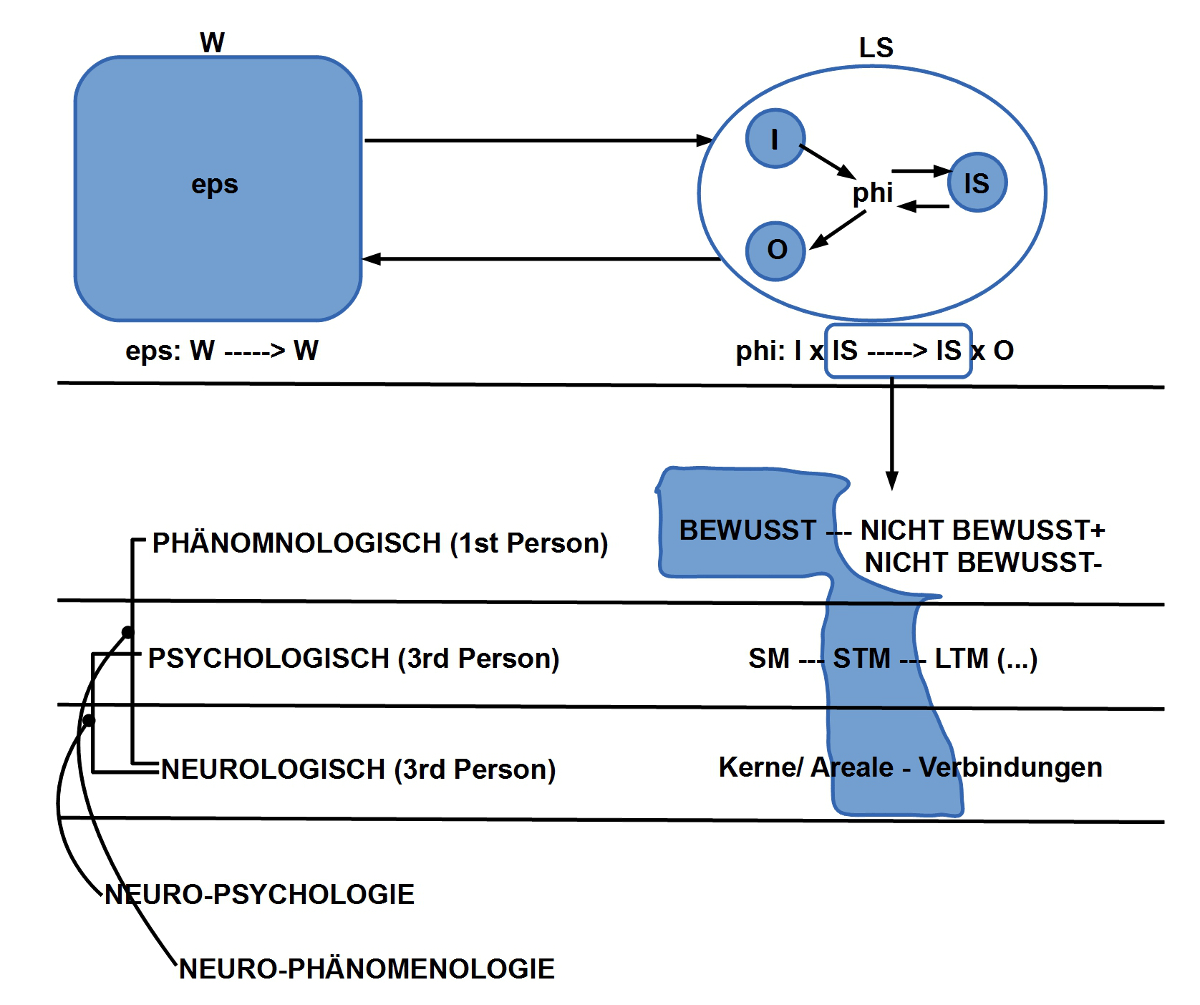

D. Eine Wissenschaft von der KI

Für Newell und Simon ist die KI-Forschung eine empirische wissenschaftliche Disziplin, die den Menschen mit seinem Verhalten als natürlichen Maßstab für ein intelligentes Verhalten voraussetzt. Relativ zu den empirischen Beobachtungen werden dann schrittweise theoretische Modelle entwickelt, die beschreiben, mit welchem Algorithmus man eine Maschine (gemeint ist der Computer) programmieren müsse, damit diese ein dem Menschen vergleichbares – und darin als intelligent unterstelltes – Verhalten zeigen könne. Im Experiment ist dann zu überprüfen, ob und wieweit diese Annahmen zutreffen.

E. Intelligenz (ohne Lernen)

Aufgrund ihrer eigenen Forschungen hatten Newell und Simon den unterstellten vagen Begriff der ’Intelligenz’ schrittweise ’eingekreist’ und dann mit jenen Verhaltensweisen in Verbindung gebracht, durch die ein Mensch (bzw. ein Computer) bei der Abarbeitung einer Aufgabe schneller sein kann, als wenn er nur rein zufällig’ handeln würde. ’Intelligenz’ wurde also in Beziehung gesetzt zu einem unterstellten ’Wissen’ (und zu unterstellten ‚Fertigkeiten‘), über das ein Mensch (bzw. ein Computer) verfügen kann, um eine bestimmte Aufgabe ’gezielt’ zu lösen. Eine so verstandene ’Intelligenz’ kann sich aus sehr vielfältigen, möglicherweise sogar heterogenen, Elementen zusammen setzen.

Dies erklärt ihre mannigfaltigen Erscheinungsweisen bei unterschiedlichen Aufgaben. ’Intelligenz’ ist dabei klar zu unterscheiden, von einem ’Lernen’. Ist die Aufgabenstellung vor dem Einsatz einer Maschine hinreichend bekannt, dann kann ein Ingenieur all das spezifische Wissen, das eine Maschine für die Ausführung der Aufgabe benötigt, von vornherein in die Maschine ’einbauen’. In diesem Sinne ist jede Maschine durch das Knowhow von Ingenieuren in einem spezifischen Sinne ’intelligent’. Bis vor wenigen Jahrzehnten war dies die Standardmethode, wie Maschinen von Ingenieuren entworfen und gebaut wurden.

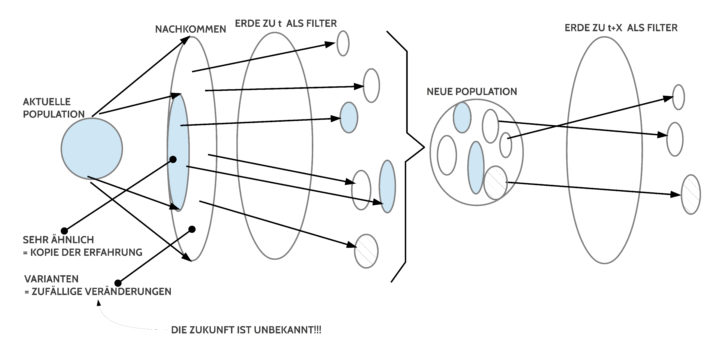

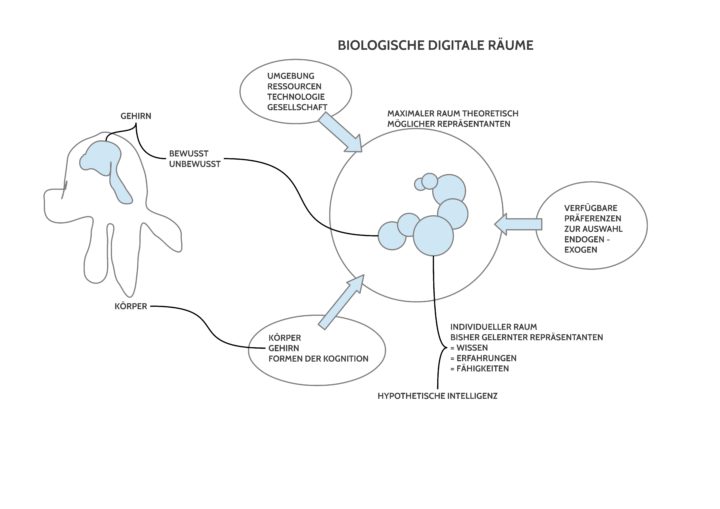

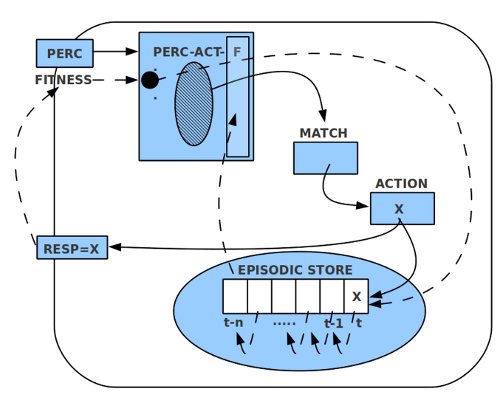

F. Lernen ermöglicht Intelligenz

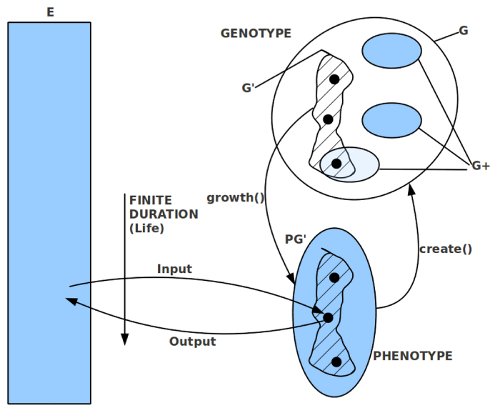

Im Fall von biologischen Systemen ist ein solches Vorgehen kaum möglich. Biologische Systeme entstehen (durch Zellteilung), ohne dass bei der Entstehung bekannt ist, wie die Umwelt aussehen wird, ob sie sich verändert, welche Aufgaben das biologische Systemlösen muss. Zwar haben alle biologische Systeme auch genetisch vorbestimmte Verhaltensmuster, die gleich bei der Geburt zur Verfügung stehen, aber darüber hinaus haben alle biologische Systeme einen ariablen Anteil von Verhaltensweisen, die sie erst lernen müssen. Das Lernen ist hier jene Fähigkeit eines biologischen Systems, wodurch es seine internen Verhaltensstrukturen in Abhängigkeit von der ’Erfahrung’ und von ’spezifischen Bewertungen’ ’ändern’ kann. Dies bedeutet, dass biologische Systeme durch ihre Lernfähigkeit ihr Verhalten ’anpassen’ können. Sie können damit – indirekt – ein ’spezifisches Wissen’ erwerben, das ihnen dann eine spezifische ’Intelligenz’ verleiht, wodurch das biologischen System besser als durch Zufall reagieren kann. Diese Fähigkeit eines situationsgetriebenen Wissens besaßen Maschinen bis vor kurzem nicht. Erst durch die modernen Forschungen zu einer möglichen ’künstlichen Intelligenz (KI)’ machte man mehr und mehr Entdeckungen, wie man Maschinen dazu in die Lage versetzen könnte, auch nach Bedarf neues Verhalten erlernen zu können. Innerhalb dieses Denkrahmens wäre dann eine ’künstliche Intelligenz’ eine Maschine, hier ein Computer, der über Algorithmen verfügt, die ihn in die Lage versetzen, Aufgaben- und Situationsabhängig neues Verhalten zu erlernen, falls dies für eine bessere Aufgabenbearbeitung wünschenswert wäre.

Die noch sehr ursprüngliche Idee von Turing, dass ein Computer Lernprozesse analog dem der Menschen durchlaufen könnte, inklusive Belohnung und Bestrafung, wurde seitdem auf vielfältige Weise weiter entwickelt. Eine moderne Form dieser Idee hat unter dem Namen ’Reinforcement Learning’ sehr viele Bereiche der künstlichen Intelligenzforschung erobert (vgl. Sutton und Barto (1998) [SB98]).

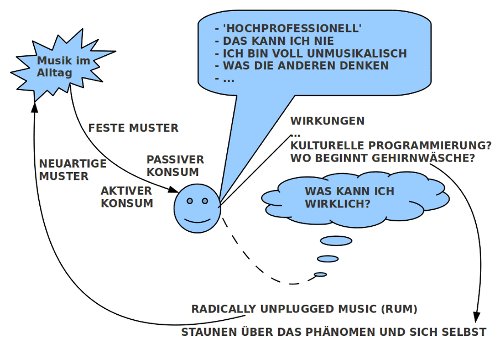

G. KI und Werte

Für die Aufgabenstellung einer ’lernenden Intelligenz’ spielen ’Werte’ im Sinne von ’Verhaltenspräferenzen’ eine zentrale Rolle. Ein Gebiet in der KI-Forschung, in dem diese Thematik sehr intensiv behandelt wird, ist der Bereich der ’Entwicklungs-Robotik’ (Engl.:’developmental robotics’). In diesem Bereich wurde u.a. die Thematik untersucht (vgl. Kathryn Merrick(2017) [Mer17]), wie ein Roboter ’von sich aus’, ohne direkte Befehle, seine Umgebung und sich selbst ’erforschen’ und aufgrund dieses Lernens sein Verhalten ausrichten kann. Dabei zeigt sich, dass reine Aktivierungsmechanismen, die im Prinzip nur die Neugierde für ’Neues’ unterstützen, nicht ausreichend sind. Außerdem reicht es nicht aus, einen Roboter isoliert zu betrachten, sondern man muss Teams oder ganze Populationen von Robotern betrachten, da letztlich ein ’Wert’ im Sinne einer ’Präferenz’ (eine bevorzugte Verhaltenstendenz) nur etwas nützt, wenn sich alle Mitglieder einer Population daran orientieren wollen. Dies führt zur grundlegenden Frage, was denn eine Population von Robotern gemeinschaftlich als solch einen gemeinsamen ’Wert’ erkennen und akzeptieren soll. Wirklich befriedigende Antworten auf diese grundlegenden Fragen liegen noch nicht vor. Dies hat u.a. damit zu tun, dass die Robotersysteme, die hier untersucht werden, bislang noch zu unterschiedlich sind und dass es auch hier bislang – wie bei der KI-Forschung insgesamt – ein großes Theoriedefizit gibt in der Frage, innerhalb welches theoretischen Rahmens man diese unterschiedlichen Phänomene denn diskutieren soll.

Man kann aber den Ball dieser Forschung einmal aufgreifen und unabhängig von konkreten Realisierungsprozessen die Frage stellen, wie denn überhaupt ein ’Wert’ beschaffen sein müsste, damit eine ganze Population von Robotern sich ’von sich aus’ darauf einlassen würde. Letztlich müsste auch ein Roboter entweder eine ’eingebaute Tendenz’ haben, die ihn dazu drängt, ein bestimmtes Verhalten einem anderen vor zu ziehen, oder aber es müsste eine ’nicht eingebaute Tendenz’ geben, die im Rahmen seiner ’internen Verarbeitungsprozesse’ neue Verhalten identifizieren würde, die ihm im Sinne dieser ’Tendenz’ ’wichtiger’ erscheinen würde als alles andere. Es ist bislang nicht erkennbar, wo eine ’nicht eingebaute Tendenz’ für eine Verhaltensauswahl herkommen könnte. Ein industrieller Hersteller mag zwar solche Werte aufgrund seiner Interessenlage erkennen können, die er dann einem Roboter ’zu verstehen geben würde’, aber dann wäre die Quelle für solch eine ’Initiierung einer Verhaltenstendenz’ ein Mensch.

In der aktuellen Forschungssituation ist von daher als einzige Quelle für nicht angeborene Verhaltenstendenzen bislang nur der Mensch bekannt. Über welche Werte im Falle von sogenannten künstlichen Super-Intelligenzen diese verfügen würden ist noch unklar. Dass künstliche Super-Intelligenzen von sich aus Menschen grundsätzlich ’gut’ und ’erhaltenswert’ finden werden, ist in keiner Weise abzusehen. Die künstlichen Superintelligenzen müssten sich in Wertefragen – wenn überhaupt – eher am Menschen orientieren. Da die bisherige Geschichte der Menschheit zeigt, dass der Mensch selbst zu allen Zeiten eine starke Neigung hat, andere Menschen zu unterdrücken, zu quälen, und zu töten, würde dies für alle Menschen, die nicht über künstliche Superintelligenzen verfügen, tendenziell sehr gefährlich sein. Ihr ’Opferstatus’ wäre eine sehr große Versuchung für die jeweilige technologische Macht.

III. WER SIND WIR MENSCHEN?

Wenn Menschen sich in der KI wie in einem Spiegelbetrachten, dann kann dies für den betrachtenden Menschen viele Fragen aufwerfen. Zunächst erfinden die Menschen mit dem Computer einen Typ von intelligenter Maschine, die zunehmend den Eindruck erweckt, dass sich die Menschen in solchen Maschinen vervielfältigen (und möglicherweise noch übertreffen) können. Dann benutzen sie diese Computer dazu, die Strukturen des menschlichen Körpers immer tiefer zu erforschen, bis hin zu den Zellen und dort bis in die Tiefen der molekularen Strukturen, um z.B. unsere Gene zu erforschen, unser Erbmaterial, und zwar so weitgehend, dass wir dieses Erbmaterial gezielt verändern können. Die Menschen verstehen zwar noch nicht in vollem Umfang die möglichen Wirkungen der verschiedenen Änderungen, aber es ist möglich, real Änderungen vorzunehmen, um auszuprobieren, ’was dann passiert’? Mit Hilfe des Computers beginnt der Mensch, seinen eigenen Bauplan, sein eigenes genetisches Programm, umzubauen.

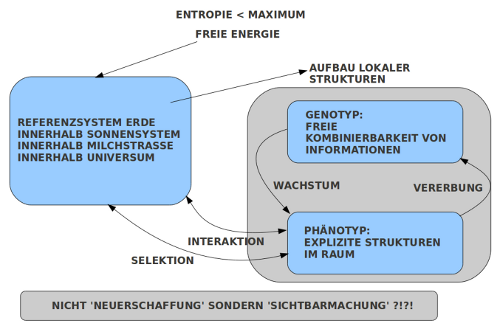

Dazu kommt, dass die Menschen seit dem19.Jahrhundert mit der modernen Biologiewissen können, dass die vielfältigen Formen des biologischen Lebens zu einem bestimmten Zeitpunkt immer das Ergebnis von langen vorausgehenden Entwicklungsprozessen sind. Das Wachsen und Sterben von Organismen gründet jeweils in einer befruchteten Zelle, für die durch das Erbmaterial festgelegt ist, wie sie sich weiter vermehrt und wie sich Millionen, Milliarden und gar Billionen von Zellen zu komplexen Formen zusammen finden. Und bei der Vervielfältigung von Zellen können Änderungen, Abweichungen vom ursprünglichen Plan auftreten, die über viele Tausende und Millionen von Jahren zu deutlichen Änderungen im Bau und Verhalten eines Organismus führen können. Die Biologen sprechen von ’Evolution’. Eine Erkenntnis aus diesem Evolutionsprozess war (und ist), dass wir Menschen, so, wie wir heute da sind, auch solche evolutionär gewordene biologische Strukturen sind, die Vorläufer hatten, die mit uns heutigen Menschen immer weniger zu tun hatten, je weiter wir in der Zeit zurückgehen. Wer sind wir also?

Die Frage, ob Computer als intelligente Maschinen genau so gut wie Menschen werden können, oder gar noch besser, läuft auf die Frage hinaus, ob der Mensch Eigenschaften besitzt, die sich generell nicht durch einen Computer realisieren lassen.

Die moderne Psychologie und die modernen Neurowissenschaften haben bislang nichts zutage fördern können, was sich einem ingenieurmäßigen Nachbau entziehen könnte. Auch wenn es sich hierbei nicht um einen ’strengen Beweise’ handelt, so kann dieser Anschein einer generellen ’maschinelle Reproduzierbarkeit’ des Menschen in Gestalt von intelligenten Maschinen das bisherige Selbstverständnis von uns Menschen stark verunsichern.

IV. GLAUBEN AN GOTT

A. In allen Himmelsrichtungen

Aus der Geschichte der letzten Jahrtausende wissen wir, dass es zu allen Zeiten und in allen Kulturen Religionen gegeben hat. Die größten sind wohl (bis heute) der Hinduismus, der Buddhismus, das Judentum mit dem Christentum, und der Islam. So verschieden diese zu verschiedenen Zeiten und in verschiedenen Regionen äußerlich erscheinen mögen, sie verbindet alle das tiefe Fühlen und Glauben von Menschen an einen über-persönlichen Sinn, der Glaube an ein höheres Wesen, das zwar unterschiedliche Namen hat (’Gott’, ’Deus’, ’Theos’, ’Jahwe’, ’Allah’ …), aber – möglicherweise – vielleicht nur ein einziges ist.

B. Jüdisch-Christlich

So verschieden die christlichen Bekenntnisse der Gegenwart auch sein mögen, was die Anfänge angeht beziehen sich noch immer alle auf die Bibel, und hier, für die Anfänge der Geschichte auf das Alte Testament.(Anmerkung: Für eine deutsche Übersetzung siehe die Katholisch-Evangelische Einheitsübersetzung [BB81]).

Wie uns die modernen Bibelwissenschaften lehren, blickt der Text des Alten Testaments auf eine vielfältige Entstehungsgeschichte zurück. (Anmerkung: Für eine Einführung siehe Zenger et.al (1998) [ZO98]). Nicht nur, dass der Übergang von der mündlichen zur schriftlichen Überlieferung sich im Zeitraum von ca. -700 bis ca.+200 abgespielt hat, auch die redaktionelle Erzeugung verweist auf sehr viele unterschiedliche Traditionen, die nebeneinander existiert und die zu unterschiedlichen Varianten geführt haben. Auch die Kanonbildung dauerte dann nochmals viele hundert Jahre mit dem Ergebnis, dass es schwer ist, von dem einen Urtext zu sprechen. Für jene Menschen, die vorzugsweise Halt an etwas Konkretem, Festen suchen, mag dieses Bild der Überlieferung der Texte des alten Testaments beunruhigend wirken. Wird hier nicht vieles relativiert? Kann man denn da noch von einem ’Wort Gottes an die Menschen’ sprechen? Diese Furcht ist unbegründet, im Gegenteil.

C. Neues Weltbild

Wenn wir Menschen heute lernen (dürfen!), wie unsere individuelle, konkrete Existenz eingebettet ist in einen geradezu atemberaubenden Prozess der Entstehung der bekannten Lebensformen über viele Milliarden Jahre, wie unser eigener Körper ein unfassbares Gesamtkunstwerk von ca. 37 Billionen (10^12 !) Körperzellen in Kooperation mit ca. 100 Bio Bakterien im Körper und ca. 220 Mrd. Zellen auf der Haut ist, die in jedem Moment auf vielfältige Weise miteinander reden, um uns die bekannten Funktionen des Körpers zur Verfügung zu stellen, dann deutet unsere reale Existenz aus sich heraus hin auf größere Zusammenhänge, in denen wir vorkommen, durch die wir sind, was wir sind. Und zugleich ist es die Erfahrung einer Dynamik, die das Ganze des biologischen Lebens auf der Erde in einem ebenfalls sich entwickelnden Universum umfasst und antreibt. Wenn wir verstehen wollen, wer wir sind, dann müssen wir diesen ganzen Prozess verstehen lernen.

Wenn wir uns dies alles vor Augen halten, dann können uns die Texte des alten Testaments sehr nahe kommen. Denn diese Texte manifestieren durch ihre Vielfalt und ihre Entstehungsgeschichte über viele Jahrhunderte genau auch diese Dynamik, die das Leben auszeichnet.

D. Schöpfungsberichte

Claus Westermann, ein evangelischer Theologe und Pfarrer, leider schon verstorben, hat uns einen Kommentar zum Buch Genesis hinterlassen und eine Interpretation der beiden biblischen Schöpfungsberichte, der jedem, der will, aufzeigen kann, wie nah diese alten Texte uns heute noch sein können, vielleicht viel näher als je zuvor. (Anmerkung: Neben seinen beiden wissenschaftlichen Kommentaren aus den Jahren 1972 und 1975 hat er schon 1971 ein kleines Büchlein geschrieben, in dem er seine Forschungsergebnisse in einer wunderbar lesbaren Form zusammengefasst hat (siehe: [Wes76]).

Der erste der beiden Schöpfungstexte in Gen 1,1-2,4a ist der jüngere der beiden; seine Entstehung wird auf die Zeit 6.-5.Jh vor Christus angesetzt, der zweite Schöpfungstext in Gen 2,4b – 24 wird mit seiner Entstehung im 10.-9.Jh vor Christus verortet. Der jüngere wird einer Überlieferungsschicht zugeordnet, die als ’Priesterschrift’ bezeichnet wird, die einen großen Bogen spannt von der Entstehung der Welt mit vielen Stationen bis hin zu einem neuen Bund zwischen Menschen und Gott. Dieser erste Schöpfungsbericht, bekannt durch sein 7-Tage-Schema, steht im Übergang von sehr, sehr vielen Traditionen mythischer Berichte über Schöpfung in den umliegenden Kulturen, Traditionen, die selbst viele Jahrhunderte an Entstehungszeit vorweisen können. Von daher wundert es nicht, wenn sich einzelne Worte, Motive, Bilder, die auch im 7-Tage-Schema auftauchen, Parallelen haben in anderen Schöpfungsgeschichten. Interessant ist das, was die biblische Schöpfungsgeschichte der Priesterschrift anders macht als die anderen bekannten Geschichten es tun.

E. Menschen als Ebenbild

Die zentrale Aussage im neueren Schöpfungsbericht ist nicht, wie im älteren Text, wie Gott den Menschen geschaffen hat, sondern die Aussage, dass er den Menschen nach seinem Bilde geschaffen hat, und dass er dem Menschen eine Verantwortung übertragen hat. In der schon zu dieser Zeit bekannten Vielgestaltigkeit der Welt, ihrer vielen Werdeprozesse, war die zentrale Einsicht und damit verbunden der Glaube, dass der Mensch als ganzer (nicht eine einzelne Gruppe, kein bestimmter Stamm, kein bestimmtes Volk!) über die konkrete, reale Existenz hinausweisend mit Gott verbunden ist als seinem Schöpfer, der auch ansonsten alles geschaffen hat: die Gestirne sind keine Götter, wie in vielen anderen älteren Mythen. Die Menschen sind nicht dazu da, niedere Arbeiten für Gott zu machen, wie in anderen Mythen. Die Menschen werden vielmehr gesehen als in einem besonderen Status im Gesamt der Existenz in der Geschichte, mit einer Verantwortung für das Ganze.

Und diese besondere Stellung des Menschen wird nicht festgemacht an besonderen körperlichen und geistigen Eigenschaften; schon zu dieser Zeit wussten die Autoren der Priesterschrift, wie vielfältig die Lebensformen, ja der konkrete Mensch, sein kann. Wenn wir heute durch die Wissenschaften lernen können, wie der Mensch sich im größeren Ganzen eines biologischen Werdens einsortieren lässt, wie der Mensch selbst durch seine Kultur, seine Technologie in der Lage und bereit ist, sich selbst in allen Bereichen– einschließlich seines biologischen Körpers – zu verändern, dann steht dies in keiner Weise im Gegensatz zu der globalen Sicht des biblischen Schöpfungsberichts. Im Gegenteil, man kann das Gefühl bekommen, das sich in unserer Gegenwart die Weite des biblischen Texte mit den neuen Weiten der Erkenntnisse über Mensch und Universum neu begegnen können. Was allerdings heute auffällig ist, wie viele Menschen sich schwer tun, in diesen neuen primär wissenschaftlichen Weltsichten den Glauben an einen Gott, einen Schöpfer, an eine Geschichtsübergreifende Beziehung zu einem Schöpfer aufrecht zu erhalten. Ist dies heute nicht mehr möglich?

F. Frömmigkeit – Spiritualität

An dieser Stelle sollte man sich vergegenwärtigen, dass zu allen Zeiten die Menschen in ihrer Religiosität nie nur ’gedacht’ haben, nie nur ’mit Bildern’ der Welt oder Gottes umgegangen sind. Zu allen Zeiten gab es – und gibt es noch heute – auch das, was man ’Frömmigkeit’ nennt, ’Spiritualität’, jenes sehr persönliche, individuelle sich einem Gott gegenüber ’innerlich Vorfinden‘, ’Ausrichten’, ’Fühlen’, ’Erleben’. Es ist nicht leicht, dafür die richtigen Worte zu finden, da es nun einmal ’innere’ Prozesse sind, die sich nicht wie Gegenstände vorweisen lassen können. Sie betreffen das grundsätzliche Erleben eines Menschen, ein inneres Suchen, ein Erfahren, ein Erfülltsein (oder auch Leersein), das, was viele Menschen ermöglicht, ihr Leben in einer anderen, neuen Weise zu gestalten, sich zu ändern, anders mit Gefahren und Leiden umzugehen. In den Bildern des Alltags ’mehr’ sehen zu können als ohne dieses innere Erleben, Gestimmt sein.

In einer interessanten Untersuchung hat der britische Philosoph Walter Terence Stace die spirituellen Zeugnisse von vielen Jahrtausenden in unterschiedlichen Kulturen philosophisch untersucht (vgl. [Sta60]). Er kommt zu dem Ergebnis, dass sich trotz aller Verschiedenheiten im Äußeren, auch bei bestimmten Interpretationen, im Kern des Erlebens, des Wahrnehmens, sofern man dieses überhaupt von möglichen Interpretationen trennen lässt, erstaunliche Übereinstimmungen erkennen kann. Er folgert daraus, dass diese Fähigkeit von Menschen, einen übergreifenden Sinn direkt, existentiell erfahren zu können, möglicherweise auf eine sehr grundsätzliche Eigenschaft aller Menschen verweist, die wir einfach haben, weil wir Menschen sind. (Anmerkung: Er schließt auch nicht aus, dass alles Lebendige, von dem wir Menschen ja nur ein Teil sind, an dieser grundsätzlichen Fähigkeit einen Anteil haben könnte, wenn auch möglicherweise verschieden von der Art, wie wir Menschen erleben können.)

Die Tiefe und Weite der Sicht des jüngeren Schöpfungsberichts im Buch Genesis würde einem solchen grundlegenden Sachverhalt gut entsprechen: das Bild vom Menschen als Ebenbild Gottes schließt eine besondere Verbundenheit nicht aus; das ist das, was nach Westermann dem Menschen seine besondere Würde verleiht, diese Beziehung, nicht sein aktuelles konkretes So-sein, das sich ändern kann, ist die zentrale Botschaft.

G. Mensch, KI, Glaube an Gott

Damit beginnt sich der Kreis zu schließen. Wenn die Besonderheit des Menschen, seine zeitübergreifende Würde, in dieser grundlegenden Beziehung zu einem Schöpfergott gründet, die sich vielfältig im Gesamt des Universums und Lebens manifestiert, speziell auch in einer Form von individueller Spiritualität, dann gewinnt die Frage nach der Zukunft von Mensch und intelligenten Maschinen noch eine neue Nuance.

Bislang wird von den Vertretern einer Zukunft ohne Menschen nur noch mit intelligenten Maschinen einseitig abgehoben auf die größere Rechenkraft und die größeren Speicher, die alles erklären sollen. In diesem Beitrag wurde darauf hingewiesen, dass selbst die einfachsten Formen des Lernens ohne ’Werte’ im Sinne von ’Präferenzen’, von ’Bevorzugung von Handlungsalternativen’, ins Leere laufen. Sogenannte ’angeborene’ Präferenzen (oder eingebaute) können nur einen sehr begrenzten Nutzen vermitteln, da sich die Handlungsgegebenheiten und die gesamte Welt beständig weiter verändern. Auch die teilweise sehr komplexen Wertfindungen im sozialen-kulturellen Kontext ganzer Populationen, die von den künstlichen Intelligenzen dieser Welt noch nicht mal ansatzweise beherrscht werden, sind nur von begrenztem Wert, wie die bisherige Kulturgeschichte der Menschen eindrücklich belegt. [Mai95]

Vor diesem Hintergrund ist aktuell nicht zu sehen, wie intelligente Maschinen in der Zukunft alleine zu irgendwelchen brauchbaren Präferenzen kommen können. [SB98][Mer17][Nil10][NS76][RN10][Sta60][Tur37] Ungeklärt ist aktuell allerdings, ob und wieweit der Mensch – also jeder von uns – im Wechselspiel von philosophisch-empirischer Welterkenntnis und Spiritualität jene großen Richtungen ermitteln kann, die für die kommende komplexe Zukunft gefordert wird?

Sollte die Existenz eines Schöpfergottes über Welterkenntnis und Spiritualität wichtig sein für ein weiteres erfolgreiches Fortschreiten, dann hätten intelligente Maschinen möglicherweise ein grundsätzliches Problem. Es sei denn, auch sie könnten Gott erfahren? Einfacher wäre es, wenn Mensch und Maschine ihre aktuelle Koexistenz zu einer intensiveren Symbiose ausbauen würden. Dies würde viele sehr spannende Perspektiven bieten. Der Glaube an einen Schöpfergott ist auch heute, nach allem, was wir jetzt wissen können, keineswegs unsinnig;er erweist sich sogar – rein rational – als scheinbar dringend notwendig. Andererseits ist ein lebendiger Glaube kein Automatismus, sondern erfordert von jedem Menschen sein sehr persönliches Engagement in Verbundenheit mit dem ganzen Leben in einem dynamischen Universum. Gott erscheint hier nicht als das Hindernis, eher unsere Verweigerungen, das Ganze anzuschauen und zu akzeptieren.

QUELLEN

[*] G.Doeben-Henisch, Künstliche Intelligenz und der Glaube an Gott, In: Brennpunkt Gemeinde 70 (Aug./Sept. 2017), Studienbrief R21, 14 S., Hg. AMD Arbeitsgemeinschaft Missionarische Dienste im Verbund der Diakonie, Neukirchener Verlagsgesellschaft mbH, 47497 Neukirchen-Vluyn

[AJL + 15] B. Alberts, A. Johnson, J. Lewis, D. Morgan, M. Raff,

K. Roberts, and P. Walter. Molecular Biology of the Cell.

Garland Science, Taylor & Francis Group, LLC, Abington

(UK) – New York, 6 edition, 2015.

[BB81] Katholisches Bibelwerk and Deutsche Bibelgesellschaft. Die

Heilige Schrift. Einheitsübersetzung. Verlag Katholisches

Bibelwerk & Deutsche Bibelgesellschaft, Stuttgart, 1 edition, 1981.

[Bos14] Nick Bostrom. Superintelligence. Paths, Dangers, Strategies.

Oxford University Press, Oxford (UK), 1 edition, 2014.

[Hod83] Andrew Hodges. Alan Turing, Enigma. Springer Verlag, Wien

– New York, 1 edition, 1983.

[M.87] Turing Alan M. Intelligente maschinen. In Bernhard Dotzler

and Friedrich Kittler, editors, Alan M. Turing. Intelligence

Service, pages 81 – 113. Brinkmann & Bose, Berlin, 1987.

[Mai95] Klaus Mainzer. Computer – Neue Flügel des Geistes? Die

Evolution computergestützter Technik, Wissenschaft, Kultur

und Philosophie. Walter de Gruyter, Berlin – New York, 1th edition, 1995.

[Mer17] Kathrin Merrick. Value systems for developmental cognitive

robotics: A survey. Cognitive Systems Research, 41:38–55, 2017.

[Nil10] Nils J. Nilsson, editor. The Quest for Artificial Intelligence. A

History of Idesas and Achievements. Cambridge University

Press, New York, 2010.

[NS76] Allen Newell and Herbert A. Simon. Computer science as

empirical inquiry: Symbols and search. Communications of

the ACM, 19(3):113–126, 1976.

[RN10] Stuart J. Russell and Peter Norvig. Artificial Intelligence: A

Modern Approach. Prentice Hall, Inc., Upper Saddle River, 2010.

[SB98] Richard S. Sutton and Andrew G. Barto. Reinforcement

Learning. An Introduction. The MIT Press, Ambridge (MA) –

London, 1 edition, 1998.

[Sta60]W.T. Stace. Mysticism and Philosophy. Jeremy P.Tarcher,

Inc., Los Angeles, 1 edition, 1960. (Eine Diskussion hier im Blog findet sich HIER).

[Tur37] Alan M. Turing. Corrections to: On computable numbers, with

an application to the entscheidungsproblem. Proceedings of

the London Mathematical Society, 43:544–546, 1937.

[Tur50] Alan Turing. Computing machinery and intelligence. Mind,

59:433–460, 1950.

[Tur 7] Alan M. Turing. On computable numbers, with an application

to the entscheidungsproblem. Proceedings of the London

Mathematical Society, 42(2):230–265, 1936-7.

[Wes76] Claus Westermann. Schöpfung. Kreuz-Verlag, Stuttgart –

Berlin, 2 edition, 1976.

[ZO98] Erich Zenger and Others. Einleitung in das Alte Testament.

W.Kohlhammer, Stuttgart, 3rd edition, 1998

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.