Vorheriger Beitrag Teil 5

Letzte Änderungen: 15.April 2013, 09:30h

WARNUNG – SPEKULATIV

1. Auf den Seiten 197-229 versucht Kauffman, die Besonderheiten des Phänomens ‚Geist‘ mit den Denkmodellen der Quantenphysik zu reflektieren. Und er warnt seine Leser, dass dieses Kapitel seines Buches vermutlich die wissenschaftlich unsicherste Passage im ganzen Buch sei.(vgl.S.197, 222). Auch macht er darauf aufmerksam, dass es mit Roger Penrose schon andere gab, die Ähnliches zu denken versucht haben.

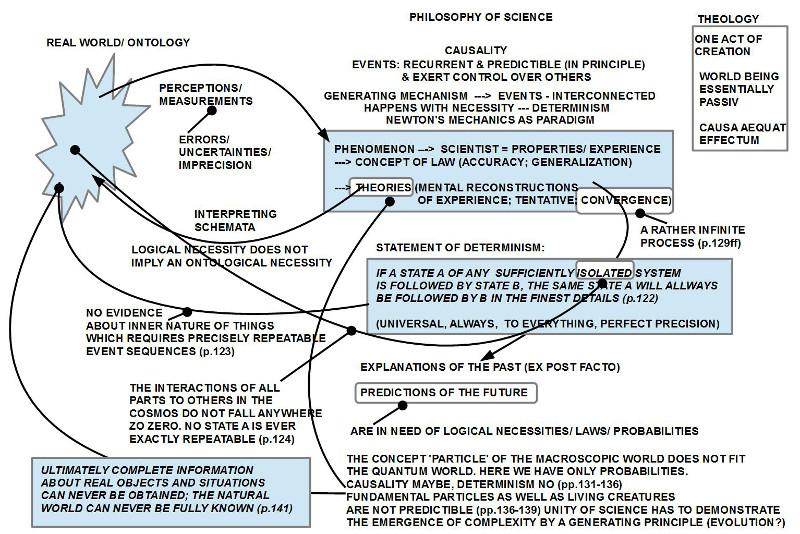

2. [Anmerkung: Wer den Beitrag über Penrose in der englischen Wikipedia liest, wird feststellen, dass Penrose und seine Partner Hameroff in ihrer Hypothesenbildung sehr weit gehen und damit eine eigenständige Diskussion auf internationaler Ebene ausgelöst haben. Im Kontext ‚Quantenphysik‘ und ‚Bewusstsein/ Geist‘ wird auch Niels Bohr erwähnt sowie Eugen Wigner. Bei letzterem ist der Zusammenhang offensichtlich; bei Planck konnte ich es noch nicht verifizieren.]

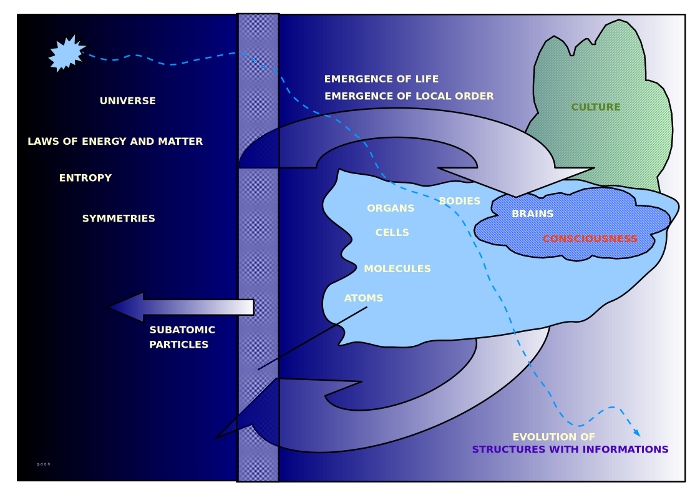

NEUROWISSENSCHAFTEN ‚KLASSISCH‘

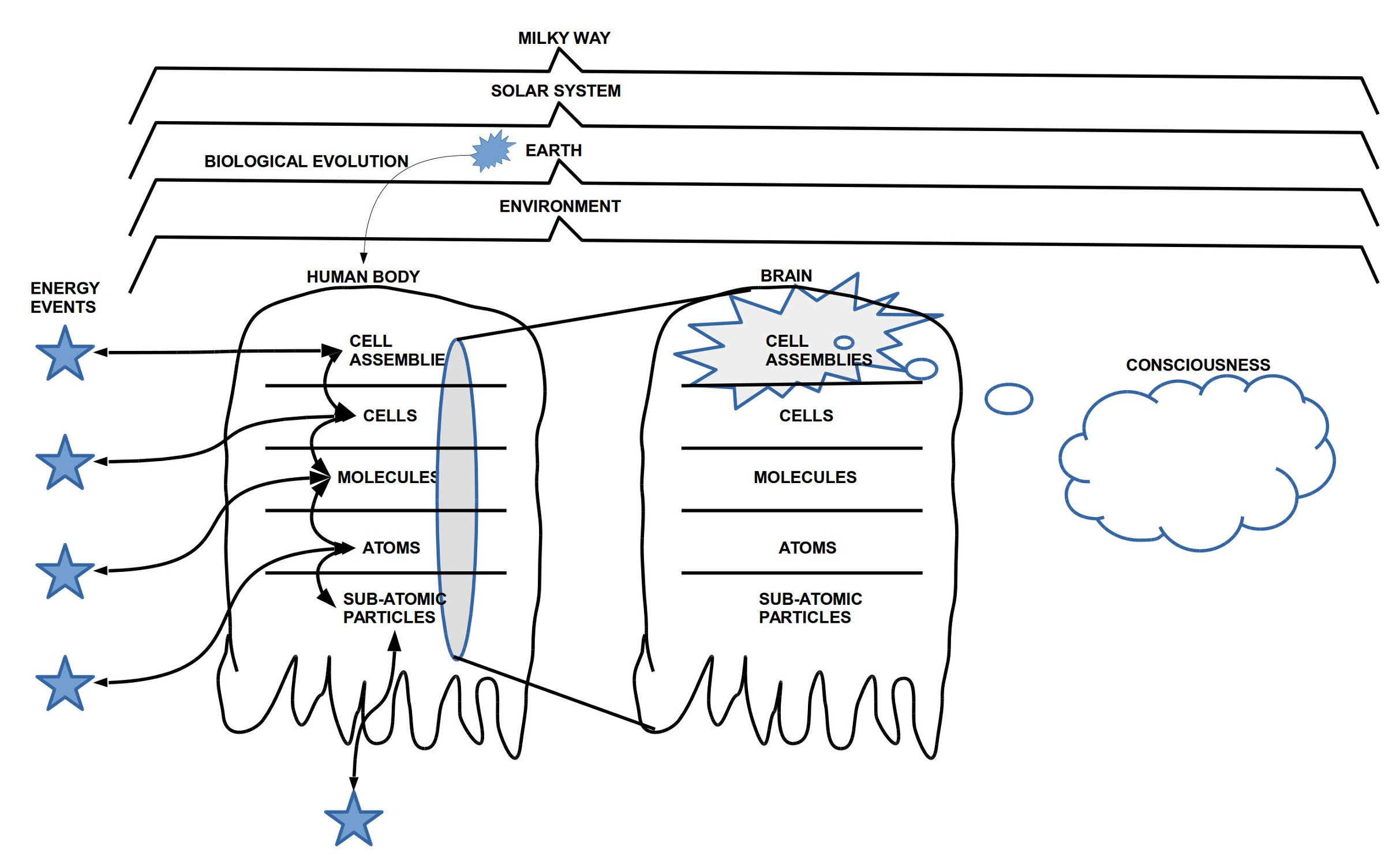

3. Ausgangspunkt für dieses Kapitel ist die Position der Neurowissenschaftler, so wie Kauffman sie sieht: sie nehmen das Gehirn als eine Ansammlung von Neuronen, die untereinander auf biochemische Weise im nicht-quantenphysikalischen Sinne kausal verknüpft sind; dies entspricht einem geschlossenen Raum kausaler Verknüpfung, in dem es zu jedem Ereignis eine erschöpfende Ursache gibt. Das, was wir im Alltag ‚Geist‘, ‚Bewusstsein‘ (inklusive ‚freiem Willen‘) nennen, ist in diesem Modell eine Eigenschaft dieser kausalen Maschinerie. Daraus ergibt sich dann, dass das ‚Bewusstsein‘ nicht diese kausale Maschinerie beeinflusst, sondern die kausale Maschinerie erzeugt die Phänomene des Bewusstseins bzw. das Bewusstsein überhaupt. Einen freien Willen gibt es in diesem Szenario daher nicht. Dies bedeutet, dass die einzelnen Menschen nicht moralisch verantwortlich sein können für das, was sie tun.(vgl. S.197f)

KEIN ABSOLUTER KAUSALER RAUM

4. Dieses sehr einfache, deterministische Bild vorausgesetzt [Anmerkung: was selbst ohne Quantenphysik m.E. so kaum haltbar ist] spekuliert Kauffman, welche neuen Perspektiven sich ergeben würden, wenn man die quantenphysikalischen Grundlagen aller Makrophänomene ernst nehmen würde. Da der quantenphysikalische Raum grundsätzlich ‚akausal‘ ist, würden letztlich alle ’scheinbar kausalen‘ Prozesse sich in einem umfassenden ‚akausalen Rauschen‘ auflösen. Letztlich wäre gar nichts mehr ‚kausal‘. Ob daraus tatsächlich etwas ‚Konstruktives‘ folgen würde, lässt Kauffman offen, aber zumindest wäre die vereinfachende ‚Abschliessung‘ aller interessanten empirischen Phänomene in einer deterministischen Feinstruktur aufgebrochen.(vgl. S.199)

5. [Anmerkung: Dass die bloße Annahme eines akausalen quantenphysikalischen Raumes als ‚Grundlage für alles‘ in gewisser Weise noch nichts erklärt, kann man an der Tatsache erkennen, dass nahezu alles, was das menschliche Weltbild ausmacht, auf ‚Regelmäßigkeiten‘ basiert, die sich vom allgemeinen ‚Rauschen‘ abheben. Dies bedeutet, dass der akausale quantenphysikalische Raum ‚als solcher‘ von sich aus nicht automatisch Erklärungen liefert, er bietet nur einen ‚Ausgangspunkt‘ für mögliche Erklärungen ‚regelmäßiger‘ Phänomene, die wir in diesem Zusammenhang als ‚emergent‘ begreifen, d.h. als Phänomene, die im akausalen quantenphysikalischen Raum ‚gründen‘, die aber in ihrem Zusammenhang und ihrer Komplexität Eigenschaften des quantenphysikalischen Raumes sichtbar machen, die allein aus seinen ‚Bestandteilen‘ nicht so ohne weiteres abgeleitet werden können. ]

IDENTITÄTSTHEORIE UND SO

6. Kaufmann zitiert in diesem Kontext beiläufig noch die Positionen der ‚Identitätstheorie‘, des ‚Dualismus‘, den ‚radikalen Idealismus eines Berkeley, zwei Sprachphilosophen Ryle und Searl, sowie zwei neuere Philosophen Flanagan und Churchland.

7. Zentral erscheint mir seine Bemerkung, dass das Faktum der ‚Bewusstheit als solcher‘ (‚awareness itself‘) unabhängig von allen angebotenen Interpretationsmodellen das primäre Phänomen darstellt, das es zu erklären und zu gewichten gilt. Die persönliche Erfahrung jedes einzelnen ist ‚privat‘ im strengsten Sinne; niemand anderes kann sie einsehen. Und was immer wir uns an Erklärungsmodellen erarbeiten, sie alle setzen diese Privatheit des subjektiven Erlebens als primäre Basis voraus.(vgl. S.199)

8. Kauffman zitiert Descartes in diesem Kontext als jener Philosoph, der das Selbstbewusstsein in Form eines sich gewissen Denkens als primären, einzig nicht bezweifelbaren Punkt aller Erkenntnis angenommen hatte Descartes (1596-1650). In seinen weiteren Reflexionen und Analysen hatte Descartes dann die Konkretheit, Veränderlichkeit und Zufälligkeit des Körpers, der ganzen Körperwelt und der darauf aufbauenden Wahrnehmung als ontologisch verschieden zu der Klarheit, Allgemeingültigkeit und Zuverlässigkeit des Denkens zum Ausgangspunkt genommen für das Postulat, dass das Denken einer anderen Substanz als jener der veränderlichen Körperwelt zugehöre. Daraus ergab sich für ihn eine Art ‚Dualismus‘ des Veränderlichen gegenüber dem Unveränderlichen. Diese Dualismus-Hypothese brachte eine Reihe von Denkproblemen mit sich.(vgl.S.199)

9. Aufgrund der fortschreitenden Erkenntnisse, wie der Körper, speziell das Nervensystem und hier das Gehirn, funktionieren, hat sich heute vielfach die Hypothese von der ‚Identität von Gehirn und Geist‘ durchgesetzt (hier als Oberbegriff für die verschiedenen Spielarten einer Gehirn-Geist-Identätstheorie. Diese Identitätstheorie schließt die Dualismus-Hypothese von Descartes aus. Kauffman sagt, dass er diese Gehirn-Geist-Identitätstheorie übernimmt, sie aber dann mit dem quantenphysikalischen Modell vereinen möchte.(vgl.S.199) In diesem Kontext sollte man auch die klassische Neurobiologie nennen, für die Kauffman als Vertreter Christof Koch zitiert. Diese nimmt an, dass es zu allen Phänomenen des Bewusstseins entsprechende neuronale Strukturen und Prozesse gibt, die kausal verantwortlich sind für das Auftreten der bewussten Ereignisse. Im Detail stellen sich hier eine Menge von ungelösten Fragen. Auch kann man von den neurologischen Daten D_nn in keiner Weise direkt auf Phänomene (= Ereignisse des individuellen Bewusstseins) D_ph schliessen. Ein geeigneter theoretischer Rahmen fehlt. (vgl. S.202f)

10. [Anmerkung: Wie schon verschiedentlich in diesem Blog angemerkt, ist die Bezeichnung ‚Geist-Identitätstheorie‘ aus philosophischer Sicht mindestens unglücklich in der Wortwahl. Da die Neurowissenschaften empirisch Daten D_nn aus der 3.Person-Perspektive haben, Daten zum Selbstbewusstsein D_ph aber nur in der 1.Person vorliegen, haben wir zwei verschiedene Datenbereiche, die ontologisch vollständig verschieden sind (D_nn cut D_ph = 0). Hier von einer ‚Identität‘ zu reden ist sehr irreführend und sachlich falsch. Denkbar wäre, dass es zu jedem Datenbereich eine Theorie TH(D_nn), TH(D_ph) gibt (bis heute hat dies aber noch niemand geschafft), und sich zwischen den verschiedenen Theorien irgendwelche Abbildungsbeziehungen konstruieren lassen (wer wird der erste sein?). Rein formal hätten wir dann irgendwelche ‚Morphismen‘, deren ontologische Deutungen dennoch keine Identität zulassen würden. Es scheint, dass sich die Philosophen die Sache mit der Identitätstheorie etwas einfach machen. Eine solche korrigierte Formalisierung führt aber weder zurück zu einem Dualismus a la Descartes noch zu einem Idealismus a la George Berkeley (1685-1753). Dies sollte an anderer Stelle weiter diskutiert werden.]

SPRACHNAHE PHILOSOPHIE

11. Kauffman erwähnt auch noch die ’sprachnahen‘ Philosophen Gilbert Ryle (1900 – 1976) und John Searle (1932 – ), die bei ihren Analysen des Verhaltens (einschließlich Sprechens) auf eine Einbeziehung des Begriffs ‚Bewusstsein‘ verzichteten mit der Begründung, dass der Begriff ‚Bewusstsein‘ kaum klar zu fassen sei. Damit wiederholen Sie aber eigentlich nur Positionen von Ludwig Wittgenstein (1889 – 1951), der die Problematik jeglicher sprachlicher Bedeutung zuvor schon in vielfältigen Analysen aufgedeckt hatte.(vgl.S.200)

12. [Anmerkung: entsprechend der allgemeinen Erkenntnistheorie, die den Überlegungen in diesem Blog zugrunde liegen, haben wir es grundsätzlich mit drei heterogenen Datenbereichen zu tun (D_nn, D_ph, D_sr (= Verhalten, 3.Person)), deren saubere Aufarbeitung und Integration in einer umfassenden Theorie bis heute nicht einmal in Ansätzen vorliegt. Es gibt ja nicht einmal Konsensus über die Besonderheit dieser drei Datenbereiche geschweige denn einen Konsens, dass und wie man damit umgehen soll. Diesen Mangel an erkenntnistheoretischem und dann auch wissenschaftstheoretischem Konsens merkt man überall auf Schritt und tritt.]

13. Kauffman erwähnt auch noch die Philosophen Paricia Smith Churchland (1943-) und Owen Flanagan (1949 – ) im Kontext der Diskussionen zur ‚Einheit des Bewusstseins‘. Während das Bewusstsein in der subjektiven Perspektive als ‚eines‘ erscheint deuten die medizinischen Befunde drauf hin, dass sich das Bewusstsein aus vielen Teilleistungen zusammensetzt, die einzeln und partiell verändert werden oder ganz ausfallen können, ohne dass deswegen das subjektive Gefühl eines ‚einzigen einen Bewusstseins‘ verschwindet.(vgl. S.200)

STARKE KI

14. Es wird dann die sogenannte ‚Starke Künstliche Intelligenz-Hypothese‘ erwähnt, die annimmt, dass bei einer genügend großen Anzahl von verknüpften rechnenden Elementen ‚ab einem bestimmten Punkt automatisch‘ ‚Selbstbewusstsein‘ entstehen würde. Als einziges hartes Argument gegen diese Hypothese führt Kauffman die die Hypothese an, dass die starke KI-Hypothese voraussetze, dass diese intelligenz ‚algorithmisch‘ sein müsse und dass nach Kauffman der ‚Geist‘ (‚mind‘) vermutlich niht algorithmisch sei.(vgl. S.201f)

15. [Anmerkung: Die Formulierung der starken KI-Hypothese (’strong artificial intelligence hypothesis‘, ’strong ai-hypothesis‘) geht zurück auf den Philsophen John Searl (s.o.) und ist alles andere als sehr klar. Nicht nur sind die verwendeten Begriffe in sich oft unscharf, sondern – wie die sehr ausufernde Diskussion zeigt – ist die ganze Problemstellung alles andere als klar. Mit einem Satz festzustellen, dass sich das Problem erledigt habe, weil klar sei, dass der ‚Geist‘ nicht algorithmisch sei, stellt daher möglicherweise eine grobe Vereinfachung dar. Abgesehen davon spring Kaufman von dem Begriff ‚Selbstbewusstsein‘ einfach zum Begriff ‚Geist‘ dabei unterstellend, dass beide Begriffe hinreichend ähnlich seien. Das aber ist eine schwierige Frage. Ich sehe keinen einfachen Zusammenhang zwischen beiden Begriffen. ]

SELBSTBEWUSSTSEIN UND QUANTENPHYSIK

16. Den nächsten sehr langen Abschnitt leitet Kauffman ein mit der Bemerkung, dass er und Penrose davon ausgehen, dass das Selbstbewusstsein (‚consciousness‘) von sehr speziellen physikalischen Bedingungen abhängt. [Anmerkung: Eine Assoziation zu Descartes kühner Arbeitshypothese, die denkende Materie (res extensa) mit der kontingenten Materie (res extensa) über die ‚Zirbeldrüse‘ verknüpft zu denken, drängt sich unwillkürlich auf. Descartes wusste nicht wirklich, was dieses ‚Selbstbwusstsein‘ mit dem ‚Ich denke‘ genau ist; es erschien ihm ‚anders‘ als die kontingente materielle Körperwelt. Um diesen logischen Bruch denkerisch zu kitten erfand Descartes die Hypothese mit der Zirbeldrüse. Niemand würde sie heute so nehmen, wie Descartes sich das gedacht hatte. Doch das Vorgehen von Kauffman an dieser Stelle wirkt ähnlich. Bislang konnte er in keiner Weise erklären, was er wirklich mit ‚Selbstbewusstsein‘ oder gar ‚Geist‘ meint. Dennoch entwickelt er eine neue Hypothese, dass bestimmte quantenphysikalische Besonderheiten die Grundlage für eben jenes Unbekannte sein könnten… Rein logisch ersetzt hier die Spekulation über die Quantenphysik den cartesischen Begriff der Zirbeldrüse ohne zu große Aussicht auf mehr Klarheit (allerdings erweitert sich der Raum möglicher Hypothesen natürlich erheblich und ich stimme Kauffman soweit zu, dass jede tatsächlich weiterführende Antwort nur unter Einbeziehung der Quantenphysik funktionieren wird). ](vgl. S.203f)

17. Das leitende ‚Motiv‘ für die Einbeziehung der Quantenphysik ist das schon zuvor mehrfach erwähnte Argument, dass der menschliche Geist (‚mind‘) ’nicht algorithmisch‘ sei, was nach Kauffman nicht impliziert, dass er völlig ‚akausal‘ (‚acausal‘) sei. [Man beachte, das er beständig zwischen den Begriffen ‚Geist‘ (‚mind‘) und ‚Selbstbewusstsein‘ (‚consciousness‘) hin und her springt obgleich beide Begriffe nach meinem Verständnis sehr verschieden sind und beide Begriffe bislang sich jeder Definition weitgehend entziehen. Man könnte stattdessen auch einfach von ‚S‘ und ‚G‘ reden, diese wechselweise vertauschen und davon sprechen, dass sie nicht algorithmisch seien. Die argumentative Luft, in der sich Kauffman hier bewegt, ist sehr dünn geworden. Daneben ist auch die Aussage, ‚G‘ bzw. ‚S‘ sei nicht algorithmisch letztlich kaum zu verstehen. Ist doch mehr oder weniger unklar, was es heißen würde, dass S-G ‚algorithmisch‘ seien (das hatte Kauffman zuvor nicht wirklich erklärt. Aber er hat dafür argumentiert, dass es nicht so sei…).] (vgl. S.204)

18. Die Einbeziehung der Quantenphysik führt zu dem generellen Paradox, dass die Quantenwelt als solche nur aus Wahrscheinlichkeitsverteilungen besteht, die als solche ‚akausal‘ sind, während die ‚reale = makroskopische‘ Welt aktuelle konkrete Instanzen präsentiert, die in bestimmten Perspektiven ‚kausale Muster‘ erkennen lassen.(vgl. S.204f) Kauffman zitiert dann Richard Feynman (1918 – 1988) mit Beispielen, die diese Eigenschaften illustrieren sollen. Der entscheidende Punkt aber ist der Übergang vom unbeschränkten Quantenzustand zu einer ‚Aktualisierung‘, bei der/ in der wichtige Quanteninformationen verlorengehen. Als Erklärungsversuch für diesen Übergang verweist Kauffman auf die Dekohärenztheorie als zur Zeit am meisten akzeptierte theoretische Beschreibung dieser Aktualisierungsphänomene.(vgl. SS.205-208)

19. Es ist genau dieses Dekohärenzphänomen was Kauffman dann aufgreift, um damit die Interaktion zwischen einem ‚quantenphysikalischen kohärentem selbstbewussten Geist (qkSG)‘ und ‚Aktualisierungen in der klassischen physikalischen Welt‘ zu interpretieren.[Anmerkung: War zuvor schon der Status der Begriffe ‚Selbstbewusstsein (S)‘ und ‚Geist (G)‘ je für sich schon unklar, wird diese Unklarheit durch die Kombination ’selbstbewusster Geist (SG)‘ (‚conscious mind‘) nicht unbedingt besser.] Auf jeden Fall ist die Einwirkung dieses qkSG auf die Materie nicht kausal. Andererseits stellt Kauffman fest, dass der Vorgang der Dekohärenz bislang kaum verstanden ist. (vgl. S.208) [Anmerkung: Damit verknüpft sich die unklare Bedeutung von SG mit der Unklarheit der postulierten Dekohärenz. ] Dann setzt Kauffman den bislang kaum fassbaren Begriff qkSG mit der ‚res cogitans‘ von Descartes gleich und die aktualisierte Materie mit der ‚res extensa‘.(vgl. S.209). [Anmerkung: Dies ist eine stimulierende Überlegung, aber wenn vor der Einführung von qkSG schon keine wirkliche Bedeutung für SG – geschweige denn qkSG – verfügbar war, dann führt uns diese Gleichsetzung auch nicht weiter. Descartes hatte keine wirkliche Definition für seine ‚res cogitans‘. Bei ihm war es eine Vermischung von phänomenalen Eigenschaften erweitert um Spekulationen über eine mögliche allgemeine (ideale) Natur des ‚Geistes‘, ein Begriff, der als solcher keine wirkliche Bedeutung besitzt. Möglicherweise könnte man in einer ‚Metatheorie‘ zur Phänomenologie ein paar allgemeinere Begriffe ‚jenseits der Phänomene‘ einführen, ihr ontologischer Status wäre aber unklar. Descartes hat dies nicht getan und ich kenne auch keinen anderen Philosophen, der dies bislang wirklich geschafft hat. Den cartesischen Begriff ‚res cogitans‘ hier zu benutzen täuscht daher eine Bedeutung vor, die es so nicht gibt.]

20. In diesem Kontext führt Kauffman auch den Begriff ‚immateriell‘ (‚immaterial‘) ein und definiert ihn als eine mögliche Eigenschaft im quantenphysikalischen Raum, die ’nicht objektiv real‘ ist. (vgl. S.209)

21. Interessant ist auch das Phänomen, dass ein kohärenter quantenphysikalischer Zustand beim Auftreten von Dekohärenz nicht aufgehoben werden muss. Es gibt Beispiele dafür, dass Dekohärenz auftreten kann und der kohärente Zustand bleibt weiter bestehen bzw. dass es Mechanismen gibt, Kohärenz/ Dekohärenz kontrolliert zu nutzen. Dazu gehören auch neuere Modelle, wie Quanten-Computer funktionieren könnten. (vgl. SS.210-214) Aufgrund eigener Untersuchungen hält Kauffman es für möglich, dass jede Zelle so strukturiert ist, dass kohärente quantenphysikalische Austauschprozesse zwischen den Proteinen möglich sind. (vgl. S.220) Das Phänomen der Qantenverknüpftheit (‚quantum entanglement‘) verweist zusätzlich auf das Phänomen, dass Quanten in beliebiger Entfernung voneinander gemeinsame Eigenschaften haben können. (vgl. S.222)

REDUKTIONISMUS ABGEMILDERT DURCH EMERGENZ

22. Kauffman stellt dann nochmals fest, dass im Falle, dass seine Überlegungen zur Quantennatur des Geistes stimmen würden, also die angenommene Verlagerung des Geistes in den Quantenraum, der über Kohärenz/ Dekohärenz mit dem makroskopischen Raum der Körper interagiert, dass diese Annahme auch eine Art ‚Reduktionismus‘ darstellen würde, einen Reduktionismus, den er zu Beginn seines Buches ja gerade bekämpft hat. Er schwächt dann aber ab, indem er darauf verweist, dass sich aus diesem Reduktionismus von Geist auf quantenphysikalische Strukturen nichts deterministisch ableiten lässt. Nahezu alle Phänomene der biologischen Evolution repräsentieren Strukturen, die sich in dieser Konkretheit aus dem vorausgesetzten quantenphysikalischen Raum nicht voraussagen lassen. (vgl. S.222f)

DIE HARTEN ARGUMENTE GEGEN DEN GEIST HARREN EINER ANTWORT

23. Abschließend zu seinem Kapitel über die Hypothese, den ’selbstbewussten Geist‘ quantenphysikalisch zu interpretieren, listet Kauffman nochmals drei zentrale philosophische Argumente gegen die Annahme eines ‚Geistes‘ als unterschieden vom Gehirn an, die beantwortet sein wollen.

24. Als erstes verweist er nochmals auf den Ephiphänomenalismus, der die geistigen Phänomene als Begleiterscheinungen einer aktiven neuronalen Maschinerie sieht, da es bislang an überzeugenden Argumenten fehlt, die erklären, wie der ‚Geist‘ (für den es als solchen keine überzeugende Beschreibung gibt), auf das Gehirn, auf den Körper einwirken kann.(vgl. S.224) Dazu gehört auch das Problem, dass es völlig unklar sei, wie ‚Geist‘ direkt auf ‚Geist‘ wirken könne ohne Einbeziehung neuronaler Prozesse. (vgl. S.224f) Kauffman verweist darauf, dass, könnte man die Hypothese einer quantenphysikalischen Interpretation eines selbstbewussten Geistes qkSG beweisen, sich diese Probleme auflösen würden, da ein qkSG auf vielfache Weise mit sich selbst interagieren könnte ohne über den Umweg neuronaler Prozesse und doch zugleich auch über Dekohärenz neuronale Prozesse beeinflussen könnte. (vgl. S.225f)

25. Als zweites Problem erwähnt Kauffman das Problem der subjektiven Erfahrung selbst, oft das Problem der Qualia (DE)/ Qualia (EN) genannt. Hier sagt Kauffman, dass es bislang völlig unklar ist, ob und wie eine quantenphysikalische Interpretation von Geist hier neue Interpretationsansätze liefern kann. [Anmerkung: Schaut man in die Wikipediastichworte – sowohl in der deutschsprachigen wie auch in der englischsprachigen Version – nach, wird man schnell feststellen können, dass die Sachlage in diesem Bereich nur als ‚verworren‘ bezeichnet werden kann.] Allerdings bemerkt Kauffman zurecht, dass wir aus der Tatsache, dass momentan noch keiner eine schlüssige Erklärung auf der Basis der Quantenphysk anbieten kann, auch nicht folgt, dass es keine gibt. Aktuell ist nicht auszuschließen, dass es später mal eine brauchbare Erklärung geben kann. (cgl. S.226f)

26. Das dritte und letzte genannte Problem ist das Phänomen des freien Willens (EN)/ freien Willens (DE). Kauffman thematisiert zunächst den Aspekt des ‚Nicht-Determiniert-Seins‘ als einer Forderung an das Gegebensein eines freien Willens. Würde die quantenphysikalische Interpretation stimmen, dann sähe er hier eine Möglichkeit, das Determinismusproblem zu lösen. Bezüglich des zweiten Aspekts der ‚moralischen Verantwortung‘ bleibt er einen Hinweis schuldig. (vgl.S.227f) [Anmerkung: Liest man sich in die Wikipediastichworte ein, so sieht man nicht nur, dass es – wie meistens – zwischen der deutschen und der englischen Version große Unterschiede gibt, sondern wie vielschichtig und damit letztlich unklar das Konzept des freien Willens ist. Generell spielt es in der Alltagskultur der westlichen Länder eine zentrale Rolle, insbesondere im Rechtssystem, aber seine philosophische Behandlung ist alles andere als zufriedenstellend.]

27. Damit ist das Ende der beiden Kapitel über den Geist erreicht. Trotz vieler kritischer Anmerkungen im Detail – eine abschließende Reflexion wird noch folgen – waren dies außerordentlich anregende Kapitel. Für Kauffman war es wichtig, zu zeigen, dass das Phänomen des ‚Selbstbewusstseins‘ [hier lässt er den Begriff ‚Geist‘ wieder mal weg] ein natürliches Phänomen ist, ein genuiner Teil der Evolution, den zu erklären, es keines ‚Schöpfergottes‘ (‚creator god‘) brauche.(vgl. S.229)

28. [Anmerkung: Seinen Schlusssatz, dass man für dies alles keine Annahme über einen ‚Schöpfergott‘ brauche, macht natürlich nur Sinn, wenn man den Begriff ‚Schöpfergott‘ in einer Weise definiert, der den bekannten naturwissenschaftlichen Daten zum evolutionären Prozess widerspricht. Dies muss aber keinesfalls so sein. Denn schon in der jüdisch-christlichen Tradition gibt es ja nicht einen einzigen, klar definierten Gottesbegriff, sondern die vielen verschiedenen Schriften der Bibel zeichnen sehr unterschiedliche Bilder. Dazu kommt, dass nirgends explizit von der Evolution die Rede ist, da ja die Menschen zu den Zeiten, als die Texte der Bibel verfasst worden sind, von all dem nichts wussten. Und die wenigen Texte, die direkt Bezug nehmen auf die Entstehung der bekannten Welt – insbesondere die beiden sogenannten ‚Schöpfungsberichte‘ zu Beginn des Buches Genesis – sind sprachlich und inhaltlich so verschieden (weil sie aus verschiedenen Zeiten von verschiedenen Autoren stammen), dass sich jede weiterreichende Interpretation auf der Basis dieser beiden Texte verbietet. Zumindest in der christlichen Tradition gibt es kein klar definiertes Bild eines Schöpfergottes, das den neueren naturwissenschaftlichen Erkenntnissen entgegen stehen würde (wobei man bedenken sollte, dass sich innerhalb der Wissenschaft die naturwissenschaftlichen Bilder von der Welt mindestens seit Galilei immer wieder und stark verändert haben. Gerade in unserer Zeit durchläuft die Wissenschaft in vielen Bereichen wieder einmal grundlegende Korrekturen, deren Ende noch gar nicht abzusehen sind). Das Wenige, was sich von einem christlichen Gottesbegriff ableiten lässt deutet eher auf eine Art ‚Koevolution von Allem‘ hin, in der dem Leben (speziell dem Menschen?) eine besondere Rolle zugedacht ist. Worin die genau besteht, ist eher unklar und muss von den Handelnden selbst schrittweise ermittelt werden (falls es überhaupt eine mögliche Klärung gibt). Ich habe nicht den Eindruck, dass sich innerhalb des Christentums irgendjemand für diese Klärung des Gesamtzusammenhangs ernsthaft interessiert. Man hört höchstens immer wieder von obskuren Abwehrschlachten von sogenannten ‚Fundamentalisten‘, die offensichtlich ihre eigene Bibel nicht kennen.]

Die Fortsetzung findet sich HIER: Teil 7.

Ein Überblick über alle bisherigen Blogeinträge nach Titeln findet sich HIER