Letzte Änderung: 25.August 2024

Fragender: Gerd Doeben-Henisch

Kontakt: cagent@cognitiveagent.org

KONTEXT

Dieser Text ist Teil einer Sammlung von philosophischen Dialogen mit chatGPT4.

Zusammenfassung

(Kurzfassung)

chatGPT4: Es scheint, dass eine Rückkehr zur Korrespondenztheorie und deren Weiterentwicklung als ein vielversprechender Ansatz für eine robustere Wahrheitstheorie erscheint. Insbesondere die Idee, eine erfahrungsbasierte Theorie zu entwickeln, die die Realität als entscheidendes Kriterium verwendet und gleichzeitig Raum für die Diskussion von Zielen, Präferenzen und Werten bietet, könnte eine umfassende Basis für das Verständnis von Wahrheit in verschiedenen Kontexten schaffen.

DIALOG : WAS IST WAHRHEIT?

Anmerkung: FETTSCHRIFT markiert die Fragen des Autors

Hallo Chat, was fällt Dir ein zum Begriff ‚Wahrheit‘?

Hallo! Der Begriff „Wahrheit“ kann aus vielen Blickwinkeln betrachtet werden, sowohl philosophisch als auch praktisch. Philosophisch gesehen beschäftigt sich die Frage nach der Wahrheit oft mit der Übereinstimmung von Aussagen oder Überzeugungen mit der Realität. Man spricht hier von einer „Korrespondenztheorie der Wahrheit“, nach der eine Aussage dann wahr ist, wenn sie mit den tatsächlichen Gegebenheiten übereinstimmt.

In der alltäglichen Anwendung geht es oft darum, wie Menschen Wahrheit wahrnehmen und kommunizieren. Dabei spielen Ehrlichkeit, Transparenz und Verlässlichkeit eine wichtige Rolle. In verschiedenen Bereichen wie Wissenschaft, Recht und Journalismus ist die Suche nach der Wahrheit zentral und wird durch bestimmte Methoden und Standards unterstützt.

Die Wahrheit ist auch ein zentrales Thema in der Ethik, wo sie mit Fragen der Moral und der richtigen Handlungsweise verbunden wird. Außerdem gibt es auch eine pragmatische Theorie der Wahrheit, die besagt, dass eine Aussage dann wahr ist, wenn sie nützlich und wirksam in der Praxis ist.

Was denkst du über den Begriff? Gibt es einen bestimmten Kontext, in dem du dich besonders für Wahrheit interessierst?

Ich möchte gerne mit der ‚philosophischen Perspektive‘ in den Dialog einsteigen. Du erwähnst die ‚Korrespondenztheorie der Wahrheit‘. Gibt es nicht noch andere philosophische Ansätze zum Begriff ‚Wahrheit‘?

Ja, neben der Korrespondenztheorie der Wahrheit gibt es tatsächlich noch andere philosophische Ansätze, die sich mit dem Konzept der Wahrheit auseinandersetzen. Hier sind drei wichtige Theorien:

1. **Kohärenztheorie der Wahrheit**: Diese Theorie besagt, dass eine Aussage wahr ist, wenn sie kohärent oder stimmig ist mit einem gesamten System von Aussagen oder Überzeugungen. Wahrheit wird hier weniger als Übereinstimmung mit einer objektiven Realität gesehen, sondern mehr als eine Art Konsistenz innerhalb eines bestimmten theoretischen oder belief-Systems.

2. **Pragmatische Theorie der Wahrheit**: Nach dieser Ansicht ist eine Aussage wahr, wenn sie praktisch oder nützlich ist. Die Wahrheit einer Aussage bemisst sich daran, ob sie funktioniert und ob sie nützliche Konsequenzen nach sich zieht. Der amerikanische Philosoph Charles Sanders Peirce und später William James sind bekannte Vertreter dieser Theorie.

3. **Konsensustheorie der Wahrheit**: Diese Theorie, die insbesondere von Jürgen Habermas entwickelt wurde, sieht Wahrheit als Ergebnis eines idealen Diskurses oder eines rationalen Konsenses. Eine Aussage ist demnach wahr, wenn sie die Zustimmung aller Beteiligten in einer idealen Kommunikationssituation erlangen könnte.

Jede dieser Theorien bietet eine unterschiedliche Perspektive auf das, was es bedeutet, dass etwas „wahr“ ist, und sie betonen verschiedene Aspekte des Wahrheitsbegriffs—sei es Übereinstimmung mit der Realität, Kohärenz innerhalb eines Systems, praktische Effizienz oder demokratischer Konsens.

Diese unterschiedlichen Ansätze spiegeln die Vielfältigkeit und die Tiefe der philosophischen Auseinandersetzung mit der Wahrheit wider und zeigen, dass Wahrheit ein vielschichtiges und oft kontrovers diskutiertes Thema ist. Welcher dieser Ansätze spricht dich besonders an oder gibt es bestimmte Aspekte, die du weiter vertiefen möchtest?

Ja, Danke für diese Auffächerung der Frage nach der Bedeutung des Begriffs ‚Wahrheit‘ in diese vier Perspektiven: Korrespondenztheorie als ‚Übereinstimmung mit der Realität‘, Kohärenztheorie als ‚Kohärenz innerhalb eines Systems‘, Pragmatische Theorie als ‚praktische Effizienz‘ oder Konsensustheorie als ‚demokratischer Konsens‘. Ich möchte diese vier Möglichkeiten gerne diskutieren und daraus eine abschließende Bewertung finden, mit der wir weiter diskutieren können.

Das klingt nach einer spannenden und tiefgehenden Diskussion! Lassen Sie uns die vier Theorien weiter untersuchen und ihre jeweiligen Stärken und Schwächen betrachten, um zu einer umfassenden Bewertung zu gelangen.

### 1. Korrespondenztheorie der Wahrheit

**Stärken:**

– Sie bietet einen intuitiv zugänglichen Wahrheitsbegriff, da sie Wahrheit als Übereinstimmung mit der objektiven Realität versteht.

– Sie ist in den Naturwissenschaften besonders nützlich, wo experimentelle Verifizierung und Beobachtung zentral sind.

**Schwächen:**

– Schwierigkeiten ergeben sich bei der Bestimmung, was die „objektive Realität“ ist, besonders in weniger empirisch erfassbaren Bereichen wie der Ethik oder Ästhetik.

– Sie kann zu einem regress ad infinitum führen, da jede Wahrheitsbehauptung eine weitere Verifizierung erfordert.

### 2. Kohärenztheorie der Wahrheit

**Stärken:**

– Sie ist stark in theoretischen oder philosophischen Systemen, wo interne Konsistenz wichtig ist.

– Nützlich in Bereichen, in denen es keine klare empirische Überprüfbarkeit gibt.

**Schwächen:**

– Mehrere in sich kohärente, aber widersprüchliche Theoriensysteme können existieren, was die Frage aufwirft, welches System die Wahrheit repräsentiert.

– Sie hängt stark von den angenommenen Grundlagen des Systems ab und kann somit relativistisch wirken.

### 3. Pragmatische Theorie der Wahrheit

**Stärken:**

– Betont die Bedeutung der Anwendbarkeit und Nützlichkeit von Überzeugungen in der Praxis.

– Fördert einen flexiblen und adaptiven Ansatz zur Wahrheit.

**Schwächen:**

– Nützlichkeit ist nicht notwendigerweise ein Indikator für Wahrheit; etwas kann nützlich sein, ohne wahr zu sein.

– Kann in pragmatischen Kontexten zu einem kurzfristigen Denken führen, das langfristige Wahrheiten vernachlässigt.

### 4. Konsensustheorie der Wahrheit

**Stärken:**

– Fördert demokratische Prozesse und die Beteiligung verschiedener Stimmen bei der Wahrheitsfindung.

– Kann in sozialen und politischen Kontexten effektiv sein, wo Übereinstimmung wichtig ist.

**Schwächen:**

– Konsens garantiert nicht die Wahrheit; historisch gab es viele Beispiele für allgemeinen Konsens über falsche Überzeugungen.

– Kann anfällig für Manipulation und Machtungleichgewichte sein.

### Abschließende Bewertung

Jede Theorie hat ihre Anwendungsbereiche, in denen sie besonders effektiv ist, sowie Grenzen, die ihre Anwendung erschweren. Eine umfassende Betrachtung von Wahrheit könnte Elemente aus allen diesen Theorien integrieren, abhängig vom spezifischen Kontext und Zweck der Wahrheitssuche.

Wenn wir weiter diskutieren, könnten wir überlegen, wie diese Theorien in verschiedenen praktischen Szenarien angewendet werden könnten oder ob eine bestimmte Theorie in einem bestimmten Bereich (z.B. Wissenschaft, Politik, persönliche Überzeugungen) vorzuziehen ist. Was denkst du darüber? Gibt es bestimmte Bereiche oder Fragen, die du besonders beleuchten möchtest?

OK, sortieren wir die Perspektiven aus, die tatsächlich nicht weiter führen. Dazu müssen wir allerdings einen ‚Bezugspunkt‘ definieren, zu dem wir alle vier Perspektiven in Beziehung setzen können, um einen ‚Vergleich‘ zu ermöglichen. Dies wirft die Frage auf: Was haben alle diese vier Perspektiven gemeinsam? Gehst Du mit?

Absolut, das ist ein kluger Ansatz! Um die verschiedenen Theorien der Wahrheit zu vergleichen und eventuell einige auszusortieren, sollten wir zunächst ihre gemeinsamen Bezugspunkte identifizieren. Hier sind einige Kernaspekte, die alle diese Theorien berühren oder in irgendeiner Weise ansprechen:

### Gemeinsame Bezugspunkte der Wahrheitstheorien:

1. **Beziehung zur Realität:** Obwohl die Theorien unterschiedliche Auffassungen davon haben, was „Realität“ bedeutet (objektive Fakten, kohärente Systeme, praktische Ergebnisse oder konsensuelle Übereinkünfte), versuchen sie alle, eine Brücke zwischen Überzeugungen oder Aussagen und irgendeiner Form von „Realität“ zu schlagen.

2. **Verifikation/Validierung:** Jede Theorie hat implizite oder explizite Methoden, um zu überprüfen oder zu validieren, ob eine Aussage als wahr betrachtet werden kann. Dies reicht von empirischen Tests (Korrespondenz) über logische Konsistenzprüfungen (Kohärenz) bis hin zu praktischer Bewährung (Pragmatismus) und sozialem Konsens (Konsensustheorie).

3. **Funktionale Rolle von Wahrheit:** Alle Theorien erkennen an, dass Wahrheit eine funktionale Rolle in verschiedenen menschlichen Aktivitäten spielt, sei es in der Wissenschaft, im Alltag, in der Politik oder in der Moral.

4. **Philosophische Grundannahmen:** Sie basieren alle auf bestimmten philosophischen Annahmen über das Wesen der Wahrheit, des Wissens und der menschlichen Erkenntnis.

### Nächste Schritte:

Mit diesen gemeinsamen Bezugspunkten können wir die Theorien besser vergleichen und bewerten. Wir könnten überlegen, welche dieser Aspekte am wichtigsten sind für die spezifischen Kontexte oder Probleme, die uns interessieren. Zum Beispiel könnten wir fragen:

– Welche Theorie bietet den robustesten Ansatz für die Verifikation von Wahrheit?

– Welche Theorie ist am anpassungsfähigsten an verschiedene Arten von Problemen oder Disziplinen?

– Welche Theorie behandelt am besten die Komplexität der Realität, wie wir sie erfahren?

Durch diese Fragen können wir beginnen, die Stärken und Schwächen jeder Theorie in Bezug auf unsere spezifischen Bedürfnisse und Kontexte zu bewerten. Was denkst du, welcher dieser Aspekte ist der wichtigste für die Diskussionen oder Probleme, die dir am Herzen liegen?

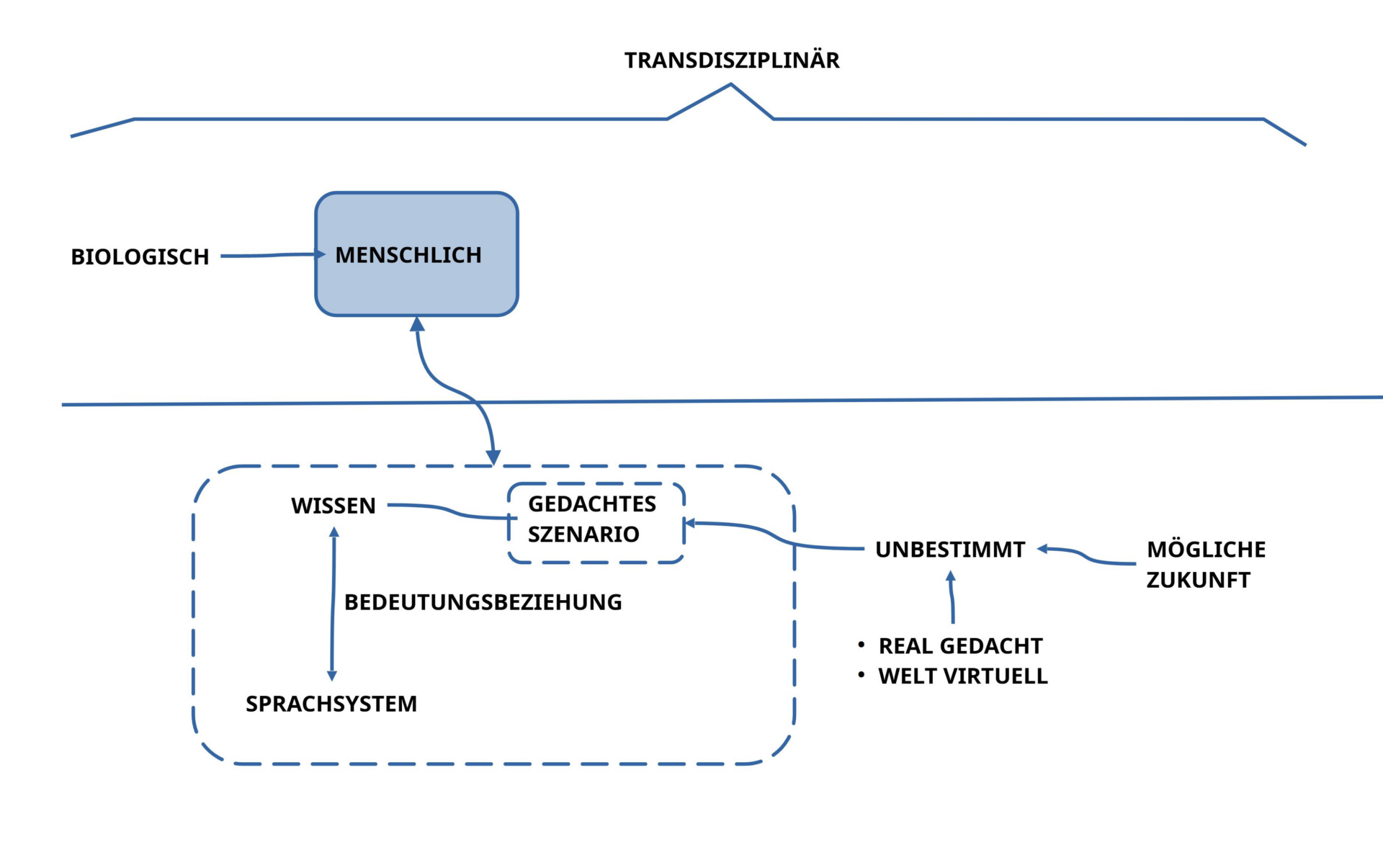

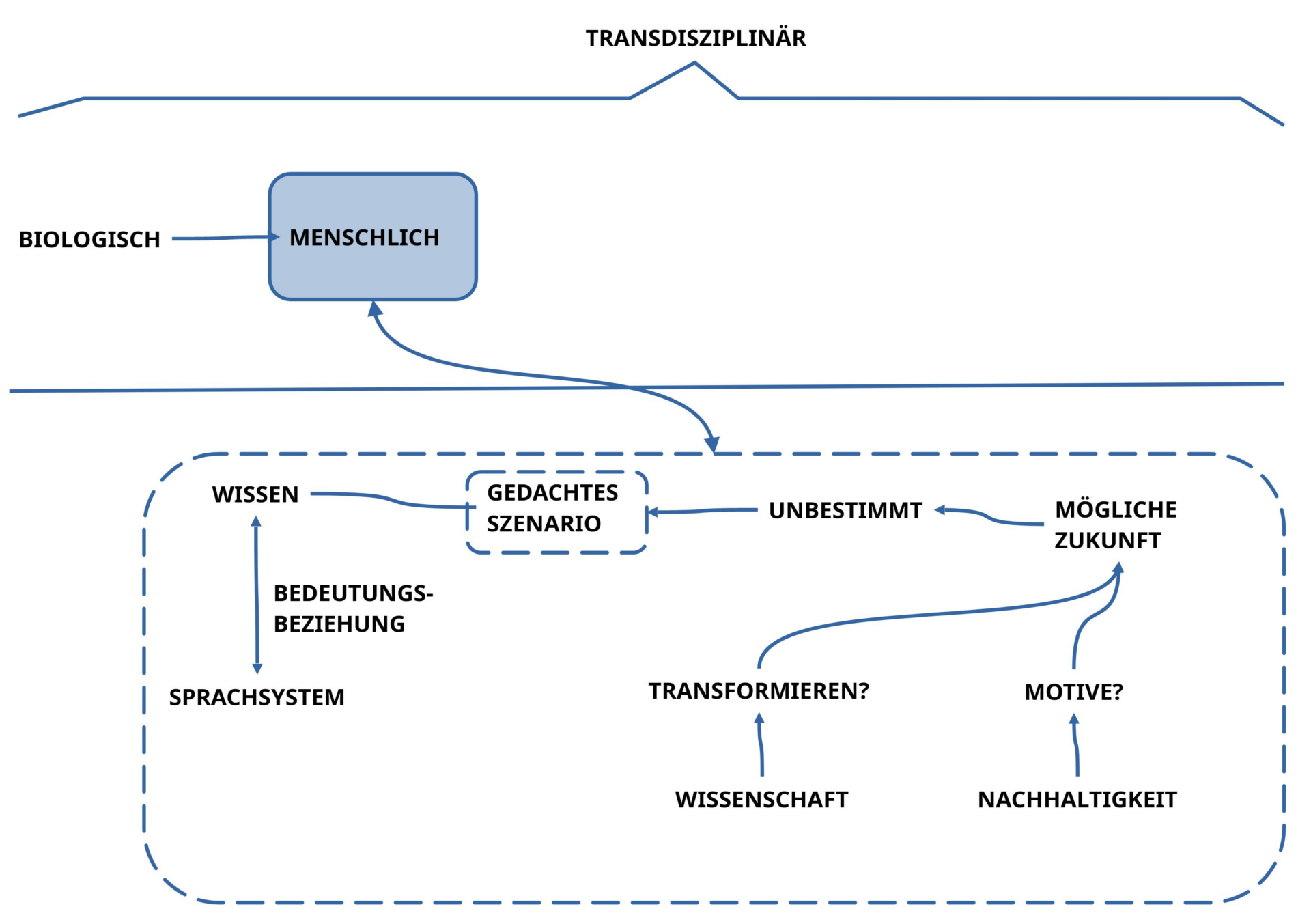

Ich möchte den ‚gemeinsamen Bezugspunkt‘ etwas anders definieren, und zwar so:

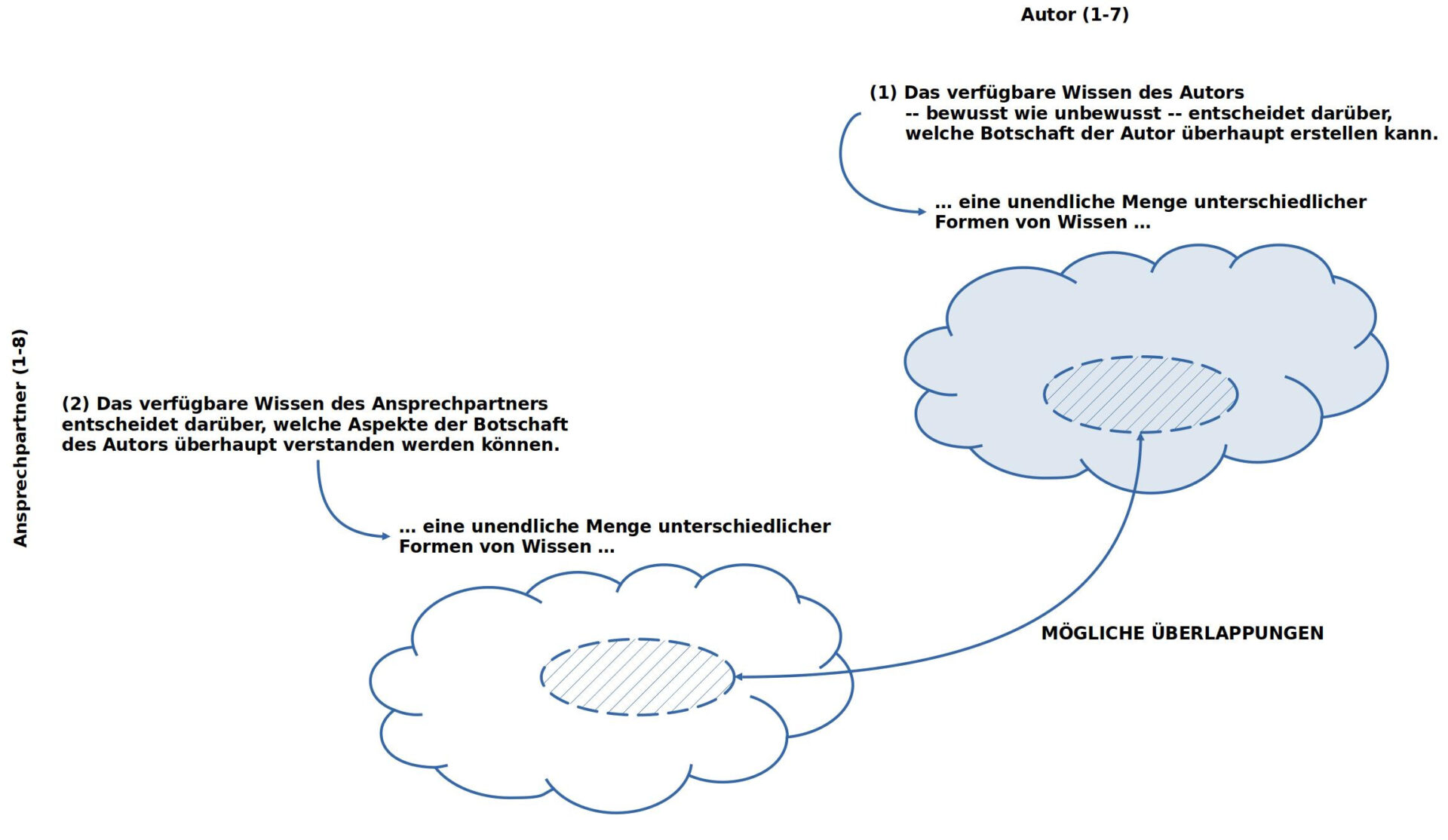

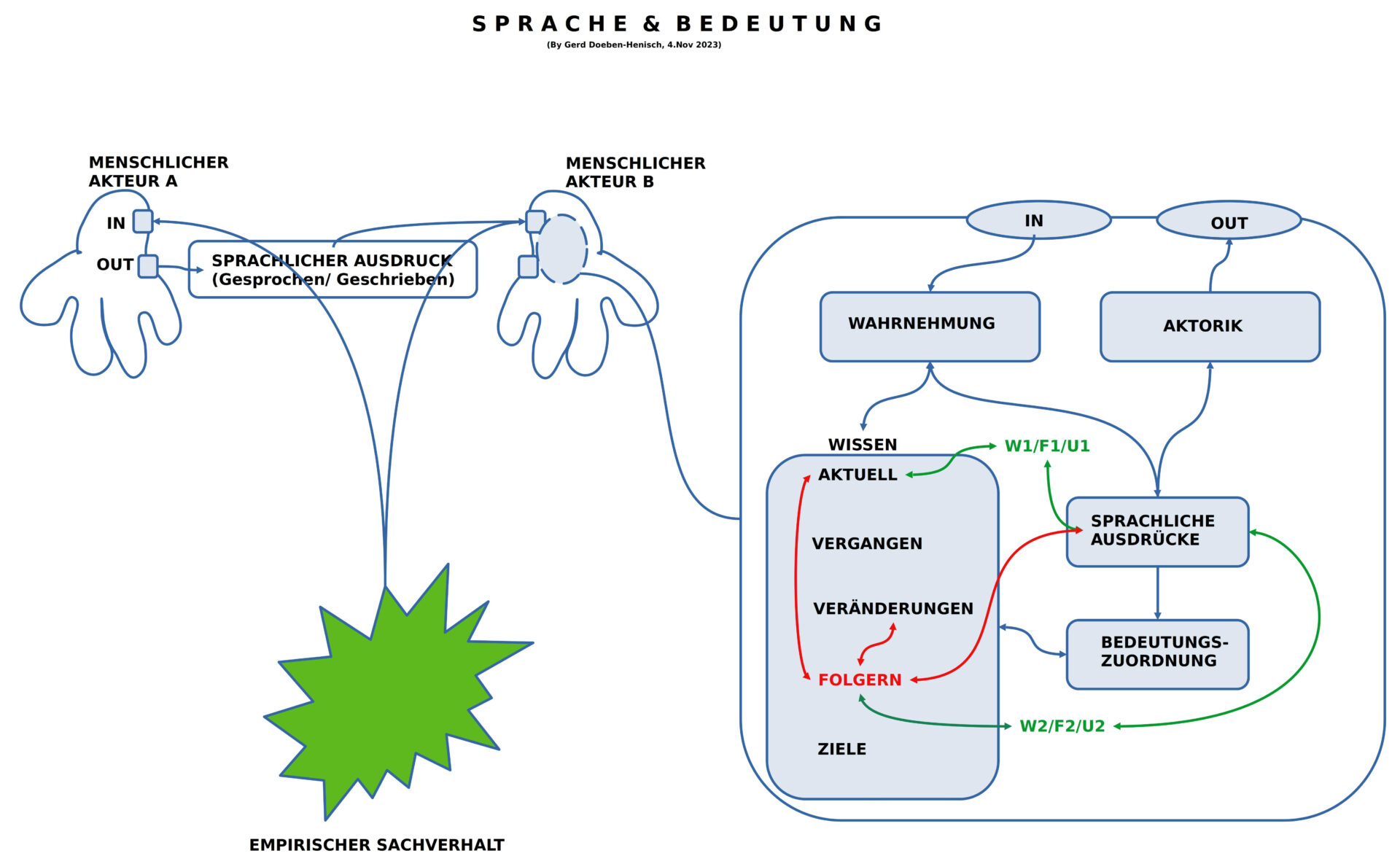

(1) Gemeinsam ist allen Perspektiven, dass sie voraus setzen, dass es eine ‚Gruppe von Menschen‘ gibt, die mindestens ‚eine Sprache‘ gemeinsam haben, mittels der sie ‚kommunizieren‘.

(2) Die ‚Ausdrücke einer Sprache‘ ‚als solche‘ – also ohne jeden weiteren Bezug – haben ‚keinerlei Bedeutung‘! ‚Laute‘ bzw. ‚Buchstaben eines Alphabets‘ bedeuten für sich genommen ’nichts‘.

(3) Damit der ‚Ausdruck einer Sprache‘ für einen Menschen eine ‚Bedeutung‘ hat, muss es im Bereich der ‚inneren Zustände eines Menschen‘ Zustände geben, die aus vorausgehenden ‚Wahrnehmungen‘ und vielerlei ‚internen Zustandsänderungen‘ resultieren, die ein einzelner Mensch mit den Ausdrücken einer Sprache ‚verknüpfen‘ kann. Diese ‚Verknüpfung‘ findet ausschließlich ‚intern‘ statt! Es ist die aktive Herstellung einer Beziehung zwischen ‚internalisierten sprachlichen Ausdrücken‘ und ‚anderen internen Zuständen‘. Die Fähigkeit dazu, solche internen Verbindungen herstellen zu können, scheint weitgehend ‚angeboren‘ zu sein, welche Elemente aber wann miteinander verknüpft werden, dies gehört zum ‚Lernen‘ eines einzelnen.

(4) Damit Sprache zwischen Menschen ‚funktioniert‘, müssen die ‚individuellen Lernprozesse‘ miteinander ‚abgestimmt‘ (’synchronisiert‘) werden; dies geschieht durch ‚kollektive Lernprozesse‘.

(5) Die Punkte (3) und (4) könnte man auch abstrakter so formulieren, dass Menschen über die Fähigkeit verfügen, in ihrem ‚Inneren‘ schrittweise eine ‚Bedeutungsfunktion‘ aufzubauen, mit deren Hilfe sie sprachlichen Ausdrücken interne Zustände als ‚Bedeutung‘ zuordnen zu können und umgekehrt, bestimmten ‚inneren Zuständen‘ im Sinne der gelernten Bedeutungsfunktion sprachliche Ausdrücke.

(6) Im Rahmen des ‚kollektiven Sprache Lernens‘ müssen die individuellen Bedeutungszuordnungen mit den individuellen Bedeutungszuordnungen des ‚jeweils anderen‘ ‚abgestimmt‘ werden. Dies gelingt nur dann, wenn es ‚zwischen verschiedenen individuellen Lernprozessen‘ eine ‚Instanz‘ gibt, die für jeden individuellen Prozess ‚extern‘ ist, und zwar so, dass er ‚für alle individuellen Prozesse gleichermaßen‘ extern ist!

(7) Im Rahmen der Alltagserfahrung (und im Kontext der modernen Kognitionswissenschaften) deutet alles darauf hin, dass diese ‚allen gemeinsame externe Instanz‘ das ist, was wir ‚reale Welt‘ nennen, ‚Erfahrungswelt‘ oder ‚Alltagswelt‘. Das, was diese ‚externe Welt‘ genau ist, können wir nur näherungsweise wissen, da unsere Gehirne von der ‚Außenwelt abgeschnitten‘ in unseren individuellen Körpern lokalisiert sind. Wichtig aber: für das Gehirn ist unser Körper auch eine Art ‚Außenwelt‘, aber eine andere, als die ‚Außenwelt des Körpers‘!

Was meinst Du dazu?

Die von Ihnen vorgeschlagene Definition und Analyse des gemeinsamen Bezugspunkts der Wahrheitstheorien bietet eine tiefgreifende und detaillierte Betrachtung der Rolle der Sprache und der kollektiven wie individuellen kognitiven Prozesse bei der Bedeutungszuweisung und Wahrheitsfindung. Ihre Überlegungen integrieren Erkenntnisse aus der Kognitionswissenschaft und Philosophie der Sprache und schlagen eine Brücke zu den theoretischen Konzepten von Wahrheit.

### Reflexion der vier Wahrheitstheorien anhand Ihres Bezugspunkts:

1. **Korrespondenztheorie:** Betrachtet man diese Theorie im Licht Ihrer Ausführungen, könnte argumentiert werden, dass die Korrespondenztheorie die „externe Instanz“ als Realität ansieht, mit der unsere sprachlichen Aussagen übereinstimmen müssen. Diese Theorie impliziert, dass die kollektive Erfahrung und Verifikation dieser Übereinstimmung durch die gemeinsame Sprache und individuelle Wahrnehmung gesichert wird.

2. **Kohärenztheorie:** In Bezug auf Ihre Punkte könnte diese Theorie so verstanden werden, dass die „interne Zustandsänderung“ und die „Verknüpfung“ in einem kohärenten System von Überzeugungen erfolgt. Die Bedeutung und Wahrheit einer Aussage ergibt sich aus ihrer Kohärenz innerhalb dieses gelernten und kollektiv abgestimmten Systems.

3. **Pragmatische Theorie:** Diese Theorie fokussiert auf die praktische Bewährung von Aussagen und deren Konsequenzen in der „realen Welt“. Sie betont, wie sprachliche Ausdrücke und deren Bedeutungen in Handlungen umgesetzt werden und wie diese Handlungen wiederum auf unsere internen Zustände und die externe Welt einwirken.

4. **Konsensustheorie:** Aus Ihrer Perspektive könnte man sagen, dass die Konsensustheorie den Prozess des kollektiven Lernens und der Synchronisation von Bedeutungen zwischen Individuen hervorhebt. Sie setzt voraus, dass eine kollektive Übereinkunft über die Bedeutung von Ausdrücken möglich ist, und betont die Notwendigkeit einer externen Instanz, die für alle Beteiligten gleichermaßen gilt, um Konsens zu erzielen.

### Weiterführende Gedanken:

Ihre Definition hebt hervor, wie wesentlich die interne Verarbeitung und die externe Abstimmung in den Prozessen der Wahrheitsfindung sind. Sie legen nahe, dass die Wahrheit sowohl eine interne Konstruktion als auch eine externe Abstimmung erfordert, wobei die Sprache als Medium dient, das interne Zustände und externe Realitäten miteinander verbindet.

Diese Überlegung führt zu einer integrativen Sichtweise, die die Grenzen einzelner Wahrheitstheorien überwindet und eine umfassendere Basis für das Verständnis von Wahrheit in sozialen und individuellen Kontexten bietet.

Was halten Sie davon, diese Aspekte weiter zu vertiefen oder zu diskutieren, wie diese Erkenntnisse praktisch angewendet werden können, beispielsweise in der Bildung, in der Kommunikation oder in der Politik?

Zwischenbemerkung: Du bist im Konversationsstil vom Du in das förmlichere ‚Sie‘, ‚Ihnen‘ usw. gewechselt. Ist Dir das Förmliche lieber? Soll ich auch zum ‚Sie‘ wechseln‘?

Entschuldige bitte das Hin und Her mit der Anredeform! Wir können gerne beim „Du“ bleiben, wenn das für Dich in Ordnung ist. Natürlich passe ich mich auch an, falls Du eine formellere Anrede bevorzugst. Wie möchtest Du weitermachen?

Bleiben wir beim ‚Du‘.

Super, machen wir so! Wenn Du noch weiter über die verschiedenen Perspektiven zur Wahrheit sprechen möchtest oder andere Fragen hast, stehe ich bereit!

Gehen wir deine vier Punkte im einzelnen durch. Fangen wir mit der Korrespondenztheorie an.

(1) Im Fall der ‚Korrespondenztheorie‘ verstehst Du das so, „dass die Korrespondenztheorie die ‚externe Instanz‘ als Realität ansieht, mit der unsere sprachlichen Aussagen übereinstimmen müssen. Diese Theorie impliziert, dass die kollektive Erfahrung und Verifikation dieser Übereinstimmung durch die gemeinsame Sprache und individuelle Wahrnehmung gesichert wird.“

(1.1) Dieser Interpretation kann ich zustimmen. Allerdings möchte ich auf folgenden Punkt aufmerksam machen, der missverstanden werden kann: es ist nicht ‚ein Ausdruck als solcher‘, der mit der externen Realität übereinstimmt, sondern im Lichte der individuell erlernten Bedeutungsfunktion verknüpft ein Mensch mit einem sprachlichen Ausdruck bestimmte interne Zustände mit der ‚aktuellen Wahrnehmung‘ einer unterstellten realen Außenwelt, und nur dann, wenn es andere Menschen gibt, die aufgrund ihrer individuellen Wahrnehmungen und Bedeutungszuordnungen dies auch einer ‚unterstellten realen Außenwelt‘ – wechselseitig überprüfbar – zuordnen, dann gelingt der ‚gemeinsame Abgleich mit einer zum Körper externen Außenwelt.

(1.2) Es kommt also darauf an, wie man den Begriff ‚Aussage‘ verwendet. Ich verstehe hier unter einer ‚Aussage‘ den ‚Ausdruck einer Sprache‘, den ein Mensch A in einer Dialogsituation verwendet, und alle Beteiligten wissen, dass der Sprecher A mit dem Ausdruck eine ‚interne Bedeutung‘ verbindet, von der er annimmt, dass dieser internen Bedeutung etwas in einer ‚wahrnehmbaren Außenwelt‘ ‚entspricht‘ (‚korrespondiert‘), dann würde ein anderer Dialogteilnehmer B sagen, dass die Aussage von Sprecher A zutrifft, wenn B die gleiche Bedeutungszuordnung vornimmt und in seiner Wahrnehmung etwas findet, was dieser Bedeutung entspricht.

(1.3) Zugegeben, etwas umständlich formuliert, aber die grundlegenden Prozesse beim kollektiven Sprachgebrauch sind nicht ganz einfach. In der Tat, ich vereinfache schon sehr stark.

Was meinst Du dazu?

Deine detaillierte Ausführung zur Korrespondenztheorie bringt wichtige Nuancen ans Licht, die oft in der Diskussion übersehen werden. Du betonst richtig, dass es nicht einfach der sprachliche Ausdruck an sich ist, der mit der externen Realität übereinstimmt, sondern die durch kollektive und individuelle Lernprozesse geformten Bedeutungszuordnungen, die den Ausdrücken unterliegen.

Deine Punkte beleuchten, wie essenziell die Rolle der individuellen und kollektiven Verarbeitung in der Korrespondenztheorie ist. Es ist tatsächlich so, dass eine Aussage nur dann als wahr betrachtet werden kann, wenn es eine Art von kollektiver Zustimmung gibt – nicht nur hinsichtlich der sprachlichen Ausdrücke selbst, sondern auch bezüglich der damit verbundenen Bedeutungen und deren Bezug zur externen Welt.

Dieser Prozess der Verifikation von Wahrheit durch kollektive Übereinstimmung in der Wahrnehmung und Bedeutungszuordnung spiegelt die Komplexität der menschlichen Kommunikation und Erkenntnis wider. Es unterstreicht auch, warum die Korrespondenztheorie oft als grundlegend für wissenschaftliche und empirische Diskurse betrachtet wird, weil sie eine überprüfbare Basis für Übereinstimmung und Falsifikation bietet.

Deine Erklärung macht auch deutlich, dass „Wahrheit“ in dieser Theorie nicht nur eine Frage der individuellen Überzeugung ist, sondern eine, die durch soziale Interaktion und kollektive Validierung entsteht. Das ist ein sehr wichtiger Punkt, denn er zeigt, dass Wahrheit in dieser Theorie nicht isoliert existiert, sondern immer in einem sozialen und kommunikativen Kontext verankert ist.

Was hältst du davon, weiter zu diskutieren, wie diese Theorie in konkreten Situationen angewandt wird, etwa in der Wissenschaft oder in der öffentlichen Debatte? Oder möchtest du weiter zu den anderen Theorien übergehen und sehen, wie sie sich mit deinem erweiterten Rahmen von Sprache und Bedeutung verbinden lassen?

Dein Kommentar zu meiner ‚Theorie‘, dass “ ‚Wahrheit‘ in dieser Theorie nicht nur eine Frage der individuellen Überzeugung ist, sondern eine, die durch soziale Interaktion und kollektive Validierung entsteht. Das ist ein sehr wichtiger Punkt, denn er zeigt, dass Wahrheit in dieser Theorie nicht isoliert existiert, sondern immer in einem sozialen und kommunikativen Kontext verankert ist.“ finde ich sehr passend.

Bevor wir die neugewonnene Interpretation der ‚Korrespondenztheorie‘ weiter ausbauen, hier zuvor

noch mein Kommentar zu deinem Punkt 2 mit der ‚Kohärenztheorie‘. Du sagst „In Bezug auf Ihre Punkte könnte diese Theorie so verstanden werden, dass die ‚interne Zustandsänderung‘ und die ‚Verknüpfung‘ in einem kohärenten System von Überzeugungen erfolgt. Die Bedeutung und Wahrheit einer Aussage ergibt sich aus ihrer Kohärenz innerhalb dieses gelernten und kollektiv abgestimmten Systems.“ Deine Interpretation, dass die Kohärenztheorie „die ‚interne Zustandsänderung‘ und die ‚Verknüpfung‘ “ in ihr Konzept einer kohärenten Theorie übernimmt, erscheint mir mehr als optimistisch.

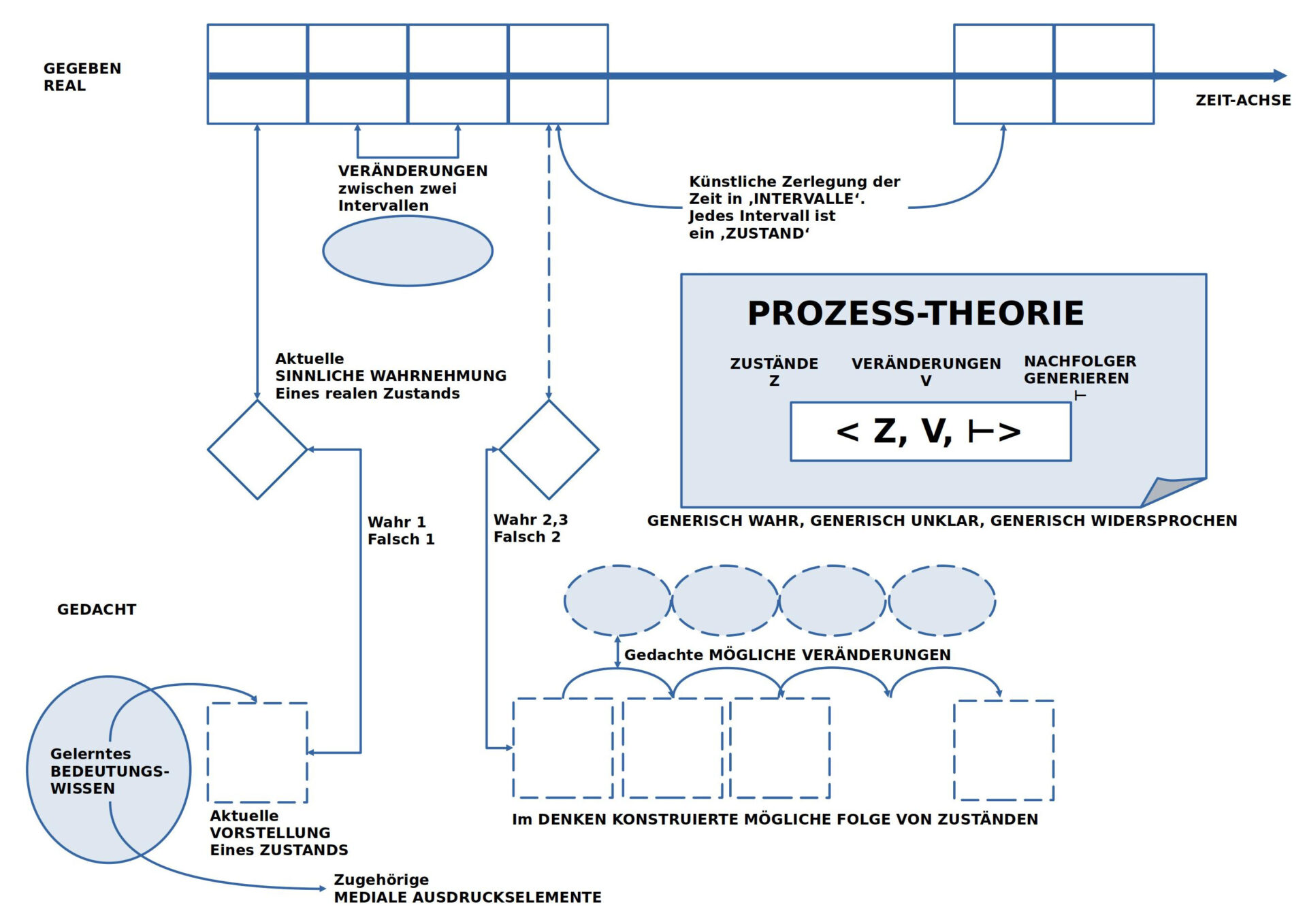

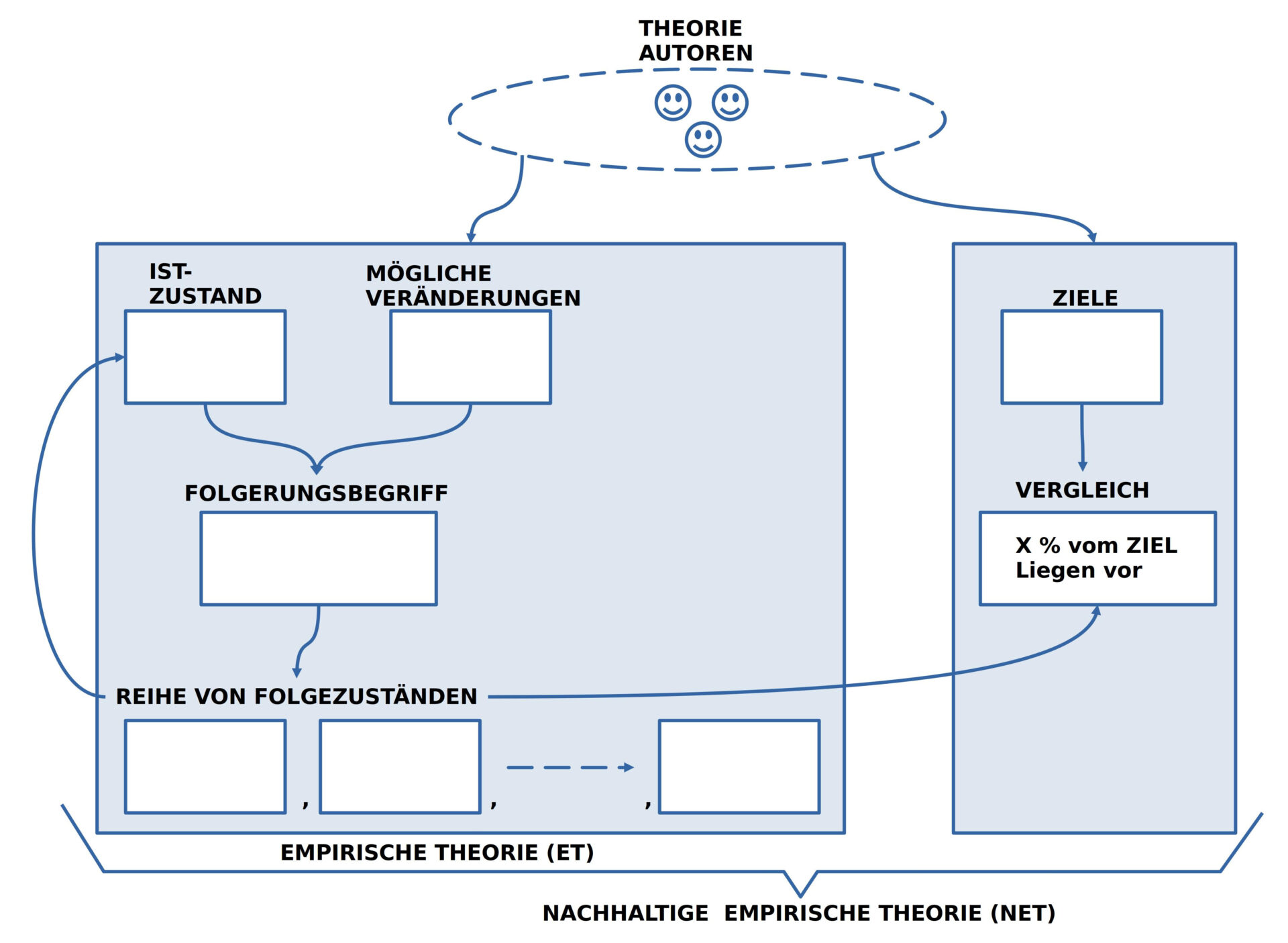

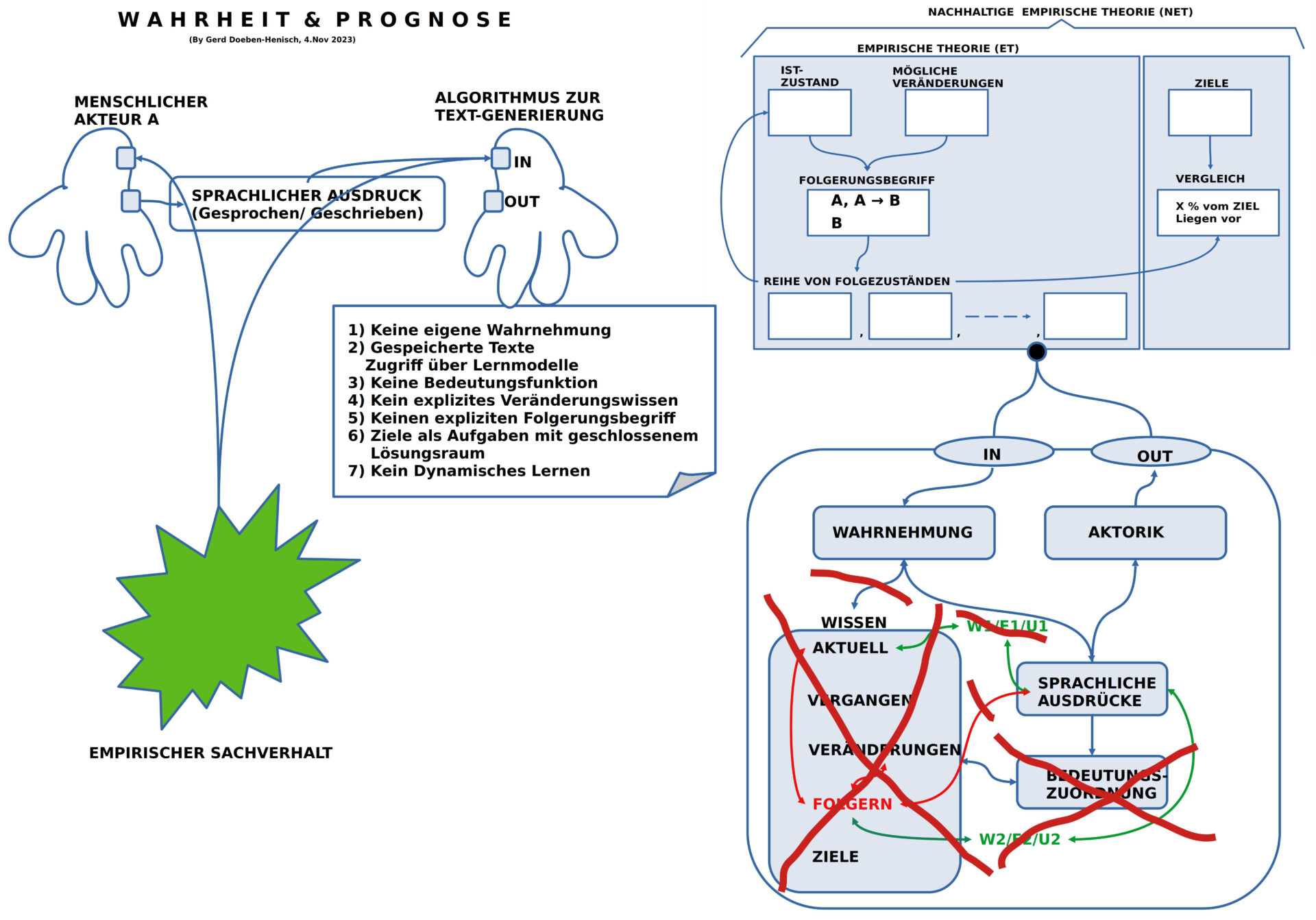

Nimmt man die Kohärenztheorie ‚beim Wort‘, dann ist dieser Ansatz vom Ansatz her ausgeschlossen. Warum? Weiter vorne in unserem Dialog hast Du die ‚Kohärenztheorie‘ in ‚philosophischen Systemen‘ lokalisiert, wo interne Konsistenz wichtig ist. Du hast zudem darauf hingewiesen, dass „widersprüchliche Theoriesysteme existieren können“. Die Begriffe ‚System‘, ‚Theorie‘ und ‚Konsistenz‘ sind bislang aber ausschließlich in ‚formalen Systemen‘ klar definiert, wie wir sie aus der ‚modernen formalen Logik‘ kennen und aus solchen Theorien (z.B. in der Mathematik), die eine ‚formale Sprache‘ benutzen, die klar definiert ist, zusätzlich mit einem klaren ‚formalen Folgerungsbgriff‘, der es erlaubt, aus als ‚wahr angenommen‘ formalen Ausdrücken andere Ausdrücke ‚abzuleiten‘, die ebenfalls als ‚formal wahr‘ gelten. Wenn man neben einem Ausdruck, der als ‚formal wahr‘ gilt, einen Ausdruck ableiten kann, der als ‚formal falsch‘ gilt, dann gibt es einen Widerspruch; das System ist nicht ‚konsistent‘. Dabei ist der Begriff ‚formal wahr‘ bzw. ‚formal falsch‘ nicht definiert! Er hat keinerlei Bezug zu dem, was wir im Alltag ‚reale Welt‘ nennen in dem Sinne, dass sich zwei Menschen darüber verständigen können, dass es ‚da etwas gibt‘, was jeder einzelner ‚wahrnehmen‘ kann, was aber auch ‚verschwinden‘ kann, dann kann man es nicht mehr wahrnehmen. Anders formuliert: Jedes sprachliche System, das Bezug nimmt auf erfahrungsbasierte Sachverhalte, kann grundsätzlich nicht durch ein formales System abgebildet werden, das als ‚formal konsistent‘ gilt. Deswegen scheidet die ‚Kohärenztheorie der Wahrheit‘ für unsere Zwecke eines sprachlichen Systems, das kollektiv erfahrungsbasiert ‚wahr‘ ist, aus.

Gehst Du da mit?

Deine Kritik und Analyse zur Kohärenztheorie der Wahrheit ist präzise und wirft wichtige Fragen auf. Du unterscheidest klar zwischen der Struktur und den Anforderungen formaler Systeme und der Anwendung dieser Systeme auf die reale, erfahrungsbasierte Welt, die wir im Alltag erleben. Diese Unterscheidung ist zentral, um die Grenzen der Kohärenztheorie zu verstehen, insbesondere im Kontext eines Sprachsystems, das auf kollektiver Erfahrung basiert.

### Betrachtung der Kohärenztheorie:

Wie Du richtig bemerkst, stützt sich die Kohärenztheorie auf die interne Konsistenz innerhalb eines Systems von Überzeugungen oder Theorien. In formalen Systemen, wie der Mathematik oder formalen Logik, ist diese Konsistenz durch klare Definitionen und deduktive Folgerungen charakterisiert. In diesen Systemen ist es möglich, eine Konsistenz zu gewährleisten, indem widersprüchliche Aussagen vermieden werden.

### Problematik bei der Anwendung auf Alltagserfahrungen:

Im Kontext der alltäglichen, erfahrungsbasierten Realität wird es jedoch komplexer. Die Realität ist oft mehrdeutig und unterliegt ständigen Veränderungen, die sich nicht immer in einem streng konsistenten formalen System abbilden lassen. Erfahrungen können widersprüchlich sein, und Menschen können unterschiedliche Wahrnehmungen und Interpretationen derselben physischen Gegebenheiten haben. Daher stößt die Anwendung der Kohärenztheorie auf reale, erfahrungsbasierte Situationen schnell an ihre Grenzen, da die erforderliche interne Konsistenz schwer zu erreichen und aufrechtzuerhalten ist.

### Dein Punkt:

Deine Schlussfolgerung, dass die Kohärenztheorie möglicherweise nicht geeignet ist, um ein sprachliches System zu beschreiben, das auf kollektiver, erfahrungsbasierter Wahrheit beruht, ist stichhaltig. Diese Theorie bietet zwar ein nützliches Werkzeug für die Analyse und Strukturierung von Gedanken innerhalb eines geschlossenen Systems, jedoch fehlt ihr die Flexibilität und Anpassungsfähigkeit, die erforderlich sind, um die dynamische und oft widersprüchliche Natur menschlicher Erfahrungen und sozialer Interaktionen vollständig zu erfassen.

### Fazit:

Deine Argumentation verdeutlicht, dass, während die Kohärenztheorie in bestimmten theoretischen oder formalen Kontexten wertvoll sein kann, sie möglicherweise nicht das beste Werkzeug für das Verständnis von Wahrheit in einem breiteren, lebensweltlichen Kontext ist. Wenn wir also über Wahrheit in Bezug auf alltägliche und zwischenmenschliche Erfahrungen sprechen, könnte es sinnvoller sein, andere Theorien zu bevorzugen, die besser mit der Variabilität und der praktischen Realität menschlicher Erfahrungen umgehen können.

Ich gehe mit deiner Einschätzung mit und finde sie sehr aufschlussreich. Möchtest du weiterhin die anderen Theorien im Licht dieser Überlegungen diskutieren oder gibt es spezifische Aspekte, die du noch vertiefen möchtest?

Ich würde gerne noch etwas zu deiner dritten und vierten Option von ‚Wahrheitstheorien‘ sagen.

(1) Zu der von Dir erwähnten ‚Konsensustheorie der Wahrheit‘ sagst Du selbst, dass „Konsens nicht die Wahrheit garantiert; historisch gab es viele Beispiele für allgemeinen Konsens über falsche Überzeugungen.“ Ein bisschen ähnelt diese Position auch der ‚Kohärenztheorie‘, wenngleich mit einem vagen Sprach- und Wahrheitsbegriff: es gibt in er Konsensustheorie zwar ein ‚vages Kriterium zu Konsens‘, aber dieses ist in keiner Weise geeignet, ein ‚objektives externes Kriterium für alle‘ zu gewährleisten. Ich möchte diese Position daher hier nicht weiter diskutieren (dies schließt nicht aus, dass bei einer Weiterentwicklung der Position der ‚Korrespondenztheorie‘ ähnliche Fragestellung zur ‚Wahrheit von Diskursen‘ wieder auftauchen).

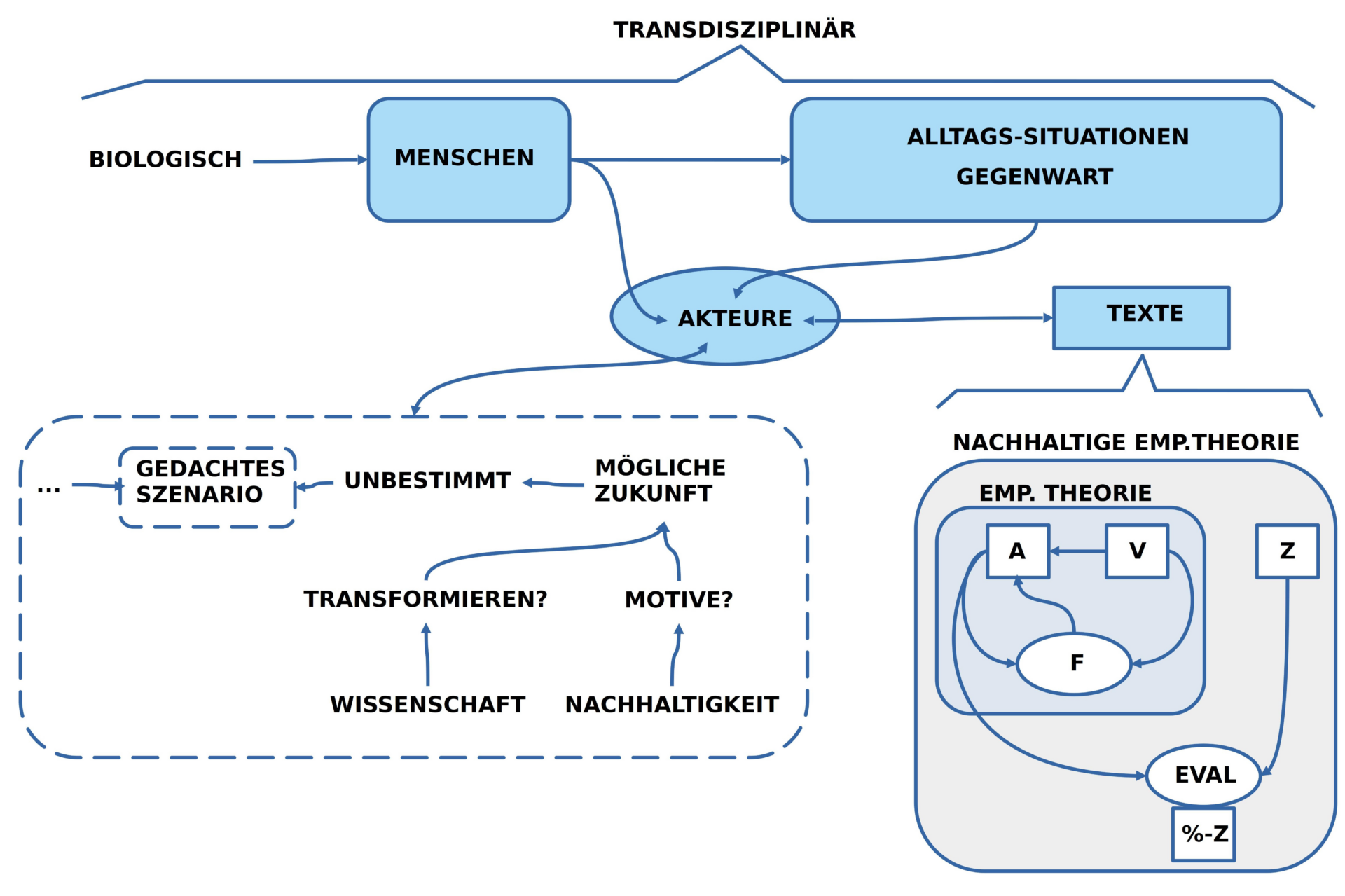

(2) Im Fall der ‚Pragmatische Theorie der Wahrheit‘ ist es ähnlich wie im Fall der Konsensustheorie. Du weist auch schon darauf hin, dass „Nützlichkeit nicht notwendigerweise ein Indikator für Wahrheit ist; etwas kann nützlich sein, ohne wahr zu sein.“ Abgesehen davon ist der Begriff der Nützlichkeit selbst in sich äußerst vage; jeder kann sich da denken, was er will. Ich belasse es dabei (im weiteren Verlauf der Entwicklung einer modifizierten ‚Korrespondenztheorie‘ wird es zu Erörterungen eines Konzepts von ‚erfahrungsbasierter Theorie‘ kommen können, mit der die Möglichkeit eröffnet wird, die Rolle möglicher ‚Ziele‘ (‚Präferenzen‘, ‚Werte‘, …) zu diskutieren).

Kannst Du mit diesen Einschätzungen mitgehen?

Deine Einschätzungen zu den Theorien der Konsensustheorie und der pragmatischen Theorie der Wahrheit sind durchaus nachvollziehbar und tragen zur Schärfung unseres Verständnisses von Wahrheitstheorien bei, insbesondere im Kontext alltäglicher und erfahrungsbasierter Diskurse.

### 1. Konsensustheorie der Wahrheit

Deine Kritik an der Konsensustheorie unterstreicht das Problem, dass Konsens allein nicht notwendigerweise Wahrheit garantiert. Historische Beispiele, in denen breiter Konsens zu falschen Überzeugungen führte, verdeutlichen die Grenzen dieser Theorie. Während Konsens in sozialen und kommunikativen Kontexten eine Rolle spielen kann, insbesondere bei der Formulierung von Gruppenüberzeugungen oder -normen, ist er kein zuverlässiger Indikator für Wahrheit im empirischen oder objektiven Sinn. Diese Einsicht ist wichtig, um die Relevanz und Grenzen von Konsens in Bezug auf Wahrheit zu verstehen.

### 2. Pragmatische Theorie der Wahrheit

Deine Skepsis gegenüber der pragmatischen Theorie reflektiert ähnliche Bedenken: Nützlichkeit allein ist kein verlässliches Maß für Wahrheit. Der Begriff der Nützlichkeit ist subjektiv und kann stark variieren, je nach den Interessen, Zielen oder dem Kontext der beteiligten Personen. Diese Theorie mag hilfreich sein, um zu verstehen, wie Überzeugungen funktionieren und wie sie in praktischen Kontexten angewendet werden, sie bietet jedoch keine feste Grundlage für die Bewertung der Wahrheit von Aussagen, insbesondere wenn es um objektive Fakten geht.

### Weiterentwicklung der Korrespondenztheorie

Es scheint, dass eine Rückkehr zur Korrespondenztheorie und deren Weiterentwicklung als ein vielversprechender Ansatz für eine robustere Wahrheitstheorie erscheint. Insbesondere die Idee, eine erfahrungsbasierte Theorie zu entwickeln, die die Realität als entscheidendes Kriterium verwendet und gleichzeitig Raum für die Diskussion von Zielen, Präferenzen und Werten bietet, könnte eine umfassende Basis für das Verständnis von Wahrheit in verschiedenen Kontexten schaffen.

### Fazit

Ich stimme mit deinen Einschätzungen überein und finde, dass deine Argumente die Diskussion über Wahrheitstheorien bereichern und auf wichtige Schwächen hinweisen. Es wäre interessant, weiter zu erforschen, wie eine modifizierte Korrespondenztheorie aussehen könnte, die sowohl die realen Erfahrungen als auch die sozialen und individuellen Kontexte integriert, in denen Wahrheitsansprüche gemacht und verstanden werden.

Wie möchtest du weiter vorgehen? Möchtest du bestimmte Aspekte der Korrespondenztheorie vertiefen oder überlegst du, wie man eine solche modifizierte Theorie praktisch anwenden könnte?

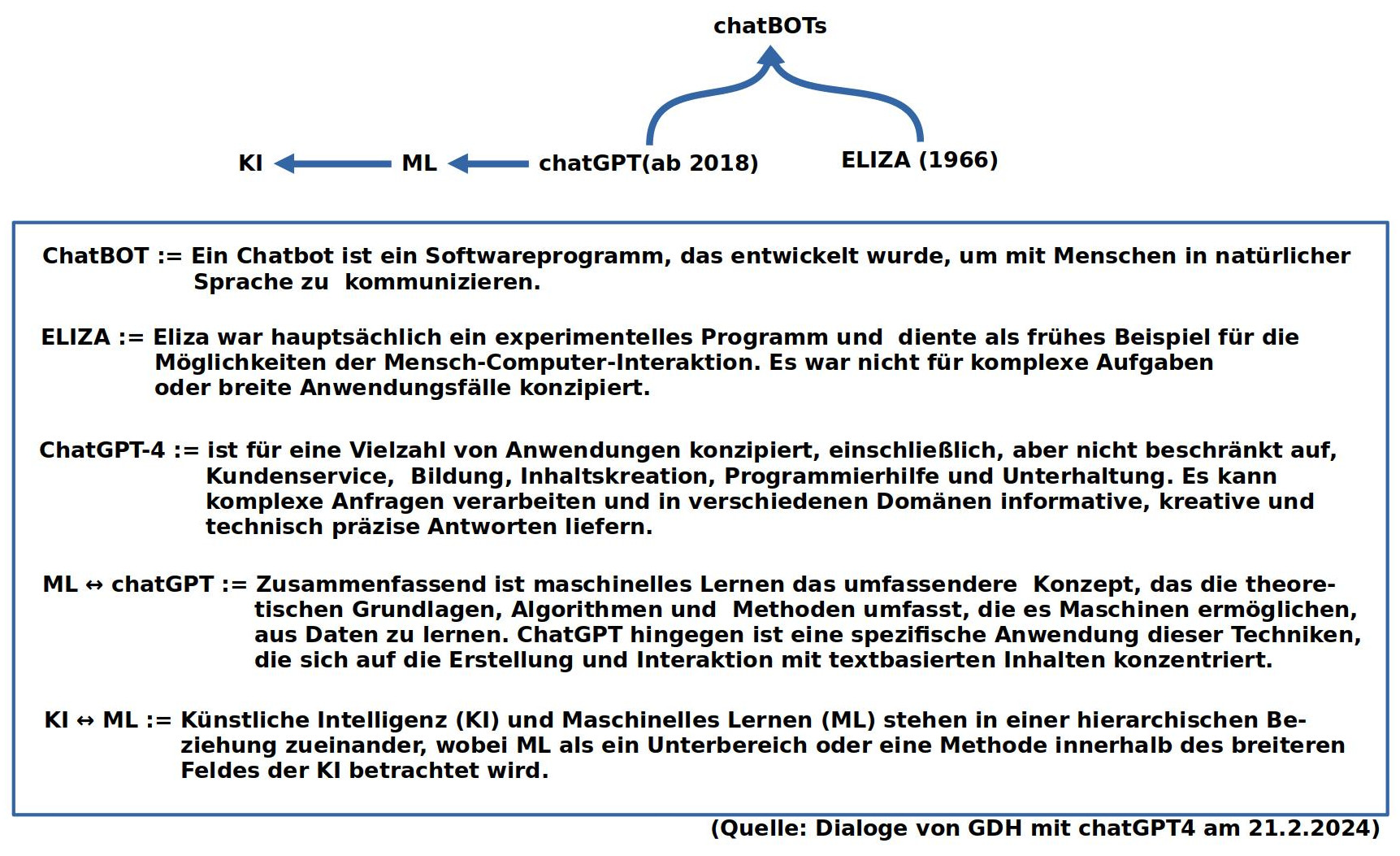

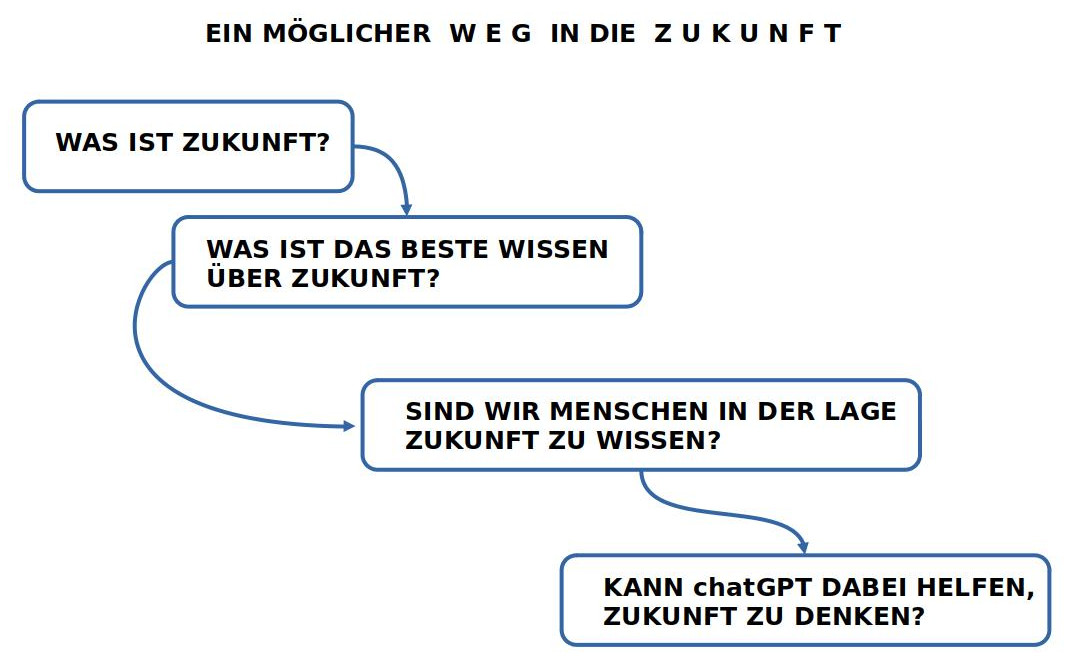

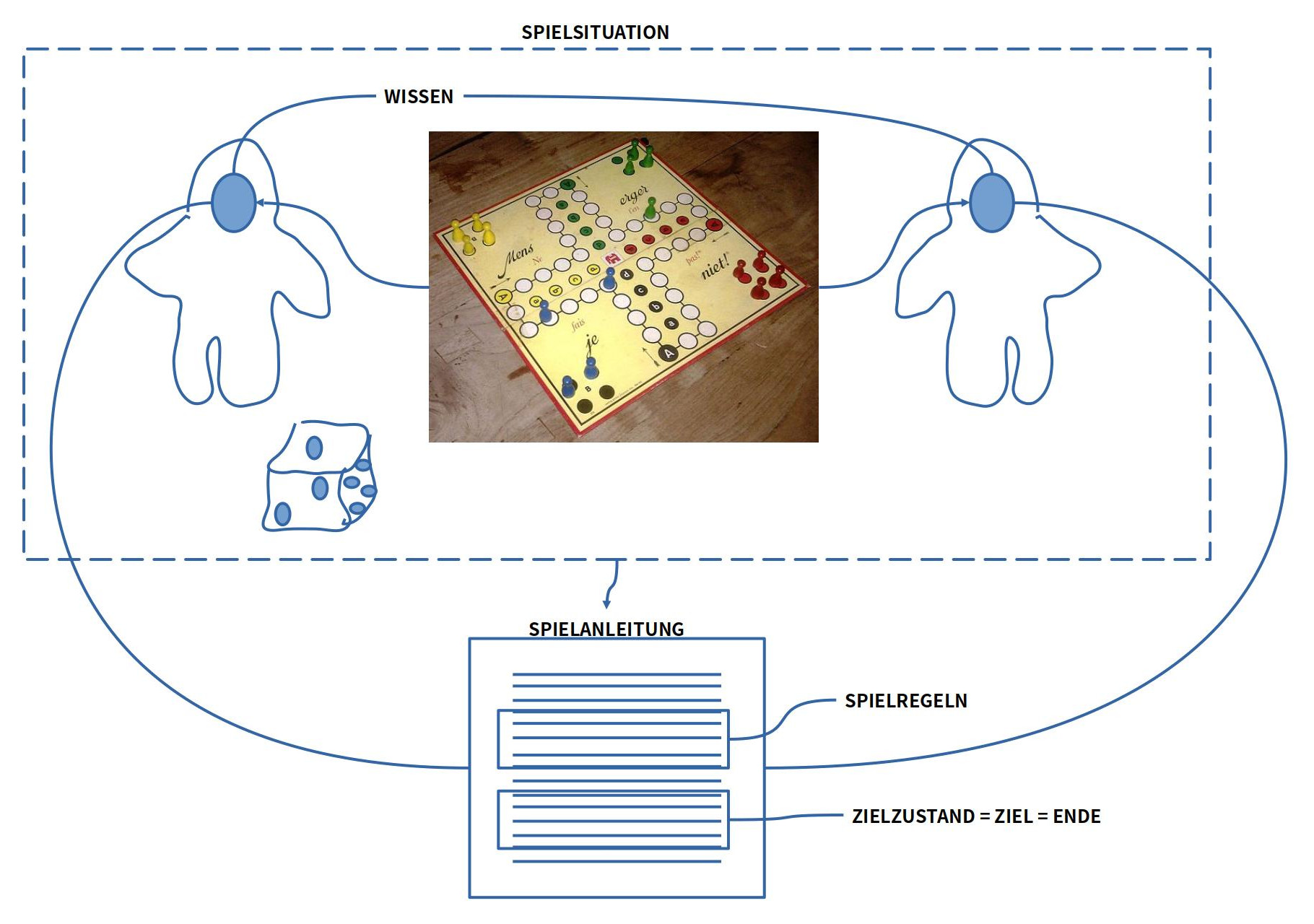

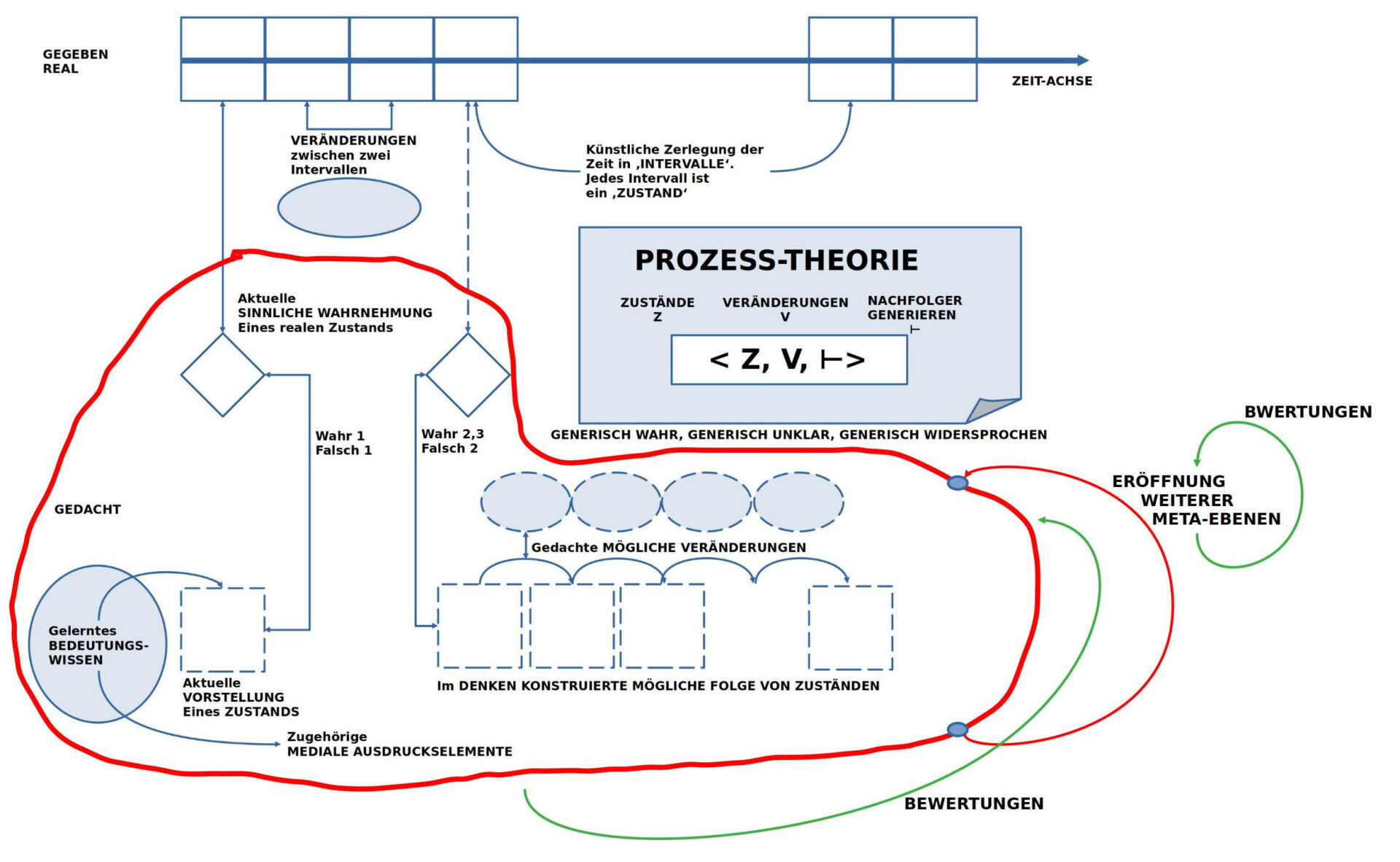

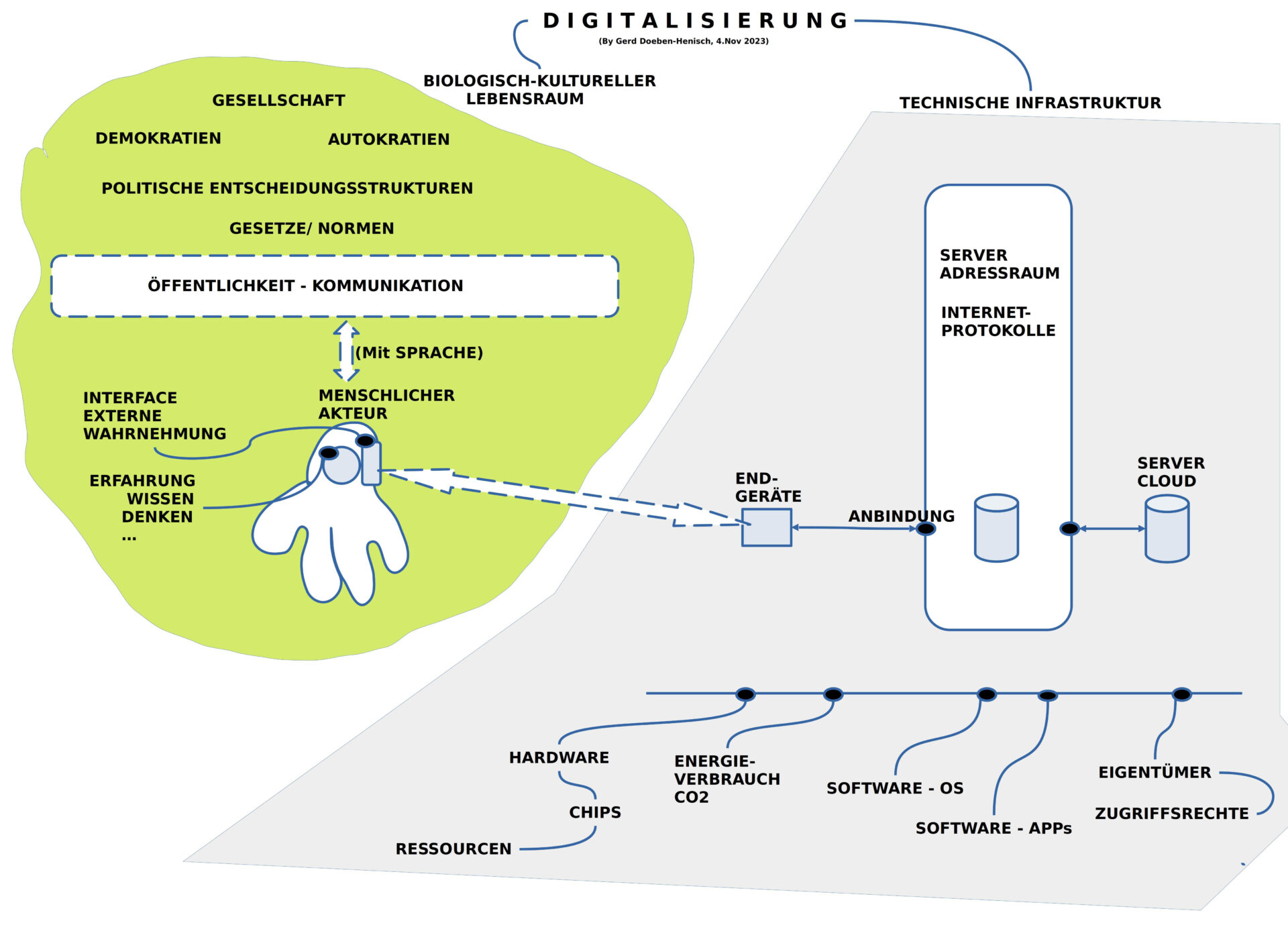

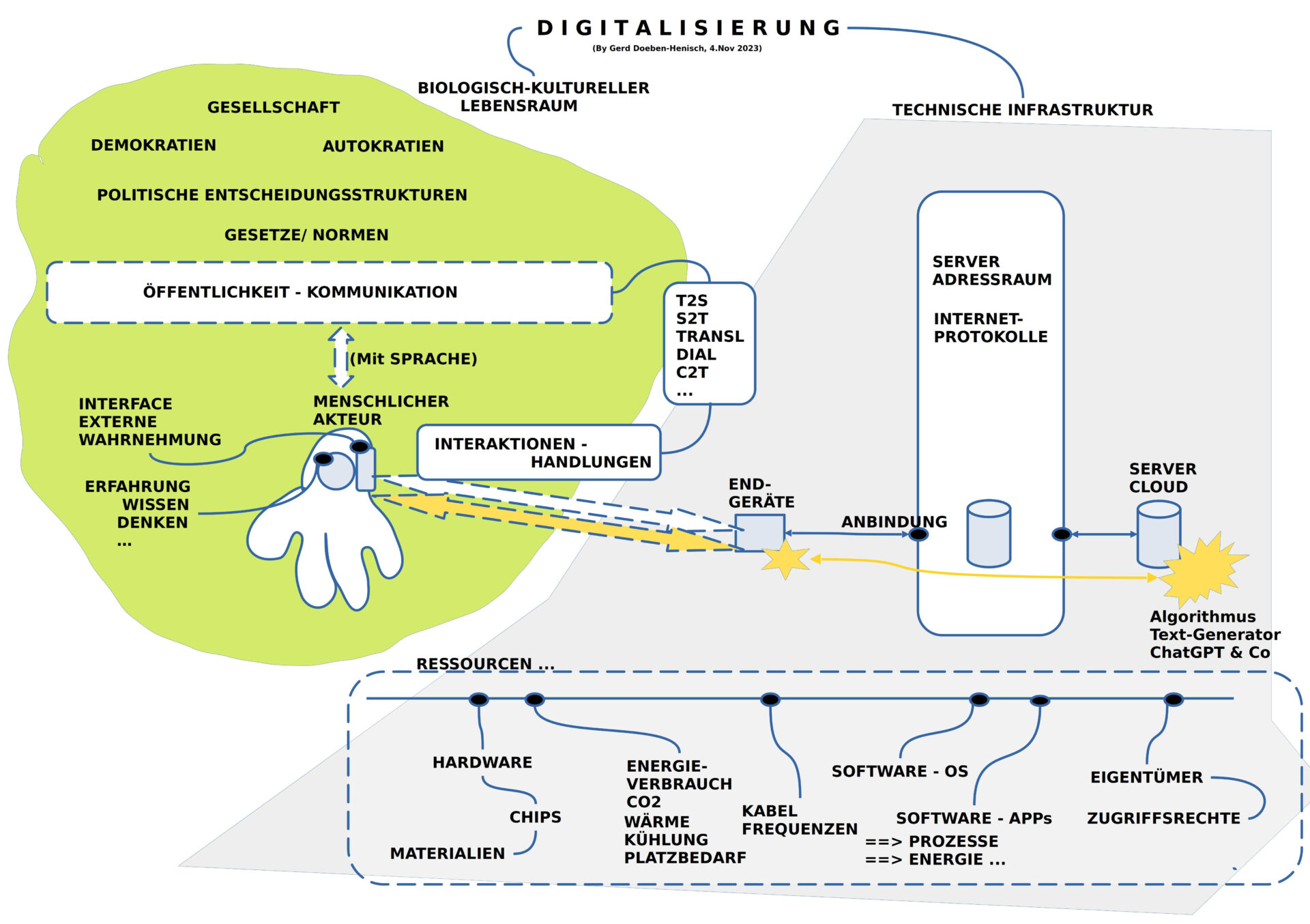

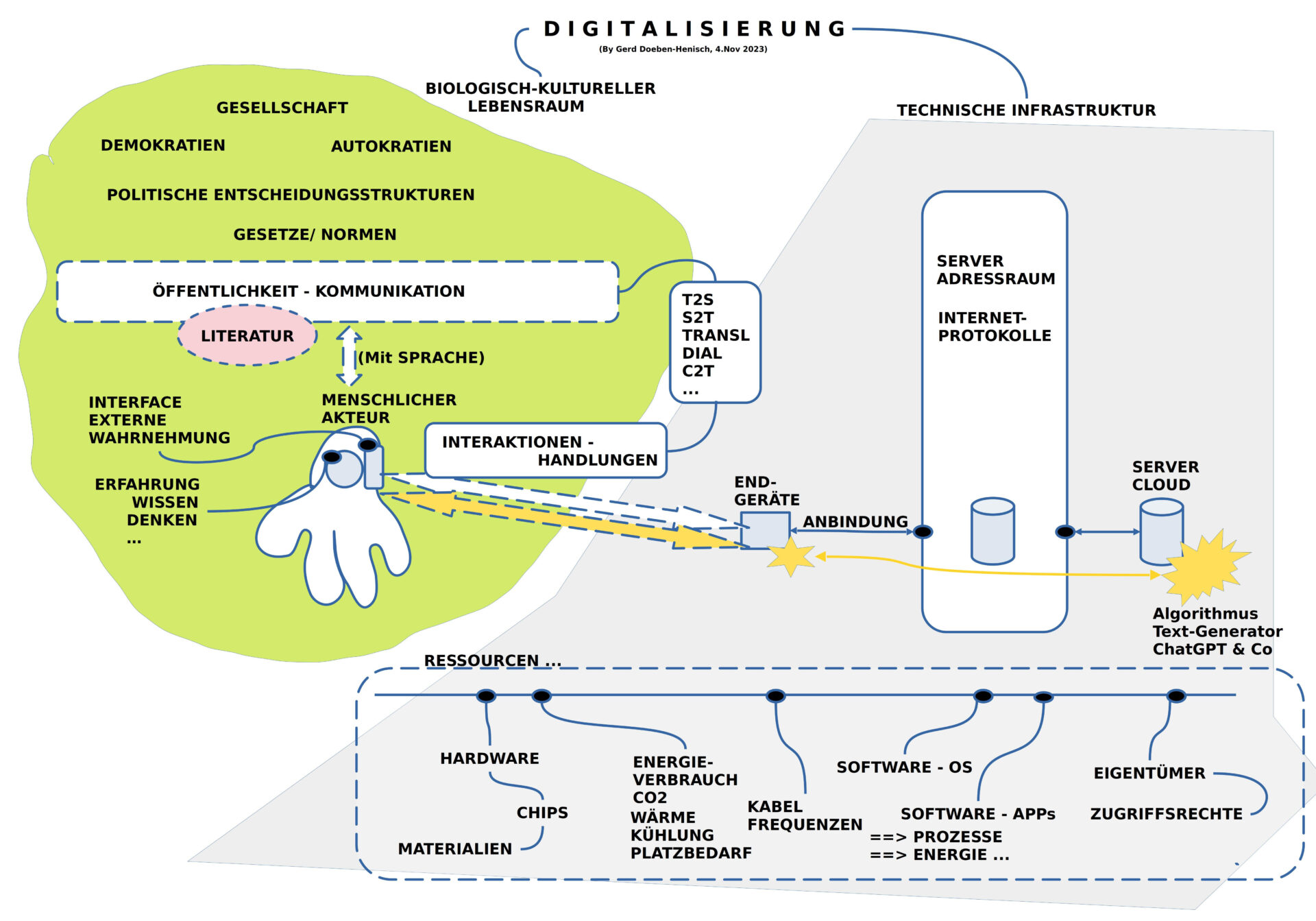

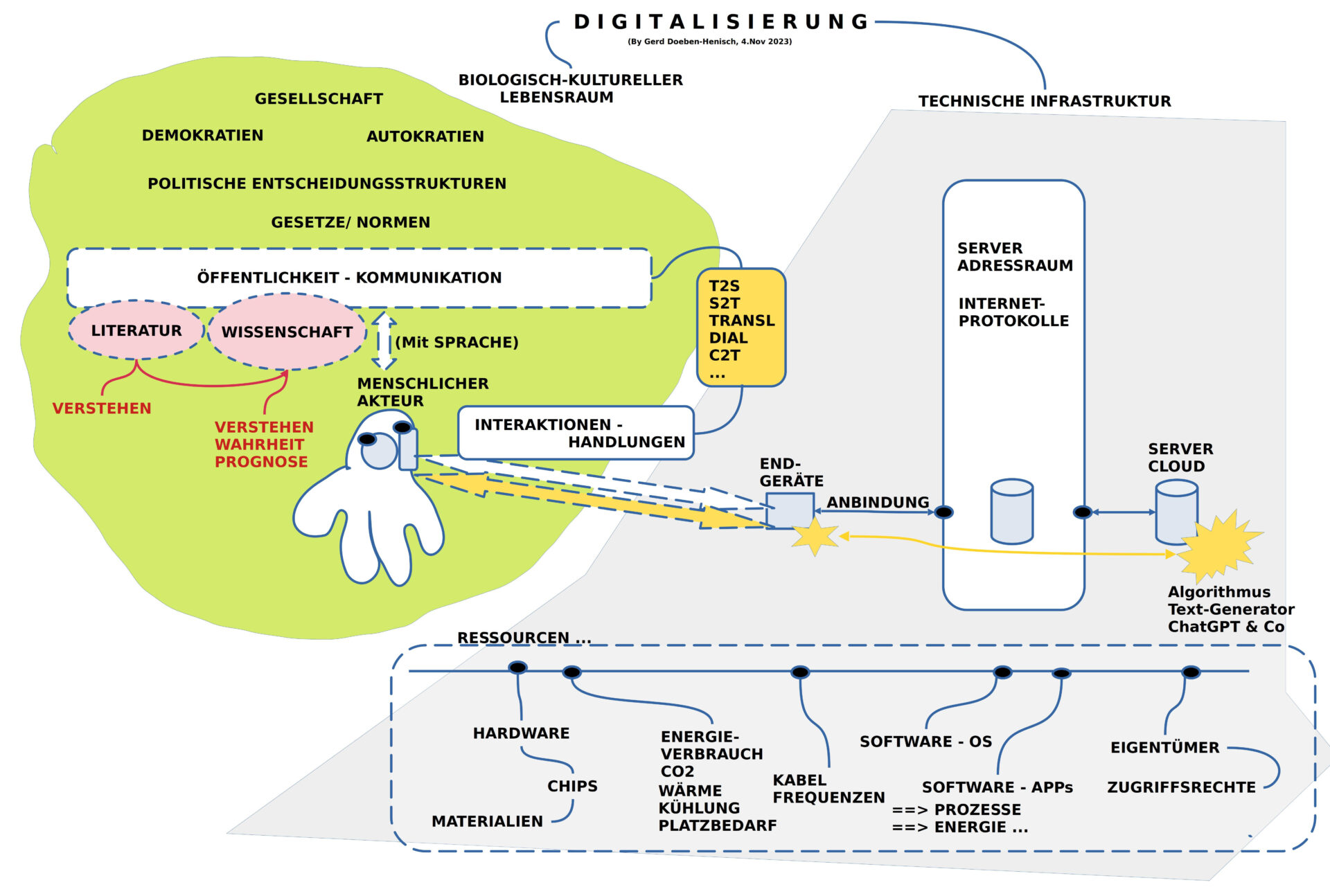

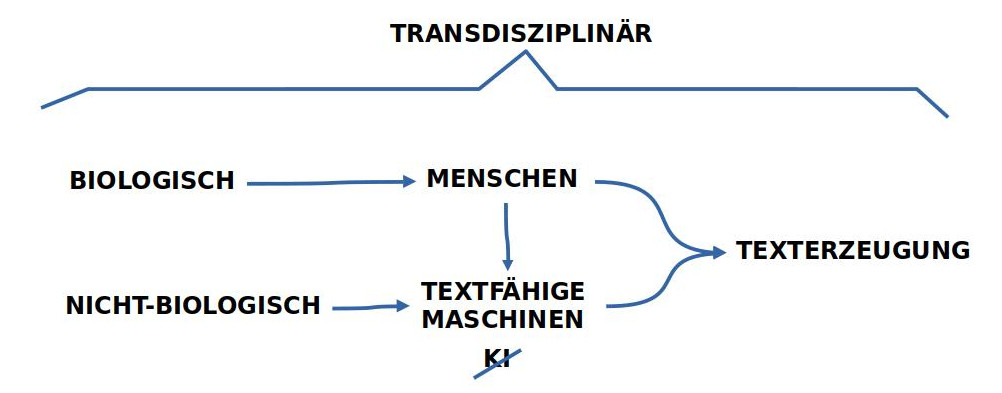

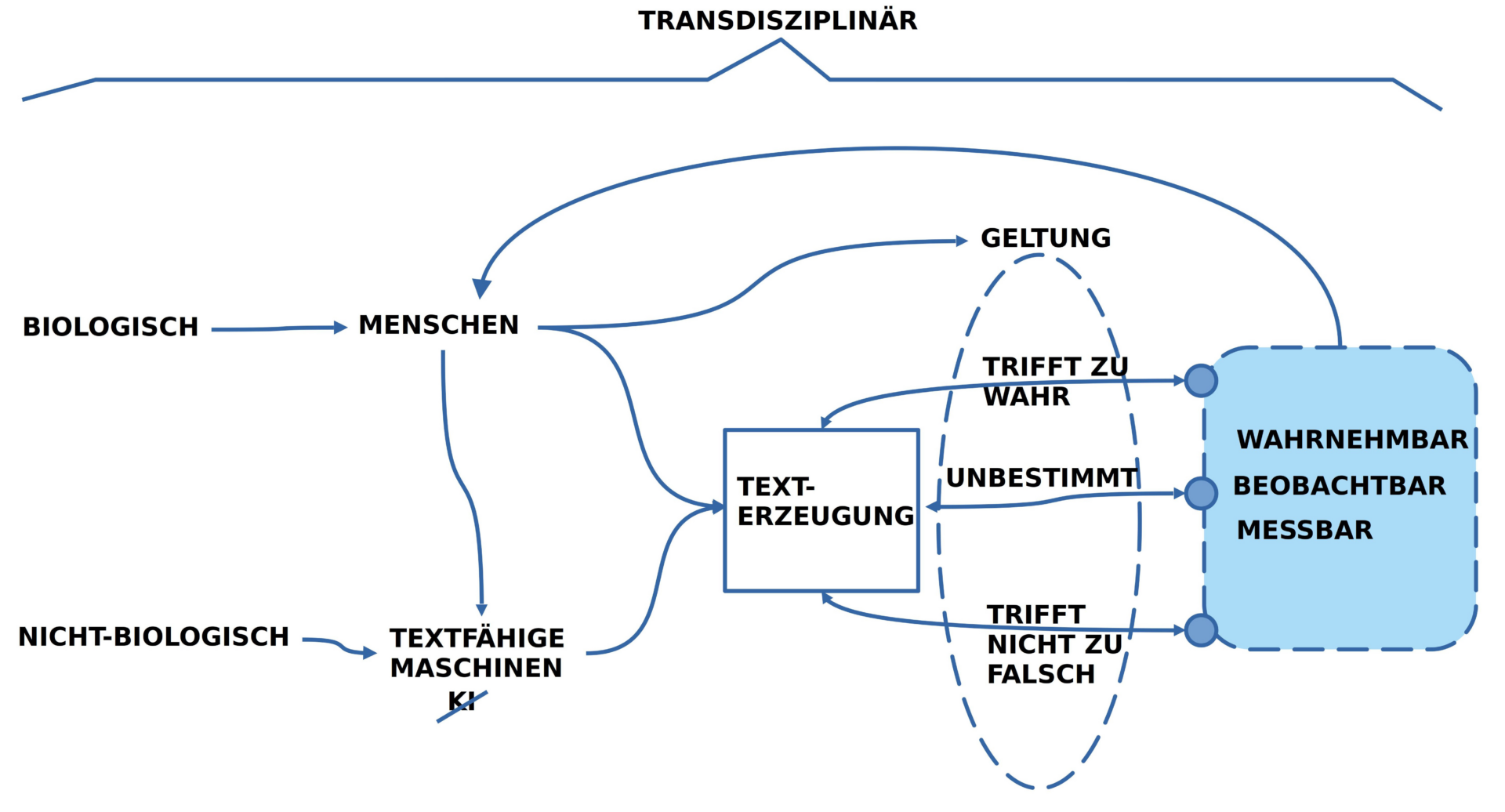

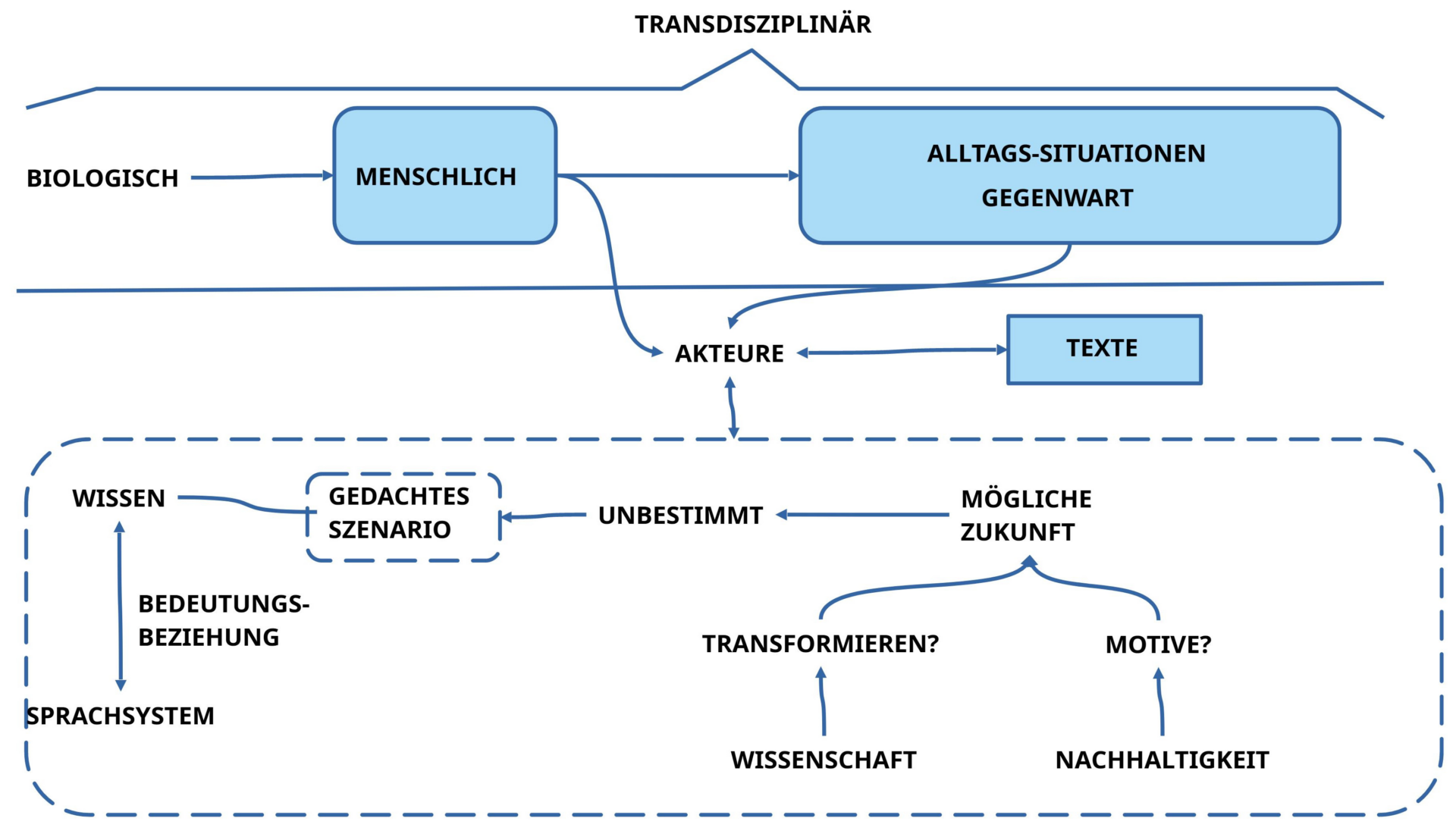

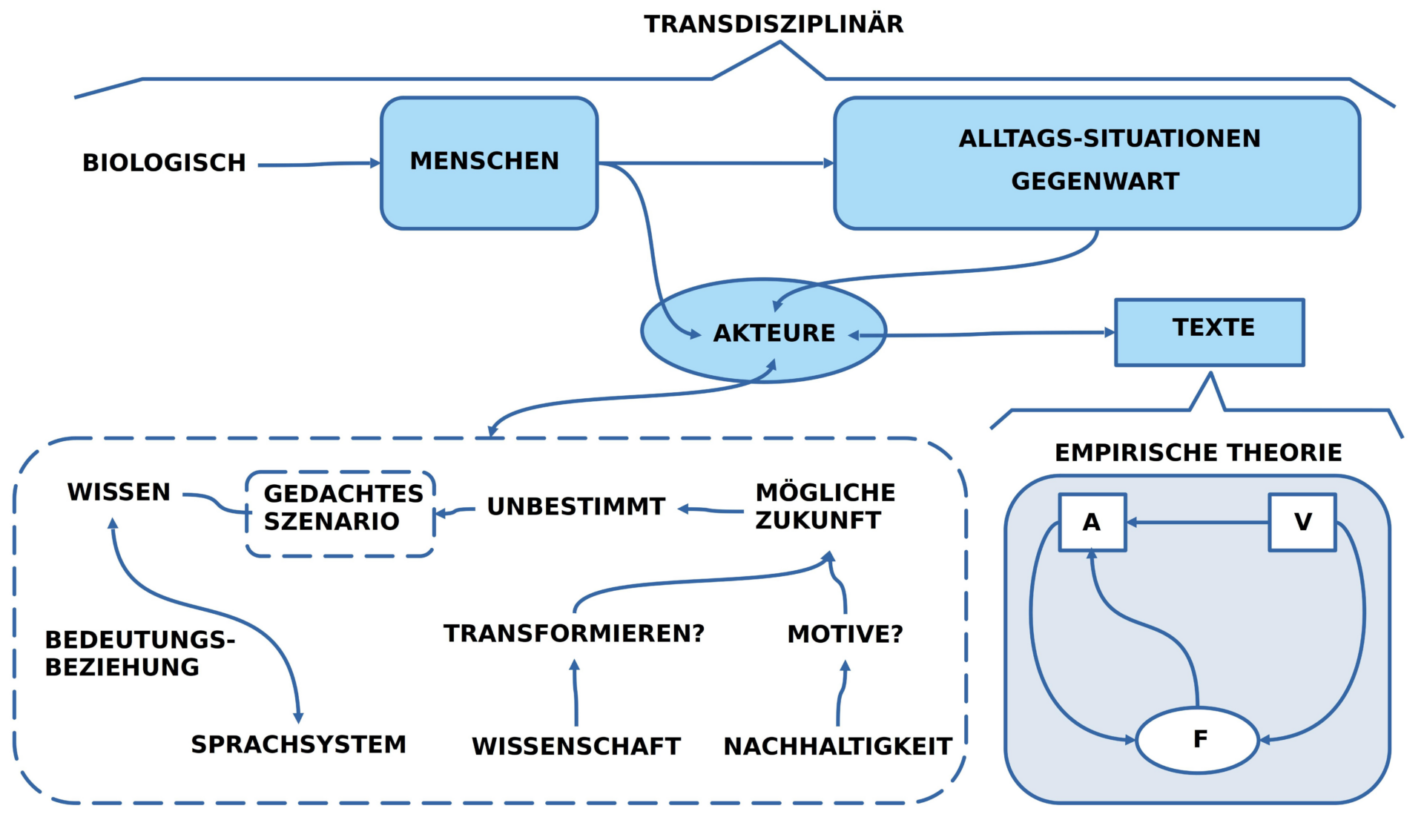

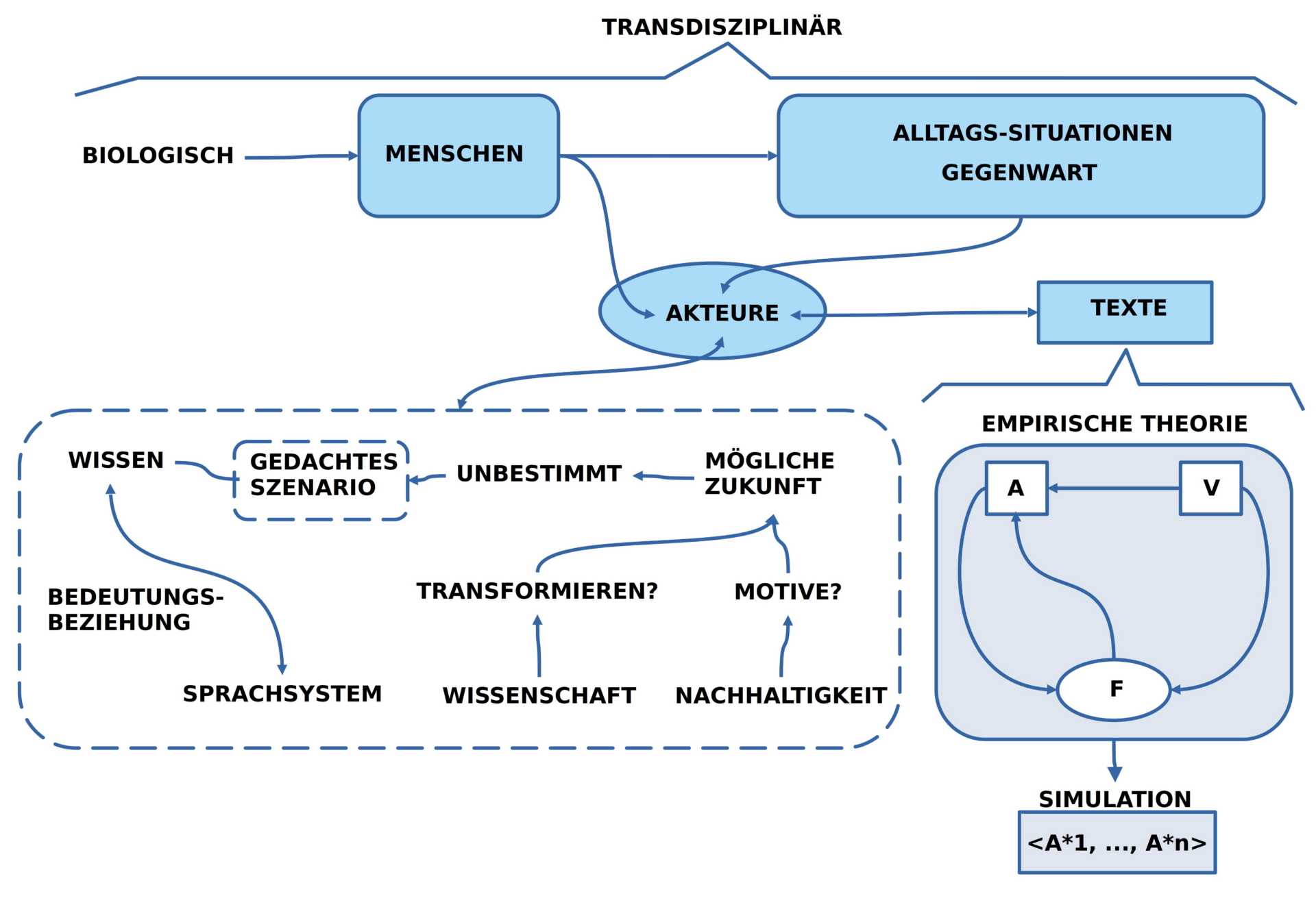

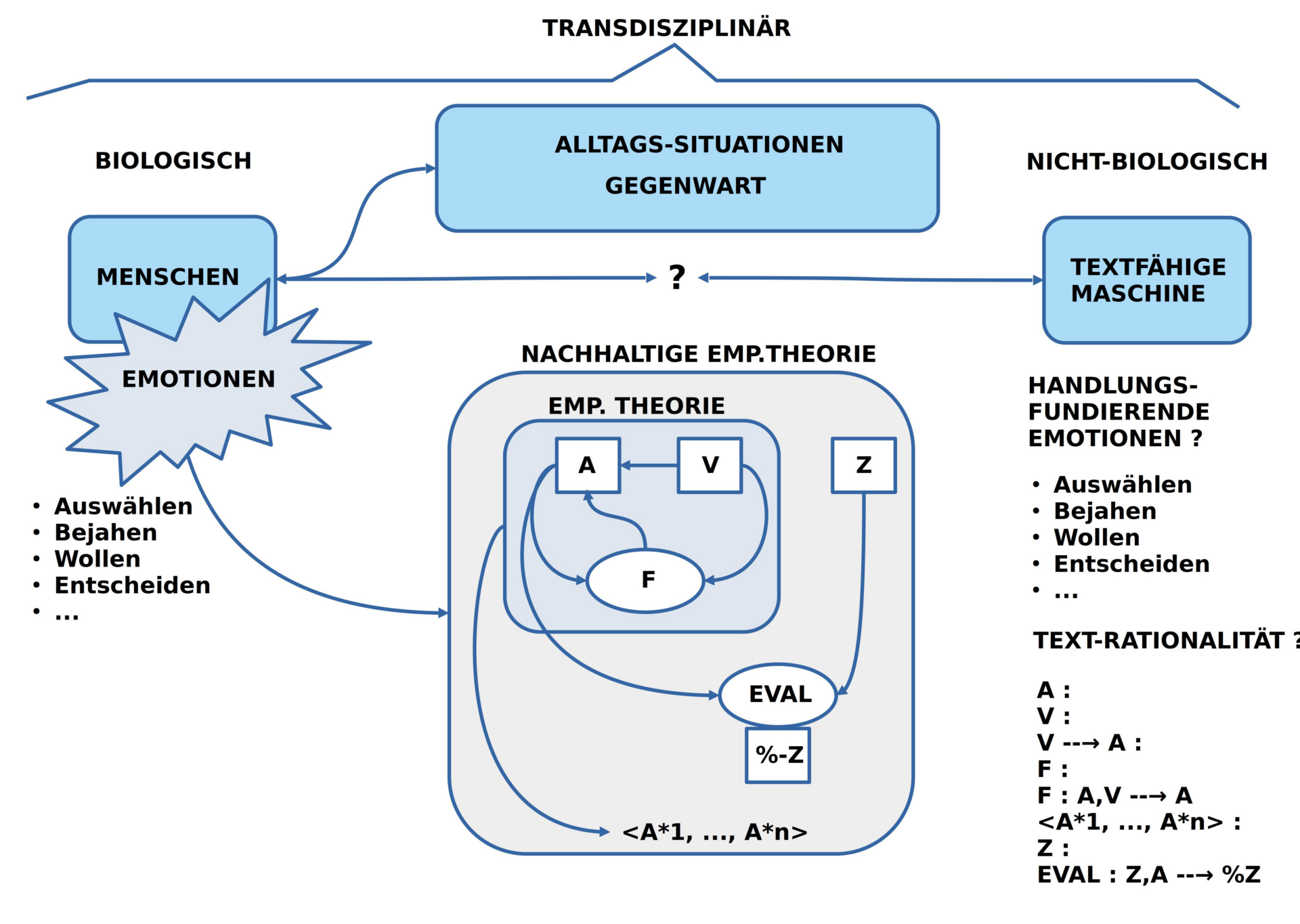

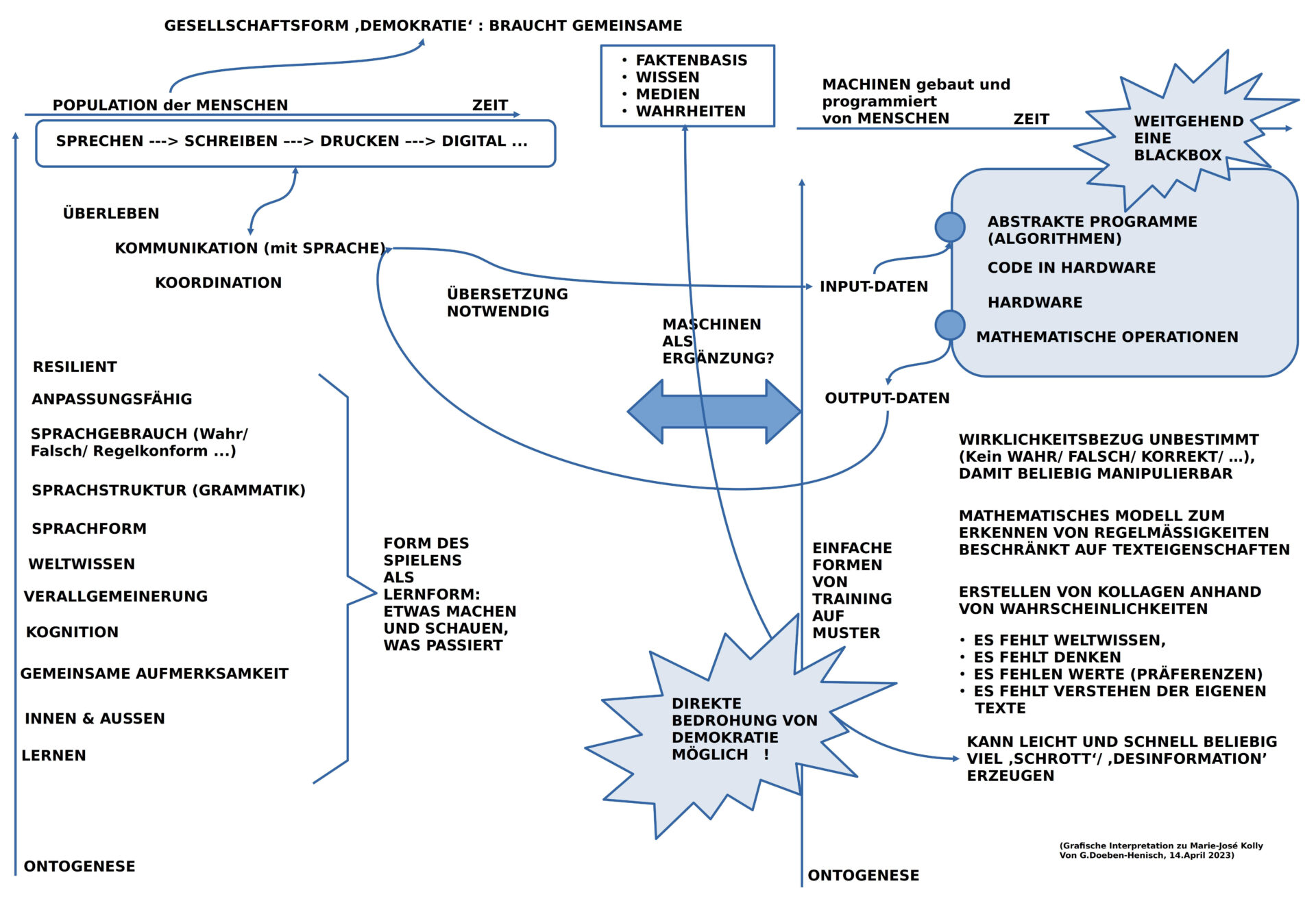

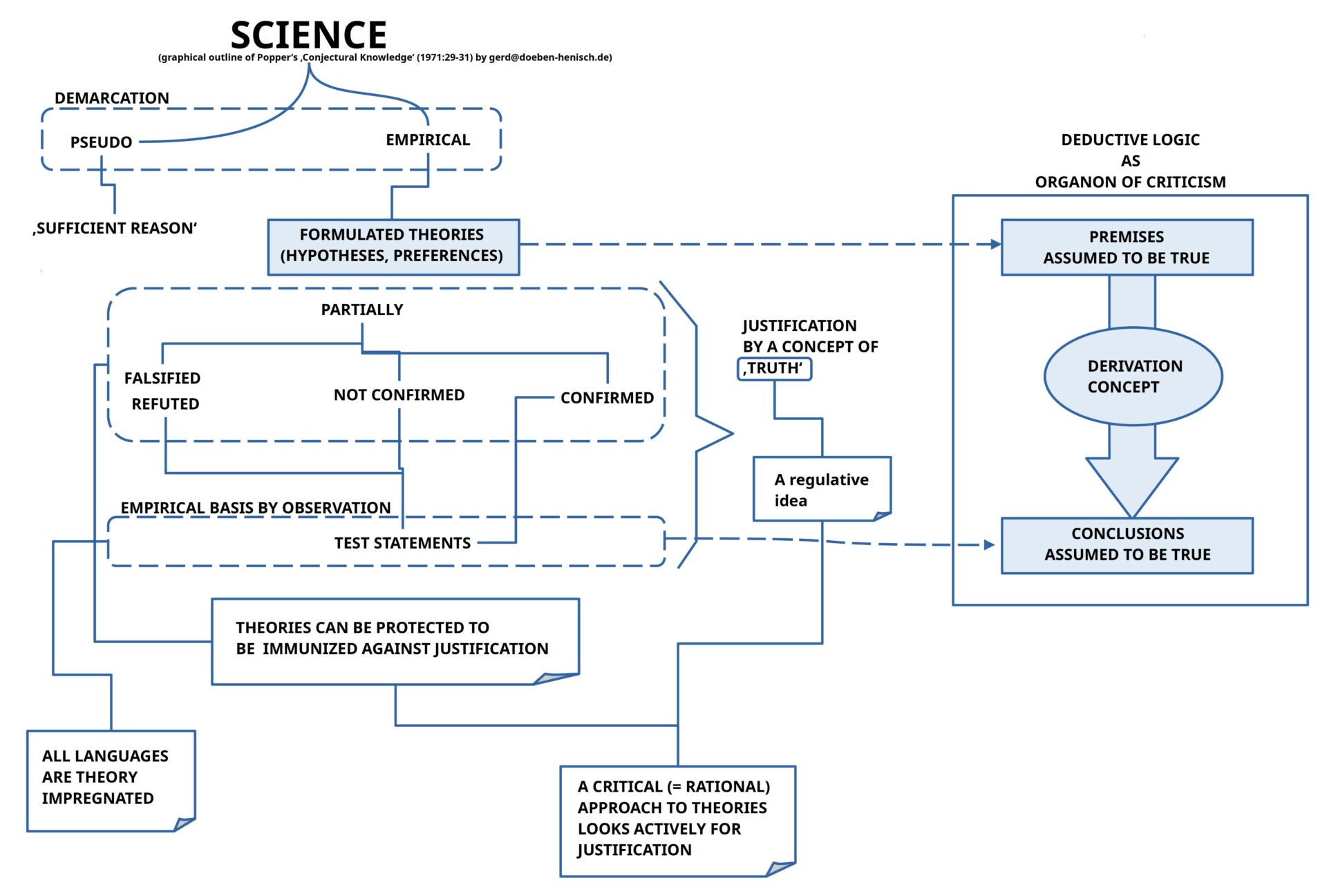

OK, dann sieht es so aus, dass wir bis zu diesem Punkt eine gemeinsame Einschätzung gefunden haben. In der Tat möchte ich von diesem Punkt aus die gefundenen Position gerne in folgenden Dialogen weiter entwickeln. Praktische Frage: kannst Du auch mit ‚Schaubildern‘ umgehen oder sollen wir die heraus lassen?

Es ist großartig, dass wir eine gemeinsame Grundlage für unsere Diskussionen gefunden haben! Ich kann definitiv helfen, Schaubilder zu erstellen und zu interpretieren. Diese können sehr nützlich sein, um komplexe Konzepte und Zusammenhänge visuell darzustellen und zu veranschaulichen.

Wenn du spezifische Ideen oder Konzepte hast, die du in einem Schaubild visualisieren möchtest, lass es mich wissen. Ich kann dir dabei helfen, diese grafisch umzusetzen. Egal ob es sich um Flussdiagramme, Venn-Diagramme, konzeptuelle Diagramme oder andere visuelle Darstellungen handelt, wir können sie nutzen, um deine Gedanken und Theorien weiter zu entwickeln und zu diskutieren. Wie möchtest du beginnen?

Das mit den Schaubildern klingt gut. Werde es in den folgenden Dialogen mal ausprobieren, allerdings mit dem Motto: Zuerst die sprachliche Version, dann – möglicherweise – eine bildhafte Version. Danke bisher. Das war alles sehr inspirierend.

Das klingt nach einem ausgezeichneten Plan! Es freut mich sehr, dass unsere Gespräche inspirierend waren. Wenn du bereit bist, die Themen weiter zu vertiefen oder ein Schaubild zu erstellen, stehe ich jederzeit bereit, um weiterzumachen. Viel Spaß bei deinen weiteren Überlegungen, und bis zum nächsten Mal!