Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 12.Okt. 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

Gerald M.Edelman, Bright Air, Brilliant Fire. On the Matter of the Mind, New York: 1992, Basic Books

BISHER

Für die bisherige Diskussion siehe die kumulierte Zusammenfassung HIER.

KURFASSUNG

Aus wissenschaftsphilosophischer Sicht ist das Kapitel 10 sehr aufschlussreich. Der in den vorausgehenden Kapiteln immer wieder angedeutete Brückenschlag zwischen Physiologie (mit Gehirnforschung) und Psychologie (verhaltensorientiert) wird in diesem Kapitel ein wenig ‚anfassbarer‘. Allerdings nicht in dem Sinne, dass der Brückenschlag nun explizit erklärt wird, aber so, dass einerseits die Begrifflichkeit auf psychologischer Seite und andererseits die Begrifflichkeit auf physiologischer Seite etwas ausdifferenziert wird. Die Beschreibung der Beziehung zwischen beiden Begrifflichkeiten verbleibt im Bereich informeller Andeutungen bzw. in Form von Postulaten, dass die zuvor geschilderte physiologische Maschinerie in der Lage sei, die angedeuteten psychologischen Strukturen in ihrer Dynamik zu ‚erklären‘.

KAP.10 Gedächtnis und Konzepte (‚Memory and Concepts‘): Errichtung einer Brücke zum Bewusstsein (‚Building a Bridge to Consciousness‘)

-

Nach den vorbereitenden Kapiteln 1-9 versucht Edelman mit den soweit formulierten Grundlagen nun ‚höhere‘ Hirnleistungen und ‚psychologische (=verhaltensbasierte)‘ Eigenschaften durch Rückgriff auf die evolutionären und neuronalen Mechanismen zu ‚erklären‘.

-

Der Ausgangspunkt der Überlegungen in Kap.10 bilden die Annahmen der vorausgehenden Kapitel, dass die ‚Welt‘ ‚außerhalb‘ eines Organismus ein überwältigendes Ereignisfeld ist, das vom wahrnehmenden Organismus erst einmal ’strukturiert‘ werden muss, damit der Organismus mit diesen Ereignisfeldern konstruktiv umgehen kann. Es stellen sich in diesem Kontext folgende Fragen: (i) welche Strukturierungen nimmt ein Organismus vor, und (ii) wie konnten sich jene Mechanismen ausbilden, die solche Strukturierungen ermöglichen? Zusätzlich ist zu bedenken, dass sich die außer-organismischen Ereignisfelder – kontinuierlich wie auch disruptiv – ändern. Es reicht also nicht, die Fähigkeit der Herausbildung solcher strukturierenden Mechanismen einmalig anzunehmen, sondern (iii) es muss auch geklärt werden, wie es zu ‚dynamischen Anpassungen‘ der strukturierenden Mechanismen angesichts einer sich ändernden Umwelt kommen kann? Die bisherige Antwort auf die Fragen (i) – (iii) war der Verweis auf (a) evolutionäre Strukturbildung, auf (b) embryonale Entwicklung, sowie auf die (c) flexible Verschaltung von neuronalen Karten sowohl durch (c.1) Rückkopplungen wie auch durch (c.2) Hierarchiebildungen. Mit diesen Annahmen zu einer komplexen dynamischen Maschinerie verbindet Edelman die Überzeugung, dass sich damit alle bekannten komplexen Funktionsleistungen des Gehirns (wie z.B. ‚Gedächtnis‘ (‚memory‘) wie auch beobachtbare psychologische Eigenschaften ‚erklären‘ lassen. (vgl. S.99f)

-

Für das, was nach Edelman ‚erklärt‘ werden soll, benutzt er die Worte ‚Bewusstsein‘, ‚Intentionalität‘, ‚Kategorisierung der Wahrnehmung‘ (‚perceptual categorization‘), ‚Gedächtnis‘ und ‚Lernen‘. Und er spricht im Zusammenhang dieser Wortmarken von ‚höheren Gehirnfunktionen‘ (‚higher brain functions‘). Damit verknüpft Edelman in dieser kurzen Beschreibung zwei methodisch unterschiedliche Betrachtungsweisen: die Begriffe ‚Bewusstsein‘, ‚Intentionalität‘, ‚Kategorisierung der Wahrnehmung‘, ‚Gedächtnis‘ und ‚Lernen‘ gehören normalerweise in den Bereich der verhaltensbasierten Psychologie; der Begriff ‚höhere Gehirnfunktionen‘ dagegen verweist auf den Bereich der Biologie mit den Spezialbereichen Physiologie und darin noch spezieller der Gehirnforschung. Damit findet sich hier die Stelle, wo er die beiden Pole Psychologie und Gehirnforschung verknüpfen möchte. Bemerkenswert ist seine ausdrückliche Feststellung, dass diese 5 mentalen Leistungen, obwohl sie oft ‚getrennt/ isoliert‘ (’separated‘) behandelt werden, doch ‚untrennbare Aspekte einer gemeinsamen mentalen Leistung‘ (‚inseparable aspects of a common mental performance‘) darstellen. Diese Feststellung geht weit über die benannten einzelnen Wortmarken hinaus. Aus dieser Feststellung folgt, dass wir es hier mit 5 unterscheidbaren mentalen ‚Leistungen‘ zu tun haben, die man als ‚Funktionen‘ {f1, …,f5} auffassen kann und sie in einer wissenschaftlichen Sicht auch so auffassen muss; dazu postuliert Edelman eine Superfunktion f*, die sich aus diesen genannten 5 Funktionen ‚zusammensetzt‘ als etwa f* = f1 u … u f5. Sind schon die einzelnen Funktionen – jede für sich – sehr ‚komplex‘ (und bis heute in der Psychologie nur unvollständig erklärt), so führt die postulierte Superfunktion f* in einen Denkbereich, der nur schwer zu fassen ist, und der bislang eigentlich von niemandem theoretisch irgendwie modelliert worden ist. (vgl. S.100) //* Falls es doch irgendwo solch eine Ausarbeitung gibt, wäre ich als Autor für einen Hinweis sehr dankbar! *//

-

Edelman sagt ganz klar, dass es der Bereich des ‚Verhaltens‘ (‚behavior‘, ‚B‘ ) ist, an dem die Bedeutung der drei ‚fundamentalen Funktionen‘ (‚fundamental functions‘) f1 ‚Kategorisierung der Wahrnehmung‘, f2 ‚Gedächtnis‘ und f3 ‚Lernen‘ zu ‚testen‘ sind. Und er sieht auch eine funktionale Abhängigkeit zwischen diesen fundamentalen Funktionen der Art, dass f2 (Gedächtnis) die Funktion f1 (Kategoriale Wahrnehmung) voraussetzt und die Funktion f3 (Lernen) setzt sowohl f1 als auch f2 voraus. Alle drei ‚beeinflussen‘ (‚affect‘) das Verhalten ‚B‘, weil sie sich untereinander beeinflussen. Angenähert könnte man dann formulieren B = (f1,f2,f3). Nach Edelmann versorgen Wahrnehmen und Gedächtnis das System mit grundlegenden Datenstrukturen, und Lernen kann daraus neue, weiterreichende Strukturen ableiten. Dann stellt Edelman plötzlich fest, dass die beiden Funktionen f1 und f2 für das Lernen f3 zwar notwendige Voraussetzungen bilden (also: f3 = (f1,f2), aber sie alleine noch nicht ausreichend wären; es bedarf noch einer weiteren Funktionalität fx, also f3=(f1,f2,fx). Diese weitere Funktion fx verweist nach Edelman auf ein ‚Wertesystem‘ (‚value system‘), das von den Kategorisierungsleistungen des Wahrnehmens und Erinnerns unabhängig ist. Wir bekommen damit folgende Zusammenhänge: B = f*() mit f* = (f3,f4,f5) und f3 = (f1,f2,fx). (vgl. S.100)

-

Das ‚Wertesystem‘ fx hat – aus Sicht des Verhaltens B – mehrere Eigenschaften: (i) es basiert auf unterschiedlichen Wertelieferanten fx = (fx1, …, fxn), die (ii) unterschiedliche ‚Erwartungen‘ (‚expectancy‘) als ‚Referenzpunkte‘ (’set points‘) ausbilden können. Diese Erwartungen können als Fitnesswerte in dem Sinne genutzt werden, dass ein Systemverhalten solche Referenzpunkte entweder ‚befriedigt‘ (und damit wieder ‚zurück setzt‘) oder ’nicht befriedigt‘ (und damit ’nicht zurücksetzt‘). Ein Lernen f3 ist ‚erfolgreich‘ (‚is achhieved‘), wenn das System seine ‚Systemzustände‘ (‚IS‘) so arrangieren kann, dass ‚in der Zukunft‘ das Verhalten des Systems bei Auftreten von werthaften Referenzpunkten direkt die ‚richtige Verhaltensantwort‘ findet. Dies impliziert als eine weitere Komponente eine ‚Dauer‘, eine zeitliche Erstreckung zwischen zwei ‚Zeitpunkten‘ (t,t‘) mit t‘ als ’später‘ zu t. Nur unter Voraussetzung einer ‚hinreichend langen‘ Zeitdauer (t,t‘) kann Lernen sich realisieren, also f3(f1,f2,fx,(t,t‘)) = (Success_1, …, Success_n) mit der Bedeutung, dass Lernen innerhalb einer Zeitspanne (t,t‘) dazu führt, dass werthafte Referenzpunkte von fx() mit Hilfe von Wahrnehmung, Wahrnehmungskategorien und Gedächtnis in ‚möglichst kurzer Zeit‘ so bedient werden können, dass sie auf einen ’neutralen Wert‘ zurück gehen. Das exakte Zusammenspiel zwischen einem solchen Lernen f3() und den übrigen Größen f4, f5 und Verhalten ‚B‘ bleibt zunächst offen. (vgl. S.101)

-

Den Zusammenhang zwischen diesen verhaltensbasierten Begriffen – nennen wir sie hier ‚Begriffe_B‘ – und jenen Begriffen, die auf der Theorie der neuronalen Gruppen basiert – nennen wir sie hier ‚Begriffe_NN‘ – sieht Edelman grundsätzlich darin, dass die Begriffe_NN letztlich ein materielles System S_NN beschreiben, das als ein ‚Modell‘ dienen kann, über dem man die Begriffe_B ‚interpretieren‘ kann. Anders ausgedrückt postulirt Edelman hier eine Abbildung der Art: Interpretation_B_NN : Begriffe_B <—> Begriffe_NN. Edelman beschreibt diese Abbildung an dieser Stelle aber nicht wirklich; er unterstellt sie einfach; er nimmt sie an und illustriert sie anhand sehr vager Beispiele. (vgl. S.101)

-

Edelman führt an dieser Stelle noch einen weiteren Prozess (eine Funktion) ‚fc‘ ein, dem er die Fähigkeit zuschreibt, dass dieser auf der Basis von Wahrnehmung (f1) und von Gedächtnis (f2) im Kontext des Lernens (f3) und möglicherweise auch — das sagt er nicht explizit – unter Berücksichtigung des Wertesystems (fx) in der Lage ist, ‚allgemeine Beziehungen‘ (‚general relational properties‘) hervorzubringen (‚to yield‘). Unter Voraussetzung dieser fünf Funktionen {f1, f2, f3, fx, fc} will er dann später zeigen, wie man damit das ‚Auftreten eines Bewusstseins‘ (‚the emergence of consciousness‘) erklären kann. //* Es sei hier darauf hingewiesen, dass die Kozeptualisierungsleistung fc im Rahmen psychologischer Modelle des Gedächtnisses oft als eine Eigenschaft des Gedächtnisses angesehen wird bzw. — was Edelman ja zuvor selbst feststellt – z.T. auch schon als eine Leistung der Wahrnehmung f1. *//

-

Den Rest des Kapitels widmet Edelman zwei Wortmarken: ‚Gedächtnis‘ (‚memory‘) und ‚Konzepte‘ (‚concepts‘).

-

Seine allgemeinste Bedeutungszuschreibung zur Wortmarke ‚Gedächtnis‘ geschieht in der verhaltensbasierten Perspektive der Psychologie, indem er die Wortmarke ‚Gedächtnis‘ verbindet mit der ‚Fähigkeit, ein Verhalten zu wiederholen‘ (f2) (‚ability to repeat a performance‘). Diese Fähigkeit beinhaltet die andere, kurz zuvor eingeführte, Fähigkeit zur Konzeptualisierung fc, die im Rahmen des Gedächtnisses die zu einem bestimmten Zeitpunkt t vorhandenen konzeptuellen Strukturen ISc(t) ‚erweitert‘ (‚enhancement‘), so dass zu einem späteren Zeitpunkt T‘ eine erweiterte konzeptuelle Struktur ISc(t‘) vorliegt.(vgl. S.102)

-

Parallel und zwischen diesen vorausgehenden psychologischen Erklärungen streut Edelman immer wieder auf informelle Weise Bemerkungen ein, wie sich die so beschriebenen psychologischen Strukturen und Funktionalitäten durch seine neuronale Maschinerie S_NN erklären lassen würden. Eine wirkliche Erklärung der hier notwendigen Interpretationsleistung der Art: Interpretation_B_NN : Begriffe_B <—> Begriffe_NN mit Begriffe_NN = S_NN leistet Edelman hier aber nicht. (vgl. S.102)

-

Edelman verweist ferner auf das sich im Verhalten manifestierende Phänomen, dass Konzeptualisierungen, die wir als ‚Kategorien‘ auffassen und nutzen, nicht statisch sondern ‚dynamisch‘ sind, d.h. der Prozess des Anordnens läuft kontinuierlich und neue Ereignisse können bisherige Anordnungen ‚überschreiben‘, ‚ergänzen‘. (vgl. S.102)

-

Wie schon zuvor bemerkt, ist die Einführung der eigenständigen Kategorisierungsleistung (Konzeptbildung) fc im Rahmen des Gedächtnisses in ihrer Beziehung zu der vorausgehenden Kategorisierungsleistung f1 in der Wahrnehmung nicht klar beschrieben. Und auf S.104 charakterisiert er die Kategorisierungsleistung der Wahrnehmung f1 als ‚zufallsgesteuert‘ (‚probabilistic‘) und als die ‚initiale Basis‘ (‚initial basis‘) des Gedächtnisses f2 und — das muss man hier unterstellen – der weiteren Kategorisierungsleistung fc des Gedächtnisses. Allgemeine, sich im Verhalten manifestierende psychologisch begründete Begriffe wie ‚Assoziation‘, ‚Ungenauigkeit‘ (‚inexactness‘), sowie ‚Generalisierung‘, sieht Edelman als Ergebnis dieser vorausgesetzten f1, f2 und fc Leistungen.(vgl. S.104)

-

Edelman betont ausdrücklich, dass das ‚Gedächtnis‘ f2 über die Fähigkeit verfügt, die ‚zeitliche Abfolge von Ereignissen‘ zu ’notieren‘ (‚to account of‘).(vgl. S.104)

-

Nachdem Edelman eine Reihe von psychologisch motivierte Wortmarken – wie z.B. {f1, f2, f3, fx, fc} – eingeführt hatte, die das verhaltenspsychologische Begriffsfeld Begriffe_B bilden, führt er nun weitere, neue Wortmarken aus dem Bereich des Gehirns ein, die alle zum physiologisch motivierten Begriffsfeld Begriffe_NN gehören. Sein Motiv für diese begrifflichen Erweiterungen ist, dadurch mehr begriffliche Möglichkeiten zu bekommen, um die Interpretationsfunktion Interpretation_B_NN : Begriffe_B <—> Begriffe_NN zu differenzieren.

-

Er beginnt mit der Einführung der Begriffe ‚Cortex‘ (Cx), ‚Cerebellum‘ (Cm), ‚Hippocampus‘ (Hp), und ‚Basal Ganglia‘ (Bg), wobei Cm, Hp und Bg den Prozess des Cortex im Bereich des ‚räumlichen und zeitlichen Ordnens‘ unterstützen, was Edelman in Verbindung sieht mit den psychologisch beschriebenen Leistungen des Gedächtnisses. (vgl. S.104) Auf der nächsten Seite erwähnt er auch noch den ‚Motor Cortex‘ (Cxm), der als Teil des Cortex eng mit den zuvor genannten Strukturen kooperiert. (vgl. S.105)

-

Bemerkenswert ist, dass Edelman bei der Charakterisierung der Leistungen der genannten Gehirnstrukturen auf psychologische Begriffe zurückgreift, z.B. wenn er vom Cerebellum Cm sagt, dass es eine wichtige Rolle spiele bei der ‚zeitlichen Ordnung‘ und einem ‚möglichst kontinuierlichen Verlauf‘ von Bewegungen (‚timing and smoothing of successions of movements‘). Letztlich kennen wir primär nur ein beobachtbares Verhalten und dessen Eigenschaften. Und es ist natürlich ein solches beobachtbares Verhalten (Gegenstand der Psychologie) als eine Art ‚Referenzpunkt‘ zu nehmen, um zu schauen, welche physiologischen Prozesse und welche zugehörigen physiologische Strukturen – wie z.B. das Cerebellum – im Kontext eines solchen beobachtbaren Verhaltens auftreten. Sofern es gelingt (was methodisch und messtechnisch extrem schwierig ist), eine irgendwie statistisch signifikante Korrelation zwischen physiologischen Messwerten und psychologischen Beobachtungswerten zu erfassen, kann man feststellen, dass z.B. das Cerebellumg Cm ‚eine wichtige Rolle spiele bei‘. Ohne ein explizites psychologisches Referenzmodell Begriffe_B wäre eine solche Korrelation ’spielt eine Rolle bei‘ nicht möglich. Dabei reicht es auch nicht aus, irgendwelche isolierte physiologische Messwerte zu haben, sondern man benötigt ein komplettes physiologisches Referenzmodell Begriffe_NN, das von den physiologischen Messwerten motiviert wird, das man mit dem psychologischen Referenzmodell Begriffe_NN in Beziehung setzt. Man müsste dann verfeinert sagen: (i) aufgrund von psychologischen Verhaltensdaten DAT_B generieren Psychologen ein psychologisches Referenzmodell Begriffe_B; (ii) aufgrund von physiologischen Messwerten DAT_NN generieren Physiologen (Gehirnforscher) ein physiologisches Referenzmodell Begriffe_NN; (iii) In einem interdisziplinären Team wird eine Interpretationsfunktion Interpretation_B_NN : Begriffe_B <—> Begriffe_NN konstruiert, die einen Zusammenhang herstellt zwischen psychologischen Verhaltensdaten und physiologischen Messwerten.(vgl. S.104f)

-

Auf der Verhaltensebene unterscheidet Edelman zwischen der ‚einzelnen Handlung‘ mit deren zeitlicher und kontinuierlicher Ausführung einerseits und ‚zeitlich sich erstreckenden Handlungsfolgen‘. Diese längeren, komplexeren – psychologisch charakterisierten — ‚Handlungsfolgen‘ bringt er in Verbindung mit der physiologischen Struktur genannt ‚Basal Ganglia‘ Bg. Eine solche komplexe Funktion wie ‚Handlungsplanung‘ (fd) interagiert mit sehr vielen unterschiedlichen anderen Funktionen, u.a. auch mit dem Wertesystem fx.(vgl. S.105f)

-

Für die Charakterisierung der nächsten physiologischen Struktur Hippocampus (Hp) benötigt Edelman weitere psychologische Begriffe, die er bislang noch nicht eingeführt hatte: er unterscheidet bei der psychologischen Funktion des Gedächtnisses (f2) zwischen eine ‚Kurzzeit-Gedächtnis‘ (’short-term memory‘) (Mst) und einem ‚Langzeit-Gedächtnis‘ (‚long-term memory‘) (Mlt). Zwischen diesen beiden psychologischen Formen des Gedächtnisses gib es spezifische Interaktionsmuster. Eines hat damit zu tun, dass Elemente des Kurzzeitgedächtnisses in das Langzeitgedächtnis ‚übernommen‘ werden. Und mit Bezug auf dieses psychologische Referenzmodell sieht Edelman den Hippocampus mit beteiligt. Der Hippocampus empfängt von allen Teilen des Cortex Signale, auch vom Wertesystem fx, und schickt seine Prozesswerte auch wieder zu den sendenden Stellen zurück.(vgl. S.106f)

-

Abschließend zu den genannten Strukturen ‚Cortex‘ (Cx), mit ‚Motor-Cortex (Cxm), ‚Cerebellum‘ (Cm), ‚Hippocampus‘ (Hp), und ‚Basal Ganglia‘ (Bg) meint Edelman, dass die Differenziertheit und Flexibilität dieser Strukturen – kondensiert in einem physiologischen begrifflichen Modell Begriffe_NN – ausreicht, um das zuvor erstellte psychologische Referenzmodell des Verhaltens zu erklären.(vgl. S.107f)

-

An dieser Stelle kommt Edelman nochmals zurück auf die Wortmarke ‚Konzepte‘ (‚concepts‘) und grenzt seine Verwendung dieser Wortmarke ab von jener, in der ‚Konzepte‘ in einem rein linguistischen Kontext gesehen wird. Für Edelman sind ‚Konzepte‘ Ordnungsstrukturen (Kategorien), durch die der Strom der Wahrnehmungen und der Gedächtnisinhalte, immer wieder neu geordnet werden können, vorab zu jeder Sprache, als Voraussetzung für Sprache. Das System gewinnt dadurch die Möglichkeit, sein Verhalten mit Bezug auf diese Strukturen neu zu kontrollieren. (vgl. S.108)

-

Das Besondere an der Konzeptualisierungsfähigkeit ist, dass sie auch unabhängig von aktuellen Stimuli stattfinden kann, dass sie sich auf ‚alles‘ anwenden kann, was im Wahrnehmen, Erinnern und Denken vorkommen kann. Dies bedeutet, die Konzeptualisierungsfähigkeit kann ihre eigenen Ergebnisse, so abstrakt sie auch sein mögen, zum Gegenstand einer späteren Aktivität machen. //* Mathematiker nennen solch eine Struktur ‚rekursiv‘ *// Solche ‚abstrakteren‘ Strukturen (Konzepte) benötigen auch keine ‚topographischen‘ Strukturen, wie man sie im Bereich der sensorischen Wahrnehmung findet. Dies hat zur Folge, dass auch nicht-topographische Ereignisse wie z.B. systemrelevante ‚Werte‘ (über Bedürfnisse wie Hunger, Durst,…) in die Strukturierung einbezogen und damit verhaltensrelevant werden können. (vgl. S.108-110)

-

Erstaunlich ist, dass Edelman an dieser Stelle nun eine Wortmarke einführt, die weder dem physiologischen Sprachspiel zugehört, noch dem psychologischen, sondern dem philosophischen Sprachspiel sofern es auf den Raum subjektiver Phänomene fokussiert ist: ‚Intentionalität‚, indem er sagt, dass die konzeptuellen Strukturbildungen ‚intentional‚ (‚intentional‘) sind. Und Edelman geht noch weiter; er sieht hier einen ‚Übergang‘, eine ‚Brücke‘ (‚the bridging elements‘) von der Physiologie zum ‚Bewusstsein‚ (‚consciousness‘) und er stellt ausdrücklich fest, dass für diesen Brückenschlag ‚keine neuen theoretischen Annahmen‘ (’no new theoretical assumptions‘) gemacht werden müssen. Diese letzte Bemerkung trifft zu, wenn man sie auf die vorausgesetzte physiologische Maschinerie bezieht: das physiologische Modell Begriffe_NN wird nicht verändert. Mit der Einführung der Wortmarken ‚Intentional‘ und ‚Bewusstsein‘ aktiviert er aber ein neues (philosophisches) Sprachspiel, das er bislang nicht benutzt hat, und das er bislang in keiner Weise erklärt hat. Man müsste hierfür auch einen eigenen Begriff Begriffe_PH einführen vergleichbar zu Begriffe_B und Begriffe_NN und man müsste natürlich auch hier explizite Interpretationsfunktionen einführen wie Interpretation_B_PH : Begriffe_B <—> Begriffe_PH sowie Interpretation_NN_PH : Begriffe_NN <—> Begriffe_PH.

DISKUSSION FORTSETZUNG: KAP.10

-

Aus wissenschaftsphilosophischer Sicht ist das Kapitel 10 sehr aufschlussreich. Der in den vorausgehenden Kapiteln immer wieder angedeutete Brückenschlag zwischen Physiologie (mit Gehirnforschung) und Psychologie (verhaltensorientiert) wird in diesem Kapitel ein wenig ‚anfassbarer‘. Allerdings nicht in dem Sinne, dass der Brückenschlag nun explizit erklärt wird, aber so, dass einerseits die Begrifflichkeit auf psychologischer Seite und andererseits die Begrifflichkeit auf physiologischer Seite etwas ausdifferenziert wird. Die Beschreibung der Beziehung zwischen beiden Begrifflichkeiten verbleibt im Bereich informeller Andeutungen bzw. in Form von Postulaten, dass die zuvor geschilderte physiologische Maschinerie in der Lage sei, die angedeuteten psychologischen Strukturen in ihrer Dynamik zu ‚erklären‘.

-

Am Ende des Kapitels 10, mehr nur in Form einer kurzen Andeutung, in einer Art Fußbote, bringt Edelman noch die Begriffe ‚Intentionalität‘ und ‚Bewusstsein‘ ins Spiel, allerdings ohne jedwede Motivation, ohne jedwede Erklärung. Diese Begriffe entstammen einen ganz anderen Sprachspiel als dem zuvor besprochenen physiologischen oder psychologischem Sprachspiel; sie gehören zum philosophischen Sprachspiel, und die Behauptung Edelmans, dass man auch diese Wortmarken aus dem philosophischen Sprachspiel in ein Erklärungsmuster einbeziehen könnte, das seine Grundlage in dem physiologischen Modell Begriffe_NN habe, ist an dieser Stelle ein reines Postulat ohne jeglichen Begründungsansatz.

-

Wissenschaftsphilosophisch kann man hier festhalten, dass man drei Sprachspiele unterscheiden muss:

-

Ein psychologisches Sprachspiel, das von Verhaltensdaten DAT_B ausgeht, und relativ zu diesen Begriffsnetzwerke Begriffe_B einführt (Modelle, Theorien), um die Verhaltensdaten zu erklären.

-

Ein physiologisches Sprachspiel, das von physiologischen Daten DAT_NN ausgeht, und relativ zu diesen Begriffsnetzwerke Begriffe_NN einführt (Modelle, Theorien), um die Prozesse der physiologischen Strukturen (Gehirn) zu erklären.

-

Ein phänomenologisches Sprachspiel (Teilbereich der Philosophie), das von phänomenologischen Daten DAT_PH ausgeht, und relativ zu diesen Begriffsnetzwerke Begriffe_PH einführt (Modelle, Theorien), um die Prozesse der phänomenologischen Strukturen (Bewusstsein) zu erklären.

-

-

Diese Sprachspiele kann man isoliert, jedes für sich betreiben. Man kann aber auch versuchen, zwischen den verschiedenen Sprachspielen ‚Brücken‘ zu bauen in Form von ‚Interpretationsfunktionen‘, also:

-

Zwischen Psychologie und Physiologie: Interpretationsfunktion Interpretation_B_NN : Begriffe_B <—> Begriffe_NN

-

Zwischen Psychologie und Phänomenologie: Interpretationsfunktion Interpretation_B_PH : Begriffe_B <—> Begriffe_PH

-

Zwischen Phänomenologie und Physiologie: Interpretationsfunktion Interpretation_PH_NN : Begriffe_PH <—> Begriffe_NN

-

-

Man muss festhalten, dass es bis heute (2018) solche Interpretationsfunktionen als explizite Theorien noch nicht gibt; genauso wenig gibt es die einzelnen Theorien Begriffe_X (X=B, PH, NN) als explizite Theorien, obgleich es unfassbare viele Daten und partielle (meist informelle) Beschreibungen gibt.

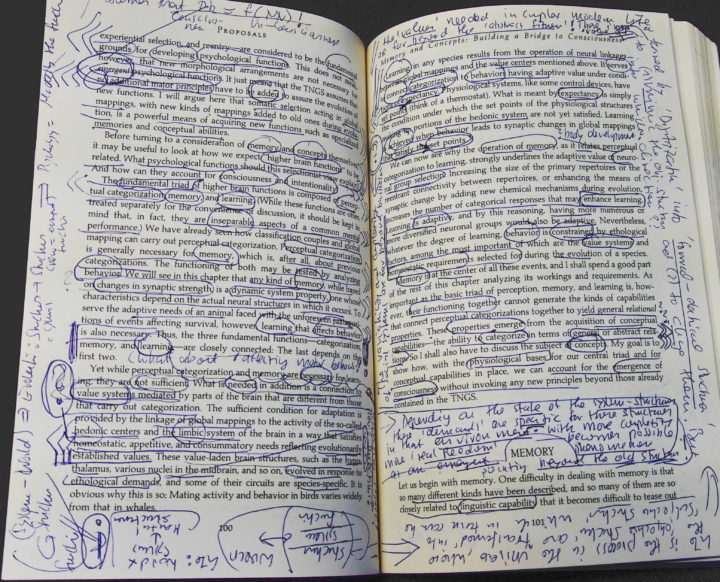

ANHANG: BILD VON ANGESTRICHENEN BUCHSEITEN

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER.