- In dem Beitrag Digitalisierung und die Religionen vom 9.März 2016 gibt es neben vielen anderen Motiven zwei Motive, die besonders hervortreten: einmal das Momentum (i) kombinatorischer Räume, die gefüllt werden können, und zum anderen (ii) das Momentum der Auswahl, welche Teilräume wie gefüllt werden sollen.

KOMBINATORISCHER RAUM BIOLOGISCHE ZELLE

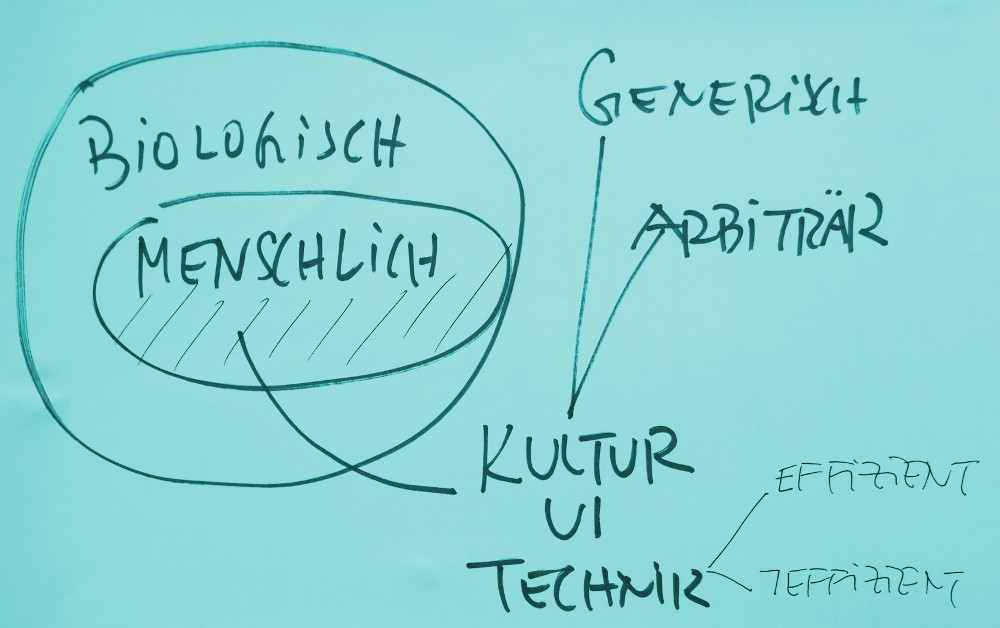

- Im Rahmen der biologischen Evolution auf Zellebene z.B. eröffnet sich der kombinatorische Raum an verschiedenen Stellen. Eine ist jene, wo das Übersetzungsmolekül (das Ribosom) von den gespeicherten potentiellen Informationen (DNA mit ihren Abwandlungen) eine Transformation in andere Moleküle (Proteine) überleitet , mit denen sich neue Zellstrukturen aufbauen lassen. Die Verfügbarkeit dieser Proteine, ihre chemischen Eigenschaften und die Umgebungseigenschaften definieren einen potentiellen kombinatorischen Raum, von dem im konkreten Übersetzungsprozess dann ein bestimmter Teilraum ausgewählt wird.

- Aber auch schon der potentielle Informationsspeicher (realisiert mittels DNA-Molekülen) selbst, wie auch seine verschiedenen Transformationsprozesse bis zum Übersetzungsprozess in Proteine repräsentieren ebenfalls kombinatorische Räume, deren Realisierung viel Spielraum zulässt.

- Man könnte diese molekülbasierte Informationsspeicherung, diese Transformationen der Moleküle, als eine Urform des Denkens ansehen: Moleküle fungieren als Repräsentanten möglicher Konstruktionsprozesse, und diese Repräsentanten können verändert, rekombiniert werden zu neuen Strukturen, die dann zu neuen Konstruktionsprozessen führen. Man hat also – vereinfacht – ein Funktion der Art repr: M_inf x M_tr x MMprot —> Z, d.h. die Reproduktionsfunktion repr die mittels Molekülen, die als Informationsträger fungieren (M_inf), mittels Molekülen (M_tr), die als Übersetzer fungieren und Molekülen (MM_prot), die als Proteine fungieren können, daraus neue Zellstrukturen entstehen lassen kann.

GELIEHENE PRÄFERENZEN

- So wundersam diese Urform des Denkens immer neue kombinatorische Räume strukturell aufspannen und dann im Reproduktionsprozess als reales Strukturen konkretisieren kann, so hilflos und arm ist dieser Mechanismus bei der Beurteilung, Bewertung, welche der möglichen Teilräume denn bevorzugt vor anderen realisiert werden sollten. Soll das Fell weiß oder schwarz sein? Benötigt man überhaupt Zähne? Wozu so komplizierte Hand- und Fingergelenke? Warum tausende Kilometer reisen, um zu brüten? … Die Urform des Denkens ist unfähig, ihre potentielle innere Vielfalt selbständig zu bewerten. Man kann auch sagen, die Urform des Denkens kann zwar kombinieren, ist aber blind wenn es darum geht, gezielt Teilräume auszuwählen, die sich als interessante Kandidaten für das Leben anbieten.

- Dabei ist schon die Wortwahl ‚interessante Kandidaten für das Leben‘ problematisch, da der Begriff Leben eine Schöpfung von Lebewesen ist, die viele Milliarden Jahre später erst auftreten und die versuchen im Nachhinein, von außen, durchtränkt von neuen Bedingungen, die zunächst bedeutungsleere Wortmarke Leben mit Bedeutung zu füllen. Die Urform des Denkens verfügt über keinen externen Begriff von Leben und es gibt keine Ingenieure, die der Urform des Denkens zuflüstern können, was sie tun sollen.

MOLEKÜLE ALS INFORMATIONSSPEICHER IMPLIZITE PRÄFERENZEN

- Allerdings beinhaltet schon die Urform des Denkens über ein Moment, das außerordentlich ist: jene Moleküle (DNA), die als Speicher potentieller Informationen dienen. Zu einem bestimmten Zeitpunkt repräsentieren diese Informations-Moleküle einen eng umgrenzten Teilraum eines kombinatorischen Raumes und wirken für den Übersetzungsprozess wie eine Art Anweisung in Form eines Bauplans. Gemessen an dem theoretisch möglichen kombinatorischen Raum stellt der Plan des Informationsmoleküls eine Auswahl dar, eine Selektion und damit zeigt sich hier eine indirekte Präferenz für die Informationen auf dem Molekül vor allen anderen möglichen Informationen. Die Urform des Denkens kann zwar im Prinzip einen riesigen potentiellen kombinatorischen Raum repräsentieren und transformieren, die konkrete Zelle aber repräsentiert in diesem riesigen Raum einen winzigen Teilbereich, mit einem aktuellen Ausgangspunkt – gegeben durch die aktuellen Informationen auf dem Informationsmolekül M_inf – und potentiellen Veränderungsrichtungen – gegeben durch die Transformationsprozesse einschließlich der verfügbaren Materialien und Pannen im Prozess. Anders formuliert, die Informationsmoleküle repräsentieren eine komplexe Koordinate (KK) im kombinatorischen Raum und die Transformationsprozesse (einschließlich Pannen und Materialien) repräsentieren eine Menge von möglichen Veränderungsrichtungen (DD), an deren Endpunkten dann jeweils neue komplexe Koordinaten KK_neu_1, …, KK_neu_n liegen.

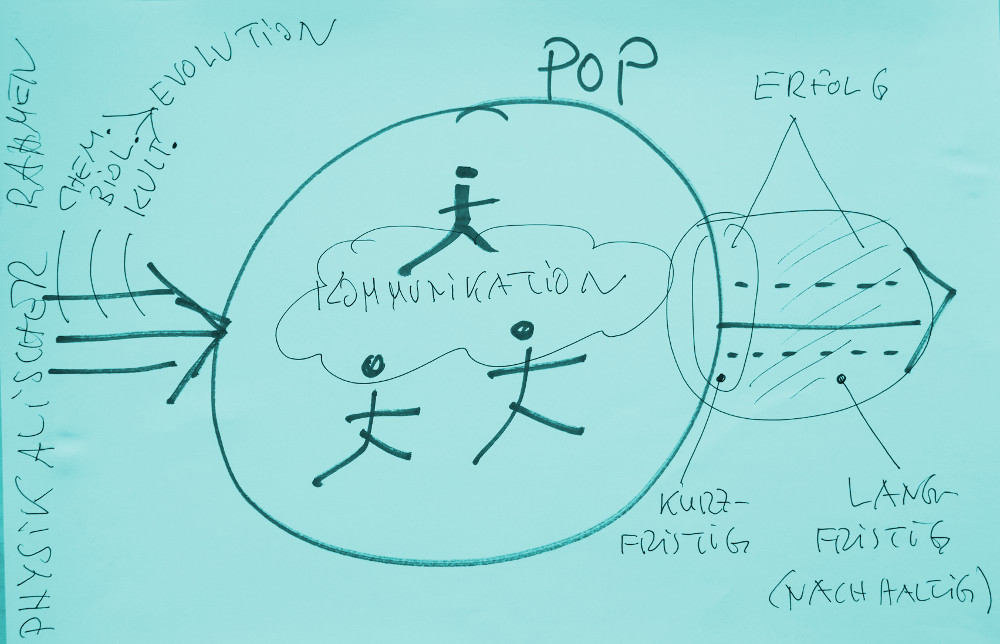

- Wichtig: eine Zelle enthält über die Informationsmoleküle zwar implizite Präferenzen/ Werte, die die Urform des Denkens steuern, diese Präferenzen werden aber nicht von der Zelle selbst generiert, sondern entstehen aus einem Wechselspiel/ aus einer Interaktion mit der Umgebung! Biologische Strukturen (bis heute nur bekannt auf dem Planeten Erde in unserem Sonnensystem in einem geschützten Bereich der Galaxie Milchstraße des uns bekannten Universums) kommen nie isoliert vor, sondern als Teil einer Umgebung, die über sogenannte freie Energie verfügt.

OHNE ENERGIE GEHT NICHTS

- Biologische Zellen sind Gebilde, die für ihre Konstruktion und für ihr Funktionieren solche freie Energie brauchen. Der Umfang ihrer Strukturen wie auch die Dauer ihres Funktionierens hängt direkt und ausschließlich von der Verfügbarkeit solcher freien Energie ab. Bezogen auf den kombinatorischen Raum, der durch die Kombination (Informationsmoleküle, Transformationsmolekül, Bausteine) potentiell gegeben ist, ist unter Berücksichtigung der notwendigen Fähigkeit zum Finden und Verarbeiten von freier Energie nicht neutral! Definieren wir den potentiellen kombinatorischen Raum PKK für biologische Zellen als Raum für mögliche komplexe Koordination KK (also KK in PKK), dann sind im potentiellen kombinatorischen Raum nur jene Teilräume von Interesse, in denen die biologische Zelle über hinreichende Fähigkeiten verfügt, freie Energie zu finden und zu nutzen. Nennen wir die Gesamtheit dieser interessanten Teilräume PKK+, mit PKK+ subset PKK.

GEBORGTE PRÄFERENZEN

- Da die individuelle biologische Zelle selbst über keinerlei explizite Informationen verfügt, wo überall im potentiell kombinatorischen Raum PKK die interessanten Teilräume PKK+ liegen, stellt sie – trotz ihrer eigenen Reproduktionstätigkeit – eher ein passives Element dar, das sich mit geborgten Präferenzen im potentiellen kombinatorischen Raum PKK bewegt, ohne explizit wissen zu können, ob es auf seinem Weg durch den potentiellen kombinatorischen Raum PKK auch tatsächlich auf solche komplexen Koordinaten KK+ stößt, die ihr eine minimale Lebensfähigkeit erlauben.

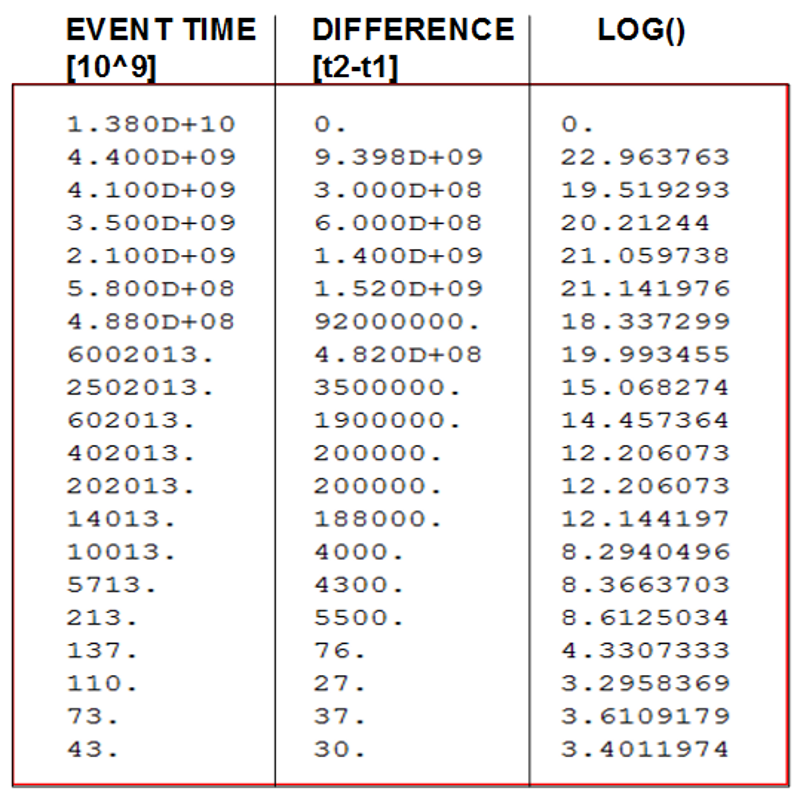

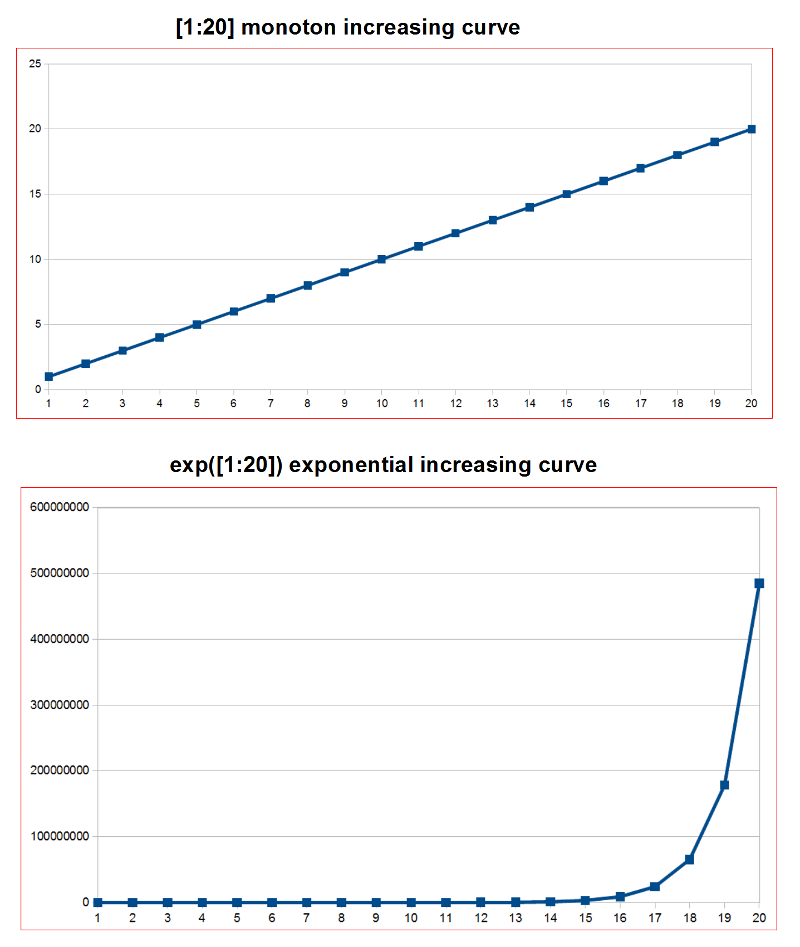

- Da wir vom Jahr 2016 rückwärts blickend wissen, dass diese passiven Elemente es in ca. 4 Mrd Jahren geschafft haben, komplexe Strukturen unvorstellbaren Ausmaßes zu generieren (ein Exemplar des homo sapiens soll z.B. ca. 37 Billionen Körperzellen haben (davon ca. 100 Mrd als Gehirnzellen), dazu ca. 200 Billionen Bakterien in seinem Körper plus ca. 220 Milliarden auf seiner Haut (siehe dazu Kegel-Review Doeben-Henisch), muss man konstatieren, dass die permanente Interaktion zwischen biologischer Zelle und ihrer Umgebung offensichtlich in der Lage war, all diese wichtigen Informationen PKK+ im potentiellen kombinatorischen Raum PKK zu finden und zu nutzen!

- Für die Frage der potentiellen Präferenzen/ Werte gilt für diesen gesamten Zeitraum, dass sich die implizit gespeicherten Präferenzen nur dadurch bilden konnten, dass bestimmte generierte Strukturen (M_inf, M_tr, MM_prot) sich immer von einer positiven komplexen Koordinate zur nächsten positiven Koordinate bewegen konnten. Dadurch konnten die gespeicherten Informationen kumulieren. Aus der Evolutionsgeschichte wissen wir, dass ein Exemplar des homo sapiens im Jahr 2016 eine Erfolgsspur von fast 4 Mrd Jahren repräsentiert, während in diesem Zeitraum eine unfassbar große Zahl von zig Mrd anderen generierte Strukturen (M_inf, M_tr, MM_prot) irgendwann auf eine negative komplexe Koordinate KK- geraten sind. Das war ihr Ende.

ERHÖHUNG DER ERFOLGSWAHRSCHEINLICHKEIT

- Für den Zeitraum bis zum Auftreten des homo sapiens müssen wir konstatieren, dass es Präferenzen/ Werte für ein biologisches System nur implizit geben konnte, als Erinnerung an einen erreichten Erfolg im Kampf um freie Energie. Unter Voraussetzung, dass die umgebende Erde einigermaßen konstant war, war die Wahrscheinlichkeit, von einer positiven Koordinate KK+ zu einer weiteren komplexen Koordinate KK+ zu kommen um ein Vielfaches höher als wenn das biologische System nur rein zufällig hätte suchen müssen. Die gespeicherten Informationen in den Informationsmolekülen M_inf stellen somit sowohl erste Abstraktionen von potentiellen Eigenschaften wie auch von Prozessen dar. Damit war es Anfangshaft möglich, die impliziten Gesetzmäßigkeiten der umgebenden Welt zu erkennen und zu nutzen.

URSPRUNG VON WERTEN

- Es fragt sich, ob man damit einen ersten Ort, einen ersten Ursprung potentieller Werte identifizieren kann.

- Vom Ergebnis her, von den überlebensfähigen biologischen Strukturen her, repräsentieren diese einen partiellen Erfolg von Energienutzung entgegen der Entropie, ein Erfolg, der sich in der Existenz von Populationen von solchen erfolgreichen Strukturen als eine Erfolgsspur darstellt. Aber sie alleine bilden nur die halbe Geschichte. Ohne die umgebende Erde (im Sonnensystem, in der Galaxie…), wäre dieser Erfolg nicht möglich. Andererseits, die umgebende Erde ohne die biologischen Strukturen lässt aus sich heraus nicht erkennen, dass solche biologische Strukturen möglich noch wahrscheinlich sind. Bis heute ist die Physik mehr oder weniger sprachlos, wirkt sie wie paralysiert, da sie mit ihren bisherigen (trotz aller mathematischen Komplexität weitgehend naiven) Modellen nicht einmal ansatzweise in der Lage ist, die Entstehung dieser biologischen Strukturen zu erklären. Von daher müssen wir fordern, dass die umgebende Erde — letztlich aber das gesamte bekannte Universum — die andere Hälfte des Erfolgs darstellt; nur beide zusammen geben das ganze Phänomen. In diesem Fall würde ein reduktiver Ansatz nicht vereinfachen, sondern das Phänomen selbst zerstören!

ONTOLOGISCHE GELTUNG VON BEZIEHUNGEN

- Dies führt zu einem bis heute ungeklärten philosophischen Problem der ontologischen Geltung von Funktionen. In der Mathematik sind Funktionen die Grundbausteine von allem, und alle Naturwissenschaften wären ohne den Funktionsbegriff aufgeschmissen. Eine Funktion beschreibt eine Beziehung zwischen unterschiedlichen Elementen. In der Mathematik gehören diese Elemente in der Regel irgendwelchen Mengen an, die einfach unterstellt werden. Wendet man das mathematische Konzept Funktion auf die empirische Wirklichkeit an, dann kann man damit wunderbar Beziehungen beschreiben, hat aber ein Problem, die in der Mathematik unterstellten Mengen in der Realität direkt erkennen zu können; man muss sie hypothetisch unterstellen. Was man direkt beobachten und messen kann sind nicht die funktionalen Beziehungen selbst, sondern nur isolierte Ereignisse in der Zeit, die der Beobachter in seinem Kopf (Gehirn, Gehirnzellen…) verknüpft zu potentiellen Beziehungen, die dann, wenn sie sich hinreichend oft wiederholen, als gegebener empirischer Zusammenhang angenommen werden. Was ist jetzt empirisch real: nur die auslösenden konkreten individuellen Ereignisse oder das in der Zeit geordnete Nacheinander dieser Ereignisse? Da wir ja die einzelnen Ereignisse protokollieren können, können wir sagen, dass auch das Auftreten in der Zeit selbst empirisch ist. Nicht empirisch ist die Zuordnung dieser protokollierten Ereignisse zu einem bestimmten gedachten Muster/ Schema/ Modell, das wir zur gedanklichen Interpretation benutzen. Die gleichen Ereignisse lassen in der Regel eine Vielzahl von unterschiedlichen Mustern zu. Einigen wir uns kurzfristig mal auf ein bestimmtes Muster, auf den Zusammenhang R(X, …, Z), d.h. zwischen den Ereignissen X, …, Z gibt es eine Beziehung R.

- Biologische Systeme ohne Gehirn konnten solche Relationen in ihrem Informations-Moleküle zwar speichern, aber nicht gedanklich variieren. Wenn die Beziehung R stimmen würde, dann würde sie zur nächsten positiven komplexen Koordinate KK+ führen, was R im Nachhinein bestätigen würde; wenn R aber zu einer negativen komplexen Koordinate KK- führen würde, dann war dies im Nachhinein eine Widerlegung, die nicht mehr korrigierbar ist, weil das System selbst verschwunden (ausgestorben) ist.

- Im Gehirn des homo sapiens können wir ein Beziehungsmuster R(X, …, Z) denken und können es praktisch ausprobieren. In vielen Fällen kann solch ein Interpretationsversuch scheitern, weil das Muster sich nicht reproduzieren lässt, und in den meisten solchen Fällen stirbt der Beobachter nicht, sondern hat die Chance, andere Muster R‘ auszuprobieren. Über Versuch und Irrtum kann er so – möglicherweise irgendwann – jene Beziehung R+ finden, die sich hinreichend bestätigt.

- Wenn wir solch ein positiv bestätigtes Beziehungsmuster R+ haben, was ist dann? Können wir dann sagen, dass nicht nur die beteiligten empirischen Ereignisse empirisch real sind, sondern auch das Beziehungsmuster R+ selbst? Tatsächlich ist es ja so, dass es nicht die einzelnen empirischen Ereignisse als solche sind, die wir interessant finden, sondern nur und ausschließlich die Beziehungsmuster R+, innerhalb deren sie uns erscheinen.

- In der Wechselwirkung zwischen umgebender Erde und den Molekülen ergab sich ein Beziehungsmuster R+_zelle, das wir biologische Zelle nennen. Die einzelnen Elemente des Musters sind nicht uninteressant, aber das wirklich frappierende ist das Beziehungsmuster selbst, die Art und Weise, wie die Elemente kooperieren. Will man dieses Beziehungsmuster nicht wegreden, dann manifestiert sich in diesem Beziehungsmuster R+_zelle ein Stück möglicher und realer empirisches Wirklichkeit, das sich nicht auf seine Bestandteile reduzieren lässt. Es ist genau umgekehrt, man versteht die Bestandteile (die vielen Milliarden Moleküle) eigentlich nur dadurch, dass man sieht, in welchen Beziehungsmustern sie auftreten können.

- Vor diesem Hintergrund plädiere ich hier dafür, die empirisch validierten Beziehungsmuster als eigenständige empirische Objekte zu betrachten, sozusagen Objekte einer höheren Ordnung, denen damit eine ontologische Geltung zukommt und die damit etwas über die Struktur der Welt aussagen.

- Zurück zur Frage der Präferenzen/ Werte bedeutet dies, dass man weder an der Welt als solcher ohne die biologischen Systeme noch an den biologischen Strukturen als solche ohne die Welt irgendwelche Präferenzen erkennen kann. In der Wechselwirkung zwischen Erde und biologischen Strukturen unter Einbeziehung einer Irreversibilität (Zeit) werden aber indirekt Präferenzen sichtbar als jener Pfad im potentiellen Möglichkeitsraum der komplexen Koordinaten KK, der die Existenz biologischer Systeme bislang gesichert hat.

- Dieser Sachverhalt ist für einen potentiellen Beobachter unaufdringlich. Wenn der Beobachter nicht hinschauen will, wenn er wegschaut, kann er diesen Zusammenhang nicht erkennen. Wenn der Beobachter aber hinschaut und anfängt, die einzelnen Ereignisse zu sortieren und versucht, aktiv Beziehungsmuster am Beispiel der beobachteten Ereignispunkte auszuprobieren (was z.B. die Evolutionsbiologie tut), dann kann man diese Strukturen und Prozesse erkennen, und dann kann man als Beobachter Anfangshaft begreifen, dass hier ein Beziehungsmuster R+_zelle vorliegt, das etwas ganz Außerordentliches, ja Einzigartiges im ganzen bekannten Universum darstellt.

Keine direkte, aber eine indirekte, Fortsetzung könnte man in diesem Beitrag sehen.

Einen Überblick von allen Beiträgen des Autors cagent in diese Blog nach Titeln findet sich HIER.