Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 9.Januar 2022, 12:00h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

VORBEMERKUNG

Dieser Text versteht sich als ein ‚Trigger‘, der auf ein Thema verweist, das von Interesse zu sein scheint, ohne dass die vielen Aspekte des Themas hier voll ausgeleuchtet werden (können).

KONTEXT

Im Jahr 2022 hat das Thema ‚Klimaänderung‘ mit den Aspekten ‚Verursachung durch den Menschen‘ und ‚Folgen für den Menschen‘ eine hohe Aufmerksamkeit. Vielfache Phänomene lassen sich als Hinweise für die Realität einer Klimaänderung interpretieren, die vom Menschen mindestens mit verursacht sein sollen [1]. Dennoch bleibt das Thema kontrovers, da es — wie bei jedem komplexen Phänomen — trotz allem offene Fragen geben kann, auch weitere Wirkfaktoren, die man berücksichtigen könnte/ sollte.

Im folgenden Text sollen diese Fragen nicht ‚geschlichtet werden. Es geht vielmehr darum, einige wichtige Aspekte zu thematisieren, die bei der Fokussierung auf den Aspekt ‚Klima‘ alleine leicht übersehen werden können bzw. tatsächlich — in der Öffentlichkeit — aus dem Blick geraten.

KLIMA IM KONTEXT

Blickt man auf die vielen Botschaften von Naturereignissen rund um den Globus mit den heftigen Auswirkungen auf Menschen in ganzen Regionen, dann erscheinen diese Phänomene als Boten eines Klimawandels bedrohlich. Und mit den Hinweisen auf den Menschen als Verursacher von z.B. Treibhausgasen und von massiven Veränderung der Erdoberfläche und der Meere gerät der Mensch selbst immer mehr in den Fokus der Betrachtung.

ANTHROPOZÄN

Seit Jahrzehnten wird diskutiert, ob der immense Einfluss des Menschen auf den Planeten Erde — mit einer deutlichen Beschleunigung seit den 1950er Jahren — mittlerweile nicht so groß ist, dass man diese aktuelle Phase mit einer neuen Erdepochenbezeichnung entsprechend kenntlich machen sollte: Anthropozän. [2],[2b], [3] Noch ist es nicht offiziell.

Erst kürzlich haben sich Forscher zu Wort gemeldet [2c], die diese Art von Benennung irreführend finden. Mit Verweis auf das große erdgeschichtliche ‚Sauerstoffereignis‘ [2a] schlagen sie vor, nicht von einer geologischen ‚Epoche‘ zu sprechen, sondern von einem globalen ‚Ereignis‘, das die Situation auf der Erde für alle Beteiligten verändert.

Die Diskussion ist kontrovers, aber aus Sicht des Autors dieser Zeilen wird die ‚Ereignissicht‘ eher der Prozesshaftigkeit gerecht, um das Wechselspiel zwischen menschlicher Population (als Teil der Biosphäre) und ‚allem anderen‘ zu beschreiben.

ARTENVIELFALT (BIODIVERSITÄT)

Im Kontext der Diskussion um die Wechselwirkung des Menschen mit ‚allem anderen‘ wird nicht nur das aktuell sehr prominente Thema der ‚Klimaänderung aufgrund der Einwirkungen des Menschen‘ diskutiert, sondern auch z.B. das Phänomen der negativen Auswirkungen des Menschen auf die vielen anderen Lebensformen: einmal ‚verdrängt‘ der Mensch viele Arten bis hin zu ihrer völligen Auslöschung; zum anderen führen die bislang erfassten Änderungen des Klimas indirekt ebenfalls zu einem massiven Artensterben.[5], [5b]

ANTHROMES (ANTHROPOGENE BIOME)

Eine Lebensform als solche kann aber nicht ‚einfach so‘ existieren; ihre Existenz verlangt immer nach einer eigenen ‚Umgebung‘, ohne die der notwendige lebenserhaltende Prozess nicht stattfinden kann. Diese Einheit von Lebensraum und spezifischer Lebensform wird allgemein ‚Biom‘ genannt. [6c]

Ein Teilaspekt der Umgebung eines Bioms ist das ‚Land‘, das eine Lebensform benötigt. Da die Lebensform des Homo sapiens mittlerweile mehr als 3/4 der verfügbaren Landflächen für sich vereinnahmt hat [6], [6a], gibt es Vorschläge, das dem Menschen zugeordnete Biom als ‚anthropogenes Biom‘ zu bezeichnen, um seine Sonderrolle zu thematisieren. Abkürzend heißt es u.a. auch ‚Anthrom‘.

Die Grundlegung für das Konzept eines Bioms kann man bei Jakob J. von Uexküll verorten, der mit seinen Untersuchungen 1909 deutlich machte, wie spezifische eine bestimmte Lebensform auf eine bestimmte Umgebung zugeschnitten ist (wobei die jeweils anderen Lebensformen in der Umgebung jeweils auch zur Umgebung gehören). [6d], [6e]

WELT UND ‚WELTBILD‘

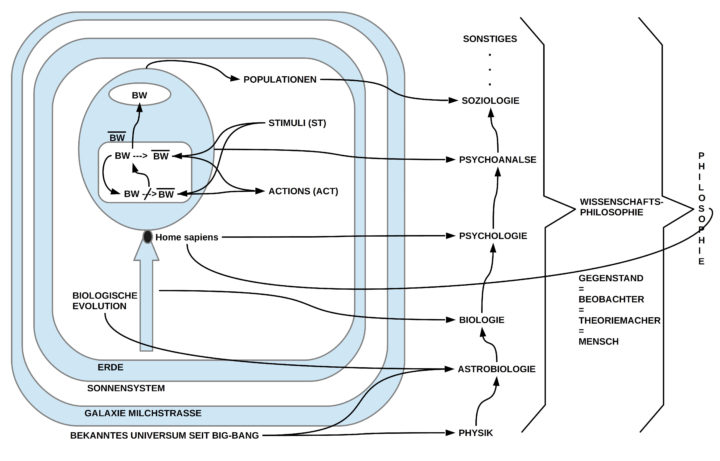

Im Ringen um das richtige Verständnis unserer aktuellen Situation im globalen Kontext wird deutlich, dass das Verhältnis von der ‚real existierenden Welt‘ und den verschiedenen ‚Ansichten‘ zu dieser Welt sehr vielfältig bis widersprüchlich ist. Dies ist kein Zufall. Die Art und Weise, wie wir die Welt ‚beschreiben‘ ist nicht fest vorgegeben. Jede Generation muss für sich neu klären, mit welchen Konzepten, mit welcher Sprache, mit welchen Beobachtungsmethoden will man alle jene Aspekte der realen Welt ‚gedanklich so aufbereiten‘, dass sie ‚gemeinschaftlich verstehbar‘ und ‚überprüfbar‘ werden. Im Bereich der ‚Ökologie‘, der allgemeinen Erforschung unserer Umwelt unter Berücksichtigung der Biosphäre samt den vielfältigen Prozessen, die hier involviert sind, hat sich ein Vorgehen etabliert, das als ‚theoretische Ökologie‘ [7] bezeichnet wird. Hier werden die wichtigsten Konzepte, die wichtigsten theoretischen Modelle zusammengetragen, angewendet, und überprüft. Dies fördert die begriffliche Klarheit, fördert Synergieeffekte, fördert unterschiedliche Integrationen der verschiedenen Teilaspekte.

Eine fortschreitende Theoretisierung‘ besitzt aber neue Gefahren, die darin bestehen, dass ein theoretisches Modell als solches zwar faszinieren kann, dass aber sein ‚Wirklichkeitsbezug‘ immer wieder neu, z.T. sehr aufwendig, hergestellt werden muss. Ein beeindruckendes Beispiel für Theoriebildung ist hier Stephen P.Hubbell [7a] mit seiner Theorie [7b], die aber zugleich wegen ihres Bezugs zur Realität umstritten ist. Auch Volker Mosbrugger zeigt sich in seinem Beitrag sehr ‚theoriefreudig‘, ist sich aber der Problematik der oft noch unzulänglichen Abstützung durch unvollständige Daten sehr bewusst. [5] Andere Akzente setzen Robert Ulanowicz [7c] oder Stuart Kauffman [7d].

WAS IST MIT UNS?

Mit diesem versuchten Blick auf das ‚Ganze‘ (wer den Blog ‚Philosophie Jetzt‘ kennt, der weiß, dass dies natürlich nicht wirklich das ‚Ganze‘ ist), stellt sich die einfache — und zugleich schwere — Frage, was dies dann für jeden einzelnen, für seine Region, sein Land, für den ganzen Planeten bedeutet?

Was immer als bewusstes Handeln geschehen soll, es wird nur dann als ‚gemeinsames Werk‘ gelingen, wenn alle Handelnden zu einer einigermaßen einheitlichen ‚Sicht der Dinge‘ gelangen würden, und dass diese Handelnden über ‚genügend politische Macht‘ und ‚genügend materielle Ressourcen‘ verfügen müssen, um die Einsichten auch umsetzen zu können.

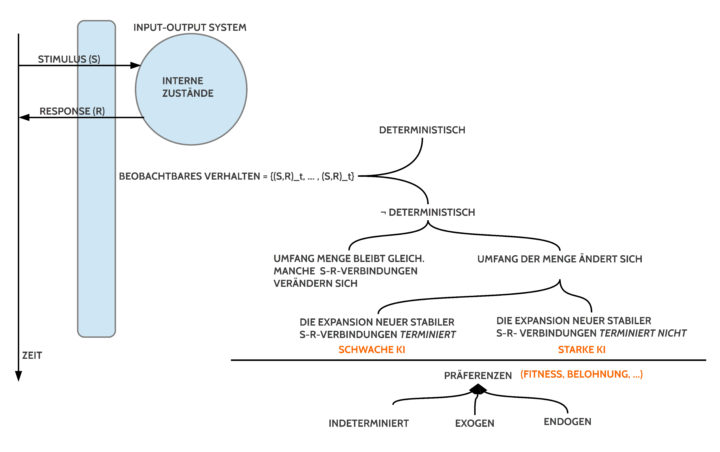

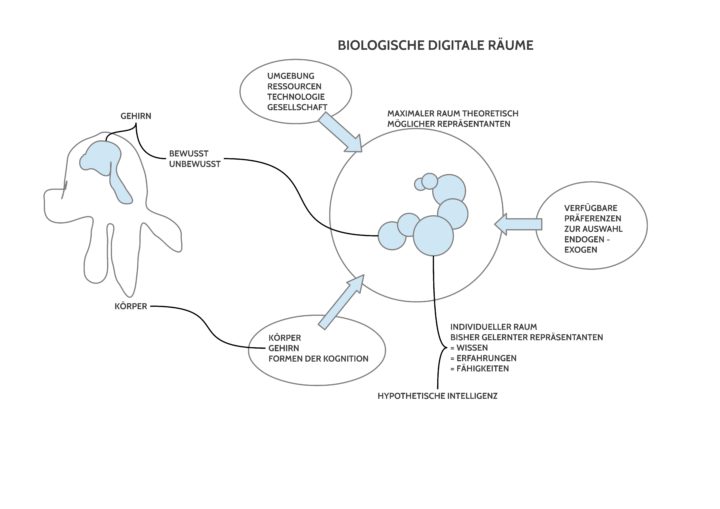

Entgegen dem Mainstream-Märchen, dass Künstliche Intelligenz bei genügender Versorgung mit ‚Daten‘ schon alles richten werde — die Menschen kommen in diesem Märchen praktischerweise erst gar nicht vor –, muss man festhalten, dass die Erarbeitung einer angemessenen theoretischen Sicht auf eine komplexe Realität das menschliche Erkennen an seine Grenzen führt. Dies ist kein ‚Selbstläufer‘ sondern erfordert extreme Anstrengungen. Und damit diese Bemühungen nicht nur in den Gehirnen einzelner Spezialisten stattfinden, brauchen sie eine umfassende gesellschaftliche Kommunikation auf hohem Niveau, was ohne ein entsprechend lebendiges Bildungssystem ein Wunschdenken bleibt. Die ausreichende Bereitstellung der notwendigen Ressourcen ist damit noch nicht geklärt, auch nicht die zentrale Frage der Macht. Laut dem schwedischen V-dem Institut [8] gab es weltweit 2010 noch 32 liberale Demokratien von 208 Staaten, 2020 nur noch 16! Auch wenn man über die Details dieser Klassifikationen streiten kann, der globale Trend ist eindeutig. In nicht-liberalen Demokratien, erst Recht in totalitären Regimen, können wir ständig zerstörerische Prozesse beobachten, wo sich die Bevölkerung gegen totalitäre Machthaber erheben und diese mit brutalster Gewalt zurückschlagen, d.h. ihre eigene Bevölkerung wie Kriminelle behandeln, und sie im übrigen regelrecht ausbeuten. Moderne Technologien ermöglichen totalitären Regimen — und nicht nur diesen — eine immer umfassendere Überwachung ihrer Bürger.

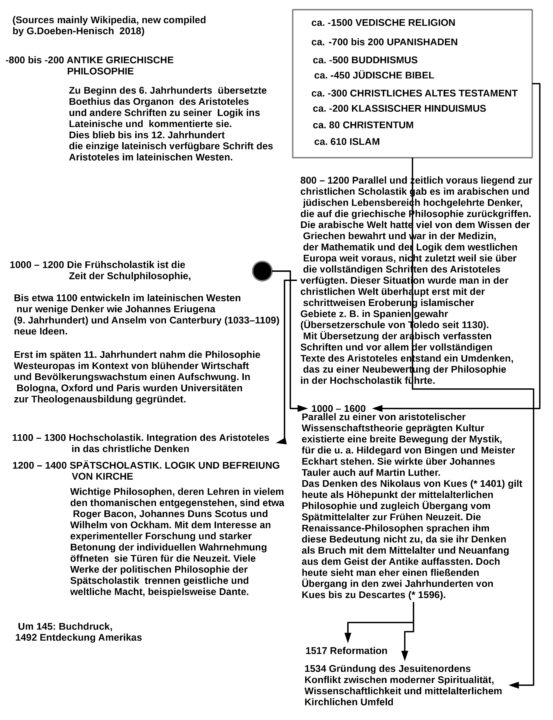

Diese Phänomene sind nicht neu. In den letzten Jahrtausenden gab es viele vergleichbare Phänomene. Insbesondere kann man studieren, wie die Veränderung eines gesellschaftlich geteilten Weltbildes immer viele Generationen gebraucht hat, 100 bis 200 und mehr Jahre sind normal.

Unsere Gegenwart ist hier mit Sicherheit keine Ausnahme. Seit der großen UN Konferenz zur Nachhaltigkeit 1992 sind schon 30 Jahre vergangen und die aktuelle Verfasstheit der verschiedenen Länder ist weit davon entfernt, eine wirklich gemeinsame Reaktion zu zeigen. Auch mit einem klaren Ziel vor Augen sollten wir uns darauf einstellen, dass die Klimaänderung mit all ihren verheerenden Folgen mehr oder weniger stattfinden wird.

Festzuhalten ist: Nicht das Klima ist das Problem, sondern die Art und Weise, wie die Lebensform des Homo sapiens mit der Welt, der Biosphäre und sich selbst umgeht, das ist das zentrale Problem. Wir Menschen haben mittlerweile enorme Technologien entwickelt (und es gibt natürlich noch viel mehr), aber wir selbst haben uns in entscheidenden Fähigkeiten scheinbar kaum weiter entwickelt. Obwohl das biologische Leben auf dem Planet Erde das größte Wunderwerk ist, was in dem bekannten Universum vorkommt, glauben wir naiv, primitive Maschinen (die wir selbst entwickelt haben) wären uns überlegen. Welch grandioser Irrtum.

ANMERKUNGEN

wkp := Wikipedia

[1] Climate change in wkp-en: https://en.wikipedia.org/wiki/Climate_change

[1b] Regina Oehler, Petra Gehring, Volker Mosbrugger (Hrsg.), 2017, Reihe: Senckenberg-Buch 78, „Biologie und Ethik: Leben als Projekt. Ein Funkkolleg Lesebuch“, Stuttgart, E. Schweizerbart’sche Verlagsbuchhandlung (Nägele u. Obermiller) und Senckenberg Gesellschaft für Naturforschung

[2] ‚Anthropocene‚ in wkp-en: https://en.wikipedia.org/wiki/Anthropocene

[2a] Great oxidation event in wkp-en: https://en.wikipedia.org/wiki/Great_Oxidation_Event

[2b] Wolfgang Haber, Martin Held, Markus Vogt (Hrsg.), 2015, „Die Welt im Anthropozän“, München, Oekom-Verlag

[2c] Bauer, Andrew M.; Edgeworth, Matthew; Edwards, Lucy E.; Ellis, Erle C.; Gibbard, Philip; Merritts, Dorothy J. (Korrespondenz 16. September 2021). „Anthropocene: event or epoch?“. Nature. 597 (7876): 332

[3] Wolfgang Haber, Martin Held, Markus Vogt: „Das Anthropozän im Spannungsfeld zwischen Ökologie und Humanität“, in [1], SS.97-105 (entnommen aus [2])

[4] Drenckhahn, D. und Hacker, J. ,(Hrsg.), 2013, “ Rolle der Wissenschaft im Globalen Wandel“, Nova Acta Leopoldina NF Bd. 118

[5] Volker Mosbrugger: „Globaler Wandel der Biodiversität“, in [1], SS. 108-117 (aus [4])

[5b] E.O.Wilson, 2016, „Die Hälfte der Erde: So retten wir die Biosphäre“ , München, Verlag C.H.Beck

[5c] E.O.Wilson, 2017, „Die Hälfte der Erde: So retten wir die Biosphäre“, in [1], SS.118-120, aus [5b]

[5d] E.O.Wilson in wkp-en: https://en.wikipedia.org/wiki/E._O._Wilson

[6] Erle C. Ellis, 2020, „Anthromes“, in: Encyclopedia of the World’s Biomes, Elevier Inc. (Autor: Department of Geography & Environmental Systems, University of Maryland, Baltimore, MD, United States)

[6a] ‚Anthromes‚ auf der Webseite von Ellis: https://anthroecology.org/anthromes

[6b] ‚Anthropogenetic Biome‚ in wkp-en: https://en.wikipedia.org/wiki/Anthropogenic_biome

[6c] Biome in wkp-en: https://en.wikipedia.org/wiki/Biome

[6d] Jakob Johann von Uexküll in wkp-de: https://de.wikipedia.org/wiki/Jakob_Johann_von_Uexk%C3%BCll

[6e] Jakob von Uexküll, 1909, Umwelt und Innenwelt der Tiere. Berlin: J. Springer. (Download: https://ia802708.us.archive.org/13/items/umweltundinnenwe00uexk/umweltundinnenwe00uexk.pdf )

[7] Theoretical ecology in wkp-edn: https://en.wikipedia.org/wiki/Theoretical_ecology

[7a] Stephen P. Hubbell in wkp-en: https://en.wikipedia.org/wiki/Stephen_P._Hubbell

[7b] Unified neutral theory of biodiversity in wkp-en: https://en.wikipedia.org/wiki/Unified_neutral_theory_of_biodiversity

[7c] Robert Ulanowicz in wkp-en: https://en.wikipedia.org/wiki/Robert_Ulanowicz

[7d] S.A.Kauffman in wkp-en: https://en.wikipedia.org/wiki/Stuart_Kauffman (siehe eine Diskussion seines Buches „Reinventing The Sacred. A new View of Science, Reason, and Religion.“ in 7 Teilen HIER).

[8] Gerd Doeben-Henisch, 2021, “ OKSIMO PARADIGMA und DEMOKRATIE – Das V-dem Forschungsinstitut für Demokratie„, in: UNIVERSELLE PROZESSPLANUNG: https://www.oksimo.org/2021/08/28/oksimo-paradigma-und-demokratie-das-v-dem-forschungsinstitut-fuer-demokratie/

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.