Paul Davies, The FIFTH MIRACLE: The Search for the Origin and Meaning of Life, New York:1999, Simon & Schuster

Fortsetzung von Suche… (Teil 1)

Start: 27.Aug.2012

Letzte Fortsetzung: 1.Sept.2012

-

Das dritte Kapitel ist überschrieben ‚Out of the Slime‘. (SS.69-96) Es startet mit Überlegungen zur Linie der Vorfahren (Stammbaum), die alle auf ‚gemeinsame Vorfahren‘ zurückführen. Für uns Menschen zu den ersten Exemplaren des homo sapiens in Afrika vor 100.000 Jahren, zu den einige Millionen Jahre zurückliegenden gemeinsamen Vorläufern von Affen und Menschen; ca. 500 Mio Jahre früher waren die Vorläufer Fische, zwei Milliarden Jahre zurück waren es Mikroben. Und diese Rückführung betrifft alle bekannten Lebensformen, die, je weiter zurück, sich immer mehr in gemeinsamen Vorläufern vereinigen, bis hin zu den Vorläufern allen irdischen Lebens, Mikroorganismen, Bakterien, die die ersten waren.(vgl. S.69f)

-

[Anmerkung: Die Formulierung von einem ‚einzelnen hominiden Vorfahren‘ oder gar von der ‚afrikanischen Eva‘ kann den Eindruck erwecken, als ob der erste gemeinsame Vorfahre ein einzelnes Individuum war. Das scheint mir aber irreführend. Bedenkt man, dass wir ‚Übergangsphasen‘ haben von Atomen zu Molekülen, von Molekülen zu Netzwerken von Molekülen, von Molekülnetzwerken zu Zellen, usw. dann waren diese Übergänge nur erfolgreich, weil viele Milliarden und Abermilliarden von Elementen ‚gleichzeitig‘ beteiligt waren; anders wäre ein ‚Überleben‘ unter widrigsten Umständen überhaupt nicht möglich gewesen. Und es spricht alles dafür, dass dieses ‚Prinzip der Homogenität‘ sich auch bei den ‚komplexeren‘ Entwicklungsstufen fortgesetzt hat. Ein einzelnes Exemplar einer Art, das durch irgendwelche besonderen Eigenschaften ‚aus der Reihe‘ gefallen wäre, hätte gar nicht existieren können. Es braucht immer eine Vielzahl von hinreichend ‚ähnlichen‘ Exemplaren, dass ein Zusammenwirken und Fortbestehen realisiert werden kann. Die ‚Vorgänger‘ sind also eher keine spezifischen Individuen (wenngleich in direkter Abstammung schon), sondern immer Individuen als Mitglieder einer bestimmten ‚Art‘.]

-

Es ist überliefert, dass Darwin im Sommer 1837, nach der Rückkehr von seiner Forschungsreise mit der HMS Beagle in seinem Notizbuch erstmalig einen irregulär verzweigenden Baum gemalt hat, um die vermuteten genealogischen Zusammenhänge der verschiedenen Arten darzustellen. Der Baum kodierte die Annahme, dass letztlich alle bekannten Lebensformen auf einen gemeinsamen Ursprung zurückgehen. Ferner wird deutlich, dass viele Arten (heutige Schätzungen: 99%) irgendwann ‚ausgestorben‘ sind. Im Falle einzelliger Lebewesen gab es aber – wie wir heute zunehmend erkennen können – auch das Phänomene der Symbiose: ein Mikroorganismus ‚frißt‘ andere und ‚integriert‘ deren Leistung ‚in sich‘ (Beispiel die Mitochondrien als Teil der heute bekannten Zellen). Dies bedeutet, dass ‚Aussterben‘ auch als ‚Synthese‘ auftreten kann.(vgl. SS.70-75)

-

Die Argumente für den Zusammenhang auf Zellebene zwischen allen bekannten und ausgestorbenen Arten mit gemeinsamen Vorläufern beruhen auf den empirischen Fakten, z.B. dass die metabolischen Verläufe der einzelnen Zellen gleich sind, dass die Art und Weise der genetischen Kodierung und Weitergabe gleich ist, dass der genetische Kode im Detail der gleiche ist, oder ein kurioses Detail wie die molekulare Ausrichtung – bekannt als Chiralität –; obgleich jedes Molekül aufgrund der geltenden Gesetze sowohl rechts- oder linkshändig sein kann, ist die DNA bei allen Zellen ‚rechtshändig‘ und ihr Spiegelbild linkshändig. (vgl.SS.71-73)

-

Da das DNA-Molekül bei allen bekannten Lebensformen in gleicher Weise unter Benutzung von Bausteinen aus Aminosäure kodiert ist, kann man diese Moleküle mit modernen Sequenzierungstechniken Element für Element vergleichen. Unter der generellen Annahme, dass sich bei Weitergabe der Erbinformationen durch zufällige Mutationen von Generation zur Generation Änderungen ergeben können, kann man anhand der Anzahl der verschiedenen Elemente sowohl einen ‚genetischen Unterschied‘ wie auch einen ‚genealogischen Abstand‘ konstruieren. Der genetische Unterschied ist direkt ’sichtbar‘, die genaue Bestimmung des genealogischen Abstands im ‚Stammbaum‘ hängt zusätzlich ab von der ‚Veränderungsgeschwindigkeit‘. Im Jahr 1999 war die Faktenlage so, dass man annimmt, dass es gemeinsame Vorläufer für alles Leben gegeben hat, die sich vor ca. 3 Milliarden Jahren in die Art ‚Bakterien‘ und ‚Nicht-Bakterien‘ verzweigt haben. Die Nicht-Bakterien haben sich dann weiter verzweigt in ‚Eukaryoten‘ und ‚Archäen‘. (vgl. SS.75-79)

-

Davies berichtet von bio-geologischen Funden nach denen in de Nähe von Isua (Grönland) Felsen von vor mindestens -3.85 Milliarden Jahren gefunden wurden mit Spuren von Bakterien. Ebenso gibt es Funde von Stromatolythen (Nähe Shark Bay, Australien), mit Anzeichen für Cyanobakterien aus der Zeit von ca. -3.5 Milliarden Jahren und aus der gleichen Zeit Mikrofossilien in den Warrawoona Bergen (Australien). Nach den Ergebnissen aus 1999 hatten die Cyanobakterien schon -3.5 Mrd. Jahre Mechanismen für Photosynthese, einem höchst komplexen Prozess.(vgl. SS.79-81)

-

Die immer weitere Zurückverlagerung von Mikroorganismen in die Vergangenheit löste aber nicht das Problem der Entstehung dieser komplexen Strukturen. Entgegen der früher verbreiteten Anschauung, dass ‚Leben‘ nicht aus ‚toter Materie‘ entstehen kann, hatte schon Darwin 1871 in einem Brief die Überlegung geäußert, dass in einer geeigneten chemischen Lösung über einen hinreichend langen Zeitraum jene Moleküle und Molekülvernetzungen entstehen könnten, die dann zu den bekannten Lebensformen führen. Aber erst in den 20iger Jahren des 20.Jahrhunderts waren es Alexander Oparin (Rußland) und J.B.S.Haldane (England) die diese Überlegungen ernst nahmen. Statt einem kleinen See, wie bei Darwin, nahm Haldane an, dass es die Ozeane waren, die den Raum für den Übergangsprozess von ‚Materie‘ zu ‚Leben‘ boten. Beiden Forschern fehlten aber in ihrer Zeit die entscheidende Werkzeuge und Erkenntnisse der Biochemie und Molekularbiologie, um ihre Hypothesen testen zu können. Es war Harold Urey (USA) vorbehalten, 1953 mit ersten Laborexperimenten beginnen zu können, um die Hypothesen zu testen. (vgl. SS.81-86)

-

Mit Hilfe des Studenten Miller arrangierte Urey ein Experiment, bei dem im Glaskolben eine ‚Mini-Erde‘ bestehend aus etwas Wasser mit den Gasen Methan, Hydrogen und Ammonium angesetzt wurde. Laut Annahme sollte dies der Situation um ca. -4 Millarden Jahren entsprechen. Miller erzeugte dann in dem Glaskolben elektrische Funken, um den Effekt von Sonnenlicht zu simulieren. Nach einer Woche fand er dann verschiedene Amino-Säuren, die als Bausteine in allen biologischen Strukturen vorkommen, speziell auch in Proteinen.(vgl. S.86f)

-

Die Begeisterung war groß. Nachfolgende Überlegungen machten dann aber klar, dass damit noch nicht viel erreicht war. Die Erkenntnisse der Geologen deuteten in den nachfolgenden Jahren eher dahin, dass die Erdatmosphäre, die die sich mehrfach geändert hatte, kaum Ammonium und Methan enthielt, sondern eher reaktions-neutrales Kohlendioxyd und Schwefel, Gase die keine Aminosäuren produzieren. (vgl.S.87)

-

Darüber hinaus ist mit dem Auftreten von Aminosäuren als Bausteine für mögliche größere Moleküle noch nichts darüber gesagt, ob und wie diese größere Moleküle entstehen können. Genauso wenig wie ein Haufen Ziegelsteine einfach so ein geordnetes Haus bilden wird, genauso wenig formen einzelne Aminosäuren ‚einfach so‘ ein komplexes Molekül (ein Peptid oder Polypeptid). Dazu muss der zweite Hauptsatz überwunden werden, nach dem ’spontane‘ Prozesse nur in Richtung Energieabbau ablaufen. Will man dagegen komplexe Moleküle bauen, muss man gegen den zweiten Hauptsatz die Energie erhöhen; dies muss gezielt geschehen. In einem angenommenen Ozean ist dies extrem unwahrscheinlich, da hier Verbindungen eher aufgelöst statt synthetisiert werden.(vgl.87-90)

-

Der Chemiker Sidney Fox erweiterte das Urey-Experiment durch Zufuhr von Wärme. In der Tat bildeten sich dann Ketten von Aminosäurebausteinen die er ‚Proteinoide‘ nannte. Diese waren eine Mischung aus links- und rechts-händigen Molekülen, während die biologisch relevanten Moleküle alle links-händig sind. Mehr noch, die biologisch relevanten Aminosäureketten sind hochspezialisiert. Aus der ungeheuren Zahl möglicher Kombinationen die ‚richtigen‘ per Zufall zu treffen grenzt mathematisch ans Unmögliche.(vgl.S.90f) Dazu kommt, dass eine Zelle viele verschiedene komplexe Moleküle benötigt (neben Proteinen auch Lipide, Nukleinsäuren, Ribosomen usw.). Nicht nur ist jedes dieser Moleküle hochkomplex, sondern sie entfalten ihre spezifische Wirkung als ‚lebendiges Ensemble‘ erst im Zusammenspiel. Jedes Molekül ‚für sich‘ weiß aber nichts von einem Zusammenhang. Wo kommen die Informationen für den Zusammenhang her? (vgl.S.91f) Rein mathematisch ist die Wahrscheinlichkeit, dass sich die ‚richtigen‘ Proteine bilden in der Größenordnung von 1:10^40000, oder, um ein eindrucksvolles Bild des Physikers Fred Hoyle zu benutzen: genauso unwahrscheinlich, wie wenn ein Wirbelsturm aus einem Schrottplatz eine voll funktionsfähige Boeing 747 erzeugen würde. (vgl.S.95)

-

Die Versuchung, das Phänomen des Lebens angesichts dieser extremen Unwahrscheinlichkeiten als etwas ‚Besonderes‘, als einen extrem glücklichen Zufall, zu charakterisieren, ist groß. Davies plädiert für eine Erklärung als eines ’natürlichen physikalischen Prozesses‘. (S.95f)

-

Im Kapitel 4 ‚The Message in the Machine‘ (SS.97-122) versucht Davies mögliche naturwissenschaftliche Erklärungsansätze, beginnend bei den Molekülen, vorzustellen. Die Zelle selbst ist so ungeheuerlich komplex, dass noch ein Niels Bohr die Meinung vertrat, dass Leben als ein unerklärbares Faktum hinzunehmen sei (vgl.Anmk.1,S.99). Für die Rekonstruktion erinnert Davies nochmals daran, dass diejenigen Eigenschaften, die ‚lebende‘ Systeme von ’nicht-lebenden‘ Systemen auszeichnen, Makroeigenschaften sind, die sich nicht allein durch Verweis auf die einzelnen Bestandteile erklären lassen, sondern nur und ausschließlich durch das Zusammenspiel der einzelnen Komponenten. Zentrale Eigenschaft ist hier die Reproduktion. (vgl.SS.97-99)

-

Reproduktion ist im Kern gebunden an das Kopieren von drei-dimensional charakterisierten DNA-Molekülen. Vereinfacht besteht solch ein DNA-Molekül aus zwei komplementären Strängen, die über eine vierelementiges Alphabet von Nukleinsäurebasen miteinander so verbunden sind, dass es zu jeder Nukleinsäurebase genau ein passendes Gegenstück gibt. Fehlt ein Gegenstück, ist es bei Kenntnis des Kodes einfach, das andere Stück zu ergänzen. Ketten von den vierelementigen Basen können ‚Wörter‘ bilden, die ‚genetische Informationen‘ kodieren. Ein ‚Gen‘ wäre dann solch ein ‚Basen-Wort‘. Und das ganze Molekül wäre dann die Summe aller Gene als ‚Genom‘. Das ‚Auftrennen‘ von Doppelsträngen zum Zwecke des Kopierens wie auch das wieder ‚Zusammenfügen‘ besorgen spezialisierte andere Moleküle (Enzyme). Insgesamt kann es beim Auftrennen, Kopieren und wieder Zusammenfügen zu ‚Fehlern‘ (Mutationen) kommen. (vgl.SS.100-104)

-

Da DNA-Moleküle als solche nicht handlungsfähig sind benötigen sie eine Umgebung, die dafür Sorge trägt, dass die genetischen Informationen gesichert und weitergegeben werden. Im einfachen Fall ist dies eine Zelle. Um eine Zelle aufzubauen benötigt man Proteine als Baumaterial und als Enzyme. Proteine werden mithilfe der genetischen Informationen in der DNA erzeugt. Dazu wird eine Kopie der DNA-Informationen in ein Molekül genannt Boten-RNA (messenger RNA, mRNA) kopiert, dieses wandert zu einem komplexen Molekülnetzwerk genannt ‚Ribosom‘. Ribosomen ‚lesen‘ ein mRNA-Molekül als ‚Bauanleitung‘ und generieren anhand dieser Informationen Proteine, die aus einem Alphabet von 20 (bisweilen 21) Aminosäuren zusammengesetzt werden. Die Aminosäuren, die mithilfe des Ribosoms Stück für Stück aneinandergereiht werden, werden von spezialisierten Transportmolekülen (transfer RNA, tRNA) ‚gebracht‘, die so gebaut sind, dass immer nur dasjenige tRNA-Molekül andocken kann, das zur jeweiligen mRNA-Information ‚passt‘. Sobald die mRNA-Information ‚abgearbeitet‘ ist, liegt eines von vielen zehntausend möglichen Proteinen vor. (vgl.SS. 104-107) Bemerkenswert ist die ‚Dualität‘ der DNA-Moleküle (wie auch der mRNA) sowohl als ‚Material/ Hardware‘ wie auch als ‚Information/ Software‘. (vgl.S.108)

-

Diese ‚digitale‘ Perspektive vertieft Davies durch weitere Betrachtung und führt den Leser zu einem Punkt, bei dem man den Eindruck gewinnt, dass die beobachtbaren und messbaren Materialien letztlich austauschbar sind bezogen auf die ‚impliziten Strukturen‘, die damit realisiert werden. Am Beispiel eines Modellflugzeugs, das mittels Radiowellen ferngesteuert wird, baut er eine Analogie dahingehend auf, dass die Hardware (das Material) des Flugzeugs wie auch der Radiowellen selbst als solche nicht erklären, was das Flugzeug tut. Die Hardware ermöglicht zwar grundsätzlich bestimmte Flugeigenschaften, aber ob und wie diese Eigenschaften genutzt werden, das wird durch ‚Informationen‘ bestimmt, die per Radiowellen von einem Sender/ Empfänger kommuniziert werden. Im Fall einer Zelle bilden komplexe Molekülnetzwerke die Hardware mit bestimmten verfügbaren chemischen Eigenschaften, aber ihr Gesamtverhalten wird gesteuert durch Informationen, die primär im DNA-Molekül kodiert vorliegt und die als ‚dekodierte‘ Information alles steuert.(vgl. SS.113-115)

-

[Anmerkung: Wie schon zuvor festgestellt, repräsentieren Atome und Moleküle als solche keine ‚Information‘ ‚von sich aus‘. Sie bilden mögliche ‚Ereignisse‘ E ‚für andere‘ Strukturen S, sofern diese andere Strukturen S auf irgendeine Weise von E ‚beeinflusst‘ werden können. Rein physikalisch (und chemisch) gibt es unterschiedliche Einwirkungsmöglichkeiten (z.B. elektrische Ladungen, Gravitation,…). Im Falle der ‚Information‘ sind es aber nicht nur solche primären physikalisch-chemischen Eigenschaften, die benutzt werden, sondern das ‚empfangende‘ System S befindet sich in einem Zustand, S_inf, der es dem System ermöglicht, bestimmte physikalisch-chemische Ereignisse E als ‚Elemente eines Kodes‘ zu ‚interpretieren. Ein Kode ist minimal eine Abbildungsvorschrift, die Elemente einer Menge X (die primäre Ereignismenge) in eine Bildmenge Y (irgendwelche anderen Ereignisse, die Bedeutung) ‚übersetzt‘ (kodiert), also CODE: X —> Y. Das Materiell-Stoffliche wird damit zum ‚Träger von Informationen‘, zu einem ‚Zeichen‘, das von einem Empfänger S ‚verstanden‘ wird. Im Falle der zuvor geschilderten Replikation wurden ausgehend von einem DNA-Molekül (= X, Ereignis, Zeichen) mittels mRNA, tRNA und Ribosom (= Kode, CODE) bestimmte Proteine (=Y, Bedeutung) erzeugt. Dies bedeutet, dass die erzeugten Proteine die ‚Bedeutung des DNA-Moleküls‘ sind unter Voraussetzung eines ‚existierenden Kodes‘ realisiert im Zusammenspiel eines Netzwerkes von mRNA, tRNAs und Ribosom. Das Paradoxe daran ist, das die einzelnen Bestandteile des Kodes, die Moleküle mRNA, tRNA und Ribosom (letzteres selber hochkomplex) ‚für sich genommen‘ keinen Kode darstellen, nur in dem spezifischen Zusammenspiel! Wenn also die einzelnen materiellen Bestandteile, die Atome und Moleküle ‚für sich gesehen‘ keinen komplexen Kode darstellen, woher kommt dann die Information, die alle diese materiell hochkomplexen Bestandteile auf eine Weise ‚zusammenspielen‘ lässt, die weit über das hinausgeht, was die Bestandteile einzeln ‚verkörpern‘? ]

-

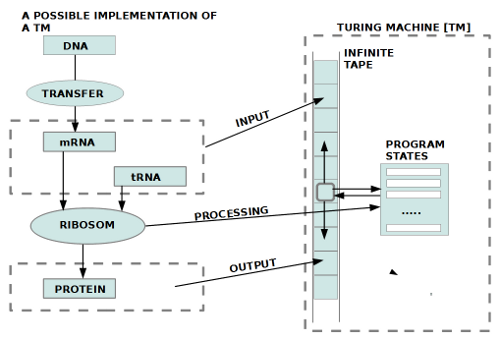

zelle_tm [Anmerkung: Es gibt noch eine andere interssante Perspektive. Das mit Abstand wichtigste Konzept in der (theoretischen) Informatik ist das Konzept der Berechenbarkeit, wie es zunächst von Goedel 1931, dann von Turing in seinem berühmten Artikel von 1936-7 vorgelegt worden ist. In seinem Artikel definiert Turing das mathematische (!) Konzept einer Vorrichtung, die alle denkbaren berechenbaren Prozesse beschreiben soll. Später gaben andere dieser Vorrichtung den Namen ‚Turingmaschine‘ und bis heute haben alle Beweise immer nur dies eine gezeigt, dass es kein anderes formales Konzept der intuitiven ‚Berechenbarkeit‘ gibt, das ’stärker‘ ist als das der Turingmaschine. Die Turingmaschine ist damit einer der wichtigsten – wenn nicht überhaupt der wichtigste — philosophischen Begriff(e). Viele verbinden den Begriff der Turingmaschine oft mit den heute bekannten Computern oder sehen darin die Beschreibung eines konkreten, wenngleich sehr ‚umständlichen‘ Computers. Das ist aber vollständig an der Sache vorbei. Die Turingmaschine ist weder ein konkreter Computer noch überhaupt etwas Konkretes. Genau wie der mathematische Begriff der natürlichen Zahlen ein mathematisches Konzept ist, das aufgrund der ihm innewohnenden endlichen Unendlichkeit niemals eine reale Zahlenmenge beschreibt, sondern nur das mathematische Konzept einer endlich-unendlichen Menge von abstrakten Objekten, für die die Zahlen des Alltags ‚Beispiele‘ sind, genauso ist auch das Konzept der Turingmaschine ein rein abstraktes Gebilde, für das man konkrete Beispiele angeben kann, die aber das mathematische Konzept selbst nie erschöpfen (die Turingmaschine hat z.B. ein unendliches Schreib-Lese-Band, etwas, das niemals real existieren kann).

] - [Anmerkung: Das Interessante ist nun, dass man z.B. die Funktion des Ribosoms strukturell mit dem Konzept einer Turingmaschine beschreiben kann (vgl. Bild). Das Ribosom ist jene Funktionseinheit von Molekülen, die einen Input bestehend aus mRNA und tRNAs überführen kann in einen Output bestehend aus einem Protein. Dies ist nur möglich, weil das Ribosom die mRNA als Kette von Informationseinheiten ‚interpretiert‘ (dekodiert), die dazu führen, dass bestimmte tRNA-Einheiten zu einem Protein zusammengebaut werden. Mathematisch kann man diese funktionelle Verhalten eines Ribosoms daher als ein ‚Programm‘ beschreiben, das gleichbedeutend ist mit einer ‚Funktion‘ bzw. Abbildungsvorschrift der Art ‚RIBOSOM: mRNA x tRNA —> PROTEIN. Das Ribosom stellt somit eine chemische Variante einer Turingmaschine dar (statt digitalen Chips oder Neuronen). Bleibt die Frage, wie es zur ‚Ausbildung‘ eines Ribosoms kommen kann, das ’synchron‘ zu entsprechenden mRNA-Molekülen die richtige Abbildungsvorschrift besitzt.

] - Eine andere Blickweise auf das Phänomen der Information ist jene des Mathematikers Chaitin, der darauf aufmerksam gemacht hat, dass man das ‚Programm‘ eines Computers (sein Algorithmus, seine Abbildungsfunktion, seine Dekodierungsfunktion…) auch als eine Zeichenkette auffassen kann, die nur aus Einsen und Nullen besteht (also ‚1101001101010..‘). Je mehr Wiederholungen solch eine Zeichenkette enthalten würde, um so mehr Redundanz würde sie enthalten. Je weniger Wiederholung, um so weniger Redundanz, um so höher die ‚Informationsdichte‘. In einer Zeichenkette ohne jegliche Redundanz wäre jedes einzelne Zeichen wichtig. Solche Zeichenketten sind formal nicht mehr von reinen zufallsbedingten Ketten unterscheidbar. Dennoch haben biologisch nicht alle zufälligen Ketten eine ’nützliche‘ Bedeutung. DNA-Moleküle ( bzw. deren Komplement die jeweiligen mRNA-Moleküle) kann man wegen ihrer Funktion als ‚Befehlssequenzen‘ als solche binär kodierten Programme auffassen. DNA-Moleküle können also durch Zufall erzeugt worden sein, aber nicht alle zufälligen Erzeugungen sind ’nützlich‘, nur ein verschwindend geringer Teil. Dass die ‚Natur‘ es geschafft hat, aus der unendlichen Menge der nicht-nützlichen Moleküle per Zufall die herauszufischen, die ’nützlich‘ sind, geschah einmal durch das Zusammenspiel von Zufall in Gestalt von ‚Mutation‘ sowie Auswahl der ‚Nützlichen‘ durch Selektion. Es stellt sich die Frage, ob diese Randbedingungen ausreichen, um das hohe Mass an Unwahrscheinlichkeit zu überwinden. (vgl. SS. 119-122)

-

[Anmerkung: Im Falle ‚lernender‘ Systeme S_learn haben wir den Fall, dass diese Systeme einen ‚Kode‘ ‚lernen‘ können, weil sie in der Lage sind, Ereignisse in bestimmter Weise zu ‚bearbeiten‘ und zu ’speichern‘, d.h. sie haben Speichersysteme, Gedächtnisse (Memory), die dies ermöglichen. Jedes Kind kann ‚lernen‘, welche Ereignisse welche Wirkung haben und z.B. welche Worte was bedeuten. Ein Gedächtnis ist eine Art ‚Metasystem‘, in dem sich ‚wahrnehmbare‘ Ereignisse E in einer abgeleiteten Form E^+ so speichern (= spiegeln) lassen, dass mit dieser abgeleiteten Form E^+ ‚gearbeitet‘ werden kann. Dies setzt voraus, dass es mindestens zwei verschiedene ‚Ebenen‘ (layer, level) im Gedächtnis gibt: die ‚primären Ereignisse‘ E^+ sowie die möglichen ‚Beziehungen‘ RE, innerhalb deren diese vorkommen. Ohne dieses ‚Beziehungswissen‘ gibt es nur isolierte Ereignisse. Im Falle multizellulärer Organismen wird diese Speicheraufgabe durch ein Netzwerk von neuronalen Zellen (Gehirn, Brain) realisiert. Der einzelnen Zelle kann man nicht ansehen, welche Funktion sie hat; nur im Zusammenwirken von vielen Zellen ergeben sich bestimmte Funktionen, wie z.B. die ‚Bearbeitung‘ sensorischer Signale oder das ‚Speichern‘ oder die Einordnung in eine ‚Beziehung‘. Sieht man mal von der spannenden Frage ab, wie es zur Ausbildung eines so komplexen Netzwerkes von Neuronen kommen konnte, ohne dass ein einzelnes Neuron als solches ‚irgend etwas weiß‘, dann stellt sich die Frage, auf welche Weise Netzwerke von Molekülen ‚lernen‘ können. Eine minimale Form von Lernen wäre das ‚Bewahren‘ eines Zustandes E^+, der durch ein anderes Ereignis E ausgelöst wurde; zusätzlich müsste es ein ‚Bewahren‘ von Zuständen geben, die Relationen RE zwischen primären Zuständen E^+ ‚bewahren‘. Solange wir es mit frei beweglichen Molekülen zu tun haben, ist kaum zu sehen, wie es zu solchen ‚Bewahrungs-‚ sprich ‚Speicherereignissen‘ kommen kann. Sollte es in irgend einer Weise Raumgebiete geben, die über eine ‚hinreichend lange Zeit‘ ‚konstant bleiben, dann wäre es zumindest im Prinzip möglich, dass solche ‚Bewahrungsereignisse‘ stattfinden. Andererseits muss man aber auch sehen, dass diese ‚Bewahrungsereignisse‘ aus Sicht eines möglichen Kodes nur möglich sind, wenn die realisierenden Materialien – hier die Moleküle bzw. Vorstufen zu diesen – physikalisch-chemische Eigenschaften aufweisen, die grundsätzlich solche Prozesse nicht nur ermöglichen, sondern tendenziell auch ‚begünstigen‘, und dies unter Berücksichtigung, dass diese Prozesse ‚entgegen der Entropie‘ wirken müssen. Dies bedeutet, dass — will man keine ‚magischen Kräfte‘ annehmen — diese Reaktionspotentiale schon in den physikalisch-chemischen Materialien ‚angelegt‘ sein müssen, damit sie überhaupt auftreten können. Weder Energie entsteht aus dem Nichts noch – wie wir hier annehmen – Information. Wenn wir also sagen müssen, dass sämtliche bekannte Materie nur eine andere Zustandsform von Energie ist, dann müssen wir vielleicht auch annehmen, dass alle bekannten ‚Kodes‘ im Universum nichts anderes sind als eine andere Form derjenigen Information, die von vornherein in der Energie ‚enthalten‘ ist. Genauso wie Atome und die subatomaren Teilchen nicht ’neutral‘ sind sondern von vornherein nur mit charakteristischen (messbaren) Eigenschaften auftreten, genauso müsste man dann annehmen, dass die komplexen Kodes, die wir in der Welt und dann vor allem am Beispiel biologischer Systeme bestaunen können, ihre Wurzeln in der grundsätzlichen ‚Informiertheit‘ aller Materie hat. Atome formieren zu Molekülen, weil die physikalischen Eigenschaften sie dazu ‚bewegen‘. Molkülnetzwerke entfalten ein spezifisches ‚Zusammenspiel‘, weil ihre physikalischen Eigenschaften das ‚Wahrnehmen‘, ‚Speichern‘ und ‚Dekodieren‘ von Ereignissen E in einem anderen System S grundsätzlich ermöglichen und begünstigen. Mit dieser Annahme verschwindet ‚dunkle Magie‘ und die Phänomene werden ‚transparent‘, ‚messbar‘, ‚manipulierbar‘, ‚reproduzierbar‘. Und noch mehr: das bisherige physikalische Universum erscheint in einem völlig neuen Licht. Die bekannte Materie verkörpert neben den bislang bekannten physikalisch-chemischen Eigenschaften auch ‚Information‘ von ungeheuerlichen Ausmaßen. Und diese Information ‚bricht sich selbst Bahn‘, sie ‚zeigt‘ sich in Gestalt des Biologischen. Das ‚Wesen‘ des Biologischen sind dann nicht die ‚Zellen als Material‘, das Blut, die Muskeln, die Energieversorgung usw., sondern die Fähigkeit, immer komplexer Informationen aus dem Universum ‚heraus zu ziehen, aufzubereiten, verfügbar zu machen, und damit das ‚innere Gesicht‘ des Universums sichtbar zu machen. Somit wird ‚Wissen‘ und ‚Wissenschaft‘ zur zentralen Eigenschaft des Universums samt den dazugehörigen Kommunikationsmechanismen.]

- Fortsetzung Teil 3

Einen Überblick über alle bisherigen Themen findet sich HIER

Zitierte Literatur:

Chaitin, G.J. Information, Randomness & Incompleteness, 2nd ed., World Scientific, 1990

Turing, A. M. On Computable Numbers with an Application to the Entscheidungsproblem. In: Proc. London Math. Soc., Ser.2, vol.42(1936), pp.230-265; received May 25, 1936; Appendix added August 28; read November 12, 1936; corr. Ibid. vol.43(1937), pp.544-546. Turing’s paper appeared in Part 2 of vol.42 which was issued in December 1936 (Reprint in M.DAVIS 1965, pp.116-151; corr. ibid. pp.151-154).

Interessante Links:

Ein Video in Youtube, das eine Rede von Pauls Davies dokumentiert, die thematisch zur Buchbesprechung passt und ihn als Person etwas erkennbar macht.

Teil 1:

http://www.youtube.com/watch?v=9tB1jppI3fo

Teil 2:

http://www.youtube.com/watch?v=DXXFNnmgcVs

Teil 3:

http://www.youtube.com/watch?v=Ok9APrXfIOU

Teil 4:

http://www.youtube.com/watch?v=vXqqa1_0i7E

Part 5:

http://www.youtube.com/watch?v=QVrRL3u0dF4

Es gibt noch einige andere Videos mit Paul Davies bei Youtube.