Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 13.-17.Januar 2022, 07:30 h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de

VORBEMERKUNG

Dieser Text verstand sich ursprünglich als ein ‚Trigger‘, der auf ein Thema verweist, das von Interesse zu sein scheint, ohne dass die vielen Aspekte des Themas hier voll ausgeleuchtet werden (können). Mittlerweile ist der Text eine Einleitung für eine längere Diskussion mit der Position von Jablonka & Lamb geworden.

KONTEXT

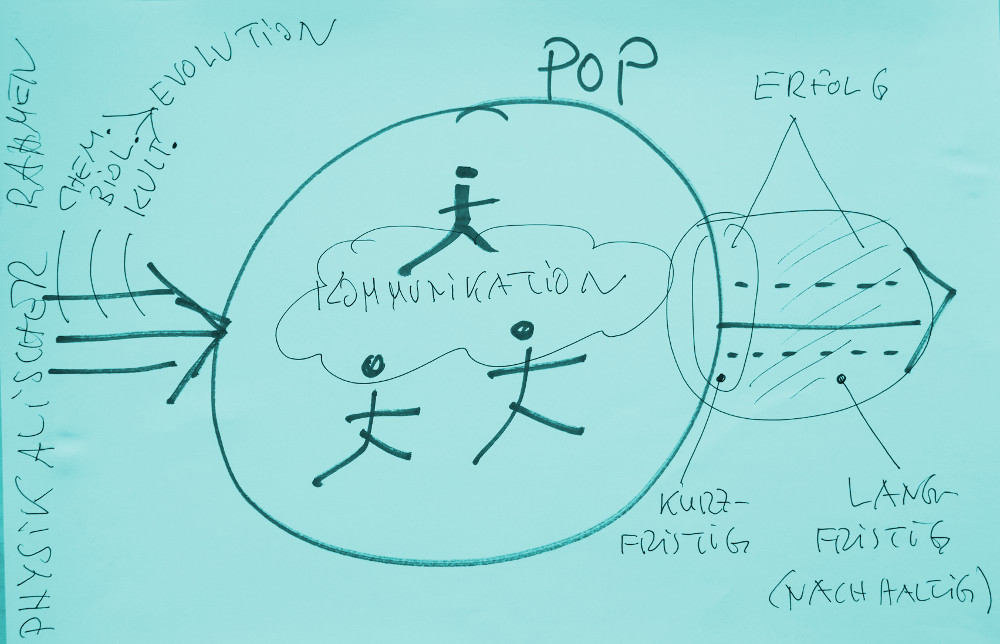

Das Thema ‚Evolution des Lebens‘ ist in diesem Blog schon sehr oft besprochen und diskutiert worden.[2] Dabei nimmt der Autor cagent die Position ein, dass Evolution die Eigenschaft einer Population P ist, die in einer Umgebung U vorkommt, wobei diese Umgebung ‚dynamisch‘ ist, d.h. nicht stationär; sie ändert sich permanent. Um das jeweils ‚aktuelle Format‘ (Genotyp [1f] und Phänotyp [1g]) in der Abfolge der Zustände der Umgebung U ‚am Leben‘ zu erhalten (‚im Spiel zu bleiben‘), müssen die Mitglieder der Population P sowohl ihr Format kontinuierlich ‚anpassen‘ wie auch ihren Verhaltensraum. [2b] Primär geschieht dies über die genetischen Informationen, die ‚Konstruktionsanweisungen‘ enthalten, wie sich ein neuer Organismus entwickeln sollte. Bei der ‚Reproduktion‘ dieser ‚Anweisungen‘ wie auch bei der ‚Umsetzung der Anweisung‘ in einen Konstruktionsprozess (‚Wachstum‘, ‚Ontogenese‘ [1h]), treten mehr oder weniger große ‚Veränderungen‘ auf, die eine Formatänderung bedingen können. Wie neuere Erkenntnisse nahelegen, können die genetischen Informationen auch schon zu Lebzeiten eines individuellen Organismus auf molekularer Ebene verändert werden. Es wird grob eine Interaktion zwischen dem Gesamtsystem und den genetischen Informationen angenommen. [3] Klar ist aber auch, dass solche Lebensformen, die über eine hinreichend differenzierte Wahrnehmung und hinreichende soziale Kommunikation verfügen, unabhängig von den genetischen Informationen durch Änderungen des Verhaltens, eventuell noch ergänzt um individuell unabhängige Artefakte der Umgebung, Veränderungen der Umwelt herbeiführen können, die als Umgebung spezifisch auf die Mitglieder einer Population ‚rückwirken‘ können. Die Möglichkeit der Artefakt-Gesteuerten Verhaltensänderungen bildet einen ‚offenen Raum‘ ab, der von Nicht-Menschen und Menschen besetzt wird. Jenen Teilraum, den wir Menschen als ‚Kultur‘ [4] bezeichnen, von jenem Teilraum abzugrenzen, der nicht als ‚Kultur‘ zu verstehen ist, ist nicht ganz einfach. In der Sicht von Jablonka und Lamb wird zumindest aufgezeigt, dass auch nicht-menschliche Populationen grundlegende Muster aufweisen, die man als ‚Kultur‘ bezeichnen könnte.

ERSTE THESEN AUS DEM BUCH

Erste Thesen zum Buch werden anhand der Zusammenfassung in dem Kurzartikel „Traditionen und kumulierende Evolution: Wie sich ein neuer Lebensstil entwickelt“ [1b] hier vorgestellt. Im Anschluss werden diese Anfangsthesen dann anhand der Deutschen — gegenüber der Englischen Ausgabe erweiterten — Ausgabe von 2017 weiter differenziert.

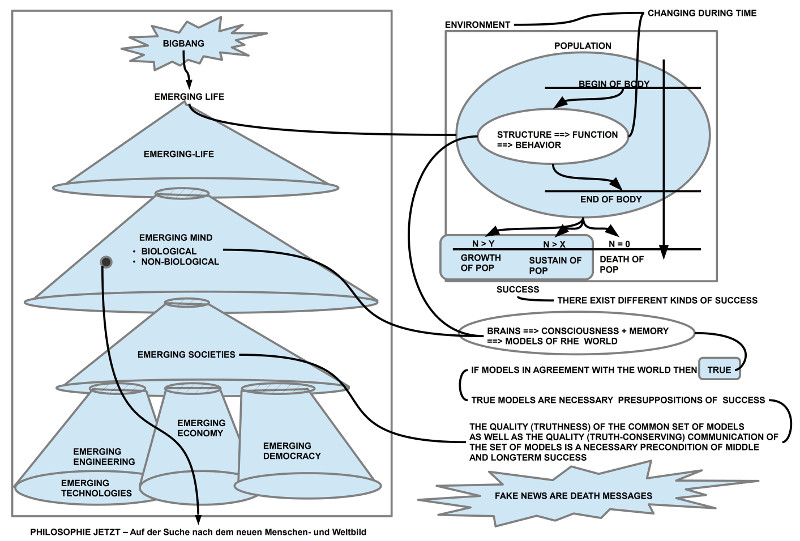

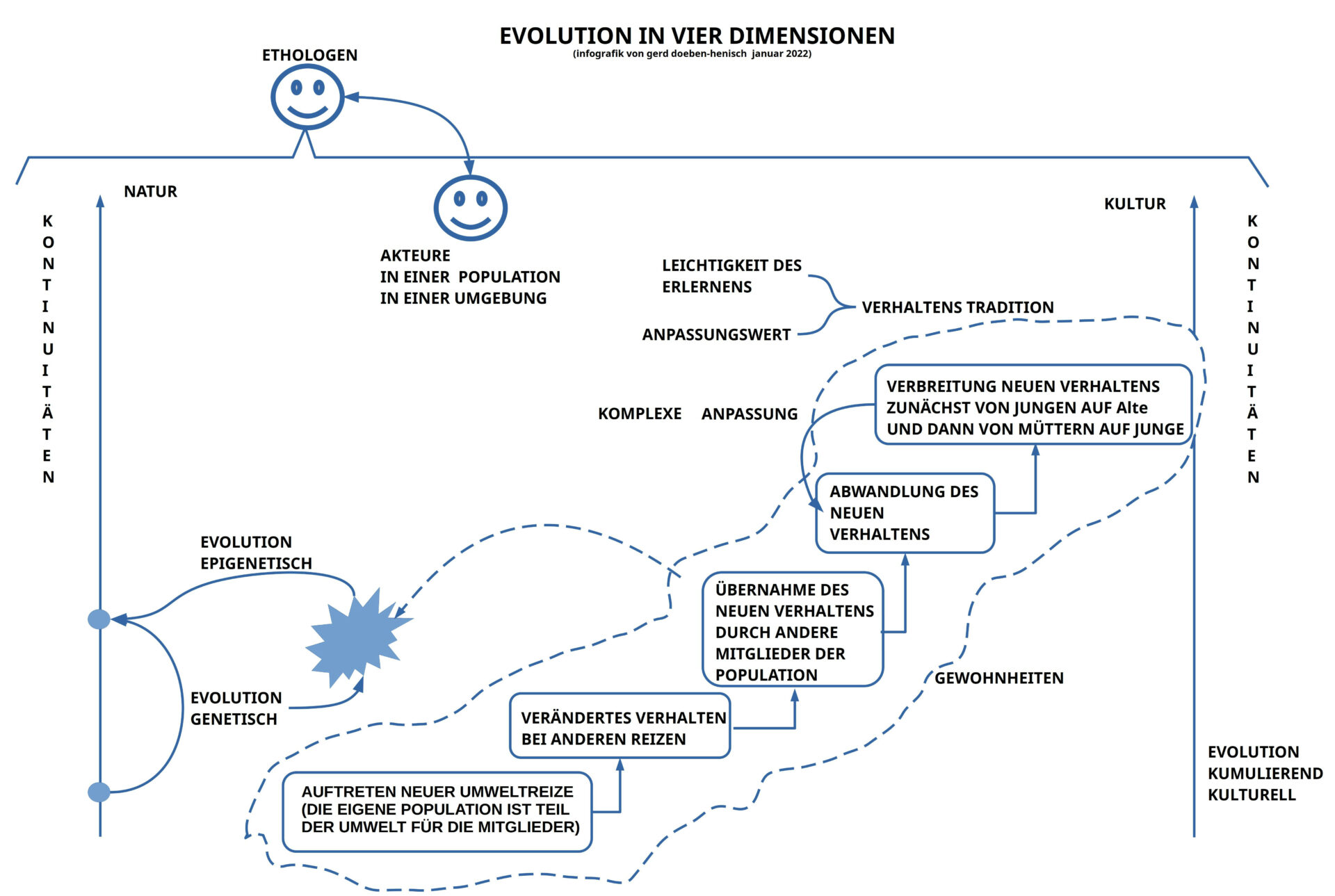

Die Infografik in Bild 1 zeigt vereinfachend und kondensiert die zentralen Aussagen aus dem Kurztext [1b]. Man kann sie wie folgt zusammenfassen:

- Die hier referierten Erkenntnisse entstammen den Forschungen von menschlichen Wissenschaftlerinnen, die wiederum auf eine Vielzahl anderer Wissenschaftler und Wissenschaftlerinnen aufbauen.

- Der Forschungsgegenstand sind nicht-menschliche Lebensformen, in diesem Fall Affen, insbesondere japanische Makaken.

- Generell werden Populationen einer bestimmten Lebensform betrachtet, die in einer bestimmten Umgebung leben, wobei die Umgebung sich ändern kann.

- Wichtig ist, dass die Population für ihre eigenen Mitglieder auch eine Form von Umgebung bildet: der Körper eines biologischen Individuums ist für die jeweils anderen auch Teil der Umgebung.

- Neue Umweltreize in der Umgebung können dazu führen, dass sich bei mindestens einem Mitglied der Population eine neue Verhaltensantwort heraus bildet.

- Neue Verhaltensantworten eines Mitglieds der Population sind selbst neue Reize, die wiederum andere Mitglieder dazu anregen können, diese neuen Verhaltensantworten zu übernehmen.

- Verhaltensantworten können abgewandelt werden sowohl in der Form der Ausführung wie auch in Bezug auf die Handlungssituation.

- Jüngere Mitglieder einer Population sind tendenziell eher bereit, etwas Neues zu übernehmen und abzuwandeln als ältere Mitglieder.

- Wenn ein neues Verhalten bei den älteren Mitgliedern ‚angekommen‘ ist, dann sind z.B. die ‚Mütter‚ diejenigen, die neues Verhalten an Jüngere ‚weitergeben‘.

- Verhalten kann sich — auch ohne Sprache — über mehrere Generationen erhalten.

- Es wird beobachtet, dass die Veränderung der Wirkung eines genetischen Programms schon zu Lebzeiten eines Organismus stattfinden kann. Diese Phänomene werden durch den Ausdruck ‚Epigenetik‘ adressiert. [1i]

Dies sind ‚Thesen‘, die man dem Kurztext [1b] entnehmen kann. Es fehlen in dem Kurztext natürlich alle ausführlichen Erläuterungen und Begründungen. Dennoch kann schon diese Kurzform zu verschiedenen Überlegungen Anlass bieten.

ERSTE ÜBERLEGUNGEN

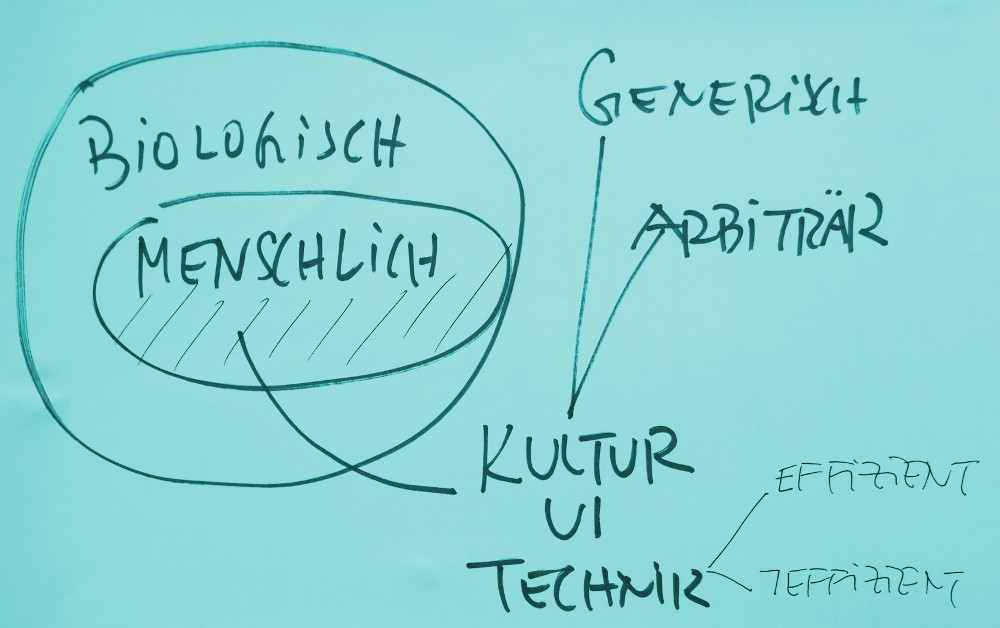

Klar wird schon durch diesen Kurztext, dass wir es bei der Analyse von biologischen Lebensformen mit mindestens den folgenden ‚Dimensionen‘ zu tun haben:

- Es gibt eine vorfindliche ‚Natur‘ als eine veränderliche Größe mit ’naturspezifischen‘ Eigenschaften, und

- in dieser Natur gibt es als ‚Bestandteil der Natur‘ biologische Populationen, die für ihre eigenen Mitglieder wie auch für andere Populationen selbst als ‚Umwelt‘ erscheinen.

- Populationen sind selbst veränderlich.

- Die Mitglieder einer biologischen Population sind in der Lage auf Eigenschaften der umgebenden Natur — mit den anderen Mitgliedern der Population als Bestandteil der Umgebung (Selbstbezüglichkeit einer Population) — durch ein spezifisches Verhalten zu reagieren.

- Ein Verhalten kann sowohl in seiner Form wie auch bezogen auf einen konkreten Anlass verändert werden.

- Aufgrund der Selbstbezüglichkeit einer Population kann eine Population daher

- das eigene Verhalten wechselwirkend verändern

- durch das veränderte Verhalten mit der Umgebung veränderlich interagieren (und dadurch in gewissem Umfang die Umgebung selbst verändern)

- Es zeigt sich, dass Mitglieder einer Population bestimmte Verhaltensweisen in Abhängigkeit von Umgebungseigenschaften auch über längere Zeiträume erinnern können.

- Aufgrund der unterschiedlichen Lebenszeiten wie auch durch das Erinnerungsvermögen können neue Verhaltensweisen zwischen Generationen übertragen werden, was eine Tradierung über eine Generation hinaus ermöglicht.

- Ferner wird beobachtet, dass sich die Wirkung genetischer Informationen im Kontext der Reproduktion meta-genetisch (epigenetisch) unterschiedlich auswirken können, wobei diese meta-genetische (epigenetische) Veränderungen zu Lebzeiten stattfinden. Die Kombination aus genetischen und epigenetischen Faktoren kann sich auf die Nachkommen auswirken. Die Wirkung solcher epigenetisch beeinflussbaren Änderungen im tatsächlichen Verhalten (Phänotyp) ist nicht linear. [1i]

Die Rolle von ’symbolischer Interaktion‘, in komplexen Formen als ‚Sprache‘, wird aus dem Kurztext [1b] noch nicht klar.

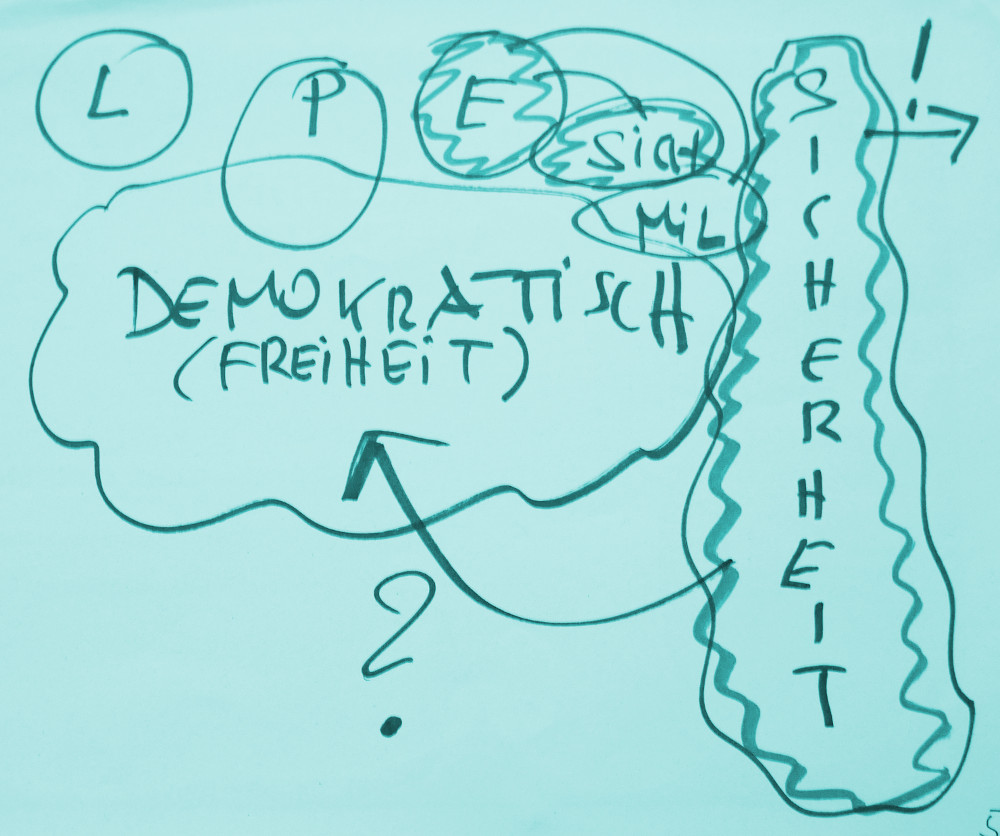

DEFINTIONS-HYPOTHESEN

Für die weitere Diskussion ist es hilfreich, sich schon an dieser Stelle darüber Klarheit zu verschaffen, welches die grundlegenden (Leit-)Begriffe sind, die den weiteren Diskurs prägen. Dies soll in Form ‚tentativer‘ Definitionen erfolgen. Sollten diese sich im weiteren Verlauf als ‚unangemessen‘ erweisen, dann kann man sie entsprechend abändern.

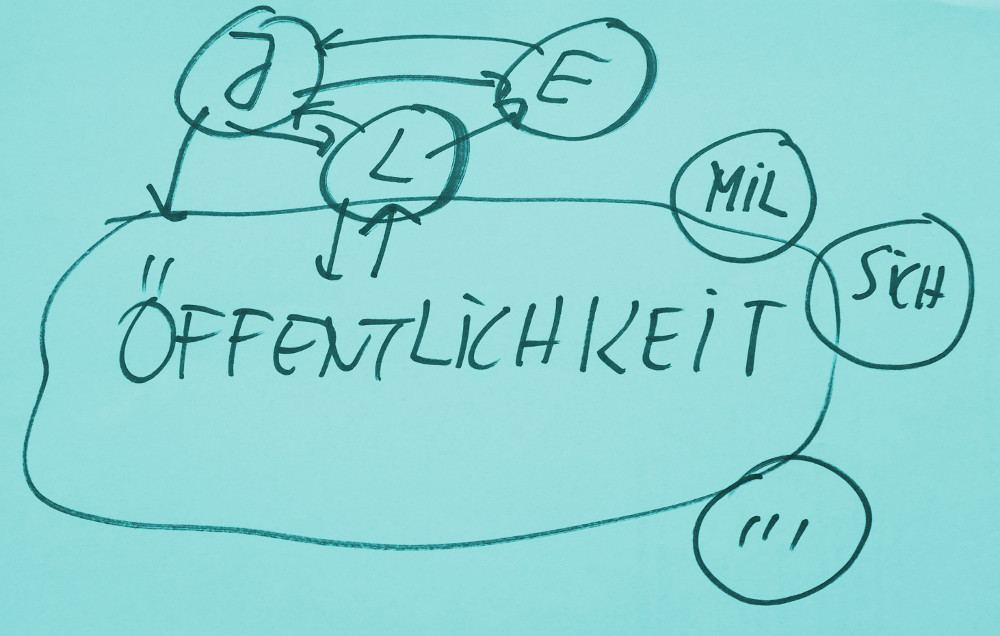

Drei Begriffe erscheinen an dieser Stelle als solche Leitbegriffe eine Rolle zu spielen: ‚Population‘, ‚Kultur‘ und — der Diskussion vorgreifend — ‚Gesellschaft‘.

Def0: Population

Unter Population soll hier minimal eine solche Gruppierung von biologischen Individuen verstanden werden, die eine biologische Fortpflanzungsgemeinschaft bilden.(Dies ist enger als die übliche Verwendung des Begriffs ‚Population‘, siehe [4a])

Def0: Kultur

Im üblichen Sprachgebrauch wird der Begriff ‚Kultur‘ auf die Population von ‚Menschen‘ beschränkt. [4] Hier wird der Vorschlag gemacht, ‚Kultur‘ dort beginnen zu lassen, wo biologische Populationen zu minimaler Traditionsbildung aufgrund ihres Verhaltensraumes fähig sind. Damit erweitert sich der Anwendungsbereich des Begriffs der ‚Kultur‘ über die Population der Menschen hinaus auf viele andere biologische Populationen, aber nicht auf alle.

Def0: Gesellschaft

Der Begriff ‚Gesellschaft‘ gewinnt je nach Betrachtungswinkel (einer Disziplin) ganz unterschiedliche Bedeutungen. (Vgl. [4b]) Hier soll der Begriff mit Bezug auf [4a], [4] minimalistisch dahingehend bestimmt werden, dass biologisch eine ‚Gesellschaft‘ minimal vorliegt, wenn es eine biologische Population gibt [4a], in der auf minimale Weise ‚Kultur‘ [4] vorkommt.

Es soll weiter betrachtet werden, wie diese Prozesse im einzelnen zu verstehen sind und was dies in philosophischer Sicht bedeuten kann.

ANMERKUNGEN

wkp := Wikipedia

[1] Regina Oehler, Petra Gehring, Volker Mosbrugger (Hrsg.), 2017, Reihe: Senckenberg-Buch 78, „Biologie und Ethik: Leben als Projekt. Ein Funkkolleg Lesebuch“, Stuttgart, E. Schweizerbart’sche Verlagsbuchhandlung (Nägele u. Obermiller) und Senckenberg Gesellschaft für Naturforschung

[1b] Eva Jablonka, Marion J. Lamb, 2017, „Traditionen und kumulierende Evolution: Wie sich ein neuer Lebensstil entwickelt“, In: [1], SS.141-146, verweist auf [1c]

[1c] Eva Jablonka, Marion J. Lamb, 2017, „Evolution in vier Dimensionen. Wie Genetik, Epigenetik, Verhalten und Symbole die Geschichte des Lebens prägen“, Stuttgart, S. Hirzel Verlag. Ursprünglich auf English (2005) als „Evolution in Four Dimensions: Genetic, Epigenetic, Behavioral, and Symbolic Variation in the History of Life“ , MIT Press: siehe: https://en.wikipedia.org/wiki/Evolution_in_Four_Dimensions. Auf der Buchseite Hinweise auf einige Review-Artikel. Die Englische Zusammenfassung des Buches auf der MIT Press Webseite lautet wie folgt: „Ideas about heredity and evolution are undergoing a revolutionary change. New findings in molecular biology challenge the gene-centered version of Darwinian theory according to which adaptation occurs only through natural selection of chance DNA variations. In Evolution in Four Dimensions, Eva Jablonka and Marion Lamb argue that there is more to heredity than genes. They trace four „dimensions“ in evolution—four inheritance systems that play a role in evolution: genetic, epigenetic (or non-DNA cellular transmission of traits), behavioral, and symbolic (transmission through language and other forms of symbolic communication). These systems, they argue, can all provide variations on which natural selection can act. Evolution in Four Dimensions offers a richer, more complex view of evolution than the gene-based, one-dimensional view held by many today. The new synthesis advanced by Jablonka and Lamb makes clear that induced and acquired changes also play a role in evolution. After discussing each of the four inheritance systems in detail, Jablonka and Lamb „put Humpty Dumpty together again“ by showing how all of these systems interact. They consider how each may have originated and guided evolutionary history and they discuss the social and philosophical implications of the four-dimensional view of evolution. Each chapter ends with a dialogue in which the authors engage the contrarieties of the fictional (and skeptical) „I.M.,“ or Ifcha Mistabra—Aramaic for „the opposite conjecture“—refining their arguments against I.M.’s vigorous counterarguments. The lucid and accessible text is accompanied by artist-physician Anna Zeligowski’s lively drawings, which humorously and effectively illustrate the authors‘ points.“, siehe: https://mitpress.mit.edu/books/evolution-four-dimensions.“

Die Deutsche Ausgabe von 2017 ist eine überarbeitete, erweiterte Fassung gegenüber den Englischen Fassung. Anhand dieser erweiterten Deutschen Fassung werden die Anfangsthesen dann weiter entwickelt.

[1d] Eva Jablonka in wkp-de: https://de.wikipedia.org/wiki/Eva_Jablonka

[1e] Marion J. Lamb in wkp-ed: https://en.wikipedia.org/wiki/Marion_J._Lamb

[1f] Genotyp in wkp-de: https://de.wikipedia.org/wiki/Genotyp

[1g] Phänotyp in wkp-de: https://de.wikipedia.org/wiki/Ph%C3%A4notyp#Ph%C3%A4notypische_Plastizit%C3%A4t

[1h] Ontogenese in wkp-de: https://de.wikipedia.org/wiki/Ontogenese

[1i] Epigenetik in wkp-de: https://de.wikipedia.org/wiki/Epigenetik

[2] Das Thema ‚Evolution‘ in diesem Blog z.B. hier: https://www.cognitiveagent.org/category/evolution/

[2b] Unter ‚Verhaltensraum‘ wird hier die Menge der möglichen individuellen Verhaltensweisen verstanden, durch die ein Individuum mit der Umgebung interagieren kann. Das gleiche Format (Genotyp & Phänotyp) können ganz verschiedene Verhaltensräume ermöglichen. Dies hängt von der kognitiven Basis des Verhaltens ab. Das genetisch gleiche Gehirn hat eine ungeheuer große Bandbreite an potentiellen Verhaltenssteuerungen.

[3] Zu den Details epigenetischer Veränderungsprozesse siehe einleitend [1i].

[4] Kultur in wkp-de: https://de.wikipedia.org/wiki/Kultur

[4a] Population in der wkp-de: https://de.wikipedia.org/wiki/Population_(Biologie)

[4b] Gesellschaft in der wkp-de: https://de.wikipedia.org/wiki/Gesellschaft

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.