Änerung: 19.März 2015 (Die Künslergruppe Reul & Härtel hat das Foto mit Ihnen durch ein Bild aus ihr Performance (‚visualexploration‘) ersetzen lassen)

Änderung: 20.Nov.2014 (Einfügung Videoschnappschuss von der Uraufführung des Eingangereignisses)

Wie schon zuvor in diesem Blog darauf hingewiesen gab es am 8.November 2014 in der Frankfurt University of Applied Sciences eine recht interessante Veranstaltung INFORMATIK & GESELLSCHAFT. Computer und Geist. Aspekte einer Standortbestimmung. Im Folgenden ein kurzer Bericht mit einigen Schnappschüssen. Alle Bilder sind von Dominik Wolf, dem es gelungen ist, unter schwierigen Lichtverhältnissen doch das eine oder andere Bild zu schiessen. Die beiden ersten Bilder sind allerdings von Anita Henisch, die dann wegen der schwierigen Lichtverhältnisse aufgegeben hatte. Von Dominik Wolf selbst gibt es leider kein Foto, was schade ist, da er die Hauptlast der Organisation getragen hat.

13.20 Uhr Eingangsereignis Computermediated Sound/Images 1

(cagentArtist & Guido May)

Hier ein Video Schnappschuss von Dominik Wolf. Dies war nicht als Dokumentation geplant; aber da der geplante Tonmitschnitt leider nicht verfügbar ist, ist dies nun das einzige Zeugnis der 20 Minuten-Uraufführung.

Das Stück ‚Little CRUNCS symphony No.1‘ wirkte auf den ersten Blick wie sinfonische Musik, war aber vollständig im Computer generiert worden. Sieben verschiedene Eingangsklänge wurden auf unterschiedliche Weise algorithmisch bearbeitet und miteinander verzahnt. Viele Zuhörer sagten anschliessend, dass für sie das Schlagzeugspiel sehr wichtig gewesen sei. Ohne dieses hätten sie sich mit dem reinen Soundtrack schwer getan. So aber war es ein Erlebnis. Auch für den erfahrenen Jazz-Schlagzeuger Guido May war das Stück, wie er sagte, eine besondere Herausforderung. Alle ihm bekannten Muster passten bei diresdem Stück nicht. Er musster sich die Rolle des Schlagzeugs hier speziell erarbeiten.

13.45 Uhr Begrüßungen

(Moderator Prof. Doeben-Henisch, Sprecher ForschungsCampus FC3 & Informatik Cluster Fb2 Prof. Schäfer, Dekan Fb2 Prof. Morkramer, Vizepräsident Wissenschaft Infrastruktur Forschungstransfer der Frankfurt University of Applied Sciences Prof. Schrader)

Prof.Doeben-Henisch bei der Begrüßung. Es war die erste Veranstaltung dieser Art für die Informatik an der Hochschule. So war es sehr erfreulich, dass so viele sich aktiv und engagiert bei dieser Veranstaltung beteiligt haben.

Prof. Morkramer, der Dekan des Fb2, verstand es, am Beispiel seiner eigenen Familie lebendig werden zu lassen, wie schnell die Computer innerhalb von zwei Generationen aus dem Nichts aufstiegen und heute alles durchdringen. Erst jetzt beginnen wir Menschen scheinbar zu begreifen, welche große Folgen dies für uns alle haben kann, nicht nur positiv, sondern auch negativ.

Der Vizepräsident für Weiterbildung, Infrastruktur und Forschung, Prof. Dr. Schrader, griff sich aus den vielfältigen Entwicklungen jenen Bereich heraus, der ihn selbst besonders betrifft, den Bereich neuer Unterrichtstechnologien. So wunderbar diese neue Welt auch erscheint, er machte darauf aufmerksam, dass der Aufwand für eine volle Nutzung dieser neuen technologischen Möglichkeiten, von einer einzelnen Hochschule kaum gestemmt werden kann. Er wagte einen visionären Ausblick dahingehend, ob nicht Hochschule, Behörden und Wirtschaft zusammen ein ‚Leuchtturmprojekt‘ gemeinsamer neuer digitaler interaktiver Lernräume stemmen sollten. Eine Frage, die noch immer weiterhallt, auch nach der Veranstaltung.

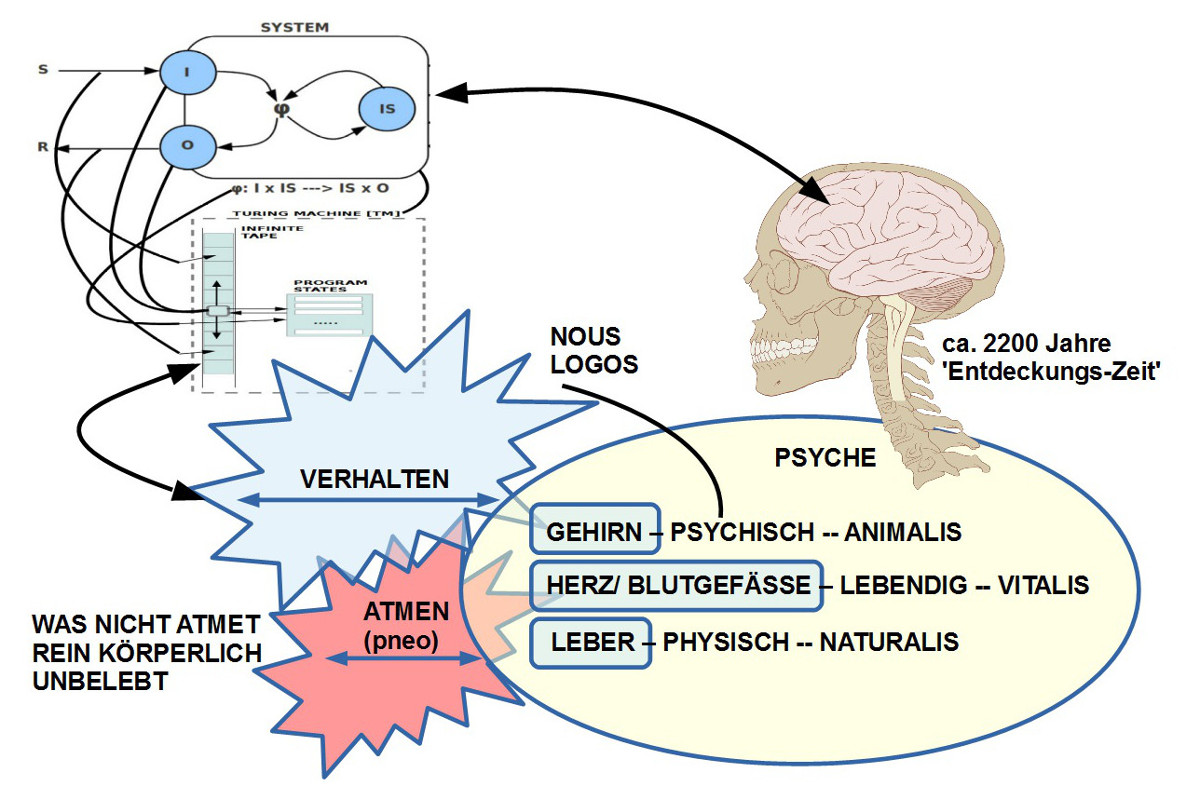

14.00 Uhr Geist zum Nulltarif? Philosophische Aspekte zur Herkunft und zur Zukunft der Informatik. Vortrag und Diskussion

(Prof. Dr. phil. Dipl. theol G. Doeben-Henisch)

Unter dem Titel ‚Geist zum Nulltarif‘ ordnete Prof. Doeben-Henisch den Menschen mit seiner ‚Geistigkeit‘ ein in die Ideengeschichte (‚Geist‘ in der antiken griechischen Philosophie, hier verankert im Phänomen des ‚Atmens‘ (Verb: ‚pneo‘) erweitert zum Lebensprinzip (Substantiv ‚pneuma‘)) und in die Evolution des Lebendigen (‚Geist‘ als eine inhärente Eigenschaft des Biologischen selbst). Die strukturellen Übereinstimmungen zwischen dem Prinzip Computer und biologischen Zellen bis hin zum Gehirn lassen heute nicht erkennen, warum der Computer den Menschen in seinen Fähigkeiten nicht übertreffen können sollte. Die – besonders in den USA – vertretene Hypothese von der kommenden ‚technologischen Singularität‘ geht schon ganz selbstverständlich davon aus, dass die Tage der Menschen gezählt sind; die ‚intelligenten Maschinen‘ werden ‚übernehmen’…

15.00 Uhr Informatik und Gesellschaft Soziologische und kulturanthropologische Aspekte der neuen Informationstechnologien. Vortrag und Diskussion

(Prof. Dr. habil. Dipl. soz. Manfred Faßler)

Dass diese ‚Anpassbarkeit‘ des Computers an gesellschaftliche Abläufe und psychischen Bedürfnissen massive Rückwirkungen auf das Verhalten der Menschen und viele soziale Strukturen hat, thematisierte Prof. Fassler. Er identifizierte in den beobachtbaren Veränderungen einen großen Forschungsbedarf: wie können wir verhindern, dass die Menschen zu bloßen ‚Anhängsel‘ eines einzigen großen kybernetischen Systems werden, das einer ’smarten Humanität‘ zuwider läuft? Und in der Tat, der Reflexionsbedarf der heutigen Informatik gerade mit Blick auf Soziologie und Kulturanthropologie ist drängend; wo aber sind die zugehörigen Forschungsgruppen und Forschungsprogramme?

16.00 Uhr Pause Computermediated Sound/Images 2

(Philip Reul & Markus Härtel)

Die wunderbaren Bilder von Härtel/ Reul, die auf der digitalen Verarbeitung von analogen Prozessen in verschiedenen Flüssigkeiten beruhten, ließen in der ersten Pause dann etwas Leichtigkeit aufblitzen, einen Hauch von Schönheit. Zu erwähnen ist, dass Philip Reul auch Absolvent des Bachelor-Studiengangs Informatik der Hochschule ist sowie des interdisziplinären Masterstudiengangs ‚Barrierefreie Systeme‘ (BaSys).

16.30 Uhr Verkehr von morgen. Total umsorgt, total verkauft? Über Uber, Überwachung, und die neue Mobilität. Vortrag und Diskussion

(Prof. Dr. Jörg Schäfer)

Prof. Schäfer demonstrierte dann am Beispiel der Mauterfassung, wie das vorhandene Knowhow der Informatik von der Politik nicht genutzt wird, um die Privatsphäre bei der Mauterfassung zu wahren. Stattdessen wird direkt auf die Privatheit zugegriffen. Am Beispiel des neuen Fahrgastvermittlungssystem Uber illustrierte Schäfer, wie einige wenige Kapitalgeber mit einer einfachen, billigen Software weltweit hohe Vermittlungsgebühren einziehen können, ohne juristische Verantwortung für das Fahrgastgeschäft selbst zu übernehmen. Er fragte, warum die Bürger dies nicht selbst organisieren, z.B. mit einer ‚genossenschaftlichen Bürgerplattform‘. Noch weiter gedacht: warum sollten Studierende, Professoren und Bürger nicht solch eine Genossenschaft gründen?

17.30 Uhr Robot-Fabriken. Erhöhung der Produktivität; wo bleibt die Arbeit? Vortrag und Diskussion

( Prof. Dr. Kai-Oliver Schocke)

Das Thema ‚Automatisierung‘ bzw. ‚Roboter-Fabriken‘ ist in der Öffentlichkeit wegen unterstelltem Arbeitsplatzverlust schon mit Vorbehalten verhaftet. Prof. Schocke verstand es aber, in einem sehr engagierten Vortrag zunächst einmal die Notwenigkeit einer Produktivitätssteigerung durch weiter automatisierte Fabriken zu klären. Der internationale Konkurrenzdruck zwingt Deutschland, hier an vorderster Stelle mit zu halten. Allerdings zeigte die lebhafte Diskussion, dass damit das Problem der oft zitierten Arbeitsplatzvernichtung möglicherweise noch nicht völlig beantwortet ist. In der Diskussion wurde klar, dass hier alle betroffenen gesellschaftlichen Kräfte herausgefordert sind nach Lösungen zu suchen. den Unternehmen alleine kann man dies nicht anlasten.

18.30 Uhr Pause Computermediated Sound/Images 3

(acrylnimbus)

Tobias Schmitt, ehemaliger Absolvent der Informatik – noch mit dem klassischen Diplom –, der zugleich seit gut 20 Jahren auch experimentelle Musik produziert, komponiert, performed, zeigte ein eigens Kunstvideo parallel zu einem eigenen Soundtrack, den er live spielte.

19.30 Uhr Video Slam zum Thema Informatik und Gesellschaft (Länge eines Videos maximal 7-Min, künstlerisch oder wissenschaftlich, Publikumspreise für die zwei besten Beiträge)

Obgleich die Vorlaufzeit für den Videowettbewerb vergleichsweise sehr kurz war hatte es Einsendungen gegeben und es war möglich, den vom Förderkreis der Hochschule gestifteten Preis an zwei Preisträger zu überreichen. Sowohl Siegfried Härtel wie auch Tom Pluemmer sind profiliert Kunstschaffende. Während Tom Pluemmer seinen Schwerpunkt im Bereich Film hat, hat Siegfried Kärcher in seinem Leben schon eine ganze Bandbreite von künstlerische Aktivitäten aufzuweisen. Darin kommt eine intensive Auseinandersetzung mit Computern in ihren vielschichtigen Einsatzmöglichkeiten ebenso vor wie Lichttechnik, Sounddesign und Videokunst, um nur einiges zu nennen.

21.30-23.00 Uhr Ausgangsereignis Computermediated Sound/Images 4

(Werkstattgespräch mit den Künstlern; Digital Jam-Session)

Hier eine Momentaufnahme von der inspirierenden Improvisation Tobias Schmitt & Guido May. Leider viel zu kurz …

Weitere Berichte, Kommentare können möglicherweise noch folgen. Insbesondere sollen noch Links auf die beiden prämierten Videos folgen.

Eine erste Nachreflexion von cagent zur Tagungfindet sich HIER.

Einen Überblick über alle Einträge in diesem Blog nach Titeln findet sich HIER.