Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 10.Sept. 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

KONTEXT

Die Sitzung am 9.September 2018 hatte eine Vorgeschichte.

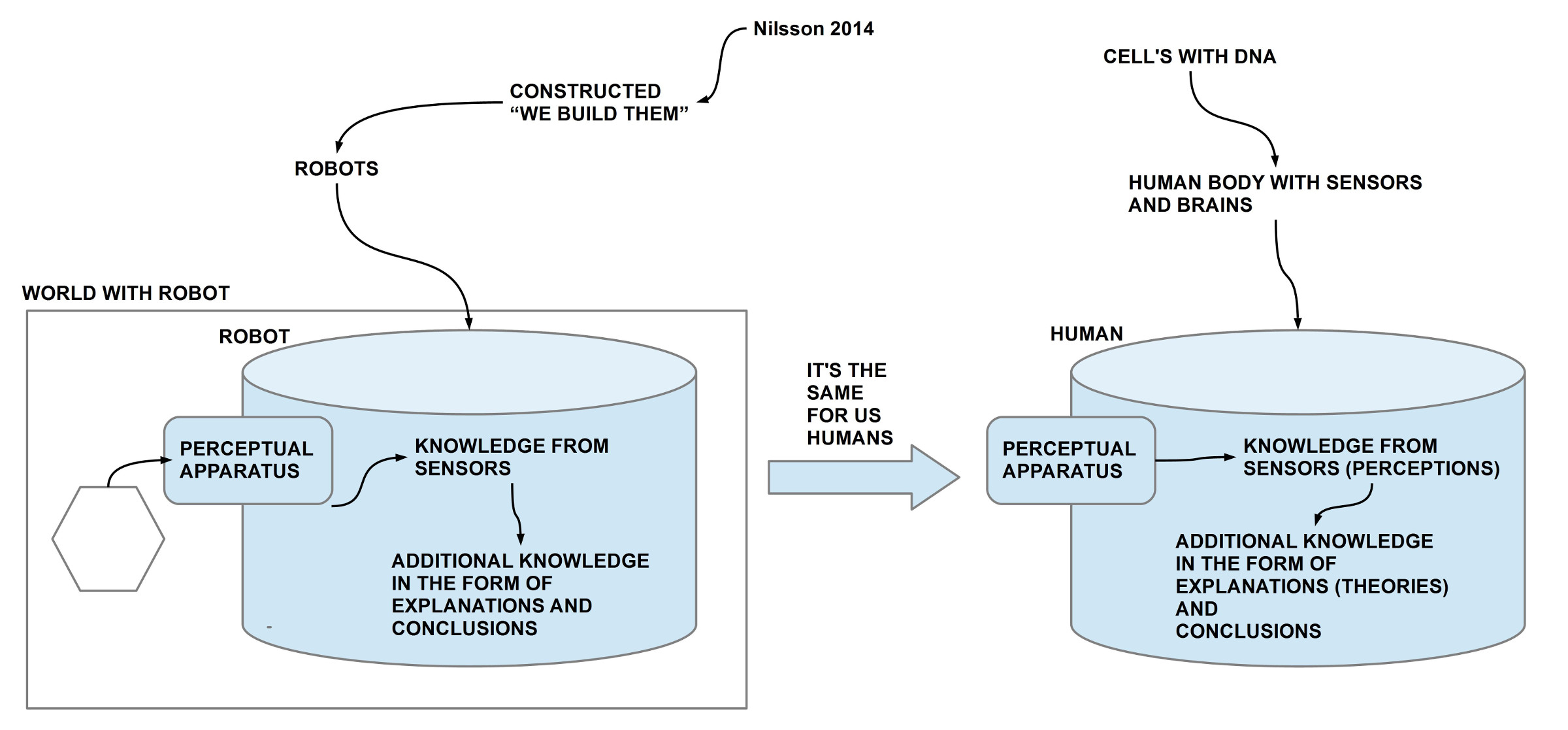

ROBOTER VERLANGEN BESCHREIBUNG

In einer Sitzung im Januar 2018 hatte sich die bunt gemischte Gesprächsrunde die Frage gestellt, ob man einen Psychoanalytiker durch einen Roboter ersetzen könne. Die Analyse kam zur Erkenntnis, dass der Bau eines geeigneten Roboters voraussetzt, dass es eine hinreichend angemessene Beschreibung dessen gibt, was genau ein Psychoanalytiker im Rahmen eines therapeutischen Prozesses tut, wie die Interaktionen mit dem Analysanden sind, und welche speziellen ‚inneren Zustände‘ beim Analytiker gegeben sein müssen, damit er so handeln kann. Damit verschob sich die Aufgabenstellung hin zu einer solchen angemessenen Beschreibung des Psychoanalytikers/ der Psychoanalytikerin in einem Therapieprozess.

PSYCHOANALYSE ALS EMPIRISCHE THEORIE

In der nachfolgenden Sitzung im März 2018 wurde daher das Selbstverständnis der Psychoanalyse im Rahmen des Begriffs einer empirischen Theorie abgefragt. Das erstaunliche Ergebnis war, dass die Psychoanalyse grundsätzlich alle Anforderungen an eine empirische Wissenschaft erfüllt. Sie hat allerdings zwei Besonderheiten: (i) Der Beobachter und der Theoriemacher sind selbst Bestandteil der Theorie; (ii) die Messvorgänge laufen unter Laborbedingungen ab, die neben schon klassifizierten Phänomenen kontinuierlich auch ’neue‘ Phänomene zulässt, die für die Theoriebildung wichtig sein können (für Details siehe den Beitrag).

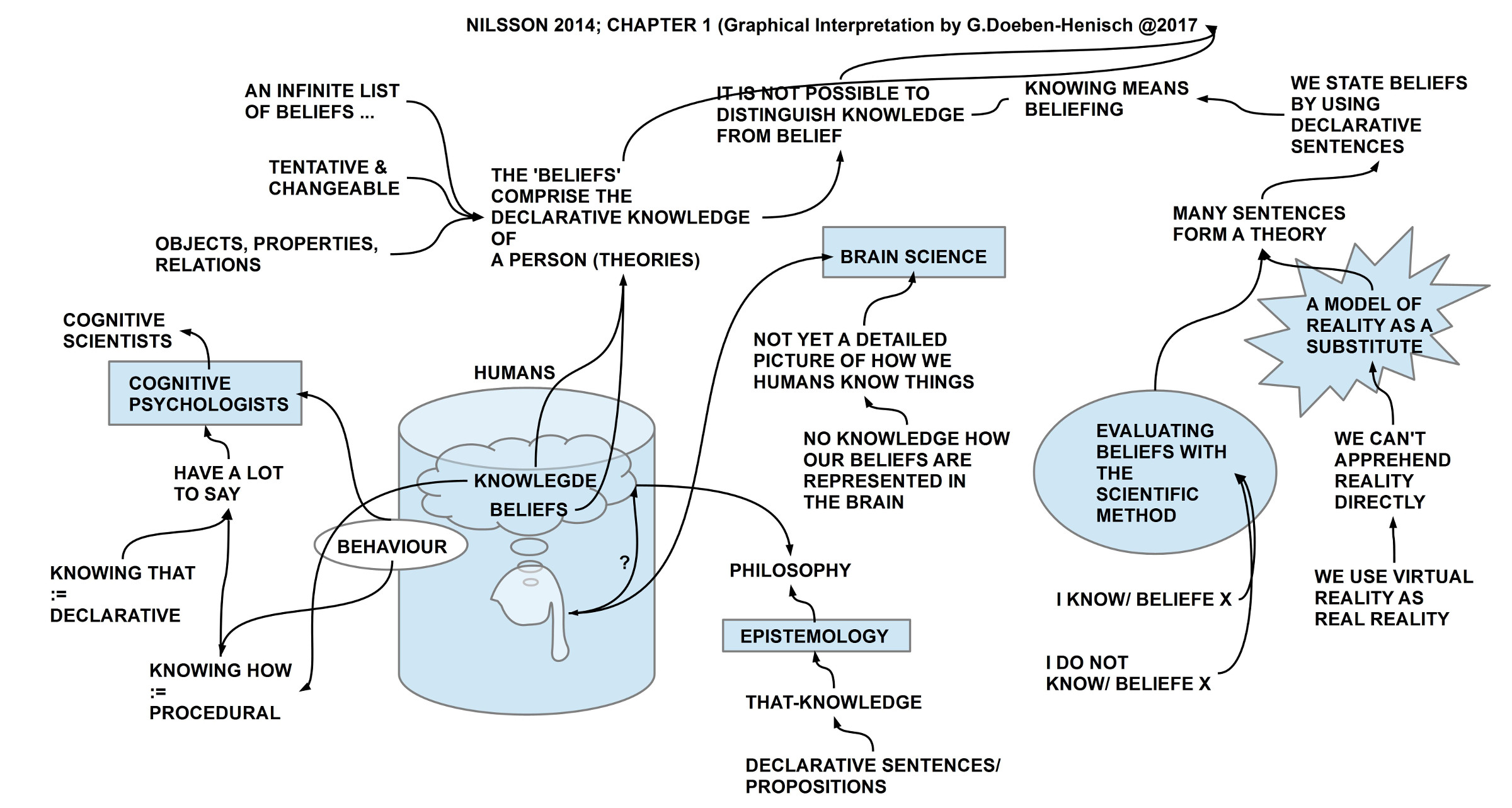

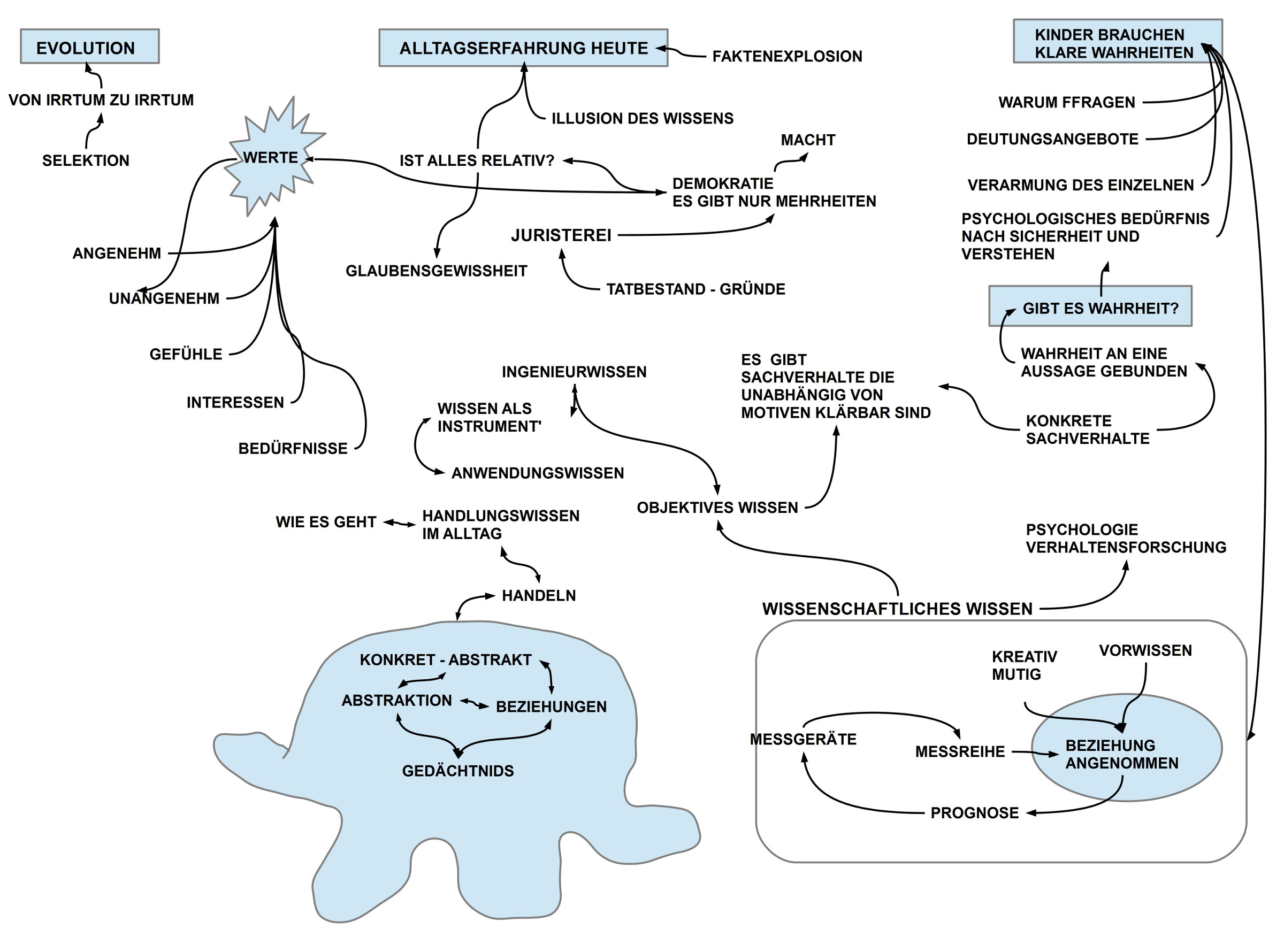

VON DEN DATEN ZUM MODELL

In der nachfolgenden Sitzung im April 2018 fokussierte sich das Gespräch auf das Wechselspiel zwischen ‚Daten‘ und erklärendem ‚Modell‘ (‚Theorie‘) und wie es zum Modell kommt. Speziell im Fall des Psychoanalytikers ergibt sich eine Doppelrolle: (i) als Teil des Prozesses agiert er/sie im Prozess als Mensch mit ‚Un-Bewusstem‘ und und seinen ‚Erfahrungen‘ und seinem bisherigen ‚Modell‘, andererseits (ii) ist er/sie reflektierter Profi, der seine Wahrnehmungen des Analysanden, der Umgebung und seiner selbst mit seinem ‚professionellen Modell‘ abgleichen muss. Der hier offensichtlich werdende ‚dynamische Charakter der Modellbildung‘ ist charakteristisch für jede Modellbildung, wird aber in den meisten empirischen Wissenschaften eher verdeckt. (Für Details siehe den Beitrag).

EINE PSYCHOANALYTISCHE FALLSTUDIE

In der Sitzung vom Mai 2018 wurde nach so viel vorausgehender Theorie ein konkretes Fallbeispiel betrachtet, das eine der teilnehmenden Psychoanalytikerinnen vorstellte. Dieses Beispiel demonstrierte sehr klar, wie die Psychoanalytikerin als aktives Moment im Therapieprozess im Bereich des Un-Bewussten mit dem Analysand interagiert und dadurch diesen in die Lage versetzt, einen Zugriff auf jene Faktoren zu bekommen, die im Un-Bewussten das Verhalten über Jahrzehnte massiv beeinflusst hatten. Dadurch lies sich dann schnell und wirkungsvoll eine qualitative Verbesserung der Situation des Analysanden herstellen.

WISSENSCHAFTSPHILOSOPHISCHE AKTUALITÄT DER PSYCHOANALYSE

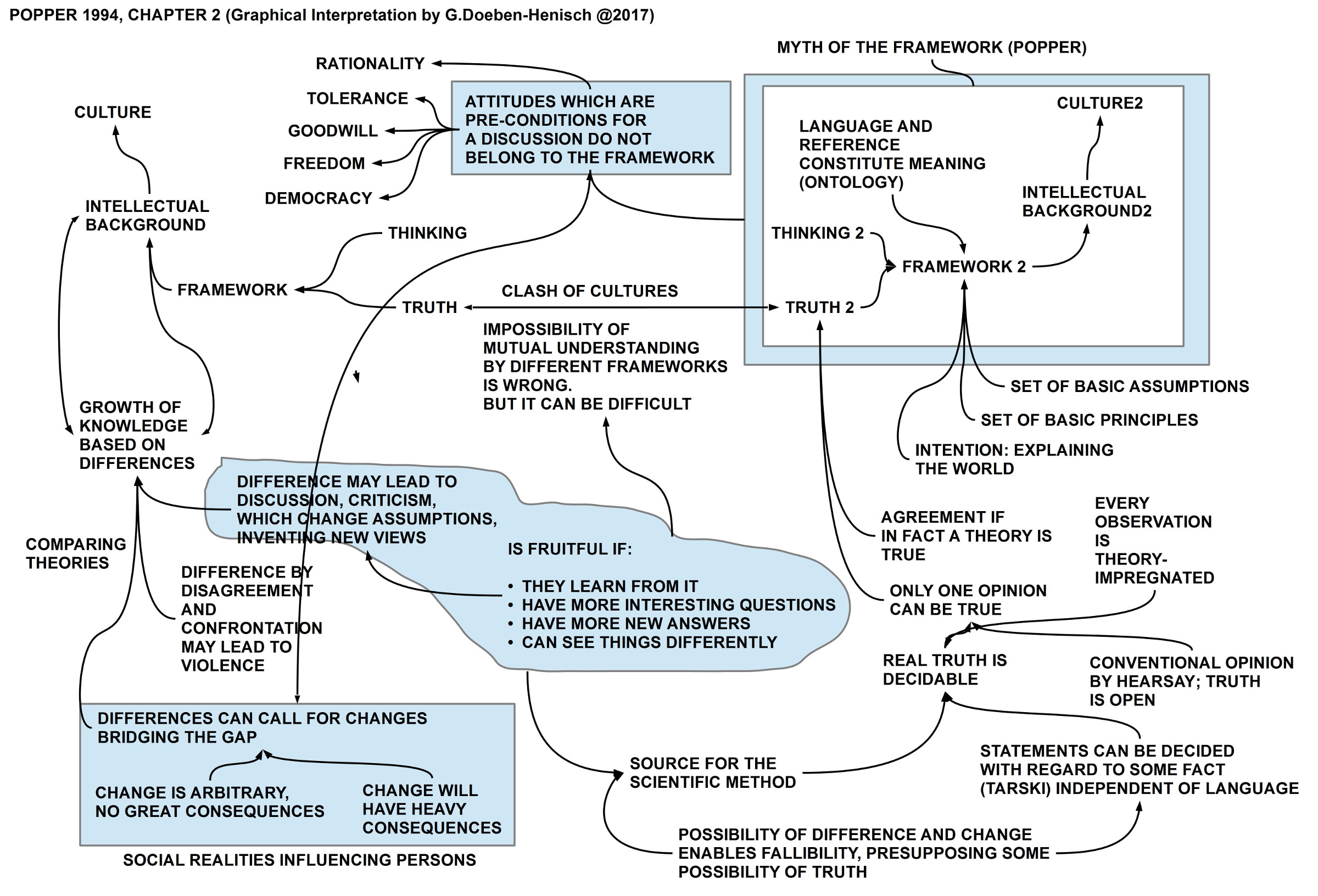

GEISTESWISSENSCHAFTEN VERSUS NATURWISSENSCHAFTEN

Die Gegensatzbildung zwischen ‚Geisteswissenschaften‘ einerseits und ‚Harten Wissenschaften‘ andererseits ist nicht neu und bei vielen so eine Art Stereotyp, das man gar nicht mehr hinterfragt. In den ‚harten Wissenschaften‘ selbst gibt es aber immer wieder von einzelnen selbst-kritische Überlegungen zur Problematik des ‚Beobachters‘ und des ‚Theoriemachers‘, die aus der eigentlichen Theorie ausgeklammert werden, was wissenschaftsphilosophisch zu erheblichen Problemen führt (Ein prominentes Beispiel, was ich auch gerade im Blog analysiere und diskutiere ist Edelman, ein exzellenter Erforscher des Immunsystems und des Gehirns).

INGENIEURWISSENSCHAFTEN

In den Ingenieurwissenschaften, die den empirischen Wissenschaften in Sachen Formalisierung in Nichts nachstehen, eher noch ausführlicher und in vielen Fällen erheblich detaillierter sind, gibt es dagegen schon seit vielen Jahren die wachsende Erkenntnis, dass 60 – 80% der Projekte nicht daran scheitern, dass die beteiligten Experten zu wenig wissen, sondern daran, dass die beteiligten ExpertenInnen ihre eigenen psychologischen Zustände zu wenig kennen, mit ihnen nicht umgehen können, diese in die Planung von Projekten und den zugehörigen komplexen Formalisierungen nicht einbeziehen. Statt von ‚Beobachter‘ und ‚Theoriemacher‘ spreche ich hier vom ‚Akteur‘ als jenem Moment eines Theorieprozesses, das sowohl die Theorie entwickelt als auch anwendet. Eine moderne und zukunftsfähige Theorie des Engineerings wird nicht umhin kommen, irgendwann den Akteur selbst in die Theoriebildung einzubeziehen (einen Theorieansatz in diese Richtung findet sich in dem Online-Buchprojekt ‚Actor-Actor-Interaction Anaysis‘).

PSYCHOANALYSE ALS PROTOTYP

Interessant ist, dass die Psychoanalyse eigentlich ein Prototyp einer solchen ‚Beobachter-Integrierten empirischen Theorie‘ ist, und zwar schon von Anfang an. Wie Jürgen Hardt, einer der teilnehmenden Psychoanalytiker, in Erinnerung rief, hatte der Begründer der Psychoanalyse, Freud, von Anfang an die Forderungen aufgestellt, (i) dass die Psychoanalyse eine Naturwissenschaft sein muss, allerdings (ii) mit dem methodischen Hinweis, dass man das ‚Seelische‘ nicht mit den unleugbar somatischen Parallelvorgängen (im Gehirn, im Körper) verwechseln dürfe. Aus Sicht eines verkürzten Empirieverständnisses wurde dies oft als ‚un-empirisch‘ oder gar als ‚dualistisch‘ charakterisiert. Dies ist jedoch unangemessen. Freud ging es primär darum, zunächst mal jene ‚Phänomene zu retten‘, die sich bei dem damaligen Zustand der empirischen Wissenschaften noch nicht in die aktuellen theoretischen Modelle (sofern es denn überhaupt echte empirische Modelle waren) einordnen liesen. Es zeichnet ‚wahre empirische Wissenschaft‘ schon immer aus, dass sie ‚Phänomene‘ akzeptiert, auch und gerade dann, wenn die aktuelle Theoriebildung sie noch nicht einordnen kann.

KEIN DUALISMUS

Dazu kommt, dass man die Charakterisierung von ‚Dualismus‘ selbst sehr kritisch hinterfragen muss. In der modernen Mathematik und damit auch in allen empirischen Theorien, die Mathematik benutzen (was letztlich alle empirischen Disziplinen sind, die den Anforderungen einer ‚wissenschaftlichen‘ Theorie gerecht werden wollen) gibt es nur zwei Grundbegriffe:’Menge‘ und ‚Relation (Funktion)‘. Während man für das abstrakte Konzept ‚Menge‘ in der empirischen Wirklichkeit nahezu beliebig viele konkrete ‚Objekte‘ finden kann, die als ‚Instanzen/ Beispiele‘ für Mengen dienen können, sozusagen die Prototypen für ‚Reales‘, lassen sich für ‚Relationen/ Funktionen‘ so leicht keine direkte Entsprechungen finden. ‚Relationen‘ bestehen nur ‚zwischen‘ Objekten, ‚Funktionen‘ dagegen lassen sich ‚Veränderungen‘ zuschreiben. Beides ‚Beziehungen zwischen‘ und ‚Veränderungen‘ sind keine realen Objekte; sie existieren quasi nur in unserer Wahrnehmung als ‚virtuelle‘ Objekte. Das Verhältnis zwischen ‚realen Objekten‘ und ‚virtuellen Relationen/ Funktionen‘ würde man daher nicht als ‚Dualismus‘ bezeichnen, da der Begriff des Dualismus spätestens seit Descartes eher für die Forderung nach zwei unterschiedliche ‚Substanzen‘ (‚res extensa‘, ‚res cogitans) reserviert hat. Objekte kann man vielleicht als Substnzen (‚res extensa‘) bezeichnen, nicht aber ‚virtuelle Relationen/ Funktionen‘.

Angewendet auf die Psychoanalyse wäre die Freudsche Unterscheidung von ’somatischen Prozessen‘ (Gehirn/ Körper als ‚res extensa‘, denen zugleich aber auch ‚dynamische‘ Eigenschaften zukommen (= Funktionen)) und dem ‚Seelischen‘, das sich qualitativ im ‚Bewusstsein‘ zeigt (= Phänomene als ‚virtuelle Objekte‘ (mit virtuellen Beziehungen) in einer spezifischen Dynamik (mit virtuellen Funktionen)) dann kein klassischer Dualismus sondern eine Unterscheidung unterschiedlicher Phänomenklassen, denen unterschiedliche Gesetzmäßigkeiten zukommen.

SYSTEMISCHES KONZEPT

Was viele gern übersehen, das ist die ‚Gesamtsicht‘, die der Psychoanalyse zu eigen ist. Freud selbst tendierte in seiner Spätphase (Hinweis Jürgen Hardt) zu einem ‚organismischen‘ Denken, wie er es nannte; heute würde man es vielleicht ’systemisch‘ nennen. Durch die Anerkennung der Tatsache, dass das ‚Bewusstsein‘ nur einen Teil – heute müsste man vielleicht sagen: einen sehr kleinen Teil! – der Vorgänge im menschlichen Körper abbildet, wobei das ‚Un-Bewusste‘ letztlich den ganzen Restkörper beinhaltet, muss die Psychoanalyse jede Reaktion eines Akteurs als eine ‚Antwort des ganzen Systems‘ betrachten, die in den meisten Fällen von Prozessen und Faktoren verursacht werden, die eben un-bewusst sind. Insofern es weder aktuell eine vollständige Theorie aller Körperprozesse gibt noch man davon ausgehen kann, dass die Menge der möglichen Körperprozesse endlich und konstant ist, nicht einmal im Fall eines einzelnen Akteurs, ist die psychoanalytische Theoriebildung kontinuierlich in einer Situation, wo es eine Modellvorstellung M bis zum Zeitpunkt t gibt, die ab dem Zeitpunkt t mit einer offenen Menge von Phänomenen Ph_t+ konfrontiert werden kann, die vielfach bzw. überwiegend noch nicht Teil des bisherigen Modells M sind. Sofern das Modell M Anhaltspunkte für Interpretationen oder Verhaltensprognosen gibt, kann der Therapeut danach handeln; sofern das Modell ’schweigt‘, muss er das tun, was die Evolution seit 3.8 Milliarden Jahren tut: mangels Wissen über die Zukunft lassen biologische Populationen die Bildung von ‚Varianten‘ zu, von denen vielleicht einige dann in der Zukunft ‚passen‘, wenn alle anderen aufgrund von Veränderungen der Umgebung ’nicht mehr passen‘. Dieses ‚Handeln bei mangelndem Wissen ist der wichtigste Überlebensakt aller biologischer Systeme. Die ‚Quelle‘ für psychotherapeutische Verhaltensvarianten ist das eigene System, der Körper des Psychoanalytikers, schwerpunktmäßig sein Un-Bewusstes, das ‚aus sich heraus‘ wahrnimmt und reagiert.

Von den Psychoanalytikern wurde zahllose Beispiel angeführt, deren Phänomenologie die Arbeitshypothese nahelegt, dass es zwischen dem ‚Un-Bewussten‘ des Therapeuten und dem Un-Bewussten des Patienten offensichtlich eine Kommunikation im Nicht-Bewussten-Bereich geben muss, da unbewusste Zustände des Patienten, von denen der Therapeut bis dahin nichts wusste, sehr charakteristische Körperzustände beim Therapeut hervorriefen, die dann zum ‚Katalysator‘ dafür wurden, dass der Therapeut und der Patient dadurch einen entscheidenden Hinweis auf die zugrunde liegenden un-bewussten Faktoren im Patient gewinnen konnten.

Angesichts dieser Systemsicht und ihrer komplexen Dynamik stellt sich die Frage nach der Funktion des ‚Bewusstseins‘ ganz anders. Irgendwie erscheint das Bewusstsein wichtig (mindestens für alle sprachliche Kommunikation und explizite Planung), aber irgendwie ist das Bewusstsein nur ein kleiner Teil eines viel größeren dynamischen Systems, dessen Ausmaß und genaue Beschaffenheit weitgehend im Dunkeln liegt. Die moderne Gehirnforschung (wie auch die gesamte moderne Physiologie) könnte hier sicher viele wertvolle Erkenntnisse beisteuern, wären sie nicht bislang wissenschaftsphilosophisch so limitiert aufgestellt. Viele der möglichen interessanten Erkenntnisse ‚verpuffen‘ daher im Raum möglicher Theorien, da diese Theorien nicht ausformuliert werden.

ERFOLGSKRITERIEN

Natürlich kann und muss man die Frage stellen, inwieweit ein psychoanalytisches Modell – oder gar eine ausgebaute Theorie – ‚verifizierbar‘ bzw. ‚falsifizierbar‘ ist. Berücksichtigt man die methodischen Probleme mit dem Begriff der ‚Falsifikation‘ (siehe dazu die kurze Bemerkung Nr.18 im Blogbeitrag vom 5.September 2018) beschränken wir uns hier auf den Aspekt der ‚Verifikation‘.

Eine Verifikation wäre im allgemeinen die ‚Bestätigung‘ einer ‚Prognose‘, die man aus dem ‚bestehenden Modell‘ ‚abgeleitet‘ hatte. Da das ‚bestehende Modell‘ im Fall der Psychoanalyse im allgemeinen nicht als ‚formalisiertes Modell‘ vorliegt, kann es sich bei den möglichen ‚Prognosen‘ daher nur um ‚intuitive Schlüsse‘ des Therapeuten aus seinem ‚bewusst-unbewussten‘ Modell handeln. Im praktischen Fall bedeutet dies, dass (i) es einen ‚therapeutischen Prozess‘ gab, der alle offiziellen Anforderungen an einen psychoanalytischen Prozess erfüllt, dass (ii) ein Zustand erreicht wird, in dem der Patient einen höheren Grad an ‚Selbststeuerung‘ erreicht hat. Dies kann sich an vielerlei Phänomenen fest machen, z.B. der Patient hat weniger ‚Angst‘, sein ‚körperlicher Gesundheitszustand‘ ist besser geworden, er kann seine ‚Alltagsaufgaben besser lösen‘, er ist generell ‚weniger krank‘, er besitzt mehr ‚Selbstvertrauen‘ im Umgang mit zuvor gefürchteten Situationen, und dergleichen mehr. All diese Phänomene kann man objektivieren. Die sehr verbreiteten Auswertungen nur per Fragebogen sind eher unbrauchbar und nutzlos.

WEITERES VORGEHEN

Zum ersten Mal tauchte die Idee auf, die bisherigen Gespräche zur Psychoanalyse in einem kleinen Büchlein zusammen zu fassen und zu publizieren.

Eine spontane Fortsetzung findet sich HIER.

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER.