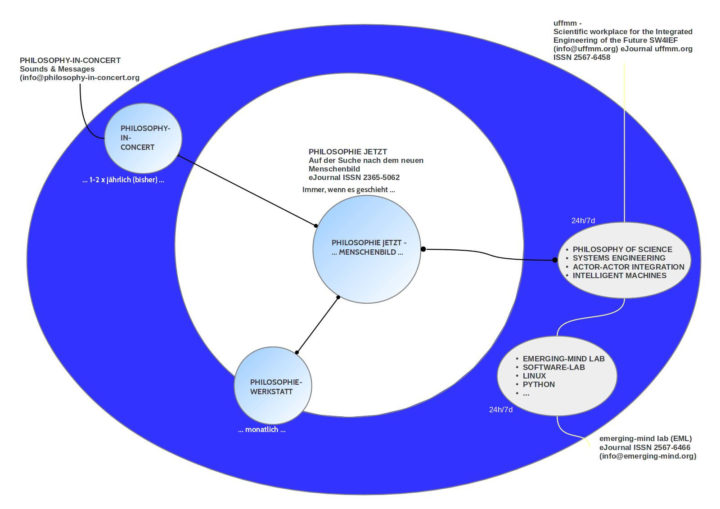

Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 8.September 2022 – 10. September 2022, 10:12h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Kontext

In dem Parallelblock uffmm.org entwickelt der Autor das Konzept einer nachhaltigen empirischen Theorie (siehe z.B. „COMMON SCIENCE as Sustainable Applied Empirical Theory, besides ENGINEERING, in a SOCIETY“, ein Beitrag, der hervorgegangen ist aus den Überlegungen zu „From SYSTEMS Engineering to THEORY Engineering“), in der die Menschheit eine zentrale Rolle spielt, nicht losgelöst von der Biosphäre, nicht losgelöst vom gesamten Universum, sondern als eine ‚Handlungsmacht‘, die in diesen empirischen Substrat genannt ‚empirische Wirklichkeit‘ eingebettet ist.

Vor diesem Hintergrund erscheint das Buch von Glaubrecht zum Ende der Evolution auf den ersten Blick wie eine willkommene Ergänzung, eine Geschichte aus der Sicht der biologischen Evolution, wie ein ‚missing link‘, in dem das aktuelle wissenschaftliche Chaos und die zerstörerischen Kräfte einer entfesselten menschlichen Population ihren Erzähler finden.

Doch, lässt man sich auf die ruhig und sachlich wirkende ‚Erzählungen‘ dieses Buches ein, dann begegnet man im geradezu epischen Prolog Gedankenmuster, die wie ‚Disharmonien‘ wirken, wie ‚falsche Töne‘ in einer ansonsten berauschenden Sinfonie von Klängen.

Ein Prolog wie eine Ouvertüre

Glaubrecht lässt seine Erzählung beginnen mit dem einem Foto von William Alison Anders, einem Astronauten der Apollo-8 Mission 1968, das um die Welt ging, und mittlerweile einen ‚Kultstatus‘ hat: die blaue Kugel im Schwarz des umgebenden interstellaren Raumes, wundersam, so unwirklich, ein Bild ‚wie im Traum‘. Und doch, es ist kein Traum. Es ist der Ort von etwas, was wir gelernt haben, ‚biologisches Leben‘ zu nennen. Ein multidimensionales Phänomen, das nach heutigem Kenntnistand einzigartig im gesamten bekannten Universum ist. Diesen ‚Gedanken der Einzigartigkeit‘ greift Glaubrecht auf und pointiert ihn sehr stark, indem er die neuesten Forschungen zu einem ‚möglichen extra-terrestrischen Leben‘ auswertet und diese Option eines ‚anderen Lebens irgendwo dort draußen‘ quasi ad absurdum führt. (vgl. SS.21-24)

Nach diesem argumentativen ‚knock down‘ für die Option eines Lebens außerhalb der Erde wendet er sich dann dem Phänomen des Lebens auf der blauen Erde zu, und rafft die ca. 3.5 Milliarden Jahre Entstehung des Lebens auf der Erde mit Akzentuierung des Homo sapiens in 14 Zeilen auf S.24 zusammen. Die 14 Zeilen schließen mit der Bemerkung „obgleich wir … im kosmischen Maßstab kaum mehr sind als eine Eintagsfliege der irdischen Evolution“.

Fast könnte man das Buch an dieser Stelle zuklappen, es beiseite legen, und vergessen, dass es dieses Buch gibt.

Was immer der Autor Glaubrecht an wunderbaren Dingen in seinem Kopf haben mag, weiß, denkt, fühlt, mit dieser Aussage am Ende seiner 14 Zeilen Evolution auf S.24 deutet er an, dass er den Menschen in seiner biologischen Erscheinungsweise sehr ‚klassisch biologisch‘ sieht, Produkt einer ‚biologischen Hervorbringung‘, von der viele Biologen zu glauben wissen, was biologisches Leben ist. Dieser sich hier nurmehr ‚andeutende Akzent‘, dieser ‚gedankliche Tonfall‘, wird die ganze ‚Sinfonie der Gedanken‘ im weiteren Gang begleiten, verfolgen, und zu Disharmonien führen, die das ganze Werk in einen Abgrund zu reißen drohen, aus dem es kein gedankliches Entkommen zu geben scheint. ‚Schwarze Löcher‘ sind nicht nur ein Problem der heutigen theoretischen Physik.

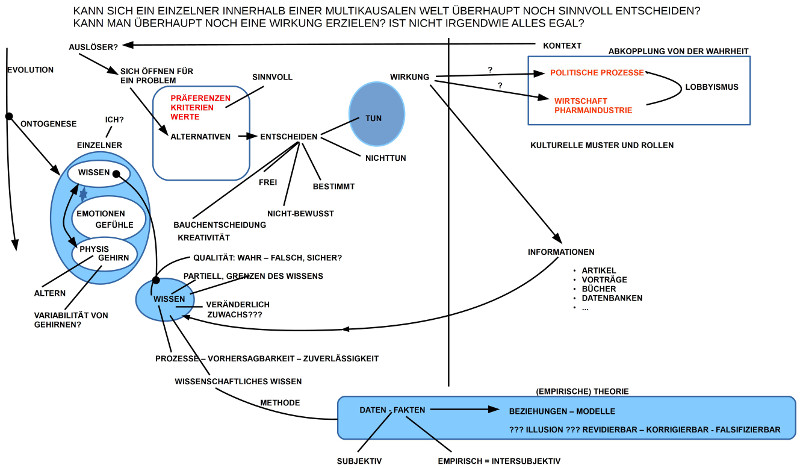

Nachdem Glaubrecht (SS.24-28) die großen Phänomene einer tiefgreifenden Störung der Biosphäre und ihrer planetarischen Umgebung ins Bewusstsein gerufen hat (Bevölkerungsentwicklung, Ressourcenverbrauch, dramatisches Artensterben, Klimaextreme), deutet er auf das widersprüchliche Phänomen hin, dass es gesellschaftlich zwar schon — auch seit längerem — eine gewisse Wahrnehmung dieser Phänomene gibt (vgl. z.B. S.27), dass diese partiellen gesellschaftlichen Wahrnehmungen aber noch zu keiner wirklich wirksamen gesellschaftlichen Verhaltensänderung geführt zu haben scheinen.

Wer sollte diese ‚Gegenbewegung‘ zu einer wahrnehmbaren globalen zerstörerischen Dynamik auslösen? Woher sollte sie kommen?

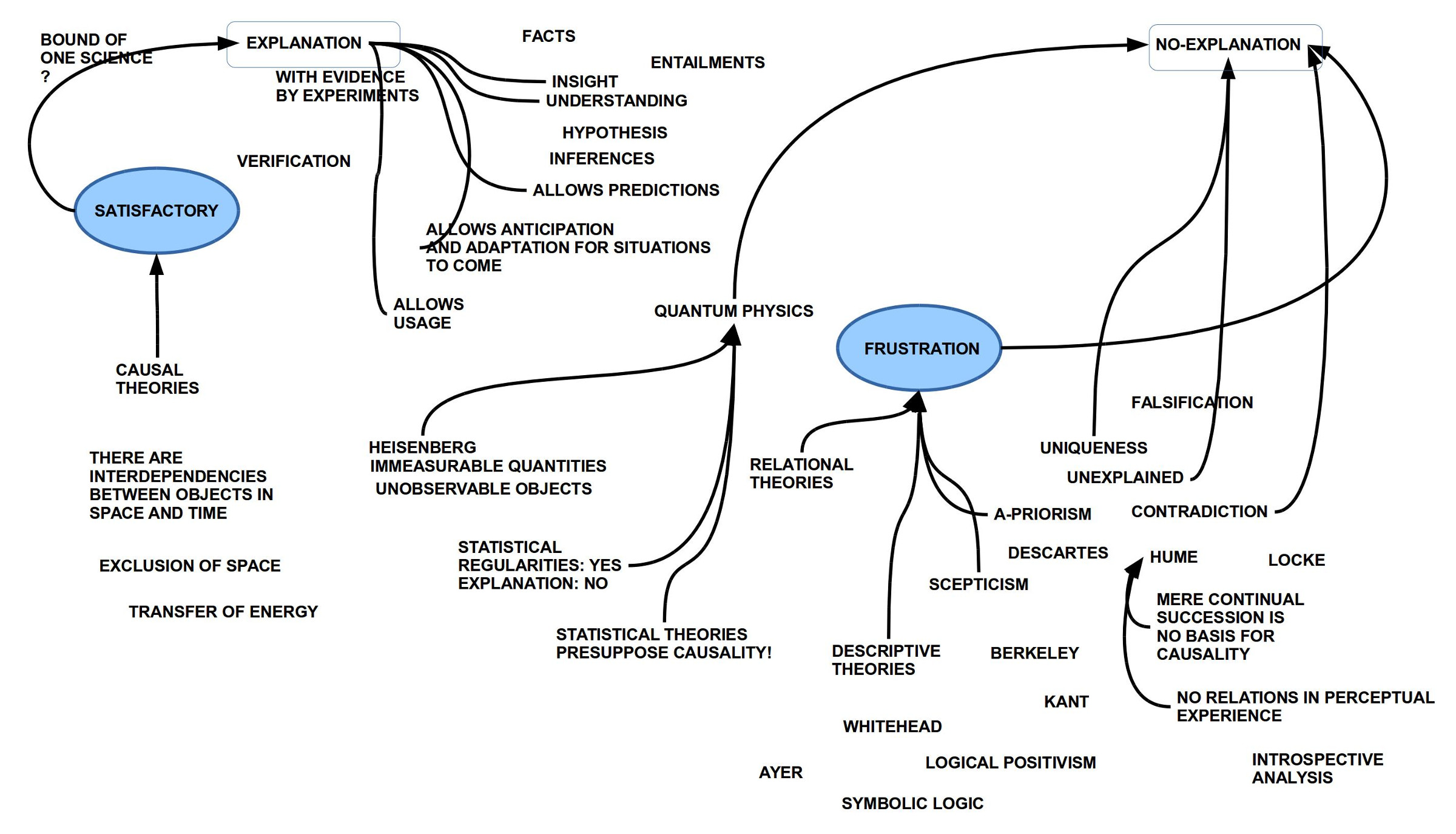

Auf den Seiten 28-30 bekennt sich Glaubrecht klar zum Faktor ‚Wissen‘: „Der Schlüssel zu allem ist Wissen; ohne Kenntnis der Fakten und Hintergründe, der Daten und Quellen ist ein sicherer Umgang mit den komplexen Szenarien unserer Gegenwart nicht möglich, geschweige denn, dass sich die Herausforderungen der Zukunft meistern lassen.“(S.28) Allerdings, diese Bemerkung ist wichtig, Wissenschaft kann wirklich verlässlich „nur Vergangenes und bereits Geschehenes deuten“.(S.29) Dies klingt eher resignativ und wäre möglicherweise kaum ein Hilfe, gäbe es nicht doch auch — so Glaubrecht — die Möglichkeit, aus der Vergangenheit zu „lernen“ und „mithin Vorhersagen erleichtern“.(vgl. S.29)

Glaubrecht sagt nicht viel — eigentlich gar nichts — zur Frage, wie denn überhaupt Prognosen möglich sein können, was ihre Randbedingungen sind. Und irgendwie scheint ihm diese Option der ‚Prognose‘ ein wenig suspekt zu sein, beginnt er doch dann den Abschnitt darüber, wie er in seinem Buch arbeiten will, mit einem verstärkten Zweifel an der Möglichkeit von Prognosen (sein Zitat von Niels Bohr, S.30, Zeilen 1-2) und stellt fest „Tatsächlich ist Wissenschaft immer nur im Rückblick wirklich gut“.(S.30)

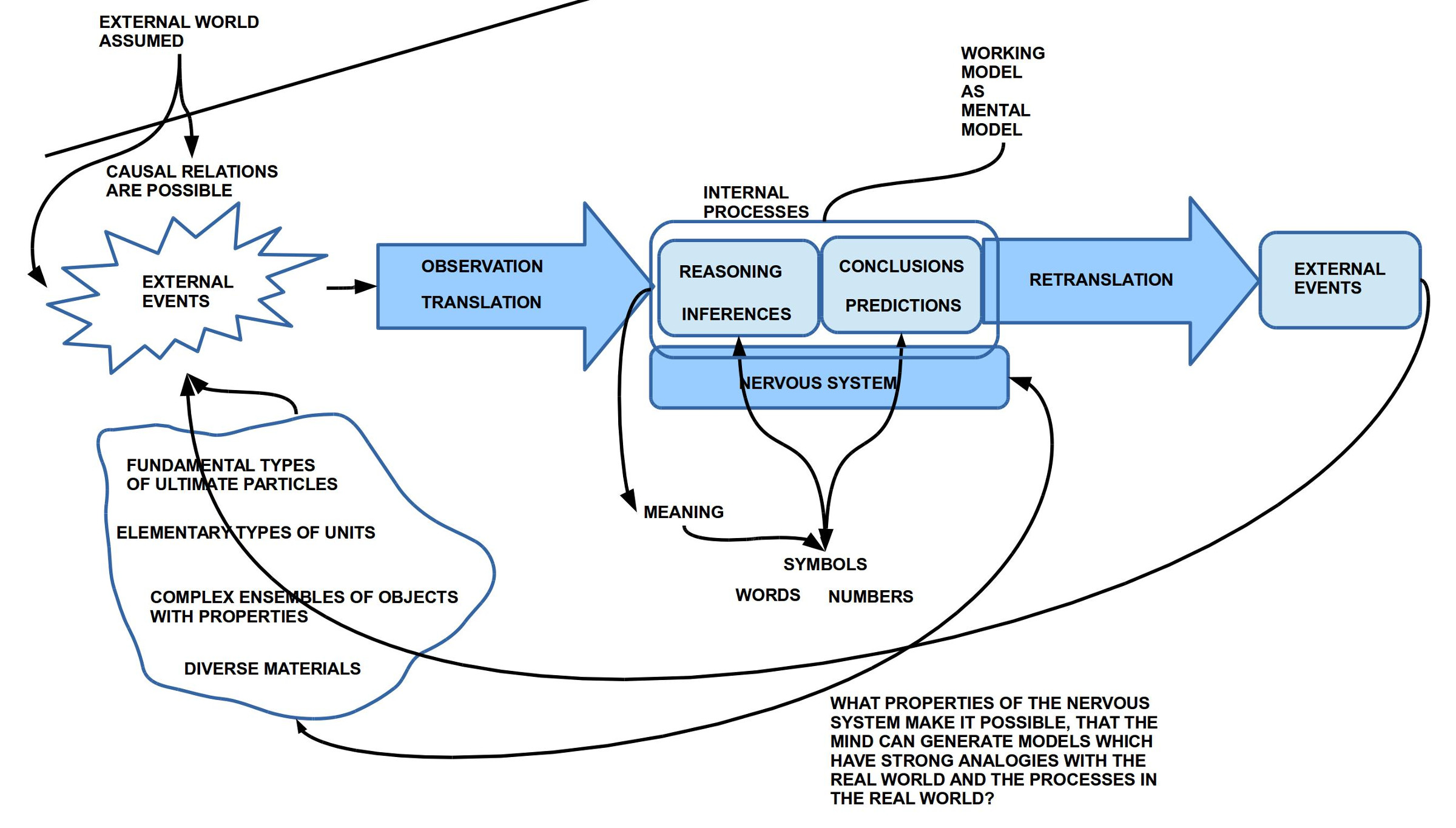

Damit mehren sich die Fragen, was Glaubrecht denn genau unter ‚Wissenschaft‘ versteht? Prognosen bezweifelt er, und der ‚Rückblick‘ soll es richten? Und er betont, dass es hier nicht nur um sein eigenes „Bauchgefühl“ — das eines einzelnen Wissenschaftlers — geht, der „sein Bauchgefühl zur Wissensautorität erhebt“ (S.28), sondern darum „Evidenzen“ zu sichern.(vgl. S.28f) Er verweist dann auf die Wissenschaftstheorie, die betone, dass das Gute an Wissenschaft sei, „dass wir ein Verfahren haben, den Gegenständen unserer Forschung gerecht zu werden, und unsere Ansichten, Befunde und Meinungen methodisch zu testen gelernt haben, statt uns im Vagen und Wunschdenken zu verlieren.“(S.29)

Eine Formulierung wie „den Gegenständen unserer Forschung gerecht zu werden“ ist natürlich ‚vage‘, und der Hinweis „unsere Ansichten, Befunde und Meinungen methodisch zu testen gelernt haben“ soll vielleicht weiter beruhigend wirken, aber diese Formulierung ist auch vage. Eine Kernbedeutung von ‚Testen‘ ist normalerweise jene, dass ich aus ‚Annahmen‘, die ich als Wissenschaftler — warum auch immer — mache, eine ‚Folgerung‘ (eine ‚Prognose‘) ableite, die ich dann ‚teste‘. Dieses Konzept der Generierung von ‚Prognosen‘ setzt einen ‚Mechanismus‘ (ein ‚Verfahren‘) voraus, wie ich aus Annahmen eine Prognose ‚ableiten‘ kann. Wie zirka 2.500 Jahre Philosophie und etwa 150 Jahre Wissenschaftsphilosophie zeigen, ist dies alles andere als ein ‚trivialer Sachverhalt‘. Glaubrecht schweigt dazu. Was sagt dies über seine Wissenschaftlichkeit … und jene der Evolutionsbiologie und Biodiversitätsforschung? Fakten ja, aber keine Prognosen?

Und es gibt noch einen Punkt, der bedenklich stimmen kann, ja sollte. Nach seiner wissenschaftsphilosophischen Verortung, die sich in vagen Andeutungen erschöpft, kommt er zu folgender Feststellung: „Just beim Blick in die biohistorischen Vergangenheit ist die Evolutionsforschung in ihrem Metier. Ausgerüstet mit dem Blick des Evolutionsbiologen und dem Wissen des Biodiversitätsforschers zur Artenvielfalt ebenso wie Artenschwund soll es hier um den Menschen, seine Wurzeln in der Natur und die Entwicklung seiner Kultur sowie um unseren Umgang mit der Natur gehen; schließlich auch darum, wohin uns das zukünftig führt“.(S.30)

Dass „Evolutionsbiologen und … Biodiversitätsforscher“ besonders geschult sind, um ‚evolutionäre biologische Prozesse‘ sowie die ‚Entwicklung von biologischen Arten‘ zu identifizieren und zu beschreiben, das mag man zunächst noch glauben; den nächsten Schritt, nämlich solche ‚auf Beobachtung beruhenden Evidenzen‘ dann sogar in ‚geeignete voraussagefähige Modelle‘ einzuordnen, muss man nicht unbedingt glauben. Noch weniger sollte man so ohne weiteres glauben, dass ‚Evolutionsbiologen und Biodiversitätsforscher‘ einfach so auch befähigt sind, komplexe Phänomene wie ‚Kultur‘ bzw. überhaupt ‚menschliche Gesellschaften‘ zu beschreiben. Ein Schreiner mag zwar an einem Haus Aspekte erkennen, die mit seiner Profession als Schreiner Überschneidungen aufweisen, aber er wird damit nicht zum ‚Multi-Handwerker‘, keinesfalls automatisch zum ‚Architekt‘ oder ‚Bauingenieur‘.

Mit dieser Selbstüberschätzung einzelner Disziplinen steht Glaubrecht nicht alleine. Er reproduziert damit nur ein Muster, was sich heute — leider — in nahezu allen wissenschaftlichen Einzeldisziplinen findet: jeder kultiviert seine eigene ‚Wissenschaftssprache‘, seine eigenen ‚wissenschaftlichen Methoden‘, aber die Fähigkeit zum ‚transdisziplinären‘ Denken und zu einer ‚gemeinsamen allgemeinen Theorie‘ existiert bislang eher nur in Absichtserklärungen. Eine der Folgen von dieser ’spendid isolation‘ der moderner Einzelwissenschaften ist genau das, was Glaubrecht — zu Recht — konstatiert: es gibt viele, verstreute Wahrnehmungen von ‚bedenklichen Entwicklungen‘ auf diesem Planeten, aber eine ‚Zusammenschau‘, die sich über ein ‚gemeinsames Wissen‘ organisieren müsste, findet nicht statt, weil wir als Menschen uns den Luxus leisten, in den Köpfen der überwältigenden Mehrheit ‚Weltbilder‘ zu hegen, die mit der realen Welt und ihrer Dynamik wenig zu tun haben. Für populistische und autokratische Gesellschaften eine ideale Umgebung.

Diese eher kritischen Bemerkungen zum wissenschaftlichen Setting des Buches sollten aber nicht davon ablenken, dass die Fülle der Fakten und Einsichten zu jenen Veränderungsprozessen planetarischen Ausmaßes, die Glaubrecht darbietet, wichtig sind. Diese Fülle ist atemberaubend. Doch diese wunderbare Seite des Buches darf nicht darüber hinweg täuschen, dass das schwierige wissenschaftlichen Setting des Buches sich voraussichtlich dort bemerkbar machen wird, wo es um eine Einschätzung der möglichen Zukunft gehen wird, ob und wie wir diese werden bewerkstelligen können. Auf dem Weg dahin wird es natürlich vielfach Sachverhalte geben, deren Einschätzung aufgrund seines Vorverständnisses vorzüglich in die Richtung seines Vorwissens laufen werden. Dies ist unausweichlich.

Auf den Seiten 30-35 lässt Glaubrecht umrisshaft erkennen, wie er sein Buch in drei Teilen organisieren will. Vor dem Blick in die Zukunft (Prognose!) ein langer Blick zurück in die Vergangenheit: Befunde, Fakten, Zusammenhänge. (vgl. S.30)

Im Rückblick auf den bisherigen Weg des Menschen zeichnet er das Bild eines „Pfadfinders“, der neugierig umherzieht, der sich überall aus einer scheinbar kostenlosen, unerschöpflichen Natur bedient, und der sich dabei rein zahlenmäßig dermaßen vermehrt, dass er nach und nach die gesamte planetarische Oberfläche in Besitz genommen und dabei so verändert hat, dass der Lebensraum nicht nur für erschreckend viele andere Arten genommen und zerstört wurde, sondern mittlerweile auch für sich selbst. Diese Auswirkungen des Menschen auf den Planeten sind so massiv, dass Geowissenschaftler eine neue erdgeschichtliche Epoche mit Namen „Anthropozän“ vorschlagen. (vgl.S.33) Alle Indizien deuten auf ein neues, sechstes, planetarisches Artensterben hin.(vgl. S.33) Dass es für uns Menschen scheinbar immer noch funktioniert trotz der aufweisbaren massiven Schäden überall lässt erahnen, wie komplex und redundant das gesamte biologische Ökosystem aufgebaut ist; in Milliarden von Jahren hat es sich in einer Weise ‚organisiert‘, die von einer großen ‚Resilienz‘ [1],[1.1], [1.2] zeugt. Doch diese ist nicht ‚unendlich‘; wenn die zerstörerischen Belastungen bestimmte Punkte — die berühmten ‚tipping points‘ — überschreiten, dann bricht das System so zusammen, dass eine Regenerierung — wenn überhaupt — möglicherweise nur über viele Millionen Jahre möglich sein wird und dann … (vgl. S.34f)

Wie dieser aktuell dramatische Prozess letztlich ausgehen wird: Glaubrecht lässt diese Frage bewusst unbeantwortet. Er plant zwar, einen ‚worst case‘ und ein mögliches ‚happy end‘ zu schildern (vgl.S36), aber welcher dieser beiden Fälle — oder womöglich noch ein dritter — letztlich eintreten wird, hängt vom Verhalten von uns Menschen in den nächsten Jahren ab. Wiederholt weist er darauf hin, dass der ‚Klimawandel‘, der heute in alle Munde ist, letztlich ja nur eine Nebenwirkung des eigentlichen Hauptproblems, der Verwüstung des Ökosystems ist. Eine Konzentration auf das Klima bei Vernachlässigung des ökologischen Problems kann daher kontraproduktiv sein.(vgl. S.36f)

Womit sich die Frage stellt, ob uns Menschen letztlich — biologisch und kulturell — die Mittel fehlen, mit dieser Problematik angemessen umzugehen? „Ist der Mensch letztlich ein vernunftloses Tier?“ (S.36)

(Paläo-)Anthropologie, Soziologie, Geschichte, Religion …

Gefühlt könnte der Prolog auf S.37 enden. Glaubrecht bringt aber noch Gedanken ins Spiel, die mit Evolutionsbiologie und Biodiversität eigentlich nichts mehr zu tun haben. Sein methodologisches wissenschaftliches Programm von S.30 wird damit deutlich gesprengt. Es folgt eine Skizze des Homo sapiens in den letzten 12.000 Jahren in denen die „überschaubaren Jäger und Sammler Horden“ (S.37) sich in Bauern verwandelten, in immer komplexere Gesellschaften leben mit all den Phänomenen, die frühe komplexe Gesellschaften so mit sich brachten (Ungleichheit, Gewalt, Unterdrückung, Krankheiten, Soziales als Stress, ..). Diese Darstellung ist durchsät mit ‚Bewertungen‘, die all dies Neue eher ’negativ‘ erscheinen lassen gegenüber der vorausgehenden ‚positiven‘ Zeit der wenigen, frei umherziehenden Horden.(vgl. S.37f)

Mit Evolutionsbiologie und Biodiversität hat dies nicht mehr viel zu tun. Glaubrecht bezieht sich an dieser Stelle direkt und ausführlich auf Schalk und Michel (EN 2016, DE 2017), die das Buch der Bibel aus anthropologischer Sicht interpretieren. Dazu führen sie eine dreifache Typologie der menschlichen ‚Natur‘ ein: (i) ‚Biologisch‘, (ii) ‚Kultur‘, (iii) ‚Vernunft‘. Abgesehen davon, dass die für die Klassifikation benutzten Begriffe in ihrem Verwendungskontext und ihrem Bedeutungsfeld mehr als vage sind, erscheint die Zuschreibung dieser Begriffe zur biologischen Lebensform des homo sapiens philosophisch und wissenschaftsphilosophisch zunächst sehr willkürlich (wenngleich diese Art der Typisierung sehr populär ist). Die in der Anthropologie (und auch den Geisteswissenschaften) sehr beliebte Gegenübersetzung von ‚Biologisch‘ und ‚Kultur‘ und dann auch noch zur ‚Vernunft‘ sitzt tief in den Köpfen der Vertreter dieser Disziplinen, aber dies sind ‚Denkprodukte‘ einer Epoche, ‚Artefakte‘ eines Denkens, das viele Jahrhunderte, ja viele Jahrtausende, nichts anderes gekannt hat. Wenn man aber im 20.Jahrhundert, und jetzt sogar im 21.Jahrhundert, lebt, darf man sich über diese denkerische Naivität schon wundern.

Fast schon extrem ist in diesem Zusammenhang die Zurichtung des Blicks auf das Phänomen der jüdisch-christlichen Religion mit der ‚Bibel‘ als Referenzpunkt. Bedenkt man, wie umfassend und reichhaltig die verschiedenen Gesellschaften und Kulturen der Menschheit in allen Erdteilen schon ab -5000 waren (man denke z.B. an Indien, China, Ägypten,) dann erscheint diese Blickverengung nicht nur extrem, sondern auch willkürlich.

Die Interpretation der Bibel, die Schaik und Michel präsentieren (und die Glaubrecht durch sein ausführliches Zitieren mindestens wohlwollend zur Kenntnis nimmt)(vgl. SS.38ff), ist zwar bei vielen immer noch populär, ist aber wissenschaftlich in keiner Weise zu rechtfertigen. Wie die verdienstvolle Arbeit der kritischen Bibelwissenschaften (ab dem 18.Jahrhundert)[2],[3] zeigt, muss man den Text des Alten Testaments als das Produkt eines Entstehungsprozesses sehen, der inhaltlich bis in die Zeit vor -900 (oder sogar weiter) zurückverweist. Er dokumentiert das vielstimmige Ringen von Menschen aus vielen verschiedenen Regionen und Zeiten, um eine Antwort auf letzten und doch auch sehr konkrete Fragen des Verhaltens im Alltag zu finden. In diesen Texten wird deutlich, dass diese Sichten keinesfalls ‚monoton‘ waren, sondern vielstimmig, teilweise geradezu konträr.[4] Und sowohl am Beispiel der jüdisch-christlichen Tradition wie auch an den Beispielen der verschiedenen anderen Religionen ist unübersehbar, dass es letztlich nicht die sogenannten ‚religiösen Inhalte‘ waren, die ganze Völker ‚befriedet‘ haben, sondern massive Machtinteressen (eng gekoppelt an finanziellen Interessen), die sich die religiösen Erzählungen für ihre Zwecke nutzbar machten um damit viele Völker äußerst blutig zu unterwerfen bzw. die Unterworfenen dogmatisch-autokratisch zu regieren. Dass sich modernes Denken, moderne Wissenschaft trotz dieser gedanklichen Unterdrückung überhaupt entwickeln konnten, ist dann fast schon ein Wunder. Die destruktive Kraft der religiösen Traditionen erlebt heute in vielen populistisch-fundamentalistischen Strömungen immer noch eine globale Wirkung, die ein modernes, dem Leben zugewandtes kritisches Denken eher verhindert und freie Gesellschaften gefährdet.[6]

Die massive Unterdrückung von anderem Fühlen und Denken, die von der jüdisch-christlichen Tradition mindestens ausging (und das war nicht die einzige Religion, die sich so verhielt) basiert im Kern auf bestimmten Überzeugungen, was ‚der Mensch‘ und was ‚Geschichte‘ ist. Während die Bibel selbst — und hier insbesondere das alte Testament — noch vielstimmig und gar konträr daherkommt, entstanden in den Zeiten nach der ‚Kanonisierung‘ [7] der verschiedenen Schriften immer mehr ‚verfestigte‘ Interpretationen, die zwar geeignet waren, Machtansprüche der herrschenden Institutionen durchzusetzen, sie verkleisterten aber das ursprüngliche Bild, machten seine menschlichen Verwurzelungen eher unsichtbar, und leisteten damit einer starren Dogmatisierung Vorschub. ‚Anderes‘ Denken war erst einmal ‚fremd‘, ‚gefährlich‘, ‚falsch‘. Dass die ‚Intelligenz der mittelalterlichen Mönche‘ es über mehrere Jahrhunderte hin schaffte, das ‚Denken der Griechischen Philosophie, vor allem das Denken des Aristoteles‘, in einen konstruktiven Dialog mit dem christlichen Dogma zu bringen, grenzt schon fast an ein Wunder. Allerdings schafften diese großartigen Denker es nicht, das christliche Lehramt in zentralen Positionen zu erneuern. Die aufkommenden neuen empirischen Wissenschaften (bis hin zur Evolutionsbiologie) wurden ebenfalls zunächst verteufelt, verfolgt, gar auf dem Scheiterhaufen verbrannt. Die christliche Begleitung der europäischen Unterwerfung der Völker anderer Kontinente ermöglichte zwar neue Einsichten und Verhaltensweisen speziell des Jesuitenordens, der sich überall auf die Seiten der ursprünglichen Bewohner schlug (Nord- und Südamerika, Asien), indem sie diese Sprachen lernten, Wörterbücher herausgaben, deren Kleidung und religiösen Praktiken teilweise übernahmen, oder sie (in Südamerika) aktiv gegen die portugiesisch-spanischen Ausbeuter zu schützen versuchten, doch wurden sie dafür von der Institution gnadenlos abgestraft: ohne Vorankündigung wurden sie über Nacht überall verfolgt, eingekerkert, gefoltert, umgebracht. Die später aufkeimende kritischen Bibelwissenschaften hatten genug Erkenntnisse, um die naiven Grundanschauungen des christlichen Dogmas zu erschüttern und als haltlos zu erweisen. Aber auch diese wurden lange unterdrückt und innerhalb der Institution dann soweit ‚abgeschwächt‘, dass notwendige Korrekturen am Gesamtbild von ‚Mensch‘, ‚Geschichte‘, ‚Institution‘ dann doch wieder unterblieben.

Wenn die Autoren Schaik und Michels — mit Billigung von Glaubrecht — diese ‚finstere Maschine‘ einer dogmatischen christlichen Religion (mit vielen ihrer späteren Ablegern) letztlich ‚glorifizierend‘ preisen als einen ‚menschheitsverbindenden Verhaltenskodex‘, den man irgendwie zurück haben möchte (S.41), dann erscheint dies vor dem Hintergrund der massiven Fakten als ‚extrem naiv‘; mit Wissenschaft hat dies nicht das Geringste zu tun.

Typisierung: Natur – Kultur – Vernunft

Ich möchte hier nochmals auf die für Schaik und Michels grundlegende Typisierung der menschlichen ‚Natur‘ als (i) ‚Biologisch‘, (ii) ‚Kulturell‘, (iii) ‚Vernunft‘ (vgl. S.39f) zurück kommen, die sich prozesshaft in einem komplexen Phänomen von „kumulativer kultureller Evolution“ (S.40) niederschlägt.

Wenn ich ein technisches System wie einen Computer nehme, dann besteht dieser aus (i) Hardware, die festlegt, welche technischen Systemzustände im Prinzip möglich sind (Hardware, die mittlerweile partiell ‚adaptiv‘ sein kann), aus (ii) Software, die aus dem Raum der möglichen Systemzustände eine charakteristische Teilmenge von Zuständen auswählt, und — für den menschlichen Benutzer bedeutsam — (iii) das beobachtbare Input-Output-Verhalten des Systems, das mit dem menschlichen Verhalten eine ‚Symbiose‘ eingeht. Ein Mensch im Jahr 2022, der ein sogenanntes ‚Smartphone‘ benutzt, der denkt während der Nutzung weder über die Hardware noch über die Software nach; er erlebt das technische System direkt und unmittelbar als ‚Teil seines eigenen Handlungsraumes‘. Letztlich ‚verschwindet‘ in der Wahrnehmung das technische System als etwas ‚Anderes‘; es gehört zum Menschen so wie sein Arm, seine Hand, seine Beine.

Die Dreifach-Typologie von Schaik und Michel (literarisch approbiert von Glaubrecht) liese sich auf die Menge der Smartphones anwenden: (i) der menschliche Körper als Manifestation des ‚Biologischen‘ entspricht der Hardware als Manifestation des Technischen. (ii) Die ‚Kultur‘ entspricht der Software, deren Regelmengen die Menge der Systemzustände festlegen. (iii) die ‚Vernunft‘ entspricht jenen typischen ‚Reaktionen‘ des technischen Systems auf die Anforderungen seitens des menschlichen Benutzers, in denen das System ‚antwortet‘, ‚erinnert‘, ‚Konsequenzen sichtbar macht‘, ‚Assoziationen herstellt‘, usw.

Wer jetzt einwenden möchte, dass diese ‚Auslegung der Begriffe‘ in diesem Beispiel doch etwas ‚willkürlich‘ sei, der sollte sich fragen, wie denn Schaik und Michel die Verwendung ihrer Begriffe rechtfertigen. Ihre Verwendung der Begriffe ist absolut beliebig.

Im Smartphone-Beispiel wird allerdings klar, dass die unterschiedlichen ‚Erscheinungsweisen‘ dieses technischen Systems (Hardware, Software, Input-Output-Verhalten) zwar sprachlich unterschiedlich gehandhabt werden können, dass aber jede ‚Ontologisierung‘ dieser drei Erscheinungsweisen in Richtung eigenständiger ‚Naturen‘ die tatsächliche Funktionalität des Systems stark verzerren würde. Jeder Informatiker weiß, dass das beobachtbare Input-Output-Verhalten des Smartphones (so ‚klug‘ es auch erscheinen mag), letztlich nur eine spezielle Abbildung der inneren Systemzustände ist, die von der aktiven Software aus der Menge der möglichen technischen Systemzustände ausgewählt wird. Das eine kann man nicht ohne das andere verstehen. Das technische System bildet als solches ein einziges ‚funktionales Ganzes‘. Und in dem Maße wie Computersysteme über ‚Sensoren‘ verfügen (das Smartphone hat sehr viele), die ‚Signale der Außenwelt‘ messen können, und/ oder auch über ‚Aktoren‘ (hat ein Smartphone auch), auf die Außenwelt physikalisch einwirken kann, dann kann ein Smartphone ‚Zustände der Außenwelt‘ in seine ‚internen Systemzustände‘ ‚abbilden‘, und es kann — falls die Software so ausgelegt wurde — auch Eigenschaften der Außenwelt (und auch über sich selbst) ‚lernen‘. Nicht rein zufällig sprechen ja heute fast alle vom ‚Smart‘-Phone, also von einem ‚klugen‘ Phone, von einem klugen technischen System. Selbstfahrende Autos und ‚autonome Roboter‘ gehören auch in diese Rubrik der ‚klugen‘, ‚vernünftigen‘ Maschine.

Wenn jetzt wieder jemand (vorzugsweise Anthropologen und Geisteswissenschaftler) einwenden würden, dass man diese Begriffe ‚klug‘ und ‚vernünftig‘ hier nicht anwenden darf, da sie ‚unpassend‘ seien, dann kann man gerne zurückfragen, wie Sie denn diese Begriffe definieren? Die Verwendungen dieser Begriffe in der Literatur ist dermaßen vielfältig und vage, dass es schwer fallen dürfte, eine ’scharfe‘ Definition zu geben, die eine gewisse Mehrheit findet. Nichts anderes machen die Informatiker. Weitgehend ohne Kenntnis der philosophischen Literatur benutzen sie diese Begriffe in ihrem Kontext. Sie haben allerdings den Vorteil, dass ihre technischen Systeme schärfere Definitionen zulassen. Von einer ‚klugen‘ Maschine in einem Atemzug mit einem ‚klugen‘ Menschen zu sprechen, erhöht zwar den kulturellen Verwirrtheitsgrad, bislang scheint dies aber niemanden ernsthaft zu stören.

Um es klar zu sagen: das von mir konstruierte Beispiel ist genau das, ein Beispiel; es ersetzt keine umfassende ‚Theorie‘ über den Menschen als Moment der biologischen Evolution auf diesem blauen Planeten. Von einer solchen Theorie sind wir aktuell auch noch — so scheint es — gefühlte Lichtjahre entfernt. Auf jeden Fall dann, wenn Biologen und Anthropologen kein Problem damit zu haben scheinen, solch ein finsteres Phänomen wie die jüdisch-christliche Religion in ihrer historischen Manifestation (sind andere besser?) als positives Beispiel einer Bewältigung des Lebens auf diesem Planeten zu qualifizieren. Vielleicht wäre es hilfreich, wenn Biologen und Anthropologen sich mehr damit beschäftigen würden, wie denn alle diese — scheinbar widersprüchlichen Phänomene ‚biologische Systeme‘, ‚Kultur‘ und ‚Vernunft‘ tatsächlich zusammenhängen. Die — geradezu naive — Verherrlichung der frühen Phase des ‚vorgesellschaftlichen‘ homo sapiens und die — ebenso naiven — Kassandra-Rufen-ähnliche Klassifizierungen von zunehmend komplexen Gesellschaftsbildungen zerstört das Phänomen, was es wissenschaftlich zu erklären gilt, bevor man es überhaupt richtig zur Kenntnis genommen hat. Hier bleibt erheblich ‚Luft nach oben‘.[8]

KOMMENTARE

wkp := Wikipedia, [de, en, …]

[1] Resilienz: Dieser Begriff wird von verschiedenen Disziplinen in Anspruch genommen. Nach meinen Recherchen taucht er als erstes in der Ökologie auf [1.1], wo er sich als wichtiger theoretischer Begriff etabliert hat.[1.2]

[1.1] C.S. Holling. Resilience and stability of ecological systems. Annual Review of Ecology and Systematics, 4(1):1–23, 1973. Online: https://www.jstor.org/stable/2096802

[1.2] Brand, F. S., and K. Jax. 2007. Focusing the meaning(s) of resilience: resilience as a descriptive concept and a boundary object. Ecology and Society 12(1): 23. [online] URL: http://www.ecologyandsociety.org/vol12/iss1/art23/

[1.3] Peter Jakubowski. Resilienz – eine zusätzliche denkfigur für gute stadtentwicklung. Informationen zur Raumentwicklung, 4:371–378, 2013.

[2] Biblische Exegese in wkp-de: https://de.wikipedia.org/wiki/Biblische_Exegese

[3] Historisch-kritische Methode in wkp-de: https://de.wikipedia.org/wiki/Historisch-kritische_Methode_(Theologie)

[4] Ein sehr prominentes Beispiel sind die beiden verschiedenen Versionen der sogenannten ‚Schöpfungsgeschichten‘ zu Beginn des heutigen biblischen Textes, die aus ganz verschiedenen Zeiten stammen, eine ganz verschiedene Sprache benutzen (im hebräischen Text direkt sichtbar), und die ganz unterschiedliche Bilder von Gott, Mensch und Schöpfung propagieren.

[5] Carel van Schaik und Kai Michel, „Das Tagebuch der Menschheit: Was die Bibel über unsere Evolution verrät“, Rowohlt Taschenbuch; 8. Edition (17. November 2017)(Original: The Good Book of Human Nature. An Evolutionary Reading of the Bible, 2016)

[6] Sehr aufschlussreich ist der Umgang der christlichen Tradition mit der sogenannten ‚Spiritualität‘ und ‚Mystik‘: nahezu alle großen geistlichen Lebensgemeinschaften (oft ‚Orden‘ genannt) durften nur existieren, wenn sie sich vollständig der Kontrolle der Institution unterwarfen. Falls nicht, wurden sie verfolgt oder getötet. ‚Subjektivität‘, ‚individuelle Erfahrung‘, nichtautoritäre Praxis, andere Gesellschaftsformen, wurden kompromisslos unterdrückt, ebenso jede Art von abweichender Weltsicht (man denke z.B. nur an Galilei und Co.).

[7] Die ‚Kanonisierung‘ der Bibel meint den historischen Prozess, in dem festgelegt wurde, welche Schriften zum Alten und Neuen Testament gezählt werden sollten und welche nicht. Wie man sich vorstellen kann, war dieser Prozess in keiner Weise ‚trivial‘.(Siehe auch: wkp-de, https://de.wikipedia.org/wiki/Kanon_(Bibel))

[8] Eine sehr interessante alternative Sicht im Bereich (Kultur-)Antropologie und Soziologie zum Verständnis des Phänomens Mensch bietet das interessante Buch von Pierre Lévy “Collective Intelligence. mankind’s emerging world in cyberspace” (translated by Robert Bonono),1997 (French: 1994), Perseus Books, 11 Cambridge Center Cambridge, MA, United States. Allerdings scheint auch dieses Buch — trotz seiner neuen Akzente — noch eher im ‚alten Denken‘ verhaftet zu sein als in einem ’neuen Denken‘.

[8.1] Eine Folge von Kommentaren zu Pierre Lévy’s Buch findet sich hier: Gerd Doeben-Henisch, 2022, „Pierre Lévy : Collective Intelligence – Chapter 1 – Introduction“, https://www.uffmm.org/2022/03/17/pierre-levy-collective-intelligence-preview/ (mit Fortsetzungs-Links)

Ein Überblick über alle Beiträge des Autors nach Titeln findet sich HIER.