Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 26.Nov. 2017

URL: cognitiveagent.org

info@cognitiveagent.org

Autor: cagent

Email: cagent@cognitiveagent.org

INHALT

I Wissenschaftsphilosophie und Wahrheit …1

II Interdisziplinär und Unterschiede …2

III Interdisziplinäres Projekt…2

III-A Einzelvorschläge zum Begriff ’Simulation’ . . . . . . . .3

III-B Vernetzung der Einzelvorschläge . ….3

III-C Formalisierungsversuch . . . . . . . . 4

Weiter zur Wahrheit …7

IV Literaturverweise …8

WORUM ES GEHT

‚Wissenschaftsphilosophie‘ klingt für die meisten sehr abstrakt. Wendet man sich aber dem Alltag zu und betrachtet ein – fast beliebiges – Beispiel, dann kann man

schnell entdecken, dass eine wissenschaftsphilosophische

Sehweise sehr konkret – und auch sehr praktisch – werden

kann. Dies wird in diesem Beitrag illustriert.

I. WISSENSCHAFTSPHILOSOPHIE UND WAHRHEIT

In einem vorausgehenden Beitrag in diesem Blog mit

der Überschrift ”WAHRHEIT ALS UNABDINGBARER

ROHSTOFF EINER KULTUR DER ZUKUNFT” wurde

besprochen, welche Mechanismen uns Menschen

zur Verfügung stehen, um wahre Aussagen über

die Welt und uns selbst machen zu können. Die

Blickweise, die hinter diesen Überlegungen stand,

war die der Wissenschaftsphilosophie. Aber was ist

’Wissenschaftsphilosophie’? Warum ist diese Blickweise

so wichtig?

’Wissenschaftsphilosophie’ ist, wie der Name schon

andeutet, ein Teil der philosophischen Blickweise auf die

Welt.

Während sich die Einzelwissenschaften aufgrund ihrer

spezifischen Interessen auf ’Teilgebiete der erfahrbaren

Wirklichkeit’ festlegen und diese im Rahmen des Paradigmas der experimentellen Wissenschaften im Detail erforschen, versteht sich eine philosophische

Blickweise als jene, die nicht von vornherein

Ausgrenzungen vornimmt, sondern alle Phänomene

zulässt, die sich dem menschlichen Bewusstsein zur

Erfahrung geben. Ein philosophisches Denken legt sich

auch nicht auf einige wenige Methoden fest, sondern

erlaubt zunächst einmal alles, was geht.

Eine so verstandene philosophische Blickweise hat

Vor- und Nachteile. Die Nachteile liegen auf der Hand:

der Verzicht auf eine wie auch immer geartete Vorweg-

Zensur von Erfahrung konfrontiert einen Philosophen

von vornherein mit einer solchen Fülle von Phänomen

und Methoden, dass es im Allgemeinen schwer ist,

hier auf einfache und schnelle Weise zu strukturierten

Erkenntnissen zu kommen.

Andererseits, schaut man sich die fortschreitende

Zersplitterung der Einzelwissenschaften an, dann

trifft man auch hier auf eine methodisch bedingte

Vielfalt, die bislang nicht systematisch integriert ist.

Zum aktuellen Zeitpunkt ist es nicht einmal abzusehen,

wann und wie diese immensen, sich gegenseitig

ausschließenden Datengebirge und Teildeutungen, sich

irgendwann zu einem einzigen großen integrierten

Ganzen zusammenfügen lassen lassen.

Die philosophische Blickweise als solche trägt im

Prinzip den Keim der Integration in sich, da sie ja

nicht auf Teilaspekte der Wirklichkeit abonniert ist,

sondern im Prinzip für alles offen ist. So kann sie sich

die Ergebnisse der Einzelwissenschaften vornehmen

und versuchsweise, spielerisch die verschiedenen

Erkenntnisse z.B. zum subjektiven Bewusstsein, zum

objektiven Verhalten oder zum objektiven Körper

aufgreifen, miteinander in Beziehung setzen, und

versuchen, die darin verborgenen Zusammenhänge

sichtbar zu machen.

Philosophen können dies irgendwie machen, oder

sie können sich im Jahr 2017 die denkerischen

Vorarbeiten der Wissenschaftsphilosophen aus den

letzten ca. 150 Jahren zu Nutze machen. Diese haben nämlich spezielle Teilaspekte der Wirklichkeit, des Denkens, der Wissenschaften systematisch untersucht.

Dazu gehören Themen wie Messen, Modellbildung,

logische Argumentation, Überprüfung eines Modells,

Simulation, und vieles mehr. Im Endeffekt haben die

Wissenschaftsphilosophen untersucht, wie das Konzept

einer experimentellen Wissenschaften überhaupt

funktioniert, unter welchen Umständen experimentelle

Theorien wahr sind, und unter welchen Bedingungen

man verschiedene Theorien integrieren kann.

Da das Thema Wissenschaftsphilosophie für sich

sehr umfassend ist und in vielen Bereichen nicht gerade

einfach zu erklären ist, sei an dieser Stelle auf eine solche

umfassende Darstellung verzichtet (Vergleiche dazu z.B.: [Sup79], [Sne79],

[Bal82], [BMS87]). Stattdessen sei hier ein einfaches (reales) Beispiel aus dem (realen) Alltag

vorgestellt, wie es jeder erleben kann oder schon erlebt

hat.

II. INTERDISZIPLINÄR UND UNTERSCHIEDE

Das Wort Interdisziplinär ist heute ja ein

richtiges Modewort, um das Zusammenarbeiten

von unterschiedlichen Disziplinen, Experten mit

unterschiedlichem Knowhow, unterschiedlichen

Erfahrungen zu etikettieren.

Während wir in den verschiedenen Gesellschaften

in Europa und weltweit zunehmend eher wieder

Phänomene der Abgrenzung beobachten, der

Ausgrenzung, der Abschottung, der identitätserhaltenden

Gruppenbildung, haben wir immer mehr international

operierende Firmen, in denen die Zusammenarbeit

von Menschen aus vielen Nationen (bis über 100)

Alltag ist und funktioniert. Es spielt nicht wirklich eine

Rolle, aus welchem Land jemand kommt, welche

Religion er hat, wie sie sich kleidet, was jemand isst,

solange alle im Rahmen der gestellten Aufgabe friedlich

zusammenwirken können. Auch in den Wissenschaften

ist dies eigentlich Alltag. Mathematik ist für alle gleich und

die Welt, die es zu erforschen gilt, ist auch für alle gleich.

Ähnlich ist es in den großen internationalen Metropolen

dieser Welt. Dort leben ganz viele verschiedene Kulturen

so lange friedlich zusammen, so lange niemand anfängt,

bewusst Hass und Zwietracht zu streuen.

Andererseits scheint das Phänomen der Abgrenzung

ein tief sitzender Reflex im menschlichen Verhalten

zu sein. Denn überall, wo Menschen leben und

es in der jeweiligen Gemeinschaft unterschiedliche

Gruppen – alleine schon wegen der notwendigen und

fortschreitenden Spezialisierungen – gibt, tendiert jede

Gruppe dazu, sich von den anderen abzugrenzen.

Es ist letztlich eine kognitive Entlastungsstrategie: es

ist immer einfacher, sich nur dem den Eigenschaften

und Regeln der eigenen Gruppe zu beschäftigen, als

zusätzlich auch noch mit den Eigenheiten und Regeln

einer anderen Gruppe. Dies strengt an und belastet.

Zu diesem Zweck gibt es allgemeine Verhaltensregeln,

die einem im Alltag Entscheidungen abnehmen, und

es gibt Klischees, Stereotype, mit denen man andere

Gruppen – und damit auch die einzelnen Mitglieder

der anderen Gruppen – mit einem einzigen Wort

in eine große Kiste von Klischees einsortiert. Dies

fängt schon im Bereich der Familie an, und erstreckt

sich dann über Schulklassen, Schulen, Abteilungen

in Behörden und Betrieben zu ganzen Einrichtungen,

Stadtteilen, Volksgruppen. Im ’Normalbetrieb’ verläuft

dies friedlich, ohne direkte Auseinandersetzungen, ist

fester Bestandteil von Witzen, Volksbelustigungen und

vielen Fernsehsendungen und Filmen.

Im Konfliktfall sind diese Vorurteile aber wie trockenes

Holz, das sich blitzschnell entzünden kann, und mit

einem Mal sind die Nachbarn, die Arbeitskolleginnen,

und die Leute aus dem anderen Stadtteil nicht einfach

nur anders, sondern gefährlich anders, moralisch anders,

überhaupt anders. Aus unverfänglichen Unterschieden

werden plötzlich metaphysische Ungeheuer. Die

gedankliche Bequemlichkeit, die sich im Alltag im

Gebrauch von Klischees ausruht, wird zur gedanklichen

Hilflosigkeit, die im Stress einfach wild um sich schlägt,

und dann natürlich auf das haut, was sie in ihrer

vereinfachten Weltsicht kennt: auf die stereotypen

Unterschiede, die plötzlich die ganze Welt bedeuten.

III. INTERDISZIPLINÄRES PROJEKT

Während interdisziplinäres Zusammenarbeiten in

großen Firmen und Behörden von Metropolen Alltag ist,

tun sich die Bildungseinrichtungen, speziell Hochschulen

in Deutschland, damit noch schwer. Selbst an einer

Hochschule in einer internationalen Metropole, an der

junge Menschen aus mehr als 100 Nationen studieren,

gibt es nur einen verschwindend geringen Anteil von

wirklich interdisziplinären Studienprogrammen. Die

Lehrenden mögen solche Veranstaltungen nicht, da

der normal Lehrende ein Spezialist ist; auch die

Fachbereichsstrukturen an Hochschulen stehen einer

wirklichen Interdisziplinarität massiv im Wege, und die

Hochschulleitungen sind heute von der Realität der

Lehre in ihren eigenen Hochschulen meist so weit

entfernt, dass sie in der Regel gar nicht wirklich wissen,

wie der Alltag der Lehre aussieht.

Das folgende Beispiel stammt aus einer realen

Lehrveranstaltung von einer realen Hochschule mit

Studierenden aus mehr als 100 Nationen, an der es

offiziell genau zwei interdisziplinäre Studienprogramme

gibt. Im Rahmen des einen Programms gibt es ein Modul,

in dem sich Studierende aus verschiedenen Disziplinen

mit dem Begriff der Simulation auseinander setzen sollen.

So gibt es in diesem Modul z.B. Studierende

aus den Disziplinen soziale Arbeit, Pflege, Case

Management, Architektur, Maschinenbau, Elektrotechnik

und Informatik.

A. Einzelvorschläge zum Begriff ’Simulation’

Das Modul ist so angelegt, dass alle Beteiligten

im Rahmen von Kommunikationsprozessen, eigenen

Recherchen und eigenen Experimenten schrittweise

ihr bisheriges Verständnis des Begriffs ’Simulation’

verfeinern und mit den Vorstellungen der jeweils

anderen Disziplinen integrieren, falls möglich. Im

Folgenden Beispiele von Formulierungen, wie der Begriff

Simulation’ zu Beginn von den Teilnehmern umschrieben

wurde.

- Team A: Unter Simulation versteht man ein realitätsnahes Nachbilden von Situationen.

- Ein virtueller Raum wird mit Hilfe von Visualisierungsprogrammen realistisch dargestellt .

- Nach einer Abbildung mit verschiedenen Programmen kann das Modell mit Hilfe von Grundrissen geschaffen werden.

- Verschiedene Gebäudetypen, zum Beispiel:

öffentliche, kulturelle oder soziale Einrichtungen,

können simuliert werden. - Der Außenraum bzw. die Umgebung wird beim

Entwurf mitberücksichtigt und 3D visualisiert. - Durch Materialität, Textur, Lichtverhältnissen

und Schattierungen wird versucht, den Entwurf

realitätsnah wie möglich darzustellen. - Konstruktionen können in Simulationsprogrammen ebenfalls detailliert ausgeführt werden.

- Team B: Simulation ist eine Methode Situationen abzubilden, z.B. räumliche Wirkungen, Umwelteinflüsse, Szenarien, um effektiv Probleme und

Lösungen zu analysieren. - Team C: Die Analyse von möglichen Problemen

im Alltag. Die Nachbildung von Anwendungsfällen

wie zum Beispiel Flugsimulation und Wettersimulation. Die Optimierung von Systemen und Prozessen.

Komplexe Sachverhalten zu vereinfachen und (visuell) darzustellen. Es ist eine kostengünstigere Variante als die tatsächliche Umsetzung. Es werden in

einer Simulation Prognosen und Voraussagen erstellt. - Team D:

- Analyse von Systemen vor der praktischen An-

wendung - Die Simulation ist ein Bestandteil eines Produktlebenszyklus. Dabei lassen sich die Entwicklungsschritte wie folgt definieren:

- Konzeptentwicklung

- Simulation

- Konstruktiond) Produktherstellung

- Integration im System

- Optimierung von einem bestehendem Prozess

mit Ziel die Effizienz und die Fehlerbehebung

zu verbessern −→ Prozessoptimierung

- Analyse von Systemen vor der praktischen An-

- Team E: Unter dem Begriff ”Simulation” ist das

theoretische bzw. praktische Durchspielen unterschiedlicher Szenarien zu verstehen. Das Durchspielen oder auch Verifizieren der Situation lässt

die Übertragung von komplexen Aussagen über das

mögliche Verhalten des gewählten Klientels zu. Das

Ergebnis kann auf die Realität projiziert werden,

ohne damit laufende Prozesse negativ zu beeinflussen. - Team F : Eine Simulation ist eine modellhafte

Darstellung einer möglichen oder reellen Situation.

Die Situation kann sowohl prospektiv als auch retrospektiv sein. Sie dient der Analyse, Übung und Optimierung verschiedener Prozesse beziehungsweise

einzelner Prozessabläufe. - Team G: Simulationen in der sozialen Arbeit bieten die Möglichkeit insbesondere ethisch schwierig

vertretbare oder praktisch schwierig umsetzbare Situationen experimentell darzustellen und dadurch

präventiv Kompetenzen zu erwerben, Lerninhalte

zu erarbeiten, Lösungsansätze zu entwickeln und

Problem- bzw. Konfliktsituationen zu vermeiden. - Team H: Simulation im Beratungskontext meint das

Herstellen realitätsnaher Szenarien, um das Verhalten von Personen in speziellen Situationen erproben,

beobachten und evaluieren zu können.

B. Vernetzung der Einzelvorschläge

Diese Textfragmente wirken unterschiedlich und tragen

deutlich Spuren der unterschiedlichen Fachkulturen. So

ist das Team A unschwer als Team aus dem Bereich

Architektur zu erkennen, oder Team C: das klingt sehr

nach einem technischen Hintergrund. Team E klingt

nach sozialer Arbeit oder Case Management. usw.

Was macht man nun damit?

Es gab ein Live-Gespräch, bei dem die einzelnen

Formulierungen nacheinander diskutiert wurden

und einzelne Begriffe, die hervor stachen, wurden

versuchsweise auf ein Whiteboard geschrieben (siehe

Schaubild Nr. 1).

Für einen Unbeteiligten wirkt dieses Bild vermutlich

noch ein wenig ’wirr’, aber bei näherem Hinsehen kann

man die Umrisse einer ersten Struktur erkennen.

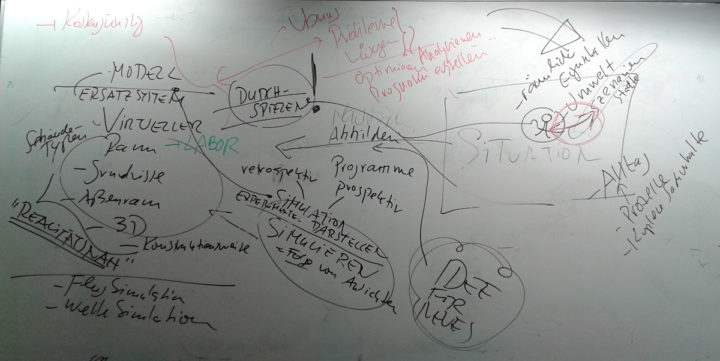

In einer im Anschluss erstellten Idealisierung des

ersten Tafelbild (siehe Schaubild Nr. 2) kann man die

in diesen Begriffen liegende verborgene Struktur schon

deutlicher erkennen.

Man erkennt abgrenzbare Bereiche, Komponenten

wie z.B. die reale Welt oder das Ersatzsystem, Modell,

oder auch so etwas wie die Idee von etwas Neuem.

Zwischen diesen Komponenten findet man Beziehungen

wie Nachbilden oder Erfinden oder Modell nutzen.

Offensichtlich passen diese Größen nicht in das

klassische Schema einer Definition, bei dem ein neuer

Begriff (das ’Definiendum’) durch schon bekannte

Begriffe (das ’Definiens’) ’erklärt’ wird (vgl. dazu [Mit95] und [San10]), sondern es ist

eher die Einführung eines neuen Bedeutungsfeldes im

Sinne einer axiomatischen Theorie: man benennt eine

Reihe von Komponenten, von denen man annimmt, dass

sie alle wichtig sind, beschreibt Beziehungen zwischen

diesen Komponenten, die man ebenfalls für wichtig

findet, und nennt dann das Ganze ’Simulation’. Eine

zunächst diffuse Wirklichkeit gewinnt dadurch Konturen,

gewinnt eine Struktur.

Ob diese sich so heraus schälende Struktur wirklich

brauchbar ist, irgendwelche Wahrheitsansprüche

einlösen lässt, das kann man zu diesem Zeitpunkt

noch nicht entscheiden. Dazu ist das Ganze noch

zu vage. Andererseits gibt es an dieser Stelle auch

keine festen Regeln, wie man solche Strukturen

herausarbeitet. Auf der einen Seite sammelt man

Phänomene ein, auf der anderen Seite sucht man

Begriffe, sprachliche Ausdrücke, die passen könnten.

Was einem auffällt, und wie man es dann anordnet,

hängt offensichtlich von aktuellen Interessen, verfügbarer

Erfahrung und verfügbarem Sprachwissen ab. Drei

verschiedene Personen kämen isoliert vermutlich zu drei

unterschiedlichen Ergebnissen.

Man kann jetzt bei dem Schaubild stehen

bleiben, oder man kann das Instrumentarium der

Wissenschaftsphilosophie weiter nutzen indem man

z.B. eine formale Strukturbildung versucht. Unter

Verwendung einer mengentheoretischen Sprache

kann man versuchen, die erkannten Komponenten

und Beziehungen in mathematische Strukturen

umzuschreiben. Falls es gelingt, führt dies zu noch

mehr struktureller Klarheit, ohne dass man irgendwelche

Feinheiten opfern müsste. Man kann im Verlauf eines

solchen Formalisierungsprozesses Details nach Bedarf

beliebig ergänzen.

C. Formalisierungsversuch

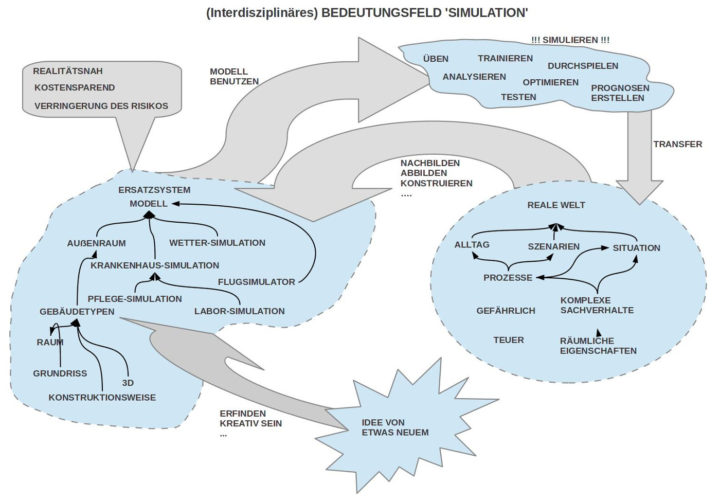

Das idealisierte Schaubild lässt erkennen, dass wir

es mit drei Wirklichkeitsbereichen zu tun haben: (i)

die Reale Welt (W) als Ausgangspunkt; (ii) die Welt

der kreativen Ideen (KID) als Quelle möglicher neuer

Gegenstände oder Verhaltensweisen; und verschiedene

Ersatzsysteme, Modelle (M), mittels deren man etwas tun kann.

Unter Voraussetzung dieser genannten Gegenstandsbereiche W, KID, M wurde folgende wichtige Beziehungen genannt, die zwischen diesen

Gegenstandsbereichen angenommen wurden:

- Nachbilden, Abbilden (Abb): Bestimmte Aspekte

der realen Welt W werden in einem Ersatzsystem,

in einem Modell M so nachgebildet, dass man

damit etwas tun kann. Außerdem soll das Modell

u.a. realitätsnah sein, Kosten sparen, und Risiken

vermindern. - Erfinden (Erf): Aufgrund von kreativen Ideen KID

wird ein Modell M erstellt, um diese Ideen sichtbar

zu machen. - Simulieren (Sim): Hat man ein Modell M gebaut,

dann können Menschen (ME) mit dem Modell

unterschiedliche Simulationen für unterschiedliche

Zwecke vornehmen. Aufgrund von Simulationen

werden die Menschen Erfahrungen (X+) mit dem

Modell sammeln, die zu einem verbesserten Verhalten (V+) auch in der realen Welt führen können, zugleich kann aufgrund dieser Erfahrungen das

bisherige Modell oft auch optimiert werden; man

kommt also zu einem optimierten Modell (M+). - Transfer (Trans): Aufgrund von neuen Erfahrungen

(X+) und einem möglicherweise optimierten Modell

(M+) besteht die Möglichkeit, dass man im Ausgangspunkt, in der realen Welt (W), Sachverhalte und Abläufe ändert, um die Verbesserungen im

Modell und im neuen Verhalten in die reale Welt,

in den Alltag, einzubringen. Würde man dies tun,

dann erhielte man eine verbesserte Welt (W+).

Diese Vorstrukturierung kann man nun weiter treiben und tatsächlich eine mathematische Struktur hinschreiben. Diese könnte folgendermaßen aussehen:

— Siehe hierzu das PDF-Dokument —

Der Ausdruck zu Nummer (1) besagt, dass etwas (x) genau nur dann (iff) eine Simulation (SIMU) genannt wird, wenn es die folgenden Komponenten enthält: W, W+ M, M+ , KID, X+ , ME. Zusätzlich werden folgenden Beziehungen zwischen diesen Komponenten angenommen: Abb, Erf, Sim, Trans. Welcher Art diese Beziehungen sind, wird in den folgenden Nummern (2) – (5) erläutert.

In der Abbildungsbeziehung Abb : ME × W−→ M werden Aspekte der realen Welt W von Menschen ME in ein idealisierendes Modell M abgebildet.

In der Erfindungsbeziehung Erf : ME × KID −→ M werden Aspekte aus der Welt der Ideen KID von Menschen ME in ein idealisierendes Modell M abgebildet.

In der Simulationsbeziehung Sim : ME × M −→ M+ × X+ benutzen Menschen ME Modelle M und machen dadurch neue Erfahrungen X+ und können u.a. das Modell verbessern, optimieren M+ .

In der Transferbeziehung rans : ME × M+ × X+ −→ W+ können Menschen ME optimierte Modelle M+ und/ oder neue Erfahrungen X+ in ihren Alltag, in die reale Welt so einbringen, dass die bisherige Welt zu einer besseren Welt M+ verändert wird.

IV. WEITER ZUR WAHRHEIT

An diesem kleinen Beispiel wird deutlich, wie man

unterschiedliche alltagssprachliche Formulierungen

miteinander vernetzen kann, daraus Strukturen

herausarbeitet, und diese ansatzweise formalisiert.

Um einen möglichen Wahrheitsanspruch dieser

Formalisierung klären zu können, müsste nun weiter

herausgearbeitet werden, was mit den einzelnen

Größen dieser Struktur gemeint ist. Also, wenn man die

Beziehung Abbildung liest ( Abb : ME × W −→ M), müsste klar sein, welche Menschen gemeint sind, die dort eine Abbildungsbeziehung herstellen, und was

müsste man sich konkret darunter vorstellen, dass

Menschen Aspekte der Welt (W) in ein Modell (M)

abbilden?

Wenn ein Kind ein Stück Holz benutzt, als ob es

ein Spielzeugauto ist, mit dem es auf dem Boden

herumfährt und dazu ’BrumBrum’ macht, dann ist für

das Kind das Stück Holz offensichtlich ein Modell für ein

Autor aus der realen Welt, seine Bewegungen simulieren

das Herumfahren, und das ’BrumBrum’ simuliert das

Motorgeräusch (bald nicht mehr, vielleicht).

Wenn Architekten (früher) aus Gips ein Gebäude im

Maßstab angefertigt hatten, es in eine Modelllandschaft

stellten, und dies einer Lichtquelle aussetzten, die

analog der Sonne bewegt wurde, dann war offensichtlich

das Gipshaus in der Landschaft mit der Lichtquelle

ein Modell des Schattenwurfs eines Gebäudes bei

Sonnenlicht.

Wenn Pflegestudierende heute an einem Krankenbett

mit einer künstlichen Puppe üben, wie man verschiedene

Pflegetätigkeiten ausübt, dann ist diese Puppe im Bett

offensichtlich ein Modell des realen Patienten, an dem

man übt.

Wenn Case Managerinnen in Rollenspielen

Beratungsgespräche üben, dann sind diese Rollen,

die sie ausfüllenden Personen, und die stattfindenden

Interaktionen ein Modell der realen Situation.

Wenn Informatikstudierende am Computerbildschirm

Schaltungen zusammenbauen, dann sind diese Software

basierten Bauteile und Schaltungen offensichtlich

Modelle von richtigen Bauteilen und den daraus

konstruierten Schaltungen.

Die Liste der hier möglichen Beispiele ist potentiell

unendlich lang.

Die Abbildung von Aspekten der realen Welt in

Ersatzsysteme, die wie Modelle fungieren, anhand bzw.

mittels deren man üben kann, analysieren usw. ist

offensichtlich sehr grundlegend.

Ob solch ein modellierendes Ersatzsystem und

die damit möglichen Handlungen die abzubildende

Wirklichkeit hinreichend gut abbilden, oder ob sie diese

so verzerren, dass das Modell bezogen auf die reale

Welt falsch ist, dies zu beurteilen ist nicht immer ganz

einfach oder vielleicht sogar unmöglich. Schwierig und

unmöglich ist dies dann, wenn das erarbeitete Modell

etwas zeigt, was in der realen Welt selbst durch die

Verwobenheit mit anderen Faktoren gar nicht sichtbar

ist, wenn also dass Modell überhaupt erst etwas sichtbar

macht, was ansonsten verdeckt, verborgen ist. Damit

würde das Modell selbst zu einer Art Standard, an dem

man die reale Welt misst.

Was im ersten Moment absurd klingt, ist aber genau

die Praxis der Wissenschaften. Das Ur-Meter, das als

Standard für eine Längeneinheit vereinbart wurde, ist

ein Modell für eine bestimmte Länge, die überall in

der räumlichen Welt angetroffen werden kann, aber

ohne das Ur-Meter können wir nicht sagen, welche der

unendlich vielen Stellen nun einem Meter entspricht. Wir

benutzen also ein künstlich erschaffenes Modell einer

bestimmten Länge, um damit die ansonsten amorphe

reale Welt mit Plaketten zu überziehen. Wir projizieren

das Ur-Meter in die reale Welt und sehen dann überall

Längen, die die realer Welt als solche nicht zeigt. Zu

sagen, diese Strecke hier in der realen Welt ist 1 m lang,

ist eine Äußerung, von der wir normalerweise sagen

würden, sie ist wahr. Wahrheit ist hier eine Beziehung

zwischen einer vereinbarten Einheit und einem Aspekt

der realen Welt.

Im allgemeinen Fall haben wir irgendwelche

sprachlichen Ausdrücke (z.B. Abb : ME × W −→ M), wir ordnen diesen sprachlichen Ausdrücke davon unabhängige Bedeutungen zu, und stellen dann fest,

ob es in der realen Welt Sachverhalte gibt, die mit

dieser vereinbarten Bedeutung korrespondieren oder

nicht. Falls Korrespondenz feststellbar ist, sprechen

wir von Wahrheit, sonst nicht. Eine solche Wahrheit ist

aber keine absolute Wahrheit, sondern eine abgeleitete

Wahrheit, die nur festgestellt werden kann, weil zuvor

eine Bedeutung vereinbart wurde, deren Korrespondenz

man dann feststellt (oder nicht). Sprachlich gefasste

Wahrheiten können also immer nur etwas feststellen,

was zuvor vereinbart worden ist (wie beim Ur-Meter), und

man dann sagt, ja, das früher vereinbarte X liegt jetzt

hier auch vor. Und diese grundsätzliche Feststellung,

diese ist fundamental. Sie erlaubt, in den veränderlichen

vielfältigen Bildern der Welt, ansatzweise Ähnlichkeiten,

Wiederholungen und Unterschiede feststellen zu

können, ohne dass damit immer schon irgendwelche

letzten absoluten Sachverhalte dingfest gemacht werden.

Die moderne Wissenschaft hat uns demonstriert, wie

dieses einfachen Mittel in vielen kleinen Schritten über

Jahrzehnte hinweg dann doch zu sehr allgemeingültigen

Sachverhalten hinführen können.

LITERATURHINWEISE

[Bal82] W. Balzer, editor. Empirische Theorien: Modelle, Strukturen,

Beispiele. Friedr.Vieweg & Sohn, Wiesbaden, 1 edition, 1982.

[BMS87] W. Balzer, C. U. Moulines, and J. D. Sneed. An Architectonic

for Science. D.Reidel Publishing Company, Dordrecht (NL),

1 edition, 1987.

[Mit95] Jürgen Mittelstrass, editor. Enzyklopädie Philosophie und

Wissenschaftstheorie Teil: Bd. 1., A – G. Verlag J.B. Metzler,

Stuttgart – Weimar, 1 edition, 1995.

[San10] Hans Jörg Sandkühler, editor. Enzyklopädie Philosophie,

Bd.1-3. Meiner Verlag, Hamburg, 1 edition, 2010.

[Sne79] J. D. Sneed. The Logical Structure of Mathematical Physics.

D.Reidel Publishing Company, Dordrecht – Boston – London,

2 edition, 1979.

[Sup79] F. Suppe, editor. The Structure of Scientific Theories. Uni-

versity of Illinois Press, Urbana, 2 edition, 1979.

KONTEXT BLOG

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER