Dieser Text ist Teil des Textes „Neustart der Menschlichkeit (Rebooting humanity)“

(Die Englische Version findet sich HIER)

Autor Nr. 1 (Gerd Doeben-Henisch)

Kontakt: cagent@cognitiveagent.org

(Start: 5.Juni 2024, Letzte Änderung: 7.Juni 2024)

Ausgangspunkt

Es soll also ein ‚Text‘ geschrieben werden, der über die Welt spricht, einschließlich aller Lebewesen, und die Autoren sind im ersten Anlauf ‚Menschen‘. Bisher kennen wir keine Fälle, in denen Tiere oder Pflanzen selbst Texte schreiben: ihre Sicht des Lebens. Wir kennen nur Menschen die aus ‚ihrer menschlichen Sicht‘ über das Leben, über Tiere und Pflanzen schreiben. An dieser Vorgehensweise kann man viel kritisieren. Bei einem weiteren Nachdenken kann man dann vielleicht sogar feststellen, dass auch das ‚Schreiben von Menschen über andere Menschen und sich selbst‘ nicht ganz so trivial ist. Schon das Schreiben von Menschen ‚über sich selbst‘ ist fehleranfällig, kann völlig ‚daneben‘ laufen, kann vollständig ‚falsch‘ sein, was allerdings die Frager aufwirft, was denn ‚wahr‘ bzw. ‚falsch‘ ist. Man sollte also ein paar Gedanken darauf verwenden, wie wir Menschen so über die Welt und uns selbst reden können, dass wir gemeinsam eine Chance haben, nicht nur zu ‚fantasieren‘, sondern etwas zu erfassen, was ‚real‘ ist, was etwas von dem beschreibt, was uns als Menschen, als Lebewesen, als Bewohner dieses Planeten ‚real‘ auszeichnet. … aber dann poppt schon wieder die Frage auf, was denn ‚real‘ ist? Drehen wir uns im Kreis von Fragen mit Antworten, wo die Antworten selbst schon wieder Fragen sind, bei näherem Hinschauen?

Erste Schritte

Leben auf Planet Erde

Beim Start des Schreibens gehen wir davon aus, dass es den ‚Planet Erde‘ gibt und auf diesem Planeten gibt es etwas, das wir ‚Leben‘ nennen, und wir Menschen — zur Lebensform des Homo sapiens gehörend — sind Teil davon.

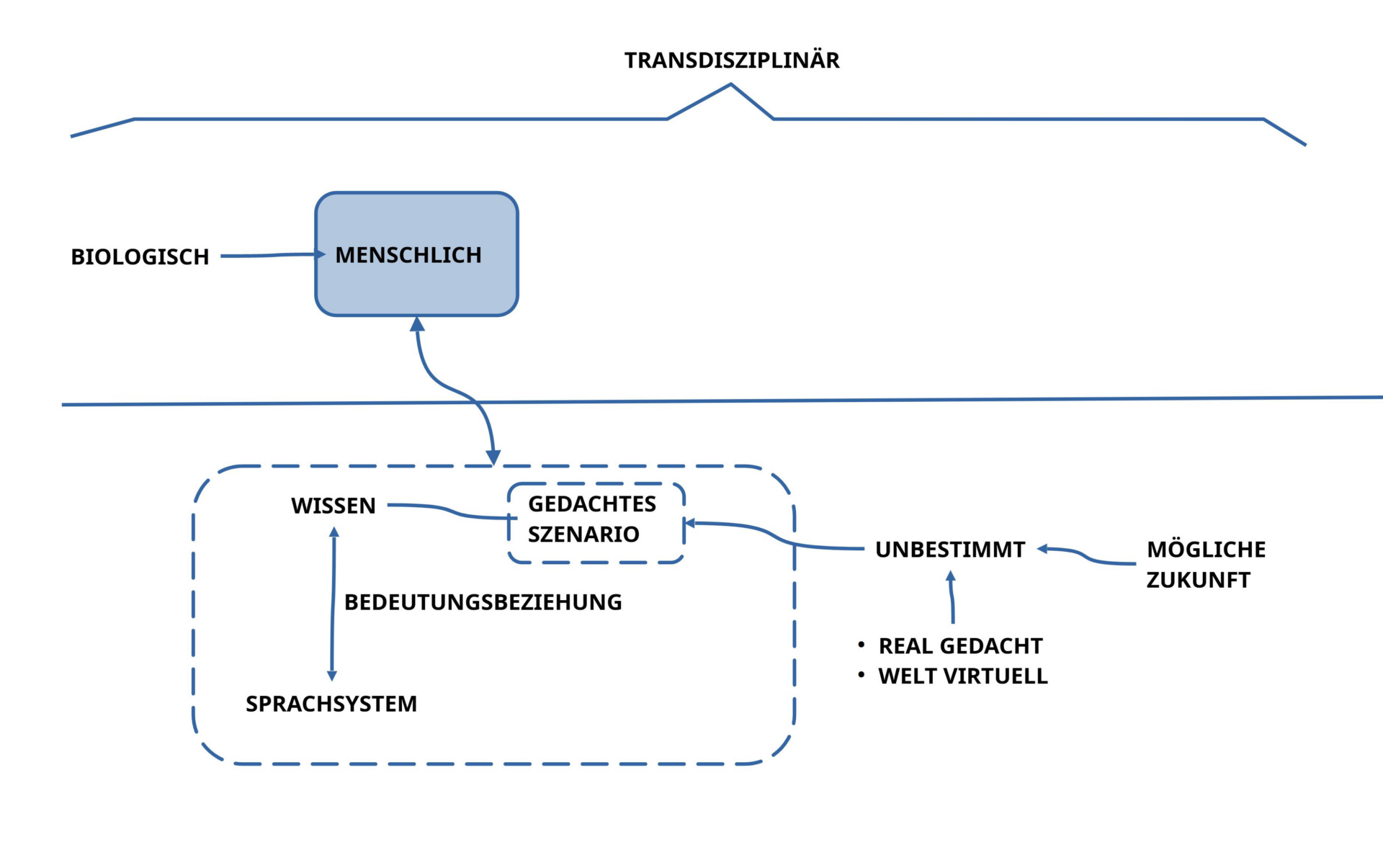

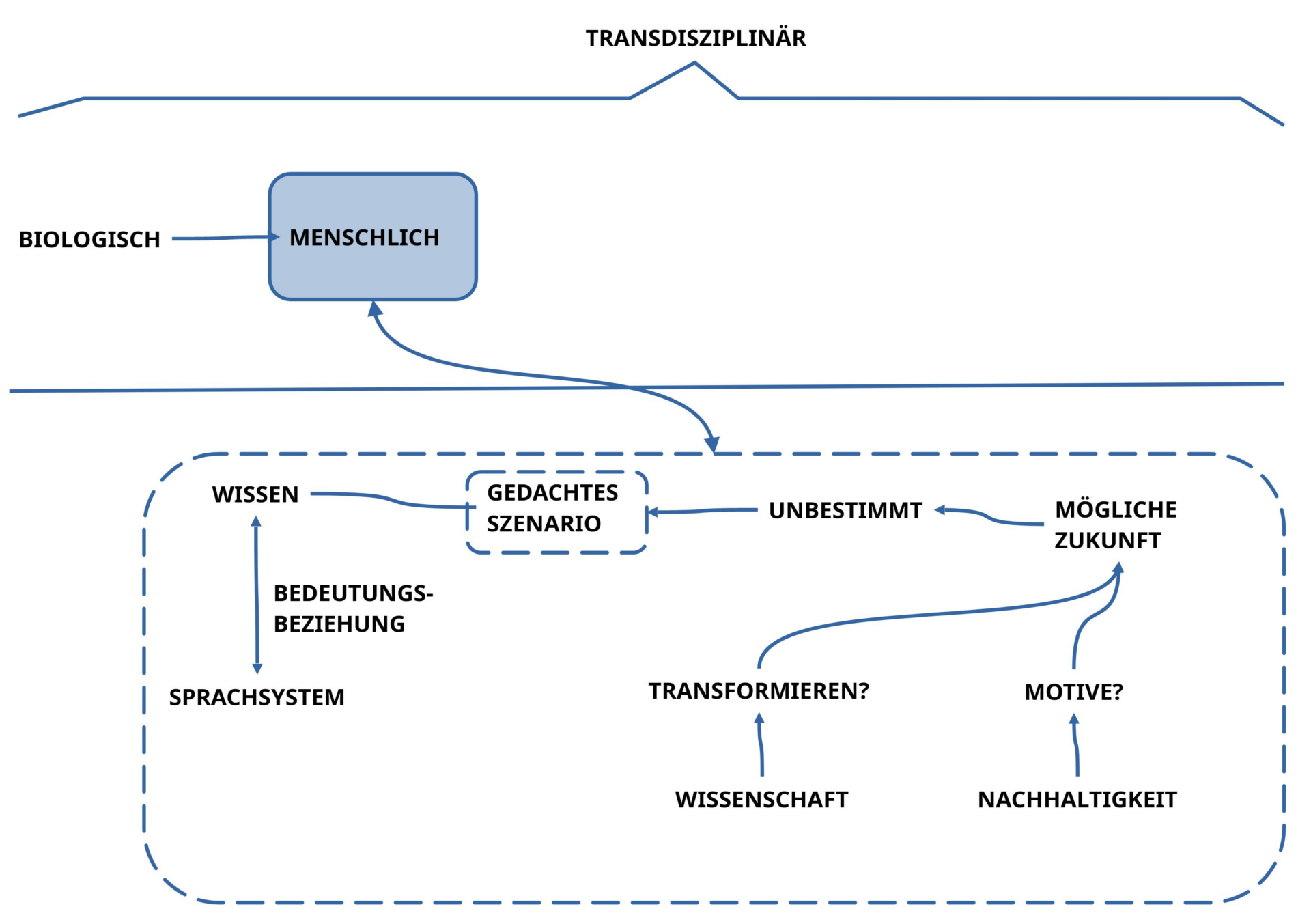

Sprache

Wir gehen auch davon aus, dass wir Menschen über die Fähigkeit verfügen, mittels Lauten miteinander zu kommunizieren. Diese Laute, die wir für die Kommunikation benutzen, nennen wir hier ‚Sprachlaute‘, um anzudeuten, dass die Gesamtheit der Laute für die Kommunikation ein ‚System‘ bilden, das wir letztlich ‚Sprache‘ nennen.

Bedeutung

Da wir Menschen auf diesem Planeten in der gleichen Situation für die ‚gleichen Objekte‘ ganz unterschiedliche Laute benutzen können, deutet sich an, dass die ‚Bedeutung‘ von Sprachlauten nicht fest an die Sprachlaute geknüpft ist, sondern irgendwie etwas mit dem zu tun hat, was ‚in unserem Kopf‘ stattfindet. Leider können wir nicht ‚in unseren Kopf‘ hineinschauen. Da scheint viel zu passieren, aber dieses Geschehen im Kopf ist ‚unsichtbar‘.[1] Trotzdem erleben wir im ‚Alltag‘, dass wir uns mit anderen ‚einigen‘ können, ob es gerade ‚regnet‘ oder ob es irgendwie ’stinkt‘ oder da auf dem Gehweg eine Mülltonne steht, die den Weg versperrt oder …. Also irgendwie scheint das ‚Geschehen im Kopf‘ bei unterschiedlichen Menschen gewisse ‚Übereinstimmungen‘ aufzuweisen, so dass nicht nur ich etwas Bestimmtes sehe, sondern der andere auch, und wir können sogar die gleichen Sprachlaute dafür benutzen. Und da ein Programm wie chatGPT meine Deutschen Sprachlaute z.B. in Englische Sprachlaute übersetzen kann, kann ich feststellen, dass ein anderer Mensch, der kein Deutsch spricht, statt meines Wortes ‚Mülltonne‘ z.B. das Wort ‚trash bin‘ benutzt und dann auch zustimmend nickt: ‚Yes, there is a trash bin‘. Wäre das ein Fall für eine ‚wahre Aussage‘?

Veränderungen und Erinnerungen

Da wir täglich erleben, wie der Alltag sich ständig ‚verändert‘, wissen wir, dass etwas, was gerade mal Zustimmung fand, im nächsten Moment keine Zustimmung mehr findet, weil die Mülltonne nicht mehr da steht. Diese Änderungen können wir aber nur bemerken, weil wir etwas haben, was wir ‚Erinnerung‘ nennen: wir können uns daran erinnern, dass eben an einer bestimmte Stelle eine Mülltonne stand, jetzt aber nicht mehr. Oder ist diese Erinnerung nur eine Einbildung? Kann ich meiner Erinnerung trauen? Wenn jetzt alle anderen sagen, da war doch keine Mülltonne, ich mich aber meine zu erinnern, was heißt dies?

Konkreter Körper

Ja, und dann mein Körper: immer wieder muss ich was trinken, etwas essen, bin nicht beliebig schnell, brauche etwas Platz, …. mein Körper ist etwas sehr Konkretes, mit allerlei ‚Empfindungen‘, ‚Bedürfnissen‘, einer bestimmten ‚Form‘, …. der sich im Laufe der Zeit sogar ändert: er wächst, er altert, er kann krank werden, …. ist er wie eine ‚Maschine‘?

Galaxien von Zellen

Wir wissen heute, dass unser menschlicher Körper weniger einer ‚Maschine‘ gleicht als vielmehr einer ‚Galaxie von Zellen‘. Unser Körper hat etwa 37 Billionen (10¹2) Körperzellen mit weiteren 100 Billionen Zellen im Darm, die für unser Verdauungssystem lebenswichtig sind, und diese Zellen zusammen bilden das ‚System Körper‘.[2] Das bislang eigentlich Unfassbare ist, dass diese ca. 140 Billionen Zellen ja jeweils komplett autonome Lebewesen sind, mit allem, was es zum Leben braucht. Und wenn man weiß, wie schwer wir uns als Menschen tun, schon zwischen fünf Menschen auf Dauer eine Kooperation aufzubauen und aufrecht zu halten, dann kann man zumindest ansatzweise ein wenig ahnen, was es heißt, dass 140 Billionen Lebewesen es in jeder Sekunde — und über viele Jahre, ja Jahrzehnte hinweg — schaffen, miteinander so zu kommunizieren und koordiniert zu handeln, dass das Gesamtkunstwerk ‚menschlicher Körper‘ existiert und funktioniert.

Entstehung als Frage

Und da es keinen ‚Befehlshaber‘ gibt, der allen Zellen ständig sagt, was sie tun sollen, erweitert sich dieses ‚Wunder des Systems Mensch‘ weiter um die Dimension, woher das Konzept kommt, das diese ‚Super-Galaxie der Zellen‘ dazu befähigt, so zu sein, wie sie sind. Wie funktioniert dies? Wie ist es entstanden?[3]

Hinter die Phänomene schauen

Im weiteren Verlauf wird es darauf ankommen, ausgehend vom Alltag nach und nach die ‚Oberfläche der Alltagsphänomene‘ zu durchdringen, um jene Strukturen sichtbar zu machen, die ‚hinter den Phänomenen‘ am Werke sind, jene Strukturen, die alles zusammenhalten und gleichzeitig alles beständig bewegen, verändern.

Grunddimension Zeit

Dies alles impliziert das Phänomen ‚Zeit‘ als Grundkategorie aller Wirklichkeit. Ohne Zeit gibt es auch keine ‚Wahrheit‘ …

[1] Spezialisten für Gehirnforschung werden natürlich gleich ihre Hand erheben und werden sagen wollen, dass sie mittlerweile sehr wohl ‚in den Kopf schauen‘ können, aber warten wir ab, was es mit diesem ‚in den Kopf hineinschauen‘ auf sich hat.

[2] Wenn wir für die Anzahl der Sterne in unserer Heimatgalaxie der Milchstraße mit geschätzten 100 – 400 Milliarden Sterne mal annehmen, dass es 200 Milliarden sind, dann würde unser Körpersystem dem Umfang von 700 Galaxien im Format der Milchstraße entsprechen, eine Zelle für einen Stern.

[3] Verschiedene Disziplinen der Naturwissenschaften, besonders sicher die Evolutionsbiologie, haben in den letzten ca. 150 Jahren viele Aspekte dieses Mega-Wunders partiell ausgeleuchtet. Man kann über die physikalische Sicht unsres Universum staunen, aber verglichen mit den Super-Galaxien des Lebens auf dem Planet Erde erscheint das physikalische Universum geradezu ‚langweilig‘ … Keine Angst: letztlich hängt beides untereinander zusammen: das eine erklärt das andere …

Geschichten erzählen

Fragmente des Alltags – ohne Kontext

Wir reden ständig über irgend etwas: das Essen, das Wetter, der Verkehr, die Preise beim Einkaufen, Tagesnachrichten, die Politik, den Chef, die Kollegen, Sportereignisse, Musik, …. meistens sind es ‚Fragmente‘ aus dem größeren Ganzen, das wir ‚Alltag‘ nennen. Menschen in einem der vielen Krisengebiete auf diesem Planeten, speziell jene in Unwetterkatastrophen oder gar im Krieg …, leben konkret in einer ganz anderen Welt, in einer Welt von Überleben und Tod.

Diese Fragmente mitten im Leben sind konkret, betreffen uns, aber sie erzählen aus sich heraus keine Geschichte, wo sie herkommen (Bomben, Regen, Hitze,…), warum sich dies ereignet, wie sie mit anderen Fragmenten zusammen hängen. Der Regen, der herunter prasselt, ist ein einzelnes Ereignis an einem bestimmten Ort zu einer bestimmten Zeit. Die Brücke, die gesperrt werden muss, weil sie überaltert ist, lässt aus sich heraus auch nicht erkennen, warum gerade diese Brücke, warum gerade jetzt, warum konnte man dies nicht ‚voraus sehen‘? Die Menschen, die ‚zu viel‘ sind in einem Land oder auch ‚zu wenig‘: Warum ist das so? Konnte man dies voraus sehen? Was können wir tun? Was sollten wir tun?

Der Strom der einzelnen Ereignisse trifft auf uns, mehr oder weniger wuchtig, vielleicht auch einfach als ‚Rauschen‘: wir sind so daran gewöhnt, dass wir bestimmte Ereignisse schon gar nicht mehr wahrnehmen. Aber diese Ereignisse als solche erzählen keine ‚Geschichte über sich selbst‘; sie finden einfach statt, scheinbar unwiderstehlich; manche sagen ‚Das ist Schicksal‘.

Bedürfnis nach Sinn

Auffällig ist, dass wir Menschen aber doch versuchen, dem Ganzen einen ‚Sinn‘ zu geben, eine ‚Erklärung‘ zu suchen, warum dies so ist. Und der Alltag zeigt, dass wir viel ‚Fantasie‘ haben, was mögliche ‚Zusammenhänge‘ oder ‚Ursachen‘ betrifft. Im Blick zurück in die Vergangenheit lächeln wir gerne über verschiedene Erklärungsversuche von unseren Vorfahren: solange man über die Details unseres Körpers und überhaupt über das Leben nichts wusste, war jede Geschichte möglich. [1] In unserer Zeit mit einer seit ca. 150 Jahren etablierter Wissenschaft gibt es aber immer noch viele Millionen von Menschen (möglicherweise Milliarden?), die von Wissenschaft nichts wissen und bereit sind, nahezu jede Geschichte zu glauben, nur weil ein anderer Mensch diese Geschichte überzeugend erzählt.

Befreiung vom Augenblick durch Worte

Aufgrund dieser Fähigkeit, mit der ‚Kraft der Fantasie‘ Dinge, die man erlebt, in eine ‚Geschichte‘ zu packen, die ‚mögliche Zusammenhänge‘ andeuten, durch die Ereignisse einen ‚gedanklichen Sinn‘ bekommen, kann der Mensch versuchen, sich aus der scheinbaren ‚Absolutheit des Augenblicks‘ in gewisser Weise zu ‚befreien‘: ein Ereignis, das sich in einen ‚Zusammenhang einordnen‘ lässt, verliert seine ‚Absolutheit‘. Allein schon durch diese Art von Erzählung gewinnt der erlebende Mensch ein Stück ‚Macht‘: im Erzählen eines Zusammenhangs kann er Erzähler das Erlebnis ‚zur Sache‘ machen, über die er ’nach eigenem Gutdünken‘ verfügen kann. Diese ‚Macht durch das Wort‘ kann ‚Angst‘ lindern, die ein Ereignis auslösen kann. Dies durchzieht die Geschichte der Menschheit von den Anfängen an, soweit es die archäologischen Zeugnisse hergeben.

Vielleicht ist es nicht verkehrt, den Menschen nicht als erstes als ‚Jäger und Sammler‘ oder als ‚Ackerbauer‘ oder so einzuordnen, sondern als ‚den, der Geschichten erzählt‘.

[1] Ein solches Zauberwort war in der griechischen Philosophie der Begriff ‚Atem‘ (griechisch „pneuma“). Der Atem kennzeichnete nicht nur das individuell Lebendige, sondern wurde auch verallgemeinert zum Lebensprinzip von allem, das sowohl Körper, Seele und Geist verband wie auch das ganze Universum durchwirkte. Im Lichte des heutigen Wissens könnte man diese ‚Erklärung‘ nicht mehr erzählen, aber vor ca. 2300 Jahren war diese Überzeugung unter allen Intellektuellen ein gewisser ‚intellektueller Standard‘, das herrschende ‚Weltbild‘; man ‚glaubte‘ es. Wer etwas anderes befand sich außerhalb dieses ‚Sprachspiels‘.

Organisation einer Ordnung

Denken erschafft Beziehungen

Sobald man mittels ‚Sprache‘ einzelne Ereignisse, Sachen, Vorgänge, Eigenschaften von Sachen und mehr ‚benennen‘ kann, verfügen Menschen offensichtlich über die Fähigkeit, mittels Sprache eben nicht nur zu ‚benennen‘, sondern ‚Benanntes‘ durch ‚Anordnung von Worten im sprachlichen Ausdruck‘ in ‚gedachte Beziehungen‘ einzubetten, wodurch das einzeln Benannte nicht mehr ‚isoliert‘ vorkommt sondern ‚gedanklich verbunden‘ mit anderem. Diese grundlegende Fähigkeit eines Menschen, ‚in seinem Kopf‘ ‚Beziehungen zu denken‘, die man ‚gar nicht sehen‘, wohl aber ‚denken‘ kann [1], ist natürlich nicht auf einzelne Ereignisse und nicht auf eine einzige Beziehung beschränkt. Letztlich können wir Menschen ‚alles‘ zum Thema machen und wir können ‚jedmögliche Beziehung‘ in unserm Kopf ‚denken‘; hier gibt es keine grundsätzliche Beschränkung.

Geschichten als Naturgewalt

Nicht nur die Geschichte ist voll von Beispielen, auch unsere Gegenwart. Dass heute trotz der unfassbaren Erfolge der modernen Wissenschaft in unserem Alltag weltweit nahezu über alle Kanäle die wildesten Geschichten mit ‚rein gedachten Beziehungen‘ erzählt und auch sofort geglaubt werden, das sollte uns zu denken geben. Unsere grundlegende Eigenschaft, dass wir Geschichten erzählen können, um die Absolutheit des Augenblicks zu durchbrechen, hat offensichtlich den Charakter einer ‚Naturgewalt‘, die so tief in uns verortet ist, dass wir sie nicht ‚ausrotten‘ können; wir können sie vielleicht ‚zähmen‘, sie vielleicht ‚kultivieren‘, aber wir können sie nicht stoppen. Es ist eine ‚elementare Eigenschaft‘ unseres Denkens, sprich: unseres Gehirns im Körper.

Gedacht und Überprüft

Die Erfahrung, dass wir, die wir diejenigen sind, die Geschichten erzählen, damit Ereignisse benennen und in Beziehungen einordnen können — und zwar letztlich unbegrenzt — kann zwar real zum Chaos führen, wenn das erzählte Beziehungsgeflecht letztlich ‚rein gedacht‘ ist, ohne echten Bezug zur ‚realen Welt um uns herum‘, aber es ist zugleich auch unser größtes Kapital, da wir Menschen uns damit nicht nur grundsätzlich von der scheinbaren Absolutheit der Gegenwart befreien können, sondern wir können mit dem Erzählen von Geschichten Ausgangspunkte schaffen, ‚zunächst bloß gedachte Beziehungen‘, die wir dann aber konkret in unserem Alltag ‚überprüfen‘ können.

Ein Ordnungssystem

Wenn jemand zufällig einen anderen Menschen sieht, der irgendwie ganz anders aussieht als er es gewohnt ist, dann bilden sich in jedem Menschen automatisch alle möglichen ‚Vermutungen‘, was das da für ein Mensch ist. Belässt man es bei diesen Vermutungen, dann können diese wilden Vermutungen den ‚Kopf bevölkern‘ und die ‚Welt im Kopf‘ wird mit ‚potentiell bösen Menschen‘ bevölkert; irgendwann sind sie dann vielleicht schlicht ‚böse‘. Nimmt man aber Kontakt zu dem anderen auf, könnte man vielleicht feststellen, dass er eigentlich nett ist, interessant, lustig oder dergleichen. Die ‚Vermutungen im Kopf‘ verwandeln sich dann in ‚konkrete Erfahrungen‘, die anders sind als zunächst gedacht. ‚Vermutungen‘ in Kombination mit ‚Überprüfung‘ können so zur Bildung von ‚wirklichkeitsnahen Vorstellungen von Beziehungen‘ führen. Damit hat ein Mensch die Chance, sein ’spontanes Geflecht an gedachten Beziehungen‘, die falsch sein können — und meistens auch sind — in ein ‚überprüftes Geflecht von Beziehungen‘ zu verwandeln. Da letztlich die gedachten Beziehungen als Geflecht für uns ein ‚Ordnungssystem‘ aufspannen, in dem die Dinge des Alltags einbettet sind, erscheint es erstrebenswert, mit möglichst ‚überprüften gedachten Beziehungen‘ zu arbeiten.

[1] Der Atem des Menschen mir gegenüber, der bei den Griechen mein Gegenüber mit der Lebenskraft des Universums verbindet, die wiederum auch mit dem Geist un d der Seele zusammenhängt …

Hypothesen und Wissenschaft

Herausforderung: Methodisch geordnetes Vermuten

Die Fähigkeit zum Denken von möglichen Beziehungen, dann auch mittels Sprache, ist angeboren [1], aber die ‚Nutzung‘ dieser Fähigkeit im Alltag, z.B. so, dass wir gedachte Beziehungen mit der Wirklichkeit des Alltags abgleichen, dieses ‚Abgleichen’/ ‚Überprüfen‘ ist nicht angeboren. Wir können es tun, müssen es aber nicht tun. Es ist von daher interessant, sich zu vergegenwärtigen, dass seit dem ersten Auftreten des Homo sapiens auf diesem Planeten [2] 99,95% der Zeit vergangen sind, bis es zur Etablierung einer organisierten modernen Wissenschaft vor ca. 150 Jahren gekommen ist. Man kann dies als Hinweis deuten, dass der Übergang vom ‚freien Vermuten‘ bis zu einem ‚methodisch geordneten systematischen Vermuten‘ alles andere als einfach gewesen sein muss. Und wenn heute immer noch ein Großteil der Menschen — trotz Schule und sogar Studium –[3] eher dem ‚freien Vermuten‘ zuneigen und sich mit geordneter Überprüfung schwer tun, dann scheint es hier tatsächlich eine nicht leichte Schwelle zu geben, die ein Mensch überwinden muss — und immer wieder neu muss — , um vom ‚freien‘ zum ‚methodisch geordneten‘ Vermuten überzugehen.[4]

Ausgangspunkt für Wissenschaft

‚Der Übergang vom alltäglichen Denken zum ‚wissenschaftlichen Denken‘ ist fließend. Das Erzeugen von ‚gedachten Beziehungen‘ in Verbindung mit Sprache aufgrund auch unserer Fähigkeit der Kreativität/ der Fantasie ist letztlich auch der Ausgangspunkt von Wissenschaft. Während wir im alltäglichen Denken eher spontan und pragmatisch ’spontan gedachte Beziehungen‘ ‚überprüfen‘, versucht die ‚Wissenschaft‘ solche Überprüfungen ’systematisch‘ zu organisieren, um dann solche ‚positiv überprüften Vermutungen‘ als ‚empirisch überprüfte Vermutungen‘ bis zum Beweis des Gegenteils als ‚bedingt wahr‘ anzunehmen. Statt von ‚Vermutungen‘ spricht die Wissenschaft gerne von ‚Hypothesen‘ oder ‚Arbeitshypothesen‘, aber es bleiben ‚Vermutungen‘ durch die Kraft unsres Denkens und durch die Kraft unserer Fantasie.[5]

[1] Dies bedeutet, die genetische Information, die der Entwicklung unseres Körpers zugrunde liegt, ist so beschaffen, dass unser Körper mit seinem Gehirn während der Wachstumsphase so aufgebaut wird, dass wir genau über diese Fähigkeit zum ‚Denken von Beziehungen‘ verfügen. Interessant hier wieder die Frage, wie es möglich ist, dass sich aus einer einzigen Zelle ca. 13 Billionen Körperzellen (die ca. 100 Billionen Bakterien im Darm kommen ‚von außen‘ dazu) so entwickeln können, dass sie als ‚Gesamteindruck‘ das ‚Bild des Menschen‘ erzeugen, das wir kennen

[2] Nach heutigem Kenntnisstand vor ca. 300.000 Jahren in Ostafrika und in Nordafrika, von wo der Homo sapiens dann die gesamte Welt erwandert und erobert hat (es gab noch Reste von anderen Menschenformen, die schon länger da waren).

[3] Repräsentative empirische Studien dazu, wie viele Menschen einer Bevölkerung dazu neigen, sind mir nicht bekannt.

[4] Berücksichtigt man, dass wir Menschen als Lebensform Homo sapiens erst nach ca. 3.8 Milliarden Jahren auf diesem Planeten erschienen sind, dann machen die 300.000 Jahre Homo sapiens grob 0,008% der gesamten Zeit aus, seitdem es Leben auf dem Planeten Erde gibt. Wir sind also nicht nur als Homo sapiens ein sehr spätes ‚Produkt‘ des Lebensprozesses, sondern innerhalb unseres Homo sapiens Lebensprozesses taucht die Fähigkeit zum ’systematischen Überprüfen von Hypothesen‘ auch erst ‚ganz spät‘ auf. Aufs ganze Leben bezogen scheint daher diese Fähigkeit extrem wertvoll zu sein, was ja auch stimmt, betrachtet man die unfassbaren Erkenntnisse, die wir als Homo sapiens mit dieser Form zu denken gewinnen konnten. fragt sich nur, wie wir mit diesem Wissen umgehen. Auch diese Verhaltensweise, systematisch überprüftes Wissen dann zu nutzen, ist nicht angeboren.

[5] Die Fähigkeit der ‚Fantasie‘ ist kein Gegensatz zum ‚Wissen‘, sondern ist etwas ganz anderes. ‚Fantasie‘ ist eine Eigenschaft, die sich in dem Moment ‚zeigt‘, wo wir anfangen zu denken, vielleicht sogar schon darin, ‚dass‘ wir überhaupt denken. Da wir im Prinzip über ‚alles‘ Nachdenken können, was unsrem Denken ‚erreichbar‘ ist, ist die Fantasie ein Faktor, der hilft, ‚Auszuwählen‘, was wir denken. Fantasie ist insoweit dem Denken vor-gelagert.