Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

29.März 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

INHALT

I Evolutionäre Ausgangslage

I-A Ältere Blogeinträge . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

I-B Resümee . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

II Luhmann 1991: Vorwort 3

III Diskussion 4

IV Luhmann 1991 Kap.1: Bewusstsein und Kommunikation

IV-A Abschnitt I . . . . . . . . . . . . . . . . . . . . . . . .

IV-A1 Bewusstsein . . . . . . . . . . . . . . . . .

IV-A2 Kommunikation . . . . . . . . . . . . . . . .

IV-A3 Gehirn – Nervensystem . . . . . . . . . . .

IV-B Diskussion . . . . . . . . . . . . . . . . . . . . . . . .

IV-C Abschnitt II . . . . . . . . . . . . . . . . . . . . . . . .

IV-C1 Systemtheorie, Autopoiesis . . . . . . . . .

IV-C2 Bewusstsein . . . . . . . . . . . . . . . . .

IV-C3 Kommunikation . . . . . . . . . . . . . . . .

Quellen

ÜBERBLICK

Im Rahmen des ’Wahrheitsprojektes’ gibt es den Bereich ’Individuum und Gesellschaft’. Dieser Bereich setzt historisch ein mit dem Auftreten des Homo sapiens und interessiert sich für eine formale Theorie des menschlichen Individuums innerhalb einer Population, eingebettet in eine Umwelt. In Ermangelung einer allgemein akzeptierten und funktionierenden allgemeinen formalen Theorie von Individuum und Gesellschaft wird hier Niklas Luhmann als Referenzpunkt gewählt. Er gilt u.a. als wichtiger (der wichtigste?) deutschsprachiger Vertreter der soziologischen Systemtheorie und der Soziokybernetik. Da Luhmann viele Bücher geschrieben hat muss man für den Start einen ’Eingangspunkt’ in seine Denkwelt wählen. Ich habe mich für das Buch ’Die Wissenschaft von der Gesellschaft’ (1991, 2.Aufl.) [Luh91] entschieden. Alle

Interpretationen des Autors zu Luhmanns Theorie stehen grundsätzlich unter dem Vorbehalt, dass diese Rekonstruktionen keine vollständige Werkanalyse darstellen. Die Vorgehensweise in diesem Beitrag ist der Versuch des Verstehens durch rekonstruierende Analyse mit formalen Mitteln. Für die Logik, die Luhmann

im Detail benutzt, sei verwiesen auf das Buch ’Laws of Form’ von Spencer Brown (1969, 1971) [Bro72] .

I. EVOLUTIONÄRE AUSGANGSLAGE

Vorab zur Analyse von Luhmann sei hier kurz die Lage skizziert, die sich nach 3.8 Mrd Jahren Evolution mit dem Auftreten des homo sapiens bietet. Da das entsprechende Kapitel hier noch nicht geschrieben wurde, seien hier nur jene Blogbeiträge kurz erwähnt, die sich bislang mit dem Thema beschäftigt haben.

A. Ältere Blogeinträge

1) Nr.124 vom April 2013: RANDBEMERKUNG: KOMPLEXITÄTSNTWICKLUNG (SINGULARITÄT(en))

2) Nr.132 vom Mai 2013: RANDBEMERKUNG: KOMPLEXITÄTSNTWICKLUNG (SINGULARITÄT(en)) Teil 2

3) Nr. 314 vom November 2015: STUNDE DER ENTSCHEIDUNG – Ist irgendwie

immer, aber manchmal mehr als sonst

4) Nr.333 vom März 2016: DENKEN UND WERTE – DER TREIBSATZ FÜR

ZUKÜNFTIGE WELTEN (Teil 1)

5) Nr.342 vom Juni 2016: EIN EVOLUTIONSSPRUNG PASSIERT JETZT UND NIEMAND BEMERKT ES?

6) Nr.381 vom 13.März 2017: DIE ZUKUNFT WARTET NICHT – 2117 – PHILOSOPHISCHE WELTFORMEL – FAKE-NEWS ALS TODESENGEL

7) Nr. 382 vom 18.März 2017: DIE ZUKUNFT WARTET NICHT – 2117 – PHILOSOPHISCHE WELTFORMEL – Teil 4 – MIND-GEIST . . .

8) Nr.383 vom 19.März 2017: INDIVIDUUM ALS BINDEGLIED ZWISCHEN BIOLO-

GISCHEM UND SOZIALEM – Nachtrag

9) Nr.400 vom Aug.2017: MENSCHENBILD – VORGESCHICHTE BIS ZUM

HOMO SAPIENS – Überlegungen

10) Nr. 401 vom Sept.2017: MENSCHENBILD – VORGESCHICHTE BIS ZUM HOMO SAPIENS – Ergänzungen

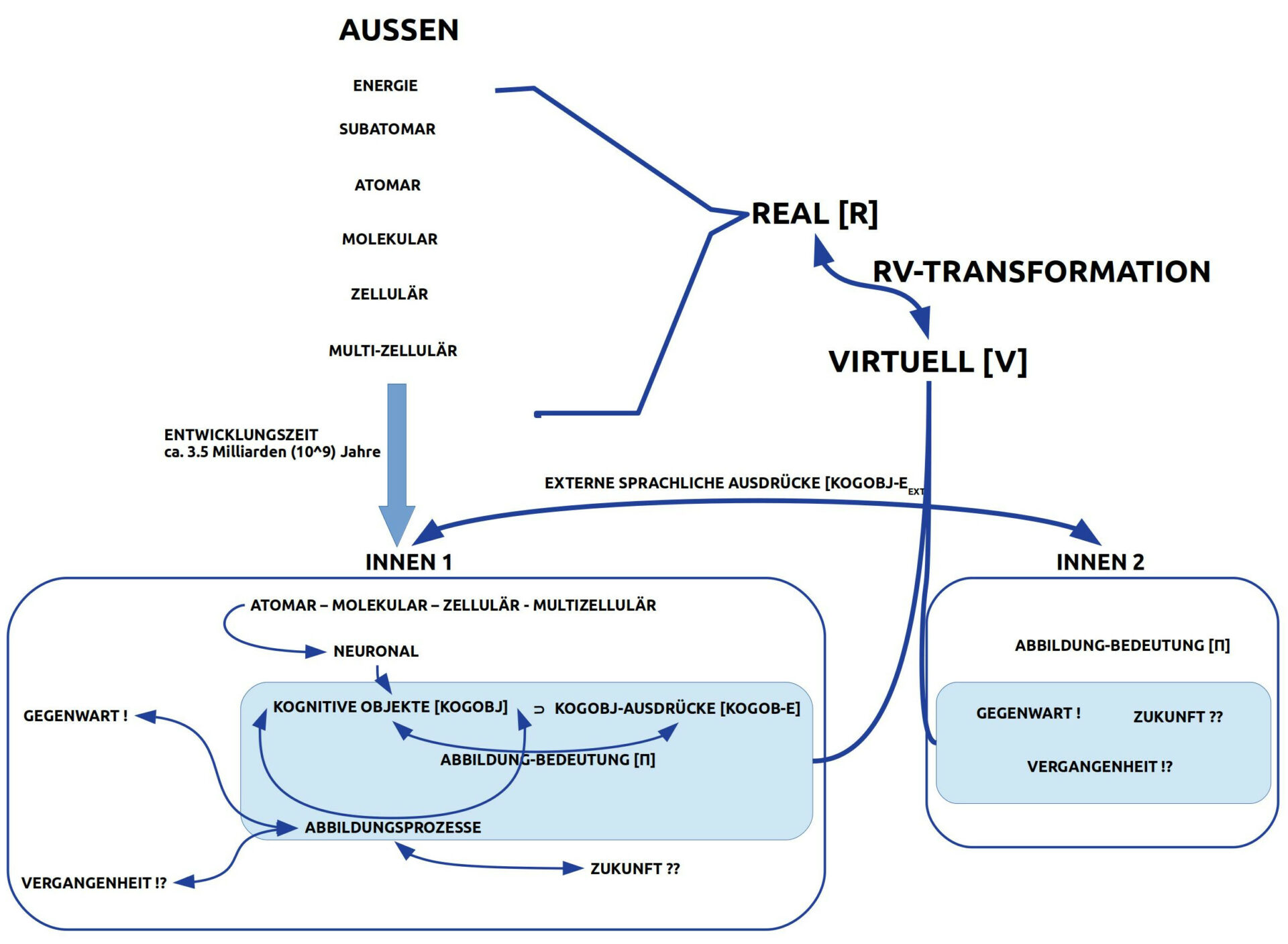

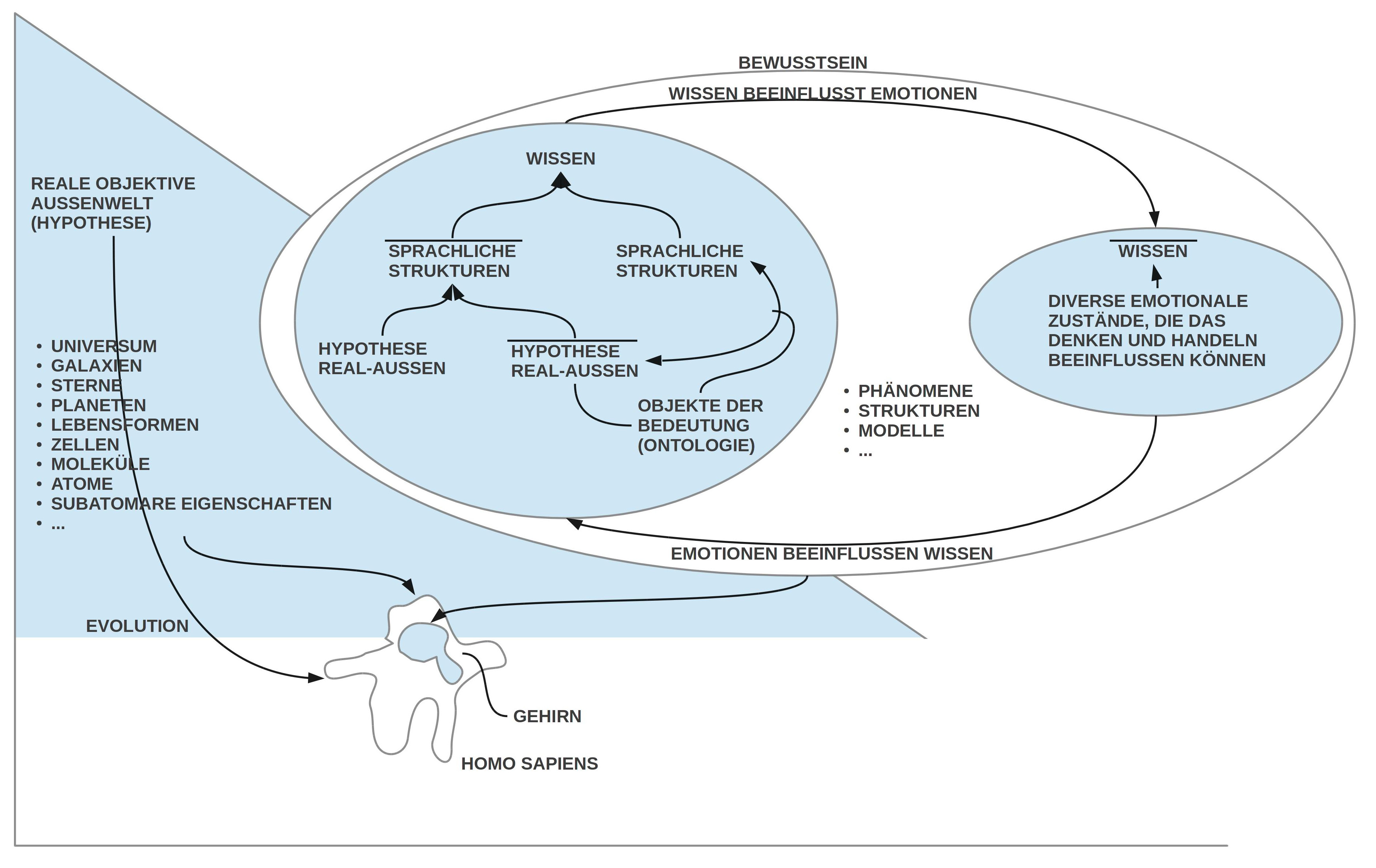

B. Resümee

Aus den bisherigen Untersuchungen ergibt sich als Zwischenstand, dass der homo sapiens die erste Lebensform auf der Erde ist, die neben der üblichen biologischen Ausstattung von Lebewesen zusätzlich über die Eigenschaften Bewusstsein, Gedächtnis, Abstraktionsvermögen, Kombinatorik, selbst definierte Ziele und symbolische Kommunikation in einer Weise verfügt, die anderen Lebensformen in dieser Weise bislang unzugänglich waren und bisher auch weiterhin unzugänglich sind.

Aufgrund dieser herausragenden Eigenschaften konnte der homo sapiens in den letzten ca. 12.000 Jahren in Bereichen wie z.B. Handwerk und Technologie, Landwirtschaft, Siedlungsbau, Infrastrukturen, Transport und Verkehr, Wissensweitergabe und Wissensspeicherung, Verwaltung großer Gesellschaftssysteme, Kunst und Kultur, Wirtschaftsformen, und vielem mehr Leistungen erbringen, die ihn weit, weit ab von den anderen bekannten Lebensformen stellen.

Diese objektiven Erfolge scheinen allerdings aktuell einen Zustand erzeugt zu haben, in dem die Menge der alltäglichen Ereignisse, ihre Auftretensgeschwindigkeit sowie ihre inhärente Komplexität die biologischen Kapazitäten eines normalen homo sapiens Gehirns mehr und mehr überschreiten. Neue Informationstechnologien aus den letzten ca. 40 Jahren konnten diese Überforderungen einerseits entlasten, führen aber bislang gleichzeitig zu einer Verstärkung der Belastung, da diese Technologien separiert von dem einzelnen Individuum gehostet und entwickelt werden (das ’Cloud-Syndrom’).

Für die übergreifende Fragestellung, ob und wieweit die neuen digitalen Technologien – möglicherweise in Kombination mit einer Art ’Cyborg-Strategie’ – noch besser als bisher für die Stärkung des Individuums genutzt werden können, soll hier eine Analyse der generellen Situation des Individuums in der Gesellschaft eingeschoben werden.

Diese Analyse nimmt ihren Ausgang bei der Annahme, dass der homo sapiens als einzelnes Individuum Teil einer Population ist, die durch ihre auf Kommunikation gründenden Aktivitäten spezifische ’gesellschaftliche Strukturen’ geformt hat und weiter formt, die das Leben in einer vorausgesetzten Umwelt gestalten. Zugleich wirken diese Strukturen auf den einzelnen zurück. Ob die aktuelle Gestaltung von Gesellschaft letztlich ’nachhaltig’ ist oder nicht bleibt an dieser Stelle noch offen. Erst soll die Frage

nach der allgemeinen Struktur geklärt werden, innerhalb deren das ’Leben’ der homo sapiens Individuen stattfindet.

II. LUHMANN 1991: VORWORT

Im folgenden Text wird auf eine Unterscheidung zwischen dem Eigentext von Luhmann und einer davon abgehobenen Interpretation verzichtet. Der gesamte Text ist von Anfang an eine Interpretation des Textes von Luhmann im Lichte der vorwiegend wissenschaftsphilosophischen Annahmen des Autors. Man könnte auch sagen, es handelt sich um eine Art ’Übersetzung’ in einen anderen begrifflichen Rahmen.

Wer wissen will, was Luhmann selbst sagt, der muss den Text von Luhmann direkt lesen. Hier geht es um eine ’theoretische Verwertung’ der Gedanken von Luhmann in einem formalen Rahmen, den Luhmann selbst zu Lebzeiten so nirgends artikuliert hat.

Vorgreifend kann man an dieser Stelle anmerken, dass diese durchgehende ’Übersetzung’ des Textes von Luhmann in den Text des Autors nur gelingen kann, weil Luhmann als ’roten Faden’ seiner Überlegungen einen ’Systembegriff’ benutzt, der es erlaubt, dass Systeme ’strukturell gekoppelt’ sind und dass sie ’Sub-Systeme’ enthalten können. Diese Auffassung teilt auch der Autor dieses Textes. Dennoch wird diese ’Übersetzung’ von dem Text Luhmanns in vielen Positionen – gerade in seinen zentralen Konzepten – radikal abweichen. Dies ist kein Paradox sondern ergibt sich aus dem Sachverhalt, dass der Autor an einigen entscheidenden Stellen die ’Selektion der Unterschiede’ anders vorgenommen hat als Luhmann; die ’Freiheit’ des Gehirns, des Bewusstseins, der Kommunikation wie auch der aktuellen gesellschaftlichen Situation des Autors lässt dies zu.

Im Vorwort thematisiert Luhmann einleitend das wissenschaftsphilosophische Problem, dass eine Soziologie, die eine wissenschaftliche Theorie der Gesellschaft erarbeiten will, trotz aller notwendigen methodischen Distanzierung zum Untersuchungsgegenstand doch auch zugleich Teil genau jener Gesellschaft ist, die untersucht werden soll. Die Bedingungen der Möglichkeit solch einer wissenschaftlichen Erkenntnis liegen der wissenschaftlichen Aktivität selbst voraus und werden traditionellerweise an die Philosophie delegiert, bzw. heutzutage vielleicht einer Erkenntnistheorie, die Hand in Hand mit der Wissenschaftsphilosophie arbeitet. Will eine einzelwissenschaftliche Disziplin – wie z.B. das System der Wissenschaft – ihr eigenes Tun in diesem Sinne von den impliziten Voraussetzungen her befragen, erhellen, klären, dann bedarf sie der Fähigkeit einer ’Autologie’, d.h. einer Selbstreflexion auf das eigene Tun, die sehr wohl auch eine Fremdbeobachtung der anderen Mit-Forschenden einbeziehen kann. Solch eine autologische Reflexion

kann nur in dem Maße die Besonderheiten eines Tuns zur Sprache bringen und kommunizieren, insoweit diese Disziplin über eine hinreichend ausdrucksstarke Metasprache verfügt. Diese wird gespeist durch das Fachwissen der Philosophie wie auch durch das spezifische Fachwissen der jeweiligen Disziplin, sofern letztere überhaupt schon über hinreichendes Spezialwissen verfügt.

Tatsächlich kann eine solche philosophische Selbstvergewisserung – hier der gesamte

Wissenschaftsbetrieb – nur gelingen, sofern diese zum Zeitpunkt der Untersuchung schon soweit als eigenes gesellschaftliches Subsystem vorkommt, dass durch gesellschaftlich legitimierte Setzungen und Verhaltensweisen ’vor-definiert’ ist, worin ’gesellschaftlich’ das Substrat dieser Disziplin besteht. Nur dann kann eine ’nach-sinnende’ autologische Reflexion die Eigenart aller beteiligten Komponenten und

Interaktionsprozesse identifizieren und analysieren. In diesem Sinne ist eine Fachdisziplin – bzw. hier der gesamte Wissenschaftsbetrieb – zu einem bestimmten historischen Zeitpunkt nicht ’Voraussetzungsfrei’ (Anmerkung: Wäre dem so, dann hätte man es mit einem eigenschaftslosen Neutrum zu tun, das nicht weiter bestimmbar wäre.) , sondern zeichnet sich gerade durch ein historisch gereiftes und darin durch Eigenschaften beschreibbares System zu tun, das innerhalb der Gesamtgesellschaft als Sub-System erscheint. Diese Unterscheidung lässt zugleich zu, dass jedes gegenwärtige System sich durch seine Eigenaktivitäten weiter verändert.

Die Aktualität der Gegenwart bildet damit tendenziell nicht das Gesamtsystem ab noch einen dauerhaften Zustand.

III. DISKUSSION

Es sei hier angenommen, dass ein historisch gewachsenes und gesellschaftlich ausgezeichnetes ’Subsystem Wissenschaft (SW)’ neben möglichen ’menschlichen Akteuren’ (A) zusätzlich über hinreichend viele Dokumente (D) verfügt, in denen Zielsetzung, typische Arbeitsweisen und der dynamische Bezug zum übergreifenden fundierenden gesellschaftlichen Gesamtsystem hinreichend beschrieben ist. Ein

gesellschaftliches wissenschaftliches Subsystem umfasst also minimal folgende Struktur:

SW (x) iff x = <A, D, h> (1)

A := Akteure (2)

D := Dokumente (3)

h := A × D —> A × D (4)

Das Symbol h repräsentiert die Menge der möglichen Handlungen, mit denen die Akteure im Sinne der offiziellen Dokumente neue Dokumente generieren können bzw. auch die Menge der Akteure verändern können. Was in dieser expliziten Darstellung noch fehlt ist der Aspekt der Gesellschaft (G). Denn eine Gesellschaft hat ja meistens mehr als ein Subsystem (Anmerkung: Wobei jedes Subsystem noch weitere Subsysteme haben kann). Zwischen einem Subsystem S und der Gesellschaft G kann es typische Interaktionen geben, ebenso auch zwischen Subsystemen direkt. Man

müsste daher mindestens eine weitere Interaktionsebene einbeziehen:

G(x) iff x = <A, D, Σ, h> (5)

A := Akteure (6)

D := Dokumente (7)

Σ := Menge von Subsystemen (8)

h := A × D × Σ —> A × D × Σ (9)

Die Akteure (A) auf der Ebene der Gesellschaft (G) sind einerseits die ’Grundmenge’ aller Akteure, andererseits unterscheiden sich Subsysteme von der umgebenden Gesellschaft G dadurch, dass sie sich in mindestens einer Eigenschaft vom globalen System ’unterscheiden’. Es wird hier angenommen, dass diese minimale Verschiedenheit sich auf auf die Akteure A bezieht, auf die beschreibenden Dokumente D sowie auf die jeweilige Veränderungsfunktion h . Um Verwechslungen in der Kommunikation zu vermeiden könnte man die jeweiligen Symbole immer mit einem ’Index’ versehen, der den jeweiligen ’Kontext’ anzeigt, z.B. A_G

im Unterschied zu A_SW oder h_G im Unterschied zu h_SW .

Aufgrund der minimalen Unterscheidbarkeit gilt dann generell, dass A_SW ⊆ A_G , d.h. die Akteure aus einem Subsystem sind spezieller als jene Akteure, die als Akteure einer globalen Gesellschaft gelten. Entsprechend verhält es sich in der Beziehung der Veränderungsfunktionen: h_SW ⊆ h_G.

Denkbar ist allerdings – und dies entspricht den empirischen Fakten –, dass es aufgrund der räumlichen Verteilung des homo sapiens auf der Erde (und zukünftig vielleicht auch im Weltall) gesellschaftliche Systeme gibt, die räumlich getrennt sind und die in ihrer ’Region’ das ’oberste’ gesellschaftliche System G darstellen, das unterschiedliche Subsysteme haben kann. Faktisch gibt es dann viele gesellschaftliche

Systeme G_1 , …, G_n , die aufgrund ihrer separierten Existenz ’gleichberechtigt’ sind.

Andererseits wissen wir aufgrund der historischen Daten, dass es zwischen solchen räumlich verteilten gesellschaftlichen Systemen G sowohl ’kriegerische Handlungen’ gegeben hat, in denen das eine System G das andere System G_0 mit Gewalt erobert hat, oder es gab ’Wanderungsbewegungen’, die zu einer Vermischung der Akteure A_G , A_G_0 geführt hat. Solche Vermischung ( μ) – durch Eroberung oder Wanderung – konnten durch die unterschiedlichen ’Präferenz- und Wissensmodelle’ der Neuankömmlinge über die Interaktionen auf die bestehenden Dokumente und auf die Veränderungsfunktion h_G so einwirken, dass Modifikationen entstanden, etwa:

μ : A_G × A_G_0 × D_G × D_G_0 —> A_(G∪G_0) × D_(G∪G_0) × h_(G∪G_0)

Die führt zu einer Erweiterung des Referenzsystems zu einer ’Weltgesellschaft (WG)’:

G(x) iff x = <A, D, Σ, h> (5)

SW (x) iff x = <A, D, h> (1)

A_SW ⊆ A_G (12)

h_SW ⊆ h_G (13)

WG(x) iff x =<R3 , Γ, ∆, AF, μ>(14)

R3 := 3 − dimensionale Koordinaten

Γ = U(A1 , …, An)

∆ =U(D1 , …, Dn )

AF := Artefakte

μ = 2^(R3 ×AF ×Γ×∆) —> 2^(R3 ×AF ×Γ×∆)

Die Grundidee ist die, dass die regional getrennten Gesellschaften miteinander vermischt werden können, was eine räumliche Umgruppierung von Akteuren und Dokumenten bedeuten kann. Andere wirksame Faktor sind z.B. der ’Handel’ oder neue ’Technologien’, die rein praktisch das alltägliche Leben verändert haben.

Im nächsten Kapitel 1 beschreibt Luhmann in erster Linie die Begriffe ’Bewusstsein’ und ’Kommunikation’ sowie deren Wechselwirkungen. Für diese Rekonstruktion werden die bisherigen begrifflichen Festlegungen berücksichtigt.

IV. LUHMANN 1991 KAP .1: BEWUSSTSEIN UND KOMMUNIKATION

A. Abschnitt I

Luhmann beginnt diesen Abschnitt mit der Frage nach dem ’Träger von Wissen‘

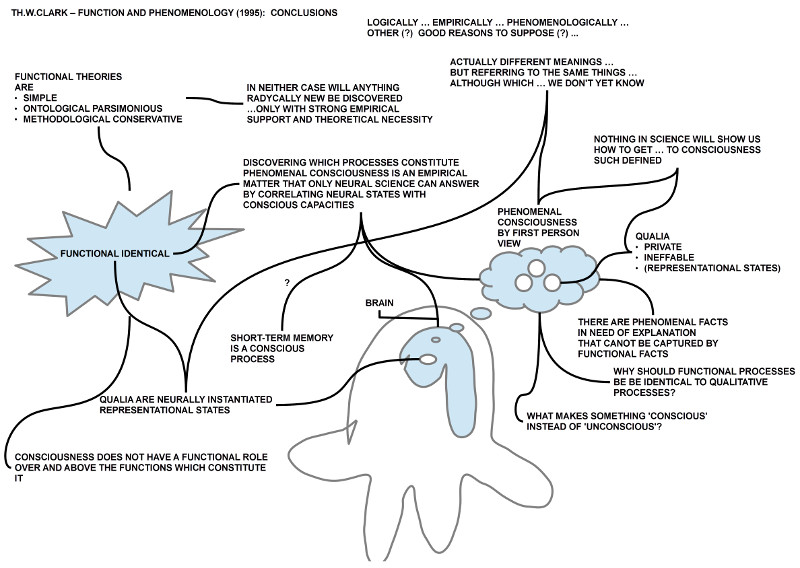

bzw. Bewusstsein: Nach allerlei historischen Betrachtungen findet er einen ersten ’Ankerpunkt’ seiner Überlegungen in der grundlegenden Fähigkeit des Bewusstseins im Rahmen der Wahrnehmung grundsätzlich ’ein anderes’ wahrnehmen zu können. Es ist ein ’dass’, ein reiner ’Unterschied’, kein interpretierendes ’wie’. Diese Unterscheidung vom anderen ist die ’primäre Differenz’, die einen möglichen ’Anschluss’ für eine Kommunikation bietet und einen möglichen Referenzpunkt für eine mögliche ’sekundäre Zuschreibung’ von weiterem Wissen. (vgl. S.17)

Das ’Bewusstsein’, das Unterschiede wahrnehmen kann, operiert unter stillschweigender Voraussetzung des ’Gehirns’ (= Nervensystem), ohne das Gehirn zu ’bemerken’. Der ’eigene Leib’ wird als bewusstseinsexterner ’Gegenstand’ erlebt. Damit externalisiert das Bewusstsein seine Zustände in die Welt hinein.(vgl.S.20)

Die Besonderheit des Bewusstseins liegt im ’Wahrnehmen’ und ’anschaulichen Imaginieren’. Ferner wird in der Wahrnehmung das Unterschiedene zugleich in einer ’Einheit’ erfasst.(vgl.S.20)

2) Kommunikation: Mit Rückgriff auf die Entwicklungspsychologie postuliert er, dass basierend auf dieser primären Unterscheidung im Bewusstsein eine erste ’Kommunikation’ angestoßen wird, noch vorab zum Spracherwerb. Und es ist diese erste Kommunikation die es nahelegt, ein ’alter ego’ im erfahrbaren Anderen zu unterstellen, und an dieses im Laufe der Zeit mehr Wissen anzulagern.(vgl. S.18f)

Und es wundert bei dieser Ausgangslage nicht, dass Luhmann postuliert, dass die Kommunikation Bedingung für ’Intersubjektivität’ ist und nicht umgekehrt. Innerhalb dieser Kommunikation wird zwischen ’Mitteilung’ und ’Information’ unterschieden. Diese Differenz soll dann nachgeordnet mit ’Sinngehalten’ angereichert werden.(vgl.S.19)

Kommunikation setzt Bewusstsein voraus, unterscheidet sich aber vom Bewusstsein, da ’Irrtum’, ’Täuschung’, ’Symbolmissbrauch’ der Kommunikation zugeordnet wird, nicht dem Bewusstsein.(vgl.S.21) Mit dem Grundsatz, dass die Wahrnehmung selbst nicht kommunizierbar ist (vgl.S.20), ergibt sich, dass logisches, kreatives Denken ohne Effekt bleibt, wenn es nicht kommunizierbar wird.(vgl.S.22)

Da Luhmann ferner annimmt, dass Wissen der Kommunikation zuzurechnen ist, nicht dem Bewusstsein (vgl.S.23), kann er weiter folgern, dass sich kein individuell bewusstes Wissen isolieren lässt.(vgl.S.22) Obwohl Kommunikation nicht zwingend auf Bewusstsein wirkt (vgl.S.22), kann Kommunikation das Leben und das Bewusstsein von Menschen auslöschen.(vgl.S.23)

3) Gehirn – Nervensystem: Das ’Nervensystem’ kann nur körpereigene Zustände unterscheiden und operiert daher ohne Bezug auf die Umwelt.(vgl.S. 19)

B. Diskussion

Luhmann bringt eine Reihe von Begriffen ins Spiel { z.B. ’Gehirn’, ’Bewusstsein’, ’Wahrnehmung’, ’Differenz’, ’Kommunikation’, ’Mitteilung’, ’Information’, ’Sinngehalt’,

’Irrtum’, ’Täuschung’, ’Symbolmissbrauch’, usw. } , die zunächst relativ undifferenziert und nur locker in Beziehung gesetzt werden.

Nach der vorausgehenden Diskussion haben wir als bisherigen Referenzrahmen die beiden Begriffe ’Subsystem Wissenschaft’, ’System Gesellschaft’, und – falls es mehrere regional unterschiedene Gesellschaften gibt – die ’Weltgesellschaft’ (für einen erster Formalisierungsansatz siehe oben).

Davon unterschieden wird für die Begriffe { ’Gehirn’, ’Bewusstsein’,

’Wahrnehmung’, ’Differenz’ } In einer ersten Annäherung angenommen, dass diese einem einzelnen Akteur A zuzurechnen sind. Dies erfordert, dass man den Akteur selbst als ein System sieht, der verschiedene Sub-Systeme umfasst, etwa so:

A(x) iff x = <BR, PERC, PH, CONSC, ψ> (30)

BR := Gehirn (31)

ψ : BR —> PERC × PH × CONSC (32)

PERC := Wahrnehmung (33)

PH := Phaenomene (34)

CONSC ⊆ 2^PH (35)

Das ’Gehirn (BR)’ erzeugt mittels der Funktion ψ ’Wahrnehmungen (PERC)’, die aufgrund von erfassbaren ’Differenzen’ unterscheidbare ’Phänomene (PH)’ erkennen lassen. Diese Phänomene bilden den ’Raum’ des ’Bewusstseins (CONSC)’. Weitere Aussagen sind an dieser Stelle noch schwierig.

Darüber hinaus muss man die Begriffe { ’Kommunikation’, ’Mitteilung’, ’Information’, ’Sinngehalt’,’Irrtum’, ’Täuschung’, ’Symbolmissbrauch’ } einordnen. Da Luhmann die Kommunikation als eigenes System sehen will, innerhalb dessen Mitteilungen und Informationen auftreten können, die mit Sinngehalten irgendwie in Beziehung stehen, dazu die Phänomene ’Irrtum’, ’Täuschung’ und ’Symbolmissbrauch’, muss man ein weiteres System annehmen, etwa so:

COM (x) iff x = <MT, INF, …>(36)

MT := Mitteilungen (37)

INF := Informationen (38)

… := Weitere Eigenschaften (39)

Wie genau dann das System Kommunikation (COM) funktionieren soll, wie das Zusammenspiel seiner unterschiedlichen Eigenschaften ist, wie genau das Wechselspiel mit dem Bewusstsein zu sehen ist, das ist an dieser Stelle noch unklar.

Ganz allgemein kann man schon an dieser frühen Stelle der Lektüre feststellen, dass Luhmann trotz seiner systemanalytischen Intentionen keinerlei Anstalten trifft, seine Überlegungen in Form einer wissenschaftlichen Theorie zu organisieren. Weder macht er sich Gedanken über eine notwendige Sprache noch über einen formalen Aufbau. Dementsprechend ist auch nicht klar, wie in seine ’Theorie’ Begriffe ’neu eingeführt’ werden können (andere nennen dies ’Definitionslehre’). Genauso wenig wie er irgendwelche überprüfbaren Qualitätskriterien für seine ’Theorie’ formuliert. Wann ist seine Theorie ’erfolgreich’? Wann ist sie ’wahr/ falsch’? … oder was auch immer man als Kriterium benutzen möchte.

Das gänzliche Fehlen dieser Überlegungen rächt sich im weiteren Verlauf nahezu auf jeder Seite.

C. Abschnitt II

In diesem Abschnitt werden die Begriffe ’Bewusstsein’ und ’Kommunikation’ als Systeme von Luhmann weiter ausdifferenziert; dazu ein paar Bemerkungen zur Autopoiesis.

1) Systemtheorie, Autopoiesis: Luhmann hält nochmals fest, dass eine fundamentale Annahme der Systemtheorie darin besteht, dass man eine Differenz von ’System’ und ’Umwelt’ annimmt. Daraus folgt einerseits, dass kein System außerhalb seiner eigenen Grenzen operieren kann, (vgl.S. 28) aber auch, dass jedes System in einer Umwelt existiert. Zwischen Umwelt und System darf man Kausalbeziehungen annehmen, die aber nur ein externer Beobachter beobachten kann.(vgl.S. 29) Zugleich gilt, dass ein

System immer schon an die Umwelt ’gekoppelt’ ist. Er behauptet sogar weiter, dass ein System immer schon angepasst sei.(vgl.S. 29)

Mit dieser Formulierung steht Luhmann im Gegensatz zu den Erkenntnissen der Evolutionsbiologie, die offengelegt hat, dass alle zu einem bestimmten Zeitpunkt beobachtbaren ’Passungen’ Ergebnisse langwieriger dynamischer Anpassungsprozesse sind. In diesem Licht sind – zumindest lebende – Systeme in einer Umwelt niemals völlig unabhängig von dieser. Der von Luhmann gewählte

Begriff der ’Systemkopplung’ erfüllt zwar formal zunächst seinen Zweck, aber er wird der komplexen Interaktionsdynamik von (lebenden) Systemen und Umwelt nicht voll gerecht.

Insofern ist in diesem Zusammenhang sein Hinweis interessant, dass ’Autopoiesis’ (Anmerkung: Zum Begriff finden sich zahlreiche online-Quellen von Whitaker (2010) [Whi10]) nicht besage, dass das System allein aus sich heraus… ohne jeden Beitrag aus der Umwelt existiere.(vgl. S.30) Er schließt damit formal weitere Interaktionsbeziehungen nicht grundsätzlich aus, klammert sie aber aus seiner formalen Analyse hier aus. Solange diese Ausklammerung den Hauptinhalt seiner Analysen nicht wesentlich verändert, kann er dies machen. Wenn aber – und der weitere Fortgang erweckt diesen Eindruck – dadurch wichtige grundlegenden Eigenschaften des Hauptgegenstandes durch formal angeregte Selektionen eliminiert werden, dann ist dieser Sachverhalt für die Untersuchung erheblich.

Aufgrund der zuvor vorgenommenen Selektion und der damit einhergehenden Vereinfachung kann Luhmann sich auf die ’Innensicht’ der isolierten Systeme fokussieren. Und er schreibt dann ganz klar, dass es vielmehr nur darum geht, ”dass die Einheit des Systems und mit ihr alle Elemente, aus denen das System besteht, durch das System selbst produziert werden. Selbstverständlich ist dies nur auf der

Basis eines Materialkontinuums möglich … Selbstverständlich braucht solch ein Prozess Zeit…”(S.30)

Die Begriffe ’Materialkontinuum’ und ’Zeit’ verweisen auf eine empirische Umwelt, ohne die es beides nicht geben würde. Und obwohl er auf die ’Autonomie’ der Systeme abhebt, kommt er nicht umhin, festzustellen, ”… der Begriff der strukturellen Kopplung wird uns daran erinnern, dass das System laufend Irritationen aus der Umwelt registriert und zum Anlass nimmt, die eigenen Strukturen zu respezifizieren. (S. 30)

Solange man die ’Irritationen’, die durch eine strukturelle Kopplung hervorgerufen werden (Anmerkung: Beruhen diese ’Irritationen’ auf einer Kausalbeziehung?) , in der

Unbestimmtheit belässt, in der sie Luhmann präsentiert, spielen diese ’Irritationen’ keine ’inhaltlich fassbare’ Rolle. Eigentlich erscheinen sie überflüssig. Andererseits erwähnt Luhmann sie aber, weil sie irgendwo offensichtlich wichtig sind. In welchem Sinne sind sie wichtig? Von lebendigen Systemen wissen wir, dass diese Kopplungen für das System ’wesentlich’ sind (z.B. die Energiezufuhr einer eukaryotischen Zelle).

Man muss daher die Frage stellen, ob eine Systembeschreibung nicht so angelegt sein sollte, dass sie den für das System erheblichen Grund der strukturellen Kopplung für das System sichtbar machen sollte, so dass die weiteren ’Systemfunktionen’ auf der Basis der grundlegenden Struktur ’verständlich’ werden? Eine Systembeschreibung, die wesentliche Systemeigenschaften und Systemdynamiken von vornherein ausklammert wirkt ansonsten ein wenig ’willkürlich’, ’voreingenommen’, ’dogmatisch’. Diese

wissenschaftsphilosophische Kritik stellt damit nicht den Systembegriff als solchen in Frage, sondern nur eine spezielle Anwendung auf einen der Theoriebildung vorgelagerten Phänomenbereich.

Für Luhmann folgt aus seiner Verwendung des Systembegriffs, dass ”’lebende Systeme’, ’Bewusstseinssysteme’ und ’Kommunikationssysteme’ verschiedenartige, getrennt operierende selbstreferentielle Systeme [sind]”.(S. 28). Damit sendet er ein klares Signal aus, dass er die möglicherweise gegebenen wichtigen strukturellen und funktionellen Zusammenhänge dieser identifizierten Systeme durch eine andere Verwendungsweise des Systembegriffs im Falle der angesprochenen Phänomene bewusst ausklammert.

Als methodisch motiviertes Gedankenexperiment kann eine solche begriffliche Anordnung Sinn machen, für die theoretische Rekonstruktion der erfahrbaren Wirklichkeit kann dieses Vorgehen aber in die Irre führen. Dies umso mehr, als Luhmann nirgendwo entscheidbare Kriterien etabliert hat, anhand deren man in minimaler Weise einen ’Erfolg’ oder ’Misserfolg’ seines Gedankenexperiments ablesen

könnte.

Das Beispiel lebender Systeme zeigt seit vielen Milliarden Jahren, dass Anpassungsprozesse nur durch das Wirken von sehr harten Kriterien funktionieren. Das harte Kriterium ist im Fall lebender Systeme die (i) Aufrechterhaltung eines Prozesses, dessen innere Logik in der (ii) individuellen Ausnutzung von freier Energie besteht, die in einer (iii) populationsweiten Abfolge von Systementwürfen (iv) die Population im Spiel hält. Das einzelne System ist hier eindeutig nur zu verstehen als ein Element einer größeren Population, die ein spezifisches Prozessmodell umsetzt. Man müsste in diesem Fall daher von vornherein einerseits (a) das System ’Population’ selektieren, das als Teil des Systems (b) ’Umwelt’ im Rahmen eines ’Prozesses’ den sowohl populären wie individuellen (c) ’Lebensprozess’ realisiert. Ferner wissen

wir heute, dass eine Population nicht ausreicht, sondern dass wir es mit einem (a*) ’Netzwerk von Populationen’ zu tun haben, die wechselseitig füreinander wichtige Funktionsleistungen erbringen. Will man diese Realität erfassen, dann kann man mit dem stark reduktionistischen Ansatz von Luhmann eigentlich nur scheitern.

Wohlgemerkt: das Problem ist nicht der Systembegriff als solcher, sondern die

Art seiner Anwendung auf eine empirisch vorhandene Realität.

2) Bewusstsein: Nach dem Vorausgehenden ist bekannt, dass Luhmann das Phänomen ’Bewusstsein’ als ein eigenständiges System selektiert hat. Er spricht im Fall des Bewusstseins auch von einem ’psychischen System’.(vgl. S.23) Entsprechend seiner allgemeinen Annahme zu Systemen kommt er dann zu Aussagen wie ”… psychische Systeme operieren selbstreferentiell-geschlossen und sind

füreinander unzugänglich…” (S. 23), oder auch ”Dem Verstehen psychischer Systeme … fehlt die für den Kommunikationsprozess notwendige Diskretheit. Psychisch gibt es hier kein entweder/oder. Genau das braucht aber der Kommunikationsprozess, um seine eigene Autopoiesis fortsetzen zu können. …Innere Unendlichkeit der psychischen Systeme…”(S. 26)

Neben den schon angemerkten eliminierenden Selektionen, die Luhmann zuvor schon vorgenommen hat, erscheint die Behauptung, dass es psychisch kein ’entweder/oder’ gibt gewagt, da ja (was Luhmann über viele Seiten schlicht ausklammert) das Bewusstsein sich gerade dadurch auszeichnet, dass grundlegend mindestens folgendes möglich ist. (i) die Unterscheidung von Bewusstseinsinhalten anhand von Eigenschaften; (ii) die Identifizierung des Unterschiedenen in der Unterscheidung, eben

die Eigenschaftskomplexe, die oft ’Phänomene’ genannt werden; (iii) die erlebbare ’Einheit’ trotz ’Unterscheidung’.

Das Bewusstsein erlebt unterscheidbare Phänomene nicht nur einfach so, sondern z.B. diese Phänomene auch als Elemente in einem ’Raum’, der unhintergehbarer Bestandteil des Erlebens ist. Nur deshalb kann das Bewusstsein diese Elemente auch ’in Beziehung setzen’, hier in räumliche Beziehungen wie z.B. a ist ’über’ b oder a ist ’unter b’. Zum aktuellen Erleben gehört sogar die Befähigung, (iv) ’Aktuelles’ im Vergleich zu ’Erinnertem’ zu sehen, also in einer zeitlichen Relation. Das ’Gedächtnis’

als ’Quelle’ von Erinnerungen ist selbst zwar kein Bestandteil des Bewusstseins (ein eigenes strukturell gekoppeltes System), aber diese Kopplung zwischen Bewusstsein und Gedächtnis ist funktional so ausgelegt, dass das Gedächtnis die aktuellen Phänomene quasi simultan ’kommentiert’, unaufgefordert, aber kausal dazu genötigt.

Dies ist ein klarer Fall, in dem die strukturelle Kopplung auf der Ebene des Systems Bewusstsein zum Gedächtnis hin abgeschottet erscheint, aber auf der Ebene des Systems ’Gehirns’ sind sowohl Bewusstsein wie Gedächtnis Teilsysteme, die das System Gehirn so ’prozessiert’, dass Inhalte des Bewusstseins ’für das System Bewusstsein unsichtbar’ in das System ’Gedächtnis’ ’transportiert’ werden und umgekehrt. Für das Funktionieren des Systems Bewusstsein ist diese kausale

Maschinerie wesentlich!

Wenn Luhmann an anderer Stelle feststellt, dass ”das Bewusstsein an die neurophysiologischen Prozesse ’seines’ Organismus gekoppelt [ist] ohne sich diesen Prozessen anpassen zu können. Es kann sie nicht einmal wahrnehmen…”(S.29) dann nimmt er diesen fundamentalen Zusammenhang beiläufig zur Kenntnis, zieht daraus aber keine weiteren Konsequenzen für sein Gedankenexperiment. Die Realität des biologischen Systems Körper, in das das System Gehirn eingebettet ist, und darin Bewusstsein und Gedächtnis, ist aus der Sicht des Gesamtsystems Körper auf bestimmte Funktionen ausgelegt, für deren Erfüllung viele Teilsysteme zusammen arbeiten müssen. Im Fall Bewusstsein haben wir mindestens die Teilsysteme ’Wahrnehmung’, ’Gedächtnis’ und ’Bewusstsein’. Obwohl die Teilsysteme ’Wahrnehmung’ und ’Gedächtnis’ aus Sicht des Systems Bewusstsein strukturell so ’gekoppelt’ sind, dass das Bewusstsein keinen direkten Einfluss auf die kausal eingekoppelten Irritationen hat, sind diese Irritationen in Form

von Wahrnehmungsereignissen und Erinnertem für das Funktionieren des Bewusstseins wesentlich!

Luhmanns Verwendungsweise des Systembegriffs greift hier einfach zu kurz; er selektiert zu viele wichtige empirische Phänomene im Vorfeld, um seine Verwendungsweise ’passend’ zu machen. Seine Formulierung vom ’Gedächtnis’, ”… [das] nichts anderes [sei] als die Konsistenzprüfung in der jeweils aktuellen Operation, also Aktualisierung ihres jeweils nutzbaren Verweisungszusammenhangs)…” (S.31)

kann man zumindest so verstehen, als dass er weitergehende Funktionen des Gedächtnisses in Abrede stellt. Von der Psychologie wissen wir, dass das Gedächtnis erheblich mehr leistet als eine bloße ’Konsistenzprüfung’. Das Gedächtnis arbeitet kontinuierlich (auch ohne bewusste Anteile), selektiert, abstrahiert, assoziiert, bewertet, bildete Netzwerke, ändert, interpretiert durch ’ist-ein-Exemplar-von-

Struktur X’, und vieles mehr.

In diesen Zusammenhang passen auch die Bemerkungen Luhmanns zum Verhältnis von Sprache und Bewusstsein: ”Man wird vielleicht einwenden, dass das Bewusstsein ’sprachförmig denken’ könne. Gewiss! Aber solches Denken ist keine Kommunikation. Und wenn es für sich alleine läuft, sieht das Ergebnis ungefähr so aus …. Fast nimmt die Eigenproduktion von Worten und Satzstücken dann die Form von … fluktuierenden Wortwahrnehmungen an – befreit von jeder Rücksicht auf Verständlichkeit. Operativ besetzen und reproduzieren Wort- und Satzfetzen dann das Bewusstsein mit der Evidenz ihrer Aktualität, aber nur für den Moment”.(S. 32)

Diese Sätze beziehen ihre ’Wahrheit’ aus der vorausgehenden Selektion, dass die mögliche ’Bedeutung’ von Worten, der ’Sinn’ von Sätzen’ ausschließlich im System ’Kommunikation’ verortet ist (siehe unten im Text). Diese Selektion widerspricht aber nicht nur der Selbsterfahrung jeden Sprechers/ Hörers, sondern auch zahllosen empirischen Untersuchungen. Zwar hat Wittgenstein in seiner späteren Phase alles getan, um die Idee zu kommunizieren, dass die Bedeutung sprachlicher Äußerungen sich ausschließlich durch die Beobachtung der ’Verwendung’ dieser Äußerungen im ’Kontext’ erschließen lasse, aber jede nähere Analyse kann schnell zeigen, dass diese Annahme nur so lange funktioniert, wie man den Begriff ’beobachten’ und den vorausgesetzten ’Beobachter’ mehr oder weniger ’neutralisiert’.

Es ist zwar richtig, dass man die Verwendungsweise von sprachlichen Ausdrücken im Kontext ’beobachten’ kann, aber sobald man zu ergründen versucht, warum ein Sprecher-Hörer ein Umgebungsmerkmal mit einer bestimmten sprachlichen Äußerung verknüpft oder umgekehrt bei Hören einer bestimmten sprachlichen Äußerung auf ein bestimmtes Umgebungsmerkmal verweist, wird man feststellen, dass ohne die Annahme einer entsprechenden ’Kodierung’ dieser Beziehungen zwischen

’Ausdruck’ und ’Umgebungseigenschaften’ (es gibt ja auch Bedeutungsverweise auf Sachverhalte, die nicht in der aktuellen Situation präsent sind!) ’im’ jeweiligen Sprecher-Hörer kein einziges Sprachspiel funktioniert. (Anmerkung: Eine Erfahrung, die die ersten Sprachlernexperimente mit Robotern sehr schnell offen gelegt haben!)

Mit der Annahme der Verortung der fundamentalen Kodierungen von Ausdrücken und Gemeintem ’im’ Beobachter, im Akteur – und zwar primär im Gedächtnis und darüber indirekt im Bewusstsein – ist die Feststellung Luhmanns, dass sowohl ”die Zeichenhaftigkeit der Mitteilung als auch die Information selbst … nicht als Bewusstseinsoperationen in das System, nicht als Wissen eines psychischen

Systems, das vorher da ist, dann in die Kommunikation eingegeben werden…” (vgl.S. 24) dann tendenziell irreführend. Natürlich kann die Kodierung im Bewusstsein (Gedächtnis) als solche nicht in die Kommunikation gelangen, aber das Auftreten von Worten in der Kommunikation setzt die Verfügbarkeit der zugrunde liegenden Kodierungen in den Bewusstseinen (bzw. Gedächtnissen) der beteiligten

Kommunikationsteilnehmer voraus! Das Konzept einer Kommunikation als eigenständiges System, das ohne Rückgriff auf die beteiligten Bewusstseins-Systeme ’Informationen’ transportieren könnte, ist buchstäblich ’haltlos’: die Worte und Wortfolgen als Kommunikationseinheiten funktionieren ’zwischen’ Bewusstseins-System semantisch nur unter simultaner Voraussetzung der individuell verankerten

Kodierungen. Nur unter dieser Voraussetzung ist es verstehbar, dass Kommunikationseinheiten, die gekoppelt ein Bewusstsein irritieren können, dies nicht unspezifisch tun, sondern unter Voraussetzung der semantischen Kodierung aufgrund der Kommunikationseinheiten dann Bedeutungsnetzwerke im angekoppelten Bewusstsein aktivieren, die z.B. im jeweiligen Bewusstsein bestimmte Erwartungen

auslösen können. (siehe dazu S.33)

3) Kommunikation: Obwohl im vorausgehenden Abschnitt verschiedentlich deutlich wurde, dass eine Abgrenzung von ’Bewusstsein’ gegenüber ’Kommunikation’ und umgekehrt im Sinne der Systemtheorie nur bedingt funktioniert, versucht Luhmann dennoch auch die Kommunikation als eigenständiges System zu konzipieren.

Für Luhmann besitzt das System ’Kommunikation’ seine Referenz in der ”Kommunikation im sozialen System der Gesellschaft”(S. 31). Es ist nicht der ’Mensch’, der kommuniziert, sondern ”nur die Kommunikation kann kommunizieren” (S. 31). Die ”Kommunikation ist ein operativ selbständiges System. Die Erzeugung von Kommunikation aus Kommunikation ist ein selbstreferentieller Prozess.”(S.24) ”Jede

Kommunikation erzeugt von Moment zu Moment… eine eigene Nachfolgekommunikation.”( S. 31f) Oder: ”Wenn Kommunikation in Gang kommt, bildet sie ein eigenes autopoietisches System mit eigenen rekursiv vernetzten Operationen, das sich auf die Fähigkeit des Bewusstseins zur Transparenz auf der Grundlage von Intransparenz verlassen kann.”(S. 26)

Diese Formulierungen wirken sehr ’scholastisch’ in dem Sinne, dass hier der Eindruck erweckt wird, als ob es nur darum geht, die formalen Anforderungen einer Systemtheorie zu erfüllen, ohne Rücksicht auf die Phänomene selbst. Zu sagen, dass es nicht der Mensch sei, der kommuniziert, sondern die Kommunikation selbst, klingt formal korrekt, wenn man einen bestimmten Systembegriff voraus setzt, aber berücksichtigt man den zuvor hervorgehobenen Sachverhalt, dass die Kodierung von sprachlichen Ausdrücken mit potentiell ’Gemeintem’ nur jeweils in den beteiligten Bewusstseins-Systemen vorliegen kann, und deswegen auch nur diese mögliche ’Informationen’ der Kommunikation aktualisieren können, dann macht es so recht keinen Sinn, zu sagen, nur die Kommunikation ’kommuniziere’. Das System

’Kommunikation’ erscheint eher als ein ’Sub-System’ der agierenden Bewusstseins-Systeme, die je nach interner Konstellation unterschiedliche Kommunikationselemente aktivieren, deaktivieren, verändern.

Vor diesem Hintergrund macht die Formulierung ”Was als Verstehen erreicht ist, wird daher im Kommunikationsprozess souverän entschieden und als Bedingung fürs Weitermachen bzw. für klärende Zwischenkommunikation markiert….”(S.26) nur Sinn, wenn sowohl das ’Verstehen’ wie auch das ’Entscheiden zum Weitermachen’ im Bewusstseins-System verortet ist. Die Kommunikationselemente als solche bieten keinerlei Anknüpfungspunkte weder für Verstehen noch für Entscheiden.

Es ist dann schon merkwürdig, wenn Luhmann einerseits registriert, dass es bei Kommunikation einen ’Übertragungseffekt’ gibt, der ”System und Umwelt von Moment zu Moment [koordiniert]”, aber es dann als ”eine offene Frage” ansieht, ”wie weit das psychisch gehen muss”. Allerdings schließt er aus, dass diese Koordinierung weder zum ”Bewusstseinsinhalt noch zum Mitteilungsinhalt” wird.(vgl.S.27) Würde Luhmann die empirische Verankerung der semantischen Kodierung in den beteiligten

Kommunikationsteilnehmern akzeptieren, dann wäre klar, dass Kommunikationsereignisse über die strukturelle Kopplung bewusstseinsrelevant werden würden, sie würden im einzelnen Bewusstsein als ’Mitteilung’ dekodiert.

Durch die Strategie der Ausklammerung des individuellen Bewusstseins aus dem Kommunikationsprozess reißt Luhmann mutwillig eine Lücke auf; plötzlich gibt es keinen wirklichen Adressaten mehr in der Kommunikation. Luhmann versucht dieses ’Loch’ dadurch zu ’stopfen’, dass er den alten ’Persona’-Begriff für seine Zwecke reaktiviert: ”Personen können Adressen für Kommunikation sein… Sie können als Aufzeichnungsstellen vorausgesetzt werden…als Zurechnungspunkte für Kausalannahmen…All das … ohne jede determinierende Auswirkung auf Bewusstseinsprozesse.”(S. 34)

Immerhin denkt Luhmann sein formales System-Konzept auf seine Weise konsequent.

Abgekoppelt vom System Bewusstsein stellt sich die Frage, was denn dann Kommunikation überhaupt noch ’tut’. Luhmann bezieht eine klare Position: ”Jenseits der psychischen Systeme differenziert und synthetisiert Kommunikation ihre eigenen Komponenten ’Information’, ’Mitteilung’ und ’Verstehen’.”(S.24) ”Die Mitteilung wird als ’Zeichen’ für eine ’Information’ genommen.”(S. 24) ”Mitteilung und Kommunikation

werden in der Kommunikation ’aufgebaut’, ’abgebaut’, ’aktualisiert’, evtl. ’aufgezeichnet’, ’evtl. erneut ’thematisiert’.(S.24)

Unterstellt man, dass Luhmann mit ’Mitteilung’ die Ausdruckselemente (einer Sprache) sieht, mittels deren Kommunikation ’realisiert’ wird, und mittels denen dann auf eine mögliche ’Information’ ’hingewiesen’ wird, die dann wiederum ein ’Verstehen’ implizieren können, dann verheddert sich diese Interpretation wieder mit den empirischen Fakten einer im Bewusstsein-System verorteten semantischen Kodierung (Anmerkung: Luhmann verwendet an dieser Stelle den Begriff ’Information’ völlig losgelöst von Shannon (1948) [Sha48]. Er stellt aber auch nicht sicher, wie er die ‚Referenz‘ seines Begriffs ‚Information‘ sieht.).

In diesem Zusammenhang ist auch die Feststellung von Luhmann ”Die Kommunikation teilt die Welt nicht mit, sie teilt sie ein in das, was sie mitteilt und das, was sie nicht mitteilt” (S.27) formal korrekt für seine Systemannahmen, aber mit Blick auf die Empirie und ein Systemkonzept, was die semantische Kodierung berücksichtigt, eher fragwürdig. Die ’Kommunikation’ ist für Bewusstseins-Systeme mit semantischer

Kodierung nur eine ’für sich genommen’ bedeutungslose Ereigniskette, deren Elementgrenzen nur dann und insoweit etwas ’bedeuten’, als sie durch Verbindung mit einer semantischen Kodierung virtualisierte Weltbezüge aktivieren und durch die Art ihrer Anordnung diese virtualisierten Weltbezüge ’einteilen’ und ’anordnen’. Da die individuellen semantischen Kodierungen untereinander variieren können, kann der

gleiche Strom von Kommunikationsereignissen bei den Beteiligten ganz unterschiedliche Reaktionen auslösen.

QUELLEN

- [Bro72] G.Spencer Brown. Laws of Form. The Julian Press, Inc., New York, 1 edition, 1972. Originally published London, 1969).

- [Luh91] Niklas Luhmann. Die Wissenschaft der Gesellschaft. Suhrkamp, Frankfurt, 2 edition, 1991.

- [Sha48] C.E. Shannon. A mathematical theory of communication. The Bell System Technical Journal, 27:379–423, 623–656,

1948. July and October 1948.

- [Whi10] Randall Whitaker. THE OBSERVER WEB: Autopoiesis and Enaction. The Biology of Cognition, Autopoietic Theory, and Enactive Cognitive Science. The Theories of Humberto Maturana and Francisco Varela. Dr. Randall Whitaker, 1 edition,

2010.

KONTEXT BLOG

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER