Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 16.Februar 2021

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Letzte Änerung: 26.2.2021 (Anmerkung zum Begriff ‚Alltagssprache‘ ergänzt)

KONTEXT

In diesem Beitrag soll das Konzept einer praktischen kollektiven Mensch-Maschine Intelligenz by design weiter entwickelt werden. Im unmittelbar vorher gehenden Beitrag wurde die grundlegende Problemstellung sowie die gewählte (Zukunfts-)Vision in einer ersten Annäherung umrissen. In diesem Text geht es jetzt darum, etwas konkreter zu skizzieren, wie diese (Zukunfts-)Vision aussehen könnte bzw. sollte.

Bisher zum Thema veröffentlicht:

- 15.02., 09:21 PRAKTISCHE KOLLEKTIVE MENSCH-MASCHINE INTELLIGENZ by design. Problem und Vision

- 12.02., 18:14 PRAKTISCHE KOLLEKTIVE MENSCH-MASCHINE INTELLIGENZ by design

MMI ANALYSE – AUSGANGSPUNKT

Der Ausgangspunkt der MMI-Analyse ist gegeben durch die ersten Angaben zur Zukunfts-Vision (Siehe Schlussabschnitt in [1]). Diese Vision umschreibt mit wenigen Worten, welcher Zustand in der Zukunft angezielt wird. Die Vision selbst sagt nichts zur Begründung, nichts zu den Motiven; diese werden vorausgesetzt. Die Vision beschreibt nur, was sein soll.

Beliebige Menschen spielen Zukunft

Zentraler Gedanke ist, dass eine beliebige Gruppe von Menschen auf eine eher spielerische Weise dabei unterstützt werden soll, für eine selbst gewählte Problemstellung und ein selbst gewähltes Ziel schrittweise einen Lösungsweg zu konstruieren.

Ein Drehbuch schreiben

Diese Konstruktion eines Lösungsweges ist vergleichbar mit dem Schreiben eines Drehbuchs in einer Alltagssprache, die alle Beteiligten hinreichend beherrschen.[2] Dies setzt voraus, dass der Prozess der Wirklichkeit — vereinfachend — gedacht wird als eine Folge von Situationen (oder auch Zuständen), in der eine Nachfolgesituation S‘ aus einer vorausgehenden Situation S durch das Stattfinden von mindestens einer beobachtbaren Veränderung hervorgegangen ist. Im Grenzfall ist es nur die Veränderung einer Uhr, deren Zeitanzeigen in der Nachfolgesituation S‘ ‚größer‘ sind als in der Situation S.[3] Im Kontext einer Folge von beschreibbaren Situationen kann man die Veränderungen in der Form von Veränderungs-Regeln fassen: Man sagt: wenn die Bedingung C in einer aktuellen Situation S erfüllt ist, dann sollen mit der Wahrscheinlichkeit π die Aussagen Eplus der Situation S hinzugefügt werden, um die Nachfolgesituation S‘ zu generieren, und die Aussagen Eminus sollen von S weggenommen werden, um die Nachfolgesituation S‘ zu generieren.

Bezug zu einer Situation

Diese Redeweise setzt voraus, dass davon ausgegangen wird, dass der Text des Drehbuchs sich auf eine reale Situation S bezieht, und die einzelnen Ausdrücke des Textes Eigenschaften der realen Situation beschreiben. Die Menge der Ausdrücke in einem Drehbuch, die sich auf eine bestimmte Situation S beziehen, bilden also Repräsentanten von realen Eigenschaften der vorausgesetzten realen Situation. Verändert sich die vorausgesetzte Situation in ihren beobachtbaren Eigenschaften, dann drückt sich dies darin aus, dass sich auch die Ausdrücke im Drehbuch verändern müssen: kommen neue Eigenschaften hinzu, müssen neue Ausdrücke hinzu kommen. Verschwinden Eigenschaften, dann müssen die entsprechenden Ausdrücke verschwinden. Wechselt also z.B. die Verkehrsampel von Rot auf Orange, dann muss z.B. der Ausdruck ‚Die Ampel ist rot‘ ersetzt werden durch die Aussage ‚Die Ampel ist orange‘. Dann wäre die Menge Eminus = {Die Ampel ist rot}, und die Menge Eplus = {Die Ampel ist orange}.

Das Drehbuch hat zwei Teile …

Das Drehbuch für die gemeinsame spielerische Planung einer gewünschten Zukunft besteht also mindestens aus zwei Teilen:

- Einer Ausgangssituation S, von der aus man starten will, und

- einer Menge von Veränderungsregeln X, die sagen, wann man eine gegebene Situation in welcher Weise abändern darf.

Vergleich mit einem Spiel

Diese Konstellation kann man ohne weiteres mit einem Spiel vergleichen:

- Es gibt die Startsituation (z.B. ein bestimmtes Spielbrett oder eine Spielfeld mit Spielobjekten und Spielern)

- Es gibt vereinbarte Spielregeln, anhand deren man in einer gegebenen Situation etwas tun darf.

Regeln jederzeit abändern

In dem hier angenommenen Szenario eines Drehbuchs für die gemeinsame spielerische Planung einer gewünschten Zukunft gibt es allerdings zwei Besonderheiten: Die eine besteht darin, dass die Ausgangslage und die Spielregeln von den Spielern selbst aufgestellt werden und jederzeit nach Absprache geändert werden können.

Leitbild Zukunft als Maßstab

Die andere Besonderheit resultiert aus der Tatsache, dass die Teilnehmer hier zu Beginn auch explizit ein Leitbild für die Zukunft formulieren. Dieses kann zwar auch jederzeit nach Absprache wieder abgeändert werden, so lange es aber gilt, dient dieses Leitbild als Maßstab für die Beurteilung, ob und in welchem Umfang der Prozess der fortschreitenden Veränderung ( = der Spielprozess!) das zuvor vereinbarte Leitbild erreicht hat.

In gewisser Weise entspricht die Bewertung einer Situation anhand eines vereinbarten Leitbildes dem Konzept des ‚Gewinnens‘ in normalen Spielen: beim Gewinnen wird in einem Spiel ein Zustand erreicht, der sich anhand zuvor vereinbarter Kriterien als ‚Gewinnsituation‚ für mindestens einen beteiligten Spieler klassifizieren lässt. Man sagt dann, dass dieser Spieler ‚gewonnen‘ hat.

Bei der Verwendung des Konzepts einer Zukunftsvision als Leitbild kann man das Leitbild dazu benutzen, um eine beliebige Situation dahingehend zu klassifizieren, ob und wenn ja in welchem Umfang diese Situation dem Leitbild ‚entspricht‘. Explizite Zukunftsbilder ermöglichen also die ‚Bewertung‘ einer Situation. Ohne solch eine Möglichkeit wäre jede Situation gleichwertig mit jeder anderen Situation. Es wäre dann nicht möglich, eine ‚Richtung‘ für einen Prozess zu definieren.

ALLTAGSSPRACHE

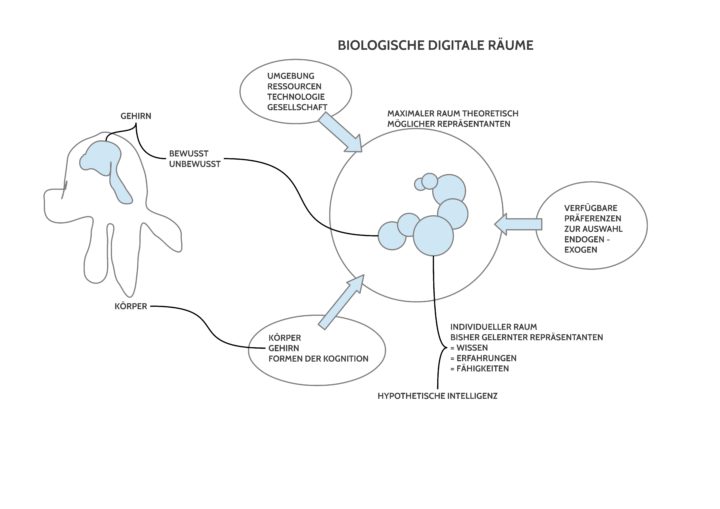

Diejenige Sprache, die jeder Mensch von Kindheit an lernt und benutzt, das ist die Alltagssprache, also die Sprache, die jeder in seinem Alltag spricht und die — normalerweise — auch von den Mitmenschen benutzt wird. [5a] Durch das Voranschreiten einer Globalisierung und der damit einhergehenden Vermischung von Alltagswelten, vermengen sich verschiedene Sprachen, was bei einzelnen zur Mehrsprachigkeit führt, auf der anderen Seite zur Zunahme von Übersetzungen. Übersetzungen durch Menschen können vergleichsweise ‚gut‘ sein (wer kann dies eigentlich überprüfen?), die heute zunehmenden Angebote von computerbasierten Übersetzungen sind aber dennoch auf dem Vormarsch, weil man ihren Einsatz sehr leicht ’skalieren‘ kann: ein Programm kann viele Millionen Menschen gleichzeitig ‚bedienen‘, dazu eher ‚einheitlich‘, und solch ein maschinelles Übersetzungsprogramm kann — wie salopp gesagt wird — ‚lernen‘.[4] Die Gesamtheit dieser maschinellen Verfahren hat aber dennoch keinen Zugang zu den eigentlichen Bedeutungsfunktionen von Alltagssprache, die in den Gehirnen der Sprecher-Hörer verortet sind. [5]

Aufgrund dieser Sachlage soll das neue Verfahren die Vorteile und Nachteile der verschiedenen Möglichkeiten auf neue Weise optimal verknüpfen. Primär soll der Anwender seine Alltagssprache — und zwar jede — voll benutzen können.

Zur Alltagssprache gehören mehrere ‚Mechanismen‘ [6], die es zulassen, dass man sie beliebig erweitern kann, und auch, dass man in der Alltagssprache über die Alltagssprache sprechen kann.[7] Diese Eigenschaften machen die Alltagssprache zu den stärksten Ausdruckssystemen, die wir kennen.[8]

Zu den möglichen — und vorgesehenen — Erweiterungen der Alltagssprache gehören z.B. beliebige Parametermengen mit zugehörigen Operationen auf diesen Parametern. Ein ‚Parameter‘ wird hier verstanden als ein Name, dem irgendein Wert (z.B. ein numerischer Wert) zugeordnet sein kann (z.B. eine Einwohnerzahl, ein finanzieller Betrag, ein Temperaturwert …). Parameter mit numerischen Werten kann man z.B. Addieren, Subtrahieren, Multiplizieren usw.

Zum Sprechen über andere Ausdrücke gehört die Möglichkeit, dass man beliebige Abstraktionen bilden kann. Schon wenn wir über sogenannte normale Gegenstände sprechen wie ‚Stuhl‘, ‚Tasse‘, ‚Tisch‘, ‚Hund‘ usw. benutzen wir sprachliche Ausdrücke, die nicht für ein einzelnes Objekt stehen, sondern für ganze Mengen von konkreten Dingen, die wir alle gelernt haben, als ‚Stuhl‘, ‚Tasse‘, ‚Tisch‘, ‚Hund‘ usw. zu bezeichnen. Auf einem Tisch können bei mehreren Personen beim Frühstück ganz viele Gegenstände stehen, die wir alle als ‚Tasse‘ bezeichnen würden, obwohl sie sich u.a. durch Form, Farbe und Material unterscheiden.[9]

SIMULATION

Normale Formen von Drehbüchern bestimmen das Geschehen auf der Bühne oder in einem Film. Auf der Bühne beginnt man mit einer Eingangsszene, in der unterschiedliche Akteure in einer bestimmten Umgebung (Situation) anfangen, zu handeln, und durch das Handeln werden Veränderungen bewirkt: in den Akteuren (meist nicht so fort direkt sichtbar, aber dann in den Reaktionen), in der räumlichen Anordnung der Dinge, in der Beleuchtung, in Begleitgeräuschen, … Im Film ist es die Abfolge der Bilder und deren Füllungen.

Im Fall von Brettspielen fangen die beteiligten Spieler an, mit Blick auf erlaubte Regeln, den aktuellen Spielstand und die möglichen Gewinnsituationen in der Zukunft zu handeln. Dieses Handeln bewirkt eine schrittweise Änderung der jeweils aktuellen Spielsituation.

In abgewandelter Form passiert in einem Krimi oder in einem Roman nichts anderes: literarisch begabte Menschen benutzen das Mittel der Alltagssprache um Situationen zu beschreiben, die sich schrittweise durch Ereignisse oder das Verhalten von Menschen ändern. Noch eine Variante stellt die Gattung Hörspiel dar: statt eine Geschichte zu lesen hört man beim Hörspiel zu und lässt sich mit hinein nehmen in ein Geschehen, das sich von Situation zu Situation fortbewegt und den Hörer — wenn er sich angesprochen fühlt — geradezu mitreißen kann.

In der vorliegenden Anwendung gibt es alle Zutaten — Gegenwart, Zukunft, mögliche Maßnahmen –, aber wie kommt es hier zu einer Abfolge von Situationen?

Im einfachsten Fall setzten sich die Autoren der Texte zusammen und prüfen durch eigene Lektüre der Texte und Regeln, welche der Regeln aktuell angewendet werden könnten und sie wenden die Regeln an. Auch so würde eine Folge von Texten entstehen, wobei jeder Text eine Situation beschreibt. Erst die Start-Situation, dann die Anwendung von passenden Regeln, die zu einer Veränderung des Textes führt und damit zu einer neuen Situation.

Wir wissen von uns Menschen, dass wir dies im Alltag können (z.B. jeder Heimwerker — oder auch Hobby-Bastler — benutzt eine Bauanleitung, um aus den Einzelteilen des Bausatzes schrittweise ein komplexes Gebilde zusammen zu bauen). Wenn die Texte umfangreicher werden und wenn die Zahl der Regeln deutlich zunimmt, dann kommt man mit dieser händischen (manuellen) Methode bald an praktische Grenzen. In diesem Moment wäre es sehr schön, man könnte sich helfen lassen.

Viele Menschen benutzen heutzutage zum Schreiben von Texten, zum Rechnen, zum Malen, zum Komponieren, den Computer, obwohl es ja eigentlich auch ohne den Computer gehen würde. Aber mit einem Rechenblatt viele Rechnungen miteinander zu verknüpfen und dann ausrechnen zu lassen ist einfach bequemer und — in den komplexen Fällen — sogar die einzige Möglichkeit, die Arbeit überhaupt zu verrichten. Computer müssen nichts verstehen, um Zeichenketten bearbeiten zu können.

Diese formale Fähigkeit eines Computers soll für diese Anwendung genutzt werden: wenn ich die Text-Version einer Situation habe wie z.B. S1 = {Das Feuer ist fast erloschen.} und ich habe eine Veränderungsregel der Art: X1 = {Wenn C1 zutrifft dann füge Eplus1 dazu und nehme Eminus1 weg}, konkret C1 = {Das Feuer ist fast erloschen.}, Eplus1 = {Lege Holz nach.}, Eminus1 = {Leer}, dann ist es für einen Computer ein leichtes festzustellen, dass die Bedingung C1 in der aktuellen Situation S1 erfüllt ist und dass daher die Aussage Lege Holz nach. hinzugefügt werden soll zu S1, was zur neuen Situation S2 führt: S2 = {Das Feuer ist fast erloschen. Lege Holz nach.} Wenn es jetzt noch die Regel geben würde X2 mit C2 = {Lege Holz nach.}, Eplus2 ={Das Feuer brennt.}, Eminus2={Das Feuer ist fast erloschen.}, dann könnte der Computer ‚ohne Nachzudenken‘ die nächste Situation S3 erzeugen mit S3 = {Das Feuer brennt.}

Dieses einfache Beispiel demonstriert das Prinzip einer Simulation: man hat eine Ausgangssituation S0, man hat eine Menge von Veränderungsregeln im oben angedeuteten Format X= Wenn C in S erfüllt ist, dann füge Epluszu S dazu und nimm Eminus von S weg, und man hat einen Akteur, der die Veränderungsregeln auf eine gegebene Situation anwenden kann. Und diese Anwendung von Regeln erfolgt so oft, bis entweder keine Regeln mehr anwendbar sind oder irgendein Stopp-Kriterium erfüllt wird.

Schreibt man für den Ausdruck Die Menge der Veränderungsregeln X wird auf eine Situation S angewendet, was zur Nachfolgesituation S‘ führt verkürzend als: X(S)=S‘, ergibt die wiederholte Anwendung von X eine Serie der Art: X(S)= S‘, X(S‘)= S“, …, X(Sn-1)= Sn. Dies bedeutet, dass die Folge der Text-Zustände <S‘, S“, …, Sn> einen Simulationsverlauf repräsentieren. Man kann dann sehr gut erkennen, was passiert, wenn man bestimmte Regeln immer wieder anwendet.

In der vorliegenden Anwendung sollen solche durch Computer unterstützte Simulationen möglich sein, tatsächlich sogar noch mit einigen weiteren Feinheiten, die später näher beschrieben werden.

SIMULATION MIT BEWERTUNG

Wie zuvor schon im Text beschrieben wurde, kann man eine gegebene Situation S immer dann klassifizieren als erfüllt Eigenschaft K, wenn man über geeignete Kriterien K verfügt. In der vorliegenden Anwendung kann der Anwender eine Vision formulieren, eine Beschreibung, welcher Zustand in der Zukunft eintreten sollte.

Im Rahmen der Simulation soll es daher möglich sein, dass nach jeder Anwendung von Veränderungsregeln X mitgeteilt wird, in welchem Ausmaß die vorgegebene Vision V im aktuellen Zustand S eines Simulationsverlaufs schon enthalten ist. Die Aussagekraft einer solchen Klassifikation, die eine Form von Bewertung darstellt, hängt direkt von der Differenziertheit der Vision ab: je umfangreicher und detaillierter der Text der Vision ist, um so konkreter und spezifischer kann die Bewertung vorgenommen werden.

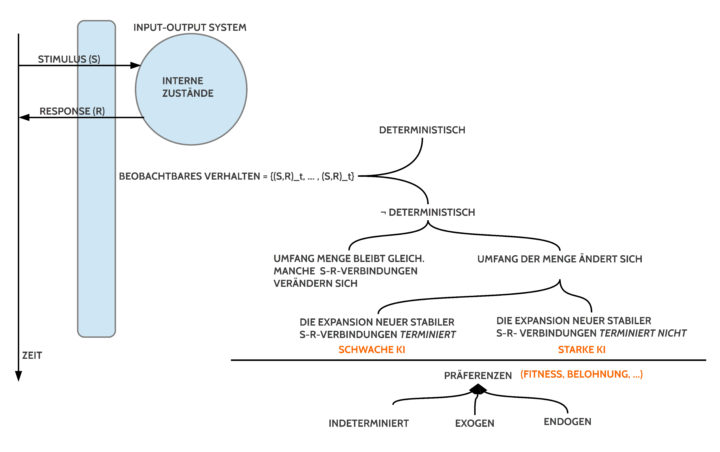

LERNFÄHIGE ALGORITHMEN (KI)

So, wie im Fall der Simulation der Computer dem Menschen bei ausufernden manuellen Tätigkeiten helfen kann, diese zu übernehmen, so ergibt sich auch für die Frage der Auswertung eines Simulationsverlaufs sehr schnell die Frage: könnte man auch ganz andere Simulationsverläufe bekommen, und welche von den vielen anderen sind eigentlich im Sinne eines vorgegebenen Zielkriteriums besser?

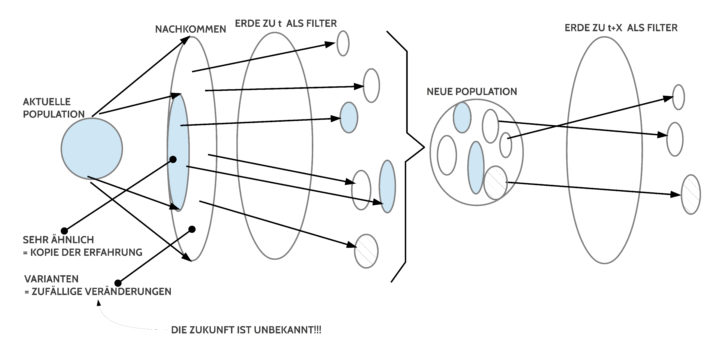

Tatsächlich haben wir es mit dem Ensemble einer Anfangssituation, einer Zukunftsvision und einer Menge von Veränderungsregeln mit einem Problemraum zu tun, der sehr schnell sehr umfangreich sein kann. Eine einzelne Simulation liefert immer nur einen einzigen Simulationsverlauf. Tatsächlich lässt der Problemraum aber viele verschiedene Simulationsverläufe zu. In den meisten Fällen ist eine Erkundung des Problemraumes und das Auffinden von interessanten Simulationsverläufen von großem Interesse. Der Übergang von einem Suchprozess zu einem lernenden Prozess ist fließend.

In der vorliegenden Anwendung soll von der Möglichkeit einer computergestützten lernende Suche Gebrauch gemacht werden.

QUELLENANGABEN und ANMERKUNGEN

[1] Siehe dazu den Schluss des Textes von Gerd Doeben-Henisch, 15.2.2021, PRAKTISCHE KOLLEKTIVE MENSCH-MASCHINE INTELLIGENZ by design. Problem und Vision, https://www.cognitiveagent.org/2021/02/15/praktische-kollektive-mensch-maschine-intelligenz-by-design-problem-und-vision/https://www.cognitiveagent.org/2021/02/15/praktische-kollektive-mensch-maschine-intelligenz-by-design-problem-und-vision/

[2] Denkbar ist natürlich, dass partiell mit Übersetzungen gearbeitet werden muss.

[3] Dieses Modell der Zerlegung der Wirklichkeit in Zeitscheiben entspricht der Arbeitsweise, wie das menschliche Gehirn die jeweils aktuellen sensorischen Signale für ein bestimmtes Zeitintervall ‚zwischen-puffert‘, um die Gesamtheit der Signale aus diesem Zeitintervall dann nach bestimmten Kriterien als eine Form von Gegenwart abzuspeichern und daraus dann Vergangenheit zu machen.

[4] Damit dies möglich ist, landen alle Texte auf einem zentralen Server, der mit statistischen Methoden ganze Texte nach Methoden des sogenannten ‚maschinellen Lernens‘ analysiert, statistische Verwendungskontexte von Ausdrücken erstellt, angereichert durch diverse sekundäre Zusatzinformationen.

[5] Was diese bedingt lernfähigen Algorithmen an Übersetzungsleistungen ermöglichen, ist sehr wohl erstaunlich, aber es ist prinzipiell begrenzt. Eine vertiefte Analyse dieser prinzipiellen Begrenzungen führt in die Entstehungszeit der modernen formalen Logik, der modernen Mathematik sowie in die theoretischen Grundlagen der Informatik, die letztlich ein Abfallprodukt der Meta-logischen Diskussion in der Zeit von ca. 1900 bis 1940 ist. Wenn also die angezielte Anwendung die volle Breite der Alltagssprache nutzen können soll, dann reicht es nicht, die prinzipiell Bedeutungsfernen Verfahren der Informatik wie bisher einzusetzen.

[5a] Das Phänomen ‚Alltagssprache‘ ist bei näherer Betrachtung äußerst komplex. In einem anderen Beitrag habe ich einige der grundlegenden Aspekte versucht, deutlich zu machen: Gerd Doeben-Henisch, 29.Januar 2021, SPRACHSPIEL und SPRACHLOGIK – Skizze. Teil 1, https://www.cognitiveagent.org/2021/01/29/sprachspiel-und-sprachlogik-skizze-teil-1/

[6] … von denen die formale Logik nicht einmal träumen kann.

[7] In der formalen Logik sind Spracherweiterungen im vollen Sinne nicht möglich, da jede echte Erweiterung das System ändern würde. Möglich sind nur definitorische Erweiterungen, die letztlich Abkürzungen für schon Vorhandenes darstellen. Das Sprechen in einer gegebenen Sprache L über Elemente der Sprache L — also meta-sprachliches Sprechen –, ist nicht erlaubt. Aufgrund dieser Einschränkung konnte Goedel seinen berühmten Beweis von der Unmöglichkeit führen, dass ein formales System sowohl Vollständig als auch Widerspruchsfrei ist. Dies ist der Preis, den formale Systeme dafür zahlen, dass ’nichts falsch machen können‘ (abgesehen davon, dass sie von sich aus sowieso über keine Bedeutungsdimension verfügen)).

[8] Während formale Systeme — und Computer, die nach diesen Prinzipien arbeiten — durch diese Elemente inkonsistent und un-berechenbar werden, kann das menschliche Gehirn damit fast mühelos umgehen!

[9] Unser Gehirn arbeitet schon immer mit beliebigen Abstraktionen auf beliebigen Ebenen.

FORTSETZUNG

Eine Fortsetzung findet sich HIER.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.