Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 13.-15.Februar 2021

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Letzte Korrekturen: 16.Februar 2021, 14:40h

KONTEXT

In diesem Beitrag soll das Konzept einer praktischen kollektiven Mensch-Maschine Intelligenz by design, das im vorausgehenden Beitrag grob vorgestellt worden ist, weiter konkretisiert werden. In diesem Text geht es um eine erste Beschreibung der auslösenden Problemstellung und einem möglichen Zukunftskonzept.

Bisher zum Thema veröffentlicht:

PROBLEMSTELLUNG

Die Problemstellung, die hier beschrieben wird, wird so knapp wie möglich gehalten.

Eine ausführliche Beschreibung könnte sehr schnell viele hundert Seiten umfassen, da es bei dem Problem um nichts weniger als um uns selbst geht, um unsere Situation als Menschen in einem Alltag; hier primär um einen Alltag in der Bundesrepublik Deutschland. Doch da es um das generelle Problem geht, wie beliebige Menschen weltweit — wenn sie denn wollen — gemeinsam ihr Wissen, ihre Erfahrungen, ihre Motive so austauschen, dass dabei ihre Gegenwart mit identifizierten Problemen vorkommt, mögliche Zielvorstellungen, wie es denn besser sein könnte, mögliche Maßnahmen, wie man die Gegenwart schrittweise ändern könnte, geht es nicht nur um Deutschland, nicht nur um Europa, sondern um die ganze Menschheit. Auf diesem Planet Erde zu überleben ist schon jetzt nur noch möglich, wenn alles positiv-konstruktiv zusammenspielt; Nachhaltigkeit ist hier keine ‚Modewort‘ sondern knallharte Realität: entweder wir lösen das Problem gemeinsam oder wir werden gemeinsam untergehen.

Es macht daher Sinn, mit möglichst wenig, möglichst einfach, anzufangen, um die Problembeschreibung dann schrittweise auszuweiten.

DER MENSCH SELBST

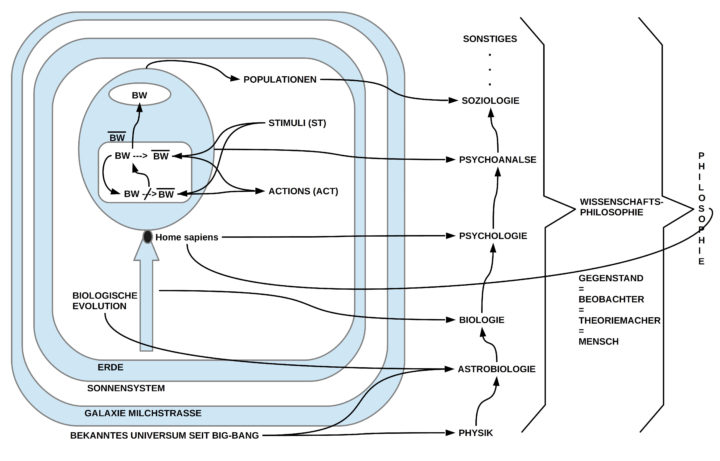

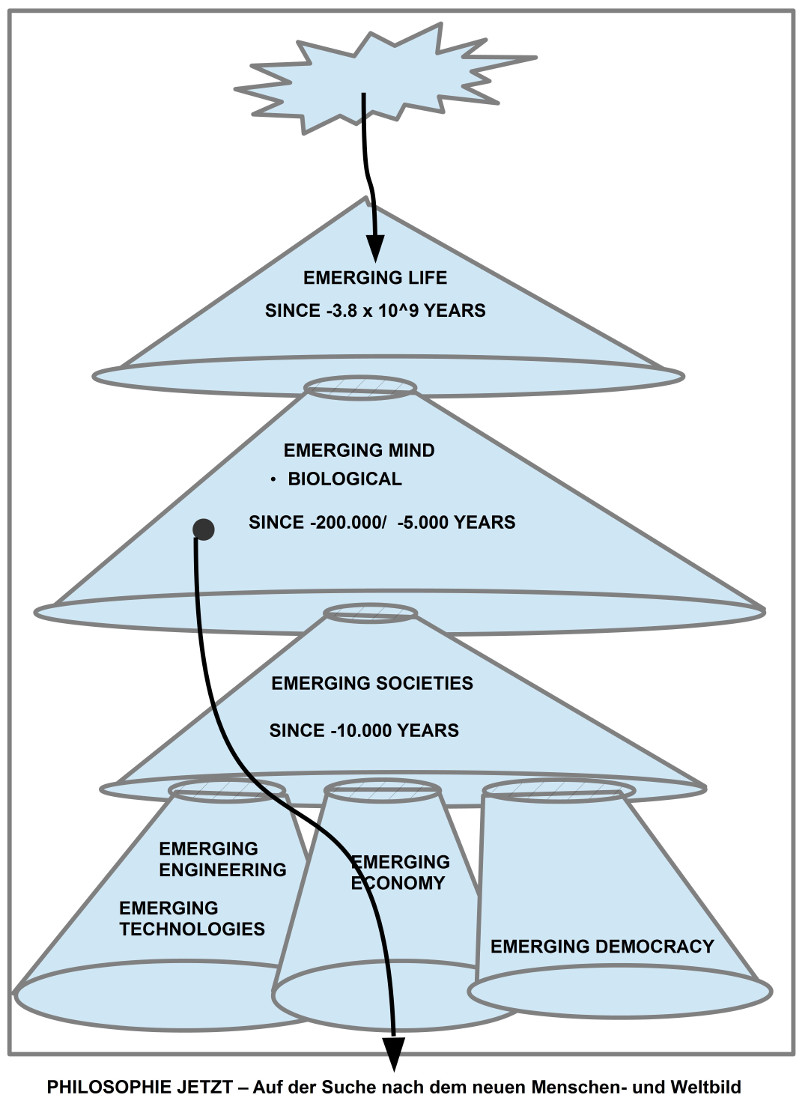

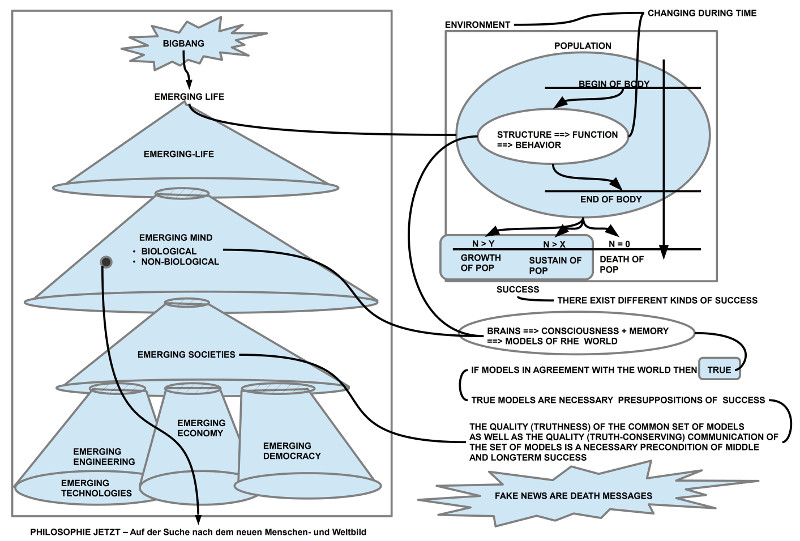

Der primäre Ansatzpunkt der Problemstellung ist der Mensch selbst, Wir, die Lebensform des homo sapiens. Die biologische Evolution hat dem homo sapiens mindestens zwei Eigenschaften mitgegeben, die ihm eine besondere Rolle — und damit auch eine besondere Verantwortung ? — zukommen lässt (für weitere Erläuterungen zu den folgenden Gedanken siehe z.B. [1] und [2]):

Außen nach Innen

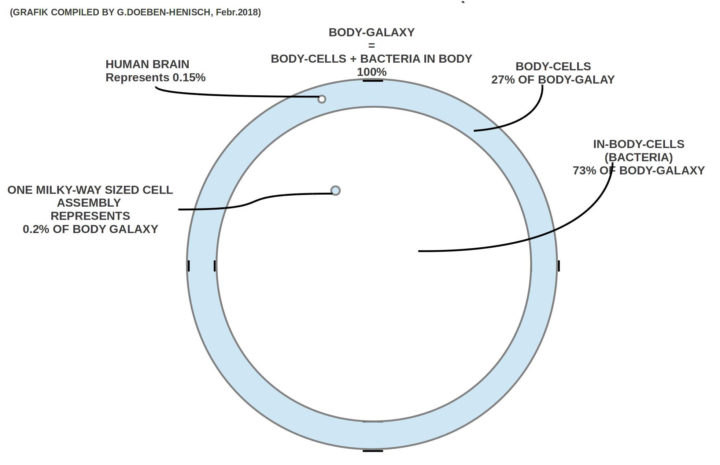

(i) Ein einzelner homo sapiens ist so gebaut, dass er automatisch die Realität der Außenwelt in die Realität seiner Gehirnzustände verwandelt, und innerhalb dieser realen Gehirnzustände real-virtuelle Signalzustände erzeugt, die speziell und partiell Eigenschaften der realen Welt außerhalb des Gehirns (einschließlich des Gehirns selbst) in real-virtuelle Zustände innerhalb des Gehirns verwandelt. Diese internen virtuellen Zustände sind partiell das, was wir subjektiv als Welt erleben (der größte Teil der neuronalen Zustände ist unbewusst). Zwischen der auslösenden realen Welt und der internen virtuellen Welt kann es große Unterschiede geben.

Ausdruckssysteme

(ii) Zusätzlich verfügt der homo sapiens über die Eigenschaft und Fähigkeit, auch intern, virtuell, ein eigenes Ausdruckssystem zu entwickeln, das über Lernprozesse mit sehr vielen (wie vielen?) Aspekten der internen virtuellen Welt verknüpft werden kann. Durch eine Übersetzung des internen Ausdruckssystem in äußerliche, reale Ereignisse (Laute, Gesten, Schriftzeichen,…) kann das eine Gehirn unter bestimmten Bedingungen mit einem anderen Gehirn eine Interaktion aufbauen, die zu einer Kommunikation führen kann: Laute erzeugt von einem Gehirn A können Bezug nehmen auf interne Zustände des Gehirns A und — unter speziellen Bedingungen — können diese Laute in einem anderen Gehirn B auf seine eigenen internen Zustände bezogen werden. Es fragt sich nur: auf welche? Die Koordinierung der Zuordnung in zwei verschiedenen Gehirnen ist eine spezifische Lernleistung und Teil einer Lebenswelt, einer Kultur. Erfahrungsgemäß ist eine Koordinierung am einfachsten und stabilsten, wenn verschiedene Gehirne sich auf ein Ereignis in der realen Außenwelt beziehen (‚es regnet‘), das bei allen Beteiligten interne Prozesse auslöst. Ähnlich gut, wenngleich nicht ganz so eindeutig, sind Ereignisse im realen Körper, sofern die Körper eine hinreichend ähnliche Struktur untereinander aufweisen (‚Ich sehe dort ein Licht‘, ‚Zahnschmerzen‘, ‚Ellbogen gestoßen‘, …). Schwieriger bis ganz schwierig wird es bei subjektiven Ereignissen und Prozessen wie verschiedene Emotionen, Gefühle, Stimmungen, Ängste, Überlegungen usw. Diese sind einem anderen Gehirn prinzipiell verschlossen, es sei denn …

Als einzige Lebensform auf dem Planet Erde — und vielleicht im gesamten bekannten Universum — verfügt die Lebensform des homo sapiens über diese einzigartige Fähigkeiten.[4] Die Geschichte des homo sapiens zeigt — soweit sie anhand von Artefakten rekonstruierbar ist –, dass der homo sapiens zu Kooperationsleistungen fähig war, die schrittweise zu hochkomplexen Siedlungsformen, Technologien, kulturellen Mustern und Wissensformen geführt haben, wie wir sie heute kennen.

ÜBER-INDIVIDUELLE KOMPLEXITÄT

Kooperation durch Kommunikation verweist aus sich heraus aber auch auf einen Umstand, der für die Lebensform des homo sapiens heute zu einem eigenen Problem geworden zu sein scheint. Kooperation kann reale und gedachte Zusammenhänge hervorbringen, die die Perspektive des einzelnen soweit übersteigen, dass der einzelne sich angesichts der gemeinsam hervorgebrachten Leistung nicht nur stolz über die gemeinsam erbrachte Leistung fühlen kann (‚Ja, zusammen können wir ganz viel.‘), sondern ihn auch überfordert. Ich habe diese Form der Überforderung früher als Negative Komplexität bezeichnet [5a,b]: Wenn die für eine bestimmte Lebensform typischen Signale seiner spezifischen Umwelt [6] zahlenmäßig die Verarbeitungskapazitäten des Gehirns wesentlich übersteigen, dann wird die Menge der Lebensform-typischen Informationen in einer Weise größer, dass diese überschießende Menge nicht mehr positiv zur Lebensführung beiträgt, sondern mehr und mehr unbewältigt ist und die Lebensführung dadurch stark negativ beeinflusst werden kann.

Viele einzelne Menschen können zusammen, im Verbund, Landwirtschaft betreiben, große Häuser bauen, Verkehrssystem ermöglichen, viele Hunderttausend Bücher schreiben, aber der einzelne versteht heute immer weniger von dem Zusammenhang, wie das Ganze genau funktioniert [7], und bei vielen Hunderttausend Büchern ist völlig klar, dass das kumulierte Wissen von einem einzelnen nicht mehr rezipiert werden kann. Durch Computer, Internet, und Datenbanken ist die Ereignismenge weiter angeschwollen und macht jeden Experten zu einem Dummkopf, der nichts mehr versteht, weil das individuelle Gehirn, diese Wunderwerk der Evolution, mit seinen endlichen Möglichkeiten, mit diesen Quantitäten einfach nicht mithalten kann.[3] Ein einzelnes menschliches Gehirn ist ein unfassbarer Hotspot von Freiheit und potentieller Zukunft, aber für eine Kommunikation und Koordination mit vielen Milliarden Menschen, in der es real um Verstehen geht, nicht einfach nur Dabei sein, ist es nicht geschaffen. Die hervorgebrachte Komplexität überfordert aktuell ihre Hervorbringer.

Diese Situation markiert den Kern des Problems, um das es hier gehen soll.

VISION: MÖGLICHE LÖSUNG?

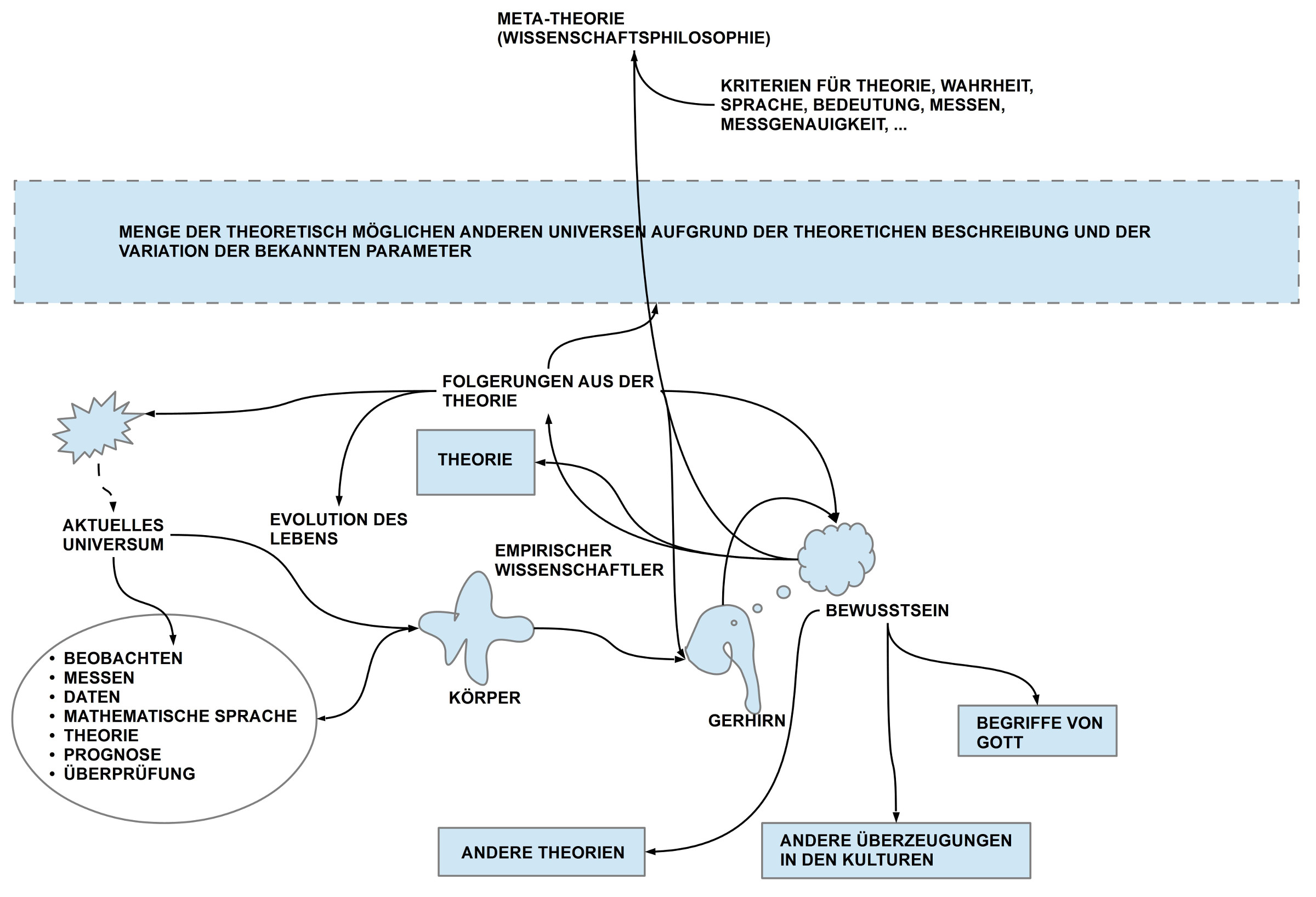

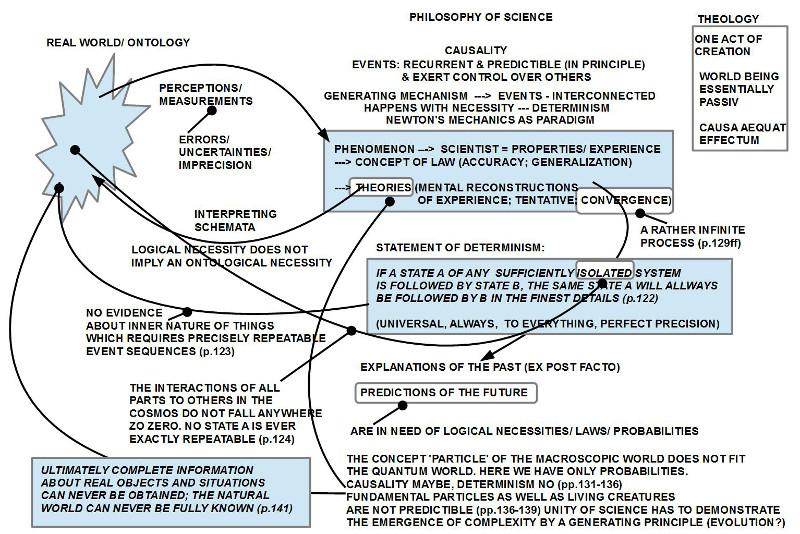

Wenn man in der Gegenwart eine Konstellation von Sachverhalten erkennt, die man als ein Problem klassifiziert, dann ist dies natürlich abhängig vom Wissensstand des Sprechers/ Schreibers. Wissen ist notorisch unvollständig und kann mehr oder weniger falsch sein. Nichts desto Trotz: solange der Sprecher zu diesem Zeitpunkt kein anderes Wissen zur Verfügung hat, wird er — will er denn überhaupt handeln — dieses aktuelle Wissen zum Maßstab für sein Handeln nehmen müssen. Dieses Handeln kann in die Irre führen, es kann Schäden anrichten, aber für den Handelnden ist es vielleicht die einzige Chance, heraus zu finden, dass sein aktuelles Wissen nicht gut ist, dass es falsch ist. ‚Durch Fehler lernen‘ ist eine alte Alltagsweisheit.

Diese grundsätzliche Fehler-Behaftetheit eines aktuellen Wissens resultiert aus der Tatsache, dass uns die Zukunft grundsätzlich nicht bekannt ist.[8] Unser Körper mit seinem Gehirn transformiert zwar kontinuierlich — ohne dass wir dies explizit wollen — aktuelle Gegenwart in stark veränderte innere Zustände, die dann durch verschiedene Speichervorgänge das werden, was wir erinnerbare Gegenwart nennen, unsere Vergangenheit, aber die Zukunft im engeren Sinne, das, was im zeitlichen Anschluss an das Gegenwärtige die neue aktuelle Gegenwart sein wird, diese Zunft kennen wir nicht. Zukunft als solche kommt in unserem Erfahrungsbereich nirgendwo vor; sie ist kein Objekt der Wahrnehmung.

Klassifizieren wir also einige Sachverhalte der Gegenwart als ein Problem, und wir möchten dazu beitragen, dass dieses Problem mindestens abgeschwächt wird, vielleicht sogar ganz gelöst wird, dann müssen wir für uns irgendwie das Bild einer möglichen Zukunft entwickeln, in der die angedachte Lösung (= die Vision), kein bloßer Gedanke ist, sondern die neue Realität, die neue Gegenwart.

Damit stellt sich die grundsätzliche — letztlich philosophische — Frage, in welcher Form wir überhaupt über die Zukunft nachdenken können, wenn wir nur Fragmente einer Gegenwart und unterschiedlich neuronal abgewandelte Fragmente unserer Vergangenheit zur Verfügung haben? Was nützt es mir, zu wissen, dass es gestern in London geregnet hat, in Paris die Sonne schien, und es in Moskau kühl war? Was nützt es mir, zu wissen, dass im 20.Jahrhundert zwei große Kriege stattgefunden haben? Was nützt es mir, zu wissen, dass es in den vergangenen 5000 Jahren viele Großreiche gab, mit hochkomplexen Organisationsformen, die heute aber völlig verschwunden sind? Was nützt es mir, zu wissen, dass sich die heutigen biologischen Lebensformen im Rahmen dessen, was wir biologische Evolution nennen, im Laufe von 3.5 Milliarden Jahren schrittweise heraus gebildet haben? Was nützt es mir, zu wissen, dass das heute bekannte Universum vor ca. 13.7 Milliarden (10^9) entstanden ist? [9]

Von den modernen empirischen Wissenschaften (entwickelt seit ca. 400 Jahren, nimmt man Galilei Galileo als einen groben Bezugspunkt [13])) wissen wir, dass wissenschaftliche Erkenntnis im größeren Stil erst möglich wurde, nachdem man nicht nur das Konzept von standardisierten und reproduzierbaren Messverfahren entwickelt hatte, sondern man auch explizite begriffliche Zusammenhänge (=Theorien) formulieren konnte, so dass es möglich wurde, Beziehungen zwischen den einzelnen Messwerten zu beschreiben. Für sich alleine sind Messwerte (= empirische Daten) zwar individuell, punktuell bedeutungsvoll (‚Die Laborratte im Labyrinth X zum Zeitpunkt T gemessen mit Verfahren V öffnete die weiße Tür und nicht die schwarze.‘), aber man kann daraus zunächst nichts weiter ableiten. Wenn man aber weiß, dass die Forscher ein Verhaltensexperiment durchführen, bei dem eine Laborratte zwischen zwei Türen mit unterschiedlicher Farbe wählen kann und hinter der weißen Tür gelegentlich Futter zu finden ist, nicht aber hinter der schwarzen, und man dann feststellt, dass die Laborrate nach anfänglichem zufälligen Entscheiden ab dem ersten Fund von Futter hinter der weißen Tür die weiße Tür eindeutig bevorzugt, dann kann ein empirisches Datum im Kontext einer zeitlichen Folge von Daten im weiteren Kontext des Experiments von theoretischer Bedeutung sein: man kann einen Zusammenhang formulieren, der besagt, dass die Laborratte (meistens hat man mehrere), wenn sie sich in einer unübersichtlichen Umgebung bewegt, sich Wege in solch einer Umgebung so einprägen kann, dass sie bei Erfolg (Hunger und Futter) aufgrund der Gedächtnisleistung genau jenen Weg finden und wählen kann, der zum Futter geführt hat.(Das klassische Experiment dazu stammt von Tolman [11]).

Im Falle der empirischen Verhaltensforschung (siehe auch [12]) sind Aussagen über das Verhalten von Organismen natürlich in ihrem zeitlichen Horizont sehr begrenzt, da nicht nur die Lebensdauer eines biologischen Organismus sehr begrenzt ist, sondern auch, weil biologische Organismen grundlegend lernende Systeme sind, die ihr Verhalten z.T. dramatisch ändern können. Dennoch lassen sich mit verhaltensbasierten Theorien Voraussagen über ein mögliches Verhalten in der Zukunft ableiten, die begrenzt hilfreich sein können.

Im Falle von nicht-biologischen Systemen wie Planeten, Sonnensystemen, Galaxien usw. kann man aufgrund der Stabilität der Systeme eher belastbare Voraussagen in die Zukunft machen. So kann man mit den heutigen physikalischen Theorien z.B. die Voraussage ableiten, dass der Lebensraum Erde spätestens in 1.4 Milliarden Jahren aufgrund der Ausdehnung der Sonne für die heutigen biologischen Lebensformen unbewohnbar sein wird. Zusätzlich kann man ableiten, dass in spätestens 2.7 Milliarden Jahren von heute aus unsere Milchstraßen Galaxie mit der Andromeda Galaxie kollidieren wird.[10] Im ‚Nahbereich‘ der nächsten Jahrzehnte gibt es Hochrechnungen zur Entwicklung des Erdklimas und der damit zusammenhängenden Lebensbedingungen auf der Erde.

Das Verlassen einer als Problem klassifizierten Situation hin zu einer im Denken als möglich erscheinenden zukünftigen Situation, in der das Problem zumindest minimiert, wenn nicht gar aufgelöst, worden ist, kann nur erfolgen, wenn es (i) mindestens ansatzweise eine Vorstellung von solch einer zukünftigen Situation (= Vision) gibt, und (ii) man sich einen Weg vorstellen kann, wie man von der problematisierten Gegenwart zu einer gewünschten Zukunft als einer neuen Gegenwart kommen kann.

Ein Weg bedeutet hier eine Folge von einzelnen Situationen, in der jede Situation das Ergebnis von vorausgehenden Veränderungen ist. Änderungen werden durch Ereignisse hervorgebracht, die auf unterschiedliche Ursachen zurückgeführt werden können. Zum Teil liegen diese Ursachen in der Eigengesetzlichkeit der jeweiligen Umgebung, zum Teil aber auch im absichtlichen Verhalten von Akteuren, z.B. auch bei uns Menschen.

VISION

Die Herausforderung besteht also darin,

- eine Form zu finden,

- wie beliebige Menschen

- zu beliebigen Problemsituationen

- gemeinsam

- Wege konstruieren können, auf die man — so wird gehofft — in der Zukunft eine neue Gegenwart erreichen kann,

- in der das Problem zumindest minimiert ist.

- Für die notwendige Kommunikation zwischen den beteiligten Menschen sollte primär die Alltagssprache genügen,

- nach Bedarf erweiterbar um spezielle Ausdruckssysteme.

- Die gemeinsamen Denkversuche sollten ferner durch automatisierte Simulationen

- und Bewertungen unterstützt werden können.

- Sofern verfügbar, sollten auch lernfähige Algorithmen eingesetzt werden können.

QUELLENNACHWEISE

[1] Gerd Doeben-Henisch, 1.Februar 2021, REAL-VIRTUELL. Ein Einschub, https://www.cognitiveagent.org/2021/02/01/real-virtuell-ein-einschub/ (Dieser Text setzt viele andere Texte voraus)

[2] Gerd Doeben-Henisch, 3.Februar 2021, EINE KULTUR DES MINIMALEN IRRTUMS? Ergänzende Notiz, https://www.cognitiveagent.org/2021/02/03/eine-kultur-des-minimalen-irrtums-ergaenzende-notiz/ (Dieser Text setzt viele andere Texte voraus)

[3] Diese Problematik zeigt sich in vielen Bereichen, u.a. auch im wissenschaftlichen Publikationssystem selbst, etwa: Moshe Y.Vardi, Reboot the Computing-Research Publication System, Communications of the ACM, Januar 2021, Vol.64, Nr.1, S.7: https://cacm.acm.org/magazines/2021/1/249441-reboot-the-computing-research-publication-systems/fulltext

[4] In der biologischen Verhaltensforschung hat man mittlerweile bei sehr vielen Lebensformen verschieden vom homo sapiens aufzeigen können, dass diese auch über Ausdruckssysteme verfügen, die zur Kommunikation über Eigenschaften der Außenwelt wie auch über die partielle Eigenschaften der Innenwelt geeignet sind. Es scheint sich also bei der Fähigkeit der Kommunikation mittels eines Ausdruckssystems um eine graduelle Fähigkeit zu handeln: beim homo sapiens ist diese Eigenschaft bislang am stärksten ausgeprägt, aber es gibt ähnliche, wenngleich einfachere Formen, auch bei anderen Lebensformen. Sieh z.B. Stichwort ‚animal language‘ in Wikipedia [EN]: https://en.wikipedia.org/wiki/Animal_language

[5a] Döben-Henisch, G.[2006] Reinforcing the global heartbeat: Introducing the planet earth simulator project In M. Faßler & C. Terkowsky (Eds.), URBAND FICTIONS. Die Zukunft des Städtischen. München, Germany: Wilhelm Fink Verlag, 2006, pp.251-263

[5b] Doeben-Henisch, G.[2006] Reducing Negative Complexity by a Semiotic System In: Gudwin, R., & Queiroz, J., (Eds). Semiotics and Intelligent Systems Development. Hershey et al: Idea Group Publishing, 2006, pp.330-342

[6] Jakob von Uexküll, 1909, Umwelt und Innenwelt der Tiere. Berlin: J. Springer. (Download: https://ia802708.us.archive.org/13/items/umweltundinnenwe00uexk/umweltundinnenwe00uexk.pdf )(Zuletzt: 26.Jan 2021)

[7] Beispiel, eines von vielen: Ein älterer Ingenieur erzählte mir am Beispiel des Abwassersystems einer großen Deutschen Stadt, dass es kaum noch Experten gibt, die das ganze System kennen, und die wenigen, die es gibt, stehen vor dem Berufsende …

[8] Gerd Doeben-Henisch, 25.Januar 2021, Gedanken und Realität. Das Nichts konstruieren. Leben Schmecken. Notiz, https://www.cognitiveagent.org/2021/01/23/gedanken-und-realitaet-das-nichts-konstruieren-leben-schmecken-notiz/

[9] Stichwort ‚age of the universe‘ in der englischen Wikipedia: https://en.wikipedia.org/wiki/Age_of_the_universe

[10] Unter dem Stichwort ‚Formation and Evolution of the Solar System‘ findet sich in der Englischen Wikipedia ein Eintrag: https://en.wikipedia.org/wiki/Formation_and_evolution_of_the_Solar_System#Timeline_of_Solar_System_evolution

[11] Edward Tolman, 1948, COGNITIVE MAPS IN RATS AND MEN, The Psychological Review, 55(4), 189-208, online auch hier: http://psychclassics.yorku.ca/Tolman/Maps/maps

[12] Charles R. Gallistel.The Organization of Learning. MIT Press, 1990.

[13] Stichwort ‚Galileo Galilei‘ in der Englischen Wikipedia: https://en.wikipedia.org/wiki/Galileo_Galilei

FORTSETZUNG

Eine Fortsetzung gibt es HIER.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.