Evan Thompson, Mind in Life. Biology, Phenomenology, and the Sciences of Mind. Harvard – London, The Belknap Press o f Harvard University Press, 2007

PHILOSOPHIE UND WISSENSCHAFTEN – EIN MOTIV

-

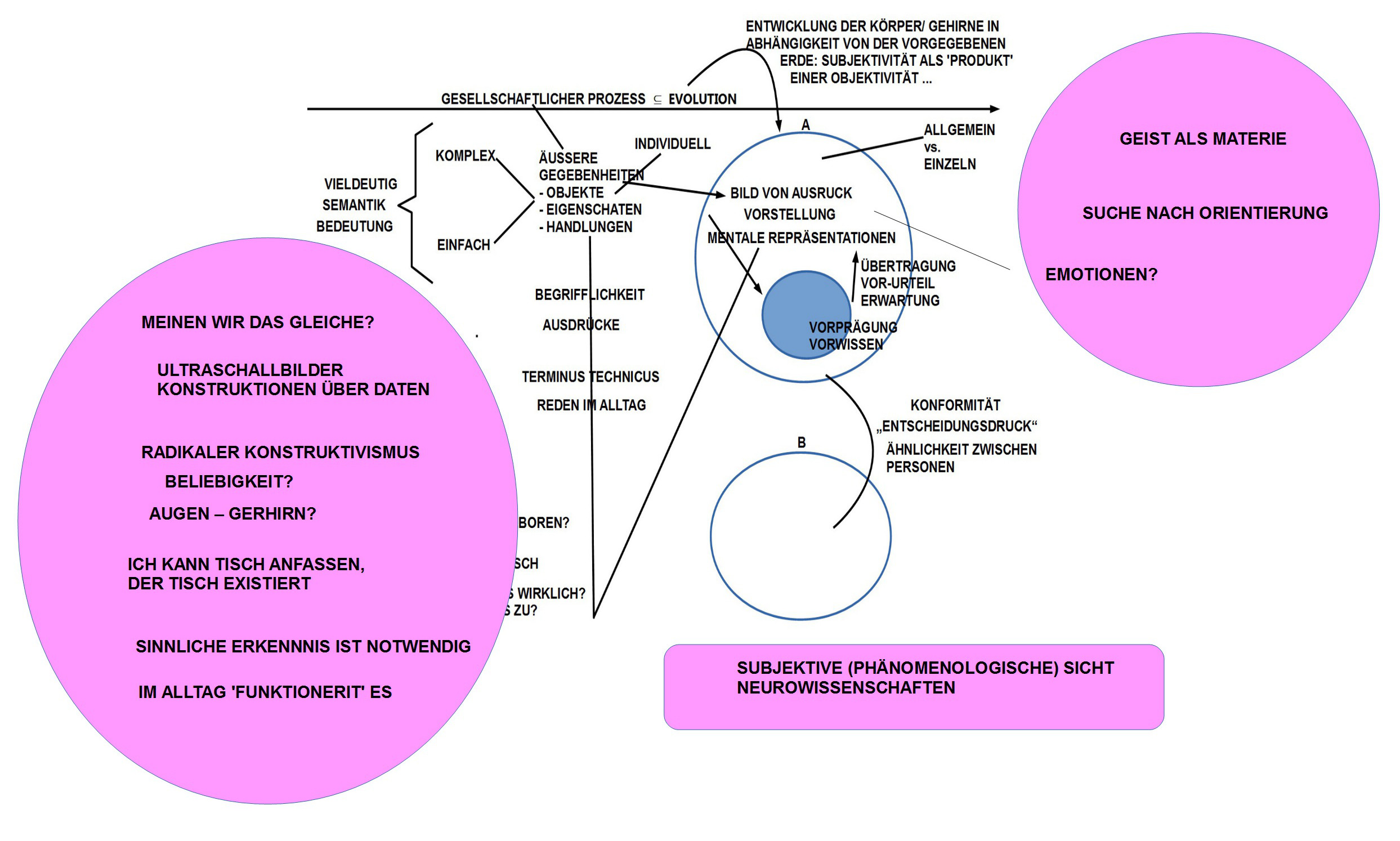

Das Motiv für die Lektüre dieses Buches rührt von der anhaltenden Auseinandersetzung von cagent zu den philosophischen Grundlagen unseres Weltbildes. Egal ob man sich mit psychologischen Modellbildungen beschäftigt, mit biologischen oder neurowissenschaftlichen, man stößt immer wieder auf die methodischen Ränder dieser Disziplinen, durch die ein direkter Zugriff auf die Inhalte des Bewusstseins nicht möglich ist (siehe Bild 1). Es bleiben immer nur Korrelationen mit etwas, das man dem Bewusstsein zurechnet, aber man kommt niemals direkt an die Daten des Bewusstseins heran.

-

Dieses Problem ist nicht neu, es ist letztlich uralt, aber durch die Fortschritte der empirischen Wissenschaften wird die Besonderheit des Phänomens des Bewusstseins klarer als je zuvor.

-

Welcher Philosoph das Phänomen des Bewusstseins bislang am besten beschrieben haben soll, ist schwer zu sagen. Jeder große Philosoph hat auf seine Weise interessante Aspekte enthüllt. Aus Sicht der heutigen Methoden und Erkenntnisse erscheint cagent das Vorgehen von Edmund Husserl mit seinem phänomenologischen Forschungsprogramm bislang als am ehesten geeignet zu sein, eine Brücke zu schlagen zu den heutigen empirischen Wissenschaften, ohne dabei das Alleinstellungsmerkmal des philosophischen Denkens und die Besonderheiten des Untersuchungsgegenstandes aufgeben zu müssen.

-

Entscheidend für das Projekt einer verbesserten Integration von philosophischem mit empirischem Denken wird der benutze Erkenntnis- und Wissenschaftsbegriff sein. Trotz ca. 100 Jahren Wissenschaftsphilosophie kann man aber nicht behaupten, dass es in allen wissenschaftlichen Disziplinen heute einen einheitlichen Wissenschaftsbegriff gibt, der sich auch in entsprechend gemeinsamen Methoden und Darstellungsweisen ausdrückt.

-

Der Autor cagent greift zu diesem Zweck zurück auf die Tradition der Wissenschaftstheorie, wie sie zuletzt im Institut für Logik und Wissenschaftstheorie der Ludwig-Maximilians Universität München in den 80iger Jahren des 20.Jahrhunderts praktiziert wurde (dies Institut existiert in der damaligen Form nicht mehr). Diese Sicht wurzelte stark u.a. auch in der Tradition des Wiener Kreises, mit all den Schwachstellen, die sich daraus ergaben. Dennoch kann man aus dieser Position eine Arbeitshypothese herleiten, die nachvollziehbar und kritisierbar ist. Diese Position sei hier mit der Abkürzung LMU-ILWT bezeichnet.

-

Ein wesentlicher Punkt in der Position des LMU-ILWT besteht in der Forderung nach einer angemessen Formalisierung intendierter wissenschaftlicher Sachverhalte in einer Disziplin. Heute könnte man die Formalisierungsanforderung ergänzen um den Punkt von brauchbaren Simulationsmodellen, mit deren Hilfe sich die Auswirkungen einer formalen Theorie sichtbar und ansatzweise überprüfbar machen lassen.

-

Die Anforderungen lassen sich an jede empirische Theorie stellen und einlösen, was aber faktisch immer nur partiell passiert. Den meisten Wissenschaftlern fehlt das Knowhow (und die Zeit, und die Werkzeuge), um diese Anforderung wirklich einzulösen.

-

Im Rahmen eines Programms zur Integration von Philosophie und empirischen Wissenschaften ist zu überprüfen, ob und wieweit sich auch die Position der Philosophie entsprechend formalisieren und simulieren lässt. Von den meisten Philosophen wird solch eine Gedanke eher abgelehnt.

-

Im Falle eines phänomenologischen Forschungsprogramms im Stile von Edmund Husserl ist solch eine Überlegung aber keinesfalls abwegig, sondern gehört sogar in gewisser Weise zum Forschungsprogramm selbst.

-

Im Rückgang auf die Grunddaten des bewussten Erlebens, Fühlens, Denkens usw. zeigt sich eine Vielfalt von Phänomenen in einer spezifischen Dynamik mit impliziten Strukturen, die zu formalisieren genauso sich anbietet wie die Formalisierung von komplexen Phänomene aus dem Bereich der biologischen Evolution oder der Entstehung des physikalischen Universums.

- Es gab sogar einen berühmten Versuch solch einer Formalisierung. Das Buch von Rudolf Carnap Der Logische Aufbau der Welt (1928) erscheint als eine 1-zu-1 Übersetzung jenes Konstitutionsprozesses der Phänomene des Bewusstseins, wie sie Husserl in den Ideen I + II (sowie in anderen Schriften) über Jahrzehnte entwickelt hat. Allerdings hat Carnap sowohl im Stufenbau wie auch in seiner Autobiographie alles daran getan, diesen Bezug zu Husserls Denken und Werk zu verdecken. (Anmerkung: Eine neuere, sehr ausführliche und gründlich recherchierte Untersuchung zum Verhältnis von Carnaps Stufenbau zum Denken Husserls, die diese Nähe Carnaps zu Husserl belegt, findet sich in einem Beitrag von Verena Mayer (München), der demnächst erscheinen wird.)

- Der Stufenbau Carnaps wurde mehrfach heftig kritisiert. Dennoch ist die Grundidee, auch die Phänomene des Bewusstseins einer formalen Analyse zu unterziehen naheliegend und konsequent. Es gibt keinen Grund, dies nicht zu tun. Die grundsätzliche Problematik einer Versprachlichung von Erkennen wird dadurch natürlich nicht aufgehoben und nicht geheilt, aber im Raum des menschlichen Erkennens gibt es keine Alternativen. Unser Denken befindet sich kontinuierlich in einem Ringen um Artikulation, die als solche notwendig ist, aber als solche niemals das Erkannte ganz erschöpfen kann. Das bekannte Ungenügen ist keine Entschuldigung, es gar nicht zu tun. Denn die Alternative zu einer unvollkommenen Artikulation ist gar keine Artikulation.

- Je mehr die empirischen Wissenschaften die Grenzen des Redens über das Bewusstsein immer klarer erfahrbar machen, umso eindringlicher entsteht die Aufforderung, sich als Philosoph erneut darüber Gedanken zu machen, ob und wie solch ein Programm einer erneuerten Theorie des Bewusstseinserlebens im Kontext von Entwicklungs-, Verhaltens-, Gehirn- und Körperwissenschaften (um nur die wichtigsten zu nennen) aussehen könnte. Arbeitshypothese ist, das phänomenologische Forschungsprogramm von Husserl als Leitschnur zu nehmen erweitert um das wissenschaftsphilosophische Instrumentarium einer modernen Wissenschaftstheorie im Stil von LMU-ILWT.

- In diesem Kontext finde ich ein Buch wie das von Thompson reizvoll, zumal Thompson sich in den letzten Jahren in einem Netzwerk von Forschern bewegt hat, denen man das Label ‚Naturalisierung der Phänomenologie‘ anheften könnte. Diese Forscher hatten ihren eigenen Lernprozess mit dem Forschungsprogramm von Husserl.

THOMPSON Kap.1 (SS.3-15)

ENAKTIVE VORGEHENSWEISE

- In diesem einführenden Kapitel versucht Thompson eine historische Einordnung vorzunehmen zwischen jenem philosophisch-wissenschaftlichen Paradigma, dem er sich zugehörig fühlt und das er Enaktiv (Englisch: ‚enactive‘) nennt, und jenen anderen Strömungen, die er als vorbereitend für den eigenen Standpunkt ansieht. Der Begriff ‚enaktiv‘ ist ein Kunstwort, in dem die Idee einer Realisierung eines Gesetzes durch Verkörperung in der Zeit ausgedrückt werden soll. (vgl. S.13) Der Begriff geht zurück auf das Buch The Embodied Mind, das Thompson zusammen mit Varela und Rosch 1991 verfasst hatte.

- Im einzelnen zählt Thompson fünf Aspekte auf, die für eine enaktive Vorgehensweise in seinem Verständnis wichtig sind.(vgl. Dazu S.13)

- Zum einen (i) ist dies der Aspekt der Autonomie lebender Systeme. Im Rahmen ihrer Möglichkeiten organisieren sie sich komplett selbst und in diesem Rahmen generieren sie ihren spezifischen Erkenntnisraum (‚cognitive domain‘).

- Innerhalb dieser generellen Autonomie arbeitet (ii) das Nervensystem (das Gehirn) ebenfalls autonom. Mit Schnittstellen zu Ereignissen außerhalb des Gehirns arbeitet das Gehirn aber vollständig selbstbezüglich und erschafft in dieser Selbstbezüglichkeit seine eigenen Bedeutungsstrukturen.

- Ferner gilt (iii): Erkenntnis (‚cognition‘) ist in diesem Kontext ein Moment an einem dynamischen Verhalten, das zwar über sensorische und motorische Kopplungen mit einer Umwelt interagiert, aber diese Kopplung führt nicht zu einer 1-zu-1-Determinierung des Systems. Das System hat eine Eigendynamik, die über diese Interaktion weit hinausgeht.

- Im Rahmen solch einer eingebetteten Kognition ist (iv) das Bild einer Welt nicht einfach eine Entsprechung, nicht eine direkte Repräsentation der empirischen Außenwelt, sondern ein dynamisches Produkt aus Interaktion und systeminternen generierenden Prozessen, die ein systemspezifisches Modell einer unterstellten Welt erzeugen.

- Schließlich: (v) Erfahrung (‚experience‘) ist in diesem Kontext nicht irgendein Nebeneffekt (‚epiphenomenal side issue‘), sondern der wesentliche Aspekt für ein Verständnis von Geist (‚mind‘). Von daher ist es notwendig genau diese Erfahrung zu untersuchen, und die beste Methode dafür ist nach Thompson eine phänomenologische Vorgehensweise.

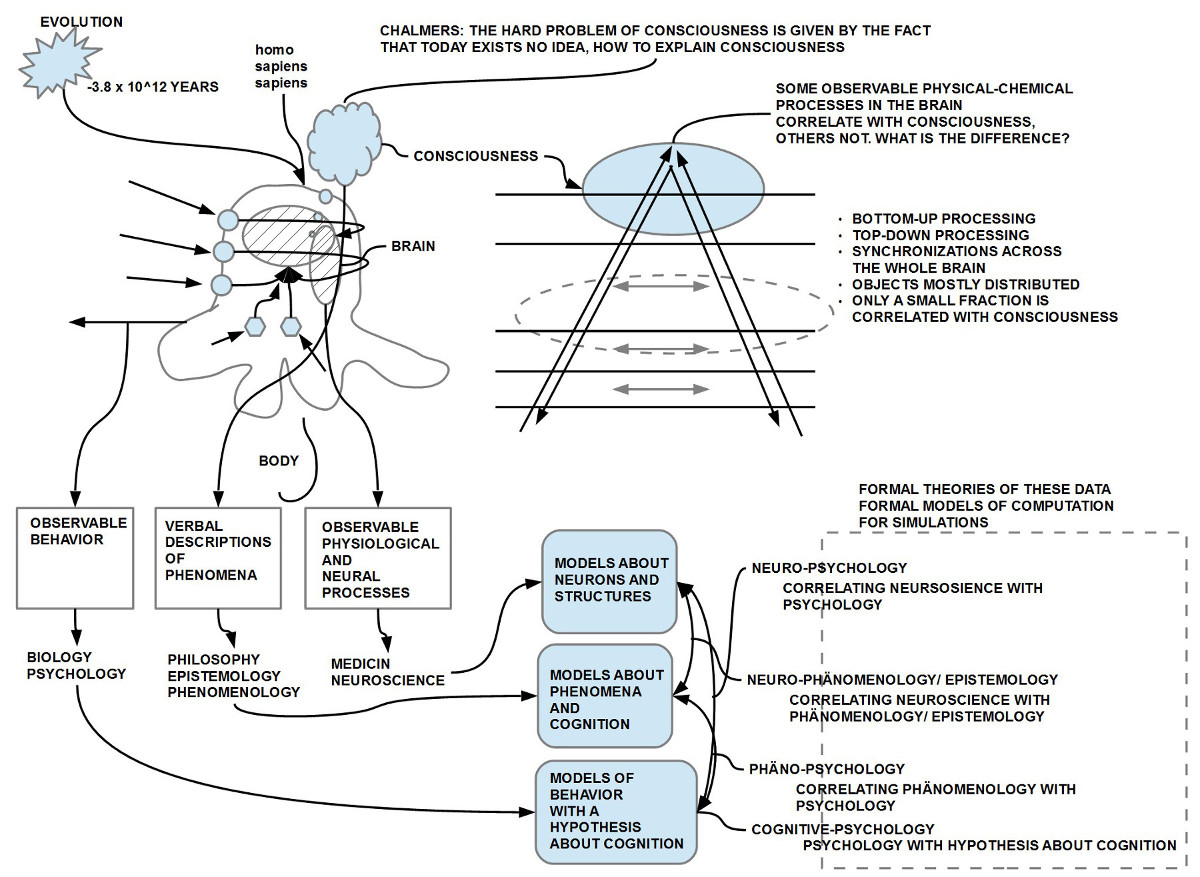

- Bevor auf diese Punkte näher eingegangen wird sei hier noch ein kurzer Blick gestattet auf den Ausblick von Thompson auf andere, konkurrierende Ansätze.(sehe Bild 2)

KOGNITIVISMUS, KONNEKTIONISMUS, VERKÖRPERTER DYNAMIZISMUS

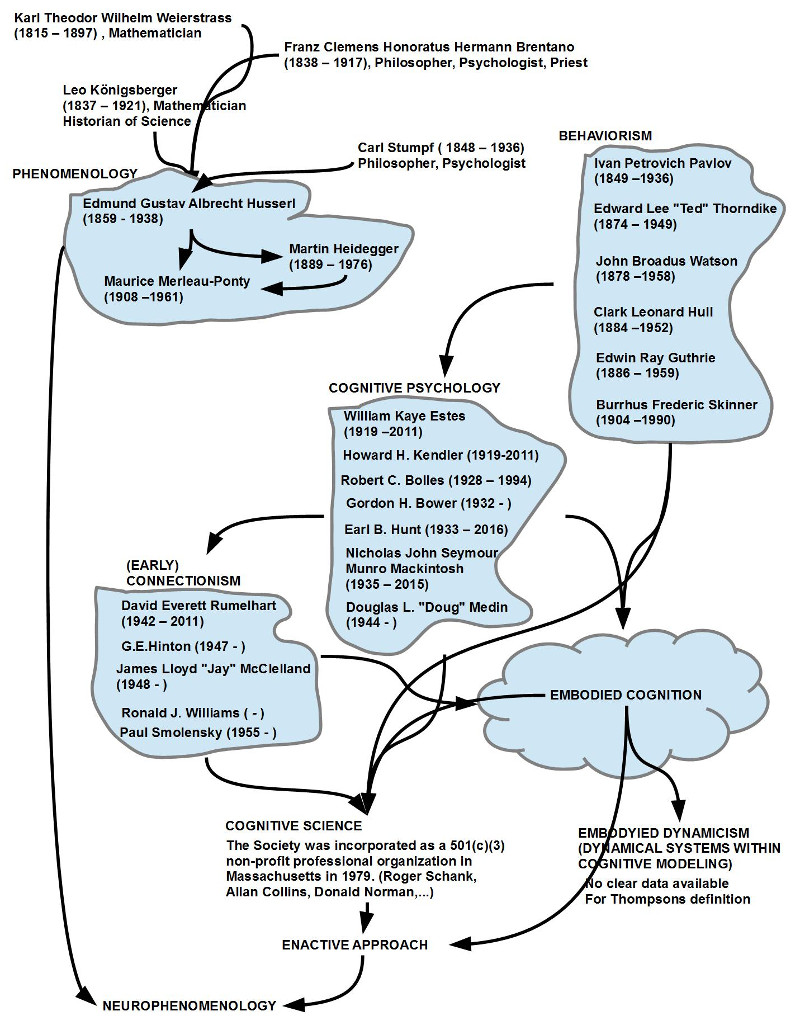

- Letztlich organisiert er seine Umschau mit den Begriffen Kognitivismus (‚cognitivism‘), Konnektionismus (‚connectionism‘) und Verköperter Dynamizismus (‚embodied dynamicism‘).

- Das Problem mit diesen Begriffen ist, dass sie nicht sehr scharf sind, eher vage. Dies zeigt sich sofort, wenn man versucht, konkrete Forscher diesen Richtungen zuzuordnen und dabei den Inhalt ihrer Schriften einbezieht. Die meisten Forscher haben in ihrem Leben eine Lerngeschichte, die sie mit einer bestimmten Position anfangen lässt und sie dann zu weiteren, neuen Positionen führt. Ordnet man nun bestimmte Forscher aufgrund bestimmter Ansichten im Jahr X einer bestimmten Ähnlichkeitsklasse M zu, so gilt dies oft nur für eine bestimmte Zeitspanne. Außerdem sind bestimmte Paradigmen (wie z.B. gerade der sogenannte Kognitivismus) in sich so komplex und vielfältig, dass eine saubere Definition in der Regel kaum möglich ist.

- So definiert Thompson den Begriff Kognitivismus einleitend gar nicht sondern zitiert in lockerer Folge unterschiedliche Autoren und Konzepte, die man sowohl der schwammigen Kognitionswissenschaft (‚cognitive science‘) zuordnen kann wie auch der Kognitionspsychologie (‚cognitive psychology‘), die sich als Gegenbewegung zur Verhaltenspsychologie (‚beavioral psychology‘, ‚behaviorism‘) gebildet hatte. Daneben gibt es auch Strömungen in der Philosophie, die sich unterschiedlich mit dem Kognitivismus und der Kognitionspsychologie überlappt haben und immer noch überlappen. In allem dabei die neue erstarkende Rolle von computerbasierten Modellen und Simulationen.(vgl. SS.4-8)

- In all diesen – nicht immer klaren – Positionen erkennt Thompson charakteristische Defizite.

- Die Verbannung der direkten Beobachtung von Geist und Bewusstsein im Rahmen einer empirischen Verhaltenspsychologie (zur Zeit ihrer Entstehung ein wichtiges Anliegen, um die einseitige Orientierung an der Introspektion aufzubrechen), führte im weiteren Verlauf zu einer ideologischen Verhärtung der Methoden, die sich dann auch in der Kognitionspsychologie und der frühen Kognitionswissenschaft (samt Teilen der Philosophie) weiter vererbte. Die Einbeziehung von Computermodellen verstärkte die Tendenz, die Arbeitsmodelle der Kognition im Stile von – rein symbolischen – Informationsverarbeitungsprozessen zu sehen, die einen gewissen Anschluss an die moderne Gehirnforschung erlaubte. Allerdings war (und ist) die Übereinstimmung des Computerparadigmas und des Gehirnparadigmas – je nach Betrachtungsstandpunkt – nur partiell ähnlich. Dazu kam – nach Thompson – eine isolierte Betrachtung individueller kognitiver Prozesse ohne den Faktor der umgebenden Kultur. Der Zusammenhang zwischen Bewusstsein und all den anderen Wissenschaftsbereichen wurde damit letztlich immer unklarer, war (und ist immer noch weitgehend) geradezu geächtet, und die resultierenden Theorie (sofern es überhaupt Theorien waren) wirkten aufgrund ihrer Eingangsbeschränkungen oft sehr verzerrt.

- Im Konnektionismus (‚connectionism‘), der nach anfänglichen Startschwierigkeiten ab den 80iger Jahren des 20.Jahrhunderts deutlich an Boden gewann, sieht Thompson einen gewissen Fortschritt derart, dass neue Erkenntnisse der Gehirnforschung und der Forschung mit künstlichen neuronalen Netzen deutlich machten, dass das Konzept eines deduktiven Denkens mittels Symbolen einer abstrakten Ebene zugehört, die tieferliegend mittels vernetzten Neuronen realisiert wird, die direkt keine Symbole verkörpern, sondern ein Netzwerk von Ereignissen, die dynamisch unterschiedlichste Abstraktionsebenen und Wechselwirkungen realisieren. Ein Verständnis von Geist muss also tiefer ansetzten als lange Zeit gedacht. Thompson kritisiert am Konnektionismus, dass dieser die Verkopplung mit der Welt nur ungenügend berücksichtigt habe. Für die ersten Jahrzehnte mag dies stimmen. Aber in den letzten Jahren hat sich dies radikal gewandelt (Beispiel google Algorithmen, IBMs Watson, Roboter, usw.). Was allerdings als Kritik bestehen bleibt ist Thompsons Diagnose, dass auch der Konnektionismus bislang ein Riesenproblem mit dem Bewusstsein hat.

- Der Begriff des verkörperten Dynamizismus (‚embodied dynamicism‘) erscheint besonders problematisch. Thompson sieht hier ein Zusammengehen der Strömung Dynamischer (selbstorganisierter) Systeme (‚dynamic (self-organizing) systems‘) und Verköperter Systeme (‚embodied systems‘). Dazu gehört, dass solche Systeme nicht einfach nur die Umwelt 1-zu-1 abbilden, sondern ihre Interaktion mit der Umwelt durch autonome, nicht-lineare Prozesse individuell gestalten. Thompson sieht in der Strömung eines verkörperten Dynamizismus Ansätze sowohl für eine Einbeziehung des Bewusstseins wie auch des Vor- und Nicht-Bewusstseins.(vgl. S.11f)

- In dieser vorausgehenden Strömung, dem verkörperten Dynamizismus, sieht Thompson dann auch den Übergang zu jener Richtung, der er sich selbst zugehörig fühlt und die für ihn die Lösung wichtiger Fragen ermöglichen soll, besser als in den vorausgehend charakterisierten Strömungen.

ENAKTIVES VORGEHEN und PHÄNOMENOLOGIE

- Nach diesen Einkreisungen der Notwendigkeit einer direkten Analyse des Bewusstseins deutet Thompson kurz an, wie er sich diese Analyse vorstellt.

- Es soll primär die phänomenologische Methode von Husserl und auch von Merleau-Ponty sein, dies aber im Rahmen der (selbstorganisierenden, autopoietischen) Autonomie und Intentionalität des Lebens allgemein. Ferner soll die Neurobiologie einbezogen werden, was die Notwendigkeit einer Neuro-Phänomenologie begründet.(vgl. S.15)

DISKUSSION

- Wie schon angedeutet, erscheint die allgemeine Lageskizze, die Thompson gibt, als problematisch, da die Begriffe nicht allzu scharf sind und eine wirkliche genau Zuordnung einzelner Personen zu bestimmten Richtungen in solch einem Kontext schwierig ist.

- Auch ist nach dieser Einleitung noch nicht ganz klar, wie Thompson sein Programm einlösen wird. Die skizzierte enaktive Vorgehensweise lässt viel Spielraum für alternative Konzepte.

Einen Überblick über alle Blogbeiträge von cagent nach Titeln findet sich HIER.