(Letzte Aktualisierung: Do 28.Juli 2016, 13:06h)

David J.Chalmers, FACING UP THE PROBLEM OF CONSCIOUSNESS, Journal of Consciousness Studies, 2, No. 3, 1995, pp.200-219

KONTEXT

-

In einem vorausgehenden Blogeintrag mit dem Titel THOMPSON: MIND IN LIFE – Review – Teil 1 hatte ich damit begonnen, eine neue Variante phänomenologischer Forschung zu besprechen, die unter dem Titel Neurophänomenologie begründet worden war. Dieser Ansatz geht zurück auf Varela, der dazu 1996 einen grundlegenden Artikel im JoCS geschrieben hatte, in dem er wiederum auf einen Artikel von Chalmers 1995 geantwortet hatte. Seine Antwort umfasste dann gleich einen kompletten konstruktiven Vorschlag, wie man es anders machen könnte. Bevor der Artikel von Varela hier zur Sprache kommen soll, hier zunächst eine Reflexion auf den Beitrag von Chalmers 1995, der seitdem in zahllosen weiteren Artikeln intensiv diskutiert worden ist. Eine andere Art von Einstimmung könnte das Kap.9 von Nick Lane sein.

OBJEKTIV – SUBJEKTIV

-

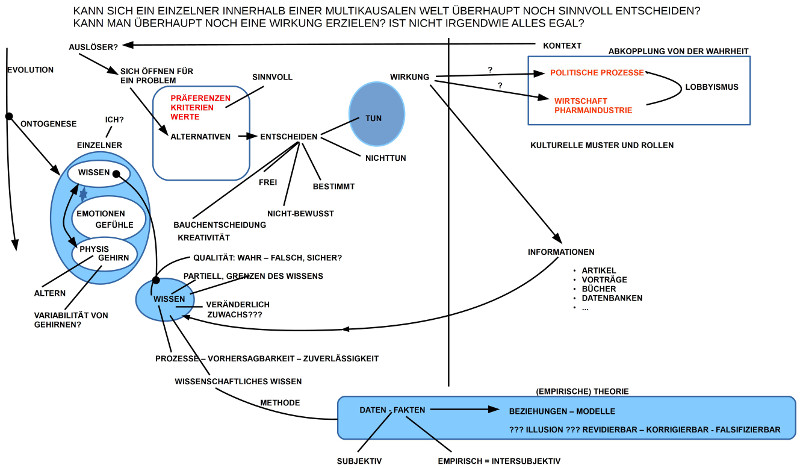

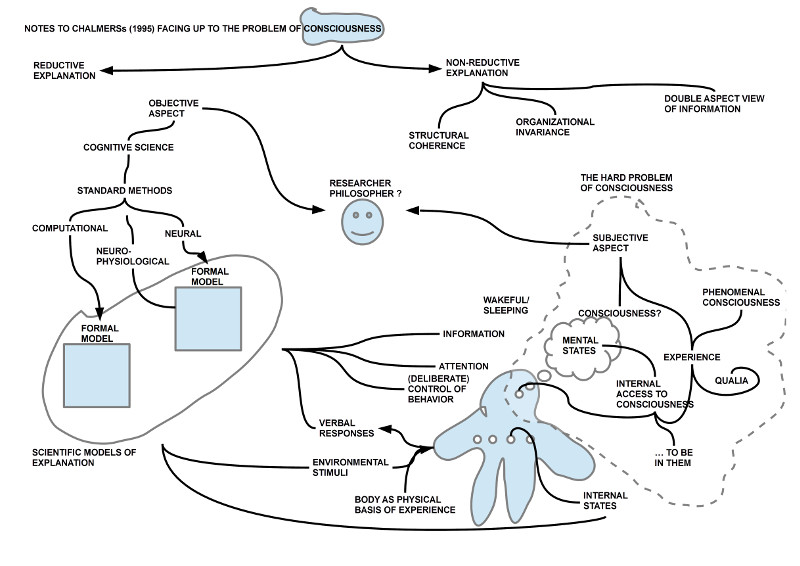

Im Kapitel 2 (siehe Bild) startet Chalmers seine Überlegungen zum Bewusstsein mit einer Fallunterscheidung in objektive Aspekte des Problems und in subjektive Aspekte.

-

Die objektiven Aspekte lassen sich nach Chalmers – im Prinzip – im Rahmen der bekannten wissenschaftlichen Disziplinen relativ einfach aufklären. Als wissenschaftliche Disziplinen führt er nur eine einzige an, nämlich die Kognitionswissenschaft (‚cognitive science‘), innerhalb deren er drei methodische Ansätze unterscheidet: computerhaft (‚computational‘), neurophysiologisch und neuronal (’neural‘).

-

Als Phänomene, die er für die Methoden der Kognitionswissenschaft im Prinzip als einfach (‚easy‘) erklärbar einstuft, zählt er auf: Umgebungsreize, verbale Äußerungen, Aufmerksamkeit, Verhaltenskontrolle, Wachheit und Schlaf, Verhaltenskontrolle und diverse interne Zustände.

-

Daneben erkennt er aber auch noch eine subjektive Dimension im Wirklichkeitszugang. Diese erschließt sich im Darin sein (‚to be in them‘) in inneren, mentalen Zuständen. Hier trifft man auf Phänomene, Qualia, befindet man sich im Raum des Bewusstseins, im Bewusstsein.

-

Die subjektive Dimension befindet sich außerhalb des Zugriffs der objektiven Methoden. Insofern nennt er die Fragen des Bewusstseins, die sich im subjektivne Zugang erschließen, als harte (‚hard‘) Fragen. Er spricht hier vom harten Problem (‚hard problem‘) des Bewusstseins.

FUNKTIONALE ERKLÄRUNG MIT GRENZEN

-

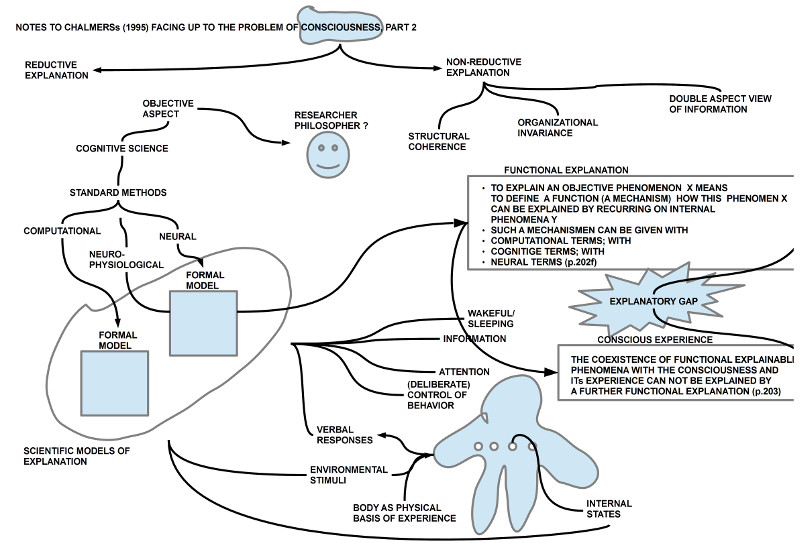

Das 3.Kapitel läuft auf die These von der begrifflichen Kluft (‚explanatory gap‘) zwischen funktionaler Erklärung objektiver Phänomene einerseits und der korrelierenden Existenz des subjektiven Phänomens des Bewusstseins hinaus (vgl. Bild 2).

-

Dies setzt voraus, dass die Wissenschaften, die objektive Phänomene im Umfeld des Bewusstseins erklären, dies mit Hilfe von funktionalen Erklärungen tun können. In einer funktionalen Erklärung F werden die beobachtbaren (zu erklärenden) Phänomene X in Beziehung gesetzt zu anderen beobachtbaren Phänomenen Y, und zwar so, dass der Zusammenhang einen Mechanismus (‚mechanism‘) erkennen lässt, aufgrund dessen das Auftreten von X in Abhängigkeit von Y akzeptiert werden kann. Entsprechend den zuvor angeführten Methoden der Kognitionswissenschaft(en) sieht Chalmers drei Arten von möglichen Mechanismen: (i) Computermodelle, (ii) kognitive Modelle und (iii) neuronale Modelle.

-

Chalmers sieht keine Möglichkeit, das korrelierende Auftreten einer Bewusstseinserfahrung B im Kontext von beobachtbaren Phänomenen X und Y ebenfalls durch eine funktionale Erklärung G so zu erklären, dass sich zwischen X und Y einerseits und B andererseits ein Mechanismus angeben lässt, der als Erklärung akzeptierbar sei.

-

Diese Unmöglichkeit der Angabe einer weiteren funktionalen Erklärung versteht Chalmers als Erklärungslücke (‚explanatory gap‘).

BEISPIELE (REDUKTIVER ERKLÄRUNG) (Kap.4)

-

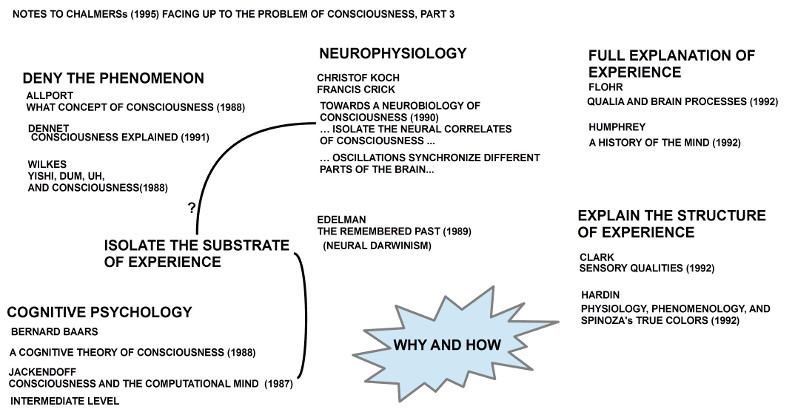

Im Kap.4 stellt Chalmers verschiedene Autoren vor, mittels deren er seine zuvor eingeführte Klassifikation illustrieren möchte. (vgl. Bild 3)

-

Diese Beispiele sind aber so karg beschrieben, dass man sie kaum verwerten kann. Als Beleg soll das Zitat von Edelman dienen. Im Buch von Edelman (1989) wird ein sehr ausführliches Bild von den Forschungen zum Bewusstsein vermittelt. Das Stichwort vom ’neuronalen Darwinismus‘ greift hier viel zu kurz (das Buch Edelmans von 1992 Bright Air, Brilliant Fire: On the Matter of thre Mind, das noch umfassender ist, wird erst gar nicht erwähnt)(Anmerkung: In seinem Buch The Conscious Mind (1996) ist Chalmers hier genauer und hilfreicher. Die Bemerkungen hier im Artikel erscheinen da eher nutzlos).

-

Die Stichworte zu Koch/ Crick und Baars lassen noch am ehesten deren Ideen erkennen. Nach Koch/Crick sind es synchronisierende Oszillationen im Gehirn (Bindungstheorie), die unterschiedliche Aktivitäten bündeln und so komplexe Zustände möglich machen, die eventuell als Korrelate des Bewusstseins (‚correlates of experience‘) angesehen werden können. Ähnlich und doch weitergehender (spekulativer) argumentiert Baars. Er sieht einen Zusammenhang zwischen den Inhalten des Bewusstseins (‚contens of consciousness‘) und dem, was er den globalen Arbeitsbereich (‚global workspace‘) des Gehirns nennt: dies soll jener Bereich sein, in den viele andere Bereiche des Gehirns wichtige Informationen abbilden, über die alle spezialisierten Bereiche kommunizieren. Er nennt dies ein gemeinsames schwarzes Brett (‚communal blackboard‘).

-

Was immer such die einzelnen Beispiele im einzelnen – nach Chalmers – sagen bzw. sagen wollen, für Chalmers bietet keines der Beispiele (also: keiner der Autoren) eine wirkliche Antwort auf die Frage, warum (‚why‘) es das Phänomen des Bewusstseins parallel zu diesen vielen Prozessen gibt und wie (‚how‘) der Zusammenhang zwischen den physiologischen und den phänomenalen Phänomenen genau zu denken ist.

WEITERE BEISPIELE (REDUKTIVER ERKLÄRUNG) (Kap.5)

-

In Kap.5 wir die kursorische Aufzählung weiterer Beispiele fortgesetzt, in der Erklärungsansätze genannt werden, die mit dem Phänomen des Bewusstseins Berührungen aufweisen, aber nichts wirklich erklären sollen.

-

So wird wird das Konzept nicht-algorithmischer Prozesse von Penrose (1989, 1994) erwähnt. Ein Zusammenhang mit dem Phänomen des Bewusstseins sieht Chalmers nicht.(p.207)

-

Ähnlich stellt Chalmers auch einen Erklärungszusammenhang zwischen chaotischen und nichtlinearen Prozessen ebenso wenig mit quantentheoretischen Modellen (Hameroff 1994) in Frage. Was erklären diese? (vgl. p.207f)

-

Chalmers wiederholt hier sein Axiom, dass jede Art von Erklärung physikalischer Prozesse alleine nicht ausreichend sein kann, das Phänomen des Bewusstseins als solches zu erklären. Die Emergenz von Bewusstseinserfahrung entzieht sich einer rein physikalischen Erklärung. Phänomene des Bewusstseins können sich im Kontext von physikalischen Prozessen zeigen, sie müssen es aber nicht.(p.208)

NEUE FUNDAMENTALE ENTITÄTEN

-

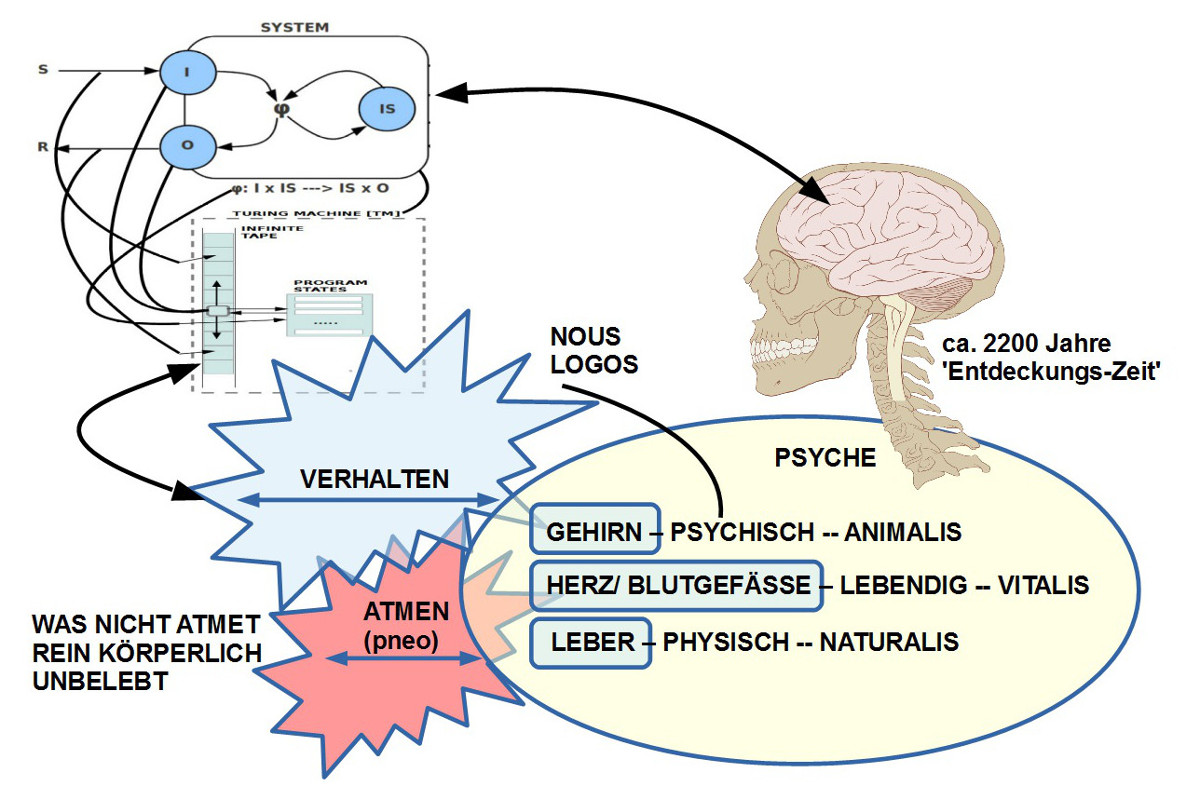

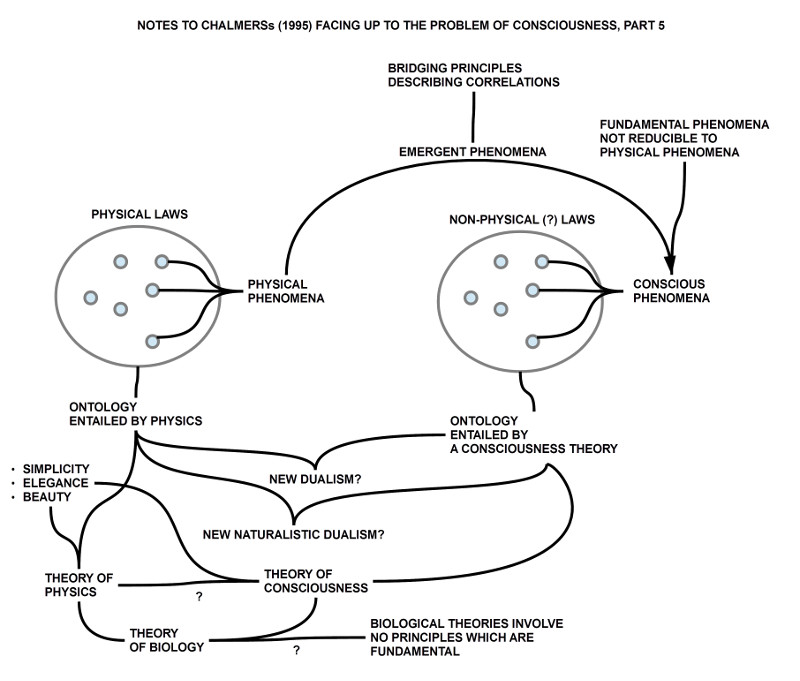

Nachdem Chalmers – aus seiner Sicht – herausgearbeitet hat, dass eine Erklärung der Phänomene des Bewusstseins mittels physikalischer Gesetze nicht möglich erscheint, folgt er der Strategie der Physik aus der Vergangenheit, indem man für nicht-reduzierbare Phänomene dann postuliert, dass sie fundamentale Phänomene seien, die ihre eigenen Gesetze benötigen.(vgl. Bild 5)

-

Insofern diese neuen fundamentale Phänomene nicht isoliert von den physikalischen Phänomenen auftreten, nennt er sie emergente Phänomene, deren korrelierendes Auftreten im Kontext physikalischer Phänomene sich gegebenenfalls mit zusätzlichen überbrückenden Prinzipien (Brückenprinzipien, ‚bridging principles‘) beschreiben lassen.

-

Die Betrachtung von Phänomenen führt meist auch zur Frage von damit zusammenhängenden möglichen Existenzen (Ontologien, ‚ontologies‘).

-

Fall sich mit den Phänomenen des Bewusstseins Existenzen ganz eigener Art verknüpfen würden, dann läge eine neue Art von Dualismus (im Stile von Descartes und anderen) vor. Soweit will Chalmers aber nicht gehen. Obwohl es sich bei den Phänomenen des Bewusstseins um nicht-reduzierbare, und damit fundamentale Phänomene handelt, will er sie nicht gänzlich von der natürlichen Ontologie getrennt sehen, wie sie von der Physik beschrieben wird.

-

Interessanterweise sieht Chalmers eine Theorie des Bewusstseins näher bei der Physik als bei der Biologie, der er jegliche fundamentale Prinzipien im Sinne des Bewusstseins abspricht.(p.211)

AUSBLICK AUF EINE THEORIE DES BEWUSSTSEINS

-

Unabhängig davon, was Chalmers über andere Autoren gesagt hat (treffend oder nicht treffend), hat er seine eigene Meinung zu einer möglichen Theorie des Bewusstseins.

-

Zu Beginn des Kap.7 skizziert er einige grundlegende Annahmen, auf deren Basis er dann weiter voranschreitet.

-

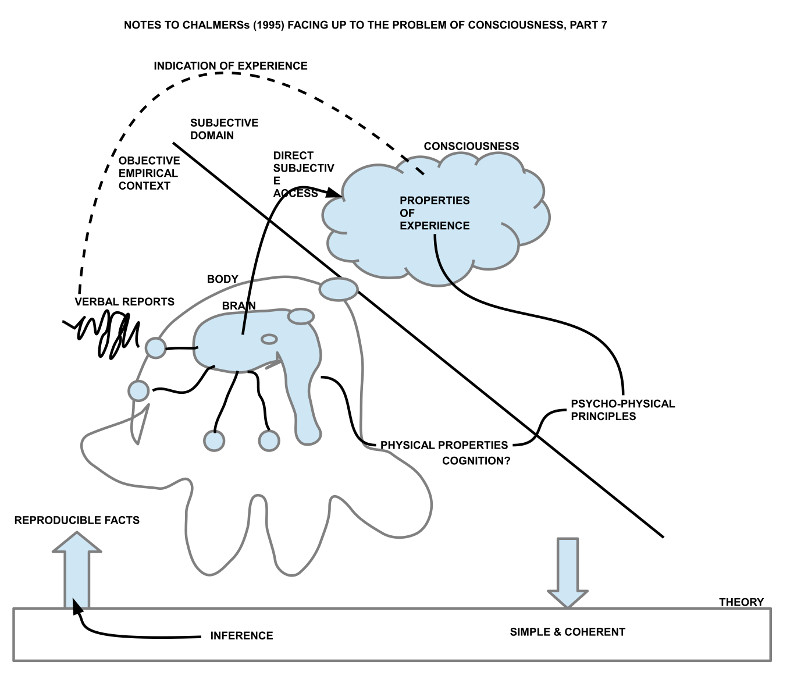

Wie in Bild 7 angedeutet, soll eine mögliche Theorie des Bewusstseins einfach und kohärent sein und soll Aussagen über reproduzierbare Fakten möglich machen.

-

Als Basis für die Theorie gibt es einerseits die Eigenschaften der bewusstseinsbasierten Erfahrung, zu denen jeder einzeln, für sich einen direkten Zugang hat, und andererseits empirische Phänomene, wie Umwelt, Körper und Gehirn, speziell auch sprachliche Äußerungen, über die man indirekt auf Eigenschaften des Bewusstseins schließen kann.

-

Ferner postuliert Chalmers spezielle psycho-physische Brückenprinzipien, die einen Zusammenhang zwischen korrelierenden physikalischen und bewusstseinsbezogenen Phänomenen herstellen.

PRINZIP DER STRUKTURELLEN KOHÄRENZ

-

Als eine mögliche Richtschnur für die Formulierung der Inhalte einer möglichen Theorie des Bewusstseins beschreibt Chalmers das Prinzip der strukturellen Kohärenz.

-

Diese Kohärenz sieht er gegeben zwischen dem empirischen Phänomen der Aufmerksamkeit (‚attention‘) und den den subjektiven Phänomenen des Bewusstseins.

-

Der Begriff der ‚Aufmerksamkeit‘ wird definiert über empirische Phänomene und deren funktionalen Beziehungen.

-

Ohne eine weitere Analyse der subjektiven Phänomene vorgelegt zu haben behauptet Chalmers nun, dass die Phänomene im Kontext der empirischen Aufmerksamkeit eine bestimmte Struktur erkennen lassen, die sich auch im Bereich der subjektiven Phänomene finde. Er geht sogar soweit, die Ähnlichkeit zwischen beiden Strukturen (Struktur der Aufmerksamkeit, Struktur des Bewusstseins) als isomorph zu bezeichnen (p.213).

-

Zugleich schränkt er diese Ähnlichkeit dahingehend ein, dass subjektive Phänomene Eigenschaften haben, die sich nicht in der strukturellen Ähnlichkeit erschöpfen. Die kohärente Strukturen beschränken das beobachtbare Verhalten subjektiver Phänomene, aber erschöpfen sie nicht. (vgl.p.213)

-

Sofern man solch eine strukturelle Kohärenz feststellen kann, macht es nach Chalmers Sinn, die empirischen Phänomene der Aufmerksamkeit als Korrelate bewusster Erfahrung zu bezeichnen.

PRINZIP DER ORGANISATORISCHEN INVARIANZ

-

Chalmers formulierte noch ein weiteres Prinzip, das von der organisatorischen Invarianz. Es ist kein mathematisches Prinzip, sondern eher ein Postulat über empirische Strukturen.

-

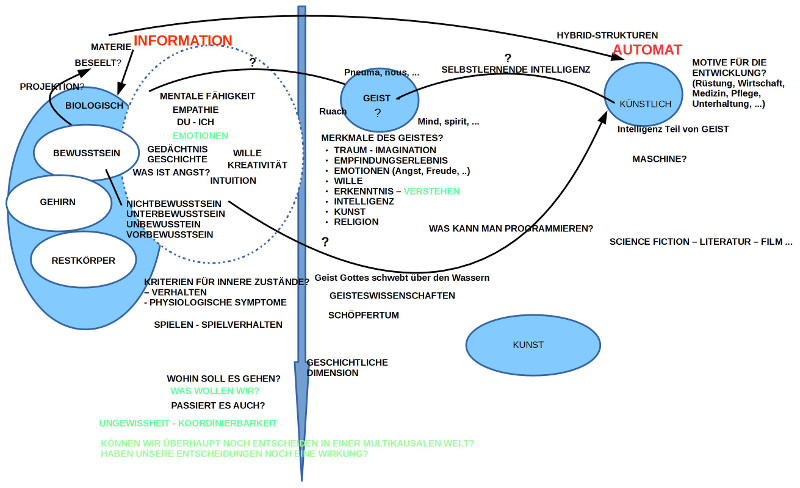

Ausgangspunkt sind zwei Systeme S1 und S2. Beide haben eine funktionale Organisation, d.h. Es gibt jeweils irgendwelche Mengen von Elementen M1 und M2 und jeweils irgendwelche Funktionen F1 und F2, die über den Mengen M1 und M2 definiert sind, also S1(x) iff x=<M1,F1> bzw. S2(x) iff x=<M2,F2>.

-

Chalmers postuliert nun, dass, wenn beide Systeme S1 und S2 die gleiche funktionale Organisation haben (‚functional organization‘), dass sie (?) dann auch die qualitativ gleiche Erfahrung (‚qualitatively identical experience‘) haben.

-

Diese Formulierung wirft einige Fragen auf.

-

Nimmt man an, dass er mit Erfahrung wie zuvor im Text immer die Erfahrung des Bewusstseins meint, dann stellt sich die Frage, in welchem Sinne ein System S1 oder S2 eine bewusste Erfahrung haben sollen? Nach allem zuvor Gesagtem haben empirische Systeme nicht notwendigerweise eine bewusste Erfahrung.

-

Wenn Chalmers aber meint, dass die Systeme S1 und S2 für empirische Systeme stehen, die Korrelate von bewussten Erfahrungen sind, dann würde das Prinzip besagen wollen, dass zwei verschiedene empirische Systeme S1 und S2, die Korrelate von jeweils einem Bewusstsein B1 bzw. B2 sind, diesen korrelierenden Bewusstseinen B1 und B2 jeweils identische Erfahrungen übermitteln.

-

Direkt beweisbar ist dieses Prinzip nicht, da der direkte Zugriff auf bewusste Erfahrungen von den beiden Bewusstseinen fehlt, aber es ist eine sehr plausible Arbeitshypothese. (vgl. p.215) Diese Arbeitshypothese würde es zumindest ansatzweise verständlich machen, warum zwei verschiedene Menschen ansatzweise über ähnliche Erfahrungen verfügen können.

DIE THEORIE DES DOPPELTEN ASPEKTS DER INFORMATION

-

Chalmers klassifiziert die beiden vorausgehenden Prinzipien als nicht basale Prinzipien. Nichts desto Trotz sind sie für ihn hilfreiche Beschränkungen (‚constraints‘).

-

Jetzt will er ein erstes basales Prinzip mit Hilfe des Begriffs der Information einführen.

-

Bei dieser Einführung des Begriffs Information bezieht er sich zwar ausdrücklich auf Shannon (1948), ersetzt aber die Begrifflichkeit von Shannon sogleich durch die Begrifflichkeit von Bateson (1972), indem er die einzelnen physikalischen Informationen als Differenzen bezeichnet, die eine Differenz konstituieren (Originalzitat Bateson: A „bit“ of information is definable as a difference which makes a difference. Such a difference, as it travels and undergoes successive transformation in a circuit, is an elementary idea. (Bateson 1972, p.335)

-

Dann überträgt er diese Begrifflichkeit auf die empirischen und auf die subjektiven Phänomene, indem er für die Menge der korrelierenden empirischen Phänomene einen Informationsraum Ie postuliert und für die Menge der subjektiven Phänomene auch einen Informationsraum Is. Ferner postuliert er, dass die Elemente in jedem dieser Räume durch eine Menge von Differenzen charakterisiert werden – also <Ie,De> sowie <Is, Ds> –, dass jedem dieser Räume mit diesen Differenzen dann eine Struktur Ste(x) iff x= <Ie,De> sowie Sts(x) iff x=<Is, Ds> zukomme, die sich direkt korrespondieren (‚directly correspond‘), also CORR(STe, Sts).

-

Aus den Postulaten werden dann sogleich Behauptungen der Art, dass man sowohl in den empirischen Prozessen wie auch in den subjektiven Erfahrungen die gleichen abstrakten Informationsräume finde.

-

Nachdem Chalmers die Begriffe Information und Differenz für die theoretische Beschreibung eingeführt hat (niemand hat ihn dazu gezwungen!), folgert er dann aus seinen eigenen Annahmen, als Hypothese, dass Information zwei Aspekte habe: einen physikalischen und einen phänomenalen (:= subjektiven).

-

Nach diesen begrifflichen Verschiebungen erklärt er dann diese letzte Hypothese zu einem basalen Prinzip, aus dem hervorgehe, dass sich immer dann Erfahrung eines Bewusstseins vorfindet, wenn ein entsprechender physikalischer Prozessraum gegeben ist.(vgl. p.216)

DISKURS

KEINE DOPPEL-ASPEKT THEORIE DER INFORMATION

-

Chalmers selbst klassifiziert seine Doppel-Aspekt Überlegungen als eher eine Idee denn eine Theorie (vgl. p.217) bzw. weiter vorne als extrem spekulativ und unterbestimmt.

-

Dies würde ich hier unterschreiben. Denn die Verwendung des Wortes Information durch Chalmers erscheint sehr fragwürdig.

-

Der Informationsbegriff bei Shannon (1948) setzt einen sehr speziellen Kontext voraus, auf den Shannon klar und deutlich hinweist. Es geht bei der Verwendung des Begriffs der Information bei Shannon NICHT um den Begriff von Information, wie er im Alltag oder bei wichtigen biologischen Kontexten vorkommt, wo unterschiedliche bedeutungsvolle/ semantische Kontexte eine Rolle spielen, sondern AUSSCHLIESSLICH um die jeweiligen Signalereignisse und deren Wahrscheinlichkeiten. Diese Signalereignisse als solche haben weder irgendeinen Informationswert noch eine irgendwie geartete Bedeutung. Es sind einfach Eigenschaften aus einem Eigenschaftsraum, die sich natürlich qua Eigenschaften durch Unterschiede/ Differenzen indirekt charakterisieren lassen. Aber der Begriff der Differenz setzt ein X und Y voraus, die minimale Eigenschaften Px und Py besitzen, aufgrund deren sie sich unterscheiden lassen. Nur unter Voraussetzung von solchen Elementen samt Eigenschaften lässt sich eine Differenz definieren. Ein System von Differenzrelationen setzt mathematisch eine Menge von Elementen voraus, aufgrund deren sich die Relationen definieren lassen.

-

Der Sprachgebrauch von Bateson (1972) mit seinen Differenzen mag irgendwie interessant klingen, ist aber mathematisch irreführend. Eine Differenz ist abgeleitet von dem X, das sich von anderem Nicht-X unterscheiden lässt. Die Unterscheidbarkeit von Ereignissen X in der Wahrnehmung ist biologisch natürlich bedeutsam, aber das Ereignis als solches keinesfalls, nur die Relationen zu einem Y, das sich biologisch als ‚relevant‘ erweist.

-

Streichen wir also den Begriff der Differenz im Kontext von Information, da redundant, bleibt der Informationsbegriff, angeblich nach Shannon.

-

Bei Shannon aber ging es nur um Signalereignisse und deren wahrscheinliches Auftreten, ohne jeglichen Bedeutungsbezug.

-

Natürlich kann man sowohl die empirischen wie auch die subjektiven Phänomene abstrakt als Ereignisse betrachten, die mit gewissen Wahrscheinlichkeiten auftreten. Das würde aber genau jene Qualitäten an diesen Ereignissen verdecken, die sie für ein biologisches System interessant machen. Biologisch interessant sind ausschließlich Ereignisse, sofern sie Bezug haben zum Überleben generell und innerhalb dessen zu speziellen Kontexten des Überleben. Es sind gerade diese Kontexte, die sich mit Ereignissen assoziieren lassen, durch die Ereignisse mit Bedeutung aufgeladen werden, sodass diese Ereignisse im biologischen Sinn informativ sind.

-

Dieser fundamentale Aspekt von Information wurde von Shannon ganz bewusst ausgeklammert, da er dies für seinen Anwendungsfall nicht benötigt hat. Bateson und Chalmers brauchen es eigentlich, folgen hier aber – blindlings? – Shannon, obgleich dieser sogar ein großes Warnschild gleich zu Beginn seines Textes aufgestellt hat. DIES IST NICHT INFORMATION IM ÜBLICHEN SINNE!!!

STRUKTURELLE KOHÄRENZ VON WAS?

-

Nach dieser Entmystifizierung des Differenz- und Informationsbegriffs bleibt von der Doppel-Aspekt Theorie der Information nur noch das übrig, was Chalmers schon zuvor mit dem nicht-basalen Prinzip der strukturalen Kohärenz ausgedrückt hat, dass nämlich die korrelierenden empirischen Phänomene und die subjektiven Phänomene strukturell ähnlich seien. Chalmers bleibt eine Definition jener Strukturen schuldig, die er als gegeben voraussetzt, von denen er immerhin sagt, dass sie isomorph seien, und doch wiederum nicht so, dass alle subjektiven Phänomene durch die empirischen Phänomene dadurch voll bestimmt wären. Eigentlich impliziert Isomorphie eine 1-zu-1 Abbildung; aber dann doch nicht ganz? Was meint er dann?

-

Wenn man von einer Strukturähnlichkeit zwischen zwei Strukturen S1 und S2 spricht, geht man normalerweise davon aus, dass die beiden Strukturen S1 und S2 nicht nur einfach gegeben sind, sondern auch in ihrer Beschaffenheit genau beschrieben/ definiert sind. Kann man das von den subjektiven Phänomenen des Bewusstseins sagen? Außer von Husserl sind mir keine ausführlichen Untersuchungen zu den Phänomenen des Bewusstseins bekannt, und von Husserls Untersuchungen kann man weder sagen, sie seien vollständig noch liegen sie in einer Form vor, die man als formal befriedigend bezeichnen könnte (obwohl Husserl von der Ausbildung her auch Mathematiker war und von daher das Rüstzeug haben konnte). Diskutabel wäre hier vielleicht Carnaps logischer Stufenbau (1928), der der Struktur von Husserl – soweit bekannt – sehr eng folgen soll. Wovon also spricht Chalmers, wenn er die Strukturähnlichkeit zwischen empirischen und subjektiven Phänomenen behauptet?

WAS BLEIBT VON CHALMERS KRITIK?

NICHTREDUZIERBARKEIT

-

Der zentrale Punkt von Chalmers Kritik dürfte wohl die Nichtreduzierbarkeit des Subjektiven auf Empirisches sein. Im subjektiv zugänglichen Erfahrungsraum des Bewusstseins erschließen sich Phänomene, die über die rein objektiv-empirischen Phänomene hinausgehen.

-

In seiner ablehnenden Kritik empirischer Ansätze kommt immer wieder auch der Begriff der Funktion vor; funktionale-empirische Erklärungsansätze sollen nicht reichen. Diese Formulierung kann missverständlich sein. Denn der Versuch, den Raum der subjektiven Phänomene als Phänomene sui generis zu beschreiben, wird – wie auch im Fall empirischer Phänomene – Elementarereignisse einführen, über diese Elementarereignisse diverse Relationen und Funktionen, und damit letztendlich eine Struktur des subjektiven Phänomenraumes definieren, mittels der man dann möglicherweise Vergleiche, Abbildungen auf andere Strukturen vornehmen kann, z.B. auch, wie von Chalmers praktiziert, auf die Struktur der mit dem Bewusstsein korrelierenden empirischen Phänomene.

-

Hier stellt sich allerdings das spezielle Problem einer simultanen Abhängigkeit von korrelierenden empirischen und subjektiven Phänomenen: man kann ja nur in dem Maße davon sprechen, dass ein empirisches Phänomen Pe mit einem subjektiven Phänomen Ps korreliert, wenn es ein subjektives Phänomen Ps gibt, das als Ausgangspunkt dient! Ein empirisches Phänomen Pe als solches lässt keinerlei Rückschluss auf ein irgendwie geartetes subjektives Phänomen Ps zu. Die Brückenprinzipien, von denen Chalmers in seinem Artikel spricht, sind induktiv simultan zu definieren. Sie sind nicht einfach da. Es sind nicht die Brückenprinzipien, mittels deren man aus den empirischen Phänomenen Pe die subjektiven Phänomene Ps ableitet, sondern es sind die subjektiven Phänomenen Ps, die sich mit empirischen Phänomenen Pe korrelieren lassen, und aufgrund solcher realisierten Korrelationen kann man vielleicht Brückenprinzipien definieren.

-

Dies gilt insbesondere auch am Beispiel der sprachlichen Äußerungen, die Chalmers explizit als Indikatoren möglicher subjektiver Erfahrung nennt. Der Sprachschall als solcher bildet ein empirisches Phänomen Pe, dem möglicherweise subjektive Bedeutungsinhalte Ps korrelieren können. Ob dies der Fall ist, kann nur der Sprechende selbst entscheiden, sofern er einen direkten Zugang zu seinen subjektiven Phänomenen hat und von daher weiß, ob sich mit einem bestimmten Sprachschall tatsächlich ein bestimmter subjektiver Sachverhalt verknüpft. Von daher sind sprachliche Äußerungen niemals ein Ersatz für die damit hypothetisch unterstellten subjektiven Phänomene.

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.