Zusammenfassung

Ausgehend von einem Artikel von A.Fink werden hier einige Gedanken geäußert, die sich auf die Art und Weise beziehen, wie der Begriff Gott in diesem Artikel benutzt wird. Dies reicht bis hin zu den Grundannahmen unseres menschlichen Erkennens.

I. Kontext

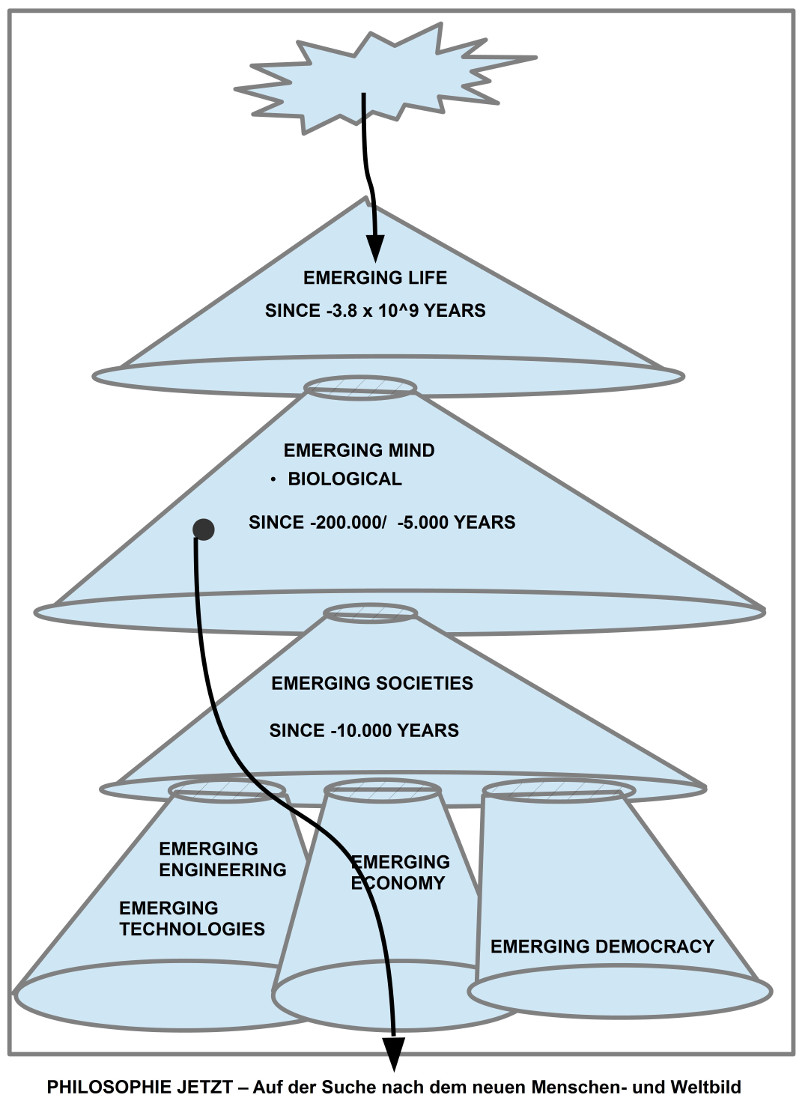

Durch einen Hinweis wurde ich aufmerksam auf den Artikel von Alexander Fink (2017) [Fink:2017] zur Themenstellung Kosmologie und der Glaube an Gott. Diese Themenstellung, geschrieben aus einer christlichen Perspektive, erscheint mir interessant, da im Kontext dieses Blogs das Verhältnis von Philosophie und Wissenschaft zur Debatte steht, hierin speziell fokussiert auf die Frage der möglichen Symbiose von Menschen und intelligenten Maschinen in der Zukunft. Während das Konzept intelligente Maschine vergleichsweise einfach erscheint, bietet das Konzept Mensch unfassbar viele komplexe Fragestellungen. Unter anderem auch deswegen, da wir heute immer mehr zu erkennen meinen, dass der heutige Mensch das Ergebnis einer komplexen Entstehungsgeschichte ist, sowohl des Universums als ganzem wie auch der komplexen Evolution des Lebens innerhalb der Entwicklung des Universums. Seit dem Auftreten des Menschen als homo sapiens hat der Mensch immer komplexere Umgebungen geschaffen, zu denen neben Weltbildern zur Weltdeutung neuerdings auch intelligente Maschinen gehören, die seine selbst geschaffene Umwelt weiter anreichern.

Im Bereich der Weltbilder wird heute im Bereich der Wissenschaften gewöhnlich unterschieden zwischen sogenannten wissenschaftlichen Bildern der Welt — wissenschaftliche Theorie genannt — und solchen Überzeugungen, die Menschen in ihrem Alltag zwar auch benutzen, die aber nach den methodischen Prinzipien der empirischen Wissenschaften nicht als überprüfbar gelten. Daraus muss allerdings nicht denknotwendig folgen, dass diese Überzeugungen im nicht-wissenschaftlichen Format von vornherein falsch sind.

Ein prominenter Bereich solcher im Alltag verhafteter Überzeugungen ohne eine direkte wissenschaftliche Unterstützung ist der Bereich der religiösen Überzeugungen und der religiösen Erfahrungen, hier speziell die Auffassung, dass die bekannte Wirklichkeit auf ein — letztlich nicht genau beschreibbares — höheres Wesen zurückgeht, das mit unterschiedlichsten Namen Gott genannt wird. [Anmerkung: An dieser Stelle die Wortmarke ‚Gott‘ zu benutzen ist ein eher hilfloses Unterfangen, da in den verschiedensten Religionen und Kulturen ganz verschiedene Wortmarken benutzt werden, von denen nicht ohne weiteres klar ist, was sie meinen und ob sie von daher miteinander überhaupt vergleichbar sind. Die großen religionswissenschaftlichen Untersuchungen legen allerdings die Hypothese nahe, dass zumindest die großen Religionen wie Hinduismus, Buddhismus, Judentum, Christentum und Islam (mit jeweils vielen Spielarten) letztlich einen gemeinsamen Gottesbegriff haben, sofern es darum geht, wie in diesen Religionen Gott von den einzelnen Menschen erfahren wird. Im Glauben versuchen jene Menschen, die sich ‚Gläubige‘ nennen, diesem höchsten Wesen ‚Gott‘ Rechnung zu tragen, im Alltag und speziell im Lichte wissenschaftlicher Überzeugungen ist dann oft wenig oder gar nicht klar, wie sich denn die bekannte Wirklichkeit (einschließlich des Menschen selbst) zu dem höchsten Wesen des Glaubens verhält.]

An dieser Stelle versucht der Artikel von Fink einen Antwort zu geben für den speziellen Bereich physikalische Sicht des Universums auf der einen Seite und christlicher Glaube an einen Schöpfergott andererseits.

II. Fink – Denkrahmen

Der Artikel ist gut lesbar geschrieben und stellt ziemlich umfassend die Fakten zusammen, die die heutige Physik zur Beschaffenheit, Entstehung und Dynamik des physikalischen Universum zusammengetragen hat, ohne dabei in technische Details abzugleiten. Von daher ist es sicher ein Gewinn, wenn jemand diesen Artikel liest.

Im Artikel zeigen sich dabei grob zwei Argumentationslinien: (i) Die physikalischen Fakten, die das heutige Bild des physikalischen Universums konstituieren, und (ii) die Ansatzpunkte für eine Deutung der physikalischen Fakten im Lichte eines vorausgesetzten christlichen Glaubens an ein bestimmtes Bild eines Schöpfergottes.

A. Physikalische Fakten

Als physikalische Fakten werden z.B. genannt die räumliche Ausdehnung des Universums; eine Größe, die die alltägliche Vorstellung von räumlichen Verhältnissen jenseits alles Vorstellbaren sprengen. Dazu die zeitliche Dauer der ganzen Prozesse, die auch sowohl im ganz Großen von Milliarden Jahren sich der Vorstellung entzieht wie auch im ganz Kleinen, zu Beginn der Entstehung des bekannten Universums; hier gerät man in Größenordnungen von 10^-44 Sekunden. Die Präzision der Feinabstimmung der bekannten physikalischen Parameter, damit das Universum genau die heute bekannte Struktur und Eigenschaften angenommen hat, und nicht nirgend eine der unendlich vielen anderen Möglichkeiten.[Anmerkung: So nennt Fink z.B. für die Abstimmung der dunklen Energiedichte zur gravitativen Energiedichte eine Größenordnung von 1:10^60, für das Verhältnis von Gravitation zur elektromagnetischen Kraft eine Genauigkeit von 1:10^40]. Dazu kommen Erkenntnisse zu den Besonderheiten der Erdchemie, wie z.B. die außergewöhnlichen Fähigkeiten von Kohlenstoff im Vergleich zu anderen chemischen Verbindungen (wie z.B. Silizium), sowie die vielseitigen Eigenschaften des Wassermoleküls. Er verweist ferner auf die das Leben begünstigende Konstellation des Erd-Sonnensystems, auf die geschützte Position des Erd-Sonnensystems innerhalb der Milchstraße, sowie auf die Funktion des Magnetfeldes, und einiges mehr.

Obgleich Fink das Phänomen des biologischen Lebens mit seiner komplexen Evolutionsgeschichte weitgehend ausblendet, bieten schon die genannten physikalischen Fakten im engeren Sinne viele Ansatzpunkte, um Deutungen vornehmen zu können.

B. Physik und Gott

Während Fink im Falle der Physik ansatzweise die historische Entstehung der physikalischen Bilder anspricht, vermisst man diese im Fall der Auffassung von Gott als Schöpfer. Ohne historische Herleitung aus der Geschichte des christlichen Glaubens stellt Fink einfach fest, dass das mit der Wortmarke ‚Gott‘ Gemeinte einen freien Willen habe, rational denke und sich zuverlässig verhalte. Dies sei die tiefere Ursache dafür, dass das Universum für die menschlichen Forscher gesetzmäßig erscheine, d.h. man kann es mit rationalen Mitteln erforschen. Die hier zur Verwendung kommenden Begriffe (freier Wille, rational, zuverlässig) sind Begriffe, die im Kontext der menschlichen Welterfahrung eine gewisse — wenngleich vage — Bedeutung haben. Wendet man sie aber ohne weitere Erläuterungen direkt auf ein unbekanntes Etwas an, das irgendwie hinter und in dem ganzen Universum stehen soll, ist es nicht direkt nachvollziehbar, was diese Begriffe in diesem umfassenden Kontext bedeuten können.

Zusätzlich zu der allgemeinen Verstehbarkeit des physikalischen Universums verweist Fink auch auf jene Momente hoher Unwahrscheinlichkeit, die bei der Wahl der Parameter am Werk zu sein scheinen und die er als Argument für eine mögliche Zielgerichtetheit der ganzen Entwicklung des Universums sieht, die er wiederum als Argument für den als rationalen zuverlässigen Schöpfer mit freiem Willen angenommen hatte. Dieser Schöpfergott hat also zusätzlich noch einen Plan.

III. Kritische Anmerkungen

A. Gottesbilder

In diesem Blog gibt es mehrere Beiträge, die sich mit dem Problem beschäftigt haben, die Bedeutung der Wortmarke ‚Gott‘ in ihrer historischen Vielfalt klären zu können.

Schränkt man die Frage ein auf die christliche Tradition, so hat man es immerhin mit mittlerweile fast 2000 Jahren Interpretationsgeschichte zu tun, dazu die jüdische Vorgeschichte und die vielfältigen Wechselwirkungen mit den umgebenden Gesellschaften und Kulturen im Laufe der Jahrhunderte. Dazu kommen die diversen Aufspaltungen der christlichen Tradition in Traditionen mit unterschiedlichen Schwerpunkten (West zu Ost, Katholisch und Protestantisch, dazu viele Unterarten). In dieser gewaltigen und vielschichtigen Tradition zu sagen, was die christliche Meinung zum Schema Schöpfergott sei, erscheint fast unmöglich. Natürlich kann man sich auf einzelne Autoren beschränken oder auf speziell ausgezeichnete Lehrmeinungen, aber inwieweit diese dann als die christliche Auffassung gelten können, erscheint doch eher fraglich.

Geht man auf die historisch frühen Quellen zurück, zu den sogenannten heiligen Schriften des Neuen Testamentes, das vielfältig Bezug nimmt auf das Alte Testament, so wird die Lage nicht unbedingt einfacher. Zeigen doch gerade die 2000 Jahre andauernden Interpretationsversuche, dass es offensichtlich keine zwingend eindeutige Interpretation zu geben scheint, wie sonst hätte es sonst zu den vielen unterschiedlichen Interpretationen kommen können.[Anmerkung: Untersucht man nur die vielfältigen Übersetzungen vom Hebräischen ins Griechische und Lateinische, vom Lateinischen in die vielen Alltagssprachen, vom Griechischen in die vielen Alltagssprachen, dann sieht man schon auf dieser ersten Kodierungsstufe von möglichen Bedeutungen, dass es schon an der Wurzel keine eindeutige Bedeutung gibt.]

Aufgrund der Erkenntnisse zu der Art und Weise wie Sprache funktioniert, wie Menschen Wahrnehmen, Erinnern, Denken und kommunizieren, kann man seit mehr als 100 Jahren immer besser verstehen, warum Texte als solche keine zwingenden Botschaften enthalten können! Es gibt zwar zu allen Zeiten viele Menschen, die das behaupten und glauben, aber die reale Funktion von Sprache und menschlichem Erkennen können solche — oft fundamentalistisch genannten — Auffassungen als grob falsch erweisen.

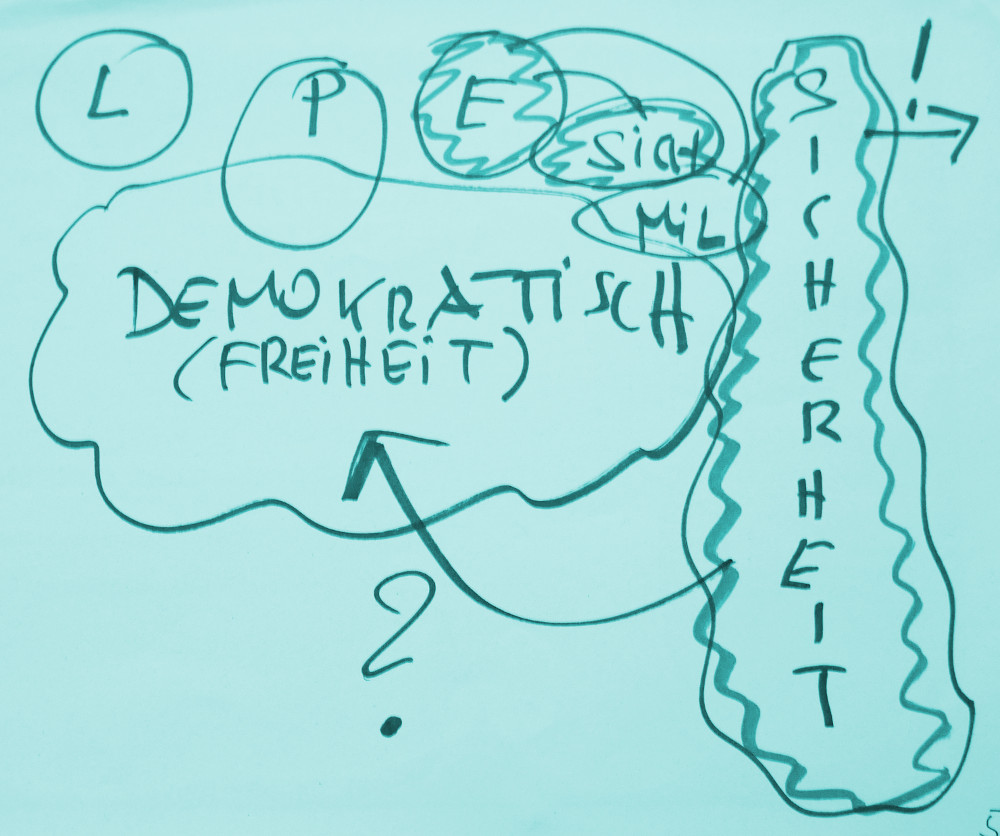

Für Menschen, die ernsthaft Sicherheit und Wahrheit suchen, sind diese neuen Erkenntnisse beunruhigend; nicht wenige lehnen sie daher ab. Dies hilft aber nicht weiter. Wir müssen uns den Tatsachen stellen, dass unsere Suche nach Wahrheit und Sicherheit nicht so einfach durch Bezug auf irgendeinen Text eingelöst werden kann, und mag er von manchen Menschen als noch so heilig bezeichnet werden.

Menschen, die sich gegen diese neuen Erkenntnisse zur Natur von sprachlichem Verstehen und Verstehen wehren, machen oft nach einen weiteren Fehler: aus der Tatsache der Unmöglichkeit einer direkten absoluten Erkenntnis aus einem Text heraus folgern sie oft, dass es dann ja überhaupt keine Wahrheit geben würde. Dieser weitreichende Schluss folgt aus der Relativierung von Texten und sprachlicher Bedeutung nicht zwingend.

Wenn jemand im Lichte des modernen Wissens die allzu einfache Deutungen sogenannter heiliger Texte in Frage stellt, sie kritisiert, dann bedeutet dies zunächst nur, dass man sich ein paar mehr Gedanken machen muss als bisher, wie man die Wirklichkeit insgesamt deuten kann. Die Kritik an einer nativen und unkritischen Verwendung eines Gottesbegriffes, eines bestimmten, sehr menschlichen Bildes von einem Schöpfergott, muss daher nicht notwendigerweise heißen, dass man damit das damit Gemeinte (eine irgendwie geartetes Etwas, was hinter und in allem steckt/ wirkt/ …) als solches in Frage stellt oder zerstört. Wenn es tatsächlich so etwas wie ‚Gott‘ geben sollte (mag man es nun glauben oder nicht), dann würde die Existenz und die Art und Weise dieses Gotes mit Sicherheit nicht davon abhängen, ob ein paar Exemplare des homo sapiens darüber sprechen, und wie sie darüber sprechen. Allerdings kann es für uns, die wir uns als Exemplare des homo sapiens ansehen, möglicherweise einen Unterschied machen, ob und wie wir über dieses Thema reden.

B. Bilder der Welt

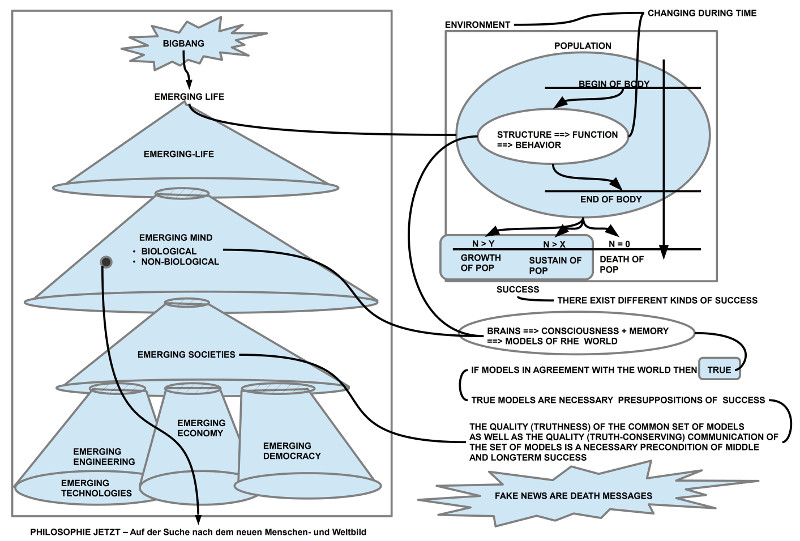

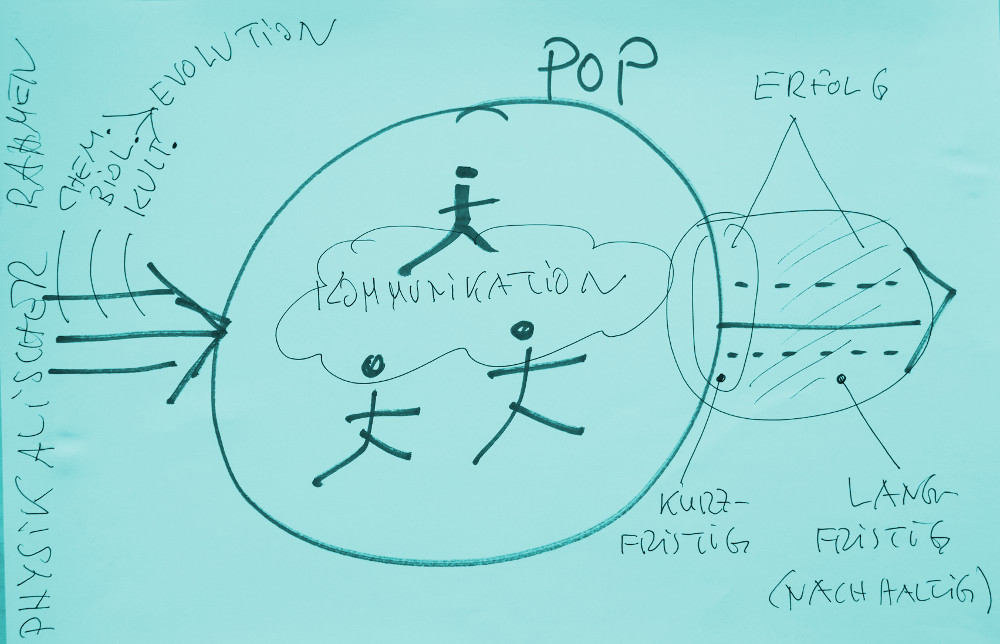

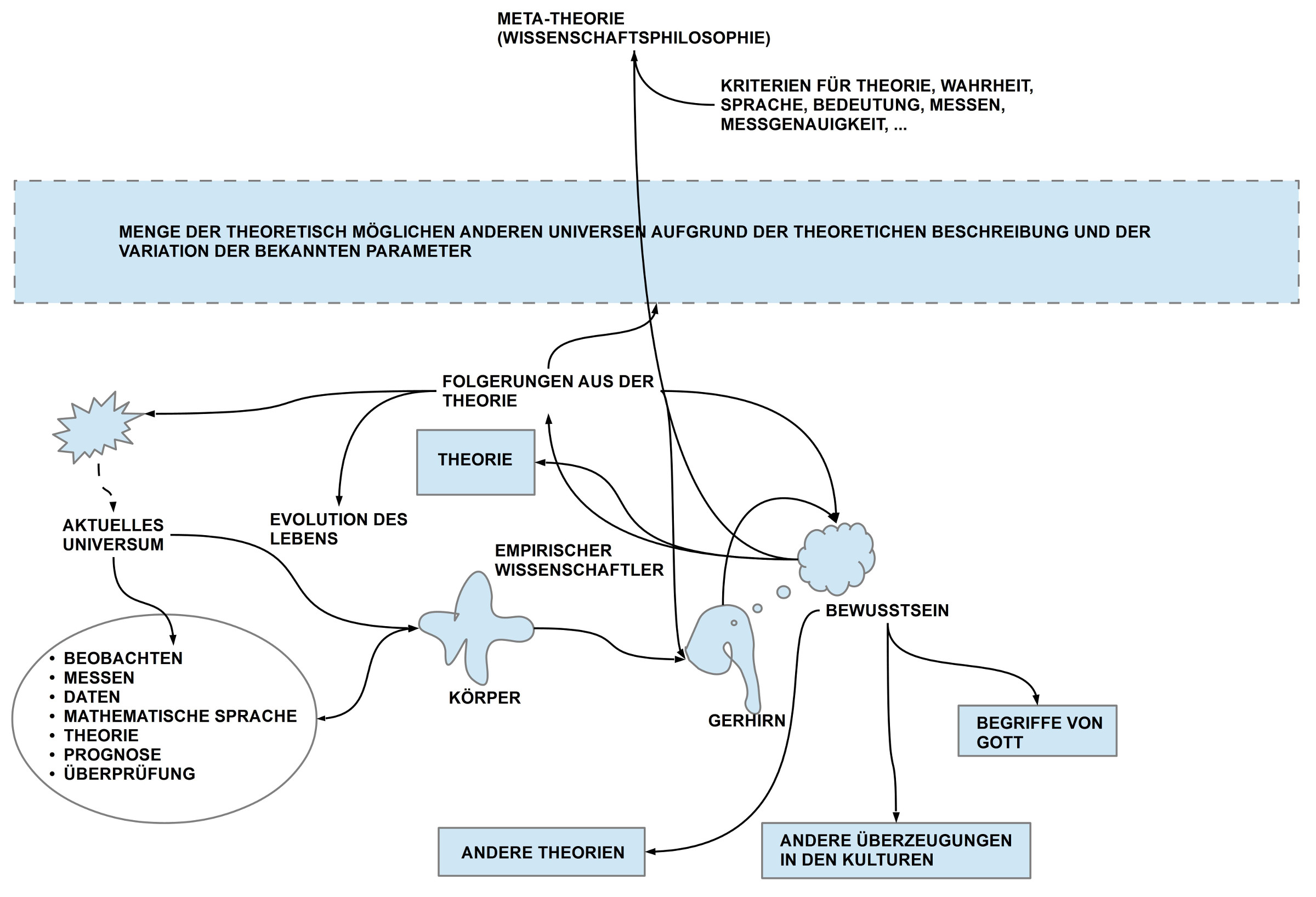

Bei der kritischen Diskussion des Artikels von Fink spielen eine Reihe von Faktoren eine Rolle. Einige im Zusammenhang mit der Verwendung der Wortmarke ‚Gott‘ wurden im vorausgehenden Abschnitt angesprochen. Weitere sollen jetzt hier angesprochen werden. Das Schaubild oben kann dazu vielleicht hilfreich sein.

1) Evolution

Aus den letzten ca. 100 Jahren konnten wir lernen, dass wir Menschen Teil eines Entwicklungsprozesses sind, die die Biologen als Evolution des biologischen Lebens bezeichnen. Ferner konnte die Struktur und die Entwicklung des bekannten physikalischen Weltalls soweit aufgehellt werden, dass auch das Zusammenspiel von Sternentwicklung und Entstehung von biologischem Leben auf der Erde viele neue, tiefe Einsichten ermöglicht hat.

2) Empirisches Wissen

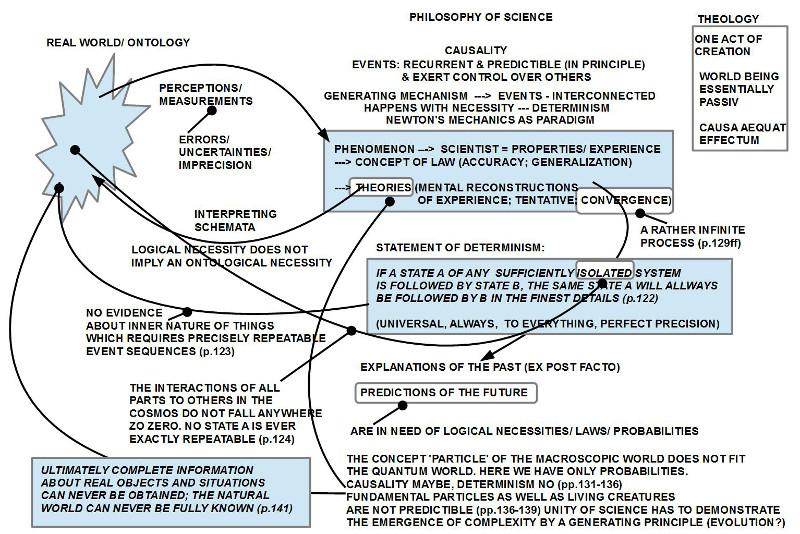

Dies alles wurde möglich, weil die Menschen gelernt haben, wie man Bilder von der Welt in einer methodisch kontrollierten Weise so konstruiert, dass sie auf transparenten, reproduzierbaren Messoperationen aufbauen. Für die Interpretation dieser Messwerte wird eine mathematische Sprache benutzt, die zusammen mit einer formalen Logik die Möglichkeit bietet, Regelmäßigkeiten und Strukturen zu formulieren, sofern sie in der Gesamtheit der Messwerte vorliegen. Die Geltung der formalen Strukturen ist hier entscheidbar zurückgebunden an die Messwerte.[Anmerkung: Diese Rückbindung ist zentral, da die mathematische Sprache es erlaubt, beliebig viele Regelmäßigkeiten und Strukturen zu formulieren. Ob eine von diesen möglichen Strukturen tatsächlich etwas beschreibt, was mit der umgebenden Wirklichkeit korrespondiert, können nur vorzeigbare Messwerte entscheiden. Diese Form von Wissens nennt man gewöhnlich empirisches Wissen oder eine empirische Theorie.]

3) Wirklichkeit und Mathematik

Die Entwicklung und Nutzung von empirischem Wissen stellt viele neue Fragen zur Natur des menschlichen Erkennens, die weitgehend noch ungeklärt sind. So ist es eine bemerkenswerte Tatsache, dass die umgebende Wirklichkeit sich mit den Mitteln einer extrem einfachen mathematischen Sprache und formalen Logik beschreiben lässt.[Anmerkung: Man kann zwar mit der mathematischen Sprache sehr komplexe Ausdrücke aufbauen, doch die Sprache selbst, mit der dies geschieht, ist in ihren Grundelementen extrem einfach. Es ist keine andere Sprache bekannt, die genauso einfach oder gar noch einfacher ist.] Bislang ist nicht zu sehen, dass es irgendein Phänomen in der erfahrbaren Welt geben könnte, was sich mit dieser mathematischen Sprache nicht beschreiben lässt, es sei denn, das Phänomen selbst, das beschrieben werden soll, ist ‚in sich‘ nicht klar.

4) Virtualität und Wahrheit

Ferner wissen wir heute, dass unser bewusstes Wissen, ein funktionierendes Gehirn voraussetzt, das selbst keinen Kontakt mit der realen Welt hat. Dennoch produziert es aufgrund von Sinnesdaten von außerhalb und von innerhalb des Körpers — und im Zusammenspiel mit einem Gedächtnis — beständig virtuelle Bilder einer Welt da draußen so, dass wir in unserem Bewusstsein die virtuellen Bilder als real erleben und als real deuten. Unsere menschliche Erkenntnis ist also ein als real erlebtes virtuelles Bild einer Welt ‚da draußen‘, die wir tatsächlich niemals direkt erleben werden. Wie können wir dann jemals erkennen was wahr ist, wenn Wahrheit verstanden würde als die Übereinstimmung von etwas Gedachtem mit etwas Realem?

Diese Frage springt sofort über zu dem zuvor eingeführten Konzept des empirischen Wissens. Ist es doch gerade ein Dogma des empirischen Wissens, dass dieses sich direkt mit der realen, objektiven Welt beschäftige im Gegensatz zu anderen Wissensformen. Wenn der Mensch nun grundsätzlich gar keinen direkten Kontakt zur sogenannten realen Wel haben kann, wie kann es dann empirische Wissenschaft geben?

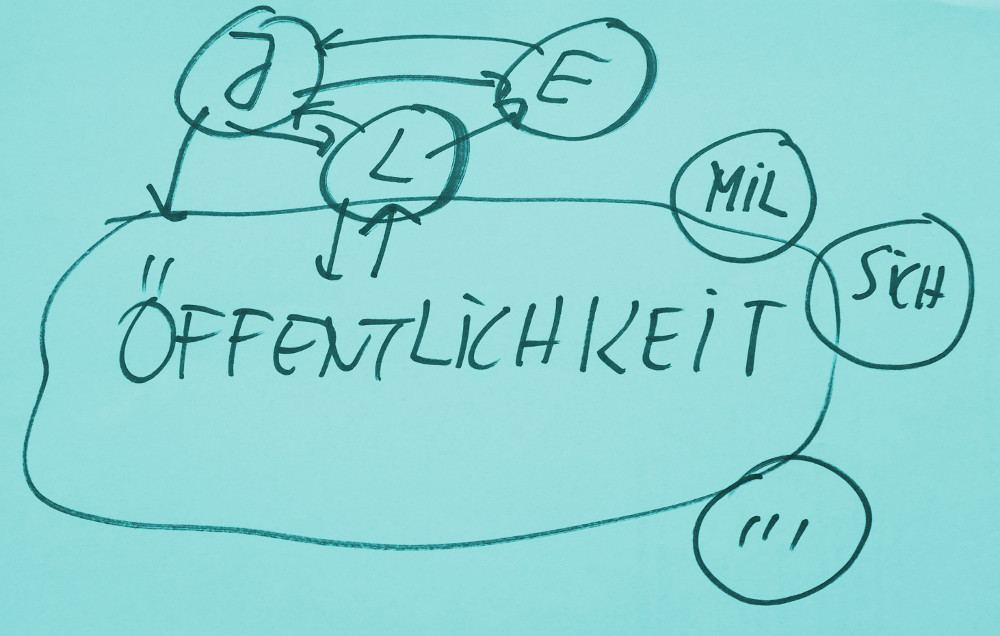

Die Antwort ist relativ einfach. Unser bewusstes Wissen ist zwar quasi Wissen aus zweiter Hand, d.h. von einem Gehirn generiert, das im Körper fest sitzt, aber von all den Phänomenen des Bewusstseins (PH), die dieses Gehirn erzeugt, gibt es eine echte Teilmenge von solchen Phänomenen PH_EMP, die aus jenen sensorischen Erregungsmustern gewonnen werden, die von den externen Sensoren (Augen, Ohren, Tastorgane, …) gewonnen werden. Für uns sind sie zwar abgeleitete, virtuelle Ereignisse, aber sie korrespondieren mit Ereignissen in der unterstellten Außenwelt. Sofern Wissenschaftler empirische Messprozesse vereinbaren, gibt es Messprozesse, die unabhängig vom Denken eines einzelnen Menschen gestartet und gestoppt werden können. Diese Messprozesse liefern Ereignisse, die mit externen Sinnesorganen registriert werden können, und zwar von allen, die diese Messprozesse wiederholen. Im Bewusstsein der beteiligten empirischen Wissenschaftler haben dieses Messergebnisse zwar weiterhin nur den Status von virtuellen Ereignissen, generiert vom Gehirn, aber diese Ereignisse lassen sich mit Messprozessen wiederholen, die alle Beteiligten in hinreichend gleicher Weise erleben können. Durch diese spezielle Maßnahme können Menschen ihr virtuelles Gefängnis methodisch partiell öffnen; nicht wirklich, aber für eine empirische Form des Erkennens praktikabel. Wir haben also die echte Teilmenge der empirischen Phänomene PH_EMP c PH, die sich partiell mit Ereignissen in der angenommenen Außenwelt (W) zusammen mit anderen parallelisieren lässt.[Anmerkung: Es ist erstaunlich, wie lange die Menschen als homo sapiens gebraucht haben, bis sie diesen ‚Trick‘ entdeckt haben. Allerdings, selbst heute (2017) scheint es noch genügend viele Menschen zu geben, die diesen Zusammenhang immer noch nicht verstehen (selbst solche, die sich empirische Wissenschaftler nennen).]

Das Potential des empirischen Wissens für das Erkennen und Verstehen der umgebenden Welt ist enorm, und seine Auswirkungen neben dem reinen Verstehen im Bereich der technologischen Anwendungen erscheint schon jetzt schier unendlich.

5) Schwache Akzeptanz von Empirischem Wissen

Nicht wirklich geklärt erscheint das Verhältnis des empirischen Wissens zu den anderen Wissensformen, speziell auch zu den alten religiösen Überzeugungen, die für die meisten auch ein Stück Welterklärung waren bzw. noch sind.

In dieser Differenz von realen Erklärungsleistungen auf der einen Seite (bei aller Begrenztheit) und den vielen unwissenschaftlichen Bildern der Welt, liegt eines der vielen Probleme der Gegenwart. Der Anteil der Menschen, die empirisches Wissen nicht verstehen oder gar offen ablehnen, liegt in Ländern mit hoher Technologie aufgrund von offiziellen Untersuchungen bei ca. 20 – 30\%; betrachtet man aber seine eigene Umgebung, einschließlich der Menschen mit mindestens einem akademischen Abschluss, dann kann man den Eindruck gewinnen, dass es vielleicht umgekehrt nur 10-20\% der Menschen sind, die überhaupt verstehen, was empirisches Wissen ist. Dies ist eine sehr beunruhigende Zahl. Damit ist nicht nur der bisherige Wissensstand langfristig bedroht, sondern die Ansatzpunkte für eine Versöhnung von empirischem und nicht-empirischen Wissen werden noch schwerer.

6) Philosophie des Empirischen Wissens fehlt

Um die Problemstellung noch zu verschärfen, muss man auch auf den Sachverhalt hinweisen, dass es selbst innerhalb des empirischen Wissens große, ungelöste Probleme gibt. Dies resultiert aus der historischen Entwicklung, dass zwar mit Begeisterung immer mehr Phänomene der umgebenden Welt untersucht worden sind, das daraus resultierende empirische Wissen wurde aber nicht in allen Fällen systematisch zu einer vollen empirischen Theorie ausgebaut. Vielleicht muss man sogar sagen, dass die Physik aktuell die einzige empirische Disziplin zu sein scheint, die nicht nur vollständige empirische Theorien entwickelt hat, sondern die ihre eigene Entwicklung der Tatsache verdankt, dass ganze Theorien kritisiert und dadurch weiter entwickelt werden konnten.

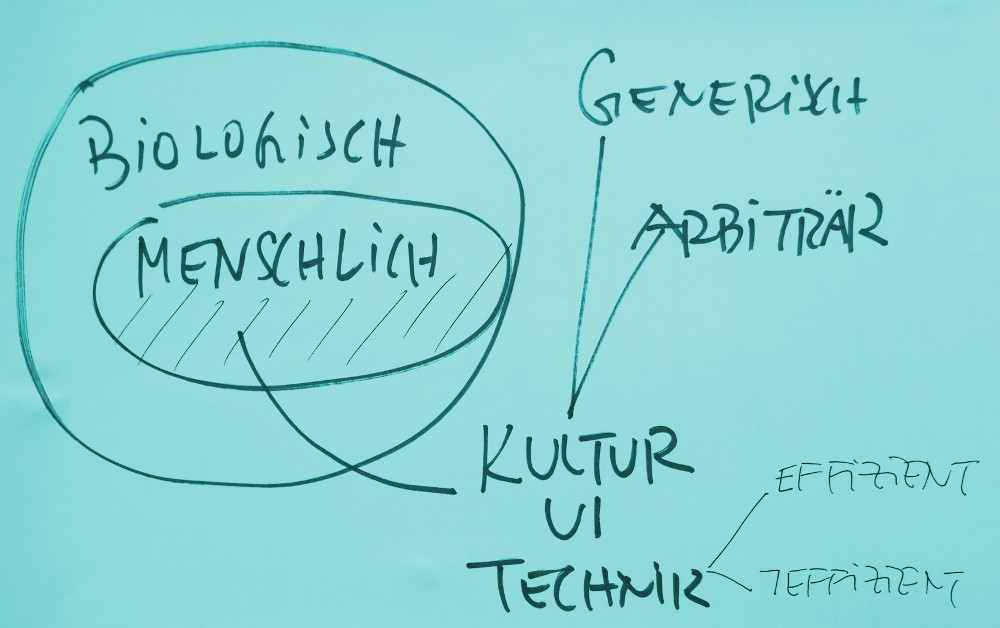

Betrachtet man Gebiete wie z.B. die Gehirnwissenschaft, die Psychologie, die Soziologie, die Wirtschaftswissenschaften, die Biologie, dann muss man allerdings berücksichtigen, dass der wissenschaftliche Gegenstand dieser Disziplinen (sofern sie sich als empirische Disziplinen verstehen wollen), ungleich komplexer ist als die Physik. Der wissenschaftliche Gegenstand der Physik erscheint komplex, da wir hier bislang die meisten vollen Theorien haben, aber tatsächlich ist das Gegenstandsgebiet der anderen genannten Disziplinen unendlich viel komplexer. Dies resultiert aus der unfassbaren Komplexität des Phänomens biologisches Leben, das sowohl in den Grundformen der einzelnen biologischen Zellen, wie dann erst recht in der Interaktion von Billionen (10^12) von Zellen in einem einzelnen Organismus wie einem homo sapiens vorliegt; dazu kommen die Wechselwirkungen zwischen allen biologischen Lebensformen, nicht nur beim homo sapiens, der die Erde zur Zeit auf vielfache Weise mit sekundären komplexen Artefakten überzieht, die dynamisch sind.

7) Empirisches Wissen und Gott

Wenn man all dies weiß, wenn man sowohl um die Begrenztheit des empirischen Wissens weiß und um die Problematik der rechten Verwendung der Wortmarke ‚Gott‘, dann stellt sich die Frage, wie kann ein Mensch in der heutigen Welt noch an ein — wie auch immer geartetes — ‚höheres Wesen in und hinter allem‘ glauben? Kann man es überhaupt noch? Und falls ja, wie?

Hält man sich die Vielfalt der religiösen Anschauungen und Praktiken vor Augen, die es im Laufe der letzten Jahrtausende gegeben hat und ganz offensichtlich immer noch gibt, dann könnte man im ersten Moment völlig entmutigt werden angesichts dieser Fülle: was davon soll jetzt sinnvoll und richtig sein?

Die modernen Religionswissenschaften und vergleichenden Kulturwissenschaften haben einiges getan, um Ähnlichkeiten und Unterschiede in diesem Meer der Phänomene heraus zu arbeiten. Sehr beeindruckend fand ich das Buch von Stace (1960), der auf der Basis von vielen vergleichenden Untersuchungen eine sehr detaillierte philosophische Analyse durchgeführt hat, die sich auf den Kern religiöser Überzeugungen fokussiert hat, auf die religiösen Erfahrungen.[Anmerkung: Siehe dazu die Diskussion dieses Buches, Teil 3]

Seine Untersuchungen legen den Schluss nahe, dass es bei aller Verschiedenheit der religiösen Ausdrucksformen und Formulierungen durch alle Zeiten hindurch und quer zu allen religiösen Formen so etwas wie einen gemeinsamen Erfahrungskern zu geben scheint, der für den Menschen als Menschen charakteristisch scheint, und der nicht an irgendwelche Texte oder lokale Traditionen gebunden ist. Dass es dennoch zu unterschiedlichen Formulierungen und unterschiedlichen Interpretationen kommen konnte liegt in der Analyse von Stace (und auch im Lichte dieses Textes; siehe die vorausgehenden Abschnitte), einzig daran, dass der Mensch nicht nur konkrete Sinneserfahrungen hat, sondern zugleich immer auch von seinem angelernten Wissen aus diese Sinneserfahrungen interpretiert. Unser Gehirn arbeitet so, dass es uns (was eigentlich sehr gut ist) alle unsere sinnlichen Erfahrungen sofort im Lichte der gespeicherten Erfahrungen interpretiert. Da die Menschen an verschiedenen Orten und zu verschiedenen Zeiten unterschiedliche Dinge gelernt haben, dazu verpackt in eine der vielen zehntausenden (oder mehr) Sprachen, erscheinen die gleichen Grunderfahrungen als tausende unterschiedliche Erfahrungen, obgleich sie — so scheint es — letztlich eine gleiche Grundstruktur haben.

Sollten diese Untersuchungen und Überlegungen stimmen, dann wären sogenannte religiöse Erfahrungen keine erfundene Spezialitäten von irgendwelchen abnormen Menschen, sondern gehören zur Grundstruktur, wie ein homo sapiens sich selbst und die ganze Welt erfährt. Einen grundsätzlichen Widerspruch zu empirischen Wissenschaften kann es dann nicht geben, da ja die empirischen Wissenschaften nicht grundsätzlich die Erfahrungen von Menschen verneinen, sondern sich nur für bestimmte — nämlich die empirischen — Untersuchungen auf einen Teilbereich der verfügbaren virtuellen Phänomene des Bewusstseins beschränken.

Interessant ist, dass die empirischen Wissenschaften, obwohl sie sich methodisch beschränken, indirekt einen fundamentalen Beitrag zur Möglichkeit von trans-empirischen Erfahrungen geleistet haben. Die fortschreitenden Erkenntnisse im Bereich der Struktur der Materie (Atomphysik, Kernphysik, Quantenphysik, …) führen uns vor Augen, dass der alltägliche Eindruck der Abgeschlossenheit und Endlichkeit der menschlichen Körper ein — womöglich schwerwiegender — Trugschluss ist. Die scheinbar so abgeschlossenen endlichen menschlichen Körper bestehen ja nicht nur aus Billionen von eigenständigen Zellen, die eigenständig miteinander kommunizieren, sondern diese Zellen bestehen ja aus chemischen Molekülen, diese aus Atomen, und diese — wie die Physik uns lehrt — aus komplexen subatomaren Teilchen und Interaktionsverhältnissen, die permanent in Wechselwirkung stehen zu allem, was sich in einem Umfeld befindet, das viele Lichtjahre betragen kann. Hier stellen sich viele — weitgehend ungeklärte — Fragen.

Eine dieser ungeklärten Fragen betrifft das Verhältnis von Bewusstsein und diesen subatomar vorhandenen Ereignissen. Wieweit können sich diese Ereignisse direkt im Bewusstsein niederschlagen?

Eine andere Frage betrifft die Erfahrbarkeit von etwas, das wir ‚Gott‘ nennen. Durch alle Zeiten und Kulturen berichten Menschen von spezifischen Erfahrungen, die für diese Menschen über die Erfahrungen des Alltags hinaus weisen, ohne dass sie dafür plausible Erklärungen liefern können. Fakt ist nur, dass im Prinzip jeder Mensch diese Erfahrungen anscheinend machen kann (auch Tiere?). Ein Widerspruch zu empirischen Wissen muss hier nicht bestehen, im Gegenteil, die empirischen Wissenschaften liefern bislang die stärksten Argumente, dass dies im Prinzip nicht auszuschließen ist. Es fehlen allerdings bislang jegliche neue Deutungsmodelle. Die alten Deutungsmodelle sollte man eventuell vorläufig mit einem Fragezeichen versehen; möglicherweise versperren sie den Weg zu dem mit der Wortmarke ‚Gott‘ Gemeintem.

ZITIERTE QUELLEN

[Fin17] Alexander Fink. Kosmologie und der Glaube an Gott. Brennpunkt Gemeinde, 19(1):1–15, 2017.

[Sta60] W.T. Stace. Mysticism and Philosophy. Jeremy P.Tarcher, Inc., Los Angeles, 1st. edition, 1960.

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER.