Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062

14.April 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch, Frankfurt University of Applied Sciences

Email: doeben@fb2.fra-uas.de

Email: gerd@doeben-henisch.de

INHALT

I VISION RESILIENZ

II VIELE AKTEURE

III PROBLEMLÖSUNGSSTRATEGIEN

IV MENSCH UND KOMPLEXITÄT

V INGENIEURE ALS VORBILD

VI CLUB OF ROME – NUR GESTERN?

VII DER UMFASSEND DIGITALISIERTE MENSCH ENTSTEHT HEUTE

VIII SIMULATIONEN BEHERZTER NUTZEN?

IX TECHNISCHE SUPERINTELLIGENZ

X WAS KANN EIN COMPUTER?

XI DAS EI DES COLUMBUS

XII EINE NEUE MENSCH-MASCHINE SUPER-INTELLIGENZ FÜR DEN BALLUNGSRAUM?

IX QUELLEN

ÜBERBLICK

Dieser Text wurde ursprünglich als Vorbereitung für das Programmheft der Konferenz ’Der Resiliente Ballungsraum’ des Frankfurter Forschungsinstituts FFin am 13.April 2018 geschrieben. Die aktuelle Version stellt eine leicht überarbeitete Version im Anschluss an die Konferenz dar, ergänzt um Literaturangaben. Ausgehend von der Komplexität heutiger Ballungsräume wird die Frage gestellt, ob und wie wir Menschen die neuen digitalen Technologien, insbesondere auch künstliche Intelligenz, nutzen könnten, um mit dieser Komplexität besser umzugehen. Durch die langsam wachsende Erkenntnis, dass der resiliente Charakter vieler komplexer Systeme zudem ein Denken verlangt, das weit hinter die Oberfläche der Phänomene schaut, wird die Frage nach einer möglichen Unterstützung durch die neuen digitalen Technologien umso dringlicher. Im Text schält sich eine ungewöhnliche mögliche Antwort heraus, die auf eine ganz neue Perspektive in der Planungsdiskussion hinauslaufen könnte.

I. VISION RESILIENZ

Mit der Leitidee der ’Resilienz’ (1) zielt das Denken im Kern ab auf die Dimension der Überlebensfähigkeit von Ballungsräumen, die sich als dynamische Gebilde zeigen, ständigen Veränderungen unterworfen sind, ein dicht verwobenes Knäuel von Faktoren, die alle gleichzeitig miteinander in Wechselwirkung stehen. Und, ja, natürlich, wer ist nicht daran interessiert, dass diese Gebilde als konkrete Lebensräume für konkrete Menschen möglichst lange funktionsfähig bleiben. Doch, was als sinnvoller Wunsch einer breiten Zustimmung sicher sein kann, kann sehr schnell zur Last, oder gar zum Alptraum werden, wenn man auf die eine oder andere Weise zum ’realen Akteur’ werden muss.(2)

(Anmk: 1: Dieser Artikel benutzt den Resilienzbegriff, wie er in dem grundlegenden Artikel von Holling 1973 [Hol73] vorgestellt worden ist)

(Anmk: 2: Eine Auseinandersetzung mit dem neuen Lieblingswort der ’Resilienz’ im Kontext der Städteplanung findet in einem Folgeartikel in diesem Blog statt. Mit Blick auf den Städtebau siehe auch Jakubowski (2013) [Jak13] )

II. VIELE AKTEURE

Ein polyzentrischer Ballungsraum wie das Rhein-Main Gebiet zählt schon heute an die 5 Mio. Bürger, die in tausenden von unterschiedlichen Rollen Akteure sind, die den Ballungsraum nutzen, ihn auf unterschiedliche Weise gestalten, und die alle ihre Ansprüche haben, die sie befriedigt sehen wollen. (3) Jeder dieser Akteure hat ’sein Bild’ von diesem Ballungsraum. Der eigene Wohnbereich, die täglichen Wege zur und von der Arbeit, Einkäufe, Kinder zum Kindergarten oder zur Schule, vielfältige Freizeit, Großereignisse, Unwetter, Krankheiten . . . irgendwie muss alles irgendwie stimmen, muss es lebbar sein, bezahlbar…. Leiter von Firmen haben weitere spezielle Anforderungen, nicht zuletzt die Verfügbarkeit geeigneter Mitarbeiter, Planungssicherheit, möglichst geringe Kosten, Verkehrs- und Telekommunikationsanbindungen, und vieles mehr . . . Die Ämter und Fachreferate in den Kommunen stehen im Kreuzfeuer vielfältigster politischer Interessen, von Alltagsanforderungen, mangelnder Kommunikation zwischen allen Abteilungen, Bergen von Vorschriften, Mangel an Geld, Personalproblemen, einer Vielzahl von komplexen und disparaten Plänen, ungelösten Altlasten aus der Vergangenheit… Polyzentrisch heißt auch, es gibt nicht nur viele Zentren, sondern auch entsprechend viele Kapitäne, die ihre eigenen Routen haben. Wie soll dies alles koordiniert werden?

(Anmk: 3: Siehe dazu Peterek/ Bürklin (2014) [PB13], Buerklin/ Peterek (2016) [BP16] )

III. PROBLEMLÖSUNGSSTRATEGIEN

Aus der Nähe betrachtet mutiert die Vision eines resilienten Planungsraumes schnell zum bekannten Muster des ’Lösens eines Problems’: es gibt einen Ausgangspunkt, die jeweilige Gegenwart, es gibt eine Gruppe von Akteuren, die selbst ernannten Problemlöser, und es gibt verschiedene Strategien, wie man versucht, ausgehend von einer – meist nur partiell bekannten – Gegenwart brauchbare Erkenntnisse für eine unbekannte Zukunft zu gewinnen; dazu soll die Lösung – entsprechend der Vision – ’resilient’ sein.

Schaut man sich konkrete Beispiele von Planungstätigkeiten aus den letzten Monaten im Rhein-Main Gebiet an, dann findet man sehr viele unterschiedliche Formen von Problemlösungsverhalten. Zwischen einer rein ’inner-behördlichen’ Vorgehensweisen mit sehr eingeschränkten Ist-Erfassungen und Lösungsfindungen bis hin zu einer sehr umfassenden Einbeziehungen von vielen Bevölkerungsgruppen über viele Kommunikationsstufen hinweg mit unterschiedlichen kreativen Ideen-Findungen. (4)

Diese letzteren, möglichst viele unterschiedliche Akteure einbeziehenden Vorgehensweisen, wirken auf den ersten Blick vertrauenerweckender, da grundsätzlich mehr Perspektiven zu Wort kommen und damit sowohl ein größerer Erfahrungsraum aus der Gegenwart wie auch eine größere Farbigkeit für eine mögliche Zukunft. Wäre solch eine Strategie die Strategie der Stunde?

(Anmk: 4: Dazu war das Referat von Dr.Gwechenberger vom Dezernat Planen und Wohnen der Stadt Frankfurt, sehr aufschlussreich. Neben der in der Sache gründenden Komplexität spielen die vielfältigen rechtlichen Vorgaben eine große Rolle, dazu die unterschiedlichen Mentalitäten aller Beteiligten, insbesondere die vielfältigen individuellen Interessen und Motivlagen. Das ganze eingebettet in unterschiedliche Zeitfenster, wann welche Aktion möglich, sinnvoll oder notwendig ist. Demokratie ist so gesehen auf jeden Fall zeitaufwendig, dann aber– hoffentlich – resilienter und nachhaltiger)

IV. MENSCH UND KOMPLEXITÄT

Schaut man sich an, was der Mensch als Lebensform des Homo sapiens in den vielen tausend Jahren seit seiner Besiedlung aller Erdteile geleistet hat, dann kann man sich eigentlich nur vor Ehrfurcht verneigen. Quasi aus dem Nichts kommend hat er es im Laufe von ca. 70.000 Jahren geschafft, aufgrund seiner Intelligenz und Sprachfähigkeit immer komplexere Tätigkeiten auszubilden, Handwerkszeug, Technologien, Regeln des Zusammenlebens, Großansiedlungen, komplexe Handelsbeziehungen. Er zeigte sich fähig, komplexe Staaten zu bilden, Großreiche, fantastische Architektur, immer komplexere Maschinen, empirische Forschungen bis in die Tiefen des Universums, in die Tiefen der Materie, in die verschlungenen Wege der Mikrobiologie von den Molekülen zu einfachen, dann komplexen Zellen bis hin zu komplexen Lebewesen, vielfältigste Formen von Klängen, Musik, Sounds, Bildwelten.

Schließlich erfand er auch die Computertechnologie, mit der man unvorstellbar viele Daten in unvorstellbar schneller Zeit verarbeiten kann. Würden heute auf einen Schlag alle Computer und Netzwerke weltweit still stehen, die Welt bräche völlig in sich zusammen. Ein beispielloses Chaos und Elend wäre die Folge.

Dies deutet indirekt auf einen Sachverhalt, den wir als Menschen im Alltag gerne übersehen, um nicht zu sagen, den wir geradezu verdrängen. Dies hat zu tun mit den realen Grenzen unserer kognitiven Fähigkeiten.

Trotz eines fantastischen Körpers mit einem fantastischen Gehirn hat jeder Mensch nur eine sehr begrenzte kognitive Aufnahmefähigkeit von ca. 5-9 Informationseinheiten pro Sekunde, was jeder Mensch in einfachen Selbstversuchen an sich überprüfen kann. (5) Und die Verarbeitung dieser Informationseinheiten mit Hilfe des vorher erworbenen Wissens verläuft unbewusst nach weitgehend relativ festen Schemata, die es einem Menschen schwer machen, Neues zu erfassen bzw. in sein bisheriges Bild von der Welt einzubauen. (6) Noch schwerer tut sich jeder Mensch, wenn es darum geht, Zusammenhänge zu erfassen, die vielerlei Faktoren umfassen, Faktoren, die oft zudem ’verdeckt’, auf den ersten Blick ’unsichtbar’ sind. Ganz schwer wird es, wenn sich komplexe Faktorenbündel zusätzlich in der Zeit ändern können, womöglich noch mit Rückkopplungen.

Gilt schon die Voraussage des Verhaltens eines einzelnen Menschen für nur ein Jahr mathematisch als unmöglich, so erscheint die Voraussage des Verhaltens von 5 Mio. Bewohner des Rhein-Main Gebietes entsprechend undurchführbar, zumal die Ab- und Zuwanderung hier sehr hoch ist. (7) Dazu kommen Veränderungen von Bedürfnislagen, Veränderungen von Technologien, Veränderungen von konkurrierenden Wirtschaftsregionen, und vieles mehr. Die bislang bekannten und praktizierten Planungsverfahren wirken angesichts dieser zu bewältigenden Komplexität nicht sehr überzeugend. Sie wirken eher hilflos, uninformiert. Scheitern wir mit unseren begrenzten individuellen kognitiven Fähigkeiten an der heutigen Komplexität?

(Anmk: 5: Die erste bahnbrechende Untersuchung zu der ’magischen Zahl 7+/-2’ stammt von George A.Miller (1956) [Mil56]. Dazu gibt es zahllose weitere Studien, die das Thema weiter auffächern, aber nicht diese grundsätzliche Kapazitätsbegrenzung.)

(Anmk: 6: Bekannte Texte zum Zusammenspiel zwischen Kurz- und Langzeitgedächtnis sind Baddeley/Logie (1999) [BL99], Baddeley (2003) [Bad03], und Repovs/Baddeley (2006) [RB06]. Allerdings ist das Thema Gedächtnis mit diesen Artikeln nicht abgeschlossen sondern wird in vielen hundert weiteren Artikeln weiter untersucht.)

(Anmk: 7: Hinweis von Dr. Gwechenberger zur Migration der Stadt Frankfurt: rein statistisch wird innerhalb von 12 Jahren die gesamte Bevölkerung von Frankfurt einmal komplett ausgetauscht.)

V. INGENIEURE ALS VORBILD

Vergessen wir für einen Moment das Problem des komplexen Ballungsraumes und schauen, was denn die Ingenieure dieser Welt machen, wenn sie seit Jahrzehnten komplexe Systeme entwickeln, bauen und in Betrieb halten, die die kognitiven Fähigkeiten eines einzelnen Ingenieurs um viele Dimensionen übersteigen.

Moderne Ingenieurleistungen verlangen das Zusammenspiel von oft mehr als 10.000 einzelnen Experten aus sehr vielen unterschiedlichen Gebieten, nicht nur über Monate, sondern oft über Jahre hin. Wie kann dies funktionieren?

Ingenieure haben sehr früh gelernt, ihr Vorgehen zu systematisieren. Sie haben komplexe Regelwerke entwickelt, die unter dem Stichwort ’Systems Engineering’ beschreiben, wie man beliebige Probleme von der Aufgabenstellung in eine funktionierende Lösung überführt, einschließlich umfassender Tests in allen Phasen. Und selbst der spätere Einsatz des entwickelten Produktes oder der entwickelten Dienstleistung ist nochmals spezifiziert. Dies führt dazu, dass z.B. Flugzeuge, Atomkraftwerke, landesweite Energienetzwerke, Raumfahrtprojekte, im Vergleich die sichersten Systeme sind, die wir kennen.

Neben ausgeklügelten Dokumentationstechniken spielen im Engineeringprozess mathematische Modelle eine zentrale Rolle und, seit vielen Jahren unverzichtbar, computergestützte Simulationen. Schon seit vielen Jahren gibt es kein einziges anspruchsvolles Produkt mehr, das zuvor nicht vollständig als Computersimulation ausprobiert und getestet wurde. Dazu gehören z.B. auch Computerchips, speziell jene Prozessoren, die das Herz eines Computers bilden. Schon vor 30 Jahren waren diese so komplex, dass deren Entwicklung und die Tests auf ihre Funktionstüchtigkeit ohne Computer nicht möglich war. Anders gesagt, wir können Computer und all die anderen komplexen Produkte schon seit Jahren nur entwickeln, weil wir dazu Computer einsetzen. Kein menschliches Gehirn ist in der Lage, die schon heute benötigten Komplexitäten noch irgendwie praktisch zu meistern, auch viele tausende Gehirne zusammen nicht.

Angesichts dieser Erfolgsgeschichten im Bereich des Engineerings kann man sich fragen, ob man von diesen Erfahrungen für den Bereich der Planung von Ballungsräumen nicht irgend etwas lernen könnte?

VI. CLUB OF ROME – NUR GESTERN?

Manche von Ihnen erinnern sich vielleicht noch an die zu ihrer Zeit provozierende erste Studie ”The Limits to Growth” des Club of Rome von 1972. (8) Dies war der erste Versuch, die Dynamik der Erde unter der Herrschaft der Menschen mit einem umfassenden Computermodell abzubilden und mit Hilfe des Modells mögliche Hinweise zu bekommen, wie sich die Dinge bei Veränderung der bekannten Faktoren in der Zukunft auswirken.

Seit dieser Veröffentlichung sind mehr als 40 Jahre vergangen. (9) Es gab auf der einen Seite heftigste Kritik, aber zugleich auch viele evaluierende Studien, die immer wieder bekräftigten, dass die Kernaussagen dieses Modells – das vergleichsweise einfach war und ist – sich im Laufe der Jahrzehnte für die Variante ’normaler Verlauf’ weitgehend bestätigt hat. (10)

Es ist hier nicht die Stelle, ein abschließendes Urteil über dieses Computermodell zu fällen (ein Student von mir hatte es mal vollständig nach-programmiert). Man kann aber sagen, dass solche Modelle den bislang einzig bekannte Weg markieren, wie wir Menschen mit unserer sehr begrenzten Fähigkeit zum Denken von Komplexität uns behelfen können, diese Grenzen ansatzweise zu überwinden. Man muss sich die Frage stellen, warum wir diese Anstöße nicht in der Gegenwart systematisch aufgreifen und für unsere Zukunft nutzen?

(Anmk: 8: Meadows et.al (1972) [MLRBI72]. Die Studie des Club of Rome war die Weiterentwicklung eines Computermodells, das zurück geht auf ein Systemmodell (und Programm), das Jay W. Forrester im Laufe von 15 Jahren entwickelt hatte. Thema von Forrester war die Erforschung der Dynamik von sozialen Systemen, speziell auch von Ballungsräumen (’urban areas’). Bemerkenswert ist bei Forresters Modellbildung, dass er auch den individuellen Menschen sieht, der mit seinem jeweiligen Weltbild (er nennt es ’mentales Modell’ bzw. dann einfach ’Modell’) die Welt wahrnimmt, interpretiert und danach handelt. Will man das Verhalten ändern, dann muss man das individuelle Weltbild ändern, das in enger Wechselbeziehung zur aktuellen Gesellschaft steht.(siehe Foorester (1971) [For71]))

(Anmk:9: Da der Club of Rome 1968 gegründet wurde, feiert er 2018 sein 50-jähriges Jubiläum … und er ist immer noch aktiv.)

(Anmk: 10: Ein erster Überblick über die verschiedenen Argumente für und gegen die Analysen des Club of Rome finden sich in dem einschlägigen Wikipedia-Artikel https://en.wikipedia.org/wiki/Club of Rome. Im deutschen Wikipedia-Eintrag finden sich keine Hinweise auf kritische Einwände!)

VII. DER UMFASSEND DIGITALISIERTE MENSCH ENTSTEHT HEUTE

Im Jahre 1972 war der Computer noch keine Maschine des Alltags. Dies begann erst ab dem Jahr 1977 mit dem Auftreten von Kleincomputern für den privaten Gebrauch. Die Entwicklung seitdem war und ist explosiv.

Die Situation heute ist so, dass der Mensch mit seinem realen Körper zwar noch weiterhin in einer realen Körperwelt verankert ist, dass er aber über die vielen elektronischen Geräte, speziell durch Smartphones, Wearables, Tabletts, Notebooks, Laptops und PCs mit immer größeren Zeitanteilen seine Tages über Datennetze mit einer globalen Datenwelt verbunden ist, die rund um die Uhr Raum und Zeit vergessen lässt. Definierte sich ein Mensch früher über seine realen Aktivitäten, wird dies zunehmend ergänzt durch digitale Aktivitäten und Ereignisse. Das Selbstbild, der ganze persönliche Erlebnisraum wird zunehmend durch solche nicht-realweltlichen Strukturen ersetzt. Empirische Realität und digitale Realität beginnen im virtuellen Raum des individuellen Bewusstseins zu verschwimmen. Müsste der Mensch nicht noch seine elementaren körperlichen Bedürfnisse befriedigen, er könnte subjektiv ausschließlich im digitalen Raum arbeiten, kommunizieren, soziale Erfüllung finden, Spielen und . . . . die Grenzen dieser neuen digital erweiterten Lebensform sind bislang noch schwer zu fassen.

Während der professionelle Planungsalltag der Kommunen und Regionen Computer noch sehr verhalten einsetzt, zeigen uns die vielen Mio. Computerspieler weltweit, dass die Menschen sehr wohl Gefallen daran finden können, mit den Mitteln der Computersimulation die Gegenwart hinter sich zu lassen. Allein für Online-Computerspiele hat sich der Markt von 2011 bis 2016 von 21 Mrd. auf 31 Mrd. US-Dollar vergrößert. (11) Für das Jahr 2017 notieren die sechs Länder mit dem höchsten Umsatz bei Onlinespielen (China, USA, Japan, Deutschland, England, Südkorea) zusammen 84.7 Mrd.US-Dollar. (12) Dazu kommen nochmals 8 Mrd. US-Dollar für PC- und Spielkonsolenspiele. (13)

Computerspiele sind komplexe Simulationen in denen eine Ausgangslage mit Hilfe von Regeln in beliebig viele Nachfolgesituationen transformiert werden können. Dies geschieht mittlerweile in 3D, berücksichtigt realistische Geländeformationen mit Vegetation, komplexe Gebäude, viele Tausend Mitspieler, erlaubt gemeinsame Aktionen und macht so eine dynamische digitale Welt virtuell erlebbar.

Diese theoretische Beschreibung lässt das gewaltige Potential erahnen, das Computerspiele prinzipiell für Lernprozesse und für gemeinsame Zukunftsforschung haben könnten. In der Realität bleiben diese aber weit hinter ihren Möglichkeiten zurück, da die Betreiber bislang wenig Interesse zeigen, das Lern- und Forschungspotential dieser neuen ’Technologie ernsthaft zu nutzen. Die Computerspiele sind bislang eher Erlebnis-, nicht Wissens- getrieben.

(Anmk: 11: Quelle: https://www.statista.com/statistics/292516/pc-online-game-market-value-worldwide/.)

(Anmk: 12: Quelle: https://www.statista.com/statistics/308454/gaming-revenue-countries/.)

(Anmk: 13: Quelle: https://www.statista.com/statistics/237187/global-pc-console-games-revenue-by-type/. )

VIII. SIMULATIONEN BEHERZTER NUTZEN?

An dieser Stelle kann man sich die Frage stellen, warum man das Komplexitätsproblem am Beispiel von Ballungsräumen nicht mit diesen neuen Simulationstechniken angehen sollte?

Verteilte Simulationen würden beliebigen Bürgern die reale Möglichkeit bieten, sich zu beteiligen. Das unterschiedliche Wissen in den unterschiedlichen Köpfen könnte man schrittweise aufsammeln und als Regelwissen in den Simulationen zur Verfügung stellen. Im Unterschied zu kommerziellen Spielen könnte man diese Regeln offenlegen für alle und sie zum Gegenstand von Fachgesprächen machen. In realen Simulationsabläufen könnte man jeweils austesten, wie sich bestimmte Regeln auswirken: sind sie realistisch? Wo führen sie uns hin? Welche Wechselwirkungen mit anderen Regeln tun sich auf? Dieses Werkzeug könnten den Fachabteilungen in den Behörden genauso offen stehen wie den Schulen und Universitäten; Firmen könnten ihre eigenen Szenarien ausprobieren. Alle könnten sich immer wieder auch zu gemeinsamen Experimenten verabreden; man könnte gar Wettbewerbe starten, eine Art kommunales eGaming. In diesem Fall würde es dann wirklich um etwas gehen, nämlich um die eigene Welt und ihre mögliche Zukunft. Mit einem solchen verteilten dynamischen Planungswerkzeug könnte man den Ballungsraum 2117 schon ziemlich gut erforschen, zumindest soweit es uns heute, im Jahr 2018 überhaupt möglich ist. (14)

(Anmk: 14: Im Rahmen der abschließenden Podiumsdiskussion zur Tagung stieß die Idee des Einsatzes von mehr Computersimulationen im Gewand von Computerspielen für die Stadtplanung auf unterschiedliche Reaktionen. Der meiste Widerstand ging aus von der Vorstellung, dass Computerprogramme abgeschlossene Einheiten sind, die aus sich heraus niemals die Vielfalt und Dynamik der Wirklichkeit abbilden könnten. Dem hielt der Autor entgegen, dass man primär vom Kommunikationsprozess zwischen Menschen her denken müsse, dem Austausch von Weltbildern, verbunden mit einem möglichen ’Um-Lernen’ dieser Weltbilder. Innerhalb dieser Kommunikationsprozesse kann eine Computerspielumgebung sehr wohl helfen, komplexe Sachverhalte besser zu nutzen. Außerdem können die Regeln, nach denen hier die Welt gesteuert wird, von allen Teilnehmern eingesehen und auf Wunsch geändert werden.)

IX. TECHNISCHE SUPERINTELLIGENZ

An dieser Stelle könnte dieser Vortrag unter normalen Umständen enden. Schon jetzt enthält er eine Reihe von Anregungen, die über den aktuellen Status Quo weit hinausgehen. Aber wir leben in einer Zeit, in der die Welt – spätestens seit der Cebit 2016 – zu fast allen passenden und auch unpassenden Gelegenheiten mit dem Begriff ’Künstliche Intelligenz’ beschallt wird. Kaum noch ein Produkt oder eine Dienstleistung, die nicht irgendwie den Anspruch erhebt, entweder schon über ’künstliche Intelligenz’ zu verfügen oder demnächst mit so etwas ausgestattet zu werden. Und neben den Evangelisten der künstlichen Intelligenz treten auch die Propheten des Untergangs der Menschheit auf, für die die aktuelle ’Künstliche Intelligenz’ nur der Vorläufer einer ganz neuen, noch mächtigeren ’Künstlichen Intelligenz’ sei, die als ’Singularity’ alles übertreffen wird, was der Mensch als künstliche Intelligenz kennt und beherrscht. (15) Diese neue Super-Intelligenz soll dem Menschen in Geschwindigkeit, Datenvolumen und Denkfähigkeit so weit voraus und darin überlegen sein, dass diese technische Superintelligenz vom Menschen nicht mehr ernsthaft kontrolliert werden kann. Sie ist gegenüber dem Menschen so überlegen, dass sie den Menschen locker als überflüssiges Etwas abschaffen kann. Wie immer, gehen die Schätzungen, wann dies der Fall sein wird, deutlich auseinander, aber das Jahr 2117 ist ein guter Kandidat, wann es soweit sein könnte. (16) Was soll man von dieser nicht gerade beruhigenden Vision halten?

Dass Menschen alles, was ihnen neu und unbekannt ist, und ihnen Angst macht, in Form von überirdische Fabelwesen packen, ist so alt, wie die Aufzeichnungen der Menschheit reichen. In den vielen Sagen gibt es dann irgendwann einen Menschen, einen besonderen Menschen, einen Helden, der dann irgendwann eine Schwachstelle findet, durch deren Ausnutzung der Held dann das Fabelwesen zur Strecke bringen kann. Im Fall des neuen Mythos von der technischen Superintelligenz muss man allerdings nicht sehr weit suchen, um zu sehen, dass die Dinge vielleicht doch ganz anders liegen, als die Marketingmaschinerien uns glauben lassen wollen. Und ja, doch, es könnte sogar sein, dass sich hinter dem abschreckenden Mythos von der menschenfeindlichen technischen Superintelligenz eine sehr konkrete Technologie verbirgt, die uns Menschen bei unserem Komplexitätsproblem ernsthaft helfen könnte. Gehen wir zurück zu dem Mann, mit dem das seriöse Reden über die Computer-Maschine angefangen hat.

(Anmk: 15: Ein wichtiger Text zu Beginn der Diskussion um die ’technische Singularität’ ist ein Beitrag von Vinge 1993 zu einer Nasa-Konferenz [Vin93]. Ein sehr guter Einstieg in die Thematik der technischen Singularität findet sich in dem Wikipedia-Artikel zur ’Technological Singularity’, URL: https://en.wikipedia.org/wiki/Technological singularity)

(Anmk: 16: Für eine Diskussion, wann man mit welcher Art von ’Super-Human-Level’ maschineller Intelligenz rechnen sollte, finden sich im Kap.1 von Bostrom 2014 [Bos14]:SS.18-21 einige Argumente. Klar ist, dass es nicht ganz klar ist; es gibt zu viele Unbekannte und wichtige Begriffe sind unscharf. So gesehen ist die Zahl ’2117’ (geschrieben im Jahr 2017) eine fast ’satirische’ Schätzung unter Berücksichtigung der Argumente bei Bostrum.)

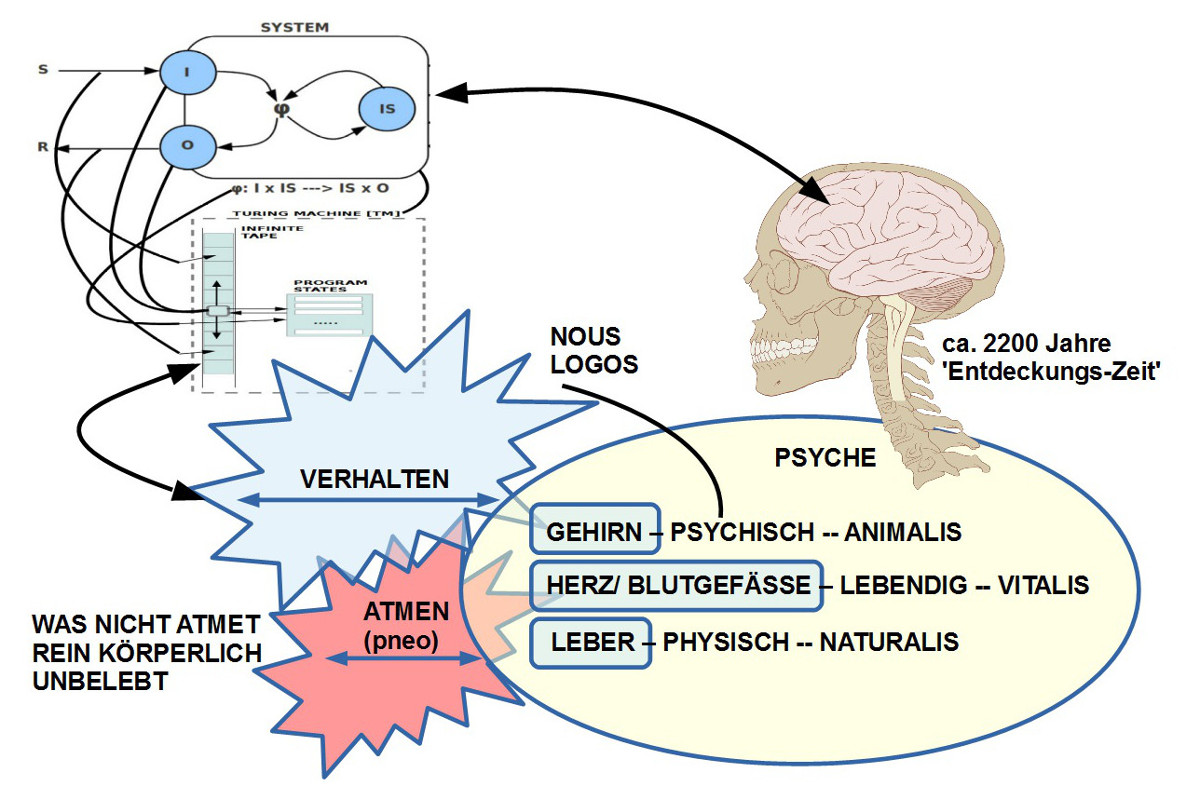

X. WAS KANN EIN COMPUTER?

Während die modernen Naturwissenschaften ihren Untersuchungsgegenstand, die reale Natur, von vornherein nicht kennen, sondern sich mühsam, über viele kleine Schritte, ein Bild erarbeiten müssen, wie es vielleicht sein könnte, hat die Computerwissenschaft es einfacher. Sie beginnt dort, wo es überhaupt noch keine Computer gab, sondern nur ein mathematisches Konzept über eine ideale Maschine, deren einzige Fähigkeit darin besteht, in völlig transparenter Weise eine endliche Liste von primitiven Befehlen auszuführen. (17) Im Unterschied zu einer normalen Maschine, die keine Befehle ausführt, kann eine Computer-Maschine Befehle ausführen. Dies erscheint noch nicht besonders aufregend. Ein klein wenig aufregender wird es dadurch, dass die Computermaschine mit einem Schreib-Lese-Band verknüpft ist, auf dem beliebige Zeichen stehen können. Man kann die Computer-Maschine so auslegen, dass sie diese Zeichen auf dem Schreib-Lese-Band als ihre neuen Anweisungen interpretiert. Dies klingt auch noch nicht aufregend. Aufregend wird es, wenn man sich klar macht, dass die Computer-Maschine diese Anweisungen auf dem Schreib-Lese-Band in eigener Regie verändern kann. Sie kann sozusagen das Programm, das sie steuert, selber abändern und damit die Kontrolle über ihre eigene Steuerung übernehmen. Damit verfügt die Computer-Maschine über eine wichtige Voraussetzung, um im Prinzip voll lernfähig zu sein.

Der soeben erwähnte Turing (18) war auch einer der ersten, der in drei Artikeln 1948, 1950 sowie 1953 ganz offen die Frage diskutierte, ob Computer-Maschinen, falls es diese irgendwann einmal als reale Maschinen geben würde, auch eine Intelligenz haben könnten, wie wir sie von Menschen kennen. (19) Turing selbst sah die Möglichkeit eher positiv. Er machte allerdings schon damals darauf aufmerksam, dass Computer-Maschinen aus seiner Sicht nur dann eine reelle Chance haben würden, mit dem Menschen im Lernen gleich zu ziehen, wenn sie ähnlich wie Kindern selbständig durch die Welt streifen könnten und – ausgestattet mit Kameras, Mikrophonen und weiteren Sensoren – die Welt wie sie ist wahrnehmen könnten.

Mittlerweile schreiben wir das Jahr 2018, das sind mehr als 65 Jahre nach Turings Spekulationen zu intelligenten, lernfähigen Computern. Wie viele Computer streifen durch die Welt wie Kinder? Nicht all zu viele, muss man feststellen; eigentlich kein einziger. Die bisherigen Roboter, die bekannt sind, haben eine sehr eingeschränkte Bewegungsfähigkeit und keiner von diesen lernt bislang in einer unbeschränkten Weise, wie Kinder es tun.

Der Bereich, in dem über lebenslang frei lernende Roboter geforscht wird, nennt sich ’Developmental Robotics’ oder – noch radikaler – ’Evolutionary Developmental Robotics’. (20) In einer Forschungsübersicht aus dem Jahr 2017 (21) gibt es eine zentrale Einsicht, die uns an dieser Stelle helfen kann. (22) Zwar weiß man eigentlich schon von den Anfängen in der Künstlichen Intelligenzforschung in den 1960iger Jahren, dass jegliche Art von Lernen minimale Formen von Rückmeldung benötigt, aber die Tragweite dieses Momentes wurde vielen Forschern erst in den letzten Jahren, und speziell in der ’Erforschung des offenen‘ Lernens so richtig klar. Wenn eine Computer-Maschinen selbständig offen lernen können soll, dann braucht sie minimale Präferenzen, um im allgemeinen Rauschen der Ereignisse Ansätze möglicher Muster zu finden. Im Fall von biologischen Systemen gibt es eine Mischung von sogenannten angeborenen Präferenzen, die sich letztlich von der Überlebenserfahrung herleiten, und eben das schlichte Überleben selbst. Nur wer überlebt besitzt offenbar brauchbare Informationen. Im Fall von Computer- Maschinen gibt es keine Überlebenserfahrungen. Eine Computer-Maschine beginnt am absoluten Nullpunkt. Bis vor wenigen Jahren haben Ingenieure das Problem dadurch gelöst, dass sie ihre eigenen Präferenzen in die Computer-Maschinen eingebaut haben. Dies hat so lange funktioniert, wie die Computer-Maschinen nur sehr spezielle Aufgaben lösen mussten, z.B. als Industrieroboter. In dem Maße aber, wie Computer-Maschinen beliebige Aufgaben lernen können sollen, funktioniert diese Strategie nicht mehr. Was nun? Woher sollen solche allgemeinen Präferenzen kommen?(23)

Die Frage mit den Präferenzen (andere sprechen von Werten) hat eine zusätzliche pikante Note, da der Homo sapiens das erste Lebewesen auf der Erde ist, das nicht mehr ausschließlich durch die nackte Überlebensnotwendigkeit getrieben ist. Der Homo sapiens, also wir Menschen, haben es durch unsere geistigen und kommunikativen Möglichkeiten geschafft, das nackte Überleben z.T. sehr weit in den Hintergrund zu drängen. Damit stellt sich für die Lebensform des Homo sapiens erstmals seit 4 Milliarden Jahren biologischen Lebens die Frage, welche möglichen Präferenzen es möglicherweise neben oder sogar vor dem nackten Überleben geben könnte. Dummerweise enthält der genetische Code keine direkte Antwort auf die Frage nach zusätzlichen Präferenzen.

(Anmk: 17: Der Text, in dem diese Art der Beschreibung eines idealen Computers erstmals vorkommt, ist ein Text, in dem Alan Matthew Turing einen metamathematischen Beweis geführt hat, in dem es um eine andere Version des Unentscheidbarkeitsbeweises von Kurt Gödel 1931 ging. Siehe [Tur 7]. Zu Ehren von Turing wurde diese Version der Definition eines Computers ’Turingmaschine’ genannt. )

(Anmk: 18: Eine sehr gute Biographie zu Turing ist Hodges (1983) [Hod83])

(Anmk: 19: Siehe Turing 1948 [M.87], 1950 [Tur50], sowie 1953 [Tur63] 20 Erste gute Überblicke bieten die beiden Wikipediaeinträge zu ’developmental robotics’ https://en.wikipedia.org/wiki/Developmental robotics sowie zu ’evolutionary developmental robotics’ https://en.wikipedia.org/wiki/Evolutionary developmental robotics)

(Anmk: 21: Siehe Merrick (2017) [Mer17])

(Anmk: 22: Ergänzend auch Singh et.al. (2010) [SLBS10] und Ryan/Deci (2000) [RD00] )

(Anmk: 23: Eine der verbreitetsten Lernformen im Bereich Künstliche Intelligenz ist das sogenannte ’Reinforcement Learning (RL)’. Dieses setzt explizit ’Belohnungssignale’ (’reward’) aus der Umgebung voraus. Siehe zur Einführung Russell/ Norvig 2010 [RN10]:Kap.21 und Sutton/Barto 1998 [SB98])

XI. DAS EI DES COLUMBUS

Das Ei des Columbus gilt als Metapher für Probleme, die als unlösbar gelten, für die es dann aber doch eine Lösung gibt.

In unserem Fall ist das Problem die begrenzte kognitive Ausstattung des Menschen für komplexe Situationen sowie die Präferenzfreiheit technischer Systeme. Die bisherigen Lösungsansätze einer cloud-basierten allgemeinen Intelligenz führt letztlich zu einer Entmachtung des einzelnen ohne dass eine cloud-basierte Intelligenz eine wirklich Überlebensfähigkeit besitzt. Sie gleicht eher einem Vampir, der so lange lebt, als viele einzelne sie mit Details aus ihrem Alltag füttern. Ohne diese Details ist solch eine cloud-basierte Intelligenz ziemlich dumm und kann einem einzelnen kein wirklicher persönlicher Assistent sein.

Die Lösung könnte tatsächlich ein reales Ei sein, ein Ei gefüllt mit einer Computer-Maschine, deren Rechenkraft vor Ort genau einem Menschen zur Verfügung steht und genau diesem einem Menschen rund um die Uhr hilft, seine kognitiven Begrenzungen auszugleichen und zu überwinden. Dieses Computer-Maschinen Ei (natürlich könnte es auch jede andere Form haben, z.B. als Ohrring, Halskette, Armband usw.) kann mit dem Internet Verbindung aufnehmen, mit jeder denkbaren Cloud, aber nur dann, wann und wie dieses Ei es selber will, und es würde keinerlei privates Wissen einfach so preisgeben. So, wie die Gehirne der Menschen anatomisch alle ähnlich sind und doch sehr individuelle Persönlichkeiten ermöglichen, so kann ein Computer-Maschinen Ei die individuellen Erfahrungen und das individuelle Wissen eines Menschen passgenau erkennen und fördern. Es entsteht eine Symbiose von Mensch und Maschine, die deutlich mehr sein kann als jede Komponenten für sich alleine.

XII. EINE NEUE MENSCH-MASCHINE SUPER-INTELLIGENZ FÜR DEN BALLUNGSRAUM?

Greift man an dieser Stelle nochmals die Vision einer verteilten, flexiblen Simulationsumgebung für die Bürger in einer Region auf, dann kann eine zusätzliche Ausstattung aller Bürger mit ihren persönlichen intelligenten Assistenten dem ganzen Projekt einen zusätzlichen messbaren Schub geben. Die persönlichen Assistenten können auch dann arbeiten, wenn der einzelne mal müde ist, sich entspannen will oder mal mit familiären Aufgaben beschäftigt ist. Und der persönliche Assistent kann auch viele Tausend oder Millionen Faktoren gleichzeitig in Rechnung stellen und in ihren Auswirkungen verfolgen. Im Zusammenwirken dieser vielen natürlichen und technischen Intelligenzen könnte eine Mensch-Maschine Superintelligenz entstehen, die den einzelnen voll mit nimmt, und als Gesamtphänomen erheblich leistungsfähiger sein wird, als alles, was wir heute kennen.

Allerdings, wir sollten uns nicht der Illusion hingeben, dass damit dann alle Probleme gelöst wären. Das Problem der geeigneten Präferenzen, sprich der Werte, wird bleiben; es wird sich vermutlich eher verschärfen. Auch die Verantwortung für uns Menschen wird weiter wachsen, auch wenn sich diese Verantwortung qualitativ neu immer auf ganz viele verteilen wird.

IX QUELLEN

[Bad03] Alan Baddeley. Working memory and language: an overwiew. Journal of Communication Disorders, 36:236–242190–208, 2003.

[BL99] A. Baddeley and R.H. Logie. Working memory: The multiple-component model. In A. Myake and P. Shah, editors, Models of working memory, chapter 2, pages 28–61. Cambridge University Press, New York, 1999.

[Bos14] Nick Bostrom. Superintelligence. Paths, Dangers, Strategies. Oxford University Press, Oxford (UK), 1 edition, 2014.

[BP16] Thorsten Bürklin and Michael Peterek. Thecycloregion. city-regional development in frankfurt rhine-main – die zykloregion. stadtentwicklung in frankfurtrheinmain. Journal of Comparative ’Cultural Studies in Architecture, 9:41–51, 2016.

[For71] Jay W. Forrester. World Dynamics. Wright-Allen Press, Inc., Cambridge (MA) 02142, 2 edition, 1971.

[Hod83] Andrew Hodges. Alan Turing, Enigma. Springer Verlag, Wien – New York, 1 edition, 1983.

[Hol73] C.S. Holling. Resilience and stability of ecological systems. Annual Review of Ecology and Systematics, 4(1):1–23, 1973.

[Jak13] Peter Jakubowski. Resilienz – eine zusätzliche denkfigur für gute stadtentwicklung. Informationen zur Raumentwicklung, 4:371–378, 2013.

[M.87] Turing Alan M. Intelligente maschinen. In Bernhard Dotzler and Friedrich Kittler, editors, Alan M. Turing. Intelligence Service, pages 81 – 113. Brinkmann & Bose, Berlin, 1987.

[Mer17] Kathryn Merrick. Value systems for developmental cognitive robotics: A survey. Cognitive Systems Research, 41:38 – 55, 2017.

[Mil56] Geroge A. Miller. The magical number seven, plus or minus two: Some limits on our capacity for processing information. Psychological review, 63:81–97, 1956.

[MLRBI72] Donella H. Meadows, Meadows Dennis L., Jørgen Randers, and William W. Behrens III. The Limits to Growth. A Report for the Club of Rome’s Project on the Predicament of Mankind. Universe Books, New York, 1 edition, 1972.

[PB13] Michael Peterek and Thorsten Bürklin. Potentials and challenges of polycentric city-regions: A case-study of frankfurt rhine-main. Technical Transactions Architecture – Czasopismo Techniczne Architektura, 1-A:179–189, 2013.

[RB06] G. Repovs and A. Baddeley. The multi-component model of working memory: Explorations in experimental cognitive psychology. Neuroscience, 139:5–21, 2006.

[RD00] Richard M. Ryan and Edward L. Deci. Intrinsic and extrinsic motivations: Classic definitions and new directions. Contemporary Educational Psychology, 25(1):54 – 67, 2000.

[RN10] Stuart Russel and Peter Norvig. Artificial Intelligence. A Modern Approach. Universe Books, 3 edition, 2010.

[SB98] Richard S. Sutton and Andrew G. Barto. Reinforcement Learning. An Introduction. The MIT Press, Ambridge (MA) – London, 1 edition, 1998.

[SLBS10] S. Singh, R. L. Lewis, A. G. Barto, and J. Sorg. Intrinsically motivated reinforcement learning: An evolutionary perspective. IEEE Transactions on Autonomous Mental Development, 2(2):70–82, June 2010.

[Tur50] Alan Turing. Computing machinery and intelligence. Mind, 59:433–460, 1950.

[Tur63] Alan Matthew Turing. Digital computers applied to games. In B.V. Bowden, editor, Faster Than Thought. Pitman Publishing, London, 1963.

[Tur 7] Alan M. Turing. On computable numbers, with an application to the entscheidungsproblem. Proceedings of the London Mathematical Society, 42(2):230–265, 1936-7.

[Vin93] Vernor Vinge. The coming technological singularity: How to survive in the post-human era. In G.A. Landis, editor, Vision-21: Interdisciplinary Science and Engineering in the Era of Cyberspace, pages 11–22. 1993.

PROJEKTGRÜNDUNG

Im Anschluss an dieses Konferenz kam es zur Gründung eines Projektes, das versucht, den ‚Spirit des Kongresses‘ aufzugreifen und konkret umzusetzen. Siehe dazu HIER.

KONTEXT BLOG

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.

Das aktuelle Publikationsinteresse des Blogs findet sich HIER