Journal: Philosophie Jetzt – Menschenbild , ISSN 2365-5062

30.April 2018

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

INHALT

I Aufgabenstellung

II Gespräch

II-A Messwert

II-B Modell – Theorie

II-C Verstehen

III Neue Fragestellungen

ÜBERBLICK

Bericht zum Treffen der Philosophiewerkstatt vom 29.April 2018 mit weiterführenden Interpretationen vom Autor. Weitere Feedbacks, Kommentare sind willkommen.

I. AUFGABENSTELLUNG

In der Einladung zur Philosophiewerkstatt am 29.April 2018 wurde einerseits Bezug genommen auf den ausführlichen Bericht der Sitzung vom 25.März 2018, andererseits wurde eine Fragestellung formuliert, die sich aus der letzten Sitzung ergeben hatte. Die vorausgehenden intensiven Gespräche zur möglichen Ersetzung eines Psychoanalytikers durch einen Roboter hatten immer stärker das Selbstverständnis des Psychoanalytikers in das Zentrum der Überlegungen gerückt, verbunden mit den Fragen, wie denn ein Psychoanalytiker sowohl den Prozess beschreibt, in dem er mit einem Analysanden interagiert, wie auch sich selbst als jemand, der in dieser Rolle agiert Es wurde sichtbar, dass ein Psychoanalytiker natürlich nicht ohne ein ’Vor-Verständnis’ agiert und dass die Beobachtungen sehr wohl im Lichte dieses Vorverständnisses zu sehen seien. Es stellte sich die Frage, wie man denn das Wechselspiel zwischen anzunehmendem Vor-Verständnis einerseits und beobachteten Vorkommnissen genauer zu verstehen sei. Für die nachfolgende Sitzung wurde diese Fragestellung dahingehend erweitert, dass dieses Wechselspiel zwischen Vorverständnis und Beobachtungswerten auf das generelle Problem des Wechselspiels zwischen ’Messwerten’ und ’Modell’ in allen wissenschaftlichen Disziplinen ausgedehnt wurde. Den meisten Menschen ist nicht bewusst, dass es in den empirischen Wissenschaften für den Weg von einzelnen Messwerten zu einem Modell ganz allgemein keinen Automatismus gibt! Aus Messwerten folgt nicht automatisch eine irgendwie geartete Beziehung, erst recht kein Modell mit einem ganzen Netzwerk von Beziehungen. In allen empirischen Disziplinen braucht es Fantasie, Mut zum Denken, Mut zum Risiko, Kreativität und wie all diese schwer fassbaren Eigenschaften heißen, die im ’Dunkel des Nichtwissens’ (und des Unbewussten) mögliche Beziehungen, mögliche Muster, mögliche Faktorennetzwerke ’imaginieren’ können, die sich dann in der Anwendung auf Messwerte dann tatsächlich (manchmal!) als ’brauchbar’ erweisen. Und, ja, persönliche Vorlieben und Interessen (unbewusste Dynamiken) können sehr wohl dazu beitragen, dass bestimmte mögliche ’interessante Beziehungs-Hypothesen’ von vornherein ausgeschlossen oder eben gerade gefunden werden. Anhand konkreter Beispiele – auch aus der Psychoanalyse ? – soll diese Thematik diskutiert werden. Es sei auch noch angemerkt, dass das große Thema der letzten Sitzung, inwieweit man die Psychoanalyse als ’empirische Wissenschaft’ verstehen kann oder sogar verstehen muss, noch nicht völlig zu Ende diskutiert ist. Es entstand der Eindruck, als ob die ExpertenInnen der Psychoanalyse die Einstufung der Psychoanalyse als empirische Wissenschaft selbst nicht so ganz akzeptieren wollten. Es sah so aus, als ob sie die Befürchtung haben, dass dadurch wesentliche Momente der Psychoanalyse verloren gehen könnten. Umgekehrt muss man aber auch bedenken, dass möglicherweise der empirischen Wissenschaft wichtige Aspekte verlorengehen, wenn man eine Disziplin wie die Psychoanalyse von vornherein ausklammert.

II. GESPRÄCH

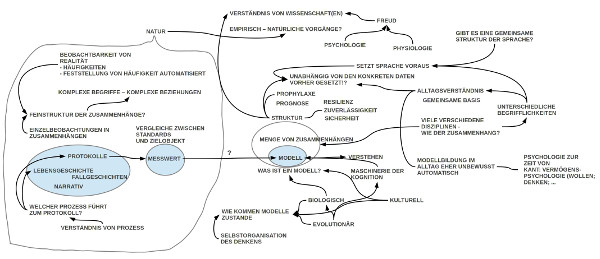

Das Gespräch nahm seinen Ausgangspunkt bei den Begriffen ’Messwert’ und ’Modell’.

Im Fall des Begriffs ’Messwert’ ergab sich recht schnell fundamentale Unterscheidungen.

A. Messwert

In den ’empirischen Wissenschaften’ geht ein ’Messwert’ in der Regel aus einer ’Vergleichsoperation’ hervor in der ein ’Zielobjekt’ (das, was gemessen werden soll), und ein ’Referenzobjekt’ (ein zuvor vereinbarter ’Standard’ wie z.B. die Längeneinheit Meter [m], oder Gewichtseinheit Kilogramm [kg] usw..) miteinander verglichen werden. Das Ergebnis solch einer Vergleichsoperation ist dann immer ein Zahlenwert kombiniert mit einer Einheit, also z.B. ’3,3 m’ oder ’5,44 kg’. Dieser Sachverhalt wird in einen geeigneten ’sprachlichen Ausdruck’ übersetzt, der seine ’Bedeutung’ aus dieser Vergleichsoperation bezieht. In den modernen Wissenschaften hängen die Messoperationen oft an komplexen technischen Vorrichtungen, die selbst schon komplexe Theorien voraussetzen, so dass das Messergebnis stark ’Theorie-belastet’ ist. Es wird dann eine Vergleichsoperation mit einem vereinbarten Standard unterstellt, die von vielen komplexen Annahmen abhängt. Eine direkte Überprüfbarkeit ’vor Ort’ ist oft kaum noch möglich.

In jenen empirischen Wissenschaften, die kollektiv als ’Lebenswissenschaften’ charakterisiert werden, ist der Messgegenstand sehr oft ein komplexes System in einem Prozesskontext, wo die punktuelle Messung eines isolierten Faktums schwer bis gar nicht möglich ist. Die ’Beobachtungen’ solcher komplexer Systeme bekommt einen ’narrativen’ Charakter, nimmt die Form von ’Fallgeschichten’ an, im Grenzfall eine ganze ’Lebensgeschichte’. Ein Narrativ enthält also viele Einzelbeobachtungen im Kontext eines komplexen Ablaufs. Einzelne Begriffe in so einem Narrativ können in sich ’komplex’ sein, d.h. viele Eigenschaften und Randbedingungen voraussetzen, die sich oft nur einem ’geschulten/ erfahrenen’ Beobachter erschließen. Desgleichen sind die Beziehungen zwischen solchen komplexen deskriptiven begriffen oft ebenfalls ’komplex’: sie umfassen viele Detailaspekte simultan.

B. Modell – Theorie

Im Gespräch wurden die Begriffe ’Modell’ und ’Theorie’ (noch) nicht explizit definiert. Als Arbeitsbegriff wurde in den Raum gestellt, dass die ’Deutung’ von einzelnen Messwerten das ’Aufstellen von Beziehungen’ voraussetzt, durch die einzelne Beobachtungen in einem Zusammenhang gestellt werden können,also z.B. ’Wenn X, dann (evtl. mit Wahrscheinlichkeiten qualifiziert) Y’. Man kann solche Beziehungen ’Regeln’ nennen oder ’Funktionen’. Ein vorläufiger Begriff von ’Modell’ wäre dann, dass ein Modell eine Menge solcher Regeln verkörpert (mindestens eine). Modell stellen dann also ’Deutungen’ her, aus denen sich begrenzt ’Voraussagen’ herleiten lassen bzw. mit denen man ansatzweise ’erklären’ kann.

Eine ’Theorie’ stellt – Arbeitsdefinition – gegenüber einem ’Modell’ eine erweiterte ’Struktur’ dar, in der nicht nur die angenommenen Regeln vorkommen, sondern zugleich auch alle beteiligten Objektmengen.

Mit Blick auf ein Modell wurden viele zusätzliche Eigenschaften genannt.

1) Der ’Verwendungszusammenhang’ eines Modells kann eine ’Erklärung’ sein oder eine ’Prognose’. Beides kann man u.U. für eine ’Prophylaxe’, für eine ’Therapie’ nutzen.

2) Ein Modell kann ferner ’globale Eigenschaften’ besitzen indem das so beschriebene Objekt (das oft ein System ist), als ’zuverlässig’ charakterisierbar ist oder als ’sicher’ oder als ’resilient’ und dergleichen mehr.

3) Man kann auch die Frage nach der ’Entstehung eines Modells’ stellen: ist es eher ein ’Produkt’ des Wirkens der biologischen Strukturen’ oder der Einwirkungen der umgebenden ’Kultur’ oder ein Zusammenspiel von beiden? Inwieweit können sich Modelle ’selbst organisieren’? In diesem Zusammenhang auch die interessante Unterscheidung zwischen ’Modellen im Alltag’, die eher unbewusst, automatisch entstehen und benutzt werden, im Kontrast zu expliziten Modellen in der Wissenschaft, die grundsätzlich ’bewusst’ konstruiert werden, ’transparent’, mit ’Dokumentationen’. Hier beobachten wir aber in der Gegenwart das Phänomen der ’Zersplitterung’ der Einzeldisziplinen, die mit spezifischen Sprachspielen und spezifischen Modellen ’für sich’ recht erfolgreich sein können, aber im ’interdisziplinären Dialog’ oft vollständig versagen. Dies ist ein reales Problem.

4) Ferner kann man fragen, inwieweit ein Modell eine geeignete ’Sprache voraus setzt’ bzw. wie das Zusammenspiel von einem ’Modell im Kopf’ ist und einer Sprache, die über dieses Modell spricht?

C. Verstehen

Mit diesen vielen Teil-Klärungen von Begrifflichkeiten stellte sich dann das Problem des Wechselspiels zwischen Beobachtungen und benutztem Modell in der Psychoanalyse so dar, dass natürlich auch die Psychoanalyse vorab zum praktischen Einsatz eine explizite ’Modellpflege’ betreibt (Anmerkung: Durch Studien, spezielles Training, Supervision, und vielem mehr ), so dass dann der ausgebildete (trainierte) Psychoanalytiker sich seines Modells so ’bewusst’ sein kann, dass er in seinem ’Narrativ’ genügend viele Einzelaspekte ’identifizieren’ kann, um sie ’im Lichte seines Modells’ so ’deuten’ zu können, dass er im Sinne des psychoanalytischen Modells ’geeignete Schlüsse’ ziehen kann, aufgrund deren er sowohl zu ’Einschätzungen’ kommen kann wie auch dann zu jeweiligen ’Interventionen’. An diesem Punkt war leider die Zeit um.

III. NEUE FRAGESTELLUNGEN

Es bestand der Wunsch aller Beteiligten, an dieser Stelle das Gespräch fortzusetzen. Ideal wäre für die nächste Sitzung ein kleines Beispiel mit einem typischen ’Narrativ’ und ’Deutungen’ auf der Basis des ’vorausgesetzten psychoanalytischen Modells’. Es wäre dann interessant, ob man aufgrund dieses Beispiels die Struktur eines psychoanalytischen Modells beispielhaft rekonstruieren und ’hinschreiben’ könnte.

Eine Fortsetzung findet sich HIER.

KONTEXTE

Einen Überblick über alle Einträge zur Philosophiewerkstatt nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs finden sich HIER.