Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 16.-17.Februar 2022, 18:00h

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Vorbemerkung

In einer Welt voller Bücher — gefühlt: unendlich viele Bücher — ist kaum voraussagbar, welches Buch man im Februar 2022 lesen wird. Dass es dann das Büchlein ‚A World of Propensities‘ (1990 (reprint 1995))[2a] von Karl Popper [1] sein würde, hing von einem ganzen Bündel von Faktoren ab, von denen jeder für sich ‚eine Rolle‘ spielte, aber dass es dann zu diesem konkreten Buch zu diesem konkreten Zeitpunkt gekommen ist, war aus Sicht der einzelnen Faktoren nicht direkt ableitbar. Auch das ‚Zusammenspiel‘ der verschiedenen Faktoren war letztlich nicht voraussagbar. Aber es ist passiert.

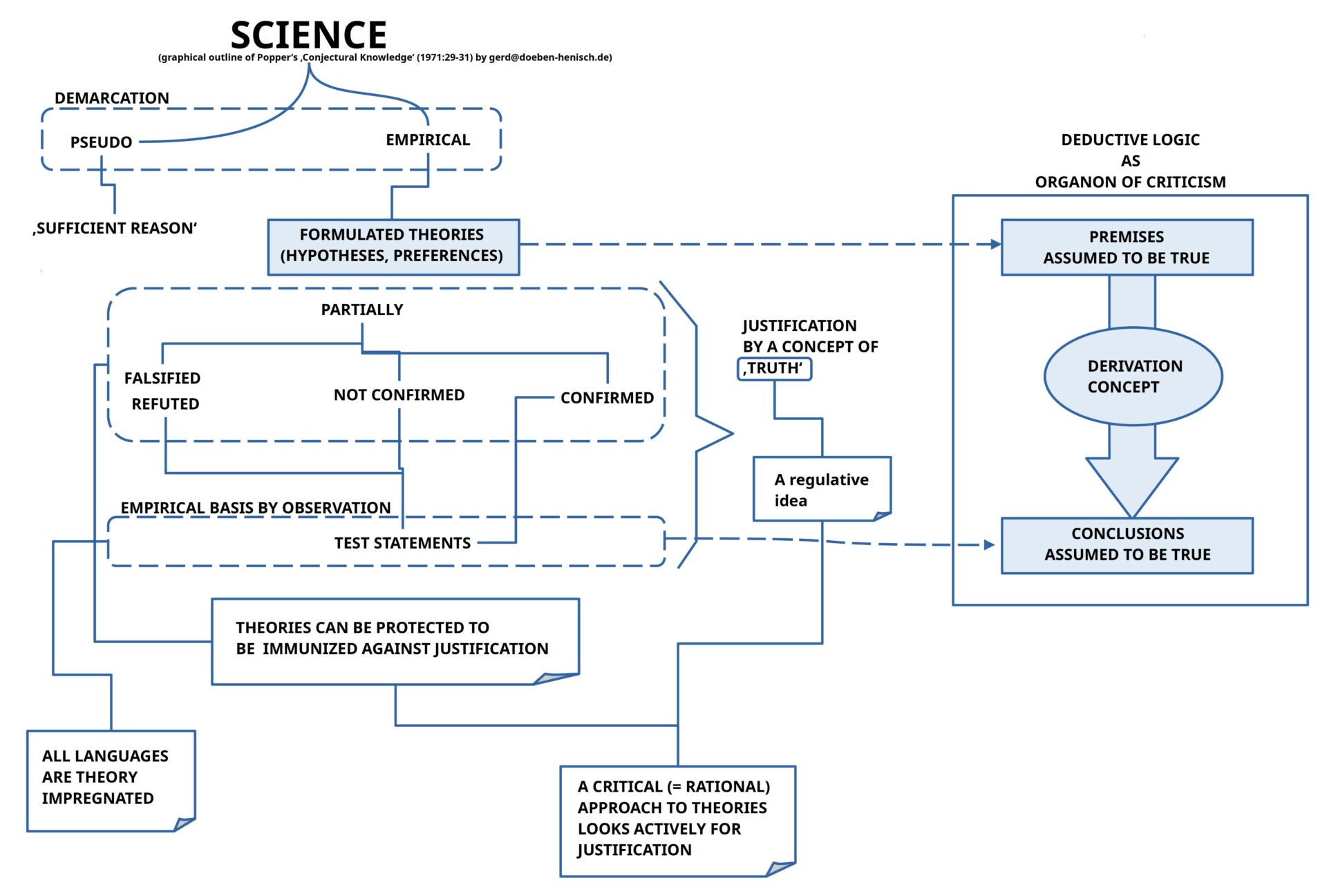

Im Rahmen meiner Theoriebildung für das oksimo-Paradigma (einschließlich der oksimo-Software)[4] Hatte ich schon viele Posts zur möglichen/ notwendigen Theorie für das oksimo-Paradigma in verschiedenen Blocks geschrieben [3a], sogar einige zum frühen Popper [3b], aber mir scheint, so richtig bin ich mit der Position von Popper in seiner ‚Logik der Forschung‘ von 1934 bzw. dann mit der späteren Englischen Ausgabe ‚The Logic of Scientific Discovery‘ (1959)[2b] noch nicht klar gekommen.

Im Frühjahr 2022 war es eine seltene Mischung aus vielerlei Faktoren, die mich über den Umweg der Lektüre von Ulanowizc [5], und zwar seines Buches „Ecology: The Ascendant Perspective“ (1997), auf den späten Popper aufmerksam machten. Ulanowizc erwähnt Popper mehrfach an prominenter Stelle, und zwar speziell Poppers Büchlein über Propensities. Da dieses schmale Buch mittlerweile vergriffen ist, kam ich dann nur durch die freundliche Unterstützung [6b] der Karl Popper Sammlung der Universität Klagenfurt [6a] zu einer Einsicht in den Text.

Der nachfolgende Text beschäftigt sich mit dem ersten der beiden Aufsätze die sich in dem Büchlein finden: „A World of Propensities: Two New Views of Causality“.[7][*]

Wahrscheinlichkeit, Wahrheit, Hypothese, Bekräftigung, … Vorgeplänkel

In seiner Einleitung im Text erinnert Popper an frühere Begegnungen mit Mitgliedern des Wiener Kreises [1b] und die Gespräche zu Theme wie ‚absolute Theorie der Wahrheit‘, ‚Wahrheit und Sicherheit‘, ‚Wahrscheinlichkeitsbasierte Induktion‘, ‚Theorie der Wahrscheinlichkeit‘ sowie ‚Grad der Bekräftigung einer Wahrscheinlichkeit‘.

Während er sich mit Rudolf Carnap 1935 noch einig wähnte in der Unterscheidung von einer Wahrscheinlichkeit im Sinne einer Wahrscheinlichkeitstheorie und einem ‚Grad der Bestätigung‘ (‚degree of confirmation‘) , war er sehr überrascht — und auch enttäuscht — 1950 in einem Buch von Carnap [8], [8b] zu lesen, dass für Carnap dies alles das Gleiche sei: mathematische Wahrscheinlichkeit und empirische Bestätigung eines Ereignisses. Hatte Carnap mit dieser Veränderung seiner Auffassung auch die Position einer ‚Absolutheit der Wahrheit‘ verlassen, die für Popper 1935 immer noch wichtig war? Und selbst in der Rede von 1988 hält Popper das Postulat von der Absolutheit der Wahrheit hoch, sich dabei auf Aristoteles [9], Alfred Tarski [10] und Kurt Gödel [11] beziehend (S.5f).

In einer Welt mit einem endlichen Gehirn, in einem endlichen Körper (bestehend aus ca. 36 Billionen Zellen (10^12)[12], in einer Welt von nicht-abzählbar vielen realen Ereignissen, war mir nie klar, woran (der frühe) Popper (und auch andere) die Position einer ‚absoluten Wahrheit‘ fest machen konnten/ können. Dass wir mit unserem endlichen – und doch komplexen, nicht-linearem — Gehirn von ‚Konkretheiten‘ ‚abstrahieren‘ können, Begriffe mit ‚offenen Bedeutungen‘ bilden und diese im Kontext der Rede/ eines Textes zu Aussagen über Aspekte der Welt benutzen können, das zeigt jeder Augenblick in unserem Alltag (ein für sich außergewöhnliches Ereignis), aber ‚absolute Wahrheit‘ … was kann das sein? Wie soll man ‚absolute Wahrheit‘ definieren?

Popper sagt, dass wir — und wenn wir uns noch so anstrengen — in unserem „Ergebnis nicht sicher“ sein können, das Ergebnis kann sogar „nicht einmal wahr“ sein.(vgl. S.6) Und wenn man sich dann fragt, was dann noch bleibt außer Unsicherheit und fehlender Wahrheit, dann erwähnt er den Sachverhalt, dass man von seinen „Fehlern“ auf eine Weise „lernen“ kann, dass ein „mutmaßliches (‚conjectural‘) Wissen“ entsteht, das man „testen“ kann.(vgl. S.6) Aber selbst dann, wenn man das Wissen testen kann, sind diese Ergebnisse nach Popper „nicht sicher“; obwohl sie „vielleicht wahr“ sind, diese Wahrheit aber ist damit dennoch „nicht endgültig bestätigt (‚established‘)“. Und er sagt sogar: „Selbst wenn sie [ergänzt: die Ergebnisse] sich als nicht wahr erweisen, … eröffnen sie den Weg zu noch besseren [ergänzt: Ergebnissen].“ (S.6)

Diese ‚changierende Sprechweise‘ über ‚wahre Ergebnisse‘ umschreibt das Spannungsfeld zwischen ‚absoluten Wahrheit‘ — die Popper postuliert — und jenen konkreten Sachverhalten, die wir im Alltag zu ‚Zusammenhängen (Hypothesen)‘ verdichten können, in denen wir einzelne Ereignisse ‚zusammen bringen‘ mit der ‚Vermutung‘, dass sie auf eine nicht ganz zufällige Weise zusammen gehören. Und, ja, diese unsere alltägliche Vermutungen (Hypothesen) können sich ‚alltäglich bestätigen‘ (wir empfinden dies so) oder auch nicht (dies kann Zweifel wecken, ob es ‚tatsächlich so ist‘).(vgl. S.6)

Das Maximum dessen, was wir — nach Popper — in der alltäglichen Erkenntnis erreichen können, ist das Nicht-Eintreten einer Enttäuschung einer Vermutung (Erwartung, Hypothese). Wir können dann „hoffen“, dass die Hypothese „wahr ist“, aber sie könnte sich dann beim nächsten Test vielleicht doch noch als „falsch“ erweisen. (vgl. S.6)

In all diesen Aussagen, dass ein Ergebnis ’noch nicht als wahr erwiesen wurde‘ fungiert der Begriff der ‚Wahrheit‘ als ein ‚Bezugspunkt‘, anhand dessen man eine vorliegende Aussage ‚vergleichen‘ kann und mit diesem Vergleich dann zum Ergebnis kommen kann, dass eine vorliegende Aussage ‚verglichen mit einer wahren Aussage‘ nicht wahr ist.

Messen als Vergleichen ist in der Wissenschaft der Goldstandard, aber auch im ganz normalen Alltag. Wo aber findet sich der Vergleichspunkt ‚wahr Aussage‘ anhand dessen eine konkrete Aussage als ’nicht dem Standard entsprechend‘ klassifiziert werden kann?

Zur Erinnerung: es geht jetzt hier offensichtlich nicht um einfache ‚Sachverhaltsfeststellungen‘ der Art ‚Es regnet‘, ‚Es ist heiß‘, ‚Der Wein schmeckt gut‘ …, sondern es geht um die Beschreibung von ‚Zusammenhängen‘ zwischen ‚isolierten, getrennten Ereignissen‘ der Art (i) ‚Die Sonne geht auf‘, (ii) ‚Es ist warm‘ oder ‚(i) ‚Es regnet‘, (ii) ‚Die Straße ist nass‘.

Wenn die Sonne aufgeht, kann es warm werden; im Winter, bei Kälte und einem kalten Wind kann man die mögliche Erwärmung dennoch nicht merken. Wenn es regnet dann ist die Straße normalerweise nass. Falls nicht, dann fragt man sich unwillkürlich, ob man vielleicht nur träumt?

Diese einfachen Beispiele deuten an, dass ‚Zusammenhänge‘ der Art (i)&(ii) mit einer gewissen Häufigkeit auftreten können, aber es keine letzte Sicherheit gibt, dass dies der Fall sein muss.

Wo kommt bei alldem ‚Wahrheit‘ vor?

‚Wahrheit an sich‘ ist schwer aufweisbar. Dass ein ‚Gedanke‘ ‚wahr‘ ist, kann man — wenn überhaupt — nur diskutieren, wenn jemand seinem Gedanken einen sprachlichen Ausdruck verleiht und der andere anhand des sprachlichen Ausdrucks (i) bei sich eine ‚Bedeutung aktivieren‘ kann und (ii) diese aktivierte Bedeutung dann entweder (ii.1) — schwacher Fall — innerhalb seines Wissens mit ‚anderen Teilen seines Wissens‘ ‚abgleichen‘ kann oder aber (ii.2) — starker Fall — seine ‚interne Bedeutung‘ mit einer Gegebenheit der umgebenden realen Ereigniswelt (die als ‚Wahrnehmung‘ verfügbar ist) vergleichen kann. In beiden Fällen kann der andere z.B. zu Ergebnissen kommen wie (a) ‚Ja, sehe ich auch so‘ oder (b) ‚Nein, sehe ich nicht so‘ oder (c) ‚Kann ich nicht entscheiden‘.

In diesen Beispielen wäre ‚Wahrheit‘ eine Eigenschaft, die der Beziehung zwischen einem sprachlichen Ausdruck mit seiner möglichen ‚Bedeutung‘ ‚zu etwas anderem‘ zukommt. Es geht in diesen Beispielen um eine dreistellige Beziehung: die beiden Größen (Ausdruck, gewusste Bedeutung) werden in Beziehung gesetzt zu (wahrgenommenem oder erinnertem oder gefolgertem Sachverhalt).[13]

‚Wahrgenommenes‘ resultiert aus Interaktionen unseres Körpers mit der umgebenden realen Ereigniswelt (wobei unsere Körper selbst ein Ereignis in der umgebenden realen Ereigniswelt ist).[14]

‚Bedeutungen‘ sind ‚gelernte Sachverhalte‘, die uns über unsere ‚Wahrnehmung‘ ‚bekannt geworden sind‘ und in der Folge davon möglicherweise auf eine schwer bestimmbare Weise in unser ‚Gedächtnis‘ übernommen wurden, aus dem Heraus wir sie auf eine ebenfalls schwer bestimmbaren Weise in einer ‚erinnerten Form‘ uns wiederholt wieder ‚bewusst machen können‘. Solche ‚wahrnehmbaren‘ und ‚erinnerbaren‘ Sachverhalte können von unserem ‚Denken‘ in schwer bestimmbarer Form eine spezifische ‚Bedeutungsbeziehung‘ mit Ausdrücken einer Sprache eingehen, welche wiederum nur über Wahrnehmung und Erinnern uns bekannt geworden sind.[15]

Aus all dem geht hervor, dass dem einzelnen Akteur mit seinen gelernten Ausdrücke und ihren gelernten Bedeutungen nur das ‚Ereignis der Wiederholung‘ bleibt, um einem zunächst ‚unbestimmt Gelerntem‘ eine irgendwie geartete ‚Qualifikation‘ von ‚kommt vor‘ zu verleihen. Kommt also etwas vor im Lichte von gelernten Erwartungen neigen wir dazu, zu sagen, ‚es trifft zu‘ und in diesem eingeschränkten Sinne sagen wir auch, dass ‚es wahr ist‘. Diese gelernten Wahrheiten sind ’notorisch fragil‘. Jene, die ‚im Laufe der Zeit‘ sich immer wieder ‚bewähren‘ gewinnen bei uns ein ‚höheres Vertrauen‘, sie haben eine ‚hohe Zuverlässigkeit‘, sind allerdings nie ganz sicher‘.

Zusätzlich erleben wir im Alltag das ständige Miteinander von ‚Konkretheiten‘ in der Wahrnehmung und ‚Allgemeinheiten‘ der sprachlichen Ausdrücke, eine ‚Allgemeinheit‘ die nicht ‚absolut‘ ist. sondern als ‚Offenheit für viel Konkretes‘ existiert. In der Sprache haben wir Unmengen von Worten wie ‚Tasse‘, ‚Stuhl‘, ‚Tisch‘, Hund‘ usw. die sich nicht nur auf ein einziges Konkretes beziehen, sondern auf — potentiell unendlich — viele konkrete Gegebenheiten. Dies liegt daran, dass es viele verschiedene konkrete Gegebenheiten gibt, die trotz Unterschiede auch Ähnlichkeiten aufweisen, die dann als ‚Tasse‘, ‚Stuhl‘ usw. bezeichnet werden. Unser Gehirn verfügt über ‚automatische (= unbewusste) Prozesse‘, die die Konkretheiten aus der Wahrnehmung in ‚Muster‘ transformieren, die dann als ‚Repräsentanten‘ von verschiedenen wahrgenommenen Konkretheiten fungieren können. Diese Repräsentanten sind dann das ‚Material der Bedeutung‘, mit denen sprachliche Ausdrücke — auch automatisch — verknüpft werden können.[15]

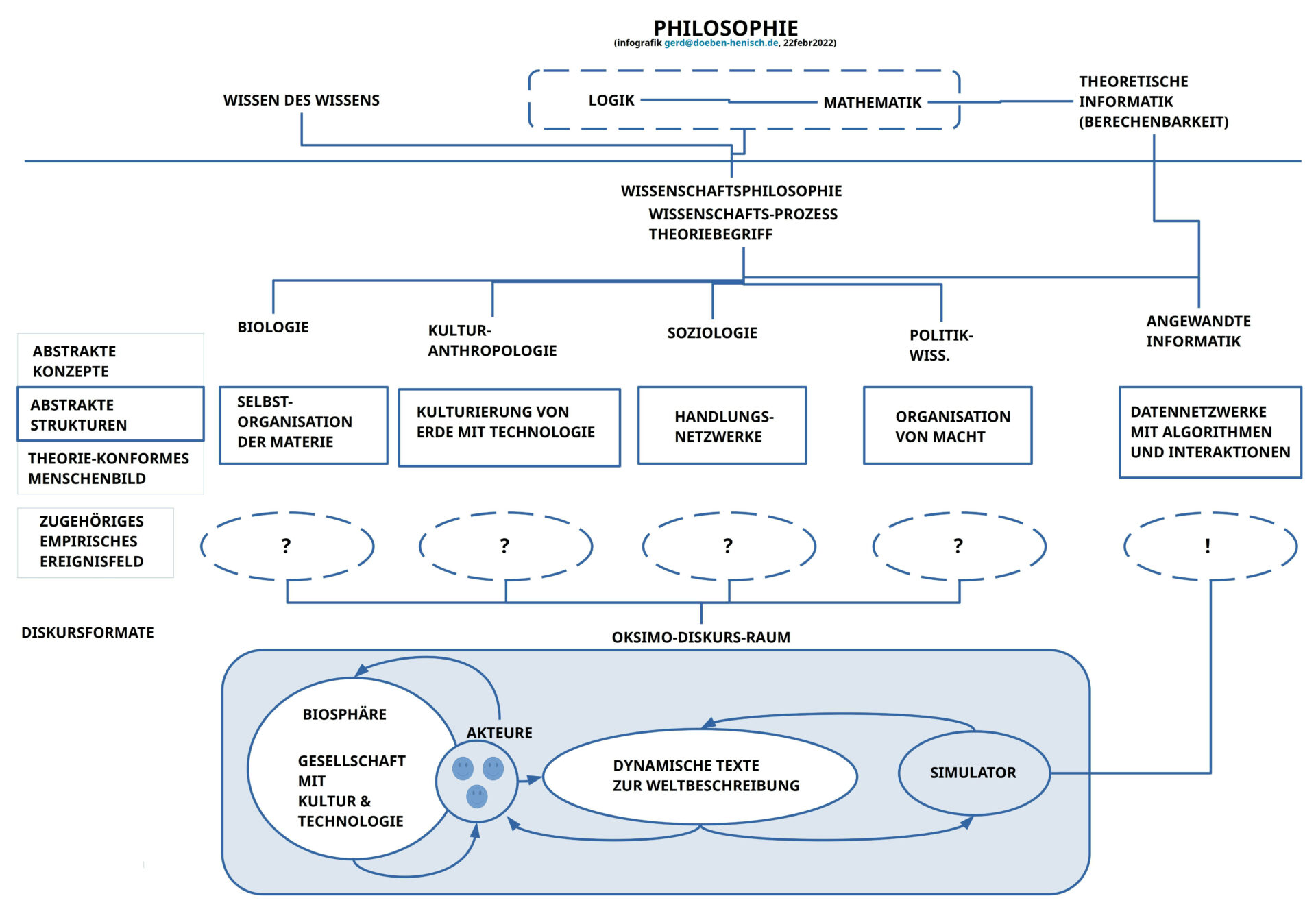

Unser ‚Denken‘ kann mit abstrakten Repräsentanten arbeiten, kann durch Benutzung von sprachlichen Ausdrücken Konstruktionen mit abstrakten Konzepten und Ausdrücken bilden, denen bedeutungsmäßig direkt nichts in der realen Ereigniswelt entsprechen muss bzw. auch nicht entsprechen kann. Logik [17] und Mathematik [18] sind bekannte Beispiele, wie man mit gedanklich abstrakten Konzepten und Strukturen ‚arbeiten‘ kann, ohne dass ein Bezug zur realen Ereigniswelt bestehe muss oder jemals bestehen wird. Innerhalb dieser Welt abstrakter Strukturen und abstrakter Ausdrücke kann es dann sogar in einem eingeschränkten Sinne ‚Wahrheit‘ als Übereinstimmung von abstrakten Ausdrücken, deren abstrakten Bedeutungen und den anderen gedachten abstrakten Strukturen geben, aber diese ‚abstrakten Wahrheiten‘ sind in keiner Weise auf die reale Ereigniswelt übertragbar. Für uns gibt es nur das Modell der Alltagssprache, die mit ihren ‚offenen abstrakten‘ Bedeutungen auf Konkretes Bezug nehmen kann und zwischen Gegenwart und Vergangenheit eine ‚gedachte Beziehung‘ herstellen kann, ebenso auch zwischen Vergangenem und Gegenwärtigem zu einer gedachten Zukunft. Inwieweit sich diese gedachten Beziehungen (Vermutungen, Hypothesen, …) dann in der realen Ereigniswelt bestätigen lassen, muss fallweise geprüft werden.

Die Welt der Wissenschaften erweckt den Eindruck, dass es mittlerweile eine große Zahl von solchen Hypothesen gibt, die allesamt als ‚weitgehend zuverlässig‘ angesehen werden, und aufgrund deren wir nicht nur unser bisheriges Wissen beständig ‚erweitern‘, sondern auch in einer Vielzahl von praktischen Anwendungen nutzen (Technologie, Landwirtschaft, Medizin, …).

Und an dieser Stelle greift Popper sehr weit aus, indem er diese für die Wissenschaften charakteristische „mutige, und abenteuerliche Weise des Theoretisierens“, ergänzt um „seriöse Tests“, im „biologischen Leben selbst“ am Werke sieht (vgl. S.7): die beobachtbare Entwicklung zu immer „höheren (‚higher‘) Formen“ des Lebens geschah/ geschieht durch Schaffung von „neuen Versuchen“ (‚trials‘), deren „Einbringung in die Realität“ (‚exposure‘), und dann das „Ausmerzen von Irrtümern“ (‚errors‘) durch „Testen“.(vgl. S.7) Mit dieser permanenten Kreativität neuer Lösungsansätze, deren Ausprobieren und dem daraus Lernen im Beseitigen von Fehlschlägen hat es nicht nur das biologische Leben als Ganzes geschafft, nach und nach die Welt quasi zu erobern, sondern in der Variante moderner empirischer Wissenschaft ist die Lebensform des Homo sapiens dabei, diese Eroberung auf neue Weise zu ergänzen. Während die biologische Evolution vor dem Homo sapiens primär um das nackte Überleben kämpfen musste, kann der Homo sapiens zusätzlich ‚reines Verstehen‘ praktizieren, das dann als ‚Werkzeug‘ zum Überleben beitragen kann. Für Popper ist ‚Verstehen‘ (‚understand‘) und ‚Lernen‘ (‚to learn more‘) das entscheidende Charakteristikum der Lebensform des Homo sapiens (als Teil des gesamten biologischen Lebens). Und in diesem Verstehensprojekt geht es um alles: um den ganzen Kosmos bis hin zum letzten Atom, um die Entstehung des Lebens überhaupt, um den ‚menschlichen Geist‘ (‚human mind‘) und die Art und Weise wie er stattfindet.(vgl. S.7)

Nach dieser ‚Einstimmung‘ wendet sich Popper dem speziellen Problem der Kausalität zu.

Kausalität – Ein wissenschaftliches Chamäleon

Der Begriff der ‚Kausalität‘ ist uns allen über den Alltag in vielfältigen Formen bekannt, ohne dass wir dazu gewöhnlich ein klares begriffliches Konzept entwickeln.

Geht es hingegen ‚um Etwas‘, z.B. um Geld, oder Macht, oder um eine gute Ernte, oder die Entwicklung einer Region, usw. , dann ist die Frage ‚Was was wie bewirkt‘ nicht mehr ganz egal. ‚Soll ich nun investieren oder nicht?‘ ‚Ist dieses Futter für die Tiere besser und auf Dauer bezahlbar oder nicht?‘ ‚Wird die neue Verkehrsregelung tatsächlich Lärm und CO2-Ausstoß reduzieren oder nicht?‘ ‚Ist Aufrüstung besser als Neutralität?‘ ‚Wird die Menge des jährlichen Plastikmülls die Nahrungsketten im Meer und damit viele davon abhängige Prozesse nachhaltig zerstören oder nicht?‘

Wenn Philosophen und Wissenschaftler von Kausalität sprechen meinten sie in der Vergangenheit meist viel speziellere Kontexte. So erwähnt Popper die mechanistischen Vorstellungen im Umfeld von Descartes; hier waren alle Ereignisse klar bestimmt, determiniert.(vgl. S.7) Mit der Entwicklung der Quantenmechanik — spätestens ab 1927 mit der Entdeckung des Unsicherheitsprinzips durch Werner Heisenberg [19], [19a] — wurde bewusst, dass die Ereignisse in der Natur keinesfalls vollständig klar und nicht vollständig determiniert sind. (vgl. S7f)

Damit trat eine inhärente Unsicherheit hervor, die nach einer neuen Lösung verlangte. Die große Zeit des Denkens in Wahrscheinlichkeiten begann.[20] Man kann das Denken in Wahrscheinlichkeiten grob in drei (vier) Sichtweisen unterscheiden: (i) In einer theoretischen — meist mathematischen — Sicht [21] definiert man sich abstrakte Strukturen, über die man verschiedene Operationen definieren kann, mit denen sich dann unterschiedliche Arten von Wahrscheinlichkeiten durchspielen lassen. Diese abstrakten (theoretischen) Wahrscheinlichkeiten haben per se nichts mit der realen Welt der Ereignisse zu tun. Tatsächlich erweisen sich aber viele rein theoretische Modelle als erstaunlich ’nützlich‘ bei der Interpretation realweltlicher Ereignisfolgen. (ii) In einer subjektivistischen Sicht [22] nimmt man subjektive Einschätzungen zum Ausgangspunkt , die man formalisieren kann, und die Einschätzungen zum möglichen Verhalten des jeweiligen Akteurs aufgrund seiner subjektiven Einschätzungen erlauben. Da subjektive Weltsichten meistens zumindest partiell unzutreffend sind, z.T. sogar überwiegend unzutreffend, sind subjektive Wahrscheinlichkeiten nur eingeschränkt brauchbar, um realweltliche Prozesse zu beschreiben.(iii) In einer (deskriptiv) empirischen Sicht betrachtet man reale Ereignisse, die im Kontext von Ereignisfolgen auftreten. Anhand von diversen Kriterien mit der ‚Häufigkeit‘ als Basisterm kann man die Ereignisse zu unterschiedlichen Mustern ‚gruppieren‘, ohne dass weitergehende Annahmen über mögliche Wirkzusammenhänge mit ‚auslösenden Konstellationen von realen Faktoren‘ getätigt werden. Nimmt man eine solche ‚deskriptive‘ Sicht aber zum Ausgangspunkt, um weitergehende Fragen nach möglichen realen Wirkzusammenhängen zu stellen, dann kommt man (iv) zu einer eher objektivistischen Sicht. [23] Hier sieht man in der Häufigkeiten von Ereignissen innerhalb von Ereignisfolgen mögliche Hinweise auf reale Konstellationen, die aufgrund ihrer inhärenten Eigenschaften diese Ereignisse verursachen, allerdings nicht ‚monokausal‘ sondern ‚multikausal‘ in einem nicht-deterministischem Sinne. Dies konstituiert die Kategorie ‚Nicht deterministisch und zugleich nicht rein zufällig‘.[24]

Wie der nachfolgende Text zeigen wird, findet man Popper bei der ‚objektivistischen Sicht‘ wieder. Er bezeichnet Ereignisse, die durch Häufigkeiten auffallen, als ‚Propensities‘, von mir übersetzt als ‚Tendenzen‘, was letztlich aber nur im Kontext der nachfolgenden Erläuterungen voll verständlich wird.

Popper sagt von sich, dass er nach vielen Jahren Auseinandersetzung mit der theoretischen (mathematischen) Sicht der Wahrscheinlichkeit (ca. ab 1921) (vgl. S.8f) zu dieser — seiner — Sicht gelangt ist, die er 1956 zum ersten Mal bekannt gemacht und seitdem kontinuierlich weiter entwickelt hat.[24]

Also, wenn man beobachtbare Häufigkeiten von Ereignissen nicht isoliert betrachtet (was sich angesichts des generellen Prozesscharakters aller realen Ereignisse eigentlich sowieso verbietet), dann kommt man wie Popper zu der Annahme, dass die beobachtete — überzufällige aber dennoch auch nicht deterministische — Häufigkeit die nachfolgende ‚Wirkung‘ einer realen Ausgangskonstellation von realen Faktoren sein muss, deren reale Beschaffenheit einen ‚Anlass‘ liefert, dass ‚etwas Bestimmtes passiert‘, was zu einem beobachtbaren Ereignis führt.(vgl. S.11f, dazu auch [25]) Dies schließt nicht aus, dass diese realen Wirkungen von spezifischen ‚Bedingungen‘ abhängig sein können, die erfüllt sein müssen, damit es zur Wirkung kommt. Jede dieser Bedingungen kann selbst eine ‚Wirkung‘ sein, die von anderen realen Faktoren abhängig ist, die wiederum bedingt sind, usw. Obwohl also ein ‚realer Wirkzusammenhang‘ vorliegen kann, der als solcher ‚klar‘ ist — möglicherweise sogar deterministisch — kann eine Vielzahl von ‚bedingenden Faktoren‘ das tatsächliche Auftreten der Wirkung so beeinflussen, dass eine ‚deterministische Wirkung‘ dennoch nicht als ‚deterministisch‘ auftritt.

Popper sieht in dieser realen Inhärenz von Wirkungen in auslösenden realen Faktoren eine bemerkenswerte Eigenschaft des realen Universums.(vgl. S.12) Sie würde direkt erklären, warum Häufigkeiten (Statistiken) überhaupt stabil bleiben können. (vgl. S.12). Mit dieser Interpretation bekommen Häufigkeiten einen objektiven Charakter. ‚Häufigkeiten‘ verwandeln sich in Indikatoren für ‚objektive Tendenzen‘ (‚propensities‘), die auf ‚reale Kräfte‘ verweisen, deren Wirksamkeit zu beobachtbaren Ereignissen führen.(vgl. S.12)

Die in der theoretischen Wahrscheinlichkeit verbreitete Charakterisierung von wahrscheinlichen Ereignissen auf einer Skala von ‚1‘ (passiert auf jeden Fall) bis ‚0‘ (passiert auf keinen Fall) deutet Popper für reale Tendenzen dann so um, dass alle Werte kleiner als 1 darauf hindeuten, dass es mehrere Faktoren gibt, die aufeinander einwirken, und dass der ‚Nettoeffekt‘ aller Einwirkungen dann zu einer realen Wirkung führt die kleiner als 1 ist, aber dennoch vorhanden ist; man kann ihr über Häufigkeiten sogar eine phasenweise Stabilität im Auftreten zuweisen, so lange sich die Konstellation der wechselwirkenden Faktoren nicht ändert.(vgl. S.13) Was hier aber wichtig ist — und Popper weist ausdrücklich darauf hin — die ‚realen Tendenzen‘ verweisen nicht auf einzelne konkrete, spezielle Eigenschaften inhärent in einem Objekt, sondern Tendenzen korrespondieren eher mit einer ‚Situation‘ (’situation‘), die als komplexe Gesamtheit bestimmte Tendenzen ‚zeigt‘.(vgl. SS.14-17) [26]

Schaut man nicht nur auf die Welt der Physik sonder lenkt den Blick auf den Alltag, in dem u.a. auch biologische Akteure auftreten, speziell auch Lebensformen vom Typ Homo sapiens, dann explodiert der Raum der möglichen Faktoren geradezu, die Einfluss auf den Gang der Dinge nehmen können. Nicht nur bildet der Körper als solcher beständig irgendwelche ‚Reize‘ aus, die auf den Akteur einwirken, sondern auch die Beschaffenheit der Situation wirkt in vielfältiger Weise. Insbesondere wirkt sich die erworbene Erfahrung, das erworbene Wissen samt seinen unterschiedlichen emotionalen Konnotationen auf die Art der Wahrnehmung aus, auf die Art der Bewertung des Wahrgenommenen und auf den Prozess möglicher Handlungsentscheidungen. Diese Prozesse können extrem labil sein, so dass Sie in jedem Moment abrupt geändert werden können. Und dies gilt nicht nur für einen einzelnen Homo sapiens Akteur, sondern natürlich auch für die vielen Gruppen, in denen ein Homo sapiens Akteur auftreten kann bzw. auftritt bzw. auftreten muss. Dieses Feuerwerk an sich wechselseitig beständig beeinflussenden Faktoren sprengt im Prinzip jede Art von Formalisierung oder formalisierter Berechnung. Wir Menschen selbst können dem ‚Inferno des Alles oder Nichts‘ im Alltag nur entkommen, wenn wir ‚Konventionen‘ einführen, ‚Regeln des Verhaltens‘, ‚Rollen definieren‘ usw. um das praktisch unberechenbare ‚Universum der alltäglichen Labilität‘ partiell zu ‚zähmen‘, für alltägliche Belange ‚berechenbar‘ zu machen.

Popper zieht aus dieser Beschaffenheit des Alltags den Schluss, das Indeterminismus und freier Wille zum Gegenstandsbereich und zum Erklärungsmodell der physikalischen und biologischen Wissenschaften gehören sollten.(vgl. S.17f)

Popper folgert aus einer solchen umfassenden Sicht von der Gültigkeit der Tendenzen-Annahme für vorkommende reale Ereignisse, dass die Zukunft nicht determiniert ist. Sie ist objektiv offen.(vgl. S.18)

Näher betrachtet ist die eigentliche zentrale Einsicht tatsächlich gar nicht die Möglichkeit, dass bestimmte Wirkzusammenhänge vielleicht tatsächlich determiniert sein könnten, sondern die Einsicht in eine durchgängige Beschaffenheit der uns umgebenden realen Ereigniswelt die sich – dies ist eine Hypothese! — durchgängig als eine Ansammlung von komplexen Situationen manifestiert, in denen mögliche unterscheidbare Faktoren niemals isoliert auftreten, sondern immer als ‚eingebettet‘ in eine ‚Nachbarschaften‘, so dass sowohl jeder Faktor selbst als auch die jeweiligen Auswirkungen dieses einen Faktors immer in kontinuierlichen Wechselwirkungen mit den Auswirkungen anderer Faktoren stehen. Dies bedeutet, dass nicht nur die starke Idealisierungen eines mechanistischen Weltbildes — auch eine Hypothese — als fragwürdig angesehen werden müssen, sondern auch die Idealisierung der Akteure zu einer ‚ Monade‘ [27],[27b], die die Welt letztlich nur ‚von sich aus‘ erlebt und gestaltet — eine andere Hypothese –.[27c]

Denkt man gemeinsam mit Popper weiter in die Richtung einer totalen Verflechtung aller Faktoren in einem kontinuierlich-realen Prozess, der sich in realen Tendenzen manifestiert (vgl. S.18f), dann sind alle üblichen endlichen, starren Konzepte in den empirischen Wissenschaften letztlich nicht mehr seriös anwendbar. Die ‚Zerstückelung‘ der Wirklichkeit in lauter einzelne, kleine, idealisierte Puzzle-Teile, wie sie bis heute Standard ist, führt sich relativ schnell ad absurdum. Die übliche Behauptung, auf andere Weise könne man eben nichts Verwertbares Erkennen, läuft beständig Gefahr, auf diese Weise die reale Problematik der konkreten Forschungspraxis deutlich zu überdehnen, nur weil man in der Tat Schwierigkeiten hat, die vorfindliche Komplexität ‚irgendwie experimentell nachvollziehbar‘ zu rekonstruieren.

Popper dehnt seine Beispiele für die Anwendbarkeit einer objektivistischen Sicht von realen Tendenzen weiterhin aus auf die Chemie (vgl. S.19f) und auf die Evolution des Lebens. (vgl. S.20) Und auch wenn er zuvor sagte, dass die Zukunft objektiv offen sei, so ist sie dennoch in der realen Gegenwart implizit gegenwärtig in den Aktivitäten der vorhandenen realen Faktoren.(vgl. S.20) Anders formuliert, jede Zukunft entscheidet sich immer jetzt, in der Gegenwart, auch wenn die lebenden Akteure zu einem bestimmten Zeitpunkt vielleicht das Geflecht der vielen Faktoren und Wirkungen nur unvollständig durchschauen. Mangelndes Wissen ist auch ein realer Faktor und kann als solcher u.U. wichtige Optionen übersehen, die — würde man sie kennen — vielleicht viel Unheil ersparen würden.

Nachbemerkung – Epilog

Verglichen mit den vielen Seiten Text, die Popper im Laufe seines Lebens geschrieben hat, erscheint der hier kommentierte kurze Text von 27 Seiten verschwindend kurz, gering, möglicherweise gar unbedeutend.

Betrachtet man aber die Kernthesen von Poppers theoretischem Prozess, dann tauchen diese Kernthesen in diesem kurzen Text letztlich alle auf! Und seine Thesen zur Realität von beobachtbaren Tendenzen enthalten alles, was er an Kritik zu all jenen Wissenschaftsformen gesagt hat, die dieser Kernthese nicht folgen. Der ganze riesige Komplex zur theoretischen Wahrscheinlichkeit, zu subjektiver Wahrscheinlichkeit und zu den vielfältigen Spezialformen von Überlegungen zur Wahrscheinlichkeit sagen letztlich nicht viel, wenn sie die objektivistische Interpretation von Häufigkeiten, dazu im Verbund mit der Annahme eines grundlegenden realen Prozesses, in dem sich alle realen Faktoren in beständiger realer Wechselbeziehung befinden, nicht akzeptieren. Die moderne Quantenmechanik wäre in einer realen Theorie der objektiven Tendenzen tatsächlich eine Teiltheorie, weil sie nur einige wenige — wenngleich wichtige — Aspekte der realen Welt thematisiert.

Poppers Mission einer umfassenden Theorie von Wahrheit als Innensicht einer umfassenden prozesshaften Realität bleibt — so scheint es mir — weiterhin brandaktuell.

Fortsetzung Popper 1989

Eine Kommentierung des zweiten Artikels aus dem Büchlein findet sich HIER.

Anmerkungen

Abkürzung: wkp := Wikipedia, de := Deutsche, en := Englische

[*] Es gibt noch zwei weiter Beiträge vom ’späten‘ Popper, die ich in den Diskurs aufnehmen möchte, allerdings erst nachdem ich diesen Beitrag rezipiert und in das finale Theorieformat im Kontext des oksimo-Paradigmas eingebunden habe.

[1] Karl Popper in wkp-en: https://en.wikipedia.org/wiki/Karl_Popper (auch in wkp-de: https://de.wikipedia.org/wiki/Karl_Popper )

[1b] Wiener Kreis (‚vienna circle‚) in wkp-de: https://de.wikipedia.org/wiki/Wiener_Kreis und wkp-en: https://en.wikipedia.org/wiki/Vienna_Circle

[2a] Karl Popper, „A World of Propensities“, Thoemmes Press, Bristol, (1990, repr. 1995)

[2b] Karl Popper, The Logic of Scientific Discovery, zuerst publiziert 1935 auf Deutsch als Logik der Forschung, dann 1959 auf Englisch durch Basic Books, New York (viele weitere Ausgaben folgten; ich benutze die eBookausgabe von Routledge (2002))

[3a] Die meisten wohl im uffmm.org Blog.

[3b] Oksimo und Popper in uffmm.org: https://www.uffmm.org/2021/03/15/philosophy-of-science/

[4] Das oksimo-Paradigma und die oksimo-Software auf oksimo.org: https://www.oksimo.org/

[5] Robert Ulanowizc in wkp-en: https://en.wikipedia.org/wiki/Robert_Ulanowicz

[5b] Robert Ulanowizc, Ecology: The Ascendant Perspective, Columbia University Press (1997)

[6a] Karl-Popper Sammlung der Universität Klagenfurt in wkp-de: https://www.aau.at/universitaetsbibliothek-klagenfurt/karl-popper-sammlung/

[6b] An dieser Stelle möchte ich die freundliche Unterstützung von Mag. Dr. Thomas Hainscho besonders erwähnen.

[7] Eine kürzere Version dieses Artikels hat Popper 1988 auf dem Weltkongress der Philosophie 1988 im Brighton vorgetragen (Vorwort zu [2a]).

[8] Rudolf Carnap in wkp-en: https://en.wikipedia.org/wiki/Rudolf_Carnap

[8b] Rudolf Carnap, Logical Foundations of Probability. University of Chicago Press (1950)

[9] Aristoteles in wkp-de: https://de.wikipedia.org/wiki/Aristoteles

[10] Alfred Tarski in wkp-en: https://en.wikipedia.org/wiki/Alfred_Tarski

[11] Kurt Gödel in wkp-ed: https://en.wikipedia.org/wiki/Kurt_G%C3%B6del

[12] Aus dem Buch von Kegel „Die Herrscher der Welt…“: Siehe https://www.cognitiveagent.org/2015/12/06/die-herrscher-der-welt-mikroben-besprechung-des-buches-von-b-kegel-teil-1/

[13] Natürlich ist die Sachlage bei Betrachtung der hier einschlägigen Details noch ein wenig komplexer, aber für die grundsätzliche Argumentation reicht diese Vereinfachung.

[14] Das sagen uns die vielen empirischen Arbeiten der experimentellen Psychologie und Biologie, Hand in Hand mit den neuen Erkenntnissen der Neuropsychologie.

[15] Hinter diesen Aussagen stecken die Ergebnisse eines ganzen Bündels von wissenschaftlichen Disziplinen: vorweg wieder die experimentelle Psychologie mit hunderten von einschlägigen Arbeiten, ergänzt um Linguistik/ Sprachwissenschaften, Neurolinguistik, ja auch verschiedene philosophische ‚Zuarbeiten‘ aus dem Bereich Alltagssprache (hier unbedingt der späte Wittgenstein [16] als großer Inspirator) und der Semiotik.

[16] Ludwig Wittgenstein in wkp-en: https://en.wikipedia.org/wiki/Ludwig_Wittgenstein

[17] Logik ( ‚logic‚) in der wkp-de: https://de.wikipedia.org/wiki/Logik und wkp-en: https://en.wikipedia.org/wiki/Logic

[18] Mathematik (‚mathematics‚) in der wkp-de: https://de.wikipedia.org/wiki/Mathematik und wkp-en: https://en.wikipedia.org/wiki/Mathematics

[19] Werner Heisenberg in wkp-en: https://en.wikipedia.org/wiki/Werner_Heisenberg

[19b] Unsicherheitsprinzip (‚uncertainty principle‘) in wkp-en: https://en.wikipedia.org/wiki/Uncertainty_principle

[20] Natürlich gab es schon viele Jahrhunderte früher unterschiedliche Vorläufer eines Denkens in Wahrscheinlichkeiten.

[21] Theoretische Wahrscheinlichkeit, z.B. in wkp-en: https://en.wikipedia.org/wiki/Probability

[22] Subjektive Wahrscheinlichkeit, z.B. in wkp-de: https://de.wikipedia.org/wiki/Subjektiver_Wahrscheinlichkeitsbegriff; illustrieret mit der Bayeschen Wahrscheinlichkeit in wkp-en: https://en.wikipedia.org/wiki/Bayesian_probability

[23] Objektivistische Wahrscheinlichkeit, nur ansatzweise erklärt in wkp-de: https://de.wikipedia.org/wiki/Objektivistischer_Wahrscheinlichkeitsbegriff

[23b] Deskriptive Statistik in wkp-de: https://de.wikipedia.org/wiki/Deskriptive_Statistik (siehe auch ‚descriptive statistics in wkp-en: https://en.wikipedia.org/wiki/Descriptive_statistics

[24] Zu verschiedenen Sichten von Wahrscheinlichkeiten sie auch: Karl Popper, The Open Universe: An Argument for Indeterminism, 1956–57 (as privately circulated galley proofs;) 1982 publiziert als Buch

[25] Hier sei angemerkt, dass ein Akteur natürlich nur dann ein bestimmtes Ereignis wahrnehmen kann, wenn er (i) überhaupt hinschaut und (ii) er über geeignete Beobachtungsinstrumente (= Messgeräte) verfügt, die das jeweilige Ereignis anzeigen. So sah die Welt z.B. ohne Fernglas und Mikroskop ‚einfacher‘ aus als mit.

[26] Diese Betonung einer Situation als Kontext für Tendenzen schließt natürlich nicht aus, dass die Wissenschaften im Laufe der Zeit gewisse Kontexte (z.B. das Gehirn, der Körper, …) schrittweise immer mehr auflösen in erkennbare ‚Komponenten‘, deren individuelles Verhalten in einem rekonstruierbaren Wechselspiel unterschiedliche Ereignisfolgen hervorbringen kann, die zuvor nur grob als reale Tendenz erkennbar waren. Tatsächlich führt eine zunehmende ‚Klarheit‘ bzgl. der internen Struktur einer zuvor nicht analysierbaren Situation auch zur Entdeckung von weiteren Kontextfaktoren, die zuvor unbekannt waren.(vgl. S.14f)

[27] Gottfried Wilhelm Leibniz in wkp-de: https://de.wikipedia.org/wiki/Gottfried_Wilhelm_Leibniz

[27b] Monadenlehre von Leibnuz in wkp-de: https://de.wikipedia.org/wiki/Monade_(Philosophie)

[27c] Allerdings muss man bemerken, dass die Leibnizsche Monadenlehre natürlich in einem ziemlich anderen ‚begrifflichen Koordinatensystem‘ einzubetten ist und die Bezugnahme auf diese Lehre nur einen stark vereinfachten Aspekt trifft.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.