KONTEXT

- Diesem Beitrag ging ein Blogeintrag voraus mit einer einleitenden methodischen Reflexion sowie die Identifizierung einer ersten Periode im Phänomen des biologischen Lebens auf der Erde.

UR-GEDÄCHTNIS, ABSTRAKTES WISSEN

- Ein wichtiger Punkt der ersten Periode des biologischen Lebens ist jene Struktur, welche erstmalig im Universum die Überwindung der Gegenwart durch eine gedächtnishafte Kumulierung von Eigenschaften und Beziehungen (Speichermolekül, Bauplan, Genom…) erlaubt, wodurch die Erfolge der Vergangenheit in die aktuelle Gegenwart hinein wirken können.

- Die Herrschaft des Augenblicks wird damit ansatzweise überwunden. Nicht mehr das aktuell Faktische (‚Seiende‘) ist die eigentliche Wahrheit, sondern erinnerte Eigenschaften und Beziehungen werden zu einer höheren Wahrheit, einer Wahrheit zweiter Ordnung; das Abstrakte und darin Virtuelle erweist sich als die bessere Aussage über die Gegenwart. Das gegenwärtig Stattfindende, aktuell in die Sinne Springende, ist nur ein Aspekt an einem dynamischen Geschehen, das als Geschehen mehr von der Wirklichkeit, vom Leben enthüllt, als das jeweils aktuell Seiende.

- Rückblickend gewinnt damit der Prozess, der zur Entstehung der ersten Zelle führte, ein eminent philosophische Bedeutung: wie konnte die sogenannte tote und dumme, schlichtweg die geistlose Materie, in der Lage sein, im Meer der Atome und Moleküle auf der frühen Erde eine Prozessumgebung bereit zu halten, in der sich chemische Prozesse so abspielten, dass nicht nur neue Energieumwandlungs- und -nutzungskonzepte entstehen konnten, sondern zugleich der Prozess sich selbst in Form eines Moleküls so kodiert, dass er sich bei der Selbstreproduktion auch wieder dekodieren konnte. Für die molekularbiologischen Details dieses komplexen Prozesses sei auf entsprechende Literatur verwiesen (Neben z.B. Christian de Duve sei noch vierwiesen auf The Origin and Nature of Life on Earth: The Emergence of the Fourth Geosphere. Cambridge University Press, 2016, Smith, Eric and Morowitz, Harold J.). Philosophisch entscheidend ist letztlich, was durch diese komplexen Prozesse an wirkender Struktur und Funktionalität oberhalb der molekularen Ebene entstanden ist, welche die sich selbst reproduzierende Zelle mit einer ersten Form von Wissen ausgestattet haben.

UR-AUTOMAT, UR-ALGORITHMUS

- Die Besonderheit dieses ersten Wissens (‚Proto-Wissen‘, ‚Ur-Wissen‘…) liegt in seinem algorithmischen Charakter: im Wechselspiel mit den dekodierenden Elementen einer Zelle zeigen diese Strukturen eine strukturelle Ähnlichkeit mit dem Konzept der Turingmaschine, das 1936 von Alan M.Turing entdeckt wurde, um das Phänomen der Berechenbarkeit zu beschreiben. Wie sich herausstellte, lassen sich alle Computer, die zeitlich nach Turing als reale Maschinen entwickelt wurden, bislang mit dem abstrakten Konzept der Turingmaschine beschreiben. [ANMERKUNG: Dass die neu entwickelten Quantencomputer von diesem Konzept abweichen, müsste erste noch bewiesen werden. Denn dass Prozesse ‚sehr schnell‘ sind, ‚parallel‘ stattfinden, und mehr als nur ‚zwei Zustände‘ kennen, sprengt das mathematische Konzept der Turingmaschine nicht notwendigerweise.]

- Diese Strukturähnlichkeit des Automatenkonzepts mit den elementaren Wissensnutzungskonzepten der ersten biologischen Zellen (und dann natürlich aller NachfolgerInnen) ist philosophisch von Interesse. Es legt die Vermutung nahe, dass das moderne algorithmische Informationsverarbeitungskonzept möglicherweise eine elementare Eigenschaft des biologischen Lebens selbst anzeigt, das ja nicht in einzelnen isolierten Komponenten besteht, sondern als ein dynamischer Zusammenhang auftritt, der auf der Basis der Eigenschaften der Materie in der Lage ist, solche Prozesse zum Laufen zu bringen, in denen sich dynamische Eigenschaften des Universums in geeignete abstrakte Kodierungen übersetzen lassen, die wiederum zu Befehlsketten für neue Prozesse werden können.

UR-ZEICHEN, UR-SEMIOTISCHER AKTEUR

- Mit Blick auf den weiteren Fortgang der biologischen Evolution ist auch noch folgender Perspektivwechsel von Interesse. Die Kodierung von Realität in eine repräsentierende Struktur mittels eines Materials für die Codeelemente (hier: Atomverbindungen im Kontext eines Moleküls) und die Dekodierung der im Material angeordneten Codeelemente mittels einer Dekodierungsvorschrift, kann man auch als semiotischen Prozess verstehen: die zu kodierende (auch prozesshafte) Realität bildet dann die Bedeutung (‚meaning‘), die in einem Zeichenmaterial (die Codeelemente) repräsentiert wird, und der Zusammenhang zwischen Zeichenmaterial und Bedeutung wird über eine Bedeutungsbeziehung hergestellt, welche immer eine prozesshafte Instanz sein muss, die sowohl die Kodierung wie auch die Dekodierung leisten kann. Innerhalb einer realisierten Bedeutungsbeziehung erscheint das Zeichenmaterial dann als Zeichen für die Bedeutung und umgekehrt wird die bezeichnete Realität zur Bedeutung des Zeichens.

- Außerhalb der Bedeutungsbeziehung gibt es weder Bedeutung noch Zeichen. Zeichen und Bedeutung sind an eine prozesshafte Instanz gebunden, durch die diese Beziehung generiert und realisiert wird. Nennt man jene prozesshafte Instanz, die Zeichenbeziehungen ermöglicht, einen semiotischen Akteur, dann ist die erste biologische Zelle der erste semiotische Akteur des Universums. Das Prozessmodell, das hier zum Tragen kommt ist – jenseits der molekularbiologischen Perspektive – das eines Automaten, das einer Turingmaschine, und damit repräsentiert die biologische Zelle – in philosophisch formaler Sicht – den ersten algorithmischen semiotischen Akteur des Universums.

- Zum Zeichenkonzept gehört auch, dass es konventionell ist: es ist beliebig, welches Ausdrucksmaterial die Prozessinstanz welchen möglichen Realitäten zuordnet. Das Beschränkende daran ist, dass die Zeichenbeziehung, die dann faktisch eingerichtet wurden, spezifisch sind: alle semiotischen Akteure, die die gleiche Zeichenbeziehung benutzen wollen, müssen sich bezüglich der Zeichenbeziehung koordinieren. Das Entgrenzende an einer Zeichenbeziehung ist, dass sie im Prinzip die gesamte Realität in sich aufnehmen kann. Durch einen semiotischen Prozess kann man die empirische Realität in eine abstrakt-virtuelle Realität transformieren und dabei zugleich verändern. Die veränderte virtuelle Realität kann dann dazu benutzt werden, um die empirische Realität im Hinblick auf mögliche zukünftige empirische Zustände zu befragen und neue Varianten voraus zu denken.

- Die Verfügbarkeit einer Zeichenbeziehung gibt damit einem individuellen System eine potentiell unbegrenzte Macht zum Verändern. Andererseits funktioniert dies nur, wenn der semiotische Akteur nicht alleine agiert, sondern als Teil einer Kollektion von semiotischen Akteuren. Jeder kann zwar die Zeichenbeziehung für sich ändern, sie gehört aber niemandem alleine. Es ist ein kollektives Wissen, das sich den einzelnen schafft und durch die Aktivität des einzelnen partiell, graduell modifizierbar ist.

- In der Phase der ersten semiotischen Revolution des Lebens wurde die Einheit der Zeichenbeziehung gewahrt durch die gemeinsame Nutzung der RNA- und DNA-Moleküle samt deren molekularen Kodierungs- und Dekodierungsstrukturen, die allen Zellen gleich sind. Und diese gesamte Zeichenstruktur war realisiert als eine universelle Turingmaschine.

REPRÄSENTATIONSPROBLEME

- Man kann sich fragen, in welcher Weise sich diese biologisch vorfindbaren Strukturen und Dynamiken im bisherigen Komplexitätskonzept identifizieren lassen? Wie lässt sich eine algorithmische semiotische Prozessstruktur mit Gedächtnis systemtheoretisch fassen? Was sagen schon Input-Output Mengen, interne Level, mit Blick auf solch komplexe Eigenschaften?

- Zeitlich punktuelle und beziehungsmäßig isolierte repräsentierende Strukturen können offensichtlich Phänomene, die sich in der Zeit erstrecken und in Wechselwirkungen stattfinden, nicht angemessen repräsentieren. Dazu kommen semiotische Eigenschaften und auch Erfolgskriterien der empirischen Systeme, die sich neben der Zeit auch in übergeordneten Strukturen repräsentieren (wenn überhaupt).

- Zusätzlich gibt es das Phänomen der Strukturveränderung STR im Laufe der Zeit, die zugleich einhergeht mit Verhaltensänderungen f. Und diese Veränderungen erfolgen nicht isoliert, sondern in einem Feld anderer Strukturen {<STR1,f1>, …, <STRn,fn>}(t1) ==> {<STR1,f1>, …, <STRn,fn>}(t1+1) und von Umgebungskontexten {C1, …, Cn}(t1)==> {C1, …, Cn}(t1+1) , die sich mit verändern.

- Jede einzelne biologische Struktur ist zudem Teil einer übergreifenden biologischen Population POP, die einen ähnlich kodierten Wissensspeicher G teilt, also POP = {Menge aller STRi für die gilt, dass ihr kodiertes Wissen Gi zur einer Ähnlichkeitsklasse Gi gehört}.

- Hier deuten sich komplexe Vernetzungsstrukturen in der Zeit an, die in dem bisherigen Komplexitätskonzept nicht befriedigend repräsentiert sind.

- Mit diesen ungelösten Fragen im Hinterkopf stellt sich die weitere Frage, welche der nachfolgenden Ereignisse in der biologischen Evolution eine weitere Steigerung der Komplexität manifestieren?

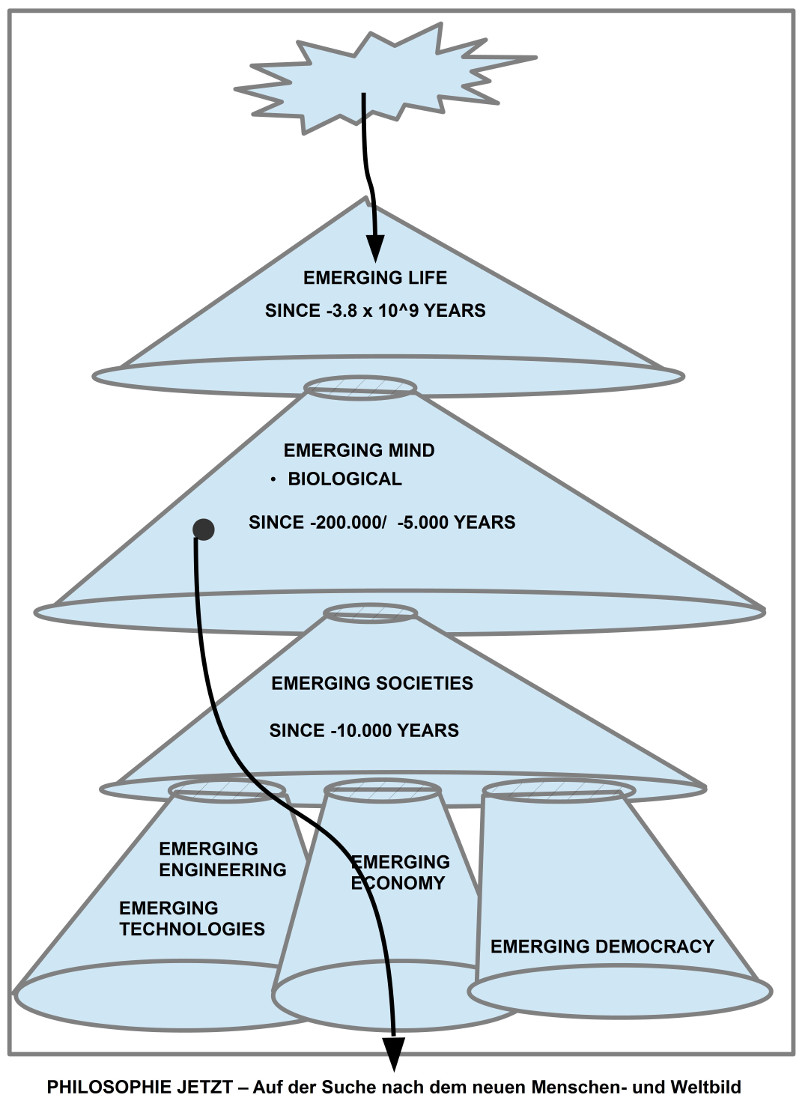

GEHIRN – BEWUSSTSEIN – GEIST

- Man kann beobachten, wie biologische Zellen sich in nahezu alle Lebensbereiche der Erde ausbreiten: im Meer, im Sediment, auf Land, in der Luft, in heißen und kalten Umgebungen, ohne und mit Sauerstoff, in immer komplexeren Verbänden von Zellen, mit immer komplexeren Strukturen innerhalb der Verbände, mit komplexer werdenden Kooperationen aufgrund von Kommunikation, als Pflanzen und Tiere, als Einzelgänger arbeitend, in Gruppen, Schwärmen, ganzen ‚Staaten‘, mit immer komplexeren Sprachen, mit Schriftsystemen, mit immer komplexeren Werkzeugen, …

- … die äußerlich beobachtbaren immer komplexer werdenden Verhaltensweisen korrelieren mit einer zunehmenden Verdichtung der internen Informationsverarbeitung mittels spezialisierter Zellverbände (Nervensystem, Gehirn). Die aktuelle Wahrnehmung der eigenen Körperzustände wie Eigenschaften der Umgebung wurde immer differenzierter. Die Informationsverarbeitung kann Wahrnehmungsereignisse abstrahieren, speichern und erinnern... Im Erinnerbaren lassen sich Unterschiede und Veränderungen erkennen, darin Beziehungen, zugleich kann Gegenwärtiges, Erinnertes neu kombiniert (Denken, Planen) werden. Dazu entwickelt sich die Fähigkeit, aktuell Wahrgenommenes symbolisch zu benennen, es mit anderen zu kommunizieren. Dies erschließt neue Dimensionen der Orientierung in der Gegenwart und über die Gegenwart hinaus.

- Wichtig ist, dass man diese neuen Fähigkeiten und Leistungen nicht direkt am Nervensystem ablesen kann (obgleich dies immer größer und dichter wird), sondern nur über das beobachtbare Verhalten, über die Wechselwirkungen mit anderen Systemen und der Umgebung. So ist das Gehirn von Säugetieren strukturell systemisch nicht wirklich verschieden, aber die Verhaltensweisen der jeweiligen Systeme im Verbund sind markant anders.

- Dies deutet auf eine neue Form von Dualität (oder wie andere vielleicht sagen würden), von Dialektik hin: die zunehmende Komplexität des Verhaltens korrespondiert mit einer entsprechend anwachsenden komplexen Umgebung, die ihre empirische Fundierung im Körper, im Gehirn zu haben scheint, aber andererseits kann sich diese Komplexität nur entfalten, nur zeigen, nur manifestieren, in dem Maße, wie diese äußere Komplexität empirisch verfügbar ist. Von daher ist es möglicherweise fruchtlos, zu fragen, was hier Ursache für was ist: das Gehirn für die Umgebung oder die Umgebung für das Gehirn. Manche sprechen hier ja auch von Ko-Evolution. Entscheidend ist offensichtlich der Prozess, durch den sich diese Wechselbeziehungen entfalten und wirken können. Dies impliziert, dass die beteiligten Strukturen plastisch, veränderlich sind.

- In der klassischen Philosophie nannte man ein komplexes Verhalten dieser Art ‚geistig‘, da man es im Organismus auf das Prinzip des Pneumas, der Psyche, des Geistes zurückführte (ohne letztlich zu wissen, was das jeweils ‚an sich‘ sein sollte). In diesem Verständnis könnte man formulieren, dass Lebensformen entstanden, deren Verhalten eine Komplexität zeigén, die man als geistig bezeichnen könnte.

- Dieses Aufkommen des Geistes (‚Emerging Mind‘) definiert sich damit nicht über die direkt messbaren Strukturen (Nervensystem, Struktur, Umfang,..), sondern über den Umfang der möglichen Zustände des Verhaltens, das direkt abhängig ist sowohl von den möglichen Zuständen des Gehirns, des zugehörigen Körpers, aber auch über die Gegebenheiten der Umwelt. Anders ausgedrückt, das neue Potential dieser Lebensform erkennt man nicht direkt und alleine an ihren materiellen Strukturen, sondern an der Dynamik ihrer potentiellen inneren Zustände in Wechselwirkung mit verfügbaren Umwelten. Es ist nicht nur entscheidend, dass diese Systeme symbolisch kommunizieren konnten, sondern auch WAS; nicht entscheidend alleine, dass sie Werkzeuge bilden konnten, sondern auch WIE und WOZU, usw.

- Es ist nicht einfach, dieses neue Potential angemessen theoretisch zu beschreiben, da eben die rein strukturellen Elemente nicht genügend aussagestark sind. Rein funktionelle Aspekte auch nicht. Es kommen hier völlig neue Aspekte ins Spiel.

- Für die Frage, wann ungefähr zeitlich solche Lebensformen auf der Erde auftreten, gibt es möglicherweise nicht den einen Zeitpunkt, sondern eher ein Zeitkorridor, innerhalb dessen sich unterschiedliche Phänomene angesammelt haben, die zusammen dann solch einen neuen Komplexitätshöhepunkt anzeigen. (Beginn Hominisation ca. -7 bis -5 Mio ; Migrationswellen ausgehend von Afrika (-130.000 bis -115.000 und -100.000 bis -50.000) ; Entstehung der Schrift ca. -4000 im Gebiet des fruchtbaren Halbmonds)

KOEXISTENZ VON GEIST UND GESELLSCHAFT

- Da alle Handlungen des Menschen, die über den Augenblick hinausgehen, an seine Erinnerungs- und Denkfähigkeit gebunden sind, durch die der Augenblick in real erfahrene oder virtuell vorstellbare Zusammenhänge nach hinten und vorne eingebettet werden kann, wird man die gesamte Entwicklung komplexer Gesellschaften immer nur unter Voraussetzung einer entsprechenden Kommunikation und entsprechender Wissensmodelle verstehen können. Das verfügbare Wissen kann stabilisieren, konservieren und – im negativen Fall – blockieren, und im positiven Fall Alternativen aufzeigen, neue Möglichkeiten, Ursache-Wirkung Zusammenhänge deutlich machen.

- Daraus legt sich nahe, dass eine Theorie der Gesellschaft die handelnden semiotischen Akteure als Grundelemente umfassen sollte.

- Während eine biologische Population von Systemen durch den gemeinsamen biologischen Bauplan (realisiert im DNA-Molekül samt zugehöriger Dekodierungsstruktur) charakterisiert ist, definiert sich eine Gesellschaft von Systemen über gemeinsamen Wissensmodelle mit den zugehörigen semiotischen Prozessen (die Redeweise von den Memen, die Dawkins 1976 eingeführt hat, ist hier möglicherweise zu schwach) sowie den zugehörigen empirischen Umweltkontexten. Zu sagen, dass es eine Ko-Evolution zwischen Umgebung und Gesellschaft gibt ist zu schwach: entscheidend ist die Mikrostruktur des Prozesses und der hier wirkenden Faktoren in einem Multi-Agenten-Prozess mit Wissensanteilen und Bedeutung.

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.