KONTEXT

- Im Rahmen der interdisziplinären Ringvorlesung Grenzen (Wintersemester 2015/16) an der Universität Passau (organisiert von der Deutsche Gesellschaft für Semiotik (DGS) e.V. in Kooperation mit der Professur für Neuere deutsche Literaturwissenschaft und Mediensemiotik (Prof. Dr. Jan-Oliver Decker und Dr. Stefan Halft) hatte ich einen Vortrag angenommen mit dem Titel Semiotik und künstliche Intelligenz. Ein vielversprechendes Team. Wie immer halte ich Vorträge immer zu Fragen, die ich bis dahin noch nicht ausgearbeitet hatte und nutze diese Herausforderung, es dann endlich mal zu tun.

- Die Atmosphäre beim Vortrag war sehr gut und die anschließenden Gespräche brachte viele interessanten Aspekte zutage, was wir im Rahmen der DGS noch tun sollten/ könnten, um das Thema weiter zu vertiefen.

MOTIV – WARUM DIESES THEMA

- Angesichts der vielfältigen Geschichte der Semiotik könnte man natürlich ganze Abende nur mit Geschichten über die Semiotik füllen. Desgleichen im Fall der künstlichen Intelligenz [KI]. Der Auslöser für das Thema war dann auch der spezielle Umstand, dass im Bereich der KI seit etwa den 80iger Jahren des 20.Jahrhunderts in einigen Forschungsprojekten das Thema Semiotik ganz neu auftaucht, und nicht als Randthema sondern verantwortlich für die zentralen Begriffe dieser Forschungen. Gemeint sind die berühmten Roboterexperimente von Luc Steels (ähnlich auch aufgegriffen von anderen, z.B. Paul Vogt) (siehe Quellen unten).

- Unter dem Eindruck großer Probleme in der klassischen KI, die aus einem mangelnden direkten Weltbezug resultierten (das sogenannte grounding Problem) versuchte Steels, Probleme des Zeichen- und Sprachlernens mit Hilfe von Robotern zu lösen, die mit ihren Sensoren direkten Kontakt zur empirischen Welt haben und die mit ihren Aktoren auch direkt auf die Welt zurück wirken können. Ihre internen Verarbeitungsprozesse können auf diese Weise abhängig gemacht werden (eine Form von grounding) von der realen Welt (man spricht hier auch von embodied intelligence).

- Obwohl Steels (wie auch Vogt) auf ungewöhnliche Weise grundlegende Begriffe der Semiotik einführen, wird dieser semiotische Ansatz aber nicht weiter reflektiert. Auch findet nicht wirklich eine Diskussion des Gesamtansatzes statt, der aus dieser Kombination von Semiotik und Robotik/ KI entsteht bzw. entstehen könnte. Dies ist schade. Der Vortrag Semiotik und künstliche Intelligenz. Ein vielversprechendes Team stellt einen Versuch dar, heraus zu arbeiten, warum die Kombination Semiotik und KI nicht nur Sinn macht, sondern eigentlich das Zeug hätte, zu einem zentralen Forschungsparadigma für die Zukunft zu werden. Tatsächlich liegt dem Emerging Mind Projekt, das hier im Blog schon öfters erwähnt wurde und am 10.November 2015 offiziell eröffnet werden wird, genau dieses Semiotik-KI-Paradigma zugrunde.

WELCHE SEMIOTIK?

- Wer Wörterbücher zur Semiotik aufschlägt (z.B. das von Noeth 2000), wird schnell bemerken, dass es eine große Vielfalt von Semiotikern, semiotischen Blickweisen, Methoden und Theorieansätze gibt, aber eben nicht die eine große Theorie. Dies muss nicht unbedingt negativ sein, zumal dann nicht, wenn wir ein reiches Phänomen vor uns haben, das sich eben einer einfachen Theoriebildung widersetzt. Für die Praxis allerdings, wenn man Semiotik in einer realen Theoriebildung einsetzen möchte, benötigt man verbindliche Anknüpfungspunkte, auf die man sich bezieht. Wie kann man solch eine Entscheidung motivieren?

- Aus der Sicht der Wissenschaftsphilosophie biete es sich an, die unterschiedlichen Zugangsweisen zur Erfahrung und und Beschreibung von Wirklichkeit als quasi Koordinatensystem zu wählen, diesem einige der bekanntesten semiotischen Ansätze zu zuordnen und dann zu schaue, welche dieser semiotischen Positionen der Aufgabenstellung am nächsten kommen. Von einer Gesamttheorie her betrachtet sind natürlich alle Ansätze wichtig. Eine Auswahl bzw. Gewichtung kann nur pragmatische Gründe haben.

ZUGÄNGE ZUR WIRKLICHKEIT

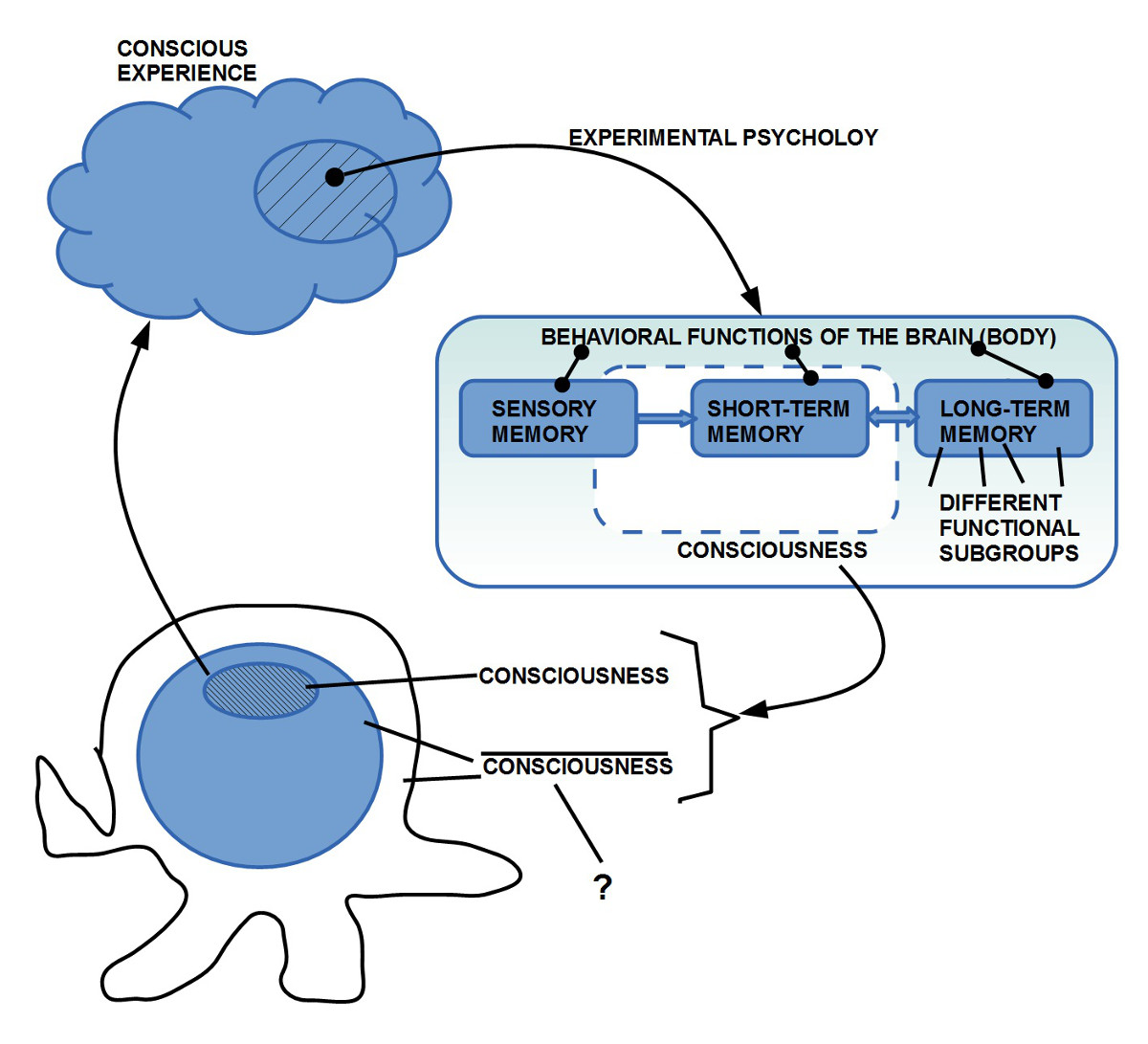

- Grundsätzlich gibt es aus heutiger Sicht zwei Zugangsweisen: über den intersubjektiven (empirischen) Bereich und über das subjektive Erleben.

- Innerhalb des empirischen Bereichs gab es lange Zeit nur den Bereich des beobachtbaren Verhaltens [SR] (in der Psychologie) ohne die inneren Zustände des Systems; seit ca. 50-60 Jahren eröffnen die Neurowissenschaften auch einen Zugriff auf die Vorgänge im Gehirn. Will man beide Datenbereiche korrelieren, dann gerät man in das Gebiet der Neuropsychologie [NNSR].

- Der Zugang zur Wirklichkeit über den subjektiven Bereich – innerhalb der Philosophie auch als phänomenologischer Zugang bekannt – hat den Vorteil einer Direktheit und Unmittelbarkeit und eines großen Reichtums an Phänomenen.

- Was den meisten Menschen nicht bewusst ist, ist die Tatsache, dass die empirischen Phänomene nicht wirklich außerhalb des Bewusstseins liegen. Die Gegenstände in der Zwischenkörperzone (der empirische Bereich) sind als Gegenstände zwar (was wir alle unterstellen) außerhalb des Bewusstseins, aber die Phänomene, die sie im Bewusstsein erzeugen, sind nicht außerhalb, sondern im Bewusstsein. Das, was die empirischen Phänomene [PH_em] von den Phänomenen, unterscheidet, die nicht empirisch [PH_nem] sind, ist die Eigenschaft, dass sie mit etwas in der Zwischenkörperwelt korrespondieren, was auch von anderen Menschen wahrgenommen werden kann. Dadurch lässt sich im Falle von empirischen Phänomenen relativ leicht Einigkeit zwischen verschiedenen Kommunikationsteilnehmern über die jeweils korrespondierenden Gegenstände/ Ereignisse erzielen.

- Bei nicht-empirischen Phänomenen ist unklar, ob und wie man eine Einigkeit erzielen kann, da man nicht in den Kopf der anderen Person hineinschauen kann und von daher nie genau weiß, was die andere Person meint, wenn sie etwas Bestimmtes sagt.

- Die Beziehung zwischen Phänomenen des Bewusstseins [PH] und Eigenschaften des Gehirns – hier global als NN abgekürzt – ist von anderer Art. Nach heutigem Wissensstand müssen wir davon ausgehen, dass alle Phänomene des Bewusstseins mit Eigenschaften des Gehirns korrelieren. Aus dieser Sicht wirkt das Bewusstsein wie eine Schnittstelle zum Gehirn. Eine Untersuchung der Beziehungen zwischen Tatsachen des Bewusstseins [PH] und Eigenschaften des Gehirns [NN] würde in eine Disziplin fallen, die es so noch nicht wirklich gibt, die Neurophänomenologie [NNPH] (analog zur Neuropsychologie).

- Der Stärke des Bewusstseins in Sachen Direktheit korrespondiert eine deutliche Schwäche: im Bewusstsein hat man zwar Phänomene, aber man hat keinen Zugang zu ihrer Entstehung! Wenn man ein Objekt sieht, das wie eine Flasche aussieht, und man die deutsche Sprache gelernt hat, dann wird man sich erinnern, dass es dafür das Wort Flasche gibt. Man konstatiert, dass man sich an dieses Wort in diesem Kontext erinnert, man kann aber in diesem Augenblick weder verstehen, wie es zu dieser Erinnerung kommt, noch weiß man vorher, ob man sich erinnern wird. Man könnte in einem Bild sagen: das Bewusstsein verhält sich hier wie eine Kinoleinwand, es konstatiert, wenn etwas auf der Leinwand ist, aber es weiß vorher nicht, ob etwas auf die Leinwand kommen wird, wie es kommt, und nicht was kommen wird. So gesehen umfasst das Bewusstsein nur einen verschwindend kleinen Teil dessen, was wir potentiell wissen (können).

AUSGEWÄHLTE SEMIOTIKER

- Nach diesem kurzen Ausflug in die Wissenschaftsphilosophie und bevor hier einzelne Semiotiker herausgegriffen werden, sei eine minimale Charakterisierung dessen gegeben, was ein Zeichen sein soll. Minimal deshalb, weil alle semiotischen Richtungen, diese minimalen Elemente, diese Grundstruktur eines Zeichens, gemeinsam haben.

- Diese Grundstruktur enthält drei Komponenten: (i) etwas, was als Zeichenmaterial [ZM] dienen kann, (ii) etwas, das als Nichtzeichenmaterial [NZM] fungieren kann, und (iii) etwas, das eine Beziehung/ Relation/ Abbildung Z zwischen Zeichen- und Nicht-Zeichen-Material in der Art repräsentiert, dass die Abbildung Z dem Zeichenmaterial ZM nicht-Zeichen-Material NZM zuordnet. Je nachdem, in welchen Kontext man diese Grundstruktur eines Zeichens einbettet, bekommen die einzelnen Elemente eine unterschiedliche Bedeutung.

- Dies soll am Beispiel von drei Semiotikern illustriert werden, die mit dem zuvor charakterisierten Zugängen zur Wirklichkeit korrespondieren: Charles William Morris (1901 – 1979), Ferdinand de Saussure (1857-1913) und Charles Santiago Sanders Peirce (1839 – 1914) .

- Morris, der jüngste von den Dreien, ist im Bereich eines empirischen Verhaltensansatzes zu positionieren, der dem verhaltensorientierten Ansatz der modernen empirischen Psychologie nahe kommt. In diesem verhaltensbasierten Ansatz kann man die Zeichengrundstruktur so interpretieren, dass dem Zeichenmaterial ZM etwas in der empirischen Zwischenwelt korrespondiert (z.B. ein Laut), dem Nicht-Zeichen-Material NZM etwas anderes in der empirischen Außenwelt (ein Objekt, ein Ereignis, …), und die Zeichenbeziehung Z kommt nicht in der empirischen Welt direkt vor, sondern ist im Zeichenbenutzer zu verorten. Wie diese Zeichenbeziehung Z im Benutzer tatsächlich realisiert ist, war zu seiner Zeit empirische noch nicht zugänglich und spielt für den Zeichenbegriff auch weiter keine Rolle. Auf der Basis von empirischen Verhaltensdaten kann die Psychologie beliebige Modellannahmen über die inneren Zustände des handelnden Systems machen. Sie müssen nur die Anforderung erfüllen, mit den empirischen Verhaltensdaten kompatibel zu sein. Ein halbes Jahrhundert nach Morris kann man anfangen, die psychologischen Modellannahmen über die Systemzustände mit neurowissenschaftlichen Daten abzugleichen, sozusagen in einem integrierten interdisziplinären neuropsychologischen Theorieansatz.

- Saussure, der zweit Jüngste von den Dreien hat als Sprachwissenschaftler mit den Sprachen primär ein empirisches Objekt, er spricht aber in seinen allgemeinen Überlegungen über das Zeichen in einer bewusstseinsorientierten Weise. Beim Zeichenmaterial ZM spricht er z.B. von einem Lautbild als einem Phänomen des Bewusstseins, entsprechend von dem Nicht-Zeichenmaterial auch von einer Vorstellung im Bewusstsein. Bezüglich der Zeichenbeziehung M stellt er fest, dass diese außerhalb des Bewusstseins liegt; sie wird vom Gehirn bereit gestellt. Aus Sicht des Bewusstseins tritt diese Beziehung nur indirekt in Erscheinung.

- Peirce, der älteste von den Dreien, ist noch ganz in der introspektiven, phänomenologischen Sicht verankert. Er verortet alle drei Komponenten der Zeichen-Grundstruktur im Bewusstsein. So genial und anregend seine Schriften im einzelnen sind, so führt diese Zugangsweise über das Bewusstsein zu großen Problemen in der Interpretation seiner Schriften (was sich in der großen Bandbreite der Interpretationen ausdrückt wie auch in den nicht selten geradezu widersprüchlichen Positionen).

- Für das weitere Vorgehen wird in diesem Vortrag der empirische Standpunkt (Verhalten + Gehirn) gewählt und dieser wird mit der Position der künstlichen Intelligenz ins Gespräch gebracht. Damit wird der direkte Zugang über das Bewusstsein nicht vollständig ausgeschlossen, sondern nur zurück gestellt. In einer vollständigen Theorie müsste man auch die nicht-empirischen Bewusstseinsdaten integrieren.

SPRACHSPIEL

- Ergänzend zu dem bisher Gesagten müssen jetzt noch drei weitere Begriffe eingeführt werden, um alle Zutaten für das neue Paradigma Semiotik & KI zur Verfügung zu haben. Dies sind die Begriffe Sprachspiel, Intelligenz sowie Lernen.

- Der Begriff Sprachspiel wird auch von Luc Steels bei seinen Roboterexperimenten benutzt. Über den Begriff des Zeichens hinaus erlaubt der Begriff des Sprachspiels den dynamischen Kontext des Zeichengebrauchs besser zu erfassen.

- Steels verweist als Quelle für den Begriff des Sprachspiels auf Ludwig Josef Johann Wittgenstein (1889-1951), der in seiner Frühphase zunächst die Ideen der modernen formalen Logik und Mathematik aufgriff und mit seinem tractatus logico philosophicus das Ideal einer am logischen Paradigma orientierten Sprache skizzierte. Viele Jahre später begann er neu über die normale Sprache nachzudenken und wurde sich selbst zum schärfsten Kritiker. In jahrelangen Analysen von alltäglichen Sprachsituationen entwickelte er ein facettenreiches Bild der Alltagssprache als ein Spiel, in dem Teilnehmer nach Regeln Zeichenmaterial ZM und Nicht-Zeichen-Material NZM miteinander verknüpfen. Dabei spielt die jeweilige Situation als Kontext eine Rolle. Dies bedeutet, das gleiche Zeichenmaterial kann je nach Kontext unterschiedlich wirken. Auf jeden Fall bietet das Konzept des Sprachspiels die Möglichkeit, den ansonsten statischen Zeichenbegriff in einen Prozess einzubetten.

- Aber auch im Fall des Sprachspielkonzepts benutzt Steels zwar den Begriff Sprachspiel, reflektiert ihn aber nicht soweit, dass daraus ein explizites übergreifendes theoretisches Paradigma sichtbar wird.

- Für die Vision eines neuen Forschungsparadigmas Semiotik & KI soll also in der ersten Phase die Grundstruktur des Zeichenbegriffs im Kontext der empirischen Wissenschaften mit dem Sprachspielkonzept von Wittgenstein (1953) verknüpft werden.

INTELLIGENZ

- Im Vorfeld eines Workshops der Intelligent Systems Division des NIST 2000 gab es eine lange Diskussion zwischen vielen Beteiligten, wie man denn die Intelligenz von Maschinen messen sollte. In meiner Wahrnehmung verhedderte sich die Diskussion darin, dass damals nach immer neuen Klassifikationen und Typologien für die Architektur der technischen Systeme gesucht wurde, anstatt das zu tun, was die Psychologie schon seit fast 100 Jahren getan hatte, nämlich auf das Verhalten und dessen Eigenschaften zu schauen. Ich habe mich in den folgenden Jahren immer wieder mit der Frage des geeigneten Standpunkts auseinandergesetzt. In einem Konferenzbeitrag von 2010 (zusammen mit anderen, insbesondere mit Louwrence Erasmus) habe ich dann dafür argumentiert, das Problem durch Übernahme des Ansatzes der Psychologie zu lösen.

- Die Psychologie hatte mit Binet (1905), Stern (1912 sowie Wechsler (1939) eine grundsätzliche Methode gefunden hatte, die Intelligenz, die man nicht sehen konnte, indirekt durch Rückgriff auf Eigenschaften des beobachtbaren Verhaltens zu messen (bekannt duch den Begriff des Intelligenz-Quotienten, IQ). Die Grundidee bestand darin, dass zu einer bestimmten Zeit in einer bestimmten Kultur bestimmte Eigenschaften als charakteristisch für ein Verhalten angesehen werden, das man allgemein als intelligent bezeichnen würde. Dies impliziert zwar grundsätzlich eine gewisse Relativierung des Begriffs Intelligenz (was eine Öffnung dahingehend impliziert, dass zu anderen Zeiten unter anderen Umständen noch ganz neue Eigenschaftskomplexe bedeutsam werden können!), aber macht Intelligenz grundsätzlich katalogisierbar und damit messbar.

- Ein Nebeneffekt der Bezugnahme auf Verhaltenseigenschaften findet sich in der damit möglichen Nivellierung der zu messenden potentiellen Strukturen in jenen Systemen, denen wir Intelligenz zusprechen wollen. D.h. aus Sicht der Intelligenzmessung ist es egal ob das zu messende System eine Pflanze, ein Tier, ein Mensch oder eine Maschine ist. Damit wird – zumindest im Rahmen des vorausgesetzten Intelligenzbegriffs – entscheidbar, ob und in welchem Ausmaß eine Maschine möglicherweise intelligent ist.

- Damit eignet sich dieses Vorgehen auch, um mögliche Vergleiche zwischen menschlichem und maschinellem Verhalten in diesem Bereich zu ermöglichen. Für das Projekt des Semiotk & KI-Paradigmas ist dies sehr hilfreich.

LERNEN

- An dieser Stelle ist es wichtig, deutlich zu machen, dass Intelligenz nicht notwendigerweise ein Lernen impliziert und Lernen nicht notwendigerweise eine Intelligenz! Eine Maschine (z.B. ein schachspielender Computer) kann sehr viele Eigenschaften eines intelligenten Schachspielers zeigen (bis dahin, dass der Computer Großmeister oder gar Weltmeister besiegen kann), aber sie muss deswegen nicht notwendigerweise auch lernfähig sein. Dies ist möglich, wenn erfahrene Experten hinreichend viel Wissen in Form eines geeigneten Programms in den Computer eingeschrieben haben, so dass die Maschine aufgrund dieses Programms auf alle Anforderungen sehr gut reagieren kann. Von sich aus könnte der Computer dann nicht dazu lernen.

- Bei Tieren und Menschen (und Pflanzen?) gehen wir von einer grundlegenden Lernfähigkeit aus. Bezogen auf das beobachtbare Verhalten können wir die Fähigkeit zu Lernen dadurch charakterisieren, dass ein System bis zu einem Zeitpunkt t bei einem bestimmten Reiz s nicht mit einem Verhalten r antwortet, nach dem Zeitpunkt t aber dann plötzlich doch, und dieses neue Verhalten über längere Zeit beibehält. Zeigt ein System eine solche Verhaltensdynamik, dann darf man unterstellen, dass das System in der Lage ist, seine inneren Zustände IS auf geeignete Weise zu verändern (geschrieben: phi: I x IS —> IS x O (mit der Bedeutung I := Input (Reize, Stimulus s), O := Output (Verhaltensantworten, Reaktion r), IS := interne Zustände, phi := Name für die beobachtbare Dynamik).

- Verfügt ein System über solch eine grundlegende Lernfähigkeit (die eine unterschiedlich reiche Ausprägung haben kann), dann kann es sich im Prinzip alle möglichen Verhaltenseigenschaften aneignen/ erwerben/ erlernen und damit im oben beschriebenen Sinne intelligent werden. Allerdings gibt es keine Garantie, dass eine Lernfähigkeit notwendigerweise zu einer bestimmten Intelligenz führen muss. Viele Menschen, die die grundsätzliche Fähigkeit besitzen, Schachspielen oder Musizieren oder Sprachen zu lernen, nutzen diese ihre Fähigkeiten niemals aus; sie verzichten damit auf Formen intelligenten Verhaltens, die ihnen aber grundsätzlich offen stehen.

- Wir fordern also, dass die Lernfähigkeit Teil des Semiotik & KI-Paradigmas sein soll.

LERNENDE MASCHINEN

- Während die meisten Menschen heute Computern ein gewisses intelligentes Verhalten nicht absprechen würden, sind sie sich mit der grundlegenden Lernfähigkeit unsicher. Sind Computer im echten Sinne (so wie junge Tiere oder menschliche Kinder) lernfähig?

- Um diese Frage grundsätzlich beantworten zu können, müsste man ein allgemeines Konzept von einem Computer haben, eines, das alle heute und in der Zukunft existierende und möglicherweise in Existenz kommende Computer in den charakteristischen Eigenschaften erschöpfend beschreibt. Dies führt zur Vor-Frage nach dem allgemeinsten Kriterium für Computer.

- Historisch führt die Frage eigentlich direkt zu einer Arbeit von Turing (1936/7), in der er den Unentscheidbarkeitsbeweis von Kurt Gödel (1931) mit anderen Mitteln nochmals nachvollzogen hatte. Dazu muss man wissen, dass es für einen formal-logischen Beweis wichtig ist, dass die beim Beweis zur Anwendung kommenden Mittel, vollständig transparent sein müssen, sie müssen konstruktiv sein, was bedeutet, sie müssen endlich sein oder effektiv berechenbar. Zum Ende des 19.Jh und am Anfang des 20.Jh gab es zu dieser Fragestellung eine intensive Diskussion.

- Turing wählte im Kontrast zu Gödel keine Elemente der Zahlentheorie für seinen Beweis, sondern nahm sich das Verhalten eines Büroangestellten zum Vorbild: jemand schreibt mit einem Stift einzelne Zeichen auf ein Blatt Papier. Diese kann man einzeln lesen oder überschreiben. Diese Vorgabe übersetze er in die Beschreibung einer möglichst einfachen Maschine, die ihm zu Ehren später Turingmaschine genannt wurde (für eine Beschreibung der Elemente einer Turingmaschine siehe HIER). Eine solche Turingmaschine lässt sich dann zu einer universellen Turingmaschine [UTM] erweitern, indem man das Programm einer anderen (sekundären) Turingmaschine auf das Band einer primären Turingmaschine schreibt. Die primäre Turingmaschine kann dann nicht nur das Programm der sekundären Maschine ausführen, sondern kann es auch beliebig abändern.

- In diesem Zusammenhang interessant ist, dass der intuitive Begriff der Berechenbarkeit Anfang der 30ige Jahre des 20.Jh gleich dreimal unabhängig voneinander formal präzisiert worden ist (1933 Gödel und Herbrand definierten die allgemein rekursiven Funktionen; 1936 Church den Lambda-Kalkül; 1936 Turing die a-Maschine für ‚automatische Maschine‘, später Turing-Maschine). Alle drei Formalisierungen konnten formal als äquivalent bewiesen werden. Dies führte zur sogenannten Church-Turing These, dass alles, was effektiv berechnet werden kann, mit einem dieser drei Formalismen (also auch mit der Turingmaschine) berechnet werden kann. Andererseits lässt sich diese Church-Turing These selbst nicht beweisen. Nach nunmehr fast 80 Jahren nimmt aber jeder Experte im Feld an, dass die Church-Turing These stimmt, da bis heute keine Gegenbeispiele gefunden werden konnten.

- Mit diesem Wissen um ein allgemeines formales Konzept von Computern kann man die Frage nach der generellen Lernfähigkeit von Computern dahingehend beantworten, dass Computer, die Turing-maschinen-kompatibel sind, ihre inneren Zustände (im Falle einer universellen Turingmaschine) beliebig abändern können und damit die Grundforderung nach Lernfähigkeit erfüllen.

LERNFÄHIGE UND INTELLIGENTE MASCHINEN?

- Die Preisfrage stellt sich, wie eine universelle Turingmaschine, die grundsätzlich lernfähig ist, herausfinden kann, welche der möglichen Zustände interessant genug sind, um damit zu einem intelligenten Verhalten zu kommen?

- Diese Frage nach der möglichen Intelligenz führt zur Frage der verfügbaren Kriterien für Intelligenz: woher soll eine lernfähige Maschine wissen, was sie lernen soll?

- Im Fall biologischer Systeme wissen wir mittlerweile, dass die lernfähigen Strukturen als solche dumm sind, dass aber durch die schiere Menge an Zufallsexperimenten ein Teil dieser Experimente zu Strukturen geführt hat, die bzgl. bestimmter Erfolgskriterien besser waren als andere. Durch die Fähigkeit, die jeweils erfolgreichen Strukturen in Form von Informationseinheiten zu speichern, die dann bei der nächsten Reproduktion erinnert werden konnten, konnten sich die relativen Erfolge behaupten.

- Turing-kompatible Computer können speichern und kodieren, sie brauchen allerdings noch Erfolgskriterien, um zu einem zielgerichtete Lernen zu kommen.

LERNENDE SEMIOTISCHE MASCHINEN

- Mit all diesen Zutaten kann man jetzt lernende semiotische Maschinen konstruieren, d.h. Maschinen, die in der Lage sind, den Gebrauch von Zeichen im Kontext eines Prozesses, zu erlernen. Das dazu notwendige Verhalten gilt als ein Beispiel für intelligentes Verhaltens.

- Es ist hier nicht der Ort, jetzt die Details solcher Sprach-Lern-Spiele auszubreiten. Es sei nur soviel gesagt, dass man – abschwächend zum Paradigma von Steels – hier voraussetzt, dass es schon mindestens eine Sprache L und einen kundigen Sprachteilnehmer gibt (der Lehrer), von dem andere Systeme (die Schüler), die diese Sprache L noch nicht kennen, die Sprache L lernen können. Diese Schüler können dann begrenzt neue Lehrer werden.

- Zum Erlernen (Training) einer Sprache L benötigt man einen definierten Kontext (eine Welt), in dem Lehrer und Schüler auftreten und durch Interaktionen ihr Wissen teilen.

- In einer Evaluationsphase (Testphase), kann dann jeweils überprüft werden, ob die Schüler etwas gelernt haben, und wieviel.

- Den Lernerfolge einer ganzen Serie von Lernexperimenten (ein Experiment besteht aus einem Training – Test Paar) kann man dann in Form einer Lernkurve darstellen. Diese zeigt entlang der Zeitachse, ob die Intelligenzleistung sich verändert hat, und wie.

- Gestaltet man die Lernwelt als eine interaktive Softwarewelt, bei der Computerprogramme genauso wie Roboter oder Menschen mitwirken können, dann kann man sowohl Menschen als Lehrer benutzen wie auch Menschen im Wettbewerb mit intelligenten Maschinen antreten lassen oder intelligente Maschinen als Lehrer oder man kann auch hybride Teams formen.

- Die Erfahrungen zeigen, dass die Konstruktion von intelligenten Maschinen, die menschenähnliche Verhaltensweisen lernen sollen, die konstruierenden Menschen dazu anregen, ihr eigenes Verhalten sehr gründlich zu reflektieren, nicht nur technisch, sondern sogar philosophisch.

EMERGING MIND PROJEKT

- Die zuvor geschilderten Überlegungen haben dazu geführt, dass ab 10.November 2015 im INM Frankfurt ein öffentliches Forschungsprojekt gestartet werden soll, das Emerging Mind Projekt heißt, und das zum Ziel hat, eine solche Umgebung für lernende semiotische Maschinen bereit zu stellen, mit der man solche semiotischen Prozesse zwischen Menschen und lernfähigen intelligenten Maschinen erforschen kann.

QUELLEN

- Binet, A., Les idees modernes sur les enfants, 1909

- Doeben-Henisch, G.; Bauer-Wersing, U.; Erasmus, L.; Schrader,U.; Wagner, W. [2008] Interdisciplinary Engineering of Intelligent Systems. Some Methodological Issues. Conference Proceedings of the workshop Modelling Adaptive And Cognitive Systems (ADAPCOG 2008) as part of the Joint Conferences of SBIA’2008 (the 19th Brazilian Symposium on Articial Intelligence); SBRN’2008 (the 10th Brazilian Symposium on Neural Networks); and JRI’2008 (the Intelligent Robotic Journey) at Salvador (Brazil) Oct-26 – Oct-30(PDF HIER)

- Gödel, K. Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme I, In: Monatshefte Math.Phys., vol.38(1931),pp:175-198

- Charles W. Morris, Foundations of the Theory of Signs (1938)

- Charles W. Morris (1946). Signs, Language and Behavior. New York: Prentice-Hall, 1946. Reprinted, New York: George Braziller, 1955. Reprinted in Charles Morris, Writings on the General Theory of Signs (The Hague: Mouton, 1971), pp. 73-397. /* Charles William Morris (1901-1979) */

- Charles W. Morris, Signication and Signicance (1964)

- NIST: Intelligent Systems Division: http://www.nist.gov/el/isd/

- Winfried Noth: Handbuch der Semiotik. 2., vollständig neu bearbeitete Auflage. Metzler, Stuttgart/Weimar 2000

- Charles Santiago Sanders Peirce (1839-1914) war ein US-amerikanischer Mathematiker, Philosoph und Logiker. Peirce gehort neben William James und John Dewey zu den maßgeblichen Denkern des Pragmatismus; außerdem gilt er als Begründer der modernen Semiotik. Zur ersten Einführung siehe: https://de.wikipedia.org/wiki/Charles Sanders Peirce Collected Papers of Charles Sanders Peirce. Bände I-VI hrsg. von Charles Hartshorne und Paul Weiss, 1931{1935; Bände VII-VIII hrsg. von Arthur W. Burks 1958. University Press, Harvard, Cambridge/Mass. 1931{1958

- Writings of Charles S. Peirce. A Chronological Edition. Hrsg. vom Peirce Edition Project. Indiana University Press,Indianapolis, Bloomington 1982. (Bisher Bände 1{6 und 8, geplant 30 Bände)

- Saussure, F. de. Grundfragen der Allgemeinen Sprachwissenschaft, 2nd ed., German translation of the original posthumously publication of the Cours de linguistic general from 1916 by H.Lommel, Berlin: Walter de Gruyter & Co., 1967

- Saussure, F. de. Course in General Linguistics, English translation of the original posthumously publication of the Cours de linguistic general from 1916, London: Fontana, 1974

- Saussure, F. de. Cours de linguistique general, Edition Critique Par Rudolf Engler, Tome 1,Wiesbaden: Otto Harrassowitz, 1989 /*This is the critical edition of the dierent sources around the original posthumously publication of the Cours de linguistic general from 1916. */

- Steels, Luc (1995): A Self-Organizing Spatial Vocabulary. Articial Life, 2(3), S. 319-332

-

Steels, Luc (1997): Synthesising the origins of language and meaning using co-evolution, self-organisation and level formation. In: Hurford, J., C.Knight und M.Studdert-Kennedy (Hrsg.). Edinburgh: Edinburgh Univ. Press.

-

Steels, Luc (2001): Language Games for Autonomous Robots. IEEE Intelligent Systems, 16(5), S. 16-22. Steels, Luc (2003):

-

Evolving grounded Communication for Robots. Trends in Cognitive Science, 7(7), S. 308-312.

-

Steels, Luc (2003): Intelligence with Representation. Philosophical Transactions of the Royal Society A, 1811(361), S. 2381-2395.

- Steels, Luc (2008): The symbol grounding problem has been solved, so what’s next?. In M. de Vega, Symbols and Embodiment: Debates on Meaning and Cognition. Oxford: Oxford University Press, S. 223-244.

-

Steels, Luc (2012): Grounding Language through Evolutionary Language Games. In: Language Grounding in Robots. Springer US, S. 1-22.

- Steels, Luc (2015), The Talking Heads experiment: Origins of words and meanings, Series: Computational Models of Language Evolution 1. Berlin: Language Science Press.

-

Stern, W., Die psychologischen Methoden der Intelligenzprüfung und deren Anwendung an Schulkindern, Leipzig: Barth, 1912

-

Turing, A. M. On Computable Numbers with an Application to the Entscheidungsproblem. In: Proc. London Math. Soc., Ser.2, vol.42(1936), pp.230-265; received May 25, 1936; Appendix added August 28; read November 12, 1936; corr. Ibid. vol.43(1937), pp.544-546. Turing’s paper appeared in Part 2 of vol.42 which was issued in December 1936 (Reprint in M.DAVIS 1965, pp.116-151; corr. ibid. pp.151-154).(an online version at: http://www.comlab.ox.ac.uk/activities/ieg/elibrary/sources/tp2-ie.pdf, last accesss Sept-30, 2012)

-

Turing, A.M. Computing machinery and intelligence. Mind, 59, 433-460. 1950

-

Turing, A.M.; Intelligence Service. Schriften, ed. by Dotzler, B.; Kittler, F.; Berlin: Brinkmann & Bose, 1987, ISBN 3-922660-2-3

- Vogt, P. The physical symbol grounding problem, in: Cognitive Systems Research, 3(2002)429-457, Elsevier Science B.V.

-

Vogt, P.; Coumans, H. Investigating social interaction strategies for bootstrapping lexicon development, Journal of Articial Societies and Social Simulation 6(1), 2003

-

Wechsler, D., The Measurement of Adult Intelligence, Baltimore, 1939, (3. Auage 1944)

-

Wittgenstein, L.; Tractatus Logico-Philosophicus, 1921/1922 /* Während des Ersten Weltkriegs geschrieben, wurde das Werk 1918 vollendet. Es erschien mit Unterstützung von Bertrand Russell zunächst 1921 in Wilhelm Ostwalds Annalen der Naturphilosophie. Diese von Wittgenstein nicht gegengelesene Fassung enthielt grobe Fehler. Eine korrigierte, zweisprachige Ausgabe (deutsch/englisch) erschien 1922 bei Kegan Paul, Trench, Trubner und Co. in London und gilt als die offizielle Fassung. Die englische Übersetzung stammte von C. K. Ogden und Frank Ramsey. Siehe einführend Wikipedia-DE: https://de.wikipedia.org/wiki/Tractatus logicophilosophicus*/

-

Wittgenstein, L.; Philosophische Untersuchungen,1936-1946, publiziert 1953 /* Die Philosophischen Untersuchungen sind Ludwig Wittgensteins spätes, zweites Hauptwerk. Es übten einen außerordentlichen Einfluss auf die Philosophie der 2. Hälfte des 20. Jahrhunderts aus; zu erwähnen ist die Sprechakttheorie von Austin und Searle sowie der Erlanger Konstruktivismus (Paul Lorenzen, Kuno Lorenz). Das Buch richtet sich gegen das Ideal einer logik-orientierten Sprache, die neben Russell und Carnap Wittgenstein selbst in seinem ersten Hauptwerk vertreten hatte. Das Buch ist in den Jahren 1936-1946 entstanden, wurde aber erst 1953, nach dem Tod des Autors, veröffentlicht. Siehe einführend Wikipedia-DE: https://de.wikipedia.org/wiki/Philosophische Untersuchungen*/

Eine Übersicht über alle Blogeinträge des Autors cagent nach Titeln findet sich HIER

Bild 1

Bild 1 Bild 2

Bild 2