Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062

URL: cognitiveagent.org

Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch

Email: gerd@doeben-henisch.de

So 16.Februar 2020

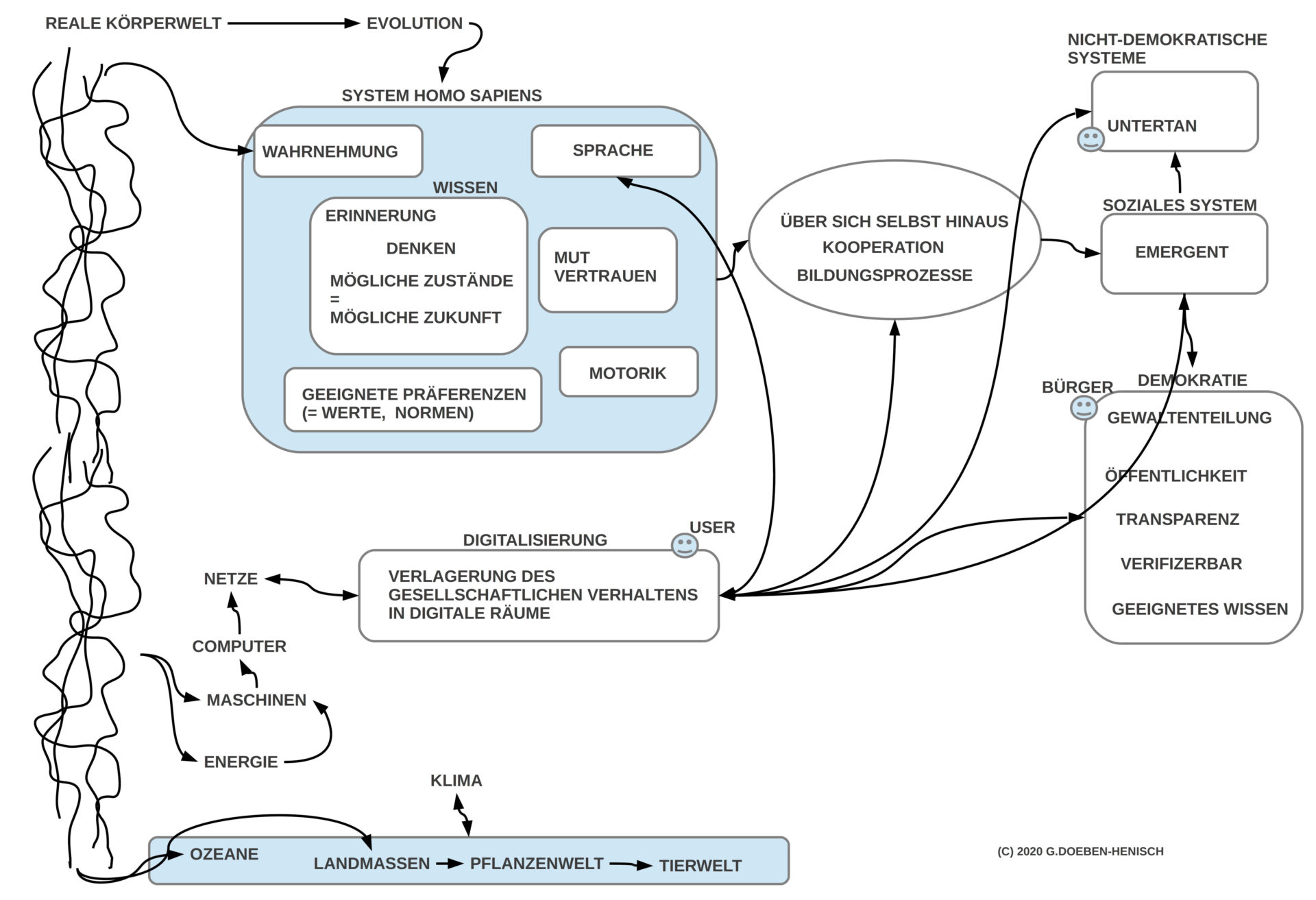

KONTEXT DEMOKRATIE

In einem vorausgehenden Beitrag hatte ich am Beispiel der Demokratie aufgezeigt, welche zentrale Rolle eine gemeinsame funktionierende Öffentlichkeit spielt. Ohne eine solche ist Demokratie nicht möglich. Entspechend der Komplexität einer Gesellschaft muss die große Mehrheit der Bürger daher über ein hinreichendes Wissen verfügen, um sich qualifiziert am Diskurs beteiligen und auf dieser Basis am Geschehen verantwortungsvoll partizipieren zu können. Eine solche Öffentlichkeit samt notwendigem Bildungsstand scheint in den noch existierenden Demokratien stark gefährdet zu sein. Nicht ausdrücklich erwähnt wurde in diesem Beitrag die Notwendigkeit von solchen Emotionen und Motivationen, die für das Erkennen, Kommunizieren und Handeln gebraucht werden; ohne diese nützt das beste Wissen nichts.

KONTEXT DIGITALISIERUNG

In einem Folgebeitrag hatte ich das Phänomen der Digitalisierung aus der Sicht des Benutzers skizziert, wie eine neue Technologie immer mehr eine Symbiose mit dem Leben der Gesellschaft eingeht, einer Symbiose, der man sich kaum oder gar nicht mehr entziehen kann. Wo wird dies hinführen? Löst sich unsere demokratische Gesellschaft als Demokratie schleichend auf? Haben wir überhaupt noch eine funktionierende Demokratie?

PARTIZIPATION OHNE DEMOKRATIE?

Mitten in den Diskussionen zu diesen Fragen erreichte mich das neue Buch von Manfred Faßler Partizipation ohne Demokratie (2020), Fink Verlag, Paderborn (DE). Bislang konnte ich Kap.1 lesen. In großer Intensität, mit einem in Jahrzehnten erarbeiteten Verständnis des Phänomens Digitalisierung und Demokratie, entwirft Manfred Faßler in diesem Kapitel eine packende Analyse der Auswirkungen des Phänomens Digitalisierung auf die Gesellschaft, speziell auch auf eine demokratische Gesellschaft. Als Grundidee entnehme ich diesem Kapitel, dass der Benutzer (User) in Interaktion mit den neuen digitalen Räumen subjektiv zwar viele Aspekte seiner realweltlichen sozialen Interaktionen wiederfindet, aber tatsächlich ist dies eine gefährliche Illusion: während jeder User im realweltlichen Leben als Bürger in einer realen demokratischen Gesellschaft lebt, wo es der Intention der Verfassung nach klare Rechte gibt, Verantwortlichkeiten, Transparenz, Kontrolle von Macht, ist der Bürger in den aktuellen digitalen Räumen kein Bürger, sondern ein User, der nahezu keine Rechte hat. Als User glaubt man zwar, dass man weiter ein Bürger ist, aber die individuellen Interaktionen mit dem digitalen Raum bewegen sich in einem weitgehend rechtlosen und demokratiefreiem Raum. Die allgemeinen Geschäftsbedingungen kaschieren diesen Zustand durch unendliche lange Texte, die kaum einer versteht; sprechen dem User nahezu alle Rechte ab, und lassen sich kaum bis gar nicht einklagen, jedenfalls nicht in einem Format, das der User praktisch einlösen könnte. Dazu kommt, dass der digitale Raum des Users ein geliehener Raum ist; die realen Maschinen und Verfügungsgewalten liegen bei Eignern, die jenseits der gewohnten politischen Strukturen angesiedelt sind, die sich eher keiner demokratischen Ordnung verpflichtet fühlen, und die diese Verfügungsgewalt — so zeigt es die jüngste Geschichte — skrupellos an jeden verkaufen, der dafür Geld bezahlt, egal, was er damit macht.

Das bisherige politische System scheint die Urgewalt dieser Prozesse noch kaum realisiert zu haben. Es denkt noch immer in den klassischen Kategorien von Gesellschaft und Demokratie und merkt nicht, wie Grundpfeiler der Demokratie täglich immer mehr erodieren. Kapitel 1 von Faßlers Buch ist hier schonungslos konkret und klar.

LAGEPLAN DEMOKRATISCHE DIGITALISIERUNG

Erschreckend ist, wie einfach die Strategie funktioniert, den einzelnen bei seinen individuellen privaten Bedürfnissen abzuholen, ihm vorzugaukeln, er lebe in den aktuellen digitalen Räumen so wie er auch sonst als Bürger lebe, nur schneller, leichter, sogar freier von üblichen analogen Zwängen, obwohl er im Netz vieler wichtiger realer Recht beraubt wird, bis hin zu Sachverhalten und Aktionen, die nicht nur nicht demokratisch sind, sondern sogar in ihrer Wirkung eine reale Demokratie auflösen können; alles ohne Kanonendonner.

Es mag daher hilfreich sein, sich mindestens die folgenden Sachverhalte zu vergegenwärtigen:

- Verankerung in der realen Welt

- Zukunft gibt es nicht einfach so

- Gesellschaft als emergentes Phänomen

- Freie Kommunikation als Lebensader

REALE KÖRPERWELT

Fasziniert von den neuen digitalen Räumen kann man schnell vergessen, dass diese digitalen Räume als physikalische Zustände von realen Maschinen existieren, die reale Energie verbrauchen, reale Ressourcen, und die darin nicht nur unseren realen Lebensraum beschneiden, sondern auch verändern.

Diese physikalische Dimension interagiert nicht nur mit der übrigen Natur sehr real, sie unterliegt auch den bisherigen alten politischen Strukturen mit den jeweiligen nationalen und internationalen Gesetzen. Wenn die physikalischen Eigentümer nach alter Gesetzgebung in realen Ländern lokalisiert sind, die sich von den Nutzern in demokratischen Gesellschaften unterscheiden, und diese Eigentümer nicht-demokratische Ziele verfolgen, dann sind die neuen digitalen Räume nicht einfach nur neutral, nein sie sind hochpolitisch. Diese Sachverhalte scheinen in der europäischen Politik bislang kaum ernsthaft beachtet zu werden; eher erwecken viele Indizien den Eindruck, dass viele politische Akteure so handeln, als ob sie Angestellte jener Eigner sind, die sich keiner Demokratie verpflichtet fühlen (Ein Beispiel von vielen: die neue Datenschutz-Verordnung DSGVO versucht erste zaghafte Schritte zu unternehmen, um der Rechtlosigkeit der Bürger als User entgegen zu wirken, gleichzeitig wird diese DSGVO von einem Bundesministerium beständig schlecht geredet …).

ZUKUNFT IST KEIN GEGENSTAND

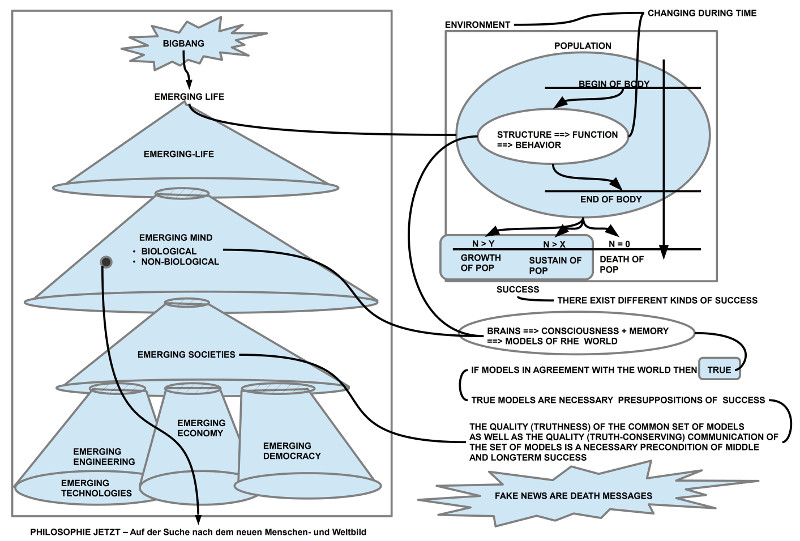

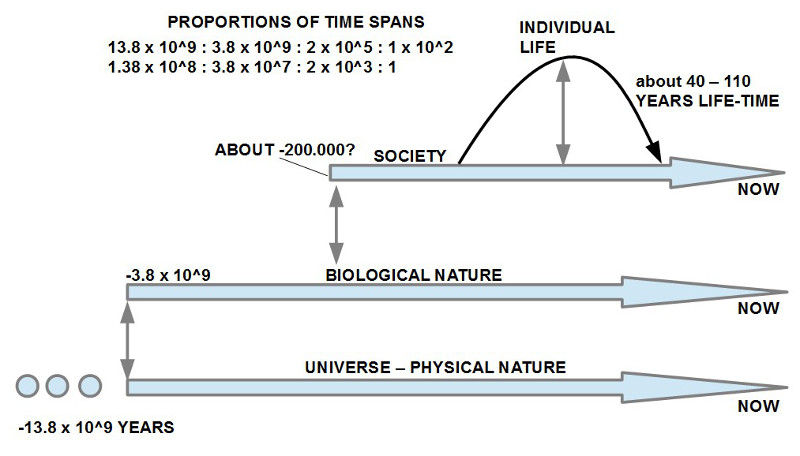

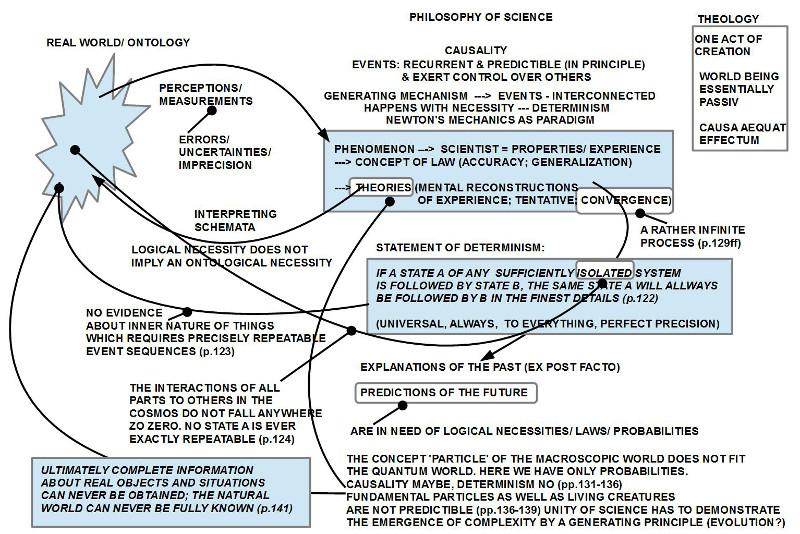

Wie ich in diesem Blog schon mehrfach diskutiert habe, ist Zukunft kein übliches Objekt. Weil wir über ein Gedächtnis verfügen, können wir Aspekte der jeweiligen Gegenwart speichern, wieder erinnern, unsere Wahrnehmung interpretieren, und durch unsere Denkfähigkeit Muster, Regelhaftigkeiten identifizieren, denken, und neue mögliche Kombinationen ausmalen. Diese neuen Möglichkeiten sind aber nicht die Zukunft, sondern Zustände unseres Gehirns, die auf der Basis der Vergangenheit Spekulationen über eine mögliche Zukunft bilden. Die Physik und die Biologie samt den vielen Begleitdisziplinen haben eindrucksvoll gezeigt, was ein systematischer Blick zurück zu den Anfängen des Universums (BigBang) und den Anfängen des Lebens (Entstehung von Zellen aus Molekülen) an Erkenntnissen hervor bringen kann. Sie zeigen aber auch, dass die Erde selbst wie das gesamt biologische Leben ein hochkomplexes System ist, das sich nur sehr begrenzt voraus sagen lässt. Spekulationen über mögliche zukünftige Zustände sind daher nur sehr begrenzt möglich.

Ferner ist zu berücksichtigen, dass das Denken selbst kein Automatismus ist. Neben den vielen gesellschaftlichen Faktoren und Umweltfaktoren, die auf unser Denken einwirken, hängt unser Denken in seiner Ausrichtung entscheidend auch von unseren Bedürfnissen, Emotionen, Motiven und Zielvorstellungen ab. Wirkliche Innovationen, wirkliche Durchbrüche sind keine Automatismen. Sie brauchen Menschen, die resistent sind gegen jeweilige ‚Mainstreams‘, die mutig sind, sich mit Unbekanntem und Riskantem auseinander zu setzen, und vieles mehr. Solche Menschen sind keine ‚Massenware’…

GESELLSCHAFT ALS EMERGENTES PHÄNOMEN

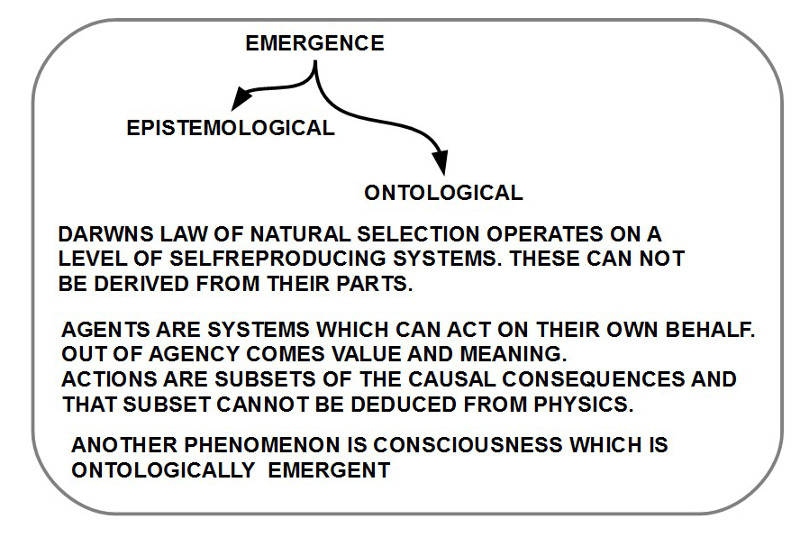

Das Wort ‚Emergenz‘ hat vielfach eine unscharfe Bedeutung. In einer Diskussion des Buches von Miller und Page (2007) Complex Adaptive Systems. An Introduction to Computational Models of Social Life habe ich für meinen Theoriezusammenhang eine Definition vorgeschlagen, die die Position von Miller und Page berücksichtigt, aber auch die Position von Warren Weaver (1958), A quarter century in then natural sciences. Rockefeller Foundation. Annual Report,1958, pages 7–15, der von Miller und Page zitiert wird.

Die Grundidee ist die, dass ein System, das wiederum aus vielen einzelnen Systemen besteht, dann als ein organisiertes System verstanden wird, wenn das Wegnehmen eines einzelnen Systems das Gesamtverhalten des Systems verändert. Andererseits soll man aber durch die Analyse eines einzelnen Mitgliedssystems auch nicht in der Lage sein, auf das Gesamtverhalten schließen zu können. Unter diesen Voraussetzungen soll das Gesamtverhalten als emergent bezeichnet werden: es existiert nur, wenn alle einzelnen Mitgliedssysteme zusammenwirken und es ist nicht aus dem Verhalten einzelner Systeme alleine ableitbar. Wenn einige der Mitgliedssysteme zudem zufällige oder lernfähige Systeme sind, dann ist das Gesamtverhalten zusätzlich begründbar nicht voraussagbar.

Das Verhalten sozialer Systeme ist nach dieser Definition grundsätzlich emergent und wird noch dadurch verschärft, dass seine Mitgliedssysteme — individuelle Personen wie alle möglichen Arten von Vereinigungen von Personen — grundsätzlich lernende Systeme sind (was nicht impliziert, dass sie ihre Lernfähigkeit ’sinnvoll‘ nutzen). Jeder Versuch, die Zukunft sozialer Systeme voraus zu sagen, ist von daher grundsätzlich unmöglich (auch wenn wir uns alle gerne der Illusion hingeben, wir könnten es). Die einzige Möglichkeit, in einer freien Gesellschaft, Zukunft ansatzweise zu erarbeiten, wären Systeme einer umfassenden Partizipation und Rückkopplung aller Akteure. Diese Systeme gibt es bislang nicht, wären aber mit den neuen digitalen Technologien eher möglich.

FREIE KOMMUNIKATION UND BILDUNG

Die kulturellen Errungenschaften der Menschheit — ich zähle Technologie, Bildungssysteme, Wirtschaft usw. dazu — waren in der Vergangenheit möglich, weil die Menschen gelernt hatten, ihre kognitiven Fähigkeiten zusammen mit ihrer Sprache immer mehr so zu nutzen, dass sie zu Kooperationen zusammen gefunden haben: Die Verbindung von vielen Fähigkeiten und Ressourcen, auch über längere Zeiträume. Alle diese Kooperationen waren entweder möglich durch schiere Gewalt (autoritäre Gesellschaften) oder durch Einsicht in die Sachverhalte, durch Vertrauen, dass man das Ziel zusammen schon irgendwie erreichen würde, und durch konkrete Vorteile für das eigene Leben oder für das Leben der anderen, in der Gegenwart oder in der möglichen Zukunft.

Bei aller Dringlichkeit dieser Prozesse hingen sie zentral von der möglichen Kommunikation ab, vom Austausch von Gedanken und Zielen. Ohne diesen Austausch würde nichts passieren, wäre nichts möglich. Nicht umsonst diagnostizieren viele Historiker und Sozialwissenschaftler den Übergang von der alten zur neuen empirischen Wissenschaft in der Veränderung der Kommunikation, erst Recht im Übergang von vor-demokratischen Gesellschaften zu demokratischen Gesellschaften.

Was aber oft zu kurz kommt, das ist die mangelnde Einsicht in den engen Zusammenhang zwischen einer verantwortlichen Kommunikation in einer funktionierenden Demokratie und dem dazu notwendigen Wissen! Wenn ich eine freie Kommunikation in einer noch funktionierenden Demokratie haben würde, und innerhalb dieser Diskussion würden nur schwachsinnige Inhalte transportiert, dann nützt solch eine Kommunikation natürlich nichts. Eine funktionierende freie Kommunikation ist eine notwendige Voraussetzung für eine funktionierende Demokratie, aber die Verfügbarkeit von angemessenen Weltbildern, qualitativ hochwertigem Wissen bei der Mehrheit der Bürger (nicht nur bei gesellschaftlichen Teilgruppen, die sich selbst als ‚Eliten‘ verstehen) ist genauso wichtig. Beides gehört zusammen. Bei der aktuellen Zersplitterung aller Wissenschaften, der ungeheuren Menge an neuem Wissen, bei den immer schneller werdenden Innovationszyklen und bei der zunehmenden ‚Fragmementierung der Öffentlichkeit‘ verbunden mit einem wachsenden Misstrauen untereinander, ist das bisherige Wissenssystem mehr und mehr nicht nur im Stress, sondern möglicherweise kurz vor einem Kollaps. Ob es mit den neuen digitalen Technologien hierfür eine spürbare Unterstützung geben könnte, ist aktuell völlig unklar, da das Problem als solches — so scheint mir — noch nicht genügend gesellschaftlich erkannt ist und diskutiert wird. Außerdem, ein Problem erkennen ist eines, eine brauchbare Lösung zu finden etwas anderes. In der Regel sind die eingefahrenen Institutionen wenig geeignet, radikal neue Ansätzen zu denken und umzusetzen. Alte Denkgewohnheiten und das berühmte ‚Besitzstanddenken‘ sind wirkungsvolle Faktoren der Verhinderung.

AUSBLICK

Die vorangehenden Gedanken mögen auf manche Leser vielleicht negativ wirken, beunruhigend, oder gar deprimierend. Bis zum gewissen Grad wäre dies eine natürliche Reaktion und vielleicht ist dies auch notwendig, damit wir alle zusammen uns wechselseitig mehr helfen, diese Herausforderungen in den Blick zu nehmen. Der Verfasser dieses Textes ist trotz all dieser Schwierigkeiten, die sich andeuten, grundlegend optimistisch, dass es Lösungen geben kann, und dass es auch — wie immer in der bisherigen Geschichte des Lebens auf der Erde — genügend Menschen geben wird, die die richtigen Ideen haben werden, und es Menschen gibt, die sie umsetzen. Diese Fähigkeit zum Finden von neuen Lösungen ist eine grundlegende Eigenschaft des biologischen Lebens. Dennoch haben Kulturen immer die starke Tendenzen, Ängste und Kontrollen auszubilden statt Vertrauen und Experimentierfreude zu kultivieren.

Wer sich das Geschehen nüchtern betrachtet, der kann auf Anhieb eine Vielzahl von interessanten Optionen erkennen, sich eine Vielzahl von möglichen Prozessen vorstellen, die uns weiter führen könnten. Vielleicht kann dies Gegenstand von weiteren Beiträgen sein.

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.