TREND ZU INSTITUTIONALISIEREN

- Es scheint eine allgemeine Tendenz menschlichen Handelns zu sein, aufregende Ideen und erfolgreiche Konzepte – allerdings nicht immer – zu institutionalisieren: aus einzelnen Menschen die überzeugen, aus einzelnen kleinen Unternehmungen, die Erfolg haben, werden Institutionen, große Firmen, Staatsgebilde.

- Wenn sie denn da sind, die Institutionen (Kirchen, Parteien, Gewerkschaften, Universitäten, politische Formen, Rechtssysteme, …), dann verselbständigen sich viele Mechanismen. Die treibende Idee kann verblassen, die Selbsterhaltungskräfte einer Institution gewinnen die Oberhand (im Falle von Geheimdiensten wenig Demokratie förderlich …).

WAS BEWEGT?

- Bei der Frage, was das Handeln von Menschen leitet, kann man angesichts der Realität von Institutionen verleitet sein, auf die soziale Realität dieser Institutionen zu starren und zu glauben, gegen diese sei nicht anzukommen, als einzelner.

- Die Geschichte – und die unruhige Gegenwart – kann uns aber darüber belehren, dass alle Institutionen nur so lange funktionieren, als die sie tragenden Menschen mit ihren subjektiven-inneren Leitbildern diese Institutionen stützen. Wenn sich die subjektiven-inneren Anschauungen ändern, zerfallen Institutionen.

- Dafür gibt es zahllose Beispiele. Der immer stärker werdende Lobbyismus unter Politikern, die fast schon dreiste Voranstellung persönlicher kurzfristiger Erfolgskriterien vor jeder gesellschaftlich tragenden Perspektive, die zunehmende Propaganda und Zensur in vielen Ländern dieser Erde, vereinfachende schwarz-weiß Modelle von Gesellschaft und Zukunft, sind einige der wirksamen Mittel, eine friedliche, kooperierende, zukunftsfähige Gesellschaft zu zerstören.

GEMEINSAMES WISSEN

- In solch einer Situation – die es in den letzten Jahrtausenden immer gab, immer wieder – stellt sich die Frage, wie kann das Wissen eines Menschen so mit anderen geteilt werden, dass aus diesem gemeinsamen Wissen auch ein gemeinsames Handeln erwachsen kann?

GRÜNDUNGSIDEEN

- Demokratische Parteien, die noch jung sind, die noch ein wenig das Gründungsfieber, die neue Vision in sich tragen, sind gute Lehrbeispiele dafür, wie Ideen sich im Alltag mühsam ihren Weg in die Köpfe möglicher Anhänger suchen müssen und dann, im Laufe der Jahre, sich behaupten müssen. Am Gründungstag weiß niemand, wer in der Zukunft dazukommen wird und was die nachfolgenden Generationen daraus machen werden.

- Ähnliches kann man bei Religionsgründern und bei Ordensgründungen beobachten: eine elektrisierende Anfangsidee bringt Menschen dazu, ihr Leben nachhaltig zu ändern und damit jeweils auch ein Stück Welt.

- Auch Firmengründungen laufen ähnlich ab: zu einem bestimmten Zeitpunkt hatte eine Idee einen wirtschaftliche Erfolg, und dieser führt zu einem Wachstum, der vorher nicht absehbar und nicht planbar war. Irgendwann gibt es ein Konglomerat aus Kapital und Macht, wo die Gründungsidee sich verdunstet hat, wo die Firma sich selbst fremd geworden ist. Manager sind angeheuerte Mietkräfte, die im System ihren persönlichen Vorteil suchen oder es gibt Anteilseigner, die wie kleine Monarchen ihrem Absolutismus zu frönen scheinen.

- Und so weiter, und so weiter…

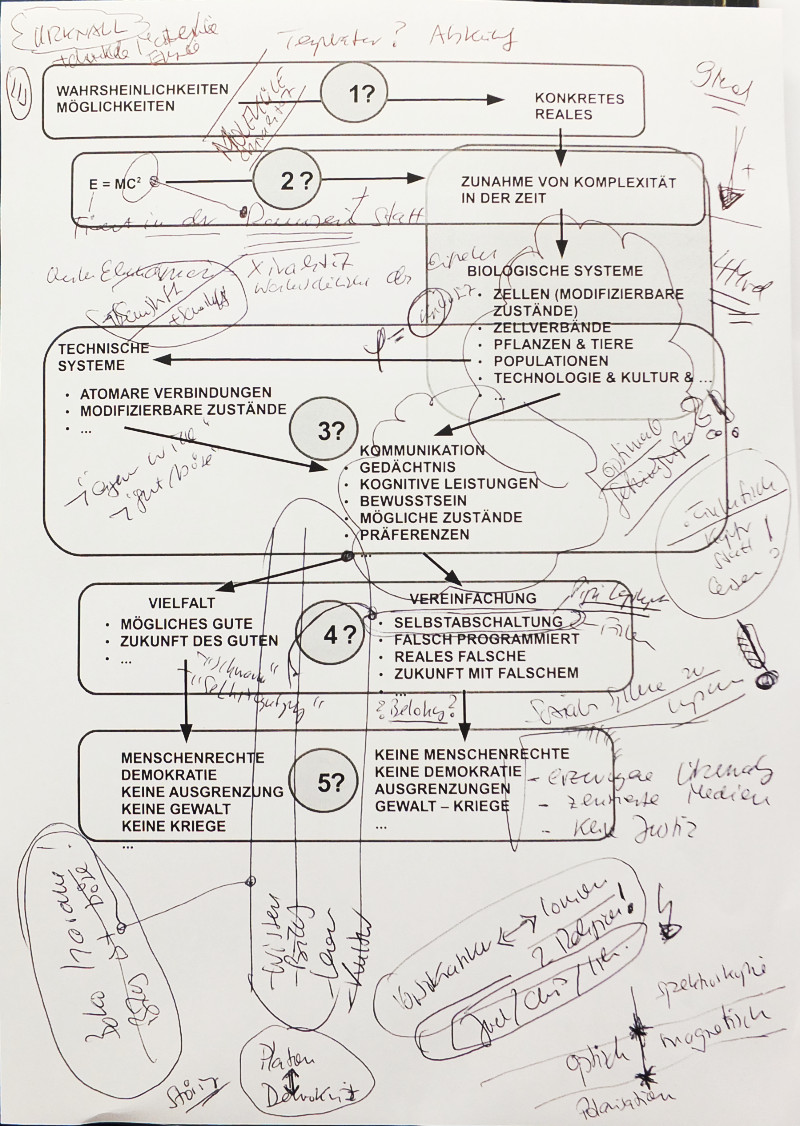

ZEITLICHKEIT

- Die übergreifende Wahrheit ist, dass alle diese Gebilde Zeit behaftet sind: mit der Sterblichkeit ihrer Leitfiguren, mit der Veränderung der Gesellschaft und Technik und der Welt drum herum verändern sich Systeme und ihre Kontexte unaufhaltsam. Die Versuchung der totalen Kontrolle durch kleine Machtzirkel ist immer gegeben und ist immer auf Scheitern programmiert, ein Scheitern, dass vieles zerstört, viele in den Tod reist, … Jahrzehnte spielen keine Rolle; Jahrhunderte sind das minimale Zeitmaß für grundlegende Ideen und Änderungen. Die Geschichte ist hier ein unerbittliches Protokoll der Wahrheiten (was solche kurzfristigen Machtinszenierungen gerne verschweigen und fälschen).

WAHRE VISIONEN

- Parallel gab es immer auch die Vision einer Menschheit die lernt, die es schafft, gemeinsam Egoismus und Wahnsinn zu verhindern, Humanität allgegenwärtig zu machen, eine Vision der Zukunft zu entwickeln, in der alle vorkommen.

- Die historische Realität erzählt uns aber, dass bislang alle Visionen zu schwach waren. Reich – Arm, Gebildet – Ungebildet, Mächtig – machtlos sind Koordinaten eines Raumes, in dem die Wirklichkeit bis heute ungleich verteilt ist.

- Wahr ist aber auch, dass der Prozess des Lebens auf der Erde, wie immer er laufen wird, nur dann eine Richtung in eine gemeinsame, nachhaltige, friedliche Zukunft für alle nehmen kann, wenn es genügend Menschen gibt, die über eine Vision, über den Ansatz eines Bildes von solch einer gemeinsamen lebensfähigen Zukunft besitzen, die ihr Handeln gemeinsam leitet, eine Vision die ‚wahr‘ ist im Sinne, dass sie eine Welt beschreibt und schafft, die tatsächlich für alle das gibt, was sie suchen und brauchen.

GENEINSAME LERNPROZESSE

- Die Geschichte Europas vom antiken Griechenland bis in die Gegenwart ist ein Beispiel, an dem man studieren kann, wie eine ganze Epoche (das lateinische Mittelalter) durch ein gemeinsames Nachbuchstabieren vorausgehender Gedanken zu sich selbst und dann zu etwas ganz Neuem gefunden hat. In der Gegenwart kann man das Gefühl haben, dass das Neue wieder zu zerfallen droht, weil man immer mehr nur auf einzelne Teile schaut und nicht auf das Ganze.

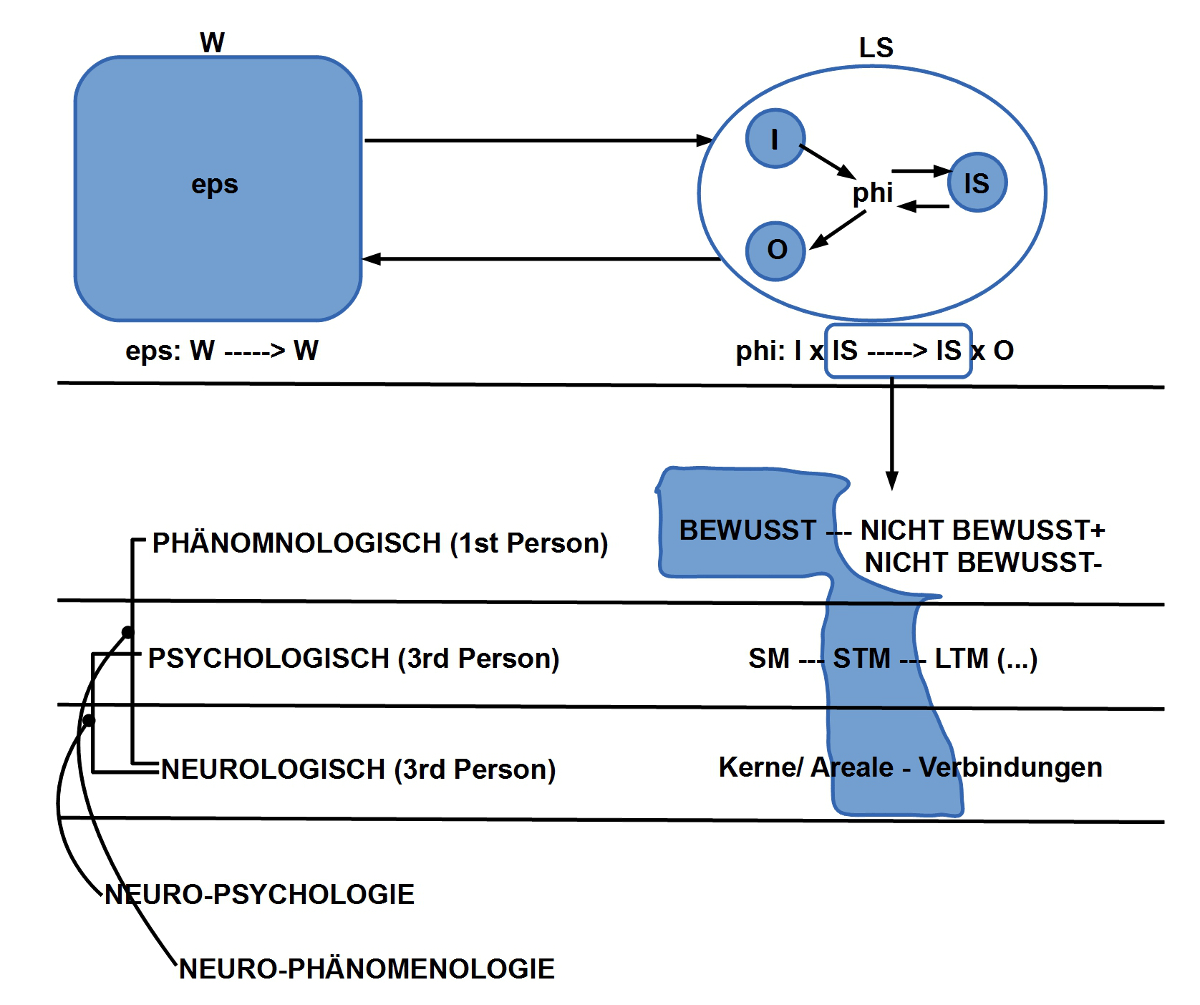

- Ein Beispiel ist das wundersame Werk Wikipedia: eine solche Enzyklopädie (bei allen realen Schwächen) gab es noch nie zuvor in der Geschichte der Menschheit. Aber diese Enzyklopädie liefert nur unverbundene Einzelteile. Wo sind die Modelle, die die Zusammenhänge sichtbar machen? Wo sind die gemeinsam geteilten Modelle, die alle nachvollziehen können? Welche transparenten Mechanismen der Bewertung bräuchte man?

- Die Physiker, Chemiker, Biologen liefern ansatzweise Modelle für Teilbereiche. Das ist gut. Aber es sind nur sehr partielle Modelle und solche, die nur die Forscher selbst verstehen. Der Rest der Welt versteht nichts, ist außen vor, und trotz hochentwickelten Teilmodellen blühen Aberglauben, vereinfachende religiöse Überzeugungen, Esoterik und Ähnliches in einem Ausmaß, was (erschreckend) staunen lässt. … Und die Politik schafft wichtige Wissenschaften sogar wieder ab, weil die Politiker gar nicht verstehen, was die Forscher da machen (im Bereich Cyber- und Drohnenkrieg leider genau umgekehrt…).

- Die geistige Welt scheint also zu zerfallen, weil wir immer höhere Datengebirge erzeugen, und immer weniger interpretierende Modelle, die alle verstehen. (BigData liefert ‚Oberflächenmodelle‘ unter Voraussetzung, dessen, was ist, aber geht nicht tiefer, erklärt nichts, und vor allem, ist blind, wenn die Daten schon Schrott sind).

- Die Frage ist also, wie kann eine ganze Epoche aus der Zersplitterung in alte, schlechte, unverständliche Modelle der Welt zu etwas mehr gemeinsamer nachhaltiger Modellbildung kommen?

DAS GUTE UND WAHRE SIND EIN SELBSTZWECK

- Der einzige Grund für das ‚Gute‘ und ‚Wahre‘ ist das ‚Gute‘ und ‚Wahre‘ selbst. Die Alternativen erkennt man an ihren zerstörerischen Wirkungen (allerdings nicht immer sofort; Jahrzehnte sind die Sekunden von Kulturgeschichte, Generationen ihre Minuten, Jahrhunderte ihre Stunden ….).

- Der je größere Zusammenhang ist bei empirischer Betrachtung objektiv gegeben. Wieweit sind wir aber in der Lage, diese übergreifenden objektiven Zusammenhänge subjektiv zu fassen, so zu verinnerlichen, dass wir damit ‚im Einklang mit allem‘ positiv leben können?

- Die Geschichte sagt ganz klar, dass es nur gemeinsam geht. Wie wird aus vielen einzelnen eine geistige (rational begründete) und emotionale Gemeinschaft, die heute das tut, was auch morgen Sinn macht?

- Man kann ja mal die Frage stellen, warum (um einen winzigen Aspekt zu nennen), Schulen und Hochschulen es nicht als eine ihrer Hauptaufgaben ansehen, die Wikipedia der Fakten (Wikipedia Level 0) mit zu pflegen, um gleichzeitig damit zu beginnen, eine Wikipedia der Modelle (Wikipedia Level 1) aufzubauen?

- Philosophische Überlegungen, die ernsthaft anlässlich der realen Welt über diese reale Welt und ihre impliziten kognitiven Räume nachdenken wollen, könnten dann Level 0 + 1 als natürliche Referenzpunkte benutzen, um die kritische Reflexion über das Weltwissen weiter voran zu treiben.

- Ja gewiss, dies alles ist nur ein Fragment. Aber als einzelne sind wir alle fragmentiert. Leben ist die Kunst der Überwindung der Fragmente in höheren, lebensfähigen Einheiten ….

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.