Reflexionen im Anschluss an Herms: Horizont der Hirnforschung….

Letzte Änderung: 2.März 2013, 10:10h (Anmerkung am Ende des Artikels)

PHILOSOPHIE

Herms nutzt in seinem Denken über das Ganze die phänomenologische Tradition, hier insbesondere Husserl und Heidegger (mündlich bestätigt). Die phänomenologische Tradition in der Philosophie wurde in diesem Blog schon mehrfach diskutiert (siehe Themenüberblick). Ihre Stärke liegt eindeutig darin, dass sie den Ankerpunkt unseres subjektiven Denkens ernst nimmt und die Wirklichkeit, wie sie sich dort darbietet, so voraussetzungslos wie möglich wahrzunehmen und zu beschreiben versucht. Die Schwierigkeiten, die sich hier bieten, wurden schon oft von sehr vielen reflektiert und angemerkt.

Positiv kann man festhalten, dass der gesamte Erkenntnishorizont eines Individuums dort aufscheint und sich in seiner Gesamtheit besprechen lässt. Man kann auch weitere Reflexionsschichten eröffnen und als solche benennen und explizieren. Einzelwissenschaftliche Erkenntnisse erscheinen hier als Teilmengen in der Gesamtmenge der Phänomene und die diversen begrifflichen Explikationen sind Teilmodelle im Gesamtrahmen möglicher Modelle. Aus phänomenologischer Sicht ist das Individuum daher grundsätzlich ‚mehr‘ als eine einzelwissenschaftliche Beschreibung eines Weltausschnitts.

Andererseits gibt es grundsätzliche Grenzen der phänomenologischen Weltsicht. Die eine resultiert aus den vorgegebenen Grenzen des einzelnen Bewusstseinsraumes, die andere aus der Existenz vieler Bewusstseinsräume, die sich über die Interaktion von Wahrnehmungsräumen erschließen kann.

Erscheint ‚der Andere‘ innerhalb der Phänomene zunächst nur als ‚Oberfläche‘ mit sich veränderten Phänomenmengen als ‚Manifestationen‘ eines möglichen ‚Zusammenhangs‘, so erzwingt das soziale Zusammenleben schon sehr früh eine ‚auf-den-anderen-bezogene‘ Modellbildung im (betrachtenden individuellen) Phänomenraum. Dies bedeutet, dass der aktive Phänomenraum die auftretenden Phänomensequenzen ‚versuchsweise/ hypothetisch‘ mit Teilen seines ‚Selbsmodells‘ in Verbindung bringen muss, um diese Phänomensequenzen des potentiell Anderen zu ‚interpretieren‘.

Sei PH der jeweils aktive Phänomenraum, seien PH_a jene Sequenzen von Phänomenen aus PH, die man einem ‚bestimmten Anderen‘ zuordnen möchte, also PH_a subset pow(PH^n), und sei M ein expliziertes Modell innerhalb von PH über Teilbereiche von PH, also M:PH —> PH (!!! Ein logisches Paradoxon, da M auch in PH liegt !!!), dann wäre eine ‚Interpretation‘ eine Abbildung zwischen PH_a und solch einem M, also I: Ph_a —> M. Dies zeigt u.a., dass jemand einen potentiell anderen nur insoweit verstehen kann, als er über ein explizites Selbstmodell verfügt. Normalerweise führt solch eine Interpretation I(PH_a) auch dazu, dass der aktive Phänomenraum PH ‚unterstellt/ annimmt‘, dass das explizierte Selbstmodell M ‚im anderen‘ auch ‚gegeben‘ ist und im anderen ‚funktioniert‘. Dies ist eine Art ‚Ontologisierung‘ des Selbstmodells im anderen, eine Form von ‚realistischer Transzendenz‘. Man könnte also sagen, dass das Selbstmodell in seiner Projektion auf einen anderen — nennen wir es M_a — ein Modell des Anderen darstellt.

Interaktionen im ‚vorsprachlichen‘ Bereich können unterschiedliche ‚Bestätigungen‘ für die Interpretation I(Ph_a) liefern, sie sind allerdings nur sehr grob. Durch Einbeziehung der Sprache lässt sich die Bestätigung — und eventuell die Interpretation I(PH_a) selbst — verfeinern.

Dazu muss man sich kurz vergegenwärtigen, wie Sprache funktioniert. In der Tradition von Peirce, Saussure und Morris kann man einen Zeichenbegriff extrahieren, in dem ‚Zeichenmaterial‘ ZM subset PH mit anderen Phänomenen PH_x subset PH ‚assoziiert‘ wird, und zwar als ‚aktivierbare Beziehung‘ BED(ZM,PH_x). Phänomenologisch ist diese Beziehung nicht ‚explizit‘, d.h. sie ist kein Phänomen wie ein sensorisches Phänomen, das ‚auftritt‘, sondern es ist ein ‚Wirkzusammenhang‘, der sich ‚indirekt andeutet‘. Also wenn das Phänomen ‚Haus‘ als Zeichenmaterial auftritt, dann werden diverse andere assoziierte Phämene PH_haus auftreten, da sie in einer aktivierbaren Beziehung zu ‚Haus‘ stehen. Diese phänomenologische Wenn-Dann-Beziehung kann man erklären durch die Annahme einer Hilfsstruktur ‚Gedächtnis‘ (MEM), deren Inhalte als solche ‚unbewusst‘ sind, die aber über den aktiven Phänomenraum PH ‚zugänglich‘ sind, so eine Art ‚phänomenologische Schnittstelle‘. Diese ‚indirekten‘ Phänomene berühren einen Sachverhalt, den wir weiter unten noch diskutieren werden.

Unter Voraussetzung von Bedeutungsbeziehungen kann man sich immer komplexere Hierarchien solcher Beziehungen denken, die es erlauben, ‚Ketten von Zeichen‘ zu bilden, bis hin zu dem, was wir Äußerungen, Sätze nennen. Diese Bedeutungsbeziehungen beruhen auf den Phänomenen eines aktiven Phänomenraumes PH. In Kombination mit dem Modell des Anderen M_a können jetzt Zeichenbeziehungen dazu benutzt werden, differenzierte Strukturen mit Hilfe des Selbstmodells M zu kodieren, die dann über das Konstrukt ‚Modell des Anderen M_a‘ auch ‚im anderen unterstellt werden können‘.

Diese Annahme macht allerdings nur Sinn, wenn man zugleich annimmt — ganz im Sinne der Bildung eines Fremdmodells M_a überhaupt — dass die Gesetze des aktiven Phänomenraumes PH auch im anderen M_a gelten (Symmetrie, Homomorphie,…)!!! Je mehr man diese Annahmen akzeptiert, um so mehr wird klar, dass man eine mögliche explizite Beschreibung M eines aktiven Phänomenraumes PH ergänzen sollte um eine ‚Metaebene‘ MM, die nicht mehr nur über einen einzelnen Phänomenraum PH spricht, sondern über die Menge aller möglichen Phänomenräume UPH. Diese universelle Menge UPH ist rein fiktiv, rein gedacht, und doch kann sie durch Interaktionen einer mehr oder weniger großen Bestätigung zugeführt werden. MM wäre eine genuin philosophische Theorie!

Kommen wir zurück zum Phänomen der indirekten Bedeutungsbeziehung und dem Konzept des ‚unbewussten‘.

Grundsätzlich ist die Annahme des Unbewussten M_ubw nicht sehr anders als die Annahme eines ‚Anderen‘ M_a. Es gibt bestimmte Phänomene, die sich in der Zeit verteilen, die aber einen ‚übergreifenden Zusammenhang‘ offenbaren (der letztlich schon immer ein Konstrukt wie ein Gedächtnis voraussetzt), der als ‚Zusammenhang‘ zu thematisieren ist. Analog wie man im Falle des Anderen, wo man ‚hinter der Oberfläche‘ eine Struktur M_a annehmen muss, kann man auch ‚hinter dem aktiven Phänomenraum‘ PH Strukturen annehmen, den ‚Körper‘, das ‚Gedächtnis‘, usw. Dies führt dazu, dass man das Selbstmodell M entsprechend ‚erweitern‘ muss. Je differenzierter das Selbstmodell M wird, umso differenzierter wird auch das Modell des anderen M_a und das universelle Modell MM.

WELTHEORIE?

Mit den obigen Überlegungen eröffnet sich die Perspektive einer möglichen phänomenologischen Theorie der Welt, in der alle Teiltheorien integriert werden können. Meines Wissens hat dies bis heute noch niemand versucht. Es wäre interessant, zu schauen, inwieweit eine solche Theorie helfen könnte, aktuelle Bruchstellen durch die Vielzahl der nicht integrierten Teiltheorien ein wenig zu überbrücken.

THEOLOGIE

Der Theologe Prof. Herms hatte ziemlich zu Beginn seines Vortrags vermerkt, dass sein Verständnis von Theologie nicht so sei, wie die meisten sich Theologie vorstellen. Diese zunächst kryptische Bemerkung gewann im Laufe seines Vortrags mehr und mehr Gestalt. Durch seine philosophische Grundausrichtung benötigt er zunächst keine offenbarungsspezifische Inhalte, da er nach den allgemeinen Bedingungen von Leben (und Erkennen) fragt. Aus diesen allgemeinen Bedingungen kann er dann allgemeine Prinzipien ableiten, innerhalb deren wir uns als Lebende orientieren sollten. Übernimmt man diese Position dann kann man sogar die Grundsatzfrage stellen, ob man überhaupt offenbarungsspezifische Inhalte noch benötigt, da ja diese keinesfalls im Gegensatz zu den allgemeinen Prinzipien stehen dürften. Vielmehr müsste es so sein, dass die potentiellen ‚Offenbarungsinhalte‘ nichts anderes sind als Instanzen dieses allgemeinen Möglichkeitsraumes.

Innerhalb des Vortrags wurde diese Fragen nicht Thema, da Herms sich auf die allgemeine Perspektive und daraus resultierenden allgemeinen Prinzipien beschränkte.

Allerdings könnte man — oder müsste man sogar? — natürlich die Frage aufwerfen, inwieweit nicht die tatsächlichen Realisierungen — wie auch im Falle der Entwicklung des Universums, der Milchstraße, der Erde, des Lebens auf der Erde … — dann doch in ihrer Konkretheit eine wichtige Aussage darstellen können. Konfrontiert mit den konkreten Ergebnissen der biologischen Evolution hat man auch dieses Dilemma: (i) relativiert man die gewordene Konkretheit durch den Verweis auf den allgemeinen Möglichkeitsraum oder (ii) nimmt man die Konkretheit ‚beim Wort‘ und sieht in ihre eine Form von ‚Mitteilung‘. Im letzteren Fall wäre die ‚Konkretheit an sich‘ dann eine Form von ‚Offenbarung‘ einer unterstellten ‚Superwirklichkeit‘, die ‚ihr Inneres‘ über die ungeheuren Werdeprozesse in der jeweiligen Konkretheit zeigt und — im Falle des menschlichen Bewusstseins — sich quasi ’selbst anschaut‘! Menschliches Bewusstsein also als eine Art ‚Minimodell‘ von universaler ‚Selbstanschauung‘ als Hinweis auf die ‚wahre Natur‘ des im Werden des Universums sich andeutenden Superwirklichkeit.

Diese Perspektive des allgemeinen Werdens als ‚möglicher Offenbarung‘ würde damit in jeder Art von Konkretisierung eine Aussage zutreffen. Vor diesem Hintergrund sind alle historisch überlieferten spezielle Ereignisse, die von Menschen als ‚offenbarungsrelevant‘ qualifiziert wurden, interessantes empirisches Material, das entweder das allgemeines Offenbarungskonzept zusätzlich konkretisieren kann oder aber nicht kompatibel ist. Im Falle der Nichtübereinstimmung (Inkompatibilität) würde dies dann eher gegen (!) die spezifischen Stoffe sprechen, da die Fülle der allgemein zusätzlichen Daten um ein Vielfaches größer ist als fragil überlieferte historische Ereignisse.

Versteht man Theologie als jene Denkhaltung und Theoriebildung, die von der allgemeinen Offenbarung ausgeht, um innerhalb dieses Rahmens mögliche konkrete Inhalte zu studieren, dann würde ich mein Erkenntnisinteresse auch als ‚theologisch‘ qualifizieren. Ich habe auch den Eindruck, dass Prof. Herms sich so versteht. Eine endgültige Bestätigung müsste ein Gespräch liefern. Ferner unterscheidet sich solch eine allgemein orientierte Theologie nicht grundsätzlich von einer philosophischen Gesamttheorie der Welt, höchstens in einer unterschiedlichen Akzentsetzung: die philosophische Gesamttheorie der Welt MM orientiert sich primär an den allgemeinen Erkenntnisstrukturen und der möglichen Integration des Einzelwissens, während eine Allgemeine Theologie sich speziell für den Aspekt einer möglichen Mitteilung durch das Gesamtgeschehen interessiert.

Diese spezifische Interessenrichtung der Theologie hat eine spezielle Pragmatik im Gefolge: während die Einzelwissenschaften (und die Philosophie) letztlich objektivierbare Messverfahren benutzen, um ihre Daten zu sichern, kann die Theologie darüber hinaus (!) die spezifischen bewusstseinsgebundenen Erfahrungsmöglichkeiten benutzen, die unter dem Begriff ‚Gotteserfahrung‘ gehandelt werden.

Der Kern des Konzepts ‚Gotteserfahrung‘ besteht — zumindest in der jüdisch-christlichen — Tradition darin, dass die Arbeitshypothese einer ‚Superwirklichkeit‘ genannt ‚Gott‘ (deus, theos, Jahwe,….) davon ausgeht, dass diese Superwirklichkeit sich nicht nur über die allgemeinen Offenbarungsstrukturen ‚mitteilen‘ kann, sondern auch zugleich ganz individuell in jedem Bewusstseinsraum (angesichts der neuesten Erkenntnisse zur Struktur der Materie grundsätzlich zumindest kein physikalisches Problem). Diese ‚Mitteilungen‘ haben — nimmt man die bekannten Zeugnisse ernst — (i) die Form von spezifischen ‚Gefühlsregungen‘, ‚Stimmungen‘, bisweilen begleitet von weiteren ‚Vorstellungsinhalten‘. Dabei kommt es auch hier nicht auf das ‚punktuelle‘ Erleben alleine an, sondern auf die ‚Abfolge verschiedener solcher Erlebnisse‘ und deren ‚Deutung‘ in Form eines Modells. Ferner (ii) implizieren sie normalerweise bestimmte Handlungen, um diese Art von innerem Erleben nicht zum ‚Versiegen‘ zu bringen, und (iii) können diese inneren Erlebnisse nicht durch das eigene Wollen verursacht werden, sondern gehen ‚von einem anderen‘ aus (dies unterscheidet Gotteserfahrung wesentlich von jeglicher Form von ‚Meditation‘, die sich auf selbstinszenierte Zustände bezieht). Im einzelnen sind diese Tatbestände eingebettet in das ‚allgemeine Rauschen des Alltags‘ und bedürfen — wie alle anderen Lernprozesse auch — meist eine Praxis von vielen, vielen Jahren, um sie wirklich zu ‚beherrschen‘, und, wie auch beim allgemeinen Lernen, geht es meist nicht ohne ‚Lehrer‘ im Sinne von ‚geistlichen Führern‘ ab. Durch die unvermeidbar radikal subjektivistischen Anteile bleibt all dies immer schwierig. Denken alleine hilft nicht. Praxis ohne Denken kann durch unreflektierte Interpretationen zu vielen falschen Schlüssen kommen.

Es ist schwer zu sagen, ob und wieweit die bekannten kirchlichen Gemeinschaften in der Lage sind, solche ‚geistliche (= spirituelle, mystische) Erfahrungen‘ angemessen zu vermitteln. Wir befinden uns hier in einer rechten Grauzone. Die offiziellen theologischen Positionen und die bekannten kirchlichen Praktiken sprechen eher gegen die Annahme.

Anmerkung 2.3.13: Eine Fortsetzung dieser Überlegungen findet sich im nachfolgenden Beitrag Gott ohne Kirche …. Der zentrale Punkt ist eigentlich ein neues Verständnis von Theologie und Offenbarung, durch die ‚Kirchen‘ nicht eigentlich verschwinden, aber stark relativiert werden auf ihren wesentlichen Punkt: ihre einzige Existenzberechtigung liegt in ihrem möglichen Dienst, anderen Menschen zu helfen, ihre Gottesbeziehung zu finden und zu leben. Wenn sie darin versagen, verlieren sie ihre Existenzberechtigung.

Einen Überblick über alle Beiträge des Blogs nach Themen findet sich HIER

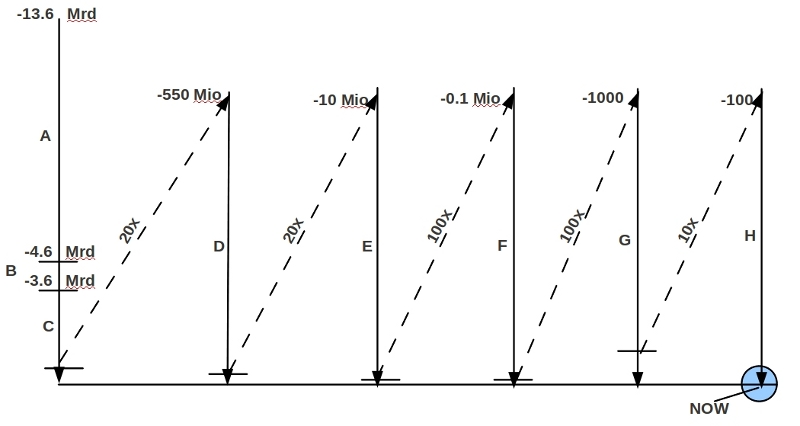

Bild 1

Bild 1 Bild 2

Bild 2