KONTEXT

- Das Thema Super-Intelligenz wurde in diesem Blog schon öfters angesprochen, nicht zuletzt sogar wie ein Buchprojekt behandelt. Irgendwie habe ich es als wichtig angesehen, aber irgendwie auch nicht so richtig. So hatte ich nach einer ersten Querlektüre des Buches von Nick Bostrom ‚Superintelligence‘ vor etwa einem Jahr dieses wieder beiseite gelegt als nicht wirklich weiter führend.

- Die Tage sah ich eine Dokumentation, in der Nick Bostrom mit einem Statement vorkam, in dem er ausdrückte, dass für ihn die Frage der möglichen technischen Superintelligenz eine entscheidende, ja geradezu existentielle Frage sei: wenn dies stattfinden würde – und er war sich sicher, dass der Tag kommen wird – dann sei es um uns Menschen, um den homo sapiens, geschehen.

- Es ist schwer, die Ernsthaftigkeit eines Menschen nur von solch einem einzelnen Statement aus zu beurteilen, aber irgendwie wirkte Bostrom bei diesem Statement sehr ernst, fast betroffen. Ob er es wirklich war … es ist offen, jedenfalls reichte dieser Moment aus, um bei mir dies Thema nochmals zu triggern. Denn, in der Tat, rein rational, wenn tatsächlich irgendwann einmal eine technische Superintelligenz realisiert würde, als Algorithmus, der auf irgendwelcher Hardware läuft, dann werden wir Menschen es schwer haben, vorausgesetzt, wir haben uns bis zu diesem Zeitpunkt nicht weiter verändert.

- Und dies war (und ist) für mich der neue Gedanke: ja, eine mehr als menschliche Superintelligenz wäre ein gefährlicher Quantensprung und zugleich die Frage: kann der Mensch, der homo sapiens sich nicht weiter entwickeln, so weit, dass er diese Superintelligenz konstruktiv nutzen könnte?

BISHERIGE EVOLUTION BIS HOMO SAPIENS

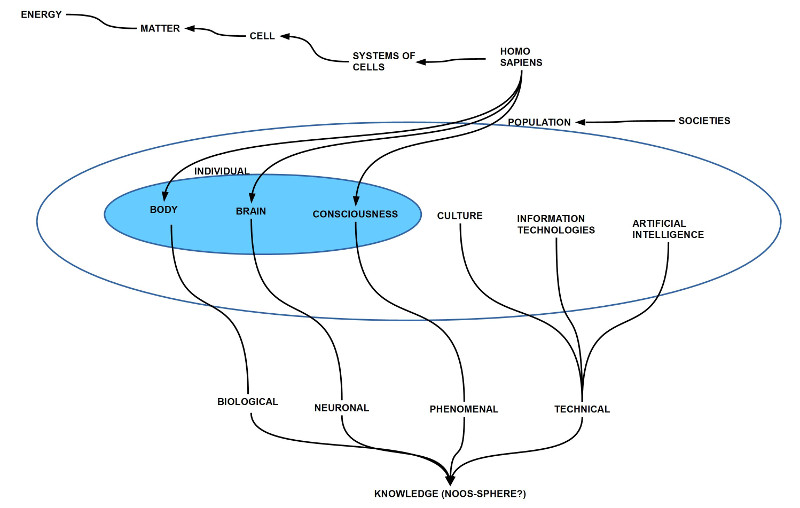

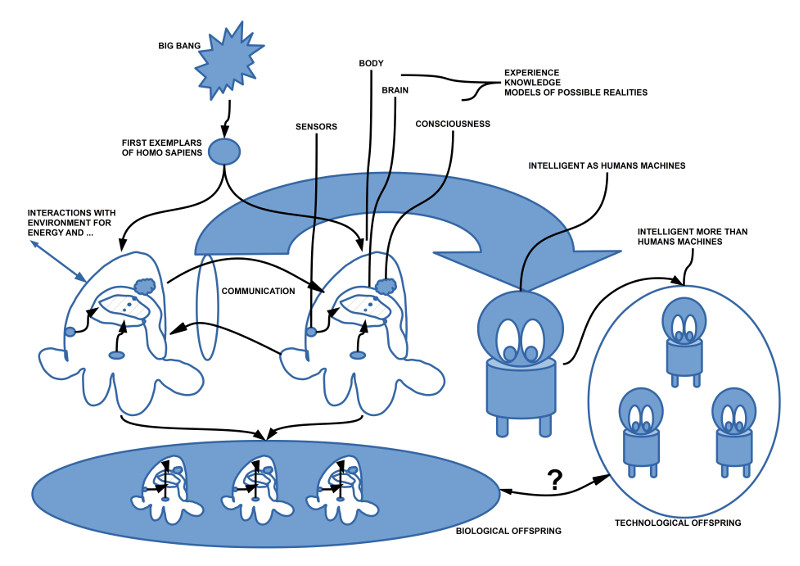

- Schaut man sich die Entwicklung des homo sapiens in evolutionärer (und dann auch historischer) Sicht an, dann repräsentiert der homo sapiens ja als homo sapiens eine fantastische Entwicklung von einer ersten einfachen Zelle über komplexe Zellen, zu Zellverbänden, Systemen von Zellen, Systeme mit Gehirn und Bewusstsein, mit Sprache, Kultur, Technologie, ja gar künstlicher Intelligenz. Dies bedeutet, dass der homo sapiens selbst eine Demonstration von fast unfassbaren Veränderungsprozessen ist.

- Was man am homo sapiens und den Gesellschaftssystemen mit dem homo sapiens als Mitglied ablesen kann, sind mindestens vier unterschiedliche Niveaus von Wissen: (i) Wissen im Format von DNA-Molekülen eingebettet in eine reproduktionsfähige Zellstruktur; (ii) Wissen im Format von Nervensystemen, die als Gehirne zu komplexen Signalverarbeitungen und Mustererkennungen fähig sind; (iii) Gehirne mit Bewusstsein, die zu symbolischer Kommunikation und komplexen Interaktionen fähig sind (Werkzeuge, Kultur, Technik…); (iv) Künstliches Wissen in Form von Algorithmen in Verbindung mit geeigneter Hardware (analog der DNA-Molekül Struktur einer Zelle mit den Reproduktionsmechanismen).

- Die Kombination von (i) bis (iv) stellt eine Transformationsleistung dar, innerhalb deren biologische Strukturen sich in alternativen Wissensformen repräsentieren und verändern können, mehr noch: sie können anders und schneller Eigenchaften der umgebenden Welt aufgreifen, anordnen, kombinieren, um sich so noch besser an die Umgebung anpassen zu können.

- Dabei gibt es eine Asymmetrie: während das biologische Wissen sich nur sehr langsam (und eher blind, per Zufall) verändern kann, bietet die technologische Dimension die Möglichkeit, Wissen im Sekundentakt zu akkumulieren, zu strukturieren, neu zu kombinieren, auszutesten, und reale Veränderungen anzustoßen. Diese technologische Veränderungsgeschwindigkeit ist dem neuronalen letztlich haushoch überlegen.

- Die Menschheit erlebt aktuell, wie die Verfügbarkeit von technologischem Wissen das eigene Leben in nahezu allen Dimensionen anreichern kann, damit verändert, und fast wie ein Traum erscheint, wenn nicht gerade der eigene Arbeitsplatz weg rationalisiert wird.

- Man kann sich aber an seinen fünf Fingern abzählen, dass diese technische Form von Wissen (maschinelle Intelligenz), sollte sie sich vom Menschen emanzipieren können, indem sie ihre eigene Entwicklung steuern könnte, sich mit einer rasenden Geschwindigkeit von Menschen entfernen kann.

TECHNISCHE SUPERINTELLIGENZ

- Da davon auszugehen ist, dass – mit Blick auf den aktuellen Technologiestand – die Abhängigkeit aller technischen Systeme von Algorithmen ins schier unmessbare steigen wird, wird eine technische Superintelligenz im Nu alle technischen Systeme durchdringen und beherrschen können (wenn heute schon Hacker überall eindringen können, weitgehend gefördert durch nationale Geheimdienst, dann wird eine technische Superintelligenz dies mit Links erledigen (zumal die Geheimdienste die Softwaretechnologien unter dem Vorwand der Sicherheit systematisch durchlöchern, um selbst Kontrolle behalten zu können; genau diese Löcher werden die ersten Einbruchstellen der möglichen Superintelligenz sein!)). Dieses Ereignis wird sich nicht mehr rückgängig machen lassen. Rein praktisch könnte man zwar versuchen, alle Maschinen abzuschalten, aber abgesehen davon, dass ja auch das Abschalten heute weitgehend einer algorithmischen Kontrolle unterliegt, würde eine solche umfassende Abschaltung aller algorithmisch gesteuerten technischen Systeme das gesellschaftliche System des homo sapiens völlig zum Erliegen bringen. Vollständiges Chaos innerhalb von Stunden wäre das Ergebnis. Nichts würde mehr funktionieren. Der homo sapiens wäre blitzschnell zurück in an seinem Ausgangspunkt in Afrika, allerdings mit dem Nachteil, das keiner mehr wüsste, wie man in solch einer Situation überlebte. Eine Steinzeit kannte vielleicht nur 100.000 Exemplare des homo sapiens weltweit; viele Milliarden könnten diese einfachen Systeme nicht ernähren.

WELCHE KONSEQUENZEN DEUTEN SICH AN?

- Angesichts dieser Perspektive muss man sich vielleicht ernsthaft der Frage stellen (und das meine ich auch im Statement von Bostrom mitgehört zu haben), wie wir uns als Menschen auf dieses Ereignis vorbereiten wollen.

- Mit Blick auf die Leichtigkeit, wie menschliche Hacker und Geheimdienste heutige algorithmische Technologien unterlaufen und unter ihre Kontrolle bringen, wäre eine Strategie, die auf Abschottung (ABSCHOTTUNG) setzt, vermutlich wenig aussichtsreich. Eine potentielle technische Superintelligenz würde diese Löcher im Handumdrehen aufspüren und für ihre Zwecke nutzen.

- Die Idee, eine potentielle technische Superintelligenz grundsätzlich zu verhindern (VERHINDERN), erscheint auch nicht überzeugend. Das Machtinteresse der Menschen (und die forschende Neugierde) ist so stark, dass irgendwer irgendwo es probieren wird. Wenn es passiert, wird es niemand mehr stoppen. (Eine spezielle Variante wäre, dass es mehr als eine potentielle technische Superintelligenz geben wird, die sich bekämpfen. Das würde uns Menschen aber nicht wirklich helfen).

- Bliebe als weitere Möglichkeit noch, dass der homo sapiens sich selbst – mit Unterstützung von technischer Intelligenz ?! – so weit verändert, dass er eine potentielle technische Superintelligenz konstruktiv nutzen könnte (WEITERENTWICKLUNG). Ein schöner Gedanke, aber wie realistisch ist er?

- Die atemberaubende bisherige Evolution zeigt, zu welch unfassbaren Veränderungen das biologische Leben fähig war. Wenn man aber die Entwicklung nicht mit den Augen des homo sapiens betrachtet sondern mit den Augen eines – idealisierten – Beobachters von ‚außerhalb‘ (spielerisch hier), dann könnte man auch zu der Arbeitshypothese kommen, dass der homo sapiens möglicherweise im Rahmen der biologischen Evolution nur einen ‚Zwischenstation‘ ist/ war. Will sagen, der homo sapiens markiert zwar eine bemerkenswerte Phase in der biologischen Evolution, aber möglicherweise nicht als Endpunkt, sondern als Durchgangsstation für eine Superintelligenz, die ab dann die Kontrolle der Entwicklung übernehmen wird.

- Welche der möglichen Zukünfte ‚wahr‘ sein wird, wird sich unausweichlich zeigen. Wenn es in ein paar Jahrzehnten (oder auch in ein paar Jahrhunderten weiter; was spielt dies für eine Rolle) eine technische Superintelligenz geben wird, mit der die Menschheit nicht mehr mithalten kann, beantwortet sich die Frage von selbst.

- Die interessanten Fragen sind also, ob es (i) an der technische Superintelligenz irgendetwas gibt, was sie letztlich doch aus Sicht des homo sapiens verwundbar oder steuerbar macht, oder (ii) ob der homo sapiens in der Lage ist, sein eigens Veränderungspotential ausreichend und schnell genug zu nutzen.

- Grundsätzlich hat der homo sapiens drei mögliche Veränderungsdimensionen: (i) Veränderung seiner Erbanlagen in Richtung von mehr Leistungsfähigkeit; (ii) Entwicklung leistungsfähiger Prothesen und Implantate; (iii) Nutzung von technischer Intelligenz für die persönliche Leistungssteigerung (nicht in der Cloud, sondern als Teil der individuellen Person, die allerdings mit der Cloud interagieren kann).

- Mit diesen Fragen im Blick werde ich jetzt das Buch von Bostrom (2014, Superintelligence) nochmals in Ruhe durchgehen, und prüfen, wie er diese Fragen beantwortet. Dann sehen wir weiter.

Einen Überblick über alle Artikel von cagent nach Titeln findet sich HIER.