VORBEMERKUNG

Vor fast genau drei Jahren hatte ich schon einmal einen Blogeintrag geschrieben, in dem das Wort ‚Level‘ im Kontext eines Computerspiels erwähnt wurde (siehe: SCHAFFEN WIR DEN NÄCHSTEN LEVEL? Oder ÜBERWINDEN WIR DEN STATUS DER MONADEN?

). Dort jedoch wurde die Idee des Computerspiels und der Level in einem ganz anderen Zusammenhang diskutiert. Im folgenden Text geht es tatsächlich um den Versuch, konkret verschiedene Ebenen des Denkens (Level) zu unterscheiden. Als ‚Ordnungsprinzip‘ in all dem wird einmal die zeitliche Abfolge benutzt, in der diese Level auftreten können, und eine ‚implizite Architektur‘ unseres Denkens, die sich nur ‚indirekt‘ beschreiben lässt.

DER BEGRIFF ‚LEVEL‘

1. Wer heutzutage Computerspiele spielt, der kennt das: man bewegt sich immer auf einem bestimmten ‚LEVEL‘, d.h. auf einer bestimmten Spielebene. Jede Spielebene hat eigene Regeln, eine eigene spezifische Schwierigkeit. Erst wenn man genügend Aufgaben gelöst hat, wenn man hinreichend viel Punkte erworben hat, dann darf man auf den nächsten Level. Diese Idee der Spielebene, des Level, kann man auch auf den Alltag übertragen.

FUNKTIONIEREN IM ALLTAG

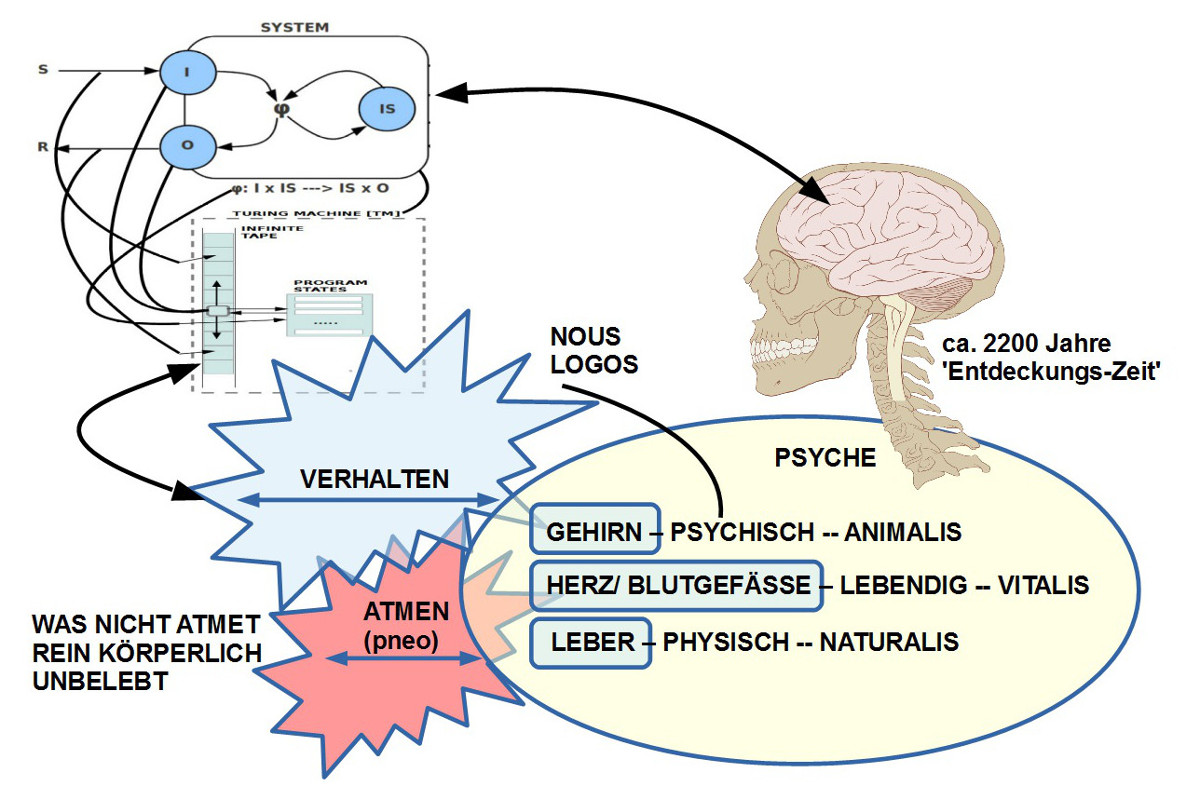

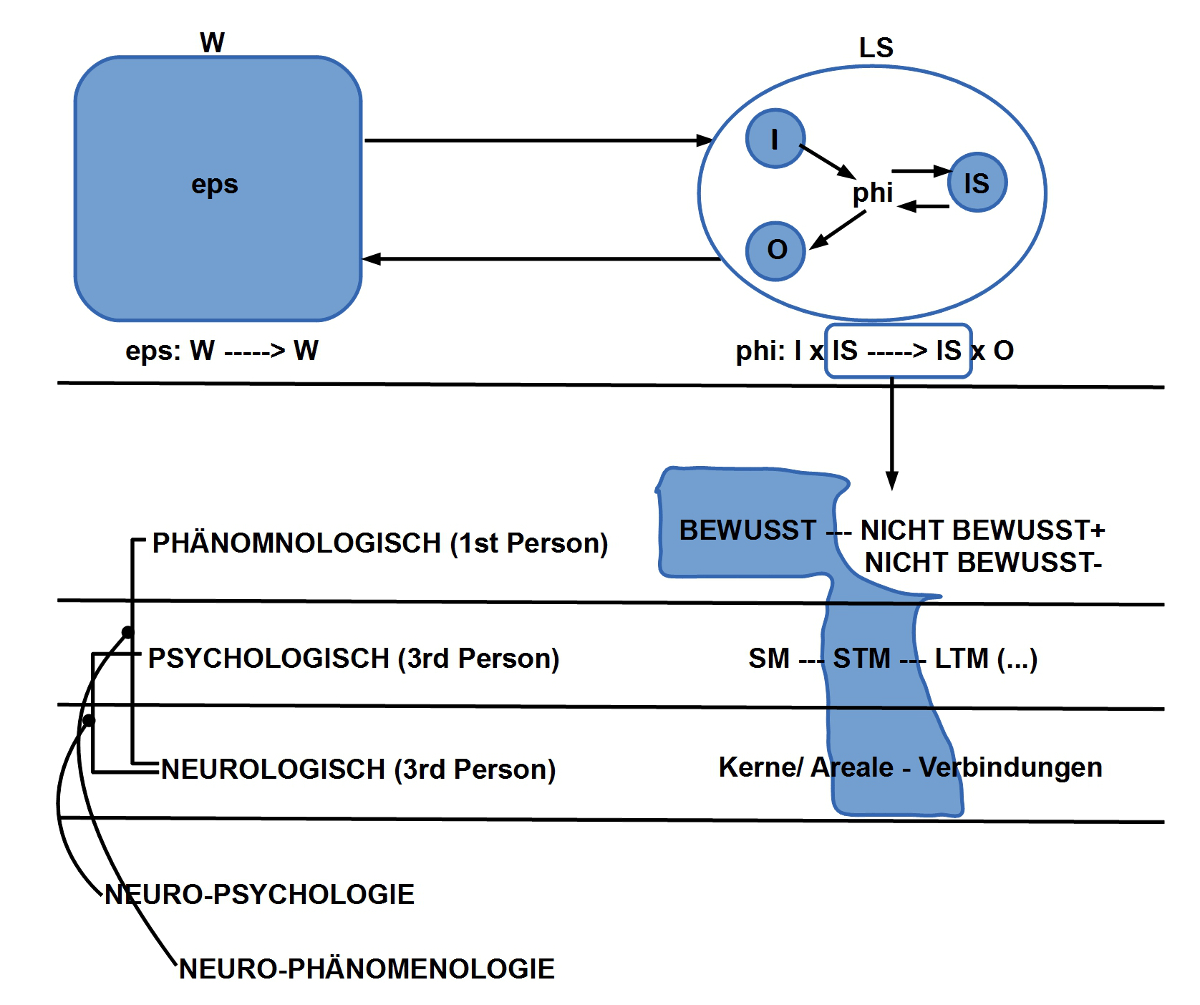

2. Im Alltag stehen wir in beständiger Interaktion mit unserer alltäglichen Umgebung (Level 1). Wir nehmen wahr, wir identifizieren Objekte mit Eigenschaften, Beziehungen zwischen diesen im Raum, zeitliche Abfolgen, und wir selbst verhalten uns nach bestimmten Regeln, die uns der Alltag aufdrängt oder aufgedrängt hat: wir lernen, dass Dinge fallen können; dass es Tag und Nacht gibt; dass Menschen unterschiedlich reagieren können; dass Menschen Rollen haben können, unterschiedliche Verpflichtungen; dass es Regeln gibt, Vorschriften, Gesetze, Erwartungen anderer, Gewohnheiten, Sitten, Gebräuche. Wir lernen mit der Zeit, dass Unterschiede gemacht werden bezüglich Herkunft, Sprache, wirtschaftlicher Stellung, Glaubens- oder Weltanschauungsansicht, usw.

3. Wenn alles ‚gut‘ läuft, dann FUNKTIONIEREN wir; wir tun, was erwartet wird, wir tun, was die Spielregeln sagen; wir tun, was wir gewohnt sind; wir bekommen unsere Leistungspunkte, unsere Anerkennungen …. oder auch nicht.

4. Wenn man uns fragt, wer wir sind, dann zählen wir für gewöhnlich auf, was wir so tun, welche Rollen wir spielen, welche Berufsbezeichnungen wir tragen.

DURCH NACHDENKEN ZUM PHILOSOPHIEREN

5. Sobald man nicht mehr nur FUNKTIONIERT, sondern anfängt, über sein Funktionieren NACHZUDENKEN, in dem Moment beginnt man, zu PHILOSOPHIEREN. Man beginnt dann mit einer BEWUSSTWERDUNG: man tut etwas und zugleich wird einem bewusst, DASS man es tut. Damit beginnt Level 2.

6. Beginn man mit einer solchen bewussten Wahrnehmung des DASS, des Unterscheidbaren, des sich Ereignenden, dann wird man nicht umhin kommen, zu unterscheiden zwischen jenen Phänomenen, Ereignissen, Objekten, die ‚zwischen‘ verschiedenen Menschen – also ‚intersubjektiv‘, ‚empirisch‘, ‚objektiv‘ – verfügbar sind und jenen, die ‚rein subjektive‘ Tatbestände darstellen. Über den ‚Apfel dort auf dem Tisch‘ kann man sich mit anderen verständigen, über die eigenen Zahnschmerzen, die eigenen Gefühle, die eigenen Erinnerungen usw. nicht so ohne weiteres. Jeder kann bis zu einem gewissen Grad ‚IN SEIN BEWUSSTSEINS HINEINSCHAUEN‘ – ’subjektiv‘, ‚introspektiv‘,’phänomenologisch‘– und solche Phänomene wahrnehmen, die NICHT INTERSUBJEKTIV sind, sondern REIN SUBJEKTIV. Diese OJEKTE DER INNENWELT sind für das eigene Erleben genauso real wie die Objekte der Außenwelt, aber sie sind nicht zugleich auch von anderen Menschen wahrnehmbar. Diese bewusste Unterscheidung zwischen AUSSEN und INNEN innerhalb des Level 2 soll hier als Level 3 bezeichnet werden. Die Menge der Inhalte, die innerhalb von Level 2 und 3 bewusst wahrgenommen werden, sollen hier einfach PHÄNOMENE genannt werden mit der anfangshaften Unterscheidung von intersubjektiven Phänomenen auch als EMPIRISCHE PHÄNOMENE und rein subjektive Phänomene als NICHTEMPIRISCHE PHÄNOMENE

WELT NEU ERZÄHLEN

7. Mit dem Bewusstwerden von Level 2 und Level 3 kann eine neue Form von BESCHREIBUNG beginnen, die hier LEVEL 4 heißen soll. Dieser Level 4 stellt eine Art META-LEVEL dar; man spricht auf einem Meta-Level über einen anderen Level. Dies ist vergleichbar einem Linguisten, der die Eigenschaften einer Sprache (z.B. des Deutschen) in seiner Fachsprache beschreiben muss. So könnte es sein, dass ein Satz wie ‚Das Haus hat einen Eingang‘ auf der linguistischen Metaebene eine Beschreibung bekäme wie ‚(‚Das‘: Bestimmter Artikel)(‚Haus‘: Substantiv)(‚hat‘: Verb)(‚einen‘: unbestimmter Artikel)(‚Eingang‘: Substantiv)‘; diese Beschreibung könnte viele weitere Elemente enthalten.

8. Eine Meta-Beschreibung kann innerlich weiter strukturiert sein. Auf Level 4.0 BENENNT man nur, was man im DASS unterscheiden kann: Objekte, Eigenschaften, Beziehungen. Auf Level 4.1 kann man ABFOLGEN von benannten Phänomenen identifizieren, speziell solche, die REGELHAFT erscheinen. Aus der Gesamtheit von Benennungen und Abfolgen kann man auf Level 4.2 ein MODELL konstruieren, mittels dem eine Teilmenge von Phänomenen und deren Abfolgen FUNKTIONAL ERKLÄRT werden soll. Mit einer zusätzlichen LOGIK auf Level 4.3 kann man dann mit einem Modell FOLGERUNGEN konstruieren, die wie VORHERSAGEN benutzt werden können, die sich ÜBRPRÜFEN lassen.

9. Beschränkt man sich auf dem Level 4 auf die empirischen Phänomene, dann bilden die Level 4.0 – 4.3 das, was wir die EMPIRISCHEN WISSENSCHAFTEN nennen. Man benennt = beschreibt die Dinge dann in einer eigenen Fachsprache (Chemie, Psychologie, Physik, Linguistik, …); man definiert Messverfahren, wie man Eigenschaften reproduzierbar messen kann; und man benutzt die Mathematik und die formale Logik, um Modelle (THEORIEN) zu konstruieren.

10. Beschränkt man sich auf dem Level 4 hingegen auf die nicht-empirischen Phänomene, dann bilden die Level 4.0 – 4.3 das, was wir die SUBJEKTIVE WISSENSCHAFT nennen könnten. Auch hier würde man die Dinge mit einer eigenen Fachsprache benennen = beschreiben; man definiert Verfahren, wie man möglicherweise Eigenschaften reproduzierbar erzeugen kann; und man benutzt die Mathematik und die formale Logik, um Modelle (THEORIEN) zu konstruieren. Eine Verständigung über Theorien der subjektiven Wissenschaft wären aufgrund der subjektiven Wahrnehmungsbasen ungleich schwieriger als im Falle von empirischen Theorien, aber niht völlig augeschlossen.

KREATIVITÄT

11. Hat man das ‚automatische‘ Verhalten überwunden (so wie es alle tun, so wie man es gelernt hat), und ist sich stattdessen bewusst geworden, dass man so und so handelt, und hat man angefangen das Automatische bewusst zu rekonstruieren, dann kann man jetzt auch bewusst Alternativen durch Variationen erzeugen [Anmerkung: natürlich kann man auch ohne Reflexion ’spontan‘ Dinge anders tun, als man sie vorher getan hat, aber dies ist dann ‚überwiegend zufällig‘, während ein Kreativität in einem reflektierten Kontext sowohl ‚gerichtet‘ ist aufgrund des verfügbaren Wissens, zugleich aber auch ‚zufällig‘, jedoch in einem viel größeren Umfang; nicht nur ‚punktuell‘]. Man kann jetzt sehr bewusst fragen, ‚warum‘ muss ich dies so tun? Warum will ich dies so? Was sind die Voraussetzungen? Was sind die Motive? Was sind die Ziele? Was will man erreichen? Usw.

12. Ein Ergebnis dieser Infragestellungen kann sein, dass man bestimmte Abläufe ändert, einfach, um mal heraus zu finden, was passiert, wenn man es anders macht. Häufige Fälle: jemand hat nie Gedichte geschrieben, weil niemand ihn vorher dazu angeregt hat, Gedichte zu schreiben; oder jemand hat nie Musik gemacht, weil sie sich immer eingeredet hat, sie sei unmusikalisch. Jemand hat nie vor anderen Menschen geredet, weil er immer Angst hatte, sich zu blamieren. Usw. Kurzum bei Erreichen von Level 4 beginnt man zu ahnen, dass alles anders sein könnte, als man es bislang gewohnt war und praktiziert hatte. Nennen wir diese neu gewonnene kreative Freiheit den LEVEL 5.

Fortsetzung folgt