Journal: Philosophie Jetzt – Menschenbild, ISSN

2365-5062, 16.März 2019

URL:

cognitiveagent.org

Email:

info@cognitiveagent.org

Autor: Gerd

Doeben-Henisch

Email: gerd@doeben-henisch.de

KONTEXT

Am 15.März 2019 war ich zu einem Vortrag mit anschließender Diskussion beim Regionaltreffen des ‚VDI Verein Deutscher Ingenieure Bezirksverein Frankfurt-Darmstadt e.V.‚ eingeladen. Das offizielle Thema war ‚Brauchen wir eine soziale KI?‘ Am Beispiel des Projektes ‚Kommunalpolitik und eGaming‚ entwickelte ich die mögliche und heute dringend gebotene Erweiterung der Blickrichtung der Informatik und Ingenieurwissenschaften über das rein Ingenieurmäßige hinaus auf die möglichen Wechselwirkungen der Methoden der Ingenieurwissenschaften mit der realen Gesellschaft vor Ort. Während des lebhaften folgenden Gesprächs tauchte auch immer wieder das Thema ‚Künstliche Intelligenz (KI)‘ für sich auf, unabhängig von diesem Kontext. Einzelne Diskussionsteilnehmer beschäftigte dieses Thema sehr, artikuliert in Fragen wie „Was ist überhaupt KI?“ oder “ Kann die KI uns Menschen überwinden (Stichwort ‚Superintelligenz‘ usw.)“. Klickt man in diesem Blog die Stichworte ‚KI‘ oder ‚KI – Künstliche Intelligenz‘ an, dann findet man mindestens 17 Blogeinträge zu diesem Thema, ein Anzeichen, dass das Thema in diesem Blog nicht neu ist. An diesem Abend aber kannte niemand diese Blogeinträge und die Fragen standen im Raum. Ich habe dann versucht, aus dem Stand, ad hoc, auf diese Fragen kurz — und damit notgedrungen informell — zu antworten. Da ich auch aus vielen anderen Gesprächen weiß, dass diese Fragen viele Menschen beschäftigen, hier also eine Liste von kurzen Thesen zu wichtigen Fragen in diesem Umfeld (eigentlich wollte ich dazu schon immer ein kleines Büchlein veröffentlichen, aber die spannenden Themen und Aufgaben des Alltags halten mich bislang davon ab….).

DEFINITION VON KI

Bis heute gibt es keine allgemein akzeptierte, gültige und brauchbare Definition von ‚Künstlicher Intelligenz‘. Die Meinung in der Öffentlichkeit wird beherrscht von den Marketingabteilungen der großen Firmen, deren Formulierungen selbst von sogenannten kritischen Medien vielfach einfach 1-zu-1 übernommen werden.

INTELLIGENZ

Die Formulierung ‚KI = Künstliche Intelligenz‘ enthält den Begriff ‚Intelligenz‚. Unabhängig von der Technik wurde dieser Begriff ‚vor-wissenschaftlich‘ nur im Kontext von biologischen Systemen benutzt. Ursprünglich primär für Menschen (Lebensform homo sapiens), in der Neuzeit im Bereich Biologie und Psychologie auch für nicht-menschliche biologische Systeme (alltagssprachlich: Tiere).

Seit dem Beginn des 20.Jahrhunderts hat die experimentelle Psychologie Verfahren entwickelt, wie man ‚Intelligenz‘ messen kann, ohne dass man weiß, was ‚Intelligenz als solche‘ ist. Vereinfacht formuliert: wenn man davon ausgeht, dass das vor-wissenschaftliche Phänomen der ‚Intelligenz‘ Menschen zukommt, dann kann man z.B. schauen, über welche beobachtbaren und messbaren Verhaltenseigenschaften verfügen z.B. alle 10-jährigen Kinder in einer bestimmten Zeitspanne (z.B. 2019) ‚im Normalfall‘. Dann kann man einen Katalog dieser Verhaltenseigenschaften aufstellen (Problem der Auswahl) und anschließend kann man experimentell feststellen, ob ein Kind diese Eigenschaften vollständig und ohne Fehler in einer bestimmten Zeit ‚reproduzieren‘ kann oder eben nicht (schneller oder länger, ohne oder mit ‚Fehlern‘ (= Abweichungen von der Vorgabe)). Dieses Verfahren hat viele Ungenauigkeiten, umschließt viele Fehler, hat sich aber dennoch in der Praxis in vielfachem Sinne als ‚Ordnungs-‚ und ‚Prognosekriterium‘ bewährt (heute meist in Verbindung mit dem Begriff des ‚Intelligenzquotienten (IQ)‘ bekannt).

Dieser psychologische Intelligenzbegriff sagt direkt nichts aus über die physiologischen Strukturen (Körper, Gehirn), die dem beobachtbaren Verhalten zugrunde liegen. Auch ist dieses Intelligenzkonzept viel zu grob, um wichtige Details, Dynamiken und Interaktionen innerhalb der unterstellten menschlichen Intelligenz zu erfassen. Immerhin gab es viele beeindruckende theoretische Ansätze, über statistische Auswertungen Hinweise auf ‚verborgene, innere‘ Strukturen der unterstellten Intelligenz zu finden.

Etwas Hilfe kam durch die moderne Gehirnforschung insoweit man mehr Wissen erlangte über Grundstrukturen und Grundfunktionsweisen des Gehirns (speziell auch seiner evolutionären wie auch ontogenetischen Entwicklung), aber die Messbarkeit von physiologischen Gehirnparametern lässt weder direkte Schlüsse zu bewussten Phänomenen zu noch kann man über diese irgendwelche Schlüsse auf die unterstellte ‚Intelligenz‘ ziehen. Was sich allerdings andeutet, ist, dass das Gehirn und die sich in der Gehirntätigkeit zeigenden Dynamiken, von einer Komplexität sind, die vorschnelle, vereinfachende Modelle eher verbieten. Die für ein Gesamtverständnis notwendige Kooperation zwischen Biologie, Psychologie, Phänomenologie und Gehirnforschung steckt noch in den Kinderschuhen. Es gibt nicht einmal einen allgemein akzeptierten theoretischen Rahmen, innerhalb dessen solch eine Kooperation stattfinden könnte. Ein direkter Vergleich der verhaltensbasierten ‚Intelligenz‘ zwischen verschiedenen biologischen Systemen (z.B. Bienen und Ratten, oder Nilpferd und Wal, oder Hund und Affe usw.) ist bislang schwierig, aber im Prinzip anhand von Verhaltenseigenschaften möglich. Nach diesem Muster kann man auch Menschen mit Maschinen vergleichen. Der berühmte ‚Turing-Test‚ ließe sich in dieses Schema einordnen. Wie aber schon die umfangreiche Diskussion zum Turing-Test zeigt, ist ein solcher Vergleich sehr grob. Kann es schon beim Vergleich einzelner Menschen riesige Unterschiede geben bis dahin, dass man — wie zu früheren Zeiten geschehen — bestimmten Menschen abgesprochen hat, dass sie Menschen seien, weil sie in ihrem Verhalten ‚von der bekannten Norm‘ abweichen (‚Hexen‘, ‚Verrückte‘, ‚die anderen‘, …), so kann es auch beim Vergleich des Verhaltens zwischen Menschen und Maschinen erhebliche Differenzen geben. Im Extremfall würde möglicherweise ein Computer als ‚menschlicher‘ eingestuft werden als ein realer Mensch. Reale Menschen verfügen über eine ungeheure Bandbreite an möglichem Verhalten bis dahin, dass Menschen von anderen Menschen sagen, das seien ‚Unmenschen‘, ‚Tiere‘ und dergleichen mehr.

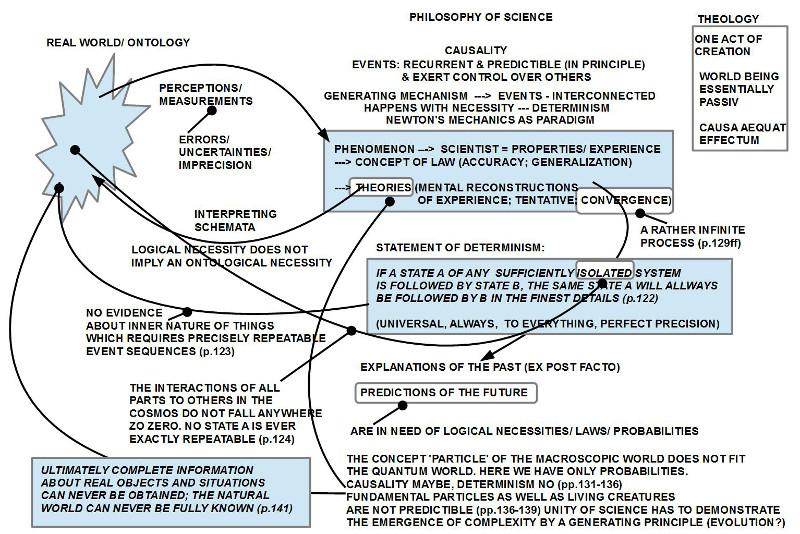

Wenn dann der Begriff ‚Künstliche Intelligenz‘ geprägt und in Umlauf gesetzt wird, dann ‚erbt‘ dieser neue Begriff die Vagheiten und Begrenztheiten des alten Begriffs ‚Intelligenz‘. Ist beim bisherigen Begriff ‚Intelligenz nicht klar, welche Erzeugungsstrukturen ‚dahinter‘ stecken, so macht der Begriff ‚Künstliche Intelligenz‘ klar, dass es um ‚nicht-biologische Systeme‘ gehen soll, also um technische Systeme, die ein Verhalten zeigen, das man dann irgendwie ‚intelligent‘ nennt. Solange die Informatik und die Ingenieurwissenschaften sich weigern, ihren Begriff der ‚KI‘ explizit mit dem psychologischen, am Verhalten orientierten, Intelligenzbegriff zusammen zu bringen, hängt der technische Intelligenzbegriff buchstäblich in der Luft. In welchem Sinne ein als ‚intelligent‘ bezeichnetes technisches System irgend etwas mit der Intelligenz eines biologischen Systems zu tun haben kann/ soll ist völlig unbestimmt. Wissenschaftsphilosophisch könnte man beide Begriffe einfach in einen gemeinsamen Theorierahmen einordnen, aber sowohl die Psychologie wie auch die Ingenieurwissenschaften verzichten bislang darauf, ihr eigenes Tun von einem Metastandpunkt aus zu reflektieren. Ist ja auch einfacher …

LERNEN (UND INTELLIGENZ)

Der Begriff des ‚Lernens‚ ist grundsätzlich unabhängig vom Begriff der Intelligenz (wenn man den verhaltensbasierten psychologischen Begriff benutzt). Bei biologischen Systemen kann man rein praktisch ‚Intelligenz‘ und ‚Lernen‘ nicht voneinander isolieren, da biologische Systeme von Grund auf ‚lernende Systeme‘ sind, d.h. kontinuierlich lernen. Die ‚messbare Intelligenz‘ eines biologischen Systems zu einem bestimmten Zeitpunkt wird daher — meistens — nie ganz getrennt gesehen von der grundsätzlichen Lernfähigkeit.

Wenn ich aber eine Maschine programmiere, dann kann ich ich diese Maschine mit einem Programm ausstatten, das viele der messbaren Verhaltenseigenschaften eines Menschen reproduzieren kann — oder sogar mehr –, ohne (!) dass sie lernt. Es handelt sich dann um eine ‚Übertragung‘ von verfügbarem Wissen (die ersten großen regelbasierten technischen KI-Systeme waren so).

Da jedes biologische System mit dem Zustand einer einzigen Zelle beginnt, die sich im Wachstumsprozess zu einem Verbund von vielen Billionen (10^12) Zellen erweitert, und das System neben ‚angeborenen Wissensstrukturen‘ die aktuelle Umgebung jeweils neu ‚lernen‘ muss, gibt es bei biologischen Systemen (insbesondere dem homo sapiens, also uns) jeweils nur eine ‚temporäre Intelligenz‘, d.h. eine Gesamtheit von Verhalten, die sich im Laufe der körperlichen und ‚kognitiven‘ Entwicklung beständig verändert. So gesehen ist die beobachtbare, messbare Intelligenz eine Funktion der dynamischen physiologischen Basis die sich in kontinuierlicher Interaktion mit der Umgebung ‚entwickelt‘ und darin ‚lernt‘.

Der verhaltensbasierte Begriff des ‚Lernens‚ nimmt die Veränderung des Verhaltens in der Zeit zum Ausgangspunkt, um zu postulieren, dass ein lernendes System ein solches ist, das seine ‚internen Zustände (IS)‘ so ‚abändern‘ kann dass es auf einen Umgebungsreiz S nicht nur mit einer Reaktion R reagieren kann, sondern ab einen bestimmten Zeitpunkt auch mit einer ‚anderen/ neuen‘ Reaktion R‘, die für eine ‚längere Zeit‘ ’stabil bleibt (Beispiel: jemand, der sich am offenen Feuer mal verbrannt hat, wird künftig einen direkten Kontakt vermeiden — wenn er ‚lernen‘ kann).

So einfach und abstrakt diese Definition eines lernenden Systems erscheinen mag, sie deckt alles ab, was wir heute kennen. Setzt man für ‚interne Zustände (IS)‘ das ‚Gehirn‘ mit dem umgebenden ‚Körper‘, dann kann z.B. ein ‚Durstreiz‘ dazu führen, dass das System ‚ irgendwann durch Probieren herausfindet, was es ‚trinken‘ kann, und dass dadurch dieser Durstreiz verschwindet (wobei bei solchen elementaren Bedürfnissen ‚angeborene‘ Verhaltenstendenzen ein ‚Lernen‘ stark unterstützen). Wenn diese Erfahrungen ‚gespeichert‘ werden können (Veränderung interner Zustände), dann kann das System beim nächsten ‚Auftreten des Durstreizes‘ sich an diese Erfahrungen ‚erinnern‘ und statt ‚planlos herum zu suchen‘ sehr ‚gezielt‘ mit einem geeigneten Verhalten reagieren. Diese Verhaltensänderungen können Verhaltensforscher beobachten und daraus die Arbeitshypothese ableiten, dass das System grundsätzlich ‚lernfähig ist

PRÄFERENZEN – ZIELE

Was in der heutigen Diskussion um Intelligenz und künstliche Intelligenz weitgehend ‚unter den Tisch fällt‘, das ist der Aspekt der Präferenzen (eng verwandt mit Begriffen wie ‚Werte‘ und ‚Ziele‘).

Dies hängt — wie oben geschildert — zu einem Teil an der Tatsache, dass der Begriff der ‚Intelligenz‘ isoliert vom Begriff des Lernens betrachtet wird.

Akzeptiert man, dass messbare ‚Intelligenz‘ bei biologischen Systemen das Ergebnis von zugrunde liegenden Lernprozessen ist und unterstellt man ferner, dass technische Systeme, die man als ‚lernfähig‘, als ‚lernend‚ bezeichnet, auch in diesem Sinne aus einer Menge möglicher Reiz-Reaktions-Muster jene ‚herausfinden‘ müssen, die ‚besser‘ sind als ‚andere‘, dann hat man automatisch diesen Begriff des ‚besser‚ im Konzept. ‚Besser‘ heißt salopp, dass man ein A einem anderen B ‚vorzieht‚, A vor B ‚präferiert‚. Das genau ist mit ‚Präferenz‘ hier gemeint. Wenn ein sogenanntes lernendes System nicht über ‚hinreichend viele‘ Präferenzen verfügt, dann kann es keine Teilmengen von Reiz-Reaktions-Mustern selektieren, d.h. dann ist ein System nicht in der Lage, zu lernen.

Während biologische Systeme quasi ‚von Anbeginn an‘ die ‚eingeborene Tendenz‚ (nicht ‚angeboren‘!) zeigen, die Ausbildung von komplexen Strukturen für die ‚Nutzung von freier Energie‘ zu erhalten und sogar beständig weiter zu entwickeln (mit einer mittlerweile ungeheuren Vielfalt von sich daraus ergebenden ’nachgeordneten Präferenzen‘), so ist bei technischen Systemen keine vergleichbare ‚eingeborene Tendenz‘ verfügbar. Um technischen Systemen das ‚Lernen‘ quasi ‚einzuhauchen‘ bedarf es der Ingenieure, die den technischen Systemen nach Bedarf unterschiedliche Präferenzen (= Ziele, Werte) ‚einprogrammieren‘ (entweder direkt oder über gezielte Interaktionen (= Training)).

Während diese Methode der expliziten Programmierung von Präferenzen z.B. im Bereich der Industrierobotik weitgehend funktioniert, zeigt sich in jenen Forschungsbereichen, in denen es nicht um klar vorgegebene Ziele geht, sondern um eine ‚offene Lernfähigkeit‘ für nahezu ‚beliebige Teilmengen‘ von Reiz-Reaktions-Mustern, dass nicht klar ist, welche Präferenzen man denn vorgeben soll.

Im Fall des homo sapiens (und auch vielen anderen biologischen Systemen) wissen wir, dass Präferenzen nicht isoliert entstehen, sondern als Interaktionsmuster in sozialen Systemen (Regeln, Gebote, Gesetze, Gewohnheiten, Überlieferung, …). Im historischen Vergleich kann man feststellen, dass sich diese kulturellen Präferenzsysteme häufig geändert haben. Zugleich wissen wir, dass unterschiedliche Präferenzsysteme gleichzeitig in unterschiedlichen Populationen bestehen können wie auch sogar in der gleichen Populationen, sofern die einzelnen Mitglieder in individuell verschiedenen Teilnetzwerken leben (Familie, Beruf, Freunde, Verein, …), in denen jeweils andere Präferenzen gelten.

Zusätzlich kann man beobachten, dass geltende Präferenzsysteme ungern in Frage gestellt werden. Menschen, soziale Gruppen, Institutionen zeigen eine starke Tendenz, einmal eingeführte Präferenzen gegen alles ‚Neue‘, gegen alle möglichen ‚Veränderungen‘ zu verteidigen. Während Präferenzen einerseits eine Voraussetzung dafür sind, dass überhaupt gelernt werden kann und dadurch eine bestimmte ‚lernabhängige Intelligenz‘ entstehen kann, kann die Fixierung von Präferenzen ein Lernen auch zum Erliegen bringen. Es reicht also u.U. nicht, einige wenige Präferenzen zu haben, sondern möglicherweise eine ‚offene Menge von Präferenzen‘.

Damit stellt sich die grundlegende Frage nach den ‚richtigen Präferenzen‘: welche Präferenzen brauchen wir? Wann, wo, wie, wie lange … ?

Obwohl die Frage der Präferenzen so fundamental erscheint für das Lernen, für die lernabhängigen Intelligenzen, für mögliche Zukünfte, besteht der starke Eindruck, dass über diese grundlegenden Fragen heute kaum bis gar nicht diskutiert wird. Dies erscheint fatal.

Klar sollte in diesem Zusammenhang sein, dass jedwede Art von ‚künstlicher Intelligenz‘ Lernprozesse voraussetzt, die eben solche Präferenzen benötigen, ohne dass klar ist, wo diese Präferenzen herkommen sollen. Bei biologischen Systemen ist sie ‚eingeboren‘, bei technischen Systeme muss sie ‚irgendwo herkommen‘.

PRINZIP COMPUTER

Im Rahmen der Diskussion um ‚künstliche Intelligenz‘ spielt auch der Begriff des Computers eine zentrale Rolle, und es ist erstaunlich wie unklar auch dieser zentrale Begriff ist.

Im Normalfall denken Menschen beim Begriff ‚Computer‚ an konkrete Maschinen (Smartphones, Laptops, PCs, Roboter, Server, …).

Was den wenigsten bewusst ist, ist die Tatsache dass der grundlegende Begriff des Computers ein rein theoretisches Konzept ist, der ‚Automat‘, historisch ‚die Turingmaschine‘. Die ‚Turingmaschine‘ ist ein rein mathematisches Konzept, das Alan Matthew Turing 1936/7 eingeführt hatte, um im Grundlagenstreit der Mathematik zu Beginn des 20.Jahrhunderts zu zeigen, dass der Metamathematische Beweis von Kurt Gödel 1931 zur Unentscheidbarkeit von mathematischen Theorien auch anders als mit der Arithmetisierung der Arithmetik mittels Goedelzahlen geführt werden kann (Goedel selbst war mit seinem eigenen Beweis nicht zufrieden gewesen und zu Turings Beweis hat er in einer Vorlesung in Princeton angemerkt, dass dies jetzt eine Form des Beweises sei, mit der er auch zufrieden sei).

Wohlgemerkt, es ging hier um die letztlich philosophische (!!!) Frage, welche ‚Beweismittel‘ denn erlaubt sein dürfen, damit ein logischer Beweis zu Eigenschaften mathematischer Theorien als ‚echter Beweis‘ anerkannt werden kann, und ob solch ein echter Beweis von einer ‚Maschine‘ automatisch ausgeführt werden könne (Frage von David Hilbert).

Goedel, Turing — und auch viele andere — haben gezeigt, dass sich für mathematische Theorien ab der Arithmetik aufwärts nicht mit endlichen Mitteln beweisen lässt, dass sie sowohl vollständig wie konsistent sind.

Auf diese Weise war — und ist — das mathematische Konzept der Turingmaschine als ein ‚theoretischer Standard‘ definiert worden, mit Bezug auf den bis heute entschieden wird, ob irgendein Prozess als ‚mit endlichen Mitteln entscheidbar‘ gelten kann oder nicht.

Was viele Menschen im Alltag übersehen ist, dass jeder physikalisch reale Computer ’schwächer‘ ist als das theoretische Konzept der Turingmaschine, da diese ein ‚unendliches‘ Schreib-Lese-Band besitzt, was sowohl für den möglichen Input und Output steht wie auch für einen möglichen Speicher. Während reale Computer angenähert auch über einen quasi-unendlichen Input und Output verfügen können, sind alle Speicher in realen Computern notgedrungen endlich.

So mancher sieht heute im sogenannten ‚Quantencomputer‘ eine Überwindung des ‚begrenzten Konzepts‘ der Turingmaschine. Diese Diskussion hat aber zwei Schwachstellen. (i) Theoretisch wird übersehen, dass das theoretische Konzept der Turingmaschine als Standard eingeführt wurde, um ‚endlich berechenbare Prozesse‘ zu definieren und es wenig Sinn macht, theoretisch als unendlich postulierte Prozesse — wie im Fall des Quantencomputers — dagegen auszuspielen; ferner ist es mehr als unklar, was der Begriff der ‚Berechenbarkeit‘ im Kontext von Quantencomputern bedeuten soll, da der Begriff der ‚Berechenbarkeit‘ bislang ja gerade nur als ‚endlicher Prozess‘ definiert wurde. (ii) Die reale Machbarkeit von Quantencomputern ist auch im Jahr 2019 alles andere als klar.

MENSCH-COMPUTER SYMBIOSE

Zwischen den Propheten der KI als Lösung für alle Probleme und den Untergangsbeschwörern, dass die KI die Menschen letztlich vernichten wird, gibt es viel Raum für eine interessante Realität und mögliche Zukunft.

Klar ist — bei angemessener Betrachtung der Entwicklung des Universums und speziell der biologischen Evolution –, dass mit dem homo sapiens eine Komplexitätsexplosion unfassbaren Ausmaßes begonnen hat. Ein Teilaspekt dieser Explosion ist die Transformation des Prinzips Turingmaschine — die in jeder biologischen Zelle bei der Reproduktion gegeben ist! — über die Formalisierung in reale programmierbare Maschinen.

Schon heute können Großteile der menschlichen Zivilisation ohne diese programmierbaren Maschinen nicht mehr funktionieren. Sie ergänzen auf vielfache Weise den Menschen mit seinen endlichen kognitiven Kapazitäten.

So wie schon das Prinzip Turingmaschine jeder biologischen Zelle erlaubt, sich zu reproduzieren, so erlauben die modernen Computernetzwerke den Menschen, die Komplexität der modernen Lebenswelt täglich neu zu reproduzieren und beständig zu erweitern (u.a. auch in der Genforschung und der Gentechnik, wodurch es im Prinzip möglich ist, die evolutionäre Weiterentwicklung des homo sapiens zu beschleunigen). Computer sind von daher kein Gegensatz der Evolution sondern genuiner Teil von ihr und schon heute für die weitere Entwicklung unabdingbar.

Bedenkt man das zuvor gesagte zur Präferenz-Problematik, dann wird die Technologie des Computers — und auch nicht der sogenannten KI — diese in irgendeiner Weise aus sich heraus lösen können. Und, obwohl Computer für das tägliche Überleben der Menschen als zentral wichtig erscheinen, kann die Computertechnologie dem Menschen das Präferenzproblem nicht abnehmen. Noch mehr Geschwindigkeit, noch mehr Datenmengen in noch kürzerer Zeit, liefern keine einzige Präferenz. Dass Spielprogramme (Schach, Go, …) ‚von alleine‘ sehr schnell Schach und Go so gut lernen können, dass sie danach alle menschlichen Spieler schlagen können, zeigt vor allem, dass Computer, angesetzt auf definierte Problem, dem Menschen real helfen können. Dies funktioniert aber immer nur dann, wenn die Kriterien für ‚Erfolg‘ vorgegeben werden (= Präferenzen). Ohne diese Gewinn-Kriterien könnte kein Computer auch nur das einfachste Spiel lernen.

ETHIK IST NICHT ETHIK

Im Zusammenhang mit der modernen Technik wird auch gerne und viel über sogenannte ‚Ethik‘ geredet. Abgesehen davon, dass es keine allgemein brauchbare Definition von Ethik gibt (wir haben es mit vielen ’selbsternannten‘ Ethikern zu tun), könnten man sich minimal vielleicht darauf einigen, dass Ethik sich mit eben den Präferenzen beschäftigt, anhand deren Menschen, Gruppen von Menschen, Institutionen usw. ihr Lernen ausrichten. Nun haben wir aber offensichtlich eine ‚offene, plurale Präferenzsituation‘, in der wir viele Präferenzsysteme gleichzeitig, nebeneinander vorfinden, deren Begründungen oftmals weitgehend unklar sind. Aufgrund dieser Unklarheit tun wir Menschen uns heute auch schwer, noch mehr gemeinsame Präferenzen zu finden, die uns ein ‚Erlernen der möglichen Zukunft‘ ermöglichen. In China legen einige wenige Menschen fest, was die Partei als Präferenzen erlaubt, und alle anderen müssen folgen. Dieses Modell erscheint im Lichte der Evolution als extrem fragwürdig und widerspricht auch sonst vielen elementaren Erkenntnissen.

Eine Ethik, die bestimmen soll, was das ‚Sollen‘ für alle sein soll, ist in sich im vollen Widerspruch zu den Prinzipien des biologischen Lebens und zudem philosophisch unhaltbar. Leben definiert sich u.a. eher als ‚das Andere zu dem, was gerade ist‘, ein anderer Name für ‚Zukunft‘; um die geht es, nicht um Vergangenheit; die ist vorbei.

DIE ZUKUNFT IST OFFEN

Wenn es irgendetwas gibt, was wir von der Evolution lernen können, dann, dass die Zukunft grundsätzlich offen ist; die Zukunft aus der Vergangenheit nur begrenzt hergeleitet werden kann; dass alles Wissen lernabhängig ist; dass Lernen ein Prozess ist, der nur über Versuch und Irrtum funktionieren kann; dass Experimentieren ohne Bereitschaft zu Fehlern und Verlust nicht geht; dass …

Einen Überblick über alle Blogeinträge von Autor cagent nach Titeln findet sich HIER.

Einen Überblick über alle Themenbereiche des Blogs findet sich HIER.